Académique Documents

Professionnel Documents

Culture Documents

Identificación de Parametros Con Redes Neuronales

Transféré par

internetzaTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Identificación de Parametros Con Redes Neuronales

Transféré par

internetzaDroits d'auteur :

Formats disponibles

Tarea 5

Netzahualcoyotl Guadarrama Camarena

2 de noviembre de 2010

1. Introducin:

Motivacin del estudio de redes neuronales

Para desarrollar identicacin de parametros de una planta

Para resolver problemas sin conocer un sistema.

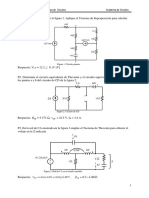

2. Experimento1

Construir una red neuronal capaz de aproximar una seal de salida de una planta lineal, cuya entrada es

una funcin, el sistema es el siguiente.

1

u

y(k)

e

PLANTA

R N

Z

-1

Z

-1

u

y(k)

e

PLANTA

R N

Z

-1

Z

-1

j (:) = aj (: 1) /j (: 2) + cn(: 1) + );

n(:) = 1,5:c:(2:) + 0,6:c:

_

3:

2

_

+ 1,12:c:

_

::

2

_

Con

a = 0,72, / = 0,9, c = 0,5, ) = 0,3

Para este experimento se utiliza el toolbox simulink de Matlab para realizar la simulacin.

y se realiza la siguiente conexin:

2

Figura 1: Capa1

Planta

Funcion de entrada

Para la red neuronal se utiliza un aprendizaje a travez de la minimizacin del error medio cuadratico de

la salida de la planta contra la salida de la red neuronal, y de manera continua como los sistemas ADALINE.

la ecuacion de aprendizaje de LMS es la siguiente: y considerando una funcin de activacin lineal, c(:) = :.

n

i

(: + 1) = n

i

(:) + jc (:) c(:) r

i

(:)

3

n

i

(: + 1) = n

i

(:) + jc (:) r

i

(:)

j (:) =

j

0

1 +

n

6

Neurona1

Factor de aprendizaje

Identicacion

Obtenemos los siguientes pesos aprendidos con esta metodologa.

4

0 10 20 30 40 50 60 70 80 90 100

-1.2

-1

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

Iteraciones

P

e

s

o

s

W1 W2 W3 W4

Fig. Pesos

0 10 20 30 40 50 60 70 80 90 100

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

Iteraciones

Y

V

S

Y

*

Y Y*

Y Vs Y*

0 10 20 30 40 50 60 70 80 90 100

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

Iteraciones

E

r

r

o

r

e=Y-Y*

Error

0 10 20 30 40 50 60 70 80 90 100

0.1

0.15

0.2

0.25

0.3

0.35

0.4

0.45

Iteraciones

E

r

r

o

r

m

e

d

i

o

c

u

a

d

r

a

t

i

c

o

Error medio cuadratico

5

0 10 20 30 40 50 60 70 80 90 100

-1

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

1

Iteraciones

F

u

n

c

i

o

n

d

e

e

n

t

r

a

d

a

u

Seal de entrada

3. Experimento 2

Utilizando el mismo sistema y adicionandole un trmino no lineal cuya ecuacin se transforma como sigue

j (:) = aj (: 1) /j (: 2) + cn(: 1) + ) + /

1

(:)

Con

/

1

(:) = 0,15

_

1 + j

2

(: 1) j

2

(: 2)

n(:) = 0,5

_

:c:(2:) + 0,3:c:

_

3

2

_

+ 0,8:c:

_

:

2

_

_

Con

a = 0,72, / = 0,9, c = 0,5, ) = 0,3

el sistema de aproximacin es el mismo

6

u

y(k)

e

PLANTA

R N

Z

-1

Z

-1

u

y(k)

e

PLANTA

R N

Z

-1

Z

-1

Utilizando el toolbox Simulink de Matlab y realizando las siguientes conexiones

Para el aprendizaje de los pesos se utiliza el algoritmo LMS, con el momento o el gradiente del error de

salida con respecto a los pesos anteriores, para una funcin de activacin lineal.

n

i

(: + 1) = n

i

(:) + jc (:) r

i

(:) + cc (: 1) r

i

(: 1)

j (:) =

j

1 + j

0

= c

Estamos utilizando ahora una planta no lineal y su interconexion es de la siguiente forma.

Planta no lineal

7

La parte no lineal se interconeta de la siguiente manera.

Parte no lineal

La interconexion de la neurona con el nuevo aprendizaje y funcion de activacion lineal.

Neurona1

Utilizando estos cambios los pesos obtenidos son los siguientes.

8

0 20 40 60 80 100 120 140 160 180 200

-1.2

-1

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

Iteraciones

P

e

s

o

s

W1 W2 W3 W4

Fig. Pesos2

0 20 40 60 80 100 120 140 160 180 200

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

1

1.2

Iteraciones

Y

V

s

Y

*

Fig. DY2

0 20 40 60 80 100 120 140 160 180 200

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

Iteraciones

E

r

r

o

r

e=Y-Y*

Fig. e2

0 20 40 60 80 100 120 140 160 180 200

0.1

0.15

0.2

0.25

0.3

0.35

0.4

0.45

0.5

Iteraciones

E

r

r

o

r

c

u

a

d

r

a

t

i

c

o

m

e

d

i

o

erms

Fig. erms2

Ahora utilizando una funcion de aprendizaje con una neurona con funcion de activacin tangente entonces

se convierte el aprendizaje como sigue:

n

i

(: + 1) = n

i

(:) + jc (:) c(:) r

i

(:) + cc (: 1) c(: 1) r

i

(: 1)

9

n

i

(: + 1) = n

i

(:) + jc (:)

_

1 j

2

(:)

_

r

i

(:) + cc (: 1)

_

1 j

2

(: 1)

_

r

i

(: 1)

j (:) =

j

1 + j

0

= c

Haciendo este cambio en nuestra neurona.

Fig. RN3

usando entonces esta funcin de activacin observamos las siguientes gracas para los pesos aprendidos.

0 20 40 60 80 100 120 140 160 180 200

-1.2

-1

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

Iteraciones

P

e

s

o

s

W1 W2 W3 W4

Fig. Pesos3

0 20 40 60 80 100 120 140 160 180 200

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

1

Iteraciones

Y

V

s

Y

*

Fig. DY3

10

0 20 40 60 80 100 120 140 160 180 200

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

Iteraciones

E

r

r

o

r

e=Y-Y*

g. e3

0 20 40 60 80 100 120 140 160 180 200

0.1

0.15

0.2

0.25

0.3

0.35

0.4

0.45

0.5

Iteraciones

E

r

r

o

r

m

e

d

o

c

u

a

d

r

a

t

c

o

erms

Fig. erms3

Ahora probemos que tan bueno es utilizar estos pesos encontrados para este modelo encontrado si cam-

biamos la funcin de entrada y mantenemos los pesos jos encontrados.:

Usando la siguiente interconexin en la entrada.

Funcin de entrada para prueba

para el caso 1. tenemos la siguiente respuesta.

11

0 5 10 15 20 25 30

-2

-1.5

-1

-0.5

0

0.5

1

1.5

2

2.5

Iteraciones

Y

V

s

Y

*

Y

Y*

Fig. Y Vs Y*

0 5 10 15 20 25 30 35 40 45 50

-1.5

-1

-0.5

0

0.5

1

1.5

2

2.5

3

3.5

Iteraciones

F

u

n

c

i

o

n

d

e

e

n

t

r

a

d

a

u

Funcin de entrada

Para el caso del sistema no lineal con funcin de activacin lineal.

0 5 10 15 20 25 30 35 40 45 50

-5

-4

-3

-2

-1

0

1

2

3

4

5

Iteraciones

Y

V

s

Y

*

Y

Y*

Fig. A Y Vs Y*

0 5 10 15 20 25 30 35 40 45 50

-2

-1

0

1

2

3

4

Iteraciones

F

u

n

c

i

o

n

d

e

e

n

t

r

a

d

a

u

Funcin de entrada

para el ltimo caso tenemos:

12

0 5 10 15 20 25 30 35 40 45 50

-5

-4

-3

-2

-1

0

1

2

3

4

Iteracions

Y

V

s

Y

*

Y

Y*

Fig. A3 Y Vs Y*

4. Conclusiones

Los pesos en una red neuronal lineal para la identicacin de una planta lineal, son ms adecuados cuando

se mantienen jos sin aprendizaje, sin embargo cuando la planta es nolineal se puede observar que con una

funcin de activacin lineal proporciona unos valores en los pesos ms adecuados cuando estos se dejan jos

para otra funcin de entrada diferente que con una red neuronal con funcin de activacin tangente. Sin

embargo, al utilizar una red neuronal con funcin de activacin tangente para la identicacin de la planta

no lineal con aprendizaje con tinuo proporciona un error menor que con una red neuronal con funcin de

activacin lineal. en estas dos ultimas comparaciones se utiliz el trmino momento y en ambos casos fu

necesario este trmino para amortiguar la salida aproximada de la red neuronal.

13

Vous aimerez peut-être aussi

- Guias de Fisica I WILLIAM TAIPE + InternetDocument21 pagesGuias de Fisica I WILLIAM TAIPE + InternetWilliam Taipe50% (2)

- Fallas AsimetricasDocument12 pagesFallas AsimetricasNelson Ortiz50% (2)

- Apuntes Electrotecnia IIDocument35 pagesApuntes Electrotecnia IIIngSerguéi Romero LuisPas encore d'évaluation

- Sistemas lineales dinámicos discretosDocument26 pagesSistemas lineales dinámicos discretosCamilo Ignacio Arriagada JaraPas encore d'évaluation

- Teoria de CircuitosDocument16 pagesTeoria de CircuitosMARKOS JOSUE CHICA MONCAYOPas encore d'évaluation

- Laboratorio de Circuitos Electricos II Ee132 FinalDocument8 pagesLaboratorio de Circuitos Electricos II Ee132 FinalCarlos Andres Gutierrez BautistaPas encore d'évaluation

- Examen 2-2208 ELT-2510Document61 pagesExamen 2-2208 ELT-2510Wilson Albert Ramos GuerrerosPas encore d'évaluation

- Trabajo Colaborativo 1 Grupo 203040 - 2.docx Control AnalogoDocument16 pagesTrabajo Colaborativo 1 Grupo 203040 - 2.docx Control AnalogoGademaraPas encore d'évaluation

- Fundamentos Regimen Permanente-Potencia Electrica y Analisis ElectricoDocument20 pagesFundamentos Regimen Permanente-Potencia Electrica y Analisis ElectricoAnthony Fredy Sanchez AltamiranoPas encore d'évaluation

- 5 Flujo de CargaDocument38 pages5 Flujo de Cargatraketto13Pas encore d'évaluation

- EstabilidadLiapunovSistemasDocument7 pagesEstabilidadLiapunovSistemasBeto EsquivelPas encore d'évaluation

- Auxiliar de CortocircuitosDocument8 pagesAuxiliar de CortocircuitosFJRVPas encore d'évaluation

- Guia ETS Teoremas 2012Document9 pagesGuia ETS Teoremas 2012barr1Pas encore d'évaluation

- LAB 2-Diagramas CircularesDocument9 pagesLAB 2-Diagramas CircularesCristhianCoyoPas encore d'évaluation

- Ball and Beam SystemDocument14 pagesBall and Beam SystemJuan José Quiroz OmañaPas encore d'évaluation

- Lab 9Document16 pagesLab 9Jonathan Alvarado SilvaPas encore d'évaluation

- Respuesta en FrecuenciaDocument9 pagesRespuesta en FrecuenciaFernando Sanz CamachoPas encore d'évaluation

- Trabajo Villasana GarverDocument13 pagesTrabajo Villasana GarverparetoskyPas encore d'évaluation

- Quinta Practica de Laboratorio 2014Document14 pagesQuinta Practica de Laboratorio 2014Sharon Ojeda CollazosPas encore d'évaluation

- Sistemas Eléctricos 2Document7 pagesSistemas Eléctricos 2Andres S De la HozPas encore d'évaluation

- Teoria de Control Clasica Ejercicios ResueltosDocument182 pagesTeoria de Control Clasica Ejercicios Resueltoslanda100% (1)

- Principio Estacionario de Energia PotencialDocument12 pagesPrincipio Estacionario de Energia PotencialJose Chingay Nicolas100% (1)

- Pendulo Invertido AnalisisDocument3 pagesPendulo Invertido AnalisisSebastian SaltosPas encore d'évaluation

- Labo03-Mat Apl ElecDocument19 pagesLabo03-Mat Apl ElecLuis Carlos Garcia PeraltaPas encore d'évaluation

- Ejemplo Analisis Fallas AsimetricasDocument21 pagesEjemplo Analisis Fallas AsimetricasOrlando Pineda100% (1)

- Ejercicios Resueltos EstabilidadDocument13 pagesEjercicios Resueltos EstabilidadWilfredoCajoCarmona0% (2)

- Etapa Julio David Chambueta Grupo 27Document10 pagesEtapa Julio David Chambueta Grupo 27Grinch FixPas encore d'évaluation

- T04 Armaduras 3DDocument13 pagesT04 Armaduras 3DDeiner Zapata Silva100% (1)

- FC Capitulo 3Document53 pagesFC Capitulo 3Wily CuscoPas encore d'évaluation

- Practica Control Levitador Magnetic 2Document11 pagesPractica Control Levitador Magnetic 2Eduard RosPas encore d'évaluation

- Solucionario Del Examen Parcial de Metodos Numericos y Computacion PDFDocument7 pagesSolucionario Del Examen Parcial de Metodos Numericos y Computacion PDFBailyIsuizaMendozaPas encore d'évaluation

- Sec p4 Levitador Magnetico 1314a-5203Document7 pagesSec p4 Levitador Magnetico 1314a-5203Adriana Yoselin Montero MendezPas encore d'évaluation

- Lab 12e23 (2) (1) 22Document12 pagesLab 12e23 (2) (1) 22Rodrigo FloresPas encore d'évaluation

- Circui 2 Labora 2Document7 pagesCircui 2 Labora 2Gabriela MoralesPas encore d'évaluation

- Ejercicios - de - Analisis 5, 13, 21, 28, 32,35,36,37Document8 pagesEjercicios - de - Analisis 5, 13, 21, 28, 32,35,36,37D Gallo GarciaPas encore d'évaluation

- Teoria de Control Clasica (Ejercicios Resueltos)Document182 pagesTeoria de Control Clasica (Ejercicios Resueltos)Gregory Cárdenas-Mansilla92% (39)

- Tarea1 1Document6 pagesTarea1 1Luis Felipe Moreno DecasaPas encore d'évaluation

- Sistema Ball and Beam Modelado y SimulaciónDocument12 pagesSistema Ball and Beam Modelado y SimulaciónGregory Cárdenas-Mansilla100% (1)

- Laboratorio Sistemas LinealesDocument23 pagesLaboratorio Sistemas LinealesalienPas encore d'évaluation

- Memória 2 Uji FisicaDocument9 pagesMemória 2 Uji FisicaAngelgo 3Pas encore d'évaluation

- Practica de Lab #2 Circuito Electico IIDocument13 pagesPractica de Lab #2 Circuito Electico IIAngel RivasPas encore d'évaluation

- Ley de FaradayDocument6 pagesLey de FaradayBeymar R CallizayaPas encore d'évaluation

- Guia Resuelta Teoremas de CircuitosDocument28 pagesGuia Resuelta Teoremas de CircuitosChristian MarsPas encore d'évaluation

- Guia Ets TeoremasDocument9 pagesGuia Ets TeoremasLeo LòpezPas encore d'évaluation

- Métodos numéricos para resolver ecuacionesDocument7 pagesMétodos numéricos para resolver ecuacionesMarco Flores ZuñigaPas encore d'évaluation

- Seminario AlambradoCI, MD - Instalaciones EléctricasDocument10 pagesSeminario AlambradoCI, MD - Instalaciones EléctricasUnknowPas encore d'évaluation

- Tarea 3 - 228 - Dana RomeroDocument12 pagesTarea 3 - 228 - Dana RomeroJavier ParodiPas encore d'évaluation

- Circuito de tercer orden con polos complejosDocument9 pagesCircuito de tercer orden con polos complejosGabriel A. Garcia LondoñoPas encore d'évaluation

- ACEII1902 - Taller 1Document3 pagesACEII1902 - Taller 1Juan Diego Marin RestrepoPas encore d'évaluation

- Practica 9Document9 pagesPractica 9Rodrigo ZuñigaPas encore d'évaluation

- ColumbDocument14 pagesColumbmario huertasPas encore d'évaluation

- Ejercicios de Integrales de Línea, Superficie y VolumenD'EverandEjercicios de Integrales de Línea, Superficie y VolumenÉvaluation : 4 sur 5 étoiles4/5 (2)

- Métodos Matriciales para ingenieros con MATLABD'EverandMétodos Matriciales para ingenieros con MATLABÉvaluation : 5 sur 5 étoiles5/5 (1)

- Desigualdades, Formulas y KroneckerDocument11 pagesDesigualdades, Formulas y KroneckerinternetzaPas encore d'évaluation

- Control Por Modos DeslizantesDocument7 pagesControl Por Modos DeslizantesinternetzaPas encore d'évaluation

- Motor DC Mamdani y SugenoDocument9 pagesMotor DC Mamdani y SugenointernetzaPas encore d'évaluation

- Estabilidad de sistemas con retardo mediante métodos de Lyapunov y D-particionesDocument139 pagesEstabilidad de sistemas con retardo mediante métodos de Lyapunov y D-particionesNetzahualcoyotl Guadarrama CamarenaPas encore d'évaluation

- Estabilidad de sistemas con retardo mediante métodos de Lyapunov y D-particionesDocument139 pagesEstabilidad de sistemas con retardo mediante métodos de Lyapunov y D-particionesNetzahualcoyotl Guadarrama CamarenaPas encore d'évaluation

- PresentacionipDocument22 pagesPresentacionipinternetzaPas encore d'évaluation

- Tarea 7Document2 pagesTarea 7internetzaPas encore d'évaluation

- Tare A 4Document4 pagesTare A 4internetzaPas encore d'évaluation

- Taller N°2 Inteligencia ArtificialDocument4 pagesTaller N°2 Inteligencia ArtificialVICTOR JULIO GUZMAN VANEGASPas encore d'évaluation

- Ejemplo BPDocument6 pagesEjemplo BPAdy CamposPas encore d'évaluation

- CAPITULO III Redes NeuronalesDocument15 pagesCAPITULO III Redes NeuronalesPaulina casasola hernandezPas encore d'évaluation

- Redes NeuronalesDocument27 pagesRedes NeuronalesJohn lercariPas encore d'évaluation

- Una Breve Introduccion A Las Redes NeuronalesDocument20 pagesUna Breve Introduccion A Las Redes NeuronalesWilliamsBorges50% (2)

- AdalineDocument2 pagesAdalineGermen SevekPas encore d'évaluation

- 6RN Con Sklearn 3Document38 pages6RN Con Sklearn 3VictorPas encore d'évaluation

- Y Redes Neuronales 6Document31 pagesY Redes Neuronales 6Carolina Flores VillalbaPas encore d'évaluation

- Manual de Usuario de Las Rede Neuronale Perceptron Simple para La Compuerta Lógica ORDocument7 pagesManual de Usuario de Las Rede Neuronale Perceptron Simple para La Compuerta Lógica ORraulhuarotePas encore d'évaluation

- Redes neuronales para transcripción automáticaDocument8 pagesRedes neuronales para transcripción automáticaalexPas encore d'évaluation

- Universidad Nacional de Trujillo Escuela de Ingeniería MecatrónicaDocument45 pagesUniversidad Nacional de Trujillo Escuela de Ingeniería MecatrónicabrandoPas encore d'évaluation

- Alvarez Trejos Juanignacio TFG PDFDocument74 pagesAlvarez Trejos Juanignacio TFG PDFMario TorresPas encore d'évaluation

- UTP 2015-2 SIRN Lab2 19645 PDFDocument17 pagesUTP 2015-2 SIRN Lab2 19645 PDFAlcides Inga TPas encore d'évaluation

- Neural Network - Toolbox de MatlabDocument51 pagesNeural Network - Toolbox de MatlabFranco Ramos Vilchez100% (2)

- Prediccion de Agua Potable La PazDocument121 pagesPrediccion de Agua Potable La PazKevIn YagunoPas encore d'évaluation

- Matlab PerceptronDocument5 pagesMatlab Perceptronfenixjb6Pas encore d'évaluation

- Aplicaciones basadas en el conocimiento. Prueba práctica II unidadDocument3 pagesAplicaciones basadas en el conocimiento. Prueba práctica II unidadluis LigniaPas encore d'évaluation

- Relacion 5Document5 pagesRelacion 5Segundo Fidel Puerto GaravitoPas encore d'évaluation

- Código Java - Perceptrón Multicapa. Propagación Hacia AtrásDocument3 pagesCódigo Java - Perceptrón Multicapa. Propagación Hacia AtrásIván PeraltaPas encore d'évaluation

- Actividad Programar Ejemplo Introducción Multicapa PDFDocument5 pagesActividad Programar Ejemplo Introducción Multicapa PDFMili VelaPas encore d'évaluation

- Redes NeuronalesDocument4 pagesRedes Neuronalesuaeh_blogPas encore d'évaluation

- Redes NeuronalesDocument87 pagesRedes NeuronalesBryanMiguelPas encore d'évaluation

- Nodos RNN entradasDocument5 pagesNodos RNN entradasJehan Carlos C TPas encore d'évaluation

- AdalineDocument8 pagesAdalineJhon Edison Rivera Alba100% (1)

- Compuerta or de Dos Entradas Usando El PerceptronDocument11 pagesCompuerta or de Dos Entradas Usando El PerceptronJòse IèdzPas encore d'évaluation

- Redes Neuronales ArtificialesDocument203 pagesRedes Neuronales ArtificialesSantiago Cacha Villacorta100% (1)

- PythonDL Parte4 PDFDocument161 pagesPythonDL Parte4 PDFMariaOtiliaCañonPas encore d'évaluation

- Entrenamiento de Perceptron - Clasificacion FloresDocument12 pagesEntrenamiento de Perceptron - Clasificacion FloresMarcus CollinsPas encore d'évaluation

- Reconocimiento de imágenes numéricas mediante redes neuronales profundasDocument7 pagesReconocimiento de imágenes numéricas mediante redes neuronales profundasCarlos Arroyo GabinoPas encore d'évaluation

- Redes Neuronales: Introducción a los Modelos de ClasificaciónDocument48 pagesRedes Neuronales: Introducción a los Modelos de ClasificaciónErRobert ChPas encore d'évaluation