Académique Documents

Professionnel Documents

Culture Documents

Analisis de Markov

Transféré par

Milthon Loza ChambillaCopyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Analisis de Markov

Transféré par

Milthon Loza ChambillaDroits d'auteur :

Formats disponibles

UNIVERSIDAD NACIONAL JORGE BASADRE GROHMANN

Cadena de Markov

Nelly Laura Rojas Yanet Ticona Nathalie Flores 2008-31871 2008-318 2008- 31846

Cadena de Markov 2011

INTRODUCCION

Una cadena de Markov es una serie de eventos, en la cual la probabilidad de que ocurra un evento depende del evento inmediato anterior. En efecto, las cadenas de este tipo tienen memoria. Recuerdan" el ltimo evento y esto condiciona las posibilidades de los eventos futuros. Esta dependencia del evento anterior distingue a las cadenas de Markov de las series de eventos independientes, como tirar una moneda al aire o un dado. En los negocios, las cadenas de Markov se han utilizado para analizar los patrones de compra de los deudores morosos, para planear las necesidades de personal y para analizar el reemplazo de equipo. El anlisis de Markov, llamado as en honor de un matemtico ruso que desarrollo el mtodo en 1907, permite encontrar la probabilidad de que un sistema se encuentre en un estado en particular en un momento dado. Algo ms importante an, es que permite encontrar el promedio a la larga o las probabilidades de estado estable para cada estado. Con esta informacin se puede predecir el comportamiento del sistema a travs del tiempo. La tarea ms difcil es reconocer cundo puede aplicarse. La caracterstica ms importante que hay que buscar en la memoria de un evento a otro.

Cadena de Markov 2011

CADENA DE MARKOV

EXPLICACIN DEL MODELO DE MARKOV

Un mtodo de previsin muy fiable sera aquel que analizase la evolucin de distintos desarrollos teniendo en cuenta las interrelaciones entre dichos desarrollos e introdujese la variable tiempo. A partir de un estudio del tipo Delphi, se obtienen como conclusiones las probabilidades y las fechas estimadas de ocurrencia de los eventos del cuestionario. Sin embargo, no se consideran las interrelaciones entre los distintos desarrollos. El modelo de Markov va a caracterizar el desarrollo secuencial tecnolgico mediante dos parmetros probabilsticos: la secuencia de los desarrollos y el tiempo entre desarrollos sucesivos. Estos dos parmetros se pueden representar con los conceptos transicin de estados y tiempo de permanencia en el estado. Se dice que un proceso es de Markov cuando verifica la propiedad de Markov: la evolucin del proceso depende del estado actual y del prximo, y no de anteriores o posteriores. A partir de un Delphi clsico se pueden extraer los parmetros caractersticos del modelo de Markov. Con estos parmetros se puede hacer un anlisis de los procesos de Markov por ordenador, estudiando el proceso secuencial en el tiempo y hallando la distribucin de probabilidades en el tiempo de los desarrollos. Como consecuencia se obtienen un conjunto de cadenas, denominadas cadenas de Markov, que indican posibles caminos para conseguir un desarrollo tecnolgico. Usando este tipo de cadenas, se puede realizar una previsin del futuro en la que se analiza la evolucin de distintos desarrollos, teniendo en cuenta las interacciones entre desarrollos e introduciendo la variable tiempo.

CADENAS DE MARKOV

En matemticas, se define como un proceso estocstico discreto que cumple con la propiedad de Markov, es decir, si se conoce la historia del sistema hasta su instante actual, su estado presente resume toda la informacin relevante para describir en probabilidad su estado futuro.

Cadena de Markov 2011

Una cadena de Markov es una secuencia X1, X2, X3,... de variables aleatorias. El rango de estas variables, es llamado espacio estado, el valor de Xn es el estado del proceso en el tiempo n. Si la distribucin de probabilidad condicional de Xn+1en estados pasados es una funcin de Xn por s sola, entonces:

Donde xi es el estado del proceso en el instante i. La identidad mostrada es la propiedad de Markov. CUL ES EL FUNDAMENTO MATEMTICO DE ESE MTODO? El anlisis de Markov es un procedimiento que se utilizar para describir el comportamiento de un sistema en una situacin donde confluyen varias variables, prediciendo los movimientos del sistema entre diferentes posibles estados en un tiempo determinado. El anlisis Markoviano o proceso de Markov est formado por un conjunto de objetos y un conjunto de estados. Si el nmero de estados es contable tal proceso de Markov se denomina Cadena de Markov. Una cadena de Markov es una secuencia de n experimentos en la que cada experimento consta de m resultados o estados posibles E1, E2, En y la probabilidad de que ocurra un resultado particular depende nicamente de la probabilidad del resultado del experimento anterior. La probabilidad de transicin pij es la probabilidad de que el experimento pase del estado Ei al estado Ei. As, p ij es una probabilidad condicional que se puede expresar como pij= PEi /Ej. ; 1.i, j m... Si los ndices i, j de pij representan el nmero de rengln y el nmero de columna, respectivamente, entonces las probabilidades de transicin se pueden colocar en una matriz P de probabilidades de transicin, cuyos elementos son no negativos y menores o iguales a 1. Cualquier rengln suma 1, y representa la probabilidad de pasar de un estado a otro. CULES SON SUS PRINCIPALES CAMPOS DE USO Las predicciones en base al anlisis de Markov son de suma importancia para el manejo de sistemas y procesos en todo tipo de organizaciones, pudiendo ser utilizada para ayuda en la toma de decisiones con respecto al movimiento de personal, inventarios, comportamiento de clientes, etc

Cadena de Markov 2011

EJEMPLO DE APLICACIN El fabricante de dentfrico Brillo controla actualmente 60% del mercado de una ciudad. Datos del ao anterior muestran que :el 88% de consumidores de Brillo continan utilizndola, mientras que el 12% de los usuarios de Brillo cambiaron a otras marcas. El 85% de los usuarios de la competencia permanecieron leales a estas otras marcas, mientras que el 15% cambi a Brillo. Definir la matriz de transicin y el vector inicial de distribucin. DESARROLLO Se considera como estado 1 al consumo de dentfrico Brillo y al estado 2 como el consumo de una marca de la competencia. Entonces, p11, probabilidad de que un consumidor de Brillo permanezca leal a Brillo, es 0.88. p12, la probabilidad de que un consumidor de brillo cambie a otra marca, es de 0.12 p21 , probabilidad de que el consumidor de otra marca cambie a brillo, es de 0.15 p22, probabilidad de que un consumidor permanezca leal a la competencia, es de 0.85 El vector inicial de distribucin de probabilidad es X^ ((O) 0 .60, 0.40 donde los componentes p_1^ ((0) yp_2^ ((0) representan las proporciones de personas inicialmente en los estados 1 y 2, respectivamente.

DEFINICIN DE CADENA DE MARKOV Un proceso estocstico Con un nmero finito de estados (M) Con probabilidades de transicin estacionarias Que tiene la propiedad Markoviano

Markov y la Toma de Decisiones En situaciones que impliquen una secuencia de ensayos con una cantidad finita de estados posibles en cada ensayo. Situaciones de competencia por adquisicin de clientela o permanencia en el mercado. Situaciones de estados absorbentes como en las cuentas por cobrar las cuentas incobrables.

Cadena de Markov 2011

En eventos donde la informacin se considera al azar o que pertenece a estados de suerte Markov Proporciona Informacin acerca de la probabilidad de cada estado despus de una gran cantidad de transiciones o periodos. Probabilidades a lo largo del tiempo o el estado en el que terminarn los acontecimientos. Idea del camino a tomar para alcanzar objetivos y metas.

PROCESO ESTOCSTICO: Es un conjunto o sucesin de variables aleatorias: {X(t)CG } definidas en un mismo espacio de probabilidad. Normalmente el ndice t representa un tiempo y X(t) el estado del proceso estocstico en el instante t. El proceso puede ser de tiempo discreto o continuo si G es discreto o continuo. Si el proceso es de tiempo discreto, usamos enteros para representar el ndice: {X1, X2,...}

EJEMPLOS DE PROCESOS ESTOCSTICOS: 1. Serie mensual de ventas de un producto 2. 3. 4. Estado de una mquina al final de cada semana (funciona/averiada) N de clientes esperando en una cola cada 30 segundos Marca de detergente que compra un consumidor cada vez que hace la compra. Se supone que existen 7 marcas diferentes N de unidades en almacn al finalizar la semana

5.

ELEMENTOS DE UNA CADENA DE MARKOV Un conjunto finito de M estados, exhaustivos y mutuamente excluyentes (ejemplo: estados de la enfermedad)

Cadena de Markov 2011

Ciclo de markov (paso) : periodo de tiempo que sirve de base para examinar las transiciones entre estados (ejemplo, un mes) Probabilidades de transicin entre estados, en un ciclo (matriz P) Distribucin inicial del sistema entre los M estados posibles

PROPIEDAD MARKOVIANA Un proceso estocstico tiene la propiedad Markoviano si las probabilidades de transicin en un paso slo dependen del estado del sistema en el perodo anterior (memoria limitada)

Cadena de Markov 2011

LAS CADENAS DE MARKOV SON UN CASO PARTICULAR DE MODELOS DE MARKOV

TIPOS DE MODELOS DE MARKOV: PROCESOS DE MARKOV (Modelos semi-markovianos): Las probabilidades de

transicin entre estados pueden variar a medida que transcurren ms ciclos Ejemplo: Para modelizar la esperanza de vida, el riesgo de muerte aumenta con la edad Cadenas de Markov: Las probabilidades de transicin se suponen constantes a lo largo del tiempo.

Cadena de Markov 2011

CLASIFICACIN DE LOS ESTADOS DE UNA CADENA DE MARKOV

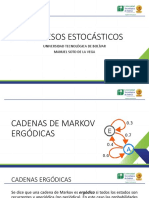

Estado Alcanzable: un estado j es alcanzable desde el estado i si hay una trayectoria que conduzca de i a j. Estados que se Comunican: se dice que dos estados i y j se comunican si j es alcanzable desde i, e i es alcanzable desde j. Estado Cerrado: un conjunto de estados S en una cadena de Markov es un conjunto cerrado si ningn estado fuera S es alcanzable desde algn estado en S. Estado Absorbente: un estado i es absorbente que cuando j llega ah no puede salir de l. Estado Transitorio: un estado i es un estado transitorio si existe un estado j que es alcanzable desde i, pero el estado i no es alcanzable desde el estado j. Estado Recurrente: siempre que parta del estado i ser recurrente si se pudiera volver al mismo estado i. un estado

Estado Peridico: un estado i es peridico con periodo k > 1 si k es el nmero ms pequeo tal que las trayectorias que conducen del estado i de regreso al estado i tienen una longitud que es mltiplo de k. Si un estado recurrente no es peridico, se conoce como aperidico. Cadena Ergdica: si los estados en una cadena son recurrentes, aperidicos y se comunican entre s, se dice que la cadena es ergdica.

Cadena de Markov 2011

APLICACIONES DE LA CADENA DE MARKOV

Las cadenas de Markov se pueden utilizar en modelos simples de valuacin de opciones para determinar cundo existe oportunidad de arbitraje, as como en el modelo de colapsos de una bolsa de valores o para determinar la volatilidad de precios. En los negocios, las cadenas de Markov se han utilizado para analizar los patrones de compra de los deudores morosos, para planear las necesidades de personal y para analizar el reemplazo de equipo.

1. APLICACIN EN LA LOGISTICA INVERSA Logstica inversa es el conjunto de procesos mediante el cual se gestiona la relacin cliente-proveedor desde el punto de consumo hasta el productor. En la actualidad muchas de las perdidas o disminucin de flujos de caja se asocian con el volumen de productos que son devueltos a las compaas, a lo que estas han hecho frente bajo la imposicin de sistemas de logstica inversa, para saber dnde y que garantas se le pueden dar al cliente, partiendo de sus requerimientos y deseos. Hoy en da existe una relativa falta de investigacin analtica frente a la mejor manera de gestionar los flujos de productos de logstica inversa, sobre todo desde el punto de vista financiero. La investigacin limitada existente tiene como objetivo ayudar a los gerentes a entender mejor cmo lograr una eficaz y eficiente optimizacin de costes y beneficios de las actividades. Por todo lo que la logstica inversa conlleva este artculo trata de hacerle frente a la aleatoriedad con que son devueltos los artculos, es decir a los volmenes, variables de bienes que son reintegrados por usuarios inconformes con ellos, frente a la liquidez futura que podr enfrentar cualquier compaa. El modelo de la valoracin de liquidez que se plantea nos permite observar el proceso de retornos de productos que se sigue a travs del sistema de logstica inversa. Este modelo incorpora el nmero de devoluciones y la dinmica del flujo de caja en este proceso. Dicho modelo es de vital importancia para las empresas, en el sentido de que la logstica inversa le genera un flujo de informacin, que en algn determinado momento mejora las relaciones cliente-proveedor, teniendo en cuenta que este proceso est regido generalmente por el siguiente diagrama:

Cadena de Markov 2011

El modelo de MARKOV considera el nmero de retornos independientes en algn periodo de tiempo dados; utilizando un modelo con estados de transicin y estados absorbentes, mediante el cual se tienen en cuenta las probabilidades que estn asociadas de pasar de un estado a otro y que sern organizadas en una matriz de transicin. Identificando el impacto que tiene el volumen de retornos y la liquidez en a travs de los costos, permitiendo que por medio de este modelo cada empresa tenga una escala programada y una capacidad diseada.

A partir de este artculo, podemos observar los modelos planteados por Cyer y Thompson, los cuales establecen que las probabilidades de los estados de transicin difieren entre si y que las caractersticas de riesgo producen un impacto en las cuentas por cobrar.

Por otra parte, los gerentes interesados en el aspecto de liquidez de la logstica inversa tambin valoran la habilidad para evaluar las mismas caractersticas de flujo de caja desde cada estado de transicin/capacidad de combinarlas lo que representa la salida del proceso.

Una de las principales aplicaciones de las cadenas de Markov en la vida real es el caso del flujo de efectivo, para determinar cmo migran los bonos corporativos de un nivel de calificacin a otro; se utilizan las cadenas de Markov para modelar procesos aleatorios que caracterizan los cambios en la calidad de las actividades. Esto se puede realizar bajo diferentes circunstancias por ejemplo bajo una certeza relativa, flujo de dinero peridico bajo incertidumbre, etc., para lo cual se ha desarrollado diferentes modelos que permiten facilitar el proceso segn sea el caso.

10

Cadena de Markov 2011

EL PROCESO DEBE RESPONDER A PREGUNTAS COMO: 1. Cules son las expectativas, la incertidumbre y la asimetra de la inversin del dinero en efectivo necesaria para apoyar a las unidades al azar con el azar efectos monetarios, permaneciendo en el sistema un nmero aleatorio de perodos antes de ser absorbidos? 2. Cules son las expectativas, incertidumbres, y el sesgo en los efectos monetarios como unidades al azar con los efectos monetarios aleatorios despus de ser absorbidos en el sistema? Las ventajas que contrae es que se puede trabajar con variables extradas de los estados financieros y se puede aplicar a todos los sectores. Pero una desventaja notable es que las variables se encuentran altamente correlacionadas por lo tanto se duda en la optimalidad de los resultados. Esta investigacin contribuye a la planificacin de la gestin, proceso que facilita el desarrollo de los intervalos de confianza asociados con las caractersticas de distribucin identificadas con el anlisis de la cadena de Markov. Los intervalos de confianza diferentes permitirn a los administradores estimar la probabilidad de que los resultados del siguiente periodo se producirn dentro de un rango. Esto permite a las empresas entender mejor a corto y a largo plazo planear en base a la necesidades de liquidez.

2. APLICACIN EN LA PLANEACIN DE PERSONAL. El anlisis de transicin puede ser til al planear satisfacer las necesidades de personal. Muchas firmas emplean trabajadores de diferentes niveles de clasificacin dentro de la misma categora de trabajo. Esto es comn para personal de confianza, oficinistas, obreros calificados, no calificados y personal profesional. La firma debe tener el nmero de empleados en cada nivel de clasificacin para proporcionar la oportunidad de promocin adecuada, cumplir con las habilidades necesarias para el trabajo y controlar la nmina. Una planeacin de personal a largo plazo apropiada requiere que se considere el movimiento de personas tanto hacia arriba en el escalafn de clasificacin como hacia afuera de la organizacin. El anlisis de Markov puede ayudar en este esfuerzo de planeacin. El movimiento de personal a otras clasificaciones puede considerarse como una cadena de Markov. Se supone que hay tres clasificaciones; el grado 1 es la ms baja. Adems, los descensos se consideran raros y se omiten. El estado

11

Cadena de Markov 2011

salen es absorbente, el cual incluye renuncias, ceses, despidos y muertes. Por supuesto, todos los empleados finalmente alcanzan este estado. Las transiciones del grado 1 al grado 2 y del grado 2 al grado 3 representan promociones. Como transiciones de probabilidad, estn controladas por la firma, puede establecerse el nivel que la firma determine que es necesario para cumplir sus objetivos. Como ejemplo, supngase que la firma tiene en este momento 30 empleados del 3, 90 empleados del grado 2 y 300 empleados del grado 1 y que desea mantener este nivel de empleados durante el prximo ao. Por experiencia, se espera que salgan el 30 % de los empleados de grado 1 al ao, el 20 % de los empleados de grado 2 y el 10 % de aquellos que estn en el grado 3. Si la poltica es contratar slo en los niveles de clasificacin ms bajos, cuntos se deben contratar y cuntos se deben promover el siguiente ao para mantener estables los niveles ?. Este problema puede resolverse sin el anlisis de Markov, pero el modelo es til para ayudar a conceptualizar el problema. Como se trata slo de un ciclo, se usa el anlisis de transicin. El anlisis comienza con el graado ms alto. No se hacen promociones pero el 10 %, o sea, 3, sale. Todos ellos deben de reemplazarse por promociones del grado 2. En el nivel de clasificacin, el 20 % sale y se deben promover 3, con una prdida de 21. Esto se debe compensar por promocin del grado 1. Al pasar al grado 1, el 30 % sale y 21 deben promoverse, lo cual una prdida total de 111. Por tanto, el siguiente ao se deben contratar 111 empleados del nivel 1.

3. APLICACIN EN EL MARKETING Markov permite analizar y conocer a los consumidores en un mercado actual y competitivo, ya que, proporciona herramientas adecuadas para poder estudiar la realidad de la participacin de la demanda. Asimismo podemos analizar la situacin de las cuentas por cobrar en una organizacin. Al aplicar Markov en cuanto a los demandantes en un mercado consumidor nos podemos dar cuenta de la exigencia del cliente para poder cubrir sus necesidades y as convertirlo en un cliente fiel. A travs de este anlisis se puede llegar a conocer las posibles actitudes de los clientes de un perodo a otro y as estar a la vanguardia y poder cubrir al mximo sus expectativas para lograr su satisfaccin y as mantenerse en el mercado competitivo. Tambin se debe tomar en cuenta que Markov permite hacer un anlisis en relacin a lo financiero de la organizacin y debemos recordar que para que una empresa subsista su principal motor es el capital por lo que se debe reguardar siempre, lo que significa tomar decisiones correctas en las inversiones. Esto implica que se debe conocer el mercado, las leyes a las

12

Cadena de Markov 2011

cuales esta sujeta la empresa, las tendencias tecnolgicas, la competencia, la situacin financiera cambiaria y finalmente hacer un anlisis de los clientes con los que cuenta la empresa para as poder otorgar crditos; ya que esto significa tener que recuperar esa cuenta. Al hablar de proporcionar crditos significa que va existir una cuenta por cobrar la cual tiene que mostrar un equilibrio adecuado para la toma de decisiones de los propietarios.

EJEMPLO DE APLICACIN 1: Un experto en mercadeo est interesado en analizar la participacin en el mercado y lealtad del cliente para Comercial Crdova y Bazar Europa. Para el efecto se recopil datos de 100 compradores de la ciudad de Chiquimula a lo largo de un periodo de 10 semanas. Se supone que estos datos muestran el patrn de viajes de compras semanales de cada cliente en funcin de la secuencia de visitas a Comercial Crdova y Bazar Europa. Para el efecto se toman en cuenta los datos del periodo anterior. Al revisar los datos, suponga que encontramos que de todos los clientes que compraron en Comercial Crdova en una semana dada, 80% compro en Comercial Crdova la siguiente semana, mientras 20% cambio a Bazar Europa. Suponga que datos similares para los clientes que compraron en Bazar Europa en una semana dada muestran que 70% compro en Bazar Europa la siguiente semana, mientras 30% cambio a Comercial Crdova. A partir de lo anterior establecer las probabilidades de transicin a travs del mtodo de markov. Probabilidades de transicin para las tiendas Comercial Crdova y Bazar Europa Periodo de Compra siguiente periodo de compra semanal Semanal actual Comercial Crdova Bazar Europa Comercial Crdova 0.80 0.20

Bazar Europa 0.30 0.70 P =P11 P12 0.80 0.20 P21 P22 0.30 0.70 Con la matriz de probabilidades podemos determinar la probabilidad de que un cliente visite Comercial Crdova o Bazar Europa en algn periodo del futuro. Suponiendo que tenemos un cliente cuyo ltimo viaje de compras fue a

13

Cadena de Markov 2011

Comercial Crdova. Cul es la probabilidad de que este cliente compre en Comercial Crdova en el siguiente viaje semanal, periodo 1?

Con un diagrama de rbol se puede describir dos viajes de compras semanales de un cliente que compro la ltima vez en Comercial Crdova. A continuacin se observa el recorrido: Semana 1 Semana 2 Probabilidad de cada patrn en 2 semanas Cliente que compro 0.80 0.80 Crdova (0.80) (0.80) = 0.64 La ltima vez en 0.20 Bazar Europa (0.80) (0.20) = 0.16 Comercial Crdova 0.20 0.30 Crdova (0.20) (0.30) = 0.06 0.70 Bazar Europa (0.20) (0.70) = 0.14 {1 (1) 2 (1)} = {1 (0) 2 (0)} (P11 P12) (P21 P22) = (0.80 0.20) (0.30 0.70) (0.70 0.30)

La probabilidad de comprar en Comercial Crdova durante la segunda semana es del 70% (0.70), mientras la probabilidad de comprar en Bazar Europa durante la segunda semana es de 30% (0.30).

Ejemplo de aplicacin 2: Parte de la base de que las probabilidades de que un consumidor adquiera una marca depende la marca comprada anteriormente, y de un conjunto de probabilidades de cambio de marca, denominada matriz de transicin, que permanecen constantes en el tiempo. Las probabilidades de transicin son aquellas de que habiendo adquirido una marca A en el periodo anterior, se adquiera esa misma marca u otra en el periodo siguiente. En el caso de tres marcas sera:

14

Cadena de Markov 2011

La PAB es la probabilidad de que habiendo adquirido A en el periodo anterior, ahora adquiera B. Para explicar mejor su funcionamiento, vayamos a un ejemplo. Supongamos un mercado con 3 empresas A, B y C, que se reparten un mercado estable de 1.000 unidades. Supongamos tambin que cada consumidor solo lo hace en una ocasin en el momento t. Se podra construir una tabla como la siguiente: Clientes MARCA en t A B C 400 400 200 1.000 Clientes retenidos en t+1 320 280 160 760 Clientes ganados en t+1 40 100 100 240 Clientes perdidos en t + 1 80 120 40 240 Clientes totales en t + 1 360 380 260 1.000 Cuota de mercado en t + 1 36% 38% 26% 100%

Ahora lo que nos interesa es conocer de cada una de las empresas a donde han ido los clientes que ha perdido y de donde venan los que ha ganado. Esto se puede conseguir de un panel de consumo por ejemplo. Supongamos que obtenemos los siguientes datos. Clientes atrados desde Marca A B C A 0 70 10 B 30 0 90 C 10 30 0

Igualmente podramos haber construido la tabla de los clientes perdidos hacia, que en realidad es la inversa de esta. Con estos datos podemos calcular la matriz de probabilidades, que sera: PAA= 320/400 = 0,8 PBA= 30/400 = 0,075 PCA= 10/200=0,05 PAB= 70/400=0,175 PBB= 280/400=0,7 PCB=30/200=0,15 PAC= 10/400=0,025 PBC= 90/400=0,225 PCC=160/200=0,8

15

Cadena de Markov 2011

Si se formula la hiptesis, de que la matriz de transicin permanece constante, se puede estimar la cuota de mercado en el periodo siguiente, multiplicndola por el vector de cuota de mercado de este periodo. T x C t+1 = C t+2 La cuota de mercado en el equilibrio se puede calcular por: T x C E = C E; donde C E es la cuota de equilibrio. Quedando De donde se obtiene un sistema de 3 ecuaciones con tres incgnitas, de las que solo se pueden aprovechar dos, pero teniendo en cuenta que C A + C B + C C =1 ya lo podemos resolver. Y para este ejemplo los valores obtenidos seran los siguientes: C A = 0,2346; C B = 0,3464 y C C = 0,4190

16

Cadena de Markov 2011

BIBLIOGRAFIA

1. 2. 3. 4. 5. 6. 7.

Derman, C. Finite State Markovian Decision Processes, Academic Press, New York, 1970. Howard, R. Dinamic Programing and Markov Processes, MIT Press, Cambridge Mass, 1960. http://html.rincondelvago.com/cadenas-de-markov.html http://sistemas.itlp.edu.mx/tutoriales/investoper2/tema43.htm http://es.wikipedia.org/wiki/Cadena_de_Markov

17

Vous aimerez peut-être aussi

- Introducción a las señales y sistemasD'EverandIntroducción a las señales y sistemasÉvaluation : 4.5 sur 5 étoiles4.5/5 (3)

- Cadenas de Markov en Ingeniería IndustrialDocument13 pagesCadenas de Markov en Ingeniería IndustrialKimberly Ariana Castillo LovatonPas encore d'évaluation

- Inv - Ope.2 - UNIDAD IVDocument22 pagesInv - Ope.2 - UNIDAD IVJonathan Millan RodríguezPas encore d'évaluation

- Modelos ocultos de Markov enDocument31 pagesModelos ocultos de Markov enCeli JLPas encore d'évaluation

- Conocimiento de EmbarqueDocument29 pagesConocimiento de EmbarqueSofia Guerrero86% (22)

- 03.cadenas de Markov Ergódicas PDFDocument24 pages03.cadenas de Markov Ergódicas PDFKelly Villa0% (1)

- Ensayo Cadenas de Markov David AlvaradoDocument3 pagesEnsayo Cadenas de Markov David AlvaradoALESSANDRO JAVIER MÁRQUEZ ALCÁNTARAPas encore d'évaluation

- Trabajo Investigación Investigación de Operaciones 2Document14 pagesTrabajo Investigación Investigación de Operaciones 2Marco CastañazaPas encore d'évaluation

- Analisis de MarkovDocument47 pagesAnalisis de MarkovChristian LeónPas encore d'évaluation

- Análisis de MarkovDocument51 pagesAnálisis de MarkovPerla_Celeste__754886% (7)

- Investigación OperativaDocument32 pagesInvestigación OperativaMarcos Bartra PerezPas encore d'évaluation

- Análisis de MarkovDocument4 pagesAnálisis de Markovgustavo ctPas encore d'évaluation

- Cadena de MarkovDocument27 pagesCadena de MarkovLeo MessiPas encore d'évaluation

- Presentación Cadenas de MarkovDocument12 pagesPresentación Cadenas de MarkovOmar ReyesPas encore d'évaluation

- Cadenas de MarkovDocument7 pagesCadenas de Markovtadeanguiano086Pas encore d'évaluation

- Cadenas de MarkovDocument17 pagesCadenas de MarkovOskarSanchezPas encore d'évaluation

- Cadenas de Markov: Análisis de transiciones de estadosDocument33 pagesCadenas de Markov: Análisis de transiciones de estadosMiguel Angel Iribe Zazueta100% (1)

- Cadenas de MarkovDocument6 pagesCadenas de MarkovDaniel Ordaz AlvarezPas encore d'évaluation

- Tecnológico Nacional de México: PeríodoDocument20 pagesTecnológico Nacional de México: PeríodoWendy Estefania Saldivar CuervoPas encore d'évaluation

- Ensayo Io2 Unidad 4 Markov Cardenas Puga Luis FernandoDocument15 pagesEnsayo Io2 Unidad 4 Markov Cardenas Puga Luis FernandoLuisFernandoCronchisPas encore d'évaluation

- Cadenas de MarkovDocument25 pagesCadenas de MarkovCristhianPas encore d'évaluation

- Inv. Ope Ii U4Document22 pagesInv. Ope Ii U4Victor Manuel Cruz Martinez100% (1)

- Ensayo Cadenas de Markov - 2010Document10 pagesEnsayo Cadenas de Markov - 2010Viviana HernándezPas encore d'évaluation

- Tarea 2 IO2Document6 pagesTarea 2 IO2Marco CastañazaPas encore d'évaluation

- Unidad 4 y 5Document43 pagesUnidad 4 y 5Karla LiceaPas encore d'évaluation

- 4.1 Fernandez Lopez AdrianDocument12 pages4.1 Fernandez Lopez AdrianAdrian FernandezPas encore d'évaluation

- ActExtra - U4 Rodriguez Santiago Pedro AlejandroDocument16 pagesActExtra - U4 Rodriguez Santiago Pedro AlejandroPEDRO ALEJANDRO RODRIGUEZ SANTIAGOPas encore d'évaluation

- Modelo de MarkovDocument105 pagesModelo de MarkovEliezer VerasPas encore d'évaluation

- Clase6 IOCadenasMarkovDocument36 pagesClase6 IOCadenasMarkovJuan Paredes Campos0% (1)

- Introducción A Las Cadenas de MarkovDocument2 pagesIntroducción A Las Cadenas de MarkovCarlosCarrilloPas encore d'évaluation

- Investigacion Segundo ParcialDocument10 pagesInvestigacion Segundo ParcialcindyPas encore d'évaluation

- Qué EsDocument96 pagesQué EsFelix Americo QuispePas encore d'évaluation

- Cadenas de MarkovDocument11 pagesCadenas de MarkovEdgar Castillo AmadoPas encore d'évaluation

- R 66900Document30 pagesR 66900as_oleo_mys_ca100% (1)

- Cadenas de MarkovDocument9 pagesCadenas de MarkovDANITZA KATHERINE JUANEZPas encore d'évaluation

- Cadenas de Markov: Trabajo de Investigación Unidad 4 Que PresentaDocument19 pagesCadenas de Markov: Trabajo de Investigación Unidad 4 Que PresentaPEDRO ZEPEDA SANCHEZ100% (1)

- Cadena Markov UNAH Ingeniería IndustrialDocument12 pagesCadena Markov UNAH Ingeniería IndustrialYamilethPas encore d'évaluation

- Cadenas de MarkovDocument13 pagesCadenas de MarkovMariana InclanPas encore d'évaluation

- Ensayo-Cadenas de MarkovDocument9 pagesEnsayo-Cadenas de MarkovMOUSES BYPas encore d'évaluation

- ResumenProcesosMarkovianos AlissonMurilloDocument4 pagesResumenProcesosMarkovianos AlissonMurilloalissonPas encore d'évaluation

- Tarea 4.1 EnsayoDocument12 pagesTarea 4.1 Ensayolupita sernaPas encore d'évaluation

- La cadena de Markov y sus aplicaciones en Investigación de OperacionesDocument6 pagesLa cadena de Markov y sus aplicaciones en Investigación de OperacionesAngie MosqueraPas encore d'évaluation

- Cadena Da MarkovDocument12 pagesCadena Da MarkovAnna Lizeth AlmendarezPas encore d'évaluation

- Cadenas markovNPJ PDFDocument33 pagesCadenas markovNPJ PDFOchoa VictorPas encore d'évaluation

- Cadenas de Markov para determinar probabilidadesDocument7 pagesCadenas de Markov para determinar probabilidadesIan EstradaPas encore d'évaluation

- Modelos de Simulación LogisticaDocument10 pagesModelos de Simulación LogisticaJuan Carlos VargasPas encore d'évaluation

- Investigacion de Operaciones Unidad 4Document21 pagesInvestigacion de Operaciones Unidad 4Victor CastilloPas encore d'évaluation

- Cadena de Markov. Grupo 3Document26 pagesCadena de Markov. Grupo 3Aldair Vega AlbanPas encore d'évaluation

- Resumen Procesos MarkovianosDocument4 pagesResumen Procesos MarkovianosalissonPas encore d'évaluation

- Cadenas MarkovDocument13 pagesCadenas MarkovAngel GarciaPas encore d'évaluation

- CadenaMarkovIO2Document8 pagesCadenaMarkovIO2feliizzPas encore d'évaluation

- Investigacion Cadenas de Markov.Document10 pagesInvestigacion Cadenas de Markov.yoPas encore d'évaluation

- Articulo Cadenas de Markov en Tiempo ContinuoDocument7 pagesArticulo Cadenas de Markov en Tiempo ContinuoAndrea NavarroPas encore d'évaluation

- Cadenas Markov PDFDocument8 pagesCadenas Markov PDFAnonymous gR34gQPas encore d'évaluation

- Investigación de Las Cadenas de Markov U4 - LCARDocument8 pagesInvestigación de Las Cadenas de Markov U4 - LCARArellano RamosPas encore d'évaluation

- Comprobación de Lectura Semana 9Document2 pagesComprobación de Lectura Semana 9Sergio CastilloPas encore d'évaluation

- Tarea 6 F.C I.O PDFDocument4 pagesTarea 6 F.C I.O PDFAngie MosqueraPas encore d'évaluation

- Casos PdiDocument4 pagesCasos Pdikarla paola contrerasPas encore d'évaluation

- Concepto de Cadena de MarkovDocument9 pagesConcepto de Cadena de MarkovYanny ZuñigaPas encore d'évaluation

- Exercises Decision Analysis Markov Chain 1 To 10Document2 pagesExercises Decision Analysis Markov Chain 1 To 10chris martinezPas encore d'évaluation

- Procesos MarkovianosDocument8 pagesProcesos MarkovianosArmando TrampaPas encore d'évaluation

- Bases para AtaudesDocument18 pagesBases para AtaudesMilthon Loza ChambillaPas encore d'évaluation

- Auditoría administrativa normas internacionalesDocument21 pagesAuditoría administrativa normas internacionalesJY AN AVPas encore d'évaluation

- Formulario 01 PDFDocument20 pagesFormulario 01 PDFUSBSU_2014Pas encore d'évaluation

- El Presente Trabajo Muestra Un Análisis EconómicoDocument21 pagesEl Presente Trabajo Muestra Un Análisis EconómicoMilthon Loza ChambillaPas encore d'évaluation

- Acta de Reunión 002 Parvulos CGTDocument2 pagesActa de Reunión 002 Parvulos CGTMilthon Loza ChambillaPas encore d'évaluation

- Para Realizar Un Análisis Exhaustivo de La Situación de La EmpresaDocument9 pagesPara Realizar Un Análisis Exhaustivo de La Situación de La EmpresaMilthon Loza ChambillaPas encore d'évaluation

- 03 - Anexo 1 de La Directiva 009-2011-CG OEADocument2 pages03 - Anexo 1 de La Directiva 009-2011-CG OEAhuasabertoPas encore d'évaluation

- Auditoría administrativa normas internacionalesDocument21 pagesAuditoría administrativa normas internacionalesJY AN AVPas encore d'évaluation

- 10 de Enero Del 2016 AtalayaDocument6 pages10 de Enero Del 2016 AtalayaMilthon Loza ChambillaPas encore d'évaluation

- Ley 29951Document28 pagesLey 29951Jim QuiñonezPas encore d'évaluation

- Unidad 03 WordDocument19 pagesUnidad 03 WordMilthon Loza ChambillaPas encore d'évaluation

- Energia Minera $Document16 pagesEnergia Minera $Milthon Loza ChambillaPas encore d'évaluation

- Administracion PruebaDocument20 pagesAdministracion PruebaMilthon Loza ChambillaPas encore d'évaluation

- Empresa Electricidad Del PeruDocument1 pageEmpresa Electricidad Del PeruMilthon Loza ChambillaPas encore d'évaluation

- Estrategias de PublicidadDocument3 pagesEstrategias de PublicidadMilthon Loza ChambillaPas encore d'évaluation

- Estrategias de PublicidadDocument3 pagesEstrategias de PublicidadMilthon Loza ChambillaPas encore d'évaluation

- Ques Una Base de DatosDocument1 pageQues Una Base de DatosMilthon Loza ChambillaPas encore d'évaluation

- Gestion de Almacenes FinalDocument37 pagesGestion de Almacenes FinalMilthon Loza ChambillaPas encore d'évaluation

- Mego Practica GanttDocument3 pagesMego Practica GanttMilthon Loza ChambillaPas encore d'évaluation

- Grupo ProduccionDocument7 pagesGrupo ProduccionMilthon Loza ChambillaPas encore d'évaluation

- FacturaDocument1 pageFacturaJaime Sarmiento ZegarraPas encore d'évaluation

- SiafDocument10 pagesSiafManuel Smith Hinostroza HuamánPas encore d'évaluation

- 1 - Introduccion A La Investigacin de OperacionesDocument25 pages1 - Introduccion A La Investigacin de OperacionesMilthon Loza ChambillaPas encore d'évaluation

- RC N°180-2005-Ef93.01-19Document2 pagesRC N°180-2005-Ef93.01-19Milthon Loza ChambillaPas encore d'évaluation

- Instalación de Windows XPDocument6 pagesInstalación de Windows XPMilthon Loza ChambillaPas encore d'évaluation

- Temas de ProduccionDocument1 pageTemas de ProduccionMilthon Loza ChambillaPas encore d'évaluation

- Plan ContableDocument22 pagesPlan ContableMery073Pas encore d'évaluation

- Produccion de CerdosDocument35 pagesProduccion de CerdosMilthon Loza Chambilla67% (3)

- Taller en Grupo Cadenas de MarkovDocument2 pagesTaller en Grupo Cadenas de MarkovDayro Avila0% (2)

- Modelos Markov trayectoria estudiantes UJATDocument15 pagesModelos Markov trayectoria estudiantes UJATMarcelo GutierrezPas encore d'évaluation

- Actividad Unidad 2Document8 pagesActividad Unidad 2TonyPas encore d'évaluation

- Primer Encuentro SincrónicoDocument8 pagesPrimer Encuentro SincrónicoCarlos HernandezPas encore d'évaluation

- Procesos de Markov - 202002 - 07082020Document59 pagesProcesos de Markov - 202002 - 07082020Fiorella Ingrid Palacios AcevedoPas encore d'évaluation

- Problemas de ProgramacionDocument34 pagesProblemas de ProgramacionZandro RaPas encore d'évaluation

- Dorantesbenavidez Y1133Document7 pagesDorantesbenavidez Y1133FelipeHernandezPas encore d'évaluation

- Cadenas de MarkovDocument40 pagesCadenas de MarkovLeonardo Chavez Ontiveros100% (2)

- Mpes U2 A3 JeruDocument5 pagesMpes U2 A3 JeruJesús ÚrzuloPas encore d'évaluation

- Cadenas de Markov (Matriz de Transicion) (Solucionario)Document2 pagesCadenas de Markov (Matriz de Transicion) (Solucionario)Arnold PretelPas encore d'évaluation

- Clase 12 EstocasticosDocument16 pagesClase 12 EstocasticosJhon Esteban Arredondo ParraPas encore d'évaluation

- Parte 3 Teoria de ColasDocument24 pagesParte 3 Teoria de Colasasdfasd alsdfjdisodfj askdfjdkls jdjiesdfPas encore d'évaluation

- AbsorventeDocument41 pagesAbsorventeNeodith RodriguezPas encore d'évaluation

- Cadenas de MarkovDocument2 pagesCadenas de Markovlisandro mesaPas encore d'évaluation

- Markov Models SoftwareDocument8 pagesMarkov Models SoftwareDaniel CabreraPas encore d'évaluation

- Procesos de Decision MarkovianosDocument5 pagesProcesos de Decision MarkovianosDulce EstrellaPas encore d'évaluation

- Silabo de Investigacion de Operaciones 2Document4 pagesSilabo de Investigacion de Operaciones 2Alexander Olivares RodriguezPas encore d'évaluation

- Toscana Moretto VillarrealDocument8 pagesToscana Moretto VillarrealAPas encore d'évaluation

- Análisis de cadenas de Markov y sus aplicacionesDocument6 pagesAnálisis de cadenas de Markov y sus aplicacionescesar anaya100% (1)

- Modelos Estocásticos y Simulacion MateriaDocument4 pagesModelos Estocásticos y Simulacion MateriaxxxtunoxxxPas encore d'évaluation

- Pauta Prueba 1 de Modelos Estocasticos 2017Document10 pagesPauta Prueba 1 de Modelos Estocasticos 2017Maxi David Cavieres ZentenoPas encore d'évaluation

- TALLERDocument5 pagesTALLERAna LilianaPas encore d'évaluation

- Ruina Del JugadorDocument20 pagesRuina Del JugadorFreddy Andres NavarretePas encore d'évaluation

- Actividad 4.1 Investigación Luis MDocument5 pagesActividad 4.1 Investigación Luis MSussan CortesPas encore d'évaluation

- IEEE - Análisis de Fallas en Un Sistema Eléctrico Utilizando Cadenas de MarkovDocument8 pagesIEEE - Análisis de Fallas en Un Sistema Eléctrico Utilizando Cadenas de MarkovJuan Sebastian Juris ZapataPas encore d'évaluation

- Guía 7 Cadenas de MarkovDocument6 pagesGuía 7 Cadenas de MarkovOscar Jhaffet PacoPas encore d'évaluation