Académique Documents

Professionnel Documents

Culture Documents

Clase 4

Transféré par

wicker123Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Clase 4

Transféré par

wicker123Droits d'auteur :

Formats disponibles

Transmisi on de Datos

Tema 2: De la Entrop a a la Codicaci on de Canal. Clase 4

Jose Antonio Portilla Figueras

Curso 2009/10

Jose Antonio Portilla Figueras

Transmisi on de Datos

De la Entrop a a la Codicaci on de Canal

Contenidos Clase 3

Concepto de Incertidumbre y Cantidad de Informaci on.

Denici on de Entrop a.

Lema de Gibs.

Entrop a de una fuente binaria.

Contenidos Clase 4

Concepto de Entrop a Conjunta.

Entrop a condicionada

Informaci on m utua.

Capacidad de Canal.

Jose Antonio Portilla Figueras

Transmisi on de Datos

Incertidumbre

En general un canal es un sistema de entrada/salida. Por lo tanto para poder estudiar la capacidad del mismo, deberemos estudiar la relaci on entre la informacin de entrada y la informaci on de salida.

Esta relaci on se denomina Informaci on M utua y se dene como la cantidad de informaci on que una variable aleatoria contiene sobre la otra.

Sin embargo antes de continuar con este concepto debemos estudiar otros.

El primero de ellos es la entropa conjunta de dos variables aleatorias.

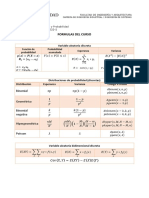

H (X , Y ) =

i =1 j =1

m n X X

p (xi , yj ) logb

1 p (xi , yj )

Evidentemente p (xi , yj ) es la probabilidad denida por la variable aleatoria bidimensional (X,Y).

Jose Antonio Portilla Figueras

Transmisi on de Datos

Entrop a Condicionada

Formalmente la Entropa Condicionada de una fuente de informacin Y es la cantidad de informaci on que nos proporcionan los mensajes de dicha fuente una vez que se conoce el mensaje de otra fuente X que puede guardar alguna relaci on con la primera. Pn

i =1

H (Y |X ) = H (Y |x = xi ) = Pm

p (xi ) H (Y |x = xi )

1 p ( y | x ) log j i 2 j =1 p (yj |xi )

Jose Antonio Portilla Figueras

Transmisi on de Datos

Informaci on M utua

Ya tenemos las herramientas necesarias para poder denir el concepto de Informaci on M utua. Consideremos dos variables aleatorias discretas X e Y, se dene la informaci on mutua I (X ; Y ) como:

I (X ; Y ) = H (X ) H (X |Y ) = H (Y ) H (Y |X )

Jose Antonio Portilla Figueras

Transmisi on de Datos

Capacidad de Canal

Comencemos ahora a estudiar el concepto de Capacidad de Canal. Para ello lo primero que debemos hacer es caracterizar el canal. En un canal discreto vamos a tener:

Un conjunto nito de entrada X = {x1 , x2 , xn } Un conjunto nito de salidad Y = {y1 , y2 , ym } Un conjunto de probabilidades condicionadas, que establecen la matriz Q .

p (y1 /x1 ) B p (y1 /x2 ) B Q=B @ p (y1 /x2 )

p (y2 /x1 ) p (y2 /x2 ) p (y2 /x2 )

1 .. . p (ym /x1 ) p (ym /x2 ) . . . p (ym /x2 ) C C C A

Jose Antonio Portilla Figueras

Transmisi on de Datos

Capacidad de Canal

Capacidad de Canal: Sea X la variable aleatoria discreta que representa la introducci on de un s mbolo en el canal, y sea Y la variable aleatoria discreta que representa la salida de un s mbolo del canal. Se dene la Capacidad del canal como el m aximo valor posible que puede adoptar la informaci on m utua entre las variables aleatorias X e Y cuando se consideran todas las posibles distribuciones de la variable aleatoria X .

C = max I (X ; Y )

p (x )

Jose Antonio Portilla Figueras

Transmisi on de Datos

Resumen

Hemos estudiado la entrop a condicionada como relaci on entre la entrada y la salida de un sistema de comunicaciones.

Debemos recordar las propiedades y las f ormulas que la denen.

La Informaci on M utua nos proporciona la informaci on que tenemos de lo que se ha enviado una vez que hemos recibido.

La maximizaci on de la Informaci on M utua nos proporciona el valor de la Capacidad del Canal.

Nos queda un cierto camino hasta llegar a la formulaci on de la Capacidad de Canal ofrecida en la Introducci on.

Jose Antonio Portilla Figueras

Transmisi on de Datos

Vous aimerez peut-être aussi

- Las Estadísticas de Orden Como Una Aplicación de Transformación de Funciones VariablesDocument68 pagesLas Estadísticas de Orden Como Una Aplicación de Transformación de Funciones VariablesPrograma Ingeniería de SistemasPas encore d'évaluation

- Pci MatematicaDocument55 pagesPci MatematicaElizabeth Moya CubaPas encore d'évaluation

- EcoIII - Tarea No.1Document4 pagesEcoIII - Tarea No.1Heidi Cabrera ManchenoPas encore d'évaluation

- Componentes de Una InvestigaciónDocument1 pageComponentes de Una InvestigaciónRodrigo CristóbalPas encore d'évaluation

- Programa de Probabilidad y Estadistica 2024Document5 pagesPrograma de Probabilidad y Estadistica 2024Carlos Isaí Amaya FloresPas encore d'évaluation

- ProyectoDocument126 pagesProyectoGuilleLenisPozoPas encore d'évaluation

- 4.1 Ejercicios de Variables Aleatorias DiscretasDocument14 pages4.1 Ejercicios de Variables Aleatorias DiscretasRafael David Acosta TorresPas encore d'évaluation

- SEMANA - 09 - ESTADÍSTICA - GENERAL - UPEU - VER 02 REGMultivariadaDocument52 pagesSEMANA - 09 - ESTADÍSTICA - GENERAL - UPEU - VER 02 REGMultivariadaJuan Jesús Soria QuijaitePas encore d'évaluation

- Lista 9 Epim 2019-I-2Document2 pagesLista 9 Epim 2019-I-2Enzo José Canales GuerreroPas encore d'évaluation

- Sistema de Informacion Geográfica SEG GuerreroDocument12 pagesSistema de Informacion Geográfica SEG GuerreroFulgencio Pineda JaimesPas encore d'évaluation

- Tema2 TestDocument3 pagesTema2 TestTanaPas encore d'évaluation

- Tema6 Muestreo Aceptacion Atributos PDFDocument24 pagesTema6 Muestreo Aceptacion Atributos PDFdamianPas encore d'évaluation

- Series de TiempoDocument25 pagesSeries de Tiempoppcharly69Pas encore d'évaluation

- Tabla de Investigacion CientificaDocument2 pagesTabla de Investigacion CientificaNayely BosmedianoPas encore d'évaluation

- TP SoftwareDocument37 pagesTP SoftwareFranco Ragnar CarlzonPas encore d'évaluation

- FORMULARIO XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXDocument3 pagesFORMULARIO XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXManuel SilveraPas encore d'évaluation

- A171Z215 EstadisticaInferencialDocument6 pagesA171Z215 EstadisticaInferencialOsman Albino Mejia HidalgoPas encore d'évaluation

- Prueba de Hip Tesis para Dos Parametros LAB MATEM TICAS PDFDocument4 pagesPrueba de Hip Tesis para Dos Parametros LAB MATEM TICAS PDFWalter Yoel Soto MamaniPas encore d'évaluation

- Módulo 1Document51 pagesMódulo 1Alina Muriel Boy GibePas encore d'évaluation

- Proyecto Final - Estadistica DescriptivaDocument28 pagesProyecto Final - Estadistica DescriptivaMelany ScarletPas encore d'évaluation

- Movilidad Sostenible A Través de Los Patinetes EléctricosDocument50 pagesMovilidad Sostenible A Través de Los Patinetes EléctricosSamir david MahechaPas encore d'évaluation

- Confiabilidad-2018 Dr. MóllerDocument385 pagesConfiabilidad-2018 Dr. MóllerLuis Alfredo Chumacero Espada100% (1)

- Resumen Del Libro Desarrollo A Escala HumanaDocument11 pagesResumen Del Libro Desarrollo A Escala HumanaElizabeth OrtegonPas encore d'évaluation

- Unidad Cero y Evaluación Diagnostica - Primaria - 5to y 6to - V CicloDocument12 pagesUnidad Cero y Evaluación Diagnostica - Primaria - 5to y 6to - V CicloKarla MostaceroPas encore d'évaluation

- Estádisticas II EstratificadoDocument5 pagesEstádisticas II EstratificadoLuis Arturo Lopez VergaraPas encore d'évaluation

- Proyecto IntegradorDocument7 pagesProyecto IntegradorCARLOS DAVID GRANDE DEL GALLEGOPas encore d'évaluation

- Fundamentos Control Estadístico de ProcesosDocument8 pagesFundamentos Control Estadístico de ProcesosJuan Camilo Brand OrtizPas encore d'évaluation

- ES0301 Practica DirigidaDocument2 pagesES0301 Practica DirigidaGuido LuquePas encore d'évaluation

- 5) U.3 As-13 Joint Commission International (2010)Document82 pages5) U.3 As-13 Joint Commission International (2010)Juan Francisco Esteves GarciaPas encore d'évaluation