Académique Documents

Professionnel Documents

Culture Documents

MVillasepln 09

Transféré par

Mvilc0 évaluation0% ont trouvé ce document utile (0 vote)

142 vues9 pagesPropuesta y evaluación de un método extractivo de generación de resúmenes en el ámbito biomédico basado en conceptos

Titre original

MVillasepln09

Copyright

© Attribution Non-Commercial (BY-NC)

Formats disponibles

PDF, TXT ou lisez en ligne sur Scribd

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentPropuesta y evaluación de un método extractivo de generación de resúmenes en el ámbito biomédico basado en conceptos

Droits d'auteur :

Attribution Non-Commercial (BY-NC)

Formats disponibles

Téléchargez comme PDF, TXT ou lisez en ligne sur Scribd

0 évaluation0% ont trouvé ce document utile (0 vote)

142 vues9 pagesMVillasepln 09

Transféré par

MvilcPropuesta y evaluación de un método extractivo de generación de resúmenes en el ámbito biomédico basado en conceptos

Droits d'auteur :

Attribution Non-Commercial (BY-NC)

Formats disponibles

Téléchargez comme PDF, TXT ou lisez en ligne sur Scribd

Vous êtes sur la page 1sur 9

Propuesta y evaluación de un método extractivo de generación de

resúmenes en el ámbito biomédico basado en conceptos

A proposal and evaluation of an extractive method for summarization in the

biomedical domain based on concepts

Manuel de la Villa y Manuel J. Maña

Departamento Tecnologías de la Información

Universidad de Huelva.

Campus La Rabida. Edif. Torreumbría,

21618, Palos de la Frontera, Huelva, España

{manuel.villa, manuel.mana}@dti.uhu.es

Resumen: Los métodos de generación de resúmenes basados en técnicas extractivas han

demostrado ser muy útiles por su adaptabilidad y eficiencia en tiempo de respuesta en cualquier

tipo de dominios. En el ámbito biomédico son numerosos los estudios que hablan de la

sobrecarga de información y recogen la necesidad de aplicación de técnicas eficientes de

recuperación y generación de resúmenes para una correcta aplicación de la medicina basada en

la evidencia. En este contexto vamos a presentar una propuesta metodológica de generación

automática de resúmenes basada en ontologías y grafos, aplicando técnicas de similitud y la

frecuencia de aparición de los conceptos para obtener las frases más relevantes. Se realiza una

evaluación de la propuesta frente a otras metodologías con la herramienta ROUGE y se analizan

los resultados. Aunque la extensión del conjunto de evaluación no permite extraer conclusiones

significativas, los resultados son suficientemente prometedores como para confiar en la

efectividad de la propuesta presentada.

Palabras clave: resumen automático, método extractivo, conceptos biomédicos, UMLS

Abstract: The methods for automatic summarization generation based in extractive techniques

have widely shown its utility for his adaptability and efficiency in the manner of response time

at any kind of application domain. In Biomedical field are numerous the research results about

the overload information and the need of application of efficient recovery and summarization

methods for the proper use of evidence based medicine. In this context we are going to present a

proposal of methodology for automatic summarization based on structured knowledge and

graph's use, applying similarity methods between phrases and considering concepts appearance

frequency. Finally, a methodology’s evaluation is made to compare with other methods using

the ROUGE tool and analyzing their results.

Although the size of the evaluation set doesn’t allow extracting noteworthy conclusions, the

results collected are enough promising to trust in the effectiveness of the proposal handed in.

Keywords: automatic summarization, extractive method, biomedical concepts, UMLS

1 Introducción Numerosos artículos certifican la sobrecarga

de información tan común hoy día en nuestra

La generación de resúmenes de texto es un

sociedad, y en especial en el ámbito biomédico,

proceso de reducción de la información, que

donde la información está disponible desde una

permite a un usuario tomar idea o conocer el

variedad de fuentes, incluyendo artículos

contenido de un texto completo, sin tener que

científicos, bases de datos de resúmenes, bases

leer todas sus frases. Esta reducción de la

de datos estructuradas o semiestructuradas,

cantidad de información a leer produce una

servicios web, webs de documentos o historia

mayor rapidez en la búsqueda de información

clínica de pacientes (Afantenos et al., 2005).

relevante y una mayor asimilación de conceptos

con menor esfuerzo.

Si a ello unimos el hecho de que gran parte evaluación y se interpretan. En la sección 6 se

de los resultados de la investigación biomédica establecen los resultados y las conclusiones del

se encuentran en forma de literatura escrita en presente trabajo.

formato libre que se acumulan en grandes bases

de datos en línea, podemos concluir que el 2 Trabajos relacionados en el ámbito

proceso de reducción de información que biomédico y recursos UMLS.

producen los resúmenes automáticos es

especialmente útil en el ámbito biomédico. Una primera propuesta de nuestro trabajo, (de la

Villa y Maña, 2009) recoge en detalle el

Por otro lado, el rápido crecimiento de los proceso de generación de resúmenes, los

resultados de la investigación del dominio principales trabajos de referencia en el ámbito,

biomédico está produciendo un importante así como una descripción detallada de los

cuello de botella. MEDLINE1 (Medical recursos UMLS que usa.

Literature Analysis and Retrieval System

Online), la principal base de datos bibliográfica En el ámbito biomédico destacaremos los

de EE.UU (de la National Library of Medicine), métodos de generación de resúmenes

contiene más de 16 millones de referencias a extractivos como BioChain, (basado en cadenas

artículos de revistas, centrados principalmente de conceptos o relaciones semánticas entre

en biomedicina. Entre 2000 y 4000 referencias conceptos vecinos en texto), FreqDist (centrado

completas se añaden cada día, más de 670000 en el uso de las distribuciones de frecuencia,

fueron añadidas en 2007. construyendo un resumen con similar

distribución que el original) y Chainfreq

Es evidente que en este dominio, los (híbrido de los dos anteriores), que usan

profesionales en general necesitan herramientas conceptos específicos del dominio biomédico

orientadas a proporcionar medios para acceder para identificar las sentencias destacables del

y visualizar la información adecuada para sus texto completo (Reeve et al., 2007).

necesidades.

Los trabajos específicos de un ámbito usan

En este trabajo vamos a presentar el modelo conceptos en vez de términos, para lo que

de generación de resúmenes de carácter necesitan herramientas que den soporte a la

extractivo apoyado en conceptos del dominio identificación de los conceptos en una

biomédico así como una evaluación realizada estructura de conocimiento del dominio y

con un mini-corpus, con el que podemos capaces de determinar relaciones semánticas

obtener unas primeras conclusiones. Para ello entre estos conceptos.

estructuramos el documento de la siguiente

manera: en primer lugar se comentan trabajos Para el procesado semántico, consistente en

de interés que son específicos del dominio. el análisis e identificación de los conceptos y

También presentamos UMLS y el conjunto de relaciones subyacentes en un texto, se requiere

herramientas de procesamiento de lenguaje una estructura de conocimiento, como la que en

natural orientadas al ámbito biomédico que el ámbito biomédico proporciona el proyecto

incorpora. En la sección tres introducimos el Unified Medical Language System (UMLS)

modelo de generación de resúmenes en que (Humphreys et al., 1998). El objetivo de este

estamos trabajando, dividido en cuatro fases. proyecto es el desarrollo de herramientas que

En la sección 4 se recoge el procedimiento ayuden a investigadores en la representación del

seguido para evaluar la efectividad de nuestro conocimiento, recuperación e integración de

sistema, enfrentándolo a sistemas presentes en información biomédica.

el mercado, ya sean resultados de investigación

o herramientas comerciales. Para ello se explica UMLS consiste en tres componentes, el

el uso de la herramienta automática de SPECIALIST Lexicon, el Metathesaurus y la

evaluación ROUGE, se explica el corpus de UMLS Semantic Network (Rindflesh et. al.,

documentos a evaluar y una breve reseña de 2005). SemRep es una herramienta de

cada sistema contra el que nos comparamos. En procesado semántico que integra los tres

la sección 5, se presentan los resultados de la anteriores componentes de UMLS para analizar

de manera automática textos con lenguaje

1

www.nlm.nih.gov/pubs/factsheets/medline.html

médico identificando los conceptos y relaciones manera simultánea, se identifican con la ayuda

que representan el contenido del documento. de Metamap Transfer (integrada en SemRep),

los conceptos biomédicos incluidos en la frase y

Usaremos el Metathesaurus y la herramienta se incluyen en el nodo, así como las relaciones

Metamap Transfer (MMTx) para la semánticas.

identificación de los conceptos biomédicos de

cada frase, base para el cálculo del solape entre 3.2 Fase 2. Aplicación de algoritmo de

frases. En cuanto a SemRep, añadiremos esta similitud.

lista de relaciones al grafo dirigido para

posteriores trabajos. Para la extracción de sentencias en resúmenes,

un concepto importante es la 'similaridad' o

3 Propuesta de generación del resumen grado de solapamiento entre sentencias, cuánto

del contenido de una sentencia se encuentra

Los métodos de generación de resúmenes incluido en otra. Es como si consideráramos el

basados en técnicas extractivas han demostrado solape como una “recomendación” de una frase

ser muy útiles por su adaptabilidad y eficiencia de dirigirse a otras que tratan y abundan los

en tiempo de respuesta en cualquier tipo de mismos conceptos. Una función de similaridad,

dominios. Por contra, los métodos abstractivos, que tome en cuenta el grado de repetición de

por la necesidad de recursos léxicos, sintácticos tokens entre sentencias de manera normalizada

y semánticos han proporcionado unos mejores proporcionará una medida de este concepto.

resultados en cuanto a comprensibilidad a costa Aplicamos una versión modificada (con

de un mayor esfuerzo computacional y por conceptos en vez de términos) de la formula de

tanto, de tiempos de respuesta, aparte de la similaridad de (Milhacea y Tarau, 2006):

especificidad del ámbito de uso de la

{T | Tk ∈ Vi ∧ Tk ∈ V j }

herramienta.

Similitud (Vi ,V j ) =

k

Nuestro objetivo es intentar combinar la

capacidad y rapidez de los métodos extractivos

( )

log(Vi )+ log V j

con la efectividad y concreción de los métodos

que podríamos expresar como sigue:

abstractivos. Para ello vamos a presentar la

({df (C ) | C ∈ V ∧ C ∈ V })

Similitud p (Vi ,V j ) =

propuesta en que venimos trabajando de una k k i k j

metodología de generación automática de log(V )+ log(V )

i j

resúmenes apoyada en conocimiento

estructurado y grafos de ranking.

La recomendación que hace cada concepto

Nuestra propuesta, basada en (Milhacea y

sobre sus apariciones en otras frases no es

Tarau, 2006) es eminentemente extractiva, de

equitativa sino que está ponderada. Su

modo que el proceso podría resumirse en

influencia será mayor cuanto mayor sea su

identificar las sentencias en el texto de origen,

frecuencia de apariciones en el documento (df,

seleccionar aquellas que sean relevantes para el

document frequency).

usuario a la vez que disminuimos la

redundancia de la información. Para ellos

asignamos una puntuación a cada frase de 3.3 Fase 3. Aplicación de algoritmo de

acuerdo a un conjunto de características. Las n- ranking

primeras frases en cuanto a puntuación se Los algoritmos de ranking basados en grafos, a

extraen y se presentan al usuario en su orden de partir de la asignación arbitraria de valores a

aparición en el texto original. cada nodo, realizan cálculos para obtener la

puntuación S(Vi) de cada nodo de manera

3.1 Fase 1. Generación del grafo. iterativa, hasta que se produce convergencia

Independientemente del tamaño del texto, sea bajo un determinado umbral. Las referencias

un texto completo o un abstract, la primera entre nodos y/o conceptos son tratadas como

tarea debe consistir en la identificación de cada 'votos' para decidir el elemento más importante.

una de las sentencias del texto de origen, así La puntuación de cada vértice se obtiene

como en la creación de un grafo que incluya un aplicando Pagerank (Brin y Page, 1998):

vértice en el grafo por cada sentencia. De

evaluación de traductores automáticos (MT

WS (V j )

W ji

WS (Vi ) = (1 − d )+ d ∗

Machine Translations) de herramientas como

∑

∈I n (Vi ) ∑W BLEU (Papineni et al. 2001), Lin y Hovy

∈O (V )

Vj jk

Vk

presentaron ROUGE (Recall-Oriented

ut j

Understudy for Gisting Evaluation). En dicho

trabajo mostraban que los resúmenes

Tras la ejecución del algoritmo, los nodos se

producidos por jueces humanos no eran fiables

ordenan atendiendo al peso o puntuación

como ‘resúmenes ideales’ (gold standard), a

asociada, que define la notoriedad (saliency) de

causa de las fuertes discrepancias que

cada vértice en un grafo dirigido y ponderado.

presentan. Como consecuencia, un resumen de

consenso obtenido por la aplicación de métricas

3.4 Fase 4. Creación del resumen basadas en el contenido, como el solape de N-

Los nodos de mayor puntuación definirán las gramas, parecía mucho más fiable como

frases a incluir en el resumen. El número de resumen ideal para usarlos como referencia en

frases puede ser fijo o basado en un umbral. En el contraste de nuevos modelos.

nuestro prototipo es el usuario el que decide el

porcentaje de frases del documento original que ROUGE, desarrollado por el Information

formarán parte del resumen. Para facilitar la Science Institute en la University of Southern

legibilidad del resumen, la secuencialidad de California es una herramienta automática que

presentación de las frases seleccionadas se hace compara un resumen generado por un sistema

atendiendo a su ordenamiento original. automatizado con uno o más resúmenes ideales,

los llamados ‘modelos’. ROUGE usa N-gramas

4 Evaluación para determinar el solapamiento entre el

resumen generado y los modelos. ROUGE ha

Aunque la mayoría de trabajos de generación sido usado desde 2004 en las Conferencias

automática de resúmenes de texto tienen una DUC (Document Understanding Conference)

componente teórica importante, suelen como herramienta de evaluación en las

establecer hipótesis o proponer técnicas y competiciones y es un estándar ‘de facto’

algoritmos que necesitan ser validados, asumido por la comunidad internacional del

evaluados y comparados de una manera formal ámbito que usaremos nosotros para evaluar la

y rigurosa. Tradicionalmente, la evaluación de corrección de nuestro trabajo.

resúmenes ha requerido el juicio humano de

diferentes métricas de calidad, como p.ej., Según (Lin, 2004) ROUGE-2, ROUGE-L,

coherencia, concisión, gramaticalidad, ROUGE-W y ROUGE-S funcionan bien en

legibilidad y contenido (Mani, 2001). tareas de resumen monodocumento. Del mismo

modo, afirma que ROUGE-1, ROUGE-L,

No obstante, incluso la evaluación manual ROUGE-W, ROUGE-SU4, y ROUGE-SU9 dan

de resúmenes a gran escala sobre unas cuantas grandes resultados en la evaluación de

cuestiones de calidad lingüística y cobertura de resúmenes muy cortos.

contenido como las realizadas en la conferencia

DUC (Document Understanding Conference) 4.1 Descripción del corpus de evaluación

hubieran requerido sobre 3000 horas de

esfuerzos humanos (Over y Yen, 2003). Una Para comparar los resúmenes generados

tarea como ésta es muy cara y difícil de llevar a automáticamente y probar nuestro sistema,

cabo de manera frecuente, por lo que la hemos usado una pequeña colección de cuatro

evaluación automática de resúmenes es un documentos médicos, cedidos por (Plaza, Díaz

desafío de investigación en el que la comunidad y Gervas, 2008), que también trabajan en la

de generación de resúmenes ha puesto su generación de resúmenes usando grafos y

objetivo en los últimos años. ontologías. Estos documentos obtenidos de la

colección Biomed Central han sido resumidos

Ante la escasez de propuestas y la dificultad manualmente por expertos médicos.

de la tarea, ROUGE (Hovy, Lin 2003) se ha

convertido en el paquete de evaluación de Indicar que sobre los documentos se realizó

resúmenes automatizados más frecuentemente previamente un trabajo de preprocesado,

usado. Tras la exitosa aplicación en la eliminando de cada documento el título, el

abstract así como las cabeceras de sección • UHU1. En esta primera versión se ha

(elementos que de ser tratados y tenidos en aplicado la metodología tal cual ha sido

cuenta supondrían un gran valor añadido, por la presentada en la sección anterior.

relevancia del título y del abstract), tablas e • UHU2. Es una versión anterior que no

imágenes. tiene en cuenta la ponderación de los

conceptos, considera todos los conceptos

Para comparar los resúmenes generados iguales y aplica directamente la fórmula de

automáticamente por los diferentes sistemas, similitud de (Milhacea y Tarau, 2006)

vamos a usar 5 modelos o resúmenes ideales de cambiando términos por conceptos.

cada documento de la colección, que • LEAD. Uno de los que suele llamarse

representan supuestamente diferentes versiones generadores de línea base, ya que su

de un resumen ideal. Dos resúmenes han sido objetivo es dar alguna idea del nivel de

elaborados por dos expertos para un ratio de rendimiento de una implementación muy

compresión del 20%, otros dos resúmenes más, simple. LEAD (o Lead) de manera

elaborados por el primero de los expertos con secuencial recupera las primeras sentencias

ratios del 30% y el 50%. Como quinto modelo del texto, hasta completar el 20% del

ideal usaremos el abstract de cada artículo. tamaño. Indicar que en textos periodísticos

y científicos, las primeras líneas del

4.2 Generadores de resúmenes usados para documento suelen tener un alto grado de

evaluación. significatividad.

Para la evaluación de nuestra propuesta vamos • MS-Word (AutoSummarize). Esta

a presentar dos modelos candidatos, el primero función se encuentra incluida en el

de ellos (UHU2) es un baseline con un proceso procesador de textos Microsoft Word

inicial de tratamiento de los textos médicos, que v.2007 (concretamente, ensamblado en

no tiene en cuenta la frecuencia de aparición de MS.Office.Tools.Word.v9.0.dll). Aunque

conceptos. El segundo de ellos (UHU1) los detalles concretos del algoritmo no son

incorpora en la fórmula de cálculo de la públicos, en la ayuda online del producto se

similitud entre frases, la frecuencia de aparición afirma que las sentencias que usan palabras

de los conceptos que se solapan. frecuentemente usadas tienen una mayor

puntuación.

Para tener un mayor grado de conocimiento • Copernic Summarizer2. Es una

de la eficiencia genérica del proceso, se incluye herramienta multilingüe comercial de

en la comparativa los resultados obtenidos generación de resúmenes a partir de textos o

sobre el mismo corpus aplicando diferentes páginas web con el objetivo de disminuir el

herramientas, plenamente admitidas y utilizadas tiempo de acceso del usuario a la

como referencia por la comunidad información importante. Obtiene los

internacional, tanto resultado de proyectos de conceptos clave y frases clave a partir de un

investigación como herramientas comerciales. ratio de compresión dado. Se integra

fácilmente en procesadores de texto,

Cada herramienta generó un resumen de un navegadores y clientes de correo. Los

tamaño igual al 20% del tamaño del texto algoritmos y técnicas usadas no son

original. El tamaño del resumen no ha sido una públicos, sólo se revela que usa

decisión arbitraria. En el dominio de los 'sofisticados' algoritmos estadísticos y

resúmenes de noticia típicamente se selecciona lingüísticos, eliminando automáticamente

un tamaño de cómo máximo 5 líneas, que contenido y texto irrelevante.

representa sobre el 20% del tamaño de una • Pertinence Summarizer3 es una

noticia típica (Goldstein et al., 1999). Ha sido herramienta comercial de generación de

generalmente aceptado que un resumen no resúmenes que se basa en técnicas

debería ser más corto del 15% ni más largo del extractivas, mediante el procesamiento de la

35% del tamaño del texto fuente (Hovy, 2005). relevancia (pertinencia la denominan ellos)

de cada sentencia, tomando en cuenta

Hagamos una breve descripción de los posibles palabras clave, diccionarios de

generadores usados:

2

http://www.copernic.com/en/products/summarizer/

3

http://www.pertinence.net/index_en.html

términos y marcadores lingüísticos Cada tabla se ha ordenado descendentemente

genéricos. Es multilingüe y se ha usado la atendiendo a su puntuación (medida F). Por lo

versión online para la evaluación. tanto, el método de generación de resúmenes

• Swesum. Es un generador de resúmenes más eficiente aparece en la primera entrada de

multilingüe (Hassel, 2007), inicialmente cada tabla mientras que el menos eficiente

para sueco e inglés. Utiliza múltiples aparece en la última fila.

aspectos para valorar las sentencias, como

su posición o valor numérico en un ROUGE es una herramienta que permite

esquema, de modo que las sentencias evaluaciones parametrizadas en función de

iniciales tienen un peso adicional, así como ciertos valores, que orientan la tarea al tipo

las numeradas. Para la evaluación se ha especial de documento original y resumen a

usado la versión online4, con las opciones generar. Vamos a diferenciar y separar entre

por defecto. dos evaluaciones, una con los parámetros que se

• Summ-It. Es un módulo para generación han usado en la tarea de resumen del DUC y

de resúmenes integrado en la plataforma otra con los valores por defecto de ROUGE, en

System Quirk5, un banco de trabajo para el la que se realizarán toda la batería de pruebas

aprendizaje e investigación de técnicas de posible:

procesamiento del lenguaje natural.

• Mead. Es generador de resúmenes 5.1 Evaluación con los parámetros del DUC.

mono- y multidocumento (Radev et al., Desde 2004 hasta 2007, ROUGE ha sido la

2004), que usa múltiples criterios a la hora herramienta fundamental de evaluación en las

de puntuar las sentencias, como la posición Conferencias DUC. Entre las tareas principales

de la sentencia en el texto, el solape de cada y desafíos propuestos se encontraban

sentencia con la primera sentencia, la principalmente tareas de resumen

longitud de la sentencia y un método multidocumento, question-answering y

basado en el centroide de un clúster de detección de novedades. Para estas tareas, el

documentos. Para la evaluación se ha usado método de evaluación usado en la tarea es

la demo online6 (MEAD, 2008), que los ROUGE-2 y ROUGE-SU4, con stemming

autores avisan de que es más limitada que la (corte de palabras a su raíz) y manteniendo

versión para descarga. stopwords (listas de palabras a ignorar).

• LexRank. (Erkan y Radev, 2004) es un ROUGE-1.5.5 será procesado con los siguientes

método multidocumento de generación de parámetros:

resúmenes extractivo orientado a la ROUGE-1.5.5.pl -n 2 -x -m -2 4 -u -c 95

obtención de la relevancia de una frase en -r 1000 -f A -p 0.5 -t 0 -d

base al concepto de centralidad del vector

propio (eigen vector) en una representación

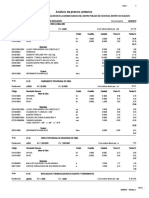

de sentencias en un grafo. Una matriz de Método Medida F

conectividad basada en la similitud entre UHU1 0.49456

sentencias (método del coseno) es usada UHU2 0.47399

como matriz de adyacencia del grafo de Word 0.46203

sentencias. Este método quedó primero en Copernic Summ. 0.46183

la tarea de resúmenes del DUC 2004. Para Swesum 0.45606

la evaluación se ha usado la versión online7 Mead 0.45552

(LexRank, 2008), más limitada. Lead 0.45331

LexRank 0.44932

5 Resultados y discusión Pertinence Summ. 0.41740

Summ-It 0.40678

Los resultados de la evaluación usando Tabla 1. Evaluación según ROUGE-1 con

ROUGE se muestran en las siguientes tablas. parámetros DUC 2005

4 -n 2 procesa ROUGE-1 y ROUGE-2

http://swesum.nada.kth.se/index-eng-adv.html -x no calcula ROUGE-L

5

http://www.computing.surrey.ac.uk/SystemQ/ -m aplica algoritmo de Porter.

6

http://tangra.si.umich.edu/clair/md/demo.cgi -2 4 procesa Skip Bigram (ROUGE-S4).

7

http://tangra.si.umich.edu/clair/lexrank/

-u incluye los uni-gramas en Skip Bigram

(ROUGE-SU) 5.2 Resultados con los parámetros del DUC.

-c 95 usa intervalo de confianza del 95%

Podemos concluir después de esta evaluación

-f A puntuaciones promediadas sobre los

que nuestro método es claramente uno de los

múltiples modelos

mejores, en cuanto da el mejor resultado en

-p 0.5 calcula la medida-F con alpha = 0.5

ROUGE-1 y queda muy cerca del mejor en

ROUGE-2 y ROUGE-SU4, a pesar de que estas

La mejor puntuación ha sido obtenida por

métricas han sido seleccionadas por su

nuestro algoritmo, en sus dos últimas versiones,

conveniencia a la hora de medir la evaluación

con una mejora sobre el siguiente del 7,04%.

en sistemas multidocumento.

5.3 Evaluación con los parámetros ROUGE

Método Medida F

por defecto.

Copernic Summ. 0.35388

UHU1 0.33964 Dado que DUC se centra sólo en las métricas

Swesum 0.33409 más adecuadas para sus tareas específicas,

Lead 0.33263 hemos decidido realizar una evaluación

Word 0.32381 genérica que recoja y presente todas las

Mead 0.31947 métricas de que es capaz ROUGE.

UHU2 0.31794

LexRank 0.30062 ROUGE-1.5.5.pl -c 95 -2 -1 -U -r 1000 -n 4

-w 1.2

Pertinence Summ. 0.29155

Summ-It 0.26765 -2 -1 indica que max-gap-length no tiene límite

Tabla 2. Evaluación según ROUGE-2 con

-U procesa los unigramas, incluso los regulares

parámetros DUC 2005

-r 1000 remuestrea bootstrap 1000 veces para

Para bi-gramas, tamaño de palabra 2, nuestra estimar el intervalo de confianza del 95%

última versión del algoritmo consigue el -n 4 -n 2 procesa ROUGE-1, ROUGE-2,

segundo mejor resultado, sólo superado por el ROUGE-3 y ROUGE-4

generador comercial de la casa Copernic. -w 1.2 con un factor de peso de 1.2 para WLCS

5.4 Resultados con los parámetros ROUGE

por defecto.

Analicemos los resultados de la Tabla 4.

Método Medida F Aparecen en las filas los distintos métodos de

Copernic 0.36260 generación de resúmenes, mientras en las

UHU1 0.35972 columnas aparecen cada uno de los diversos

Lead 0.34231 métodos de evaluación que proporciona

Swesum 0.34213 ROUGE. En cada columna se ha destacado en

UHU2 0.33622 negrita el mejor resultado. Además, en la celda

Word 0.33173 correspondiente a nuestro método, se indica

Mead 0.32568 entre paréntesis el lugar en el ranking que ocupa

LexRank 0.31275 nuestro sistema para esa métrica ROUGE.

Pertinence Summ. 0.30078

Summ-It 0.28237 En este caso, los resultados de nuestros

Tabla 3. Evaluación según ROUGE-SU4 con métodos han sido los más eficaces para los

parámetros DUC 2005 evaluadores ROUGE-1, ROUGE-L, ROUGE-

S* y ROUGE-SU*, ocupando siempre las

Para ROUGE-SU4 nuestro algoritmo sigue primeras cuatro posiciones.

superando claramente a la mayoría, salvo al de

Copernic.

ROUGE- ROUGE-W-

ROUGE-1 ROUGE-2 ROUGE-3 ROUGE-4 ROUGE-L ROUGE-S*

SU* 1.2

Copernic 0.4545 0.3526 0.3273 0.3165 0.4472 0.1868 0.1893 0.1961

Lead 0.4437 0.3307 0.3028 0.2909 0.4322 0.1620 0.1646 0.1936

Mead 0.4433 0.3181 0.2825 0.2642 0.4171 0.1877 0.1902 0.1853

Pertinence 0.4113 0.2902 0.2545 0.2398 0.3940 0.1493 0.1515 0.1432

Summ-It 0.3949 0.2648 0.2324 0.2197 0.3777 0.1383 0.1406 0.1482

Swesum 0.4493 0.3323 0.3009 0.2871 0.4322 0.1701 0.1727 0.1769

0.2978 0.2843 0.1881

UHU1 0.4834 0.3372 (2)

(4) (4) 0.4657 0.2060 0.2085 (4)

UHU2 0.4635 0.3151 0.2772 0.2638 0.4449 0.1931 0.1956 0.1722

Word 0.4527 0.3223 0.2782 0.2588 0.4287 0.1723 0.1749 0.1675

Tabla 4. Tabla comparativa de evaluación con ROUGE, parámetros por defecto

También se ha de destacar que a medida que

los N-gramas aumentan de tamaño, los 6 Conclusión

resultados empeoran, si bien no podemos aún

En este trabajo se ha presentado una

concretar la causa.

metodología propia para la generación

automática de resúmenes de texto. El método

Si bien los resultados han sido muy buenos,

está basado en técnicas extractivas y en la

hemos de ser conscientes de ciertos problemas

representación del texto usando un grafo de

intrínsecos a la tarea y a la solución aportada.

frases y conceptos. El sistema hace uso de un

Esta estrategia centrada en el concepto médico

analizador semántico que etiqueta el texto,

puede dar lugar a resúmenes más inconexos,

identificando los conceptos y relaciona

como parece que indican los resultados para

semánticamente los mismos, utilizando para

ROUGE mayores que 1. Sin duda, la mejora de

ello un metathesauro médico todos los

la legibilidad del resumen habrá de plantearse

conceptos. Por ahora, sólo trabaja con textos en

como objetivo.

inglés.

Las versiones de ROUGE L, W y S intentan

Para conocer la calidad de los resúmenes

arreglar ciertos problemas derivados de la

generados hemos realizado un proceso de

traducción (aumento del espaciado entre

evaluación, valiéndonos para ello de la

palabras, cambios en el orden, etc...). Los

herramienta ROUGE. Esta herramienta evalúa

resultados obtenidos en estas versiones han sido

automáticamente la calidad de resúmenes

muy buenos, lo que podría derivarse del hecho

candidatos frente a un conjunto de resúmenes

de que otros métodos hagan un especial

modelo, generados por jueces humanos.

hincapié en la búsqueda de grupos de términos

Mediante diversas métricas, principalmente de

significativos o relevantes, algo no prioritario

comparación de diversas variantes de N-gramas

para nosotros, por lo que a medida que el n-

obtenemos valores de Cobertura, Precisión y

grama a comparar aumenta de tamaño y se

Medida-F de cada generador automático de

permiten saltos, nuestro método es favorecido

resúmenes.

por los resultados.

Los resúmenes se han generado a partir de

En definitiva, creemos que como primera

un pequeño corpus de documentos médicos del

evaluación y a pesar de usar un sistema de

repositorio BIOMED Central, de los que dos

evaluación basado en términos, nuestros

expertos han realizado una serie de resúmenes

resultados son muy buenos, lo que parece

manuales. Para obtener una más clara referencia

indicar que el camino tomado y la estrategia de

de nuestra propuesta, se han generado

resolución del problema es la adecuada. Pero se

resúmenes candidatos para la evaluación del

ha de ser muy prudente en la evaluación de los

mismo corpus usando una serie de generadores

resultados obtenidos, primero por la escasa

de resúmenes reconocidos por la comunidad

representatividad de un corpus tan pequeño y

investigadora.

segundo, por los malos resultados obtenidos por

generadores de resúmenes genéricos de

Con la prudencia que merece el hecho de

prestigio, como Mead o LexRank.

haber usado un corpus tan pequeño, parece que

los resultados confirman que el uso de Collaboration”, Journal of the American

conceptos del ámbito biomédico dentro de un Medical Informatics Association, 5(1), 1-11.

proceso de generación extractiva de resúmenes 1998.

produce mejores resultados que los basados en Lin, C-Y. (2004) “ROUGE: a Package for

términos y que la propuesta presentada Automatic Evaluation of Summaries” en

establece un buen baseline a partir del cual Proceedings of the Workshop on Text

seguir mejorando. Summarization Branches Out (WAS 2004),

Barcelona, Spain.

Mani, I. “Automatic Summarization” John

Bibliografía Benjamins, Amsterdam / Philadelphia.

(2001)

Afantenos, S. D., Karkaletsis, V. y

Milhacea R. and Tarau P: “TextRank: Bringing

Stamatopoulos P. “Summarization from

Order into Texts”. In Proceedings of

Medical Documents: A Survey” en Artificial

Empirical Methods in Natural Language

Intelligence in Medicine, 33(2):157-177.

Processing. ACL, 404-411, 2006.

2005.

Over P., Yen J. (2003) “Intrinsic Evaluation of

Brin, S. y Page, L. “The anatomy of a large-

Generic News Text Summarization

scale hypertextual web search engine” en

Systems” DUC 2003. Workshop on Text

Computer Networks and ISDN Systems, 30

Summarization. May 31-June 1, 2003.

(1-7). 1998.

Edmonton, Canada

de la Villa, M., Maña, M. “Estableciendo una

Papineni, K., S. Roukos, T. Ward, and W-J.

línea base para un generador de resúmenes

Zhu. “BLEU: A method for automatic

extractivo basado en conceptos en el ámbito

evaluation of machine translation”. Research

biomédico”. Revista de la Sociedad

Report RC22176, IBM. (2001)

Española para el Procesamiento del

Plaza L., Díaz A. and Gervás P.:”Concept-

Lenguaje Natural, num.42 (Abril 2009)

graph based Biomedical Automatic

Erkan, G. y Radev D. (2004) “LexRank: Graph-

Summarization using Ontologies” In

based Centrality as Salience in Text

Proceedings of the 3rd Textgraphs workshop

Summarization”. Journal of Artificial

on Graph-based Algorithms for Natural

Intelligence Research 22.

Language Processing (COLING 2008).

Goldstein, J., Kantrowitz, M., Mittal, V., &

Radev D.R., Timothy Allison, Sasha Blair-

Carbonell, J. “Summarizing text documents:

Goldensohn, John Blitzer, Arda Çelebi,

sentence selection and evaluation metrics”

Stanko Dimitrov, Elliott Drabek, Ali Hakim,

SIGIR '99: Proceedings of the 22nd annual

Wai Lam, Danyu Liu, Jahna Otterbacher,

international ACM SIGIR conference on

Hong Qi, Horacio Saggion, Simone Teufel,

Research and development in information

Michael Topper, Adam Winkel, and Zhang

retrieval, Berkeley, California, United

Zhu (2004) “MEAD - a platform for

States. 121-128. (1999)

multidocument multilingual text

Hassel, M. (2007) “Resource Lean and Portable

summarization”. En Proceedings of LREC

Automatic Text Summarization”, PhD-

2004, Lisbon, Portugal.

Thesis, School of Computer Science and

Reeve, L.H., Han, H., Brooks, A.D. “The use of

Communication, KTH, ISBN-978-917178-

domain-specific concepts in biomedical text

704-0

summarization” en Information Processing

Hovy, E. y Lin, C. Y. “Automatic evaluation of

and Management 43, 1765-1776. 2007.

summaries using N-gram co-ocurrence

Rindflesh, T.C., Fiszman, M., Libbus, B.

statistics” en Proceedings of 2003 language

“Semantic interpretation for the biomedical

technology conference (HLT-NAACL 2003)

research literature”. Capítulo 14 del libro

(Vol. 1(1), pag. 71-78). Edmonton, Canada.

“Medical Informatics. Knowledge

Hovy, E.. Automated text summarization. In R.

Management and Data Mining in

Mitkov (Ed.), The Oxford Handbook of

Biomedicine ” (Springer's Integrated Series

Computational Linguistics, pp. 583-598.

in Information Systems), editores Chen, H.,

Oxford: Oxford University Press. (2005)

Fuller, S.S., Friedman C., Hersh, W. 2005

Humphreys, B.L., Lindberg, D.A., Schoolman,

H.M., y Barnett, G.O. “The Unified Medical

Language System: An Informatics Research

Vous aimerez peut-être aussi

- Trabajo de Titulacion JHON QUIROZDocument100 pagesTrabajo de Titulacion JHON QUIROZPablo F. Chacho OchoaPas encore d'évaluation

- 08 Diseño Sismorresistente Sistemas Armonicos 1GLDocument14 pages08 Diseño Sismorresistente Sistemas Armonicos 1GLAlejandro Cortijo CastilloPas encore d'évaluation

- FAVN Submission SpanishDocument2 pagesFAVN Submission SpanishLu Salinas VignesPas encore d'évaluation

- FASE 2 - Organización - PlantillaDocument62 pagesFASE 2 - Organización - PlantillaCesar Sotelo RamírezPas encore d'évaluation

- Observaciones Vehiculos Ultimo PlazoDocument18 pagesObservaciones Vehiculos Ultimo PlazoMerelyn RamirezPas encore d'évaluation

- Masa MolecularDocument3 pagesMasa MolecularAli AlexandraPas encore d'évaluation

- Proyecto DaDocument11 pagesProyecto DaJuan Diego ApontePas encore d'évaluation

- SENA2021n2311939nenglishn6 19615e2d0bb346aDocument11 pagesSENA2021n2311939nenglishn6 19615e2d0bb346aLucy Andrea Tobon LondoñoPas encore d'évaluation

- Modulo 3. Educación A Distancia y Aprendizaje AutonomoDocument94 pagesModulo 3. Educación A Distancia y Aprendizaje Autonomoanrocef1035100% (1)

- Gonzalez Juan MicroDocument3 pagesGonzalez Juan MicroJuan GlezPas encore d'évaluation

- FBC070206PP9: Fuller Beauty Cosmetics Trainee S.de RDocument1 pageFBC070206PP9: Fuller Beauty Cosmetics Trainee S.de RjorgePas encore d'évaluation

- Act10. SociedadesDocument3 pagesAct10. SociedadesandreaPas encore d'évaluation

- URP 2021-II EEI Guia 2 Ley de Corrientes de KirchoffDocument5 pagesURP 2021-II EEI Guia 2 Ley de Corrientes de KirchoffMilton MezaPas encore d'évaluation

- SCRM U2 A1 GucgDocument4 pagesSCRM U2 A1 GucgGuillermo CastillaPas encore d'évaluation

- Semana 2 Psicologia AeronauticaDocument28 pagesSemana 2 Psicologia AeronauticadavalderPas encore d'évaluation

- E Formativa de Preparación de Soluciones Uesm 2022Document6 pagesE Formativa de Preparación de Soluciones Uesm 2022CESAR EDUARDO CAÑARTE VERAPas encore d'évaluation

- Costos UnitariosDocument33 pagesCostos UnitariosmilenaPas encore d'évaluation

- ENFOQUESDocument3 pagesENFOQUESHector Armando Vargas FigueroaPas encore d'évaluation

- Caja SincronicaDocument20 pagesCaja SincronicaNerio MoralesPas encore d'évaluation

- Feedwater SystemDocument30 pagesFeedwater SystemIvan Poma MontesPas encore d'évaluation

- EDigital - Actividad - Semana 01 - Grupo4Document7 pagesEDigital - Actividad - Semana 01 - Grupo4Daniela Trujillo BazalarPas encore d'évaluation

- Buscar Archivos en JavaDocument35 pagesBuscar Archivos en JavaJohn MorilloPas encore d'évaluation

- Características de Personalidad de Varones Imputados Por Violencia Familiar PDFDocument6 pagesCaracterísticas de Personalidad de Varones Imputados Por Violencia Familiar PDFRomy BlottaPas encore d'évaluation

- Infografia Bienestar EstudiantilDocument6 pagesInfografia Bienestar EstudiantilAnaPas encore d'évaluation

- Reparación de Fuentes de Poder by EnigmaelectronicaDocument32 pagesReparación de Fuentes de Poder by EnigmaelectronicaJesus Jhonny Quispe Rojas100% (1)

- Tarea 5 - Recurso DigitalDocument7 pagesTarea 5 - Recurso DigitalUNAD89% (9)

- Proyecto Azotea Verde - Oscar Monroy Olguín - CTB Tecnología en Ambiente y AguaDocument44 pagesProyecto Azotea Verde - Oscar Monroy Olguín - CTB Tecnología en Ambiente y AguaOscarPas encore d'évaluation

- Presentacion Informativas Iinst GasDocument24 pagesPresentacion Informativas Iinst GasMiguel SaavedraPas encore d'évaluation

- Criminologia y CriminalisticaDocument47 pagesCriminologia y CriminalisticaGabriela Gonzalez HernandezPas encore d'évaluation

- Origin EjerciciosDocument4 pagesOrigin EjerciciosJonathan MercadoPas encore d'évaluation