Académique Documents

Professionnel Documents

Culture Documents

HW 01

Transféré par

leolca@hotmail.comTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

HW 01

Transféré par

leolca@hotmail.comDroits d'auteur :

Formats disponibles

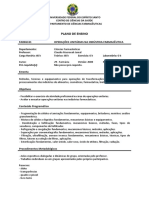

Universidade Federal de S ao Jo ao del-Rei

SEGUNDO SEMESTRE, 2014

Campus: Alto Paraopeba

TEORIA DA INFORMAC

AO

Lista de Exerccios 01

Entrega: Esta lista de exerccios devera ser entregue no dia da primeira prova.

Quest oes

1. Entropia Maxima e Mnima

Qual e o menor e o maior valor para H(p

1

, p

2

, . . . , p

n

) = H(p)? Encontre os vetores p de dimensao n que

fornecam o maximo e o mnimo. Justique sua resposta.

2. Mostre que

H(X, Y |Z) = H(X|Z) +H(Y |X, Z). (1)

dica: a demonstra cao segue os mesmos moldes do teorema da cadeia.

3. Sub-estimacao do desvio padrao

Sejam x

1

, x

2

, . . . , x

n

amostras retiradas identicamente e independentemente (i.i.d) de uma determinada dis-

tribui cao. Considere x a media amostral e =

n

i=1

(x

i

x)

2

/n o desvio padrao amostral. Mostre que

E [ ] , aonde e o desvio padrao populacional, ou seja, =

(X )

2

e = E [X].

dica: utilize a desigualdade de Jensens.

4. Entropia condicional nula

Mostre que se H(Y |X) = 0, entao Y e uma funcao de X, isto e, para todo x com probabilidade p(x) > 0,

existe apenas um unico valor de y com p(x, y) > 0.

5. Metrica e Distancia Uma fun cao f : S S R e uma metrica em S se, para todo x, y, z S, as seguintes

condicoes sao satisfeitas:

f(x, y) 0 (nao negatividade)

f(x, y) = f(y, x) (simetria)

f(x, y) = 0 se e somente se x = y (identidade dos indiscernveis)

f(x, y) +f(y, z) f(x, z) (desigualdade triangular).

Uma fun cao f : SS R e uma distancia em S se, para todo x, y S, as seguintes condicoes sao satisfeitas:

f(x, y) 0 (nao negatividade)

f(x, y) = f(y, x) (simetria)

f(x, x) = 0.

a) Mostre atraves de um exemplo que a divergencia de Kullback-Leibler (entropia relativa) nao e uma

distancia e sequer uma metrica.

b) Mostre que (X, Y ) = H(X|Y ) + H(Y |X) possui as propriedades de uma metrica. Note que (X, Y ) e

o n umero de bits necessario para X e Y comunicarem seus valores um para o outro.

c) Verique que (X, Y ) tambem pode ser expresso como

(X, Y ) = H(X) +H(Y ) 2I(X; Y ) (2)

= H(X, Y ) I(X; Y ) (3)

= 2H(X, Y ) H(X) H(Y ) (4)

6. Entropia Conjunta

Seja p(x, y) dado por

X

Y

0 1

0 1/3 1/3

1 0 1/3

Calcule

a) H(X) , H(Y )

b) H(X|Y ) , H(Y |X)

c) H(X, Y )

d) H(Y ) H(Y |X)

e) I(X; Y )

f) Faca um diagrama de Venn para representar as grandezas calculadas acima.

7. Mostre as seguintes desigualdades abaixo, utilizando para tanto a expansao em serie de Taylor.

a) ln x x 1, para x > 0;

b) ln x 1

1

x

, para x > 0.

8. Entropia da soma

Seja X e Y variaveis aleatorias com valores x

1

, . . . , x

r

e y

1

, . . . , y

s

respectivamente. Seja Z = X +Y .

a) Mostre que H(Z|X) = H(Y |X). Argumente que se X, Y sao independentes, entao H(Y ) H(Z) e

H(X) H(Z). Desta forma, a adicao de variaveis aleatorias independentes traz incerteza.

b) De um exemplo de variaveis aleatoria independentes em que H(X) > H(Z) e H(Y ) > H(Z).

c) Sob quais condicoes temos H(Z) = H(X) +H(Y )?

9. World Series

As Series Mundiais (World Series) e uma serie de sete jogos que termina assim que um dos times conseguir

quatro vitorias. Seja X a variavel aleatoria que representa o resultado de uma Serie Mundia entre os times

A e B; possveis valores para X sao AAAA, BABABAB e BBBAAAA. Seja Y o n umero de partidas

disputadas, que varia de 4 a 7. Assumindo que A e B sao times igualmente bons (mesma probabilidade de

vencer) e que as partidas sao independentes, calcule H(X), H(Y ), H(Y |X) e H(X|Y ).

10. Uma Medida de Correlacao

Sejam X

1

e X

2

identicamente distribudos, mas nao necessariamente independentes. Considere

= 1

H(X

2

|X

1

)

H(X

1

)

. (5)

a) Mostre que = I(X

1

; X

2

)/H(X

1

).

b) Mostre que 0 1.

c) Quando teremos = 0?

d) Quando teremos = 1?

11. Processamento de Dados

Considere que X

1

X

2

X

3

. . . X

n

seja uma cadeia de Markov nesta ordem, isto e,

p(x

1

, x

2

, . . . , x

n

) = p(x

1

)p(x

2

|x

1

) . . . p(x

n

|x

n1

). (6)

Simplique I(X

1

; X

2

; . . . ; X

n

).

12. Mistura aumenta entropia

Mostre que a entropia da distribuicao de probabilidade (p

1

, . . . , p

i

, . . . , p

j

, . . . , p

m

) e menor do que a en-

tropia da distribuicao (p

1

, . . . ,

p

i

+p

j

2

, . . . ,

p

i

+p

j

2

, . . . , p

m

). Mostre que, em geral, qualquer transferencia de

probabilidade, que torne a distribui cao mais uniforme, aumenta a entropia.

13. Retirando elementos com e sem reposicao

Uma urna contem r bolas vermelhas, w bolas brancas e b bolas pretas. Qual das opcoes possui maior

entropia? 1) Retirar k 2 bolas da urna com substituicao ou 2) sem substituicao?

Bernoulli para ter sido o primeiro a utilizar o modelo de urnas no estudo das probabilidades. A

inspiracao de Bernoulli pode ter sido as loterias, elei coes, ou jogos de azar, que envolvem sortear as

bolas de um recipiente. Tem sido reconhecido que nas elei coes na epoca medieval e renascentista

de Veneza, incluindo a de Doge

1

, muitas vezes incluam a escolha dos eleitores por sorteio, usando

bolas de cores diferentes, extradas de uma urna.

1

Doge e a denominacao do chefe ou primeiro magistrado eleito, das antigas rep ublicas de Genova e Veneza.

Vous aimerez peut-être aussi

- Reflexão de Organização e Manutenção Do ArquivoDocument2 pagesReflexão de Organização e Manutenção Do ArquivoAna Vicente88% (8)

- Bombas CentrífugasDocument207 pagesBombas CentrífugasDirceu Pereira Filho100% (2)

- Novo Manual Liq System T - Email - Rev3Document9 pagesNovo Manual Liq System T - Email - Rev3airon50% (2)

- Associação de Elementos Estruturais - Fundamentos UftDocument87 pagesAssociação de Elementos Estruturais - Fundamentos UftGabriel Luan Paixão Mota100% (1)

- Operações Unitárias Na Indústria FarmacêuticaDocument2 pagesOperações Unitárias Na Indústria FarmacêuticaJéssie SchöfferPas encore d'évaluation

- Conhecendo As Válvula Eletrônicas - Eletrônica e Circuitos - ElDocument7 pagesConhecendo As Válvula Eletrônicas - Eletrônica e Circuitos - Ellah.fisicaPas encore d'évaluation

- Determinação Do Volume Molar de Um GásDocument6 pagesDeterminação Do Volume Molar de Um GásThaiane Kaminski100% (1)

- Relatório 2 - TecMec 2Document9 pagesRelatório 2 - TecMec 2arthurpbdfPas encore d'évaluation

- Trane - WaveDocument91 pagesTrane - WaveJunior GaúnaPas encore d'évaluation

- Potiguar GravimetriaDocument106 pagesPotiguar GravimetriaJander FrazãoPas encore d'évaluation

- Aplicações Da EletróliseDocument3 pagesAplicações Da EletróliseRobson Soares FerreiraPas encore d'évaluation

- 4500-N A. IntroduçãoDocument34 pages4500-N A. IntroduçãoFábio Machry SanchesPas encore d'évaluation

- TS200 - CatálogoDocument1 pageTS200 - CatálogoBruno50% (2)

- NBR 5350 - Acumuladores EletricosDocument6 pagesNBR 5350 - Acumuladores EletricosCassionsilveiraPas encore d'évaluation

- FT 0.025 Bautech GeladoDocument2 pagesFT 0.025 Bautech GeladoMakz SweizerPas encore d'évaluation

- Rochas Ígneas Ou Magmáticas SlideDocument21 pagesRochas Ígneas Ou Magmáticas SlideEmerson da GJPas encore d'évaluation

- Catalo GDocument40 pagesCatalo GJosé AntunesPas encore d'évaluation

- Maquinas Elétricas de Polos SalientesDocument10 pagesMaquinas Elétricas de Polos SalientesCaioGavaPas encore d'évaluation

- A Arte de TraduzirDocument10 pagesA Arte de TraduzirEscola Brasileira Psicanálise Ebp SpPas encore d'évaluation

- Exercicios - Equilibrio QuimicoDocument2 pagesExercicios - Equilibrio QuimicoJean FrankPas encore d'évaluation

- Relatorio Quimica Experimental 6 PDFDocument8 pagesRelatorio Quimica Experimental 6 PDFReinaldo RodriguesPas encore d'évaluation

- Exercicios ResolvidosDocument6 pagesExercicios ResolvidosIcaro UlissesPas encore d'évaluation

- Vitali Prova Probabilidade PDFDocument238 pagesVitali Prova Probabilidade PDFAlexPas encore d'évaluation

- 05.001767 - Manual JF 5D - 10D (Português) - REV 03 - WebDocument40 pages05.001767 - Manual JF 5D - 10D (Português) - REV 03 - WebJhonatanPas encore d'évaluation

- Formol Estabilizado e InibidoDocument8 pagesFormol Estabilizado e InibidoLuiz Henrique TavaresPas encore d'évaluation

- Mecânica BDocument11 pagesMecânica BBruno De MattosPas encore d'évaluation

- Radical DuploDocument3 pagesRadical DuploAgapito Ribeiro JuniorPas encore d'évaluation

- Motor Pneumatico PDFDocument19 pagesMotor Pneumatico PDFCharles DavidPas encore d'évaluation

- Antologia de Ficção Científica BrasileiraDocument100 pagesAntologia de Ficção Científica BrasileiraHerman Augusto SchmitzPas encore d'évaluation

- Catalogo Produtos BPDocument41 pagesCatalogo Produtos BP69x4Pas encore d'évaluation