Académique Documents

Professionnel Documents

Culture Documents

P Valor Article 1

Transféré par

Lácides GilTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

P Valor Article 1

Transféré par

Lácides GilDroits d'auteur :

Formats disponibles

Telos

ISSN: 1317-0570

wileidys.artigas@urbe.edu

Universidad Privada Dr. Rafael Belloso Chacn

Venezuela

Romero Surez, Nelson

La revolucin en la toma de decisiones estadsticas: el p-valor

Telos, vol. 14, nm. 3, septiembre-diciembre, 2012, pp. 439-446

Universidad Privada Dr. Rafael Belloso Chacn

Maracaibo, Venezuela

Disponible en: http://www.redalyc.org/articulo.oa?id=99324907004

Cmo citar el artculo

Nmero completo

Ms informacin del artculo

Pgina de la revista en redalyc.org

Sistema de Informacin Cientfica

Red de Revistas Cientficas de Amrica Latina, el Caribe, Espaa y Portugal

Proyecto acadmico sin fines de lucro, desarrollado bajo la iniciativa de acceso abierto

TELOS. Revista de Estudios Interdisciplinarios en Ciencias Sociales

UNIVERSIDAD Rafael Belloso Chacn

ISSN 1317-0570 ~ Depsito legal pp: 199702ZU31

Vol. 14 (3): 439 - 446, 2012

La revolucin en la toma de decisiones

estadsticas: el p-valor

Nelson Romero Surez*

Introduccin

El concepto de p-valor como resultado de un tratamiento estadstico, es un

concepto debido a Fisher, es una contraposicin del concepto de tamao del

test en la teora de Neyman-Pearson. La idea es conseguir eliminar la posibilidad

de que dos investigadores que informen del resultado de un test estadstico, si utilizan dos tamaos diferentes lleguen a resultados distintos con la misma evidencia

estadstica, lo que no puede ocurrir con el p-valor. Se pretende seguir el nacimiento del concepto en el trabajo de Jacob Bernoulli y ver su evolucin hasta el concepto tal y como es utilizado en nuestros das.

Breve resea histrica

De acuerdo con Gmez (2011), Laplace hace una contribucin hacia el concepto del p-valor, que en su memoria de 1823 utiliza el mtodo de los mnimos

cuadrados, que l haba llamado el mtodo ms ventajoso para estudiar el efecto

de la luna en las mareas terrestres. Sigue Gmez, en esta memoria contrasta la hiptesis de que los cambios baromtricos no son influidos por las fases de la luna y

compara los cambios en la media estimada en cada una de dos series de 792 das;

una sujeta a la atraccin lunar, con otra del mismo tamao, cuando sta atraccin

no es tan pronunciada. En terminologa moderna, Laplace establece que la diferencia observada entre las medias ser significativa al nivel 0,01 si se hubieran estimado

las medias a partir de datos de 72 aos, es decir, Laplace se anticipa determinando

no solo el p-valor sino tambin ste en funcin del tamao muestral.

Considerando lo arriba descrito, Gmez (2011) indica que, la conclusin

de Laplace es correcta, en el sentido de que al haber escogido Pars, donde la marea lunar existe pero tiene un valor muy pequeo, no fue, sino hasta 1945 cuando

*

Doctor en Ciencias de la Educacin. MSc en Educacin Mencin Matemtica.

Licenciado en Educacin Mencin Matemtica y Fsica. Profesor Asociado del

Departamento de Matemticas de la Facultad Experimental de Ciencias, LUZ.

Maracaibo, Venezuela. Correo electrnico: nromero1512@gmail.com

439

Nelson Romero Surez

Telos Vol. 14, No. 3 (2012) 439 - 446

se pudo determinar correctamente; es decir, que Laplace se anticipa en 122 aos a

la resolucin del problema. Tambin debemos citar la contribucin de Poisson,

en relacin a la estimacin de la probabilidad de que un jurado de un veredicto

correcto. Esto lo hace Poisson en 1837, donde aproxima la distribucin binomial

por la normal y calcula el p-valor correspondiente a la aproximacin realizada.

Otro aporte importante surge por parte de Pearson, sobre la familia de distribuciones asimtricas que signific un paso ms, en la direccin sealada, sobre

la distribucin simtrica de Laplace. Pearson supona que este sistema de curvas

podra describir cualquier tipo de coleccin de nmeros. Cada distribucin de

esta familia se identifica con cuatro nmeros: media, desviacin estndar, asimetra y kurtosis. No obstante las crticas realizadas por Fisher (muchos de los mtodos eran menos que ptimos) y Neyman (no cubra el universo de las posibles

distribuciones), el sistema de curvas de Pearson sigue vigente en nuestros das

(Gmez, 2011).

Por otro lado, Pearson desarroll una herramienta estadstica bsica: la

prueba chi cuadrado de bondad de ajuste. Esta prueba permite determinar si un conjunto de observaciones responde a cierta funcin matemtica de distribucin. Demostr que la distribucin de la prueba es la misma cualquiera sea el tipo de datos

usados. Esto significa que pudo tabular la distribucin de probabilidad de este estadstico y usar el mismo conjunto de tablas para cada una de las pruebas. En un

trabajo Fisher en 1922, demostr que en el caso de comparacin de dos proporciones el valor del parmetro de Pearson era errado. Este error no invalida la importancia de esta prueba utilizada hasta nuestros das (Gmez, 2011).

La prueba de bondad de ajuste de Pearson fue el disparador de la componente principal del anlisis estadstico moderno: el contraste de hiptesis o prueba de significacin (Salsburg, 2001).

Hacia fines de la dcada de los 20 y principios de la de los 30 Egon Pearson

(1895-1980), hijo de Karl, y Jerzy Neyman (1894-1980) afirmaron que las pruebas de significacin no tendran sentido si no hubiera, al menos, dos hiptesis posibles que llamaron: hiptesis nula (la de Fisher) y a la otra, hiptesis alternativa.

Esto es la conocida teora de pruebas de hiptesis (hypothesis testing) de Neyman-Pearson (Gmez, 2011).

El P-Valor

En las pruebas de significacin y diseo de experimentos Fisher utiliz el

p-valor (p-value) que es la probabilidad que permite declarar la significacin de

una prueba. El trmino significacin en los primeros desarrollos de esta idea se

usaba para indicar que la probabilidad es suficientemente pequea como para rechazar la hiptesis planteada. Este es el concepto que an perdura, Fisher no tena

dudas acerca su importancia y utilidad del p-valor (Salsburg, 2001).

Gran parte de su Statistical Methods for Research Workers (Fisher, 1925) est

dedicado a mostrar cmo se calcula el p-valor. En el libro Fisher no describe de

donde derivan estos test y nunca dice exactamente qu p-valor puede considerarse

440

La revolucin en la toma de decisiones estadsticas: el p-valor

significativo. En su lugar presenta ejemplos de clculos y notas si el resultado es o

no significativo. En un ejemplo que muestra el p-valor menor que 0.01 dice: Slo

un valor en cien exceder (el test estadstico calculado) por casualidad, entonces la

diferencia entre los resultados es claramente significativa. Para Fisher un test de

significacin tiene sentido slo en el contexto de una secuencia de experimentos

referidos a un tratamiento especfico. De la lectura de los trabajos de aplicacin de

Fisher se puede deducir que us los test de significacin para una de tres posibles

conclusiones:

Si el p-valor es muy pequeo (usualmente menos de 0.01) declara que un

efecto ha sido demostrado.

Si el p-valor es grande (usualmente mayor que 0.20) el declara que si hay un

efecto es tan pequeo que ningn experimento de ese tamao es capaz de

detectarlo.

Si el p-valor est entre esos dos valores discute como disear un nuevo experimento para tener una idea mejor del efecto.

Recordemos que para Fisher la hiptesis a contrastar es que no existe diferencia entre los tratamientos. Para distinguir entre la hiptesis usada por Fisher para

calcular el p-valor y otras posibles hiptesis Neyman y Pearson llamaron hiptesis

nula a la hiptesis a contrastar y a la otra, hiptesis alternativa. En esta formulacin,

el p-valor es calculado para contrastar la hiptesis nula pero la potencia de la prueba

se refiere a como este p-valor funcionar si la alternativa es, en los hechos, verdadera. La potencia de la prueba es una medida de cuan buena es la prueba. Dadas dos

pruebas la de mayor potencia sera la mejor a usar (Salsburg, 2001).

De modo muy sinttico recordemos que la Teora de Neyman-Pearson,

cuya estructura matemtica es aceptada hasta nuestros das, establece, dos hiptesis posibles: la nula y la alternativa. De acuerdo a ciertos autores, existen dos fuentes de error: rechazar la hiptesis nula cuando es verdadera (nivel de significacin,

a o error de tipo I) y no rechazarla cuando es falsa (b o error de tipo II). Sus contrapartidas, en sentido probabilstico, son las decisiones correctas de no rechazar

una hiptesis cuando es verdadera (1-a) y rechazarla cuando es falsa (1-b), esto

ltimo es la potencia de la prueba.

Lo ideal sera que minimizramos ambos tipos de errores. Pero, por desgracia, para cualquier tamao muestral, no es posible minimizar ambos errores de

manera simultnea, el planteamiento clsico de este problema, incorporado en los

trabajos de los estadsticos Neyman y Pearson, consiste en suponer que es ms

probable que un error de tipo I sea ms grave, en la prctica, que uno de tipo II.

Por tanto, deberamos intentar mantener la probabilidad de cometer error de tipo

I a un nivel bastante bajo, como 0.01 0.05, y despus minimizar el error de tipo

II todo lo que se pueda. La nica forma de reducir un error de tipo II sin aumentar un error de tipo I es aumentar el tamao de la muestra, lo que no siempre resulta fcil (Gujarati, 2006).

441

Nelson Romero Surez

Telos Vol. 14, No. 3 (2012) 439 - 446

Siguiendo a Salburg (2001) admitimos que el uso de pruebas de significacin de Fisher produce un nmero que llam p-valor. Es una probabilidad calculada, una probabilidad asociada a los datos observados bajo el supuesto de que la

hiptesis nula es verdadera. El p-valor es una probabilidad, y as es como se

calcula.

Ejemplo: Clculo del P-Valor

El p-valor nos proporciona el grado de credibilidad de la hiptesis nula: si el

valor de p fuese muy pequeo (inferior a 0,001), significara que la hiptesis

nula es del todo increble (en base a las observaciones obtenidas), y por tanto la

descartaramos; si el valor de p oscilase entre 0,05 y 0,001 significara que hay

fuertes evidencias en contra de la hiptesis nula, por lo que la rechazaramos o no

en funcin del valor que hubisemos asignado (a priori) a . Finalmente, si elvalor

de p es grande (superior a 0,05), no habra motivos suficientes como para descartar la hiptesis nula, por lo que la tomaramos como cierta.

Criterios de decisin

Si la hiptesis alternativa H1 contiene > p-valor = P(Z>z)

Si la hiptesis alternativa H1 contiene < p-valor = P(Z<z)

Si la hiptesis alternativa H1 contiene p-valor = P(Z< - Z>) = 2

P(Z<)

Grficos 1 y 2

Regiones de rechazo para pruebas de una y dos colas

Regin de

rechazo

-za

Regin de

rechazo

-z/a

Regin de

rechazo

-z/a

Fuente: Mendenhall y Sincich (1997, p. 431).

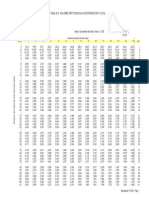

Tomemos un contraste de dos extremos, (para varianza conocida y n>30)

ahora tenemos que calcular el p-valor correspondiente al valor del estadstico de

prueba, por ejemplo zcal = 2,98, es decir el rea que hay por debajo de zcal = -2,98

ms el rea que hay por encima de zcal = 2,98, es decir, el rea en las dos colas.

Donde los dos primeros dgitos (-2,9) se encuentran en la primera columna de la

tabla normal y el ltimo dgito (8) se busca en la primera fila de la misma, luego

de la ubicacin de ambos valores se busca la interseccin entre la fila y la columna.

442

La revolucin en la toma de decisiones estadsticas: el p-valor

Si observamos la tabla de la distribucin normal estndar, podemos comprobar que el rea que hay a la izquierda de zcal = -2,98 es 0,0014 y el rea que hay

a la derecha de 2,98 es tambin 1 - 0,9986 = 0,0014 por lo que el p-valor =

2*0,0014 = 0,0028

Cuando la muestra es pequea (n<30) y no se conoce 2debe hacerse un

supuesto acerca de la forma de la distribucin a fin de obtener un procedimiento

para la prueba, el ms razonable es el supuesto de normalidad y la distribucin recomendada por sus caractersticas es la tstudent (Montgomery y Runger,

2010).

La distribucin t es similar a la z, por cuanto ambas distribuciones son simtricas y unimodales, y el valor mximo en las ordenadas se alcanza cuando =0.

Sin embargo, la distribucin t tiene colas de mayor peso que la normal, es decir,

tiene ms probabilidad en las colas que la distribucin normal. Cuando los grados

de libertad n , la forma lmite de la distribucin t es la distribucin normal estndar (Montgomery y Runger, 2010).

Tomemos el contraste dos extremos (con varianza desconocida y n<30).

Supongamos que: tamao de la muestra sea 19, los grados de libertad son

18, hiptesis H0: = 87 y H1: 87 entonces tenemos un contraste de dos colas, luego, el estadstico calculado es tcal = -2,6747 el p-valor ser la probabilidad

de estar por encima de 2,6747 ms la probabilidad de estar por debajo de t

=-2,6747. Cuando no aparece en la tabla de la tstudentel valor exacto del estadstico del cual se quiere calcular su p-valor, se toma como referencia el valor ms

cercano, en este caso t = -2,552. Por tanto el p-valor = P(t > 2,552)+P(t < 2,552) = 0,01 + 0,01 = 2*0,01 = 0,02, porque a la derecha de 2,5524 hay la

misma probabilidad que a la izquierda de -2,5524 As que el p-valor de

t=-2,6747 ser menor a 0,02 porque a mayor valor del estadstico menor rea

por encima como se puede ver en la tabla tstudent.

Cuando los grados de libertad no aparezcan en la tabla de la tstudent, se

toma los grados de libertad ms cercanos al cual se quiere tener en cuenta.

Si el contraste hubiese sido de una cola, bien por la derecha o bien por la izquierda, H1: > 87 o H1: < 87, entonces el pvalor del estadstico (supongamos que el estadstico es tcal = 2,6747) si el contraste es de cola derecha, es decir

(mayor que), sera la probabilidad de estar por encima de t = 2,5524 que sera

0,01, por lo que el p-valor de tcal= 2,6747 sera menor que 0,01.

Si es por la cola izquierda (es decir menor que), el p-valor del estadstico

(supongamos que el estadstico vale tcal = -2,6747) sera la probabilidad de estar

por debajo de tcal = -2,5524 que sera 0,01, por lo que el p-valor de tcal = - 2,6747

sera menor que 0,01.

El P-Valor: consideraciones de algunos autores

Si bien tratamiento del p-valor se le asigna a Fisher entendemos que Karl

Pearson lo us en su Prueba de chi cuadrado para la bondad de ajuste que es ante443

Nelson Romero Surez

Telos Vol. 14, No. 3 (2012) 439 - 446

rior a la denominacin de p-valor segn Fisher. Segn sigamos el punto de vista

de Fisher o el de Neyman-Pearson, en su origen, el p-valor tena significados tericos levemente diferentes. Sin embargo, con el avance de la tecnologa y la difusin de software estadsticos su diferencia terica, en apariencia, se desdibuja.

Una seleccin arbitraria de los libros de texto editados en la dcada pasada,

nos ayudan a avalar esta idea:

De acuerdo con Walpole, Myers, Myersy Ye (2007, Pp.334-335):

El valor p se puede ver simplemente como la posibilidad de

obtener este conjunto de datos dado que las muestras provienen

de la misma distribucin., la aproximacin del valor p como

ayuda en la toma de decisiones es bastante natural, ya que casi todos los paquetes computacionales que ofrecen el clculo de prueba de hiptesis dan valores p junto con valores del estadstico de

prueba adecuado. Un valor p es el nivel (de significancia) ms

bajo donde es significativo el valor observado del estadstico de

prueba

Para Daniel (2009, p. 216):

El informe de valores p como parte de los resultados de una

investigacin proporciona ms informacin al lector que afirmaciones como la hiptesis nula se rechaza con un nivel de significacin de 0,05 o los resultados no fueron significativos en el nivel

0,05. Al informar el valor p asociado con una prueba de hiptesis

se permite al lector saber con exactitud qu tan extrao o qu tan

comn es el valor calculado de la estadstica de prueba dado que

H0 es verdadera.

Segn Montgomery y Runger (2010, p. 37):

El valor p es la probabilidad de que el estadstico de prueba

asuma un valor que sea al menos tan extremo como el valor observado del estadstico cuando la hiptesis nula H0 es verdadera. Por

lo tanto, un valor p transmite mucha informacin acerca del peso

de la evidencia en contra de H0 y, por consiguiente, el responsable

de la toma de decisiones puede llegar a una conclusin con cualquier nivel de significacin especificado.

No siempre es sencillo calcular el valor p exacto de una prueba. Sin embargo, la mayora de los programas de computadora modernos para el anlisis estadstico reportan valores p, e incluso pueden obtenerse tambin en algunas calculadoras porttiles.

444

La revolucin en la toma de decisiones estadsticas: el p-valor

En opinin de Gujarati (2006, p. 120):

El taln de Aquiles del planteamiento clsico para la contrastacin de hiptesis es la arbitrariedad en la eleccin de . Aunque

1, 5, y 10 por ciento en los valores comnmente utilizados para ,

no hay nada inviolable en estos valoresEn la prctica, es preferible encontrar el valor p (es decir, el valor de probabilidad), tambin conocido como nivel exacto de significancia del estadstico de

prueba. Este valor se puede definir como el menor nivel de significancia al que se puede rechazar una hiptesis nula.

Segn Lind, Marchal, y Mason (2004, p. 347):

En aos recientes, debido a la disponibilidad de los programas de cmputo (software), se proporciona con frecuencia informacin adicional relativa a la fuerza del rechazo El valor p es

la probabilidad de observar un valor muestral tan extremo, o ms

extremo, que el valor observado, dado que la hiptesis nula es

cierta.

Para Levine, Krehbiel y Berenson (2006, p. 281):

La mayora de los programas de cmputo moderno, incluyendo Excel, Minitab y SPSS calculan el valor-p al realizar una

prueba de hiptesis.El valor-p es la probabilidad de obtener un

estadstico de prueba igual o ms extremo que el resultado de la

muestra, dado que la hiptesis nula Ho es cierta. El valor-p, que

a menudo se denomina nivel de significacin observado, es el nivel ms pequeo en el que se puede rechazar Ho.

Comentarios finales

El p-valor se puede definir como el menor nivel de significacin al que se

puede rechazar una hiptesis nula cuando es verdadera.

El discutido p-valor se puede interpretar de distinta forma segn el enfoque

de Fisher o la Teora de Neyman-Pearson.

El avance de la tecnologa permiti que los paquetes estadsticos reportaran

el p-valor.

Desde el punto de vista de la tarea cotidiana, disponer del p-valor no implica inconsistencias. En efecto, el investigador podr fijar de antemano el nivel de

significacin segn lo establece la Teora de Neyman-Pearson y, con el resultado

que reporta el software decidir sobre el rechazo, o no, de la hiptesis nula.

445

Nelson Romero Surez

Telos Vol. 14, No. 3 (2012) 439 - 446

Referencias Bibliogrficas

Daniel, Wayne. (2009). Bioestadstica, base para el anlisis de las ciencias de

la salud. Limusa Wiley. 4ta Edicin. Mxico.

Fisher, Ronald. (1925). Statistical Methods for Research Workers. Originally

published in edinburgh by oliver and boyd. Extrado de http://

es.scribd.com/doc/58873576/Fisher-R-a-1925-Statistical-Methods-for

-Research-Workers, Consulta08/08/2012.

Gujarati, Damodar. (2006). Principios de Econometra. 3era Edicin en espaol. McGraw-Hill. Espaa.

Gmez, Mara. (2011). Sobre el Concepto del P-Valor. Universidad Complutense de Madrid. Espaa.

Levine, David; Krehbiel, Timothy y Berenson, Mark. (2006). Estadstica para

Administracin. Pearson. 4ta Edicin. Mxico.

Lind, Douglas; Marchal, William; Mason, Robert. (2004). Estadstica para Administracin y Economa. 11va Edicin. Alfaomega Mxico D.F.

Mendenhall, William y Sincich, Terry. (1997). Probabilidad y Estadstica, para

ingeniera y ciencias. 4ta Edicin. Prentice-Hall Hispanoamricana.

Mxico.

Montgomery, Douglas y Runger, George. (2010). Probabilidad y Estadstica

aplicada a la Ingeniera. Limusa Wiley. 2da Edicin. Mxico.

Salsburg, David. (2001). The Lady Tasting Tea: How Statistics Revolutionized Science in the Twentieth Century. Henry Halt and Company

LLC. New York.

Walpole,Ronald; Myers, Raymond; Myers, Sharon yYe, Keying. (2007). Estadstica y Probabilidad para Ingeniera y Ciencias. 8va Edicin. Pearson. Mxico.

446

Vous aimerez peut-être aussi

- Las AnalogíasDocument3 pagesLas AnalogíasLácides GilPas encore d'évaluation

- Concurso Docente 1ra SesionDocument24 pagesConcurso Docente 1ra SesionFernando Pabon (pabonelDios)100% (2)

- AnalogiasDocument14 pagesAnalogiasJesús Saenz0% (2)

- Analogías TotalesDocument6 pagesAnalogías TotalesLácides GilPas encore d'évaluation

- Interaccion Planta PatogenoDocument11 pagesInteraccion Planta PatogenoDaniela RodriguezPas encore d'évaluation

- Ventajas A Las Plantas2Document4 pagesVentajas A Las Plantas2Lácides GilPas encore d'évaluation

- Doctorado Dea 2 Investigacion Caracterizacion Ssa Guacheta Cundinamarca Colombia CorregidoDocument24 pagesDoctorado Dea 2 Investigacion Caracterizacion Ssa Guacheta Cundinamarca Colombia CorregidoLácides GilPas encore d'évaluation

- Texto Guia EntomologiaDocument120 pagesTexto Guia EntomologiaBebo Gomez BruPas encore d'évaluation

- TablaF .05Document3 pagesTablaF .05Pedro J. Zorrilla Cavero100% (3)

- Enfermedades MaizDocument56 pagesEnfermedades MaizszacarosoPas encore d'évaluation

- Flora Soria123Document250 pagesFlora Soria123Lácides GilPas encore d'évaluation

- Acidez de Suelo EncaladoDocument18 pagesAcidez de Suelo EncaladofrederickgchPas encore d'évaluation

- Artículo Uso y Abuso de Transformaciones OkDocument5 pagesArtículo Uso y Abuso de Transformaciones OkLácides GilPas encore d'évaluation

- Artic Efic Relativa y Programa 1Document5 pagesArtic Efic Relativa y Programa 1Lácides GilPas encore d'évaluation

- Control Biológico de Enfermedades de Plantas en América Latina y El CaribeDocument404 pagesControl Biológico de Enfermedades de Plantas en América Latina y El CaribeLauraSeoaneIvanacPas encore d'évaluation

- Métodos Paramétricos para La Comparación de Dos Medias. T de StudentDocument9 pagesMétodos Paramétricos para La Comparación de Dos Medias. T de StudentRONALDPas encore d'évaluation

- Cuaderno de Practicas 2007-2008Document56 pagesCuaderno de Practicas 2007-2008Saul AlvarezPas encore d'évaluation

- Informática para Niños y Niñas de 3 A 6 AñosDocument7 pagesInformática para Niños y Niñas de 3 A 6 AñosManuel CastroPas encore d'évaluation

- Material Semana 1 InglesDocument12 pagesMaterial Semana 1 InglesLácides GilPas encore d'évaluation

- Manual Tamiz Rotativo TR40-25 PDFDocument53 pagesManual Tamiz Rotativo TR40-25 PDFJose Perez100% (1)

- Proyecto Potencia 1Document15 pagesProyecto Potencia 1Rafa ArgumedoPas encore d'évaluation

- Uipplan de ComunicaciónDocument7 pagesUipplan de ComunicaciónRolly QuirozPas encore d'évaluation

- BPZ - Lote Z-1Document19 pagesBPZ - Lote Z-1Walter Eloy Ramirez CarranzaPas encore d'évaluation

- MultiviewDocument8 pagesMultiviewTacilla Mantilla AbdiasPas encore d'évaluation

- Proponemos Normas de Convivencia en El Aula: Actividad 3Document4 pagesProponemos Normas de Convivencia en El Aula: Actividad 3Mercedes Ayala Apaza100% (1)

- Informe de Instalacion Electrica MalaDocument2 pagesInforme de Instalacion Electrica MalaMichael JuradoPas encore d'évaluation

- Cyber Admin 5Document209 pagesCyber Admin 5Ainalite AinaPas encore d'évaluation

- Avanti 2.0Document7 pagesAvanti 2.0jpabloextPas encore d'évaluation

- Las Neurohormonas - Documentos de GoogleDocument1 pageLas Neurohormonas - Documentos de GoogleScarlett K. (Scar)Pas encore d'évaluation

- El Loco PeligrosoDocument14 pagesEl Loco PeligrosoMatius De la MadridPas encore d'évaluation

- El Clima Del GenioDocument2 pagesEl Clima Del GenioSandro F. Acosta OchoaPas encore d'évaluation

- Condiciones para El Opimo Abastecimiento de Las Poblaciones - Docx Ensayooo 222222 UDocument9 pagesCondiciones para El Opimo Abastecimiento de Las Poblaciones - Docx Ensayooo 222222 UMAYERLI ARELLANO100% (1)

- Análisis Capítulo 4 de Reconstrucción en La Filosofía, de DeweyDocument5 pagesAnálisis Capítulo 4 de Reconstrucción en La Filosofía, de DeweyCarmenPas encore d'évaluation

- Informe de Uñas PalianDocument6 pagesInforme de Uñas Palianjose luisPas encore d'évaluation

- Tema 6. Corrección Activa Del Factor de PotenciaDocument7 pagesTema 6. Corrección Activa Del Factor de PotenciaDaniel MartinezPas encore d'évaluation

- Conducta DesadaptadaDocument4 pagesConducta DesadaptadaRossy Fernanda Pérez VolquezPas encore d'évaluation

- Decir, Autorrepresentación, Sujetos - Sergio CalettiDocument50 pagesDecir, Autorrepresentación, Sujetos - Sergio CalettiAnonymous pcYaAFwlIPas encore d'évaluation

- Aedes Legum de Juan Luis VivesDocument8 pagesAedes Legum de Juan Luis VivesSilvana Graciela BrizuelaPas encore d'évaluation

- Pye - Entrega FinalDocument10 pagesPye - Entrega FinalCarlos Andres Rangel CastroPas encore d'évaluation

- INFO2020 - Taller de Illustrator PDFDocument3 pagesINFO2020 - Taller de Illustrator PDFleidy seguraPas encore d'évaluation

- Actividad 3. Tipos de Diseños Experimentales y VariablesDocument3 pagesActividad 3. Tipos de Diseños Experimentales y VariablesdeyraPas encore d'évaluation

- ST PR 05 Procedimiento para El Manejo de Sustancias QuimicasDocument13 pagesST PR 05 Procedimiento para El Manejo de Sustancias QuimicasVanessa MorenoPas encore d'évaluation

- PERCEPCIONDocument1 pagePERCEPCIONVeronica PozoPas encore d'évaluation

- Actividad de Aprendizje ESCRIBE AFICHES AL ANIVERSARIO 14 - 06Document6 pagesActividad de Aprendizje ESCRIBE AFICHES AL ANIVERSARIO 14 - 06Jamery De la Cruz MarticorenaPas encore d'évaluation

- Normativa de Vuelo de Diamante RPDocument5 pagesNormativa de Vuelo de Diamante RPJESUS FABIAN PINEDO OSORIOPas encore d'évaluation

- DinámicaDocument9 pagesDinámicaElias González63% (8)

- 086 Libro Obras Completas de S H FoulkesDocument1 page086 Libro Obras Completas de S H FoulkesCide Hamete BenengeliPas encore d'évaluation

- La Noche de Los Proletarios (Jacques Ranciere)Document34 pagesLa Noche de Los Proletarios (Jacques Ranciere)AdrixDuendePas encore d'évaluation

- Leccion 3 - DofaDocument14 pagesLeccion 3 - DofaJuan Camilo Ruiz HerreraPas encore d'évaluation