Académique Documents

Professionnel Documents

Culture Documents

Red Neuronal Back Propagacion

Transféré par

Cristopher Allazo RomanCopyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Red Neuronal Back Propagacion

Transféré par

Cristopher Allazo RomanDroits d'auteur :

Formats disponibles

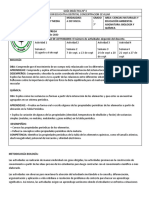

RED NEURONAL BACK PROPAGACION

Algoritmo Levenberg Marquardt Algoritmo es una variación del método de Newton que fue

designada para minimización de funciones que son de sumas de cuadrados de otras funciones no

lineales. Esto es muy adecuado para la formación de redes neuronales donde el índice de

rendimiento es el error cuadrático medio.

Algoritmo básico

Levenberg – Marquardt

xk+1 = xk-[JT(xk)J(xk)+ukI]-1JT(xk)v(xk)

Este algoritmo tiene la característica muy útil que, a medida que aumenta, se acerca al algoritmo

de descenso más pronunciado con una pequeña tasa de aprendizaje:

Mientras que a medida uk que se reduce a cero, el algoritmo se convierte en Gauss-Newton.

El algoritmo comienzan con uk establece un valor pequeño (e.g.,uk=0.01). Si un paso produce un

valor menor para F(x), entonces el paso se repite con uk multiplicados por algunos factores >1

(e.g., =10). Eventualmente F(x) debería disminuir, ya que estaríamos dando un pequeño paso

en la dirección de la pendiente descendiendo. Si un paso produce un valor menor para F(x),

que uk se dividido por para el siguiente paso, para que el algoritmo se acerque a Gauss-

Newton, que debería proporcionar una convergencia más rápida. El algoritmo proporciona un

buen compromiso entre la velocidad del método de Newton y la convergencia garantizada del

descenso más pronunciado.

Ahora veamos cómo podemos aplicar el algoritmo de Levenberg-Marquardt al problema de

entrenamiento de la red multicapa. El índice de rendimiento para el entrenamiento de red

multicapa es el error cuadrático medio (consulte la ecuación (11.11)). Si cada objetivo se

produce con igual probabilidad, el error cuadrático medio es proporcional a la suma de los

errores cuadrados sobre los Q objetivos en el conjunto de entrenamiento:

REDES NEURONALES ARTIFICIALES:

Las redes neuronales artificiales tratan de emular las características y propiedades de las redes

neuronales biológicas. En general, consiste en una serie de unidades denominadas neuronas,

conectadas entre sí.

Cada neurona recibe un valor de entrada, el cual transforma según una función específica

denominada función de activación. Dicha señal transformada pasa a ser la salida de la neurona.

Las neuronas se conectan entre si según una determinada arquitectura. Cada conexión tiene un

determinado peso que pondera cada entrada a la neurona. De esa manera la entrada de cada

neurona es la suma de las salidas de los neuronas conectadas a ella, multiplicada por el peso de

la respectiva conexión. La figura siguiente ilustra dicho concepto:

El aprendizaje de una red neuronal consiste en hallar los valores precisos de los pesos de sus

conexiones para que pueda resolver un determinado problema. El proceso general consiste en ir

introduciendo una serie de datos patrón y ajustar los pesos siguiendo un determinado criterio.

Los criterios que se van a utilizar en este proyecto se fundamentan en el error cometido por la

red, lo que nos obliga a conocer la salida que se debería obtener para cada uno de ellos. Es lo

que se conoce como entrenamiento supervisado.

Funciones de activación:

Las funciones de activación que se suele utilizar son las función identidad, la función sigmoidal

y la función tangente hiperbólica. A continuación se muestran sus respectivas expresiones.

La principal diferencia entre la función sigmoidal y la función tangente hiperbólica es el rango

de sus valores de salida. Mientras que para la primera su rango es [0,1], para la segunda es [-

1,1]. De hecho existe una relación entre las dos. Se relacionan mediante la expresión

f2(x)=2f1(x)-1, por lo que la elección entre una u otra se elige en función del recorrido que

interese.

Vous aimerez peut-être aussi

- Trabajo 050.2013Document16 pagesTrabajo 050.2013Cristopher Allazo RomanPas encore d'évaluation

- Analisis de 050-2013-tr y Taller 1Document7 pagesAnalisis de 050-2013-tr y Taller 1Cristopher Allazo RomanPas encore d'évaluation

- TEMA 1 - Interpretación e Implementación SST Ley 29783 G4Document18 pagesTEMA 1 - Interpretación e Implementación SST Ley 29783 G4Cristopher Allazo RomanPas encore d'évaluation

- Tarea 02 - Especialización Ssoma XviDocument15 pagesTarea 02 - Especialización Ssoma XviCristopher Allazo RomanPas encore d'évaluation

- Beatriz Bernal - El Derecho PrimitivoDocument10 pagesBeatriz Bernal - El Derecho PrimitivoCristopher Allazo Roman100% (1)

- Sesion 6 - EG - PRESENTACIONDocument45 pagesSesion 6 - EG - PRESENTACIONCristopher Allazo RomanPas encore d'évaluation

- EFICIENCIA ENERGETICA Modulo 2 ISO 50001 - 2018 VR (PRESENTACION)Document61 pagesEFICIENCIA ENERGETICA Modulo 2 ISO 50001 - 2018 VR (PRESENTACION)Cristopher Allazo RomanPas encore d'évaluation

- Fragmentación Del Paisaje (Ejercicio 1)Document4 pagesFragmentación Del Paisaje (Ejercicio 1)Cristopher Allazo RomanPas encore d'évaluation

- Programa de Segregacion en La Fuente y Recolección Selectiva de Residuos Solidos DomiciliariosDocument4 pagesPrograma de Segregacion en La Fuente y Recolección Selectiva de Residuos Solidos DomiciliariosCristopher Allazo RomanPas encore d'évaluation

- Guia de EstudioDocument12 pagesGuia de Estudioalondra morenoPas encore d'évaluation

- Antecedentes GinecoDocument2 pagesAntecedentes GinecoNena AguilarPas encore d'évaluation

- Esthefany Pozo ProyectoDocument24 pagesEsthefany Pozo ProyectoJesus EslavaPas encore d'évaluation

- Popeadora de Kiwicha Pkt-30x-2Document4 pagesPopeadora de Kiwicha Pkt-30x-2JB StrahlPas encore d'évaluation

- VienaDocument7 pagesVienaAde NarvaezPas encore d'évaluation

- S16.s2 Discusión de Fuentes para Examen Final 2023 MarzoDocument5 pagesS16.s2 Discusión de Fuentes para Examen Final 2023 MarzoDanny HerreraPas encore d'évaluation

- Centroide UcvDocument9 pagesCentroide UcvWilliamsQuirozPas encore d'évaluation

- Gestalt para PrincipiantesDocument4 pagesGestalt para Principiantesluisa diazarPas encore d'évaluation

- Tabla Numeros A DimensionalDocument5 pagesTabla Numeros A DimensionalItzel Garcia Belmonte100% (2)

- Clasificación de Los Volcanes y Sus CaracterísticasDocument3 pagesClasificación de Los Volcanes y Sus CaracterísticasNohemy Garzón100% (1)

- Factores Que Afectan A La Sobrevivencia de Los MoDocument100 pagesFactores Que Afectan A La Sobrevivencia de Los MoLadies prepa 4Pas encore d'évaluation

- Fundamentacion Tecnico Tactica Del DeportistaDocument43 pagesFundamentacion Tecnico Tactica Del DeportistaJadid NavarroPas encore d'évaluation

- Ensayo de Etica AmbientalDocument7 pagesEnsayo de Etica AmbientalDianita Castillo100% (1)

- Actividades Programación Orientada A ObjetosDocument9 pagesActividades Programación Orientada A ObjetosSamuel Rivera GascaPas encore d'évaluation

- Instrumentos de IfáDocument7 pagesInstrumentos de IfáMao Cisneros100% (1)

- Cemex FinalDocument13 pagesCemex FinalFernando Bernal CastilloPas encore d'évaluation

- MEMORIA DESCRIPTIVA ARQUITECTURA CERCO - Lic.Document5 pagesMEMORIA DESCRIPTIVA ARQUITECTURA CERCO - Lic.Ivan Alexander Navarro SilupuPas encore d'évaluation

- Curso Incoterms 2020 003 2Document116 pagesCurso Incoterms 2020 003 2colguinr2013Pas encore d'évaluation

- Cuervo de Pantano de La PunaDocument6 pagesCuervo de Pantano de La PunaJosefinaBravoPas encore d'évaluation

- Sopa de LetrasDocument2 pagesSopa de LetrasDesther Josue Perez QuevedoPas encore d'évaluation

- Puente Viga LosaDocument56 pagesPuente Viga LosaPaola Guevara IdrogoPas encore d'évaluation

- Manual de Entrenamiento en Concentración de Minerales - V Concentración GravimétricaDocument17 pagesManual de Entrenamiento en Concentración de Minerales - V Concentración GravimétricaRaphael Lino0% (1)

- Balanza de PagosDocument4 pagesBalanza de Pagosnatalia ballinaPas encore d'évaluation

- Teoria de Proyecciones y Proyección MongeDocument9 pagesTeoria de Proyecciones y Proyección MongeVictor Jorge Esteban Mongrut FloresPas encore d'évaluation

- Actividad 1 - Neuropsicología y El Desarrollo Del Sistema Nervioso CentralDocument5 pagesActividad 1 - Neuropsicología y El Desarrollo Del Sistema Nervioso CentralDelia Imbajoa CabreraPas encore d'évaluation

- Trabajo BencinosDocument59 pagesTrabajo BencinosXEROLIGERPas encore d'évaluation

- Informe National Del Estado Del Ambiente - GEO Guatemala 2003 PDFDocument233 pagesInforme National Del Estado Del Ambiente - GEO Guatemala 2003 PDFJose Alberto Gramajo HerreraPas encore d'évaluation

- Informe Potencial de Acción en Células ExcitablesDocument5 pagesInforme Potencial de Acción en Células ExcitablesfernandaPas encore d'évaluation

- Guía N°4 Biología 7°Document12 pagesGuía N°4 Biología 7°Joseph suarez martinezPas encore d'évaluation