Académique Documents

Professionnel Documents

Culture Documents

Série02 CC

Transféré par

Ðäñ ÑiëłøTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Série02 CC

Transféré par

Ðäñ ÑiëłøDroits d'auteur :

Formats disponibles

USDB/ Département D’Electronique/ Master1 RT / Semestre 02/ Module: CC / 2019/2020

Td N°=02. Techniques de codage et de compression de données.

Rappels : Toute fraction intelligible d’un message est constituée de symboles. Le langage est l’ensemble de ces

symboles. Un codage va associer à chaque symbole un mot de code. Chaque mot de code est constitué d’un

ensemble de signes élémentaires, encore appelés symboles de code, et est de longueur l i correspondant au

nombre de signes élémentaires qui le décrivent. Un codage est :

-intelligible :si la suite des signes élémentaires correspondant à une succession de symboles possède une

unique interprétation ;

- instantané :s il est possible de le décoder au fur et à mesure de l’arrivée des mots de code ; - préfixe, si aucun

mot de code n est le début d’ un autre mot de code ;

- complet s il est intelligible et si tout ajout d’un mot de code de longueur inférieure ou égale à n le rend

inintelligible et Lp = pour tout p > n. Une condition nécessaire pour qu’un codage de valence V (dont les mots de

code ont une longueur maximale n) soit complet et intelligible est donnée par l’égalité de Kraft-McMillan :

𝐿𝑝

∑𝑛𝑝=1 =V.

𝑉 𝑝−1

L’efficacité d’un code est estimée par ses caractéristiques :

𝐻𝑠 𝐻𝑠

-longueur moyenne : lmoy =∑𝑖 𝑙𝑖𝑃𝑖 . Il est montré que ≤lmoy, la limite théorique est donc : lmin=

𝑙𝑜𝑔2(𝑣) 𝑙𝑜𝑔2(𝑣)

𝑙𝑚𝑖𝑛

- Rendement R= 𝑙𝑚𝑜𝑦 et la redondance ρ= 1-R

Exercice1 : Soit le codage représentant les quatre symboles A, C, G, T où A est représenté par le mot de code «

0 », C par « 100 », G par « 101 », T par « 111 ».

1. Quels sont les valeurs L1, L2, L3, L4 ? Est-ce un codage intelligible ? Est-ce un codage complet ?

Exercice2 :

Soient deux s de 6 sources discrètes d’information sans mémoire S1 et S2, chacune possède un alphabet de 6

symboles, S1={X1, X2, X3, X4, X5, X6} de probabilités 1/2, 1/4, 1/8, 1/16, 1/32, 1/32 et S2= {Y1, Y2, Y3, Y4, Y5,

Y6} de distribution uniforme.

1- Quelle est la source la moins prédictible et pourquoi ?

2- Représenter le codage Huffman de chaque source. Quel le codage le plus efficace celui de S1 ou S2 ?

Exercice3 :

Soit une source (S) à 11 symboles (s1 à s11) définie par les probabilités suivantes :

S S1 S2 S3 S4 S5 S6 S7 S8 S9 S10 S11

pi 0.22 0.15 0.12 0.11 0.10 0.08 0.07 0.06 0.04 0.03 0.02

1-Calculer l’entropie de la source.

2-Que vaudrait l’entropie si tous les symboles étaient équiprobables ?

3-Donner le codage Shannon correspondant ?

4-Donner le Codage de Fano-Shannon

USDB/ Département D’Electronique/ Master1 RT / Semestre 02/ Module: CC / 2019/2020

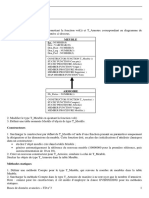

Exercice4 : ( Remarque : utiliser l’arbre comme celui montré par la figure ci-dessous)

1. Donner l’arbre du codage huffman correspondant au texte « ’RESEAUX ET

TELECOMMUNICATIONS » en calculant les probabilités d’occurrence ?

2. Donner la séquence codée ?

3. Donner le gain de compression si on avait utilisé le code ASCII ?

Exercice 5 :

Soit la séquence suivante : « abracadabrabracadabra »

1- Donner l’arbre du codage huffman correspondant ?

2-Donner la séquence codée ?

3-Donner le gain de compression si on avait utilisé le code ASCII ?

Exercice 6 (codage arithmétique)

Le principe de cette méthode est de calculer les fréquences d’apparition des symboles puis d’associer à

chaque symbole un intervalle réel compris entre 0 et 1.

Par exemple si on a la chaîne « abbc », on associe les intervalles suivants :

- a : fréquence ¼ : intervalle ]0 ; 0.25[

- b : fréquence ½ : intervalle ]0.25 ; 0.75[

- c : fréquence ¼ : intervalle ]0.75 ; 1[

Donner la séquence codée et procéder par la suite à l’opération de décodage

Exercice 7 (codage LZW)

Initialisation : un dictionnaire est créé, typiquement avec tous les caractères du code ASCII.

1. Soit la séquence suivante ‘’cagataagaaggtaa ’’

2. construire le codage dictionnaire correspondant?

3. Donner la séquence codée ?

Exercice 8(codage LZW)

Soit l’ensemble de caractere indexé par la base de dictionnaire suivante :

lettre E T W -

indice 0.22 0.15 0.12 0.11

Donner le code de la séquence suivante : « TWEET-TWEET

Vous aimerez peut-être aussi

- TD HTML CSSDocument3 pagesTD HTML CSSÐäñ ÑiëłøPas encore d'évaluation

- TD4 RSF 20 21 CorrigéDocument1 pageTD4 RSF 20 21 CorrigéNarimen BoudilmiPas encore d'évaluation

- Compte Rendu TP 01Document18 pagesCompte Rendu TP 01Sadouki AlaePas encore d'évaluation

- CN Corrigé Série 2 Part 2 PDFDocument15 pagesCN Corrigé Série 2 Part 2 PDFOussama Slimani100% (1)

- Chap 2 - Compression Sans PerteDocument57 pagesChap 2 - Compression Sans PerteMajed Ben Saada100% (1)

- Cours PLSQLDocument110 pagesCours PLSQLAbdelilah MtkPas encore d'évaluation

- TD2 RSF. 2020 21corrigéDocument2 pagesTD2 RSF. 2020 21corrigéÐäñ Ñiëłø100% (1)

- TD11Document4 pagesTD11TDMA2009Pas encore d'évaluation

- Serie TD 2Document2 pagesSerie TD 2maîgaPas encore d'évaluation

- Cours 03 Théchniques de CodageDocument9 pagesCours 03 Théchniques de CodageBou ChraPas encore d'évaluation

- Chapitre 2 Codages EntropiquesDocument9 pagesChapitre 2 Codages EntropiquesBenmo AbdoPas encore d'évaluation

- Codage Source 1Document14 pagesCodage Source 1Donald AbidjoPas encore d'évaluation

- Fiche TP Codage MasterI TLC RTSTDocument11 pagesFiche TP Codage MasterI TLC RTSTmaissaPas encore d'évaluation

- TD1 Codage Et Compression 2017Document1 pageTD1 Codage Et Compression 2017Babi Ben100% (1)

- TP Codage Et Compression Boukenadil PDFDocument10 pagesTP Codage Et Compression Boukenadil PDFAyoushi آيوشيPas encore d'évaluation

- Compression de ImagesDocument22 pagesCompression de ImagesRicardo AguilarPas encore d'évaluation

- TD 2: Information Selon Shannon Et Codage Optimal: 1 Inégalité de Kraft (Suite)Document2 pagesTD 2: Information Selon Shannon Et Codage Optimal: 1 Inégalité de Kraft (Suite)Sãb ÎnePas encore d'évaluation

- Exos CodageDocument16 pagesExos CodageTaouhid MansouriPas encore d'évaluation

- Solution Serie TD2Document6 pagesSolution Serie TD2maîgaPas encore d'évaluation

- CODAGE1Document6 pagesCODAGE1badrPas encore d'évaluation

- Chap 2Document10 pagesChap 2amalPas encore d'évaluation

- Codage-Compression TDDocument4 pagesCodage-Compression TDNouzha BoukoubaPas encore d'évaluation

- Cti TD3Document2 pagesCti TD3Mohamed MohamedPas encore d'évaluation

- Reconaissance ParoleDocument5 pagesReconaissance ParoleothmanenaggarPas encore d'évaluation

- Codage Source-1 PDFDocument14 pagesCodage Source-1 PDFAbdou SuperPas encore d'évaluation

- Enoncé Des TP (Codage de Source)Document8 pagesEnoncé Des TP (Codage de Source)Abderrazak AbdPas encore d'évaluation

- Cours de CompressionDocument18 pagesCours de CompressionEl Arbi Abdellaoui AlaouiPas encore d'évaluation

- 1 Codage ArithmétiqueDocument49 pages1 Codage ArithmétiqueMegherbi RahalPas encore d'évaluation

- Examen Codage Compression M1 2019Document2 pagesExamen Codage Compression M1 2019ranacheurfaPas encore d'évaluation

- Chapitre 3 THI Codage de Sources Discrètes Et Compression 1Document67 pagesChapitre 3 THI Codage de Sources Discrètes Et Compression 1Amine NimourPas encore d'évaluation

- Code Correcteur D'erreurDocument25 pagesCode Correcteur D'erreurpicassomedia100% (1)

- Projet Codage FinalDocument18 pagesProjet Codage FinalOussamaPas encore d'évaluation

- TP2 FRDocument9 pagesTP2 FRTamazight BinaPas encore d'évaluation

- 2 Cours TVN CS 2 PDFDocument57 pages2 Cours TVN CS 2 PDFMahfoud le KingPas encore d'évaluation

- Filière D'Ingénieurs: Systèmes Intelligents Module: Théorie de L'Information Codage Source, Canal Vidéo Et Parole Exercices de TdsDocument6 pagesFilière D'Ingénieurs: Systèmes Intelligents Module: Théorie de L'Information Codage Source, Canal Vidéo Et Parole Exercices de TdsHamza MhalPas encore d'évaluation

- TD 1Document3 pagesTD 1Youness IDRISSIPas encore d'évaluation

- Chapitre01 Notions Fondamentales de Codage Source Et Codage CanalDocument4 pagesChapitre01 Notions Fondamentales de Codage Source Et Codage CanalMohamed MohamedPas encore d'évaluation

- TP HuffmanDocument4 pagesTP HuffmanAlexandre BrabantPas encore d'évaluation

- 4_2Chapitre 6 TI - CopyDocument23 pages4_2Chapitre 6 TI - CopyZakaria TajirPas encore d'évaluation

- Université Sultan Moulay Slimane: Examen Informatique (Compilation)Document2 pagesUniversité Sultan Moulay Slimane: Examen Informatique (Compilation)AMINPas encore d'évaluation

- Codage Source Shanon FanoDocument55 pagesCodage Source Shanon FanomaxleproPas encore d'évaluation

- DevoirAlgo 2018Document4 pagesDevoirAlgo 2018dzaaPas encore d'évaluation

- TP1 CompilationDocument6 pagesTP1 CompilationEmna RekikPas encore d'évaluation

- Solutions Exercices 3 4Document3 pagesSolutions Exercices 3 4Mohamed NjehPas encore d'évaluation

- Chapitre 2Document16 pagesChapitre 2Noureddine BougreaPas encore d'évaluation

- Devoir 1-1Document2 pagesDevoir 1-1Pascal Ngorhoma KlakomPas encore d'évaluation

- SynthesesvhdDocument8 pagesSynthesesvhdwalindosPas encore d'évaluation

- Controle 2Document2 pagesControle 2Lion DE AbderrazakPas encore d'évaluation

- Compte Rendu TP1 Microprocesseurs (Récupération Automatique)Document6 pagesCompte Rendu TP1 Microprocesseurs (Récupération Automatique)Jaurel SeriPas encore d'évaluation

- Chapitre1 CodageSourceCanalDocument4 pagesChapitre1 CodageSourceCanalHocine BitamPas encore d'évaluation

- Sujet1 - Master ProfessionnelDocument2 pagesSujet1 - Master ProfessionnelDuvet francoisPas encore d'évaluation

- TD1 - RC - CodagesourceDocument4 pagesTD1 - RC - Codagesourcemaher kabarPas encore d'évaluation

- ISTDI - TD Théorie de L'info Et Du Codage - RevDocument4 pagesISTDI - TD Théorie de L'info Et Du Codage - Revstanis kamdoumPas encore d'évaluation

- Théo - Inf. Part2 Théorie de LinformatiqueDocument68 pagesThéo - Inf. Part2 Théorie de Linformatiquepfe projetPas encore d'évaluation

- Exercice 0:: J 2 1 I I JDocument5 pagesExercice 0:: J 2 1 I I JDadi Mohamed BéchirPas encore d'évaluation

- Codage 2 ATel 20Document3 pagesCodage 2 ATel 20Jesser DridiPas encore d'évaluation

- Exercice 1: TD La Transmission en Bande de Base / en Bande TransposeeDocument5 pagesExercice 1: TD La Transmission en Bande de Base / en Bande TransposeeMariam DhiebPas encore d'évaluation

- Revision Globale 2 - SC Dalli Oula Masrour Ma39eltchDocument2 pagesRevision Globale 2 - SC Dalli Oula Masrour Ma39eltchAnass BouHzamPas encore d'évaluation

- TP 2 Théorie de L'informationDocument7 pagesTP 2 Théorie de L'informationBelguith EmnaPas encore d'évaluation

- Codage de Source A Longueur Variable - CompressDocument13 pagesCodage de Source A Longueur Variable - CompressMira AllaliPas encore d'évaluation

- Python pour Débutants : Guide Complet pour Apprendre la Programmation Pas à PasD'EverandPython pour Débutants : Guide Complet pour Apprendre la Programmation Pas à PasPas encore d'évaluation

- Walid Benouh - TP04Document4 pagesWalid Benouh - TP04Ðäñ ÑiëłøPas encore d'évaluation

- VoIP - Partie 2 - SUITE - Etudiants - Ver2020Document8 pagesVoIP - Partie 2 - SUITE - Etudiants - Ver2020Narimen BoudilmiPas encore d'évaluation

- VoIP Partie1 Etudiants Ver2020Document13 pagesVoIP Partie1 Etudiants Ver2020Narimen BoudilmiPas encore d'évaluation

- VoIP - Partie 2 - Etudiants - Ver2020Document7 pagesVoIP - Partie 2 - Etudiants - Ver2020Narimen BoudilmiPas encore d'évaluation

- VoIP Moitié1 Partie 3 ÉtudiantDocument8 pagesVoIP Moitié1 Partie 3 ÉtudiantÐäñ ÑiëłøPas encore d'évaluation

- TD1 RSF Corrigé 2020 21Document1 pageTD1 RSF Corrigé 2020 21Narimen BoudilmiPas encore d'évaluation

- TD18Document2 pagesTD18Ðäñ ÑiëłøPas encore d'évaluation

- TD3 RSF CorrigéDocument1 pageTD3 RSF CorrigéNarimen BoudilmiPas encore d'évaluation

- TD1 RSF Corrigé 2020 21Document1 pageTD1 RSF Corrigé 2020 21Narimen BoudilmiPas encore d'évaluation

- Série02 CCDocument2 pagesSérie02 CCÐäñ ÑiëłøPas encore d'évaluation

- Transmission de DonneesDocument117 pagesTransmission de DonneesHachim BoubacarPas encore d'évaluation

- Partie 6 Slide Livre Réseaux InformatiquesDocument41 pagesPartie 6 Slide Livre Réseaux Informatiqueschatjpt34Pas encore d'évaluation

- Modelisation Bases de DonneesDocument11 pagesModelisation Bases de Donneesmohamed sabrixPas encore d'évaluation

- 00 Ass MachineDocument6 pages00 Ass MachineazouaoufPas encore d'évaluation

- Compilation Yaz MDKDocument1 pageCompilation Yaz MDKJonah FaulknerPas encore d'évaluation

- Jasper ReportDocument20 pagesJasper ReportSalma EttamenPas encore d'évaluation

- TD 1 Numérisation-Echantillonage Et Quantification2022Document4 pagesTD 1 Numérisation-Echantillonage Et Quantification2022Chawia Ith8iPas encore d'évaluation

- Etude D'active Directory - KHALID KATKOUTDocument37 pagesEtude D'active Directory - KHALID KATKOUTAbdelhak YaichePas encore d'évaluation

- Les Codes Détecteurs Et Correcteurs Derreur - Codage InfoDocument4 pagesLes Codes Détecteurs Et Correcteurs Derreur - Codage Infomohamed amine boukariPas encore d'évaluation

- TP 02Document8 pagesTP 02Sahouma SkPas encore d'évaluation

- Les Erreurs StopDocument8 pagesLes Erreurs StopKill IanPas encore d'évaluation

- SMI - S4 TPs Serie - 3 Et Correction Langage CDocument6 pagesSMI - S4 TPs Serie - 3 Et Correction Langage COmar KhalidPas encore d'évaluation

- console de réglage ftx 117Document19 pagesconsole de réglage ftx 117johndombroPas encore d'évaluation

- Bases de Données: Mathieu@Document183 pagesBases de Données: Mathieu@Houssem GhammamPas encore d'évaluation

- Td3-Bda-3ing-Glsi - C PDFDocument9 pagesTd3-Bda-3ing-Glsi - C PDFHamdouch BachrPas encore d'évaluation

- Cours API-AEG020-2016 2 FiniDocument16 pagesCours API-AEG020-2016 2 Finibasma100% (2)

- 9-Listes ChainéesDocument69 pages9-Listes ChainéesYassineHann67% (3)

- Série D'exercices N°3-3tech-Bascules-Compteurs-2012-2013-CorrectionDocument10 pagesSérie D'exercices N°3-3tech-Bascules-Compteurs-2012-2013-CorrectionMustapha LibourkiPas encore d'évaluation

- DBA OracleDocument36 pagesDBA Oraclehajar razikPas encore d'évaluation

- Ressources Formation CiscoICND2Document193 pagesRessources Formation CiscoICND2Anselme SERIPas encore d'évaluation

- Les VuesDocument5 pagesLes VuesHajar El atmaniPas encore d'évaluation

- tp23 CompressDocument11 pagestp23 CompressChaymaa Bjm100% (1)

- Restauration SDocument3 pagesRestauration Sdode285Pas encore d'évaluation

- Autorisations NTFSDocument4 pagesAutorisations NTFSsaidaggounPas encore d'évaluation

- Nom Et Prénom:: Test de TPDocument2 pagesNom Et Prénom:: Test de TPAbdoo SæmPas encore d'évaluation

- 3iir G3Document1 page3iir G3SabriPas encore d'évaluation

- Chap2-Circuits Séquentiels PDFDocument29 pagesChap2-Circuits Séquentiels PDFaymen houchePas encore d'évaluation

- Pnacw 973Document37 pagesPnacw 973Marcellin Moukilou ntsoulambaPas encore d'évaluation