Académique Documents

Professionnel Documents

Culture Documents

Wget en Windows

Transféré par

Edson RochaCopyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Wget en Windows

Transféré par

Edson RochaDroits d'auteur :

Formats disponibles

WGET EN WINDOWS

Pingato es una clsica y poderosa herramienta de Linux, para Windows. Para los que no saben, wget es un gestor de descargas en modo consola incluido por defecto en linux. Para instalarlo, deben copiar el archivo en el directorio raz de Windows (normalmente C:WINDOWS). Para ejecutarlo, abrimos el cmd y lo usamos como si fuera en linux (wget URL de descarga). Para ver la ayuda usamos el comando wgethelp.

Lo pueden descargar aqu: http://users.ugent.be/~bpuype/wget/ Wget tambin est disponible en Windows, y hasta hay un GUI para esta utilidad El proceso es sencillo, y tal y como indican en el post original -de nuevo adapto el contenido, pero todo el mrito es de jamsubuntu- basta con escribir el comando wget -r -p http://www.ejemplo.com El parmetro -p le indica a wget que incluya todo (imgenes tambin), de modo que todos los ficheros HTML se mostrarn en su versin offline del

mismo modo que si estuviramos viendo la pgina con conexin. Tambin podemos pasar del fichero robots.txt del sitio web que queremos extraer para obtener an ms informacin y pginas que no se obtienen con el comando normal. Para ello habr que escribir: wget -r -p -e robots=off http://www.ejemplo.com Muchos sitios web no dejaran que te descargues todo lo que hay en ellos, as que podremos engaarles hacindoles pensar que somos un navegador convencional: wget -r -p -e robots=off -U mozilla http://www.ejemplo.com An as hay administradores que han puesto un lmite a este tipo de descargas y cuando ven que hay una transferencia masiva de archivos la limitan, pero para engaar de nuevo a este comportamiento simplemente podemos establecer ciertas pausas entre la descarga de informacin: wget --random-wait -r -p -e robots=off -U mozilla http://www.ejemplo.com Como indican en jamsbuntu, existen otros parmetros tiles de wget, como por ejemplo "--limit-rate=20k", que limitar la tasa de descarga para que este proceso no se coma todo nuestro ancho de banda. El parmetro "-b" continuar con la descarga incluso si nos salimos de la sesin (til para realizar ese proceso a travs de mquinas remotas), y por ltimo la opcin "-o $HOME/wget_log.txt" permitir mantener un registro de las transferencias para comprobar posibles errrores. Links: http://jamsubuntu.blogspot.com/2009/02/using-wget-to-download-entirewebsites.html http://www.gnu.org/software/wget/

Creo que a estas alturas ya todos deben conocer esta fantstica herramienta que viene por defecto en la mayora de las distros: WGET. Pero no todos sabemos aprovechar al mximo su potencial. Con wget se puede, por ejemplo, descargar sitios completos, limitar la velocidad de descarga, establecer nombre del archivo destino, continuar descargas interrumpidas (sta es la mejor), y mil cosas ms. Ac les dejo un tutorialcito con los comands ms tiles de este excelente gestor. Ojo, que se sepa que yo no escrib sto. La fuente est al final de la pgina.

Ejemplos bsicos wget http://ejemplo.com/programa.tar.gz La manera ms simple de usarlo, descarga el archivo indicado. wget http://ejemplo.com/programa.tar.gz ftp://otrositio.com/descargas/video.mpg Es posible indicar ms de una descarga a la vez, incluso con distintos protocolos. wget http://ejemplo.com/*.pdf Otra manera de descargar varios archivos, con extensin similar. (creamos una lista en archivos.txt que sern descargados) http://ejemplo.com/programa.tar.gz http://ejemplo.com/rpm/paquete.rpm ftp://otrositio.com/descargas/distro.iso (descargamos todos indicando el archivo) wget -i archivos.txt Si vas a descargar varios archivos, ndicalos a travs de una lista en un archivo.

wget -c http://ejemplo.com/distro.iso wget -i -c archivos.txt Si la descarga se interrumpi por algn motivo, continuamos la descarga desde donde se haya quedado con la opcin c. wget -o reporte.txt http://ejemplo.com/programa.tar.gz Proporciona un reporte (log) sobre la descarga. $ wget -o /reporte.log --limit-rate=50k ftp://ftp.centos.org/download/centos5-dvd.iso En descargas muy largas como el iso de alguna distro de Linux, puedes limitar el ancho de banda de la descarga en especfico, ya que podra ser que la descarga se llevar todo el ancho de banda durante varias horas. wget http-user=admin http-password=secreto http://ejemplo.com/archivo.mp3 Si es un sitio donde se requiere de usuario/contrasea usa estas opciones. wget -t 50 http://ejemplo.com/pelicula.mpg Por defecto, wget realiza 20 intentos de establecer la conexin e iniciar la descarga, en sitios muy saturados es posible que ni con 20 intentos se logr, con la opcin t (tries) aumenta a ms intentos. wget -t inf http://ejemplo.com/pelicula.mpg Quieres que intente hasta que logr la conexin?, usa la opcin 'inf' de intentos infinitos. Ejemplos avanzados wget www.linuxtotal.com.mx Puedes descargar toda una pgina completa, wget no est limitado a solo descargas de archivos. Sitios completos pueden descargarse tambin. wget -p www.linuxtotal.com.mx Lo mismo que lo anterior pero con esta opcin p descarga adems todos los elementos extras necesarios de la pgina como hojas de estilos, imgenes en

lnea, etc. wget -r www.ejemplo.com -o reporte.log wget -r -l10 www.ejemplo.com -o reporte.log Con la opcin r se descarga recursivamente hasta 5 niveles del sitio. Con la opcin l se aumenta el nivel de recursividad hasta el nmero indicado, tambin es posible usar 'inf' como valor de recursividad infinito. wget --convert-links -r http://www.sitio.com/ (o tambin) wget -k -r http://www.sitio.com/ Por defecto, los enlaces dentro del sitio apuntan a la direccin del dominio completo. Si deseas descargar el sitio recursivamente y despus estudiarlo fuera de lnea (off line) usa la opcin convert-links que los convertir en enlaces locales, apuntando a las pginas dentro del sitio descargado. wget -r -l3 -P/tmp/sitio ftp://www.unsitio.com/ Por defecto, el sitio a descargar se guarda en el mismo directorio donde ests ejecutando wget, con la opcin P puedes indicar un directorio distinto. wget --mirror http://www.linuxtotal.com.mx/ (o tambin) wget -m http://www.linuxtotal.com.mx/ De este modo obtienes una copia (un espejo) completa del sitio. La opcin --mirror es igual a usar las opciones -r -l inf -N que indica recursividad a nivel infinito y obtienendo la marca de tiempo original de cada archivo descargado (opcin -N). wget --mirror --convert-links --html-extension http://www.linuxtotal.com.mx (o tamben) wget -m -k -E http://www.linuxtotal.com.mx Si descargas el sitio completo para verlo fuera de lnea (off line) es posible que varios archivos descargados no se abran, debido a extensiones como .cgi, .asp o .php, es entonces posible indicarle a wget con la opcin E o --html-extension que convierta todos los archivos a extensin .html. wget -H -r -l3 -k -E -p http://miblog.sitiodeblogs.com

La opcin H (span hosts) expande la recursividad a los sitios desde donde se enlace el original. Este comando descargar el sitio con una recursividad de 3 niveles (-r -l3), conviertiendo los enlaces a locales para examinarlo off line (-k), convierte todo a extensiones .html (-E), descarga completamente imgenes y dems elementos de cada pgina (-p) y adems descarga la pgina externa de los enlaces que apunten fuera del sitio (-H). Este tipo de descargas, dependiendo del sitio, puede llenar todo un disco duro!!!!, asi que salo a discresin. Un ejemplo extremo de la potencia de wget El siguiente ejemplo viene muy bien detallado en este sitio, es una lnea que busca archivos de msica mp3 desde una lista de sitios que previamente hayas definido, recuerda, un rengln por cada sitio. wget -r -l1 -H -t1 -nd -N -np -A.mp3 -erobots=off -i sitiosmp3.txt Vemoslo por partes: * [-r -l1] recursivo en solo un nivel, solo buscar un nivel en cada subdirectorio que encuentre por sitio. * [-H] si dentro del sitio encuentra un enlace externo, que lo siga, ya que posiblemente lleve a otro sitio de descarga de mscia. * [-t1] -t es igual --tries, solo har un intento de conexin, si no lo logra continua al siguiente sitio. * [-nd] indica no crear subdirectorios para cada archivo descargado, es decir, todo nos lo deja en el mismo lugar. * [-N] conserva la fecha y hora (timestamp) del archivo original que se descargue, de otro modo pondra la fecha y hora de nuestro sistema. * [-np] no parent, no seguir enlaces a directorios superiores, solo del actual y uno haca abajo, por -r -l1 * [-A.mp3] -A indica a wget el tipo de archivo a descargar solamente, en este caso solo "mp3". * [-erobots=off] esto evita que wget ignore los archivos 'robots.txt' que pudiera haber, ya que puede ser que dentro de estos archivos haya indicaciones de que subdirectorios los buscadores no deben hurgar (incluyendo a wget). Con esto lo evitamos y buscamos en todo el nivel. * [-i sitiosmp3.txt] el archivo con la lista (hecha a tu gusto, con unos cuantos o decenas de sitios de msica) de los sitios desde donde buscar "mp3" y descargarlos. Si ejecutas este comando de manera diaria o a travs de un cron entonces se

descargar la msica, y gracias a la marca de tiempo solo descargar los que sean ms nuevos que el original.

FUENTE: http://www.linuxtotal.com.mx/index.php?cont=info_admon_017 OK. Espero que a ustedes les sirva tanto como a m. Suerte.

Vous aimerez peut-être aussi

- Aprende Wget Con EjemplosDocument4 pagesAprende Wget Con EjemplosYoshuaDonkusPas encore d'évaluation

- Comandos Interesantes en LinuxDocument22 pagesComandos Interesantes en LinuxSantos CorralesPas encore d'évaluation

- Tutorial UbuntuDocument17 pagesTutorial UbuntuCharlie BrownPas encore d'évaluation

- File InclusionDocument14 pagesFile InclusionFiluxPas encore d'évaluation

- Tutorial de TeleportDocument11 pagesTutorial de TeleportManuel_Guarama_8822Pas encore d'évaluation

- Comandos LinuxDocument154 pagesComandos LinuxHebert Molina100% (2)

- Modulo 6 - FTPDocument18 pagesModulo 6 - FTPLaura Natalia ErmiagaPas encore d'évaluation

- Instalación PostgreSQL ClienteDocument4 pagesInstalación PostgreSQL ClienteMariano AgullóPas encore d'évaluation

- Nuevo Manual Lamp Centos 7Document4 pagesNuevo Manual Lamp Centos 7Tony Mayhuay RashtaPas encore d'évaluation

- Instalación y Configuración de PostgreSQL Bajo GNU - LinuxDocument33 pagesInstalación y Configuración de PostgreSQL Bajo GNU - LinuxMiguel Angel MatosPas encore d'évaluation

- Guias de InstallDocument14 pagesGuias de InstallnahomisssPas encore d'évaluation

- Compilacion Mapserver PostgisDocument28 pagesCompilacion Mapserver PostgisCarlos Isaac Otero MichilotPas encore d'évaluation

- Centos 7Document27 pagesCentos 7Miguel Angel Gonzalez GPas encore d'évaluation

- Montar Servidor FTP Con Pure-FTPd en FreeBSDDocument5 pagesMontar Servidor FTP Con Pure-FTPd en FreeBSDaalejosdPas encore d'évaluation

- Guia Instalacion OpenmeetingsDocument12 pagesGuia Instalacion OpenmeetingsJesús PalaciosPas encore d'évaluation

- Instalar Servidor ProFtpd en DebianDocument8 pagesInstalar Servidor ProFtpd en Debian17527520Pas encore d'évaluation

- Capitulo 9 Compresion de ArchivosDocument29 pagesCapitulo 9 Compresion de ArchivosMarlon OrtizPas encore d'évaluation

- Comandos Basicos de Ubuntu Linux ServerDocument19 pagesComandos Basicos de Ubuntu Linux ServerWilliam Cruz CisilaPas encore d'évaluation

- Instalacion Koha en Ubuntu PDFDocument93 pagesInstalacion Koha en Ubuntu PDFRene Alexander MartinezPas encore d'évaluation

- ProFTPD - Un Servidor FTP para ProfesionalesDocument5 pagesProFTPD - Un Servidor FTP para Profesionalesinfobits100% (1)

- Tutorial de RosettaDocument6 pagesTutorial de RosettaJean Paul Pereyra PríncipePas encore d'évaluation

- Comandos Avanzados de LinuxDocument16 pagesComandos Avanzados de LinuxYeins GonzalezPas encore d'évaluation

- Copias de Seguridad y Recuperación en PostgreSQLDocument7 pagesCopias de Seguridad y Recuperación en PostgreSQLAngela Karina ChacmaniPas encore d'évaluation

- Cómo Instalar Apache en Debian 10 y HHTrackDocument5 pagesCómo Instalar Apache en Debian 10 y HHTrackgusvellPas encore d'évaluation

- Instalacion Gentoo MinimalDocument14 pagesInstalacion Gentoo MinimalChristian CamiloPas encore d'évaluation

- Apache + PHP + MySql + PhpMyAdmin Como MóduloDocument10 pagesApache + PHP + MySql + PhpMyAdmin Como Módulo8061021Pas encore d'évaluation

- Explicamos Cómo Instalar El Motor de Base de Datos Open Source PostgreSQL en El Sistema Operativo GNU Linux Ubuntu 10Document9 pagesExplicamos Cómo Instalar El Motor de Base de Datos Open Source PostgreSQL en El Sistema Operativo GNU Linux Ubuntu 10Eduardo MartinezPas encore d'évaluation

- GNU-Linux Tema6Document8 pagesGNU-Linux Tema6mruiz_938595258Pas encore d'évaluation

- Manual de Apache+PHP+MySQL+Perl+phpMyAdminDocument16 pagesManual de Apache+PHP+MySQL+Perl+phpMyAdminArmando Jose Muñoz JimenezPas encore d'évaluation

- Instalación de Odoo en LinuxDocument7 pagesInstalación de Odoo en LinuxNoelGarciaPas encore d'évaluation

- PHP y MysqlDocument63 pagesPHP y MysqlKaren Liceth GPas encore d'évaluation

- MPDFDocument23 pagesMPDFLuis CastilloPas encore d'évaluation

- Ubuntu 01Document8 pagesUbuntu 01walter ismael sagastegui lescanoPas encore d'évaluation

- Parte 2Document84 pagesParte 2Jeison BlancoPas encore d'évaluation

- Manual de Configuración de Un Servidor FTP en LinuxDocument10 pagesManual de Configuración de Un Servidor FTP en LinuxRoger Armando Contreras CorralesPas encore d'évaluation

- Instalación de KohaDocument93 pagesInstalación de KohaDaniel MontañezPas encore d'évaluation

- Montar Un Servidor de StreamingDocument4 pagesMontar Un Servidor de StreamingCarlosMartínezGómezPas encore d'évaluation

- Servidor FTP en 5 MinutosDocument9 pagesServidor FTP en 5 MinutosRous Mery Melo UaracPas encore d'évaluation

- Instalacion Apache PHP PostgreSQLDocument9 pagesInstalacion Apache PHP PostgreSQLmarlonjcc1Pas encore d'évaluation

- Comandos Ejercicio 4 BashDocument9 pagesComandos Ejercicio 4 BashChristian MendezPas encore d'évaluation

- Guia InstalacióDocument13 pagesGuia InstalacióIván FernándezPas encore d'évaluation

- Tutorial-Instalación-Nagios-En-Cent OSDocument9 pagesTutorial-Instalación-Nagios-En-Cent OSNando ValínPas encore d'évaluation

- Tutorial Instalacion y Configuracion Pure-FtpdDocument4 pagesTutorial Instalacion y Configuracion Pure-FtpdCésar Yáñez EspinozaPas encore d'évaluation

- Manual de Instalación de OrfeoDocument6 pagesManual de Instalación de OrfeodilesverPas encore d'évaluation

- Servidor Web en Linux Debian 8 - Información Del Sistema Con PhpSysInfoDocument9 pagesServidor Web en Linux Debian 8 - Información Del Sistema Con PhpSysInfoJuan A Aguilera APas encore d'évaluation

- Aplicaciones y Comandos LubuntuDocument7 pagesAplicaciones y Comandos LubuntuJesseWakkPas encore d'évaluation

- Primeros Pasos de Kali LinuxDocument4 pagesPrimeros Pasos de Kali LinuxEdwin PiRoPas encore d'évaluation

- Servidor en Linux Ubuntu ServerVol 5Document5 pagesServidor en Linux Ubuntu ServerVol 5natxogruizPas encore d'évaluation

- Arq SO TP1 (B)Document6 pagesArq SO TP1 (B)santimangas18Pas encore d'évaluation

- Cómo Usar El Comando Wget LinuxDocument7 pagesCómo Usar El Comando Wget LinuxCiceron21Pas encore d'évaluation

- ServerDocument22 pagesServersergioPas encore d'évaluation

- Servidor FTPDocument24 pagesServidor FTPMartin Santiago RosasPas encore d'évaluation

- Configuracion Asterisk 64 BitsDocument7 pagesConfiguracion Asterisk 64 Bitsynot666Pas encore d'évaluation

- Tutorial Orangepi pc2 Servidor PDFDocument2 pagesTutorial Orangepi pc2 Servidor PDFFernando GarciaPas encore d'évaluation

- Como Montar Un Servidor Pure-FTPdDocument2 pagesComo Montar Un Servidor Pure-FTPdinfobits100% (1)

- S2GP HTML CssDocument8 pagesS2GP HTML CssAlexandre Pérez ReinaPas encore d'évaluation

- Unidad 3Document56 pagesUnidad 3Fabricio MonteroPas encore d'évaluation

- Introducción A DockerDocument11 pagesIntroducción A DockerMiguel GlezPas encore d'évaluation

- Prezi Desktop v4 (Como Instalar)Document16 pagesPrezi Desktop v4 (Como Instalar)Edson RochaPas encore d'évaluation

- Formato Ficha Tecnica EquiposDocument6 pagesFormato Ficha Tecnica EquiposEdson RochaPas encore d'évaluation

- Prezi Desktop v4 (Como Instalar)Document16 pagesPrezi Desktop v4 (Como Instalar)Edson RochaPas encore d'évaluation

- Combinacion de Teclas Windows XPDocument6 pagesCombinacion de Teclas Windows XPEdson RochaPas encore d'évaluation

- Prezi Desktop v4 (Como Instalar)Document16 pagesPrezi Desktop v4 (Como Instalar)Edson RochaPas encore d'évaluation

- Configuración de PantallasDocument3 pagesConfiguración de PantallasEdson RochaPas encore d'évaluation

- Combinacion de Teclas Windows XPDocument6 pagesCombinacion de Teclas Windows XPEdson RochaPas encore d'évaluation

- Internet en La Educacion Cardona Gonzalez ClaraDocument14 pagesInternet en La Educacion Cardona Gonzalez ClaraEdson Rocha100% (1)

- Lista de PreciosDocument3 pagesLista de PreciosEdson RochaPas encore d'évaluation

- Configuración de PantallasDocument3 pagesConfiguración de PantallasEdson RochaPas encore d'évaluation

- Anexo 4-C Modelo de Solicitud de CotizacionDocument10 pagesAnexo 4-C Modelo de Solicitud de CotizacionNestor TorresPas encore d'évaluation

- Cazau P La Antropologia Estructural de Levi Strauss PDFDocument8 pagesCazau P La Antropologia Estructural de Levi Strauss PDFDanilo Papayuelo LozanoPas encore d'évaluation

- Raza de BronceDocument28 pagesRaza de BronceEdson Rocha52% (21)

- Tema 7 - Análisis EstructuradoDocument75 pagesTema 7 - Análisis EstructuradoEdson Rocha50% (2)

- VPN A MikrotikDocument20 pagesVPN A Mikrotikfer silvaPas encore d'évaluation

- Conceptos Básicos de RoutingDocument7 pagesConceptos Básicos de RoutingSergioNaveiraPas encore d'évaluation

- Instalar Garmin Mobile XTDocument9 pagesInstalar Garmin Mobile XTjzlabPas encore d'évaluation

- 092.740cat OrigDocument1 page092.740cat OrigCesar VeraPas encore d'évaluation

- Plantilla Soplado NuevoDocument440 pagesPlantilla Soplado NuevoWagner SantoyoPas encore d'évaluation

- Calculo de Ancho de BandaDocument5 pagesCalculo de Ancho de BandaGabrielPas encore d'évaluation

- Danny PerezDocument3 pagesDanny PerezJosue SalazarPas encore d'évaluation

- Guía Instalación de UnityDocument6 pagesGuía Instalación de UnityYesid GiraldoPas encore d'évaluation

- Mapa Mental Con Los Elementos Que Conforman La Computación DistribuidaDocument6 pagesMapa Mental Con Los Elementos Que Conforman La Computación DistribuidaRodri MaldonadoPas encore d'évaluation

- Imprimir Un Formula Rio Mediante El Componente PrintFormDocument6 pagesImprimir Un Formula Rio Mediante El Componente PrintFormUziel MercadoPas encore d'évaluation

- Manual Disp MagDocument28 pagesManual Disp MagCarlos Alberto Solórzano SáenzPas encore d'évaluation

- Historia Micros IntelDocument3 pagesHistoria Micros IntelJefferson CernaPas encore d'évaluation

- Introducion A La RoboticaDocument8 pagesIntroducion A La RoboticaRebeca Martínez AbarcaPas encore d'évaluation

- DH XVR5108HS I3Document3 pagesDH XVR5108HS I3DAVID SOLORZANOPas encore d'évaluation

- P3 - 201416 - 34 Johan RubianoDocument10 pagesP3 - 201416 - 34 Johan RubianoJohan RubianoPas encore d'évaluation

- SolidDocument4 pagesSolidHilbert Perucho100% (1)

- Pruebas Unitarias IDocument34 pagesPruebas Unitarias IjmacarlupuPas encore d'évaluation

- Trabajo CNCDocument11 pagesTrabajo CNCErick P PortilloPas encore d'évaluation

- Copia de SEMANA 2Document6 pagesCopia de SEMANA 2Zoe LizPas encore d'évaluation

- Taller - de - Aprendizaje # 3Document20 pagesTaller - de - Aprendizaje # 3JORGE PEREAPas encore d'évaluation

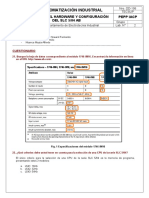

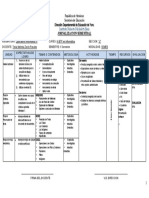

- LAB 2 Selecion y Configuracion Del SLC 5 04 ABDocument8 pagesLAB 2 Selecion y Configuracion Del SLC 5 04 ABDaniel Soncco HerreraPas encore d'évaluation

- Componentes Del OrdenadorDocument16 pagesComponentes Del Ordenadoraratecno33% (3)

- Practica 3 Gestion Usuarios y GruposDocument4 pagesPractica 3 Gestion Usuarios y Gruposdestructor_114Pas encore d'évaluation

- Codigo y Explicacion Ventana en C++Document9 pagesCodigo y Explicacion Ventana en C++Alfredo MujicaPas encore d'évaluation

- Manual Netbook XVision NX5110Document40 pagesManual Netbook XVision NX5110eduardomoralesr20% (5)

- Jornalizacion II Semestre Laboratorio IVDocument1 pageJornalizacion II Semestre Laboratorio IVTesla ZeronPas encore d'évaluation

- IS211 Desarrollo para Entorno Web 201702 PDFDocument5 pagesIS211 Desarrollo para Entorno Web 201702 PDFJair Alcacer OyerPas encore d'évaluation

- Ofimática para IngenierosDocument11 pagesOfimática para IngenierosEduardo Lopez SalasPas encore d'évaluation

- Mylab 30 - Técnicos de Mantenimiento ForoDocument3 pagesMylab 30 - Técnicos de Mantenimiento ForoReparación De Equipo Médico0% (1)

- Técnicos y Estudiantes LCD Led Panel Conexion y EntrenamientoDocument12 pagesTécnicos y Estudiantes LCD Led Panel Conexion y EntrenamientoRey Tiburon56% (9)