Académique Documents

Professionnel Documents

Culture Documents

T de Tomas

Transféré par

macroeconomia77Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

T de Tomas

Transféré par

macroeconomia77Droits d'auteur :

Formats disponibles

UNIVERSIDAD ALEJANDRO DE HUMBOLDT ESCUELA DE ECONOMA SECCION ABD0907EC PROFESOR: Tomas Leon

ANLISIS DE COMPONENTES PRINCIPALES

Autor: Oscar Antepara CI: 18.600.668

Caracas, 06 de agosto de 2010

Introduccin

En este trabajo se presenta una de las mltiples ventajas que trae consigo el anlisis multivariante de datos, mostrando como a partir de la tcnica de anlisis factorial con componentes principales como mtodo de extraccin se pueden mejorar las imagen satelitales utilizadas en la exploracin de reas geogrficas con el objetivo de identificar claramente la ubicacin especfica de ciertos materiales naturales como carbn y otros minerales Una imagen Satelital es una representacin visual de la superficie terrestre capturada por un sensor (dispositivo) montado en un satlite, la cual puede ser utilizada para mltiples propsitos, entre ellos el de interpretar las caractersticas del territorio tales como la cobertura vegetal. El satlite LandSat 7 ETM (Enhanced Thematic Mapper Plus) es un instrumento puesto en rbita por la NASA (National Space and Space Administration) y la produccin y comercializacin de imgenes depende de la USGS (United Sates Geological Survey). Este satlite esta en capacidad de tomar imgenes de Fecha de Recepcin: 25 de Enero de 2008 Fecha de Aceptacin: 20 de Marzo de 2008 Un punto de la superficie terrestre cada 16 das (resolucin temporal) compuestas por 8 bandas con resolucin espacial a 30 metros y una banda Pancromtica con resolucin de 15 metros, las cuales pueden ser combinadas de distintas formas para obtener variadas composiciones de color u opciones de procesamiento. El Anlisis Factorial con mtodo de extraccin de Componentes principales sobre la imagen puede aplicarse como un procedimiento de realce previo a cualquier interpretacin, identificando los rasgos comunes que aparecen en la mayora de las bandas y los cuales se integran en los primeros componentes. Por otra parte los Niveles Digitales ND de los pxeles de una banda pueden presentar relacin con los de componentes principales en teledeteccin busca resumir un grupo de variables en un nuevo conjunto ms pequeo sin perder parte significativa de la informacin original

Desarrollo

El ACP no requiere de un modelo estadstico para explicar la estructura probabilstica de los errores y no necesita hacer supuestos acerca de la distribucin de probabilidad de las variables originales. Sin embargo, si se supone que las variables tienen distribucin Normal multivariada, se pueden obtener algunas ventajas en la manipulacin de los Componentes Principales. Podra decirse que el objetivo principal que persigue el ACP es la representacin de las medidas numricas de varias variables en un espacio de pocasdimensiones donde nuestros sentidos puedan percibir relaciones que de otra manera permaneceran ocultas en dimensiones superiores. Dicha representacin debe ser tal que al desechar dimensiones superiores (generalmente de la tercera o cuarta en adelante) la prdida de informacin sea mnima. Un smil podra ilustrar la idea: imaginemos una gran lmina rectangular (objeto de tres dimensiones) de por ejemplo, 3m de larga, 2m de ancha y 4 cm de espesor. Para efectos prcticos, dicha lmina puede ser considerara como un objeto plano (de dos dimensiones) de 3m de largo por 2m de ancho. Al realizar esta reduccin de dimensionalidad se pierde cierta cantidad de informacin ya que, por ejemplo, puntos opuestos situados en las dos caras de la lmina aparecern confundidos en un solo. Se pierden las distancias perpendiculares a las caras. Sin embargo, la prdida de informacin se ve ampliamente compensada con la simplificacin realizada, ya que muchas relaciones, como la vecindad entre puntos, es ms evidente cuando stos se dibujan sobre un plano que cuando se hace mediante una figura tridimensional que necesariamente debe ser dibujada en perspectiva. Lo anterior, aunque sugiere que el ACP es una tcnica descriptiva, no niega la posibilidad de que tambin pueda ser utilizado con fines de inferencia. Por otra parte, las aplicaciones del ACP son numerosas y entre ellas podemos citar la clasificacin de individuos, la comparacin de poblaciones, la estratificacin multivariada, etc.

Objetivos

Entender por qu es importante reducir la dimensin en un problema estadstico. Saber aplicar el anlisis de componentes principales, con ayuda de Minitab. Conocer pautas para elegir el modelo ms adecuado para nuestro problema. Interpretar los factores del modelo obtenido. Descomposicin en valores singulares

Consideremos que nuestros datos pueden ser modelados por una distribucin gausiana, como la siguiente

El trmino dentro de la exponencial asumiendo que la media es cero, lo podemos usarlo para explicar el procedimiento

xT7-1x

Si aplicamos una matriz de rotacin R a los ejes coordenados y recordando que la transpuesta de una matriz de rotacin es equivalente a la inversa de esta, podemos escribir esta expresin como

xT(RTR)T7-1(RTR )x (Rx)T(R7-1R) Rx yT(R7-1R) y

Lo interesante de esta transformacin es tomar una matriz de rotacin que haga a la matriz de covarianza un matriz diagonal. Eso es precisamente lo que hace la descomposicin en valores singulares. As dada un matriz la descomposicin en valores singulares la escribimos como A = UDV, donde U y V son matrices de rotacin de acuerdo

a nuestro desarrollo anterior y D es una matriz diagonal a la cual se le llama la matriz de eigenvalores D = diag[l1, l2, , ln]. li es el i-esimo eigenvalor o factor. Para los datos que hemos estado manejando tenemos que la descomposicin en valores singulares de a es A = UDV

A=

0.7071 0.7071 0.7071 0.7071

22 0

0 0

-0.7071 0.7071 -0.7071 0.7071

Note que la matriz D es una diagonal y para nuestro nuevo sistema de referencia podemos ver que el eigenvalor principal es igual a 22 y en el segundo eigenvalor es cero. En este caso las matrices U y V son iguales y cada columna de estas matrices es un eigenvector. Los eigenvectores dan la direccin de las componentes principales. Note en este caso que la direccin del eigenvector principal (columna 1) es 270 grados y del segundo eigenvalor es 135 grados.

v1 = -0.7071 i - 0.7071j U = tg-1(-0.7071/-0.7071) = 270 v2 = -0.7071 i + 0.7071j U = tg-1(0.7071/-0.7071) = 135

Uno de los objetivos de hacer el anlisis en componentes principales (PCA), es resolver este tipo de problemas, reduciendo la dimensionalidad de nuestros datos. Una vez que se aplica las matrices de rotacin a los puntos de entrada y se selecciona el nmero de factores de nuestro anlisis. En este caso el nmero de factores ser uno dado que uno de los eigenvalores o factores es cero Principios del ACP

Supongamos que existe una muestra con n individuos para cada uno de los cuales se han medido m variables (aleatorias) El ACP permite encontrar un nmero de factores

subyacentes p < mque explican aproximadamente el valor de las m variables para cada

individuo. El hecho de que existan estos p factores subyacentes puede interpretarse como una reduccin de la dimensionalidad de los datos: donde antes necesitabamos m valores para caracterizar a cada individuo ahora nos bastan p valores. Cada uno de los p encontrados se llama componente principal, de ah el nombre del mtodo. Existen dos formas bsicas de aplicar el ACP: Mtodo basado en la matriz de correlacin, cuando los datos no son dimensionalmente homogneos o el orden de magnitud de las variables aleatorias medidas no es el mismo. Mtodo basado en la matriz de covarianzas, que se usa cuando los datos son dimensionalmente homogneos y presentan valores medios similares

Mtodo basado en correlaciones

El mtodo parte de la matriz de correlaciones, consideremos el valor de cada una de las m variables aleatorias . Para cada uno de los n individuos tomemos el valor de estas

variables y escribamos el conjunto de datos en forma de matriz: . Obsrvese que cada conjunto

Puede considerarse una muestra aleatoria para la variable

. A partir de los

datos

correspondientes a las m variables aleatorias, puede construirse la matriz de correlacin muestral, que viene definida por:

Puesto que la matriz de correlaciones es simtrica entonces resulta diagonalizable y sus valores propios verifican:

Debido a la propiedad anterior estos m valores propios reciben el nombre de pesos de cada uno de los m componentes principales. Los factores principales identificados . Est claro

matemticamente se representan por la base de vectores propios de la matriz

que cada una de las variables puede ser expresada como combinacin lineal de los vectores propios o componentes principales

Mtodo basado en las covarianzas

El objetivo es transformar un conjunto dado de datos X de dimensin n x m a otro conjunto de datos Y de menor dimensin n x l con la menor perdida de informacin til posible utilizando para ello la matriz de covarianza. Se parte de un conjunto n de muestras cada una de las cuales tiene m variables que las describen y el objetivo es que, cada una de esas muestras, se describa con solo I variables, donde l < m. Adems, el nmero de componentes principales l tiene que ser inferior a la menor de las dimensiones de X.

Los datos para el anlisis tienen que estar centrados a media 0 (restndoles la media de cada columna) y/o autoescalados(centrados a media 0 y dividiendo cada columna por su desviacin estndar).

Los vectores

son conocidos como scores y contienen la informacin de cmo las

muestras estn relacionadas unas con otras adems, tienen la propiedad de ser ortogonales. Los vectores se llaman loadings e informan de la relacin existente entre las variables y

tienen la cualidad de ser ortonormales. Al coger menos componentes principales que variables y debido al error de ajuste del modelo con los datos, se produce un error que se acumula en la matriz .

El PCA se basa en la descomposicin en vectores propios de la matriz de covarianza. La cual se calcula con la siguiente ecuacin:

Donde

es el valor propio asociado al vector propio

. Por ltimo,

Esta ecuacin la podemos entender como que donde los valores propios

son las proyecciones de X en

miden la cantidad de varianza capturada, es decir, la

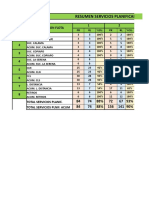

informacin que representan cada uno de los componentes principales. La cantidad de informacin que captura cada componente principal va disminuyendo segn su nmero es decir, el componente principal nmero uno representa ms informacin que el dos y as sucesivamente. Ejemplo Considere los datos de la imagen y haga el anlisis en componentes principales Results for: Imagen.MTW Principal Component Analysis: x1, x2, x3 Eigenanalysis of the Covariance Matrix

Eigenvalue Proportion Cumulative

75.883 1.000 1.000

-0.000 -0.000 1.000

-0.000 -0.000 1.000

Variable X1 X2 X3

PC1 0.577 0.577 0.577

PC2 0.789 -0.211 -0.577

PC3 -0.211 0.789 -0.577

histograma del componente principal.

Funcin discriminante del componente principal

Linear Method for Response: tono

Predictors: C8

Group Count

10 64

20 36

Summary of classification True Group Put into Group 10 20 10 64 0 20 0 36 Total N 64 36 N correct 64 36 Proportion 1.000 1.000 N = 100 N Correct = 100 Proportion Correct = 1.000

Squared Distance Between Groups 10 20 10 0.0000 94.5161 20 94.5161 0.0000

Linear Discriminant Function for Groups 10 20 Constant -44.60 -183.67 C8 5.20 10.55 La funcin de la frontera queda dada por 139.07 -5.35y1 = 0 y1 = 25.994

Conclusin

En una muestra se miden variables referidas a pruebas psicomtricas y de instruccin. Se aplican dos metodologas de enseanza: la cognoscitiva y la conductista. Los resultados de esta investigacin permiten ilustrar las aplicaciones ms frecuentes del Anlisis de Componentes Principales: a) anlisis exploratorio; b) construccin de indicadores sintticos y c) utilizacin de los componentes principales como variables independientes en el anlisis de regresin. En el anlisis exploratorio se obtienen dos grupos de variables: uno relacionado con inteligencia y el otro con rendimiento estudiantil. La estimacin de los constructos -aprendizaje e inteligenciase realiza mediante indicadores sintticos, productos del anlisis. Finalmente, se efecta un anlisis de regresin en el cual se comprueba la influencia significativa de la inteligencia y metodologa de la enseanza, sobre el aprendizaje.

Vous aimerez peut-être aussi

- Pete Walker Mariana Menendez Translator TEP COMPLEJO de Sobrevivir A Prosperar UNA GUÃ A Y MAPDocument457 pagesPete Walker Mariana Menendez Translator TEP COMPLEJO de Sobrevivir A Prosperar UNA GUÃ A Y MAPMiriam Tree100% (8)

- Matriz de Marco LogicoDocument16 pagesMatriz de Marco LogicoJilton Muñoz QuiloPas encore d'évaluation

- Clase 6Document36 pagesClase 6yeleidy perdomoPas encore d'évaluation

- Apuntes Mecanica Del Medio Continuo DemeneghiDocument113 pagesApuntes Mecanica Del Medio Continuo DemeneghiIgnacio100% (1)

- Psic - Evolutiva Herencia y Ambiente TallerDocument20 pagesPsic - Evolutiva Herencia y Ambiente TallerJuan C. FlorezPas encore d'évaluation

- Plan Departamental SucreDocument87 pagesPlan Departamental SucreJulio C Daza TorresPas encore d'évaluation

- Guia Laboratorio 1 MedicionesDocument8 pagesGuia Laboratorio 1 MedicionesMia RoyPas encore d'évaluation

- El Sutra Del LotoDocument9 pagesEl Sutra Del LotoAnalia Rosa BaiedPas encore d'évaluation

- Oración para El Tiempo de NavidadDocument5 pagesOración para El Tiempo de NavidadJavier Balán, fscPas encore d'évaluation

- ZapatasDocument4 pagesZapatasLudmerMamaniPas encore d'évaluation

- Kaizen KCDocument4 pagesKaizen KCricardo ortaPas encore d'évaluation

- Analogia de QuintoDocument9 pagesAnalogia de QuintoZaida ZegarraPas encore d'évaluation

- Carpeta Clase Explorador NiñaDocument52 pagesCarpeta Clase Explorador Niña25 DANNA VALENTINA RENDON RUBIANOPas encore d'évaluation

- Cuestionrio Del VideoDocument2 pagesCuestionrio Del VideoJoshua OnielPas encore d'évaluation

- Solucionario DominiosdeFisica10-1682396539316 PDFDocument50 pagesSolucionario DominiosdeFisica10-1682396539316 PDFAjelandro Alvarado100% (1)

- Aplicación de Las Ecuaciones de Maney para Calcular Los Momentos en Los Extremos de Las BarrasDocument4 pagesAplicación de Las Ecuaciones de Maney para Calcular Los Momentos en Los Extremos de Las BarrasAldo Salazar CamposPas encore d'évaluation

- Ventajas y Desventajas Del FerrocarrilDocument2 pagesVentajas y Desventajas Del FerrocarrilmaritareasuniversidadPas encore d'évaluation

- MS Examen 1Document2 pagesMS Examen 1Jack SuquitaPas encore d'évaluation

- FIAI - Juan Carlos Alva LunaDocument452 pagesFIAI - Juan Carlos Alva Lunam141282100% (1)

- Trabajo de Unidad 1 - Sistema de Ecuaciones LinealesDocument10 pagesTrabajo de Unidad 1 - Sistema de Ecuaciones LinealesPaula Sirlopu FachoPas encore d'évaluation

- Planeación Del 6 Al 17 de Nov.Document4 pagesPlaneación Del 6 Al 17 de Nov.Ektor Artorius HidalgoPas encore d'évaluation

- PCMDocument6 pagesPCMOswaldo BerrocalPas encore d'évaluation

- QFDDocument34 pagesQFDArmando BozoPas encore d'évaluation

- Historia de La Musico TerapiaDocument2 pagesHistoria de La Musico TerapiaPablo RuizPas encore d'évaluation

- Programacion Flota Nacional 17-04-2019Document54 pagesProgramacion Flota Nacional 17-04-2019Claudio Felipe Hernández BrunaPas encore d'évaluation

- Tinciones SangreDocument10 pagesTinciones SangrejhrpaulPas encore d'évaluation

- Relatividad: Tarea 1Document2 pagesRelatividad: Tarea 1Brian Alejandro Velazquez JuarezPas encore d'évaluation

- PolíticaDocument16 pagesPolíticaMarianaPas encore d'évaluation

- Salmo 91 Devocional Metodo InductivoDocument1 pageSalmo 91 Devocional Metodo Inductivocuatte100% (1)

- Pulpa de Mango CongeladaDocument9 pagesPulpa de Mango CongeladaMaría Elena Quispe GonzalesPas encore d'évaluation