Académique Documents

Professionnel Documents

Culture Documents

IMPRIMIR

Transféré par

Diana Huaylla TuntiCopyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

IMPRIMIR

Transféré par

Diana Huaylla TuntiDroits d'auteur :

Formats disponibles

La formula para la correccin de los pesos podra ser la siguiente:

CARCTERSTICAS DE LAS REDES NEORONALES

Incr(wji) = yi (dj - yj) Existen cuatro aspectos que caracterizan una red neuronal: Siendo: 1. TOPOLOGA La arquitectura de las redes neuronales consiste en la organizacin y disposicin de las neuronas formando capas o agrupaciones de neuronas ms o menos alejadas de la entrada y salida de la red. Los parmetros fundamentales de la red son: el nmero de capas, el nmero de neuronas por capa, el grado de conectividad y el tipo de conexiones entre neuronas. Al hacer una clasificacin topolgica de las redes neoronales se suelen distinguir: 1.1. R EDES M ONOCAPA : Se establecen conexiones laterales, cruzadas o autorrecurrentes entre las neuronas que pertenecen a la nica capa que constituye la red. Se utilizan en tareas relacionadas con lo que se conoce como autoasociacin; por ejemplo, para generar informaciones de entrada que se presentan a la red incompletas o distorsionadas.Ejemplos de redes de este tipo son la rede HOPPFIELD y la rede BRAIN-STATE-IN-A-BOX. 1.2. R EDES M ULTICAPA: Son aquellas que disponen de conjuntos de neuronas agrupadas en varios niveles o capas. Una forma de distinguir la capa a la que pertenece la neurona, consiste en fijarse en el origen de las seales que recibe a la entrada y el destino de la seal de salida. Segn el tipo de conexin,pueden clasificarse como de propagacin hacia delante(las redes feedforward) o hacia atrs(las redes feedback). 1.2.1. R EDES FEEDFORWARD :Todas las seales neuronales se propagan hacia delante a travs de las capas de la red. No existen conexiones hacia atrs ni tampoco autorrecurrentes. En estas redes ninguna salida de las neuronas es entrada de neuronas del mismo nivel o de niveles precedentes. 1.2.2. R EDESFEEDBACK : Cuando las salidas pueden ser conectadas como entradas de neuronas de niveles previos o del mismo nivel, incluyndose ellas mismas. Incr(wji) : Variacin en el peso de la conexin entre las neuronas i y j yi : Salida de la neurona i dj : Valor de salida deseado para la neurona j yj : Valor de salida obtenido en la neurona j : Factor de aprendizaje (0 < <= 1) que regula la velocidad del aprendizaje Algoritmos que utilizan este tipo de aprendizaje son: Regla de aprendizaje del perceptron: utilizada en la red PERCEPTRONRegla delta o del mnimo error cuadrado: utilizado en las redes ADALINE y MADALINE. Regla delta generalizada: utilizada en redes multicapa 2.1.2. A PRENDIZAJE POR REFUERZO : Se basa en la idea de no indicar durante el entrenamiento exactamente la salida que se desea que proporcione la red ante una determinada entrada (no disponer de un ejemplo completo del comportamiento deseado). La funcin del supervisor se reduce a indicar mediante una seal de refuerzo si la salida obtenida en la red se ajusta a la deseada (xito=+1 o fracaso=-1), y en funcin de ello se ajustan los pesos basndose en un mecanismo de probabilidades. Ejemplos de este tipo de algoritmos son el denominado Linear Reward-Penalty o LR-P [Narenda 74] y elAdapativeHeuristicCritic [Barto 83] utilizado en redes feedforward de tres capas. 2.1.3. A PRENDIZAJE ESTOCSTICO:Consiste bsicamente en realizar cambios aleatorios en los valores de los pesos de las conexiones de la red y evaluar su efecto a partir del objetivo deseado y de distribuciones de probabilidad. Una red que utiliza este tipo de aprendizaje es la red Boltzman Machine, ideada por Hinton, Ackley y Sejnowski en 1984 y la red Cauchy Machine desarrollada por Szu en 1986. 2.2. A PRENDIZAJE NO SUPERVISADO: Estas redes no requieren influencia externa para ajustar los pesos de las conexiones entre neuronas. La red no recibe ninguna informacin por parte del entorno que le indique si la salida generadaen respuesta a una determinada entrada es o no correcta; son capaces de auto organizarse. Estas redes deben encontrar las caractersticas, regularidades, correlaciones o categoras que se pueden establecer entre los datos de la entrada. Pero, qu genera la red en la salida?. Existen varias posibilidades en cuanto a interpretacin: La salida representa el grado de familiaridad o similitud entre la informacin que se le est presentando en la entrada y las informaciones mostradas con anterioridad. Clusterizacin o establecimiento de categorias, indicando la red a la salida a qu categora pertenece la informacin de entrada, siendo la propia red la que debe establecer las correlaciones oportunas. Codificacin de los datos de entrada, generando a la salida una versin codificada con menos bits, pero manteniendo la informacin relevante de los datos. Mapeo de caractersticas, obtenindose en las neuronas de salida una disposicin geomtrica que representa un mapa topogrfico de las caractersticas de los datos de entrada, de tal forma que si se presentan a la red informacikones similares,

2.

M ECANISMO DE APRENDIZAJE El aprendizaje es el proceso por el cual una red neuronal modifica sus pesos en respuesta a una informacin de entrada. Los cambios que se producen durante el proceso de aprendizaje se reducen a la destruccin (el peso de la conexin toma el valor 0), modificacin y creacin (el peso de la conexin toma un valor distinto de 0) de conexiones entre las neuronas. Se puede afirmar que el proceso de aprendizaje ha finalizado (la red ha aprendido) cuando los valores de los pesos permanecen estables (dwij / dt = 0). Un aspecto importante es determinar los criterios de la regla de aprendizaje que se considera de dos tipos: 2.1. A PRENDIZAJE SUPERVISADO:El proceso de aprendizaje se realiza mediante un entrenamiento controlado por un agente externo (supervisor, maestro) que determina la respuesta que debera generar la red a partir de una entrada determinada. El supervisor comprueba la salida de la red y en el caso de que sta no coincida con la deseada, se proceder a modificar los pesos de las conexiones, con el fin de conseguir que la salida se aproxime a la deseada. Se consideran tres formas de llevar a cabo este tipo de aprendizaje: 2.1.1. A PRENDIZAJE POR CORRECCIN DE ERROR: Consiste en ajustar los pesos en fucin de la diferencia entre los valores deseados y los obtenidos en la salida de la red; es decir, en funcin del error.

siempre sean afectadas neuronas de salidas prximas entre s, en la misma zona del mapa. Se suelen considerar dos tipos: 2.2.1. A PRENDIZAJE H EBBIANO:pretende medir la familiaridad o extraer caractersticas de los datos de entrada. Este aprendizaje consiste bsicamente en el ajuste de los pesos de las conexiones de acuerdo con la correlacin de los valores de activacin (salidas) de las dos neuronas conectadas :Incr (wji) = yiyj. Si las dos unidades son activas (salida positiva), se produce un reforzamiento de la conexin. Si por el contrario, una es activa y la otra pasiva (salida negativa), se produce un debilitamiento de la conexin. Por tanto, la modificacin de los pesos se realiza en funcin de los estados (salidas) de las neuronas, obtenidos tras la presentacin de cierto estmulo (informacin de entrada), sin tener en cuenta si se deseaba obtener o no esos estados de activacin. Este tipo de aprendizaje se utiliza en la RED HOPFIELD (1982), ADDITIVE GROSSBERG (1973),LEARNING MATRIX (1961), 4. BIDIRECTIONAL ASSOCIATIVE MEMORY (1988), TEMPORAL ASSOCIATIVE MEMORY (1972). Estas dos ltimas son redes feedforward/feedback de 2 capas. 2.2.2. A PRENDIZAJE COMPETITIVO Y COOPERATIVO : las neuronas compiten unas con otras con el fin de llevar a cabo una tarea dada. Se pretende que cuando se presente a la red cierta informacin, slo una o un grupo de ellas se activen. Por tanto las neuronas compiten por activarse, quedando las perdedoras a sus valores de respuesta mnimos. La conexin entre neuronas se realiza en todas las capas de la red, existiendo en estas neuronas conexiones recurrentes de autoexcitacin y conexiones de inhibicin (signo negativo) por parte de neuronas vecinas. El objetivo es categorizar (clustering) los datos que se introducen en la red. De esta forma, las informaciones similares son clasificadas formando parte de la misma categora, activando por tanto la misma neurona de salida. La variacin del peso de una conexin entre una unidad i y otra j ser nula si la neurona j no recibe excitacin por parte de la neurona i y se modificar si es excitada por dicha neurona i. Un ejemplo de este tipo de aprendiaje es el desarrollado por Kohonen conocido como Learning Vector Quantization (LVQ) aplicado a redes feedforward de dos capas. La diferencia entre ambos tipos estriba en la existencia o no de una agente externo (supervisor) que controle todo el proceso de aprendizaje de la red. Otro criterio para diferenciar las reglas de aprendizaje se basa en considerar si la red puede aprender durante su funcionamiento (aprendizaje ON LINE) o requiere de una fase previa de entrenamiento (aprendizaje OFF LINE).En este ltimo debe existir un conjunto de datos de entrenamiento y un conjunto de datos de test o prueba; igualmente los pesos de las conexiones no se modifican despus de terminar la etapa de entrenamiento de la red. En la red ON LINE los pesos varan dinmicamente cada vez que se presente una nueva informacin al sistema.

necesario mantener la informacin de entrada puesto que puede ser necesario acceder varias veces a ella, por lo que debe permanecer en la capa de entrada. Existen redessheteroasociativas con conexiones feedforward, feedforward/feedback y redes con conexiones laterales. Tambin existen redes heteroasociativas multidimensionales y su aprendizaje puede ser supervisado o no supervisado. 3.2.

AUTOASOCIACIN : La red aprende ciertas informaciones A1, A2, .., An de forma que cuando se le presenta una informacin de entrada realizar una autocorrelacin, respondiendo con uno de los datos almacenados, el ms parecido al de entrada. Este tipo de redes pueden implementarse con una sola capa de neuronas. El tipo de aprendizaje utilizado habitualmente es el no supervisado y suelen utilizarse en tareas de filtrado de informacin para la reconstruccin de datos, eliminando distorsiones o ruido, explorar relaciones entre informaciones similares para facilitar la bsqueda por contenido en bases de datos y para resolver problemas de optimizacin.

R EPRESENTACIN DE LA INFORMACIN DE ENTRADA Y SALIDA Las redes neuronales pueden tambin clasificarse en funcin de la forma en que se representan lasinformaciones de entrada y las respuestas o datos de salida: 4.1. R EDES CONTNUAS : En un gran nmero de redes, tanto los datos de entrada como de salida son de naturaleza analgica (valores reales contnuos y normalmente normalizados, por lo que su valor absoluto ser menor que la unidad). En este caso las funciones de activacin de las neuronas sern tambin contnuas, del tipo lineal o sigmoidal. R EDES DISCRETAS : Por el contrario, otras redes slo admiten valores discretos [0,1] a la entrada, generando tambin en la salida respuestas de tipo binario. La funcin de activacin en este caso es del tipo escaln. R EDES HBRIDAS : La informacin de entrada es contnua pero a la salida ofrecen informacin binaria.

4.2.

4.3.

3.

TIPO DE A SOCIACIN ENTRE LAS I NFORMACIONES DE ENTRADA Y S ALIDA. Las redes neuronales son sistemas que almacenan cierta informacin aprendida; est informacin se registra de forma distribuida en los pesos asociados a las conexiones entre neuronas de entrada y salida. Existen dos formas primarias de realizar esa asociacin de entrada/salida: 3.1.

HETEROASOCIACIN :La red aprende parejas de datos [(A1,B1), (A2,B2),....(An,Bn)], de tal forma que cuando se le presente determinada informacin de entrada Ai responda con la salida correspondiente Bi. Al asociar informaciones de entrada con diferentes informaciones de salida, precisan al menos de 2 capas, una para captar y retener la informacin de entrada y otra para mantener la salida con la informacin asociada. Si esto no fuese as se perdera la informacin inicial al obtenerse la salida asociada; es

Vous aimerez peut-être aussi

- Ejemplo de EntreVistasDocument18 pagesEjemplo de EntreVistasDiana Huaylla TuntiPas encore d'évaluation

- Modelo de Informe MensualDocument1 pageModelo de Informe MensualDiana Huaylla Tunti33% (3)

- Calculo de ChimeneasDocument57 pagesCalculo de ChimeneasDavidMañanes100% (1)

- Plantilla Word Formato APADocument8 pagesPlantilla Word Formato APAkarolinanicole2Pas encore d'évaluation

- PertDocument35 pagesPertpatriciaPas encore d'évaluation

- Como Han PasadoDocument1 pageComo Han PasadoDiana Huaylla TuntiPas encore d'évaluation

- Ejemplos T StudentDocument6 pagesEjemplos T Studentmacbet92Pas encore d'évaluation

- Reporte de RegistrosDocument2 pagesReporte de RegistrosDiana Huaylla TuntiPas encore d'évaluation

- Registro RaulDocument32 pagesRegistro RaulDiana Huaylla TuntiPas encore d'évaluation

- F 1024671Document2 pagesF 1024671Diana Huaylla TuntiPas encore d'évaluation

- B 1025291Document1 pageB 1025291Diana Huaylla TuntiPas encore d'évaluation

- C.V. .FERNANDO+practicasDocument4 pagesC.V. .FERNANDO+practicasDiana Huaylla TuntiPas encore d'évaluation

- B 1025291Document1 pageB 1025291Diana Huaylla TuntiPas encore d'évaluation

- Déjate Guiar Hoy MismoDocument2 pagesDéjate Guiar Hoy MismoDiana Huaylla TuntiPas encore d'évaluation

- PlataDocument5 pagesPlataDiana Huaylla TuntiPas encore d'évaluation

- Poema 1Document1 pagePoema 1Diana Huaylla TuntiPas encore d'évaluation

- Poema para CumpleañosDocument3 pagesPoema para CumpleañosDiana Huaylla TuntiPas encore d'évaluation

- Ciudad MayaDocument1 pageCiudad MayaAjja Compu GoodPas encore d'évaluation

- Cesar Basantes Ecommerce UweDocument5 pagesCesar Basantes Ecommerce UweDiana Huaylla TuntiPas encore d'évaluation

- Comunicado SISFOHDocument1 pageComunicado SISFOHDiana Huaylla TuntiPas encore d'évaluation

- Te Consideras Un Abuena PersonaDocument1 pageTe Consideras Un Abuena PersonaDiana Huaylla TuntiPas encore d'évaluation

- Anexo1 Modelo Oficio Envio de Info2014Document1 pageAnexo1 Modelo Oficio Envio de Info2014Diana Huaylla TuntiPas encore d'évaluation

- Sistema de Trámite Documentario TodosDocument13 pagesSistema de Trámite Documentario TodosDiana Huaylla TuntiPas encore d'évaluation

- Instructivo - Sistema Tramite Documentario - 1Document17 pagesInstructivo - Sistema Tramite Documentario - 1Diana Huaylla TuntiPas encore d'évaluation

- AguaDocument1 pageAguaDiana Huaylla TuntiPas encore d'évaluation

- AguaDocument1 pageAguaDiana Huaylla TuntiPas encore d'évaluation

- Caracteristicas de Las Redes NeoronalesDocument12 pagesCaracteristicas de Las Redes NeoronalesDiana Huaylla TuntiPas encore d'évaluation

- Prensa CompactadoraDocument6 pagesPrensa CompactadoraLuis Fernando Gonzalez ReyesPas encore d'évaluation

- Enunciado Trabajo Final - 2023-01Document2 pagesEnunciado Trabajo Final - 2023-01Eduardo GalvezPas encore d'évaluation

- Primera Practica So DesarrolladoDocument29 pagesPrimera Practica So DesarrolladoDaniel Trujillo FloresPas encore d'évaluation

- Explosivos ModernosDocument44 pagesExplosivos ModernosLUISPas encore d'évaluation

- El Proceso de La Construccion Del SoftwareDocument21 pagesEl Proceso de La Construccion Del SoftwareGus KnulPas encore d'évaluation

- Mapa Conceptual OperatoriaDocument1 pageMapa Conceptual OperatoriaLeonardo Manuel VillegasPas encore d'évaluation

- AMEFDocument8 pagesAMEFtributo415Pas encore d'évaluation

- Clase de FrasadoDocument34 pagesClase de FrasadoJeann JeanPas encore d'évaluation

- Tema 1 - DiédricoDocument26 pagesTema 1 - DiédricoTheDeve001 YTPas encore d'évaluation

- Acometidas y Medidores.Document6 pagesAcometidas y Medidores.Sebastian EscobarPas encore d'évaluation

- Elavoracion de Adicional de Obra Del Colegio Juan Jose Crespo y Castillo de HuanucoDocument190 pagesElavoracion de Adicional de Obra Del Colegio Juan Jose Crespo y Castillo de HuanucoArnaldo Julio Reyes RomuchoPas encore d'évaluation

- Catalogo de BosDocument6 pagesCatalogo de BosmiriamarismendiPas encore d'évaluation

- Adc0804 Conversor Analogo DigitalDocument2 pagesAdc0804 Conversor Analogo Digitaleld47_93Pas encore d'évaluation

- Fundamentos de Termodinámica PDFDocument11 pagesFundamentos de Termodinámica PDFDaniel Rodríguez VillegasPas encore d'évaluation

- Brochure l150h l180h l220h t3 Es A6 20055439 CDocument28 pagesBrochure l150h l180h l220h t3 Es A6 20055439 CRoni WayraPas encore d'évaluation

- Laboratorio 10 PDFDocument7 pagesLaboratorio 10 PDFMario Alberto Molina PandiaPas encore d'évaluation

- Replanteo TopograficoDocument39 pagesReplanteo Topograficojherson cerron moralesPas encore d'évaluation

- Estructuracion de VigaDocument10 pagesEstructuracion de VigaWM Flores LlanosPas encore d'évaluation

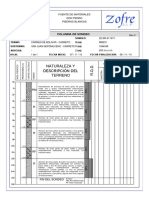

- Columna Estratigrafica Z2 SR 51107 1Document1 pageColumna Estratigrafica Z2 SR 51107 1jorgePas encore d'évaluation

- Comparación Entre Applets, CGI, PHP, ASP, Servlets y JSPDocument15 pagesComparación Entre Applets, CGI, PHP, ASP, Servlets y JSPDavid MedinaPas encore d'évaluation

- Manual de ServicioDocument74 pagesManual de ServiciordzptecPas encore d'évaluation

- TEORICA T2 2019 - 04 Chapas y ProcesosDocument38 pagesTEORICA T2 2019 - 04 Chapas y ProcesosJe MartínezPas encore d'évaluation

- Memoria DescriptivDocument10 pagesMemoria DescriptivRuben RuvasPas encore d'évaluation

- Bench MarkingDocument12 pagesBench MarkingVale Quesada MoraPas encore d'évaluation

- Estandares y ProtocolosDocument22 pagesEstandares y ProtocolosLaura FabiolaPas encore d'évaluation

- Ingenieria de FundacionesDocument11 pagesIngenieria de FundacionesSlawko BondarenkoPas encore d'évaluation

- 10 - PasarelasDocument37 pages10 - PasarelasMathias Bonilla100% (1)

- Viscosimetro Burbujas PDFDocument3 pagesViscosimetro Burbujas PDFSpliner AvilaPas encore d'évaluation