Académique Documents

Professionnel Documents

Culture Documents

Apuntes de Algebra Lineal para Publi

Transféré par

Fidel PalmaTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Apuntes de Algebra Lineal para Publi

Transféré par

Fidel PalmaDroits d'auteur :

Formats disponibles

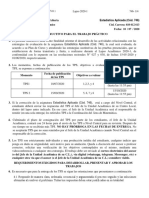

Rep ublica Bolivariana de Venezuela

Universidad Nacional Experimental Politecnica

Antonio Jose de Sucre

Vice-Rectorado Barquisimeto

Departamento de Estudios Generales y Basicos

Seccion de Matematica

Apuntes de

Algebra Lineal

Autores: MSc. Jorge F. Campos S.

MSc. Dorka M. Chaves E.

Barquisimeto, 2008

Indice general

Indice general I

1. Matrices y Sistemas de Ecuaciones Lineales 1

1.1. Operaciones con Matrices . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.1.1. Suma de Matrices y Multiplicacion por Escalar . . . . . . . . . . . . . . . 5

1.1.2. Producto de Matrices . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

1.1.3. Transposicion o Trasposicion de Matrices . . . . . . . . . . . . . . . . . . . 16

1.2. Operaciones Elementales por Filas . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

1.3. Sistemas de Ecuaciones Lineales . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27

1.4. Inversa de una Matriz Cuadrada . . . . . . . . . . . . . . . . . . . . . . . . . . . . 37

1.5. Determinantes. Propiedades de los Determinantes . . . . . . . . . . . . . . . . . . 46

1.6. Matriz Adjunta. Regla de Cramer . . . . . . . . . . . . . . . . . . . . . . . . . . . 63

1.7. Determinantes de Matrices Triangulares por Bloques . . . . . . . . . . . . . . . . 70

2. Espacios Vectoriales 76

2.1. Espacios Vectoriales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 76

2.2. Subespacios Vectoriales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 83

2.3. Combinacion Lineal y Espacio Generado . . . . . . . . . . . . . . . . . . . . . . . 88

2.4. Independencia y Dependencia Lineal . . . . . . . . . . . . . . . . . . . . . . . . . 95

2.5. Bases y Dimension . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 101

2.6. Rango, Nulidad, Espacio Fila y Espacio Columna de una Matriz . . . . . . . . . . 107

3. Matriz de Cambio de Base. Espacios con Producto Interno 117

3.1. Cambio de Base . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 117

3.2. Espacios con producto Interno . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 128

3.3. Bases Ortonormales y Proceso de Ortonormalizacion de Gram-Schmidt . . . . . . 132

3.4. Complemento Ortogonal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 142

4. Transformaciones Lineales. Autovalores y Autovectores de una Matriz 149

4.1. Transformaciones Lineales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 149

4.2. Representacion Matricial de una Transformacion Lineal . . . . . . . . . . . . . . . 161

4.3. N ucleo e Imagen de una Transformacion Lineal . . . . . . . . . . . . . . . . . . . 168

4.4. Autovalores y Autovectores de una Matriz . . . . . . . . . . . . . . . . . . . . . . 175

4.5. Diagonalizacion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 185

i

Indice general ii

4.6. Autovectores y Autoespacios Generalizados. Forma Canonica de Jordan . . . . . . 191

Apendices 207

A. Campos y N umeros Complejos 208

A.1. Campos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 208

A.2. El Campo de los N umeros Complejos . . . . . . . . . . . . . . . . . . . . . . . . . 218

B. Algo mas sobre Espacios Vectoriales 226

B.1. K-Espacios Vectoriales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 226

B.2. Espacios Vectoriales de Dimension Innita . . . . . . . . . . . . . . . . . . . . . . 228

B.3. Espacios con Producto Interno . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 228

B.4. Espacios Normados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 228

C. Algo mas sobre Transformaciones Lineales 229

C.1. Transformaciones Lineales Invertibles . . . . . . . . . . . . . . . . . . . . . . . . . 229

C.2. Autovalores y Autovectores de Transformaciones Lineales . . . . . . . . . . . . . . 234

D. Demostraciones de Algunos Teoremas 238

Captulo 1

Matrices y Sistemas de Ecuaciones Lineales

1.1. Operaciones con Matrices

Denici on 1.1. Sean m, n Z

+

. Una matriz real A de orden m por n (m n) es un

arreglo bidimensional de n umeros reales dispuestos en m las y n columnas como sigue

A = (a

ij

)

mn

=

_

_

a

11

a

12

a

1n

a

21

a

22

a

2n

.

.

.

.

.

.

.

.

.

a

m1

a

m2

a

mn

_

_

=

_

_

_

_

_

_

_

a

11

a

12

a

1n

a

21

a

22

a

2n

.

.

.

.

.

.

.

.

.

a

m1

a

m2

a

mn

_

_

_

_

_

_

_

donde a

ij

R para cada i 1, . . . , m y cada j 1, . . . , n, el cual es llamado componente

ij-esima de A.

Para cada i 1, . . . , m la i-esima la de A la denotaremos por A

(i)

y esta dada por

A

(i)

=

_

a

i1

a

i2

a

in

_

Para cada j 1, . . . , n la j-esima columna de A la denotaremos por A

(j)

y esta dada por

A

(j)

=

_

_

a

1j

a

2j

.

.

.

a

mj

_

_

Cuando m = n, diremos que A es una matriz cuadrada de orden n, en este caso, las

componentes a

11

, a

22

, . . . , a

nn

forman lo que llamaremos diagonal principal de A.

Cuando m = 1, diremos que A es una matriz la y cuando n = 1, diremos que A es una

matriz columna.

La notacion A = (a

ij

)

mn

, signica que A es la matriz de orden mn cuya ij-esima compo-

nente es a

ij

para cada i 1, . . . , m y cada j 1, . . . , n.

El conjunto formado por todas las matrices reales de orden mn lo denotaremos por M

mn

(R).

1

Matrices y Sistemas de Ecuaciones Lineales 2

Observaci on 1.1. Podemos considerar matrices sobre un campo K (ver apendice B), por

ejemplo K = C, en lugar de matrices reales, en cuyo caso las componentes de las matrices son

elementos de K.

Observaci on 1.2. Se debe tener cuidado cuando se usa la notacion (a

ij

)

mn

, el cambio de

ndices no signica que se trata de otra matriz, los ndices son mudos, esto es

(a

ij

)

mn

= (a

kr

)

mn

= (a

pq

)

mn

= (a

ji

)

mn

Ejemplo 1.1.

1. A =

_

2 0

5

2

3

4 1

_

es una matriz real de orden 23, la componente 2, 1 de A es a

2,1

=

2

3

,

la la 2 de A es A

(2)

=

_

2

3

4 1

_

, la columna 3 de A es A

(3)

=

_

5

1

_

2. B =

_

_

1 4 0

5 12 3

0 2 8

_

_

es una matriz cuadrada real de orden 3, las componentes de la

diagonal principal son a

1,1

= 1, a

2,2

= 12, a

3,3

= 8.

3. La matriz I

n

= (

ij

)

nn

, donde

ij

=

_

1 si i = j

0 si i ,= j

, para cada i, j 1, . . . , n, es llamada

matriz identidad de orden n, esto es,

I

n

=

_

_

1 0 0

0 1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

. 0

0 0 1

_

_

nn

4. La matriz 0

/

mn

= (

ij

)

mn

, donde

ij

= 0 para cada i 1, . . . , m y cada j 1, . . . , n,

es llamada matriz nula de orden mn, es decir

0

/

mn

=

_

_

0 0

.

.

.

.

.

.

0 0

_

_

mn

Matrices y Sistemas de Ecuaciones Lineales 3

Cuando m = n, solo escribiremos 0

/

n

en lugar de 0

/

nn

, es decir,

0

/

n

=

_

_

0 0

.

.

.

.

.

.

.

.

.

0 0

_

_

nn

Denici on 1.2. Sea A M

nn

(R). Diremos que A = (a

ij

)

nn

es

1. Triangular superior si a

ij

= 0 para i, j 1, . . . , n con i > j.

2. Triangular inferior si a

ij

= 0 para i, j 1, . . . , n con i < j.

3. Diagonal si a

ij

= 0 para i, j 1, . . . , n con i ,= j, es decir, A es triangular superior e

inferior simultaneamente.

4. Escalar si es diagonal y existe R tal que a

ii

= para i 1, . . . , n.

Observaci on 1.3. Una matriz cuadrada es triangular superior (respectivamente inferior) si y

solo si todas sus componentes bajo (respectivamente sobre) la diagonal principal son iguales a

cero.

Observaci on 1.4. Cuando A M

nn

(R) es diagonal y las componentes en la diagonal principal

son

1

,

2

, . . . ,

n

R, entonces escribiremos A = diag(

1

,

2

, . . . ,

n

)

Ejemplo 1.2.

1. Para cada n Z

+

, I

n

y 0

/

n

son matrices escalares, y por lo tanto diagonales y consecuente-

mente triangulares superior e inferior.

2. A =

_

_

5 4 0 7

0 3 12 5

0 0 2 1

0 0 0 0

_

_

es triangular superior.

3. A =

_

_

5 0 0 0

0 4 0 0

0 1 0 0

9 13 3 8

_

_

es triangular inferior.

Matrices y Sistemas de Ecuaciones Lineales 4

4. A =

_

_

6 0 0 0

0 3 0 0

0 0 5 0

0 0 0 0

_

_

es diagonal, en cuyo caso podemos escribir A = diag(6, 3, 5, 0).

5. A =

_

_

8 0 0 0

0 8 0 0

0 0 8 0

0 0 0 8

_

_

es escalar, en cuyo caso podemos escribir A = diag(8, 8, 8, 8).

Denici on 1.3. Sean A, B M

mn

(R). Diremos que A y B son matrices iguales, lo cual

denotaremos por A = B, si la componente ij-esima de A es igual a la componente ij-esima de

B para cada i 1, . . . , m y cada j 1, . . . , n, es decir, si A = (a

ij

)

mn

y B = (b

ij

)

mn

,

diremos que A y B son iguales si

a

ij

= b

ij

para cada i 1, . . . , m y cada j 1, . . . , n

Observaci on 1.5. Notese que para que dos matrices sean iguales, en primer lugar deben ser

del mismo orden.

Ejemplo 1.3. Si A =

_

5 1 0

6 8 3

_

; B =

_

_

5 7

0 y

2 4

_

_

y C =

_

_

x 7

0 3

2 4

_

_

, entonces A ,= B

pues ni siquiera son del mismo orden; B = C si y solo si x = 5 e y = 3.

El siguiente teorema es una consecuencia directa de la denicion de igualdad de matrices, su

demostracion la dejamos como ejercicio.

Teorema 1.1. Sean A, B M

mn

(R). Entonces las siguientes proposiciones son equivalentes

1. A = B.

2. A

(i)

= B

(i)

para cada i 1, . . . , m.

3. A

(j)

= B

(j)

para cada j 1, . . . , n.

Demostraci on. Ejercicio!

Matrices y Sistemas de Ecuaciones Lineales 5

1.1.1. Suma de Matrices y Multiplicacion por Escalar

En esta seccion deniremos dos operaciones con matrices que dotaran al conjunto M

mn

(R)

de una estructura algebraica conocida como espacio vectorial , dicha estructura sera tratada

en el cap

tulo 2 del presente trabajo.

Denici on 1.4. Sean A, B M

mn

(R) con A = (a

ij

)

mn

y B = (b

ij

)

mn

. Deniremos la

matriz suma de A con B, como la matriz A+ B M

mn

(R) cuya ij-esima componente viene

dada por a

ij

+ b

ij

para cada i 1, . . . , m y cada j 1, . . . , n, esto es, si A + B = (c

ij

)

mn

,

entonces c

ij

= a

ij

+ b

ij

para cada i 1, . . . , m y cada j 1, . . . , n.

Observaci on 1.6. Para poder sumar dos matrices estas deben ser del mismo orden.

Ejemplo 1.4. Si A =

_

_

4 9 0 8

7 3 5 12

1 0 6 2

_

_

y B =

_

_

3 9 5 4

1 13 3 9

10 4 7 11

_

_

, entonces

A + B =

_

_

4 9 0 8

7 3 5 12

1 0 6 2

_

_

+

_

_

3 9 5 4

1 13 3 9

10 4 7 11

_

_

=

_

_

4 + (3) 9 + 9 0 + 5 8 + (4)

7 + 1 3 + (13) 5 + 3 12 + 9

1 + 10 0 + 4 6 + 7 2 + 11

_

_

=

_

_

1 0 5 4

6 10 8 3

11 4 1 13

_

Denici on 1.5. Sean A M

mn

(R) y R ( es llamado escalar), con A = (a

ij

)

mn

.

Deniremos la multiplicacion de por A ( multiplicacion por escalar) como la matriz

A o simplemente A cuya ij-esima componente es a

ij

para cada i 1, . . . , m y cada

j 1, . . . , n, esto es, si A = (b

ij

)

mn

, entonces b

ij

= a

ij

para cada i 1, . . . , m y cada

j 1, . . . , n.

Observaci on 1.7. La notacion de multiplicacion por escalar es A o A y no A ni A,

se debe colocar primero el escalar luego la matriz.

Observaci on 1.8. Toda matriz escalar de orden n es un m ultiplo escalar de I

n

, ms an, A

M

nn

(R) es una matriz escalar si y solo si existe R tal que A = I

n

.

Matrices y Sistemas de Ecuaciones Lineales 6

Ejemplo 1.5. Sea A la matriz del ejemplo 1.4, entonces

2 A = 2

_

_

4 9 0 8

7 3 5 12

1 0 6 2

_

_

=

_

_

2 4 2(9) 2 0 2 8

2(7) 2 3 2 5 2(12)

2 1 2 0 2(6) 2 2

_

_

=

_

_

8 18 0 16

14 6 10 24

2 0 12 4

_

_

Teorema 1.2. Sean A, B, C M

mn

(R) y , R cualesquiera. Entonces

1. A + B = B + A (conmutatividad de la suma).

2. (A + B) + C = A+ (B + C) (asociatividad de la suma).

3. A + 0

/

mn

= A = 0

/

mn

+A (neutro aditivo).

4. Existe una matriz D M

mn

(R) tal que A+ D = 0

/

mn

= D + A (opuesto aditivo).

5. (A + B) = A + B (distributividad de la multiplicacion por escalar respecto a la suma

matricial).

6. ( + )A = A + A (distributividad de la multiplicacion por escalar respecto a la suma

escalar).

7. (A) = ()A = (A) (asociatividad de la multiplicacion por escalar).

8. 1 A = A (neutro de la multiplicacion por escalar).

Demostraci on. Sean A = (a

ij

)

mn

, B = (b

ij

)

mn

y C = (c

ij

)

mn

.

1. Hagamos A + B = E = (e

ij

)

mn

y B + A = F = (f

ij

)

mn

. Por denicion de suma de

matrices, tenemos que para cada i 1, . . . , m y cada j 1, . . . , n

e

ij

= a

ij

+ b

ij

= b

ij

+ a

ij

= f

ij

Luego A+ B = E = F = B + A (denicion de igualdad de matrices).

Matrices y Sistemas de Ecuaciones Lineales 7

2. Hagamos A + B = E = (e

ij

)

mn

, (A + B) + C = E + C = F = (f

ij

)

mn

, B + C = G =

(g

ij

)

mn

y A + (B + C) = A + G = H = (h

ij

)

mn

. As que por denicion de suma de

matrices

f

ij

= e

ij

+ c

ij

= (a

ij

+ b

ij

) + c

ij

= a

ij

+ (b

ij

+ c

ij

) = a

ij

+ g

ij

= h

ij

De donde (A+ B) + C = F = H = A + (B + C) (denicion de igualdad de matrices).

3. Recordemos que 0

/

mn

= (

ij

)

mn

donde

ij

= 0 para cada i 1, . . . , m y cada j

1, . . . , n. As que si A + 0

/

mn

= E = (e

ij

)

mn

, entonces, por denicion de suma de

matrices, para cada i 1, . . . , m y cada j 1, . . . , n

e

ij

= a

ij

+

ij

= a

ij

+ 0 = a

ij

Por lo tanto A+ 0

/

mn

= E = A y por conmutatividad

A+ 0

/

mn

= A = 0

/

mn

+A

4. Denamos D = (d

ij

)

mn

con d

ij

= a

ij

para cada i 1, . . . , m y cada j 1, . . . , n.

Hagamos A+D = E = (e

ij

)

mn

. Entonces, por denicion de suma de matrices, para cada

i 1, . . . , m y cada j 1, . . . , n

e

ij

= a

ij

+ d

ij

= a

ij

+ (a

ij

) = 0

Por lo tanto A+ D = E = 0

/

mn

y por conmutatividad

A+ D = 0

/

mn

= D + A

5. Hagamos A + B = E = (e

ij

)

mn

, (A + B) = E = F = (f

ij

)

mn

, A = G = (g

ij

)

mn

,

B = H = (h

ij

)

mn

y A + B = G + H = P = (p

ij

)

mn

. Entonces, para cada

i 1, . . . , m y cada j 1, . . . , n tenemos que

f

ij

= e

ij

(denicion de multiplicacion por escalar)

= (a

ij

+ b

ij

) (denicion de suma de matrices)

= a

ij

+ b

ij

= g

ij

+ h

ij

(denicion de multiplicacion por escalar)

= p

ij

(denicion de suma de matrices)

Luego

(A+ B) = F = P = A+ B

Matrices y Sistemas de Ecuaciones Lineales 8

6. Hagamos (+)A = E = (e

ij

)

mn

, A = F = (f

ij

)

mn

, A = G = (g

ij

)

mn

y A+A =

F + G = H = (h

ij

)

mn

. En consecuencia, para cada i 1, . . . , m y cada j 1, . . . , n

se tiene que

e

ij

= ( + )a

ij

(denicion de multiplicacion por escalar)

= a

ij

+ a

ij

= f

ij

+ g

ij

(denicion de multiplicacion por escalar)

= h

ij

(denicion de suma de matrices)

De donde

( + )A = E = H = A+ A

7. Hagamos A = E = (e

ij

)

mn

, (A) = E = F = (f

ij

)

mn

y ()A = G = (g

ij

)

mn

.

As que, por denicion de multiplicacion de por escalar, para cada i 1, . . . , m y cada

j 1, . . . , n obtenemos

f

ij

= e

ij

= (a

ij

) = ()a

ij

= g

ij

Luego (A) = F = G = ()A y en consecuencia

(A) = ()A = ()A

Por lo tanto

(A) = ()A = (A)

8. Hagamos 1 A = E = (e

ij

)

mn

. As que al usar la denicion de multiplicacion por escalar,

se tiene que para cada i 1, . . . , m y cada j 1, . . . , n

e

ij

= 1 a

ij

= a

ij

En consecuencia

1 A = E = A

Teorema 1.3.

1. La matriz nula 0

/

mn

es la unica matriz real de orden mn tal que para cada A M

mn

(R)

se cumple que A+ 0

/

mn

= A = 0

/

mn

+A.

Matrices y Sistemas de Ecuaciones Lineales 9

2. Para cada matriz A M

mn

(R), existe una unica matriz D M

mn

(R) tal que A + D =

0

/

mn

= D + A, tal matriz D es llamada matriz opuesta de A y se denota por A.

Demostraci on. La parte 3 del teorema 1.2 garantiza que la matriz nula 0

/

mn

satisface que para

cada A M

mn

(R) se cumple que A+0

/

mn

= A = 0

/

mn

+A. Ademas, la existencia de la matriz

D es garantizada en la parte 4 del mismo teorema. Solo faltara probar la unicidad de ambas

matrices.

1. Supongamos que P M

mn

(R) es tal que A + P = A = P + A para cada A M

mn

(R),

luego

P = P + 0

/

mn

(por la parte 3 del teorema 1.2)

= 0

/

mn

(hipotesis)

2. Sea A M

mn

(R) cualquiera. Supongamos que existen D, E M

mn

(R) tales que

A + D = 0

/

mn

= D + A (1.1)

A+ E = 0

/

mn

= E + A (1.2)

En consecuencia

D = D + 0

/

mn

(teorema 1.2 parte 3)

= D + (A+ E) (por la ecuacion 1.2)

= (D + A) + E (teorema 1.2 parte 2)

= 0

/

mn

+E (por la ecuacion 1.1)

= E (teorema 1.2 parte 3)

Teorema 1.4. Sean A, B, C M

mn

(R) tales que A+ B = A+ C. Entonces B = C.

Demostraci on. Ejercicio!

Teorema 1.5. Sean A M

mn

(R) y R cualesquiera. Entonces

1. 0 A = 0

/

mn

.

Matrices y Sistemas de Ecuaciones Lineales 10

2. 0

/

mn

= 0

/

mn

.

3. (1)A = A.

4. Si A = 0

/

mn

, entonces = 0 o A = 0

/

mn

.

Demostraci on.

1. Sabemos que

0 A+ 0

/

mn

= 0 A (por que?)

ademas

0 A = (0 + 0)A = 0 A+ 0 A

as que

0 A+ 0 A = 0 A+ 0

/

mn

y por el teorema 1.4, se tiene que 0 A = 0

/

mn

2. Por un lado

0

/

mn

= 0

/

mn

+0

/

mn

(por que?)

por otro lado

0

/

mn

= (0

/

mn

+0

/

mn

) = 0

/

mn

+ 0

/

mn

luego

0

/

mn

+0

/

mn

= 0

/

mn

+ 0

/

mn

y nuevamente, usando el teorema 1.4, tenemos que 0

/

mn

= 0

/

mn

3. Basta probar que A+ (1)A = 0

/

mn

, y por unicidad, obtendramos el resultado. Veamos

A+ (1)A = 1 A+ (1)A (teorema 1.2 parte 8)

= (1 + (1))A (teorema 1.2 parte 6)

= 0 A

= 0

/

mn

(por la parte 1)

Luego, por unicidad de la matriz opuesta, (1)A = A

Matrices y Sistemas de Ecuaciones Lineales 11

4. Supongamos que A = 0

/

mn

. Si = 0, no hay nada que probar, supongamos entonces que

,= 0, as que

A = 1 A (teorema 1.2 parte 8)

= (

1

)A

A =

1

(A) (teorema 1.2 parte 7)

=

1

0

/

mn

(por hipotesis)

= 0

/

mn

(por la parte 2)

Con lo cual, se concluye la prueba.

Denici on 1.6. Sean A, B M

mn

(R). Deniremos AB = A+ (B).

Ejemplo 1.6. Si A =

_

_

4 12 0

6 5 3

6 1 2

7 0 1

_

_

y B =

_

_

5 10 6

6 1 11

4 0 5

2 6 1

_

_

, entonces

AB = A+ (B) =

_

_

4 12 0

6 5 3

6 1 2

7 0 1

_

_

+

_

_

_

_

_

_

_

_

5 10 6

6 1 11

4 0 5

2 6 1

_

_

_

_

_

_

_

_

_

=

_

_

4 12 0

6 5 3

6 1 2

7 0 1

_

_

+

_

_

5 10 6

6 1 11

4 0 5

2 6 1

_

_

=

_

_

1 2 6

12 6 14

2 1 3

9 6 2

_

1.1.2. Producto de Matrices

A diferencia de las dos operaciones denidas en la seccion anterior, la multiplicacion de matrices

no se dene de manera natural, como veremos luego, no por ello deja de ser importante dicha

operacion.

Matrices y Sistemas de Ecuaciones Lineales 12

Denici on 1.7. Sean A = (a

ij

)

mn

M

mn

(R) y B = (b

jk

)

np

M

np

(R). Deniremos el

producto de A por B como la matriz C = (c

ik

)

mp

M

mp

(R), denotada por AB o A B, tal

que para cada i 1, . . . , m y cada k 1, . . . , p se tiene que

c

ik

=

n

j=1

a

ij

b

jk

= a

i1

b

1k

+ a

i2

b

2k

+ + a

in

b

nk

Observaci on 1.9. Notese que para poder denir el producto AB, la cantidad de columnas de

A debe coincidir con la cantidad de las de B, ademas, la matriz resultante, es una matriz cuya

cantidad de las coincide con la cantidad de las de A y su cantidad de columnas es igual a la

cantidad de columnas de B.

Ejemplo 1.7. Sean A =

_

2 1 0

0 3 1

_

y B =

_

_

3 1 0

2 1 2

4 2 3

_

_

. Entonces

AB = A B

=

_

2 3 + (1)2 + 0(4) 2 1 + (1)(1) + 0(2) 2 0 + (1)(2) + 0 3

0 3 + 3 2 + 1(4) 0 1 + 3(1) + 1(2) 0 0 + 3(2) + 1 3

_

=

_

6 2 + 0 2 + 1 + 0 0 + 2 + 0

0 + 6 4 0 3 2 0 6 + 3

_

=

_

4 3 2

2 5 3

_

Observaci on 1.10. Notese que en el ejemplo anterior, el producto BA no esta denido, esto

nos dice que el producto de matrices no es conmutativo, mas a un, a pesar de que ambos productos

estan denidos, AB y BA, no necesariamente son ambos del mismo orden, ademas, siendo ambos

productos del mismo orden, en cuyo caso necesariamente A y B deben ser cuadradas y del mismo

orden, las matrices AB y BA no tienen por que ser iguales, cuando esto ocurre, es decir, cuando

AB = BA, se dice que A y B son matrices que conmutan.

A continuacion enunciaremos un teorema que expone las principales propiedades del producto

de matrices

Teorema 1.6. Sean A M

mn

(R); B, C M

np

(R); C M

pq

(R) y R. Entonces

1. (AB)D = A(BD) (asociatividad del producto de matrices).

2. A(B + C) = AB + AC (distributividad a izquierda del producto de matrices).

Matrices y Sistemas de Ecuaciones Lineales 13

3. (B + C)D = BD + CD (distributividad a derecha del producto de matrices).

4. (AB) = (A)B = A(B) (asociatividad del producto de matrices y la multiplicaci on por

escalar).

5. I

m

A = A = AI

n

(neutros del producto de matrices).

6. B0

/

pq

= 0

/

nq

y 0

/

mn

B = 0

/

mp

.

Demostraci on. Sean A = (a

ij

)

mn

; B = (b

jk

)

np

; C = (c

jk

)

np

y D = (d

kl

)

pq

.

1. Hagamos AB = E = (e

ik

)

mp

; (AB)D = ED = F = (f

il

)

mq

; BD = G = (g

jl

)

nq

y

A(BD) = AG = H = (h

il

)

mq

. Entonces, usando la denicion de producto matricial, para

cada i 1, . . . , m y cada k 1, . . . , p

e

ik

=

n

j=1

a

ij

b

jk

para cada j 1, . . . , n y cada l 1, . . . , q

g

jl

=

p

k=1

b

jk

d

kl

y para cada i 1, . . . , m y cada l 1, . . . , q

f

il

=

p

k=1

e

ik

d

kl

; h

il

=

n

j=1

a

ij

g

jl

Luego

f

il

=

p

k=1

e

ik

d

kl

=

p

k=1

_

n

j=1

a

ij

b

jk

_

d

kl

=

p

k=1

n

j=1

a

ij

b

jk

d

kl

=

n

j=1

p

k=1

a

ij

b

jk

d

kl

=

n

j=1

a

ij

_

p

k=1

b

jk

d

kl

_

=

n

j=1

a

ij

g

jl

= h

il

Por lo tanto, usando la denicion de igualdad de matrices

(AB)D = F = H = A(BD)

Matrices y Sistemas de Ecuaciones Lineales 14

2. Hagamos B + C = E = (e

jk

)

np

; A(B + C) = AE = F = (f

ik

)

mp

; AB = G = (g

ik

)

mp

;

AC = H = (h

ik

)

mp

y AB + AC = G + H = R = (r

ik

)

mp

. Entonces, para cada i

1, . . . , m y cada k 1, . . . , p

f

ik

=

n

j=1

a

ij

e

jk

(denicion de producto de matrices)

=

n

j=1

a

ij

(b

jk

+ c

jk

) (denicion de suma de matrices)

=

n

j=1

(a

ij

b

jk

+ a

ij

c

jk

) =

n

j=1

a

ij

b

jk

+

n

j=1

a

ij

c

jk

= g

ik

+ h

ik

(denicion de producto de matrices)

= r

ik

(denicion de suma de matrices)

En consecuencia

A(B + C) = F = R = AB + AC

3. Analogo a la demostracion de la parte 2.

4. Sean AB = E = (e

ik

)

mp

; (AB) = E = F = (f

ik

)

mp

; A = G = (g

ij

)

mn

y (A)B =

GB = H = (h

ik

)

mp

. Entonces, para cada i 1, . . . , m y cada k 1, . . . , p

f

ik

= e

ik

(denicion de multiplicacion por escalar)

=

n

j=1

a

ij

b

jk

(denicion de producto de matrices)

=

n

j=1

(a

ij

b

jk

) =

n

j=1

(a

ij

)b

jk

=

n

j=1

g

ij

b

jk

(denicion de multiplicacion por escalar)

= h

ik

(denicion de producto de matrices)

De donde (AB) = F = H = (A)B. De manera analoga se prueba que (AB) = A(B),

as que

(AB) = (A)B = A(B)

5. Recordemos que I

n

= (

jk

)

nn

, donde

jk

=

_

1 si j = k

0 si j ,= k

(1.3)

Matrices y Sistemas de Ecuaciones Lineales 15

para cada j, k 1, . . . , n.

Hagamos AI

n

= E = (e

ik

)

mn

. Entonces, para cada i 1, . . . , m y cada k 1, . . . , n

e

ik

=

n

j=1

a

ij

jk

(denicion de producto de matrices)

= a

i1

1k

+ + a

i(k1)

(k1)k

+ a

ik

kk

+ a

i(k+1)

(k+1)k

+ + a

in

nk

= a

i1

0 + + a

i(k1)

0 + a

ik

1 + a

i(k+1)

0 + + a

in

0 (por 1.3)

= a

ik

Por lo tanto AI

n

= E = A, analogamente puede probarse que I

m

A = A, en consecuencia

AI

n

= A = I

m

A

6. Ejercicio!

Ejercicio 1.1. Pruebe que si A M

mn

(R) y B M

np

(R), entonces

1. AB =

_

AB

(1)

AB

(2)

AB

(p)

_

(desarrollo por columnas del producto AB), es decir,

la k-esima columna de AB, que es (AB)

(k)

, es igual a A por la k-esima columna de B,

AB

(k)

, para cada k 1, . . . , p.

2. AB =

_

_

A

(1)

B

A

(2)

B

.

.

.

A

(m)

B

_

_

(desarrollo por las del producto AB), es decir, la i-esima la de AB,

que es (AB)

(i)

, es igual a la i-esima la de A por B, A

(i)

B, para cada i 1, . . . , m.

Ejercicio 1.2. Dada una matriz A M

nn

(R), para k N denamos

A

k

=

_

_

0

/

n

si A = 0

/

n

y k 1

I

n

si A ,= 0

/

n

y k = 0

A

k1

A si A ,= 0

/

n

y k 1

Pruebe que A

k

A

r

= A

k+r

para cualesquiera k, r N.

Denici on 1.8. Una matriz N M

nn

(R) es llamada nilpotente si existe p N tal que

N

p

= 0

/

n

, ademas, si p es tal que N

p1

,= 0

/

n

, diremos que N es nilpotente de orden p.

Matrices y Sistemas de Ecuaciones Lineales 16

Observaci on 1.11. La matriz nula de orden n es nilpotente y conveninos en que es nilpotente

de orden 0.

Ejemplo 1.8. Las siguientes matrices son nilpotentes

N

1

=

_

_

1 1 0 0

1 0 1 0

1 0 1 0

1 0 1 0

_

_

; N

2

=

_

_

0 1 0 0

0 0 1 0

0 0 0 1

0 0 0 0

_

_

N

1

es de orden 3 y N

2

es de orden 4 (verifquelo!).

1.1.3. Transposicion o Trasposicion de Matrices

Denici on 1.9. Sea A = (a

ij

)

mn

M

mn

(R). Deniremos la transpuesta o traspuesta de

A como la matriz A

T

= (b

ji

)

nm

M

nm

(R) tal que

b

ji

= a

ij

para cada i 1, . . . , m y cada j 1, . . . , n

Ejemplo 1.9. Sea

A =

_

_

2 5 0 7

3 0 1 6

5 12 2 9

_

_

Entonces

A

T

=

_

_

2 3 5

5 0 12

0 1 2

7 6 9

_

Observaci on 1.12. Notese que las las de A pasan a ser las columnas de A

T

y las columnas

de A pasan a ser las las de A

T

, mas propiamente

_

A

(i)

_

T

=

_

A

T

_

(i)

para cada i 1, . . . , m

_

A

(j)

_

T

=

_

A

T

_

(j)

para cada j 1, . . . , n

Teorema 1.7. Sean A, B M

mn

(R), C M

np

(R) y R. Entonces

Matrices y Sistemas de Ecuaciones Lineales 17

1.

_

A

T

_

T

= A (propiedad de involucion de la transposicion de matrices)

2. (A + B)

T

= A

T

+ B

T

(transpuesta de la suma)

3. (A)

T

= A

T

(transpuesta de la multiplicacion por escalar)

4. (AC)

T

= C

T

A

T

(transpuesta del producto matricial)

5. (I

n

)

T

= I

n

y (0

/

mn

)

T

= 0

/

nm

Demostraci on. Sean A = (a

ij

)

mn

; B = (b

ij

)

mn

y C = (c

jk

)

np

.

1. Hagamos A

T

= D = (d

ji

)

nm

y

_

A

T

_

T

= D

T

= E = (e

ij

)

mn

. Entonces, para cada

i 1, . . . , m y cada j 1, . . . , n, por denicion de transpuesta

e

ij

= d

ji

= a

ij

Luego

_

A

T

_

T

= E = A

2. Sean A + B = D = (d

ij

)

mn

; (A + B)

T

= D

T

= E = (e

ji

)

nm

; A

T

= F = (f

ji

)

nm

;

B

T

= G = (g

ji

)

nm

y A

T

+B

T

= F+G = H = (h

ji

)

nm

. Entonces, para cada i 1, . . . , m

y cada j 1, . . . , n

e

ji

= d

ij

(denicion de transpuesta)

= a

ij

+ b

ij

(denicion de suma de matrices)

= f

ji

+ g

ji

(denicion de transpuesta)

= h

ji

(denicion de suma de matrices)

Por lo tanto

(A+ B)

T

= E = H = A

T

+ B

T

3. Hagamos A = D = (d

ij

)

mn

; (A)

T

= D

T

= E = (e

ji

)

nm

; A

T

= F = (f

ji

)

nm

; y

A

T

= F = G = (g

ji

)

nm

. Entonces, para cada i 1, . . . , m y cada j 1, . . . , n

e

ji

= d

ij

(denicion de transpuesta)

= a

ij

(denicion de multiplicacion por escalar)

= f

ji

(denicion de transpuesta)

= g

ji

(denicion de multiplicacion por escalar)

Matrices y Sistemas de Ecuaciones Lineales 18

As que

(A)

T

= E = G = A

T

4. Sean AC = D = (d

ik

)

mp

; (AC)

T

= D

T

= E = (e

ki

)

pm

; C

T

= F = (f

kj

)

pn

; A

T

=

G = (g

ji

)

nm

y C

T

A

T

= FG = H = (h

ki

)

pm

. Entonces, para cada i 1, . . . , m y cada

k 1, . . . , p

e

ki

= d

ik

(denicion de transpuesta)

=

n

j=1

a

ij

c

jk

(denicion de producto)

=

n

j=1

g

ji

f

kj

(denicion de transpuesta)

=

n

j=1

f

kj

g

ji

= h

ki

(denicion de producto)

De donde

(AC)

T

= E = H = C

T

A

T

5. Ejercicio!

Denici on 1.10. Sea A M

nn

(R). Diremos que

1. A es simetrica si A

T

= A.

2. A es antisimetrica si A

T

= A.

Ejemplo 1.10.

1. I

n

es simetrica para todo n N.

2. 0

/

n

es simetrica y antisimetrica para todo n N existe alguna otra matriz que sea simetrica

y antisimetrica simultaneamente?

3. La matriz

A =

_

_

0 5 7 6

5 0 4 8

7 4 0 12

6 8 12 0

_

_

Matrices y Sistemas de Ecuaciones Lineales 19

es antisimetrica pues

A

T

=

_

_

0 5 7 6

5 0 4 8

7 4 0 12

6 8 12 0

_

_

= A

4. La matriz

A =

_

_

5 9 3 0

9 2 1 13

3 1 0 7

0 13 7 3

_

_

es simetrica ya que

A

T

=

_

_

5 9 3 0

9 2 1 13

3 1 0 7

0 13 7 3

_

_

= A

Teorema 1.8. Sea A M

nn

(R). Entonces

1. A es simetrica si y solo si a

ij

= a

ji

para cualesquiera i, j 1, . . . , n.

2. A es antisimetrica si y solo si a

ij

= a

ji

para cualesquiera i, j 1, . . . , n.

3. Si A es antisimetrica, entonces a

ii

= 0 para cualquiera i 1, . . . , n.

Demostraci on. Ejercicio!

1.2. Operaciones Elementales por Filas

Las operaciones elementales por las son herramientas usadas con mucha frecuencia en

la resolucion de los sistemas de ecuaciones lineales al igual que en calculo de la inversa

de una matriz cuadrada. Estas operaciones las usaremos a lo largo de todo el curso, por ello

deben ser manejadas con la mayor perfeccion posible por parte del estudiante que desee aprender

la materia. Comencemos por denir dichas operaciones.

Denotemos por F

m

(R) el conjunto formado por todas las matrices reales con m las.

Matrices y Sistemas de Ecuaciones Lineales 20

Denici on 1.11. Una operacion elemental por las (OEF) es una funcion f : F

m

(R)

F

m

(R) la cual es de uno de los siguientes tipos

OEF Tipo 1. Si f(A) = B, entonces existen s 1, . . . , m y ,= 0 tales que B

(i)

= A

(i)

para cada i 1, . . . , m, con i ,= s, y ademas B

(s)

= A

(s)

, esto es, una de las las

de A es multiplicada por un escalar no nulo y el resto de las las permanecen iguales.

f(A) = f

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

A

(1)

.

.

.

A

(s1)

A

(s)

A

(s+1)

.

.

.

A

(m)

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

=

_

_

A

(1)

.

.

.

A

(s1)

A

(s)

A

(s+1)

.

.

.

A

(m)

_

_

= B

Por comodidad, en lugar de escribir B = f(A), escribiremos A

Fs Fs

B.

OEF Tipo 2. Si f(A) = B, entonces existen s, t 1, . . . , m, con s ,= t, y R tales

que B

(i)

= A

(i)

para cada i 1, . . . , m, con i ,= s, y ademas B

(s)

= A

(s)

+ A

(t)

,

es decir, a una la de A le sumamos un m ultiplo escalar de alguna otra la de A,

distinta de la primera, dejando el resto de las las intactas.

f(A) = f

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

A

(1)

.

.

.

A

(s1)

A

(s)

A

(s+1)

.

.

.

A

(m)

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

=

_

_

A

(1)

.

.

.

A

(s1)

A

(s)

+ A

(t)

A

(s+1)

.

.

.

A

(m)

_

_

= B

Al igual que antes, en lugar de escribir B = f(A), escribiremos A

Fs Fs + Ft

B.

OEF Tipo 3. Si f(A) = B, entonces existen s, t 1, . . . , m tales que B

(i)

= A

(i)

para

cada i 1, . . . , m, con i ,= s e i ,= t y ademas B

(s)

= A

(t)

y B

(t)

= A

(s)

, dicho de

otra manera, intercambiamos dos las de A y dejamos el resto sin alterar.

Matrices y Sistemas de Ecuaciones Lineales 21

f(A) = f

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

A

(1)

.

.

.

A

(s1)

A

(s)

A

(s+1)

.

.

.

A

(t1)

A

(t)

A

(t+1)

.

.

.

A

(m)

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

=

_

_

A

(1)

.

.

.

A

(s1)

A

(t)

A

(s+1)

.

.

.

A

(t1)

A

(s)

A

(t+1)

.

.

.

A

(m)

_

_

= B

Nuevamente, en lugar de escribir B = f(A), escribiremos A

Fs Ft

B.

Observaci on 1.13. Notese que si A M

mn

(R) y f : F

m

(R) F

m

(R) es una OEF, entonces

f(A) M

mn

(R).

Ejercicio 1.3. Pruebe que toda OEF f : F

m

(R) F

m

(R) es una funcion invertible y que su

inversa f

1

: F

m

(R) F

m

(R) es tambien una OEF del mismo tipo que f.

Ejemplo 1.11. Sea

A =

_

_

2 4 5

6 3 4

2 1 8

6 21 15

_

_

Entonces

A =

_

_

2 4 5

6 3 4

2 1 8

6 21 15

_

_

F

1

F

3

(OEF 3)

_

_

2 1 8

6 3 4

2 4 5

6 21 15

_

_

F

4

1

3

F

4

(OEF 1)

_

_

2 1 8

6 3 4

2 4 5

2 7 5

_

_

F

3

F

3

+ F

1

(OEF 2)

_

_

2 1 8

6 3 4

0 3 3

2 7 5

_

_

= B

Matrices y Sistemas de Ecuaciones Lineales 22

Observaci on 1.14. Se pueden aplicar mas de dos operaciones por las en un solo paso, lo unico

que debemos cuidar es no transformar, en el mismo paso, una la mas de una vez y no

transformar, en el mismo paso, una la que va ser usada para transformar a otra(s).

Observaci on 1.15. De manera analoga a como se denieron las operaciones elementales por

las, pueden denirse operaciones elementales por columnas (OEC), sin embargo, estas

ultimas solo se usaran para el calculo de determinantes y no para la resolucion de sistemas

de ecuaciones lineales ni para hallar la inversa de una matriz cuadrada, en estos ultimos dos

problemas solo usaremos las operaciones elementales por las.

Denici on 1.12. Sea A = (a

ij

)

mn

M

mn

(R). Diremos que A es una matriz

Escalonada

1. Si todas las las nulas de A, si las hay, estan ubicadas en las ultimas posiciones,

esto es, si A

(i)

es una la no nula de A, entonces A

(s)

tambien es no nula para cada

1 s < i.

2. Si A

(i)

y A

(i+1)

son dos las no nulas de A, entonces la primera componente no nula de

A

(i)

(contada de izquierda a derecha) esta mas a la izquierda de la primera componente

no nula de A

(i+1)

, es decir, si j, k 1, . . . , n son tales que a

ij

,= 0; a

(i+1)k

,= 0 y

a

is

= 0 = a

(i+1)t

para cada 1 s < j y cada 1 t < k, entonces j < k.

Reducida por Filas (RF)

1. Si A

(i)

es una la no nula de A, entonces la primera componente no nula de A

(i)

es

igual a 1 (uno), dicha componente es llamada pivote, es decir, si j 1, . . . , n es

tal que a

ij

,= 0 y a

is

= 0 para cada 1 s < j, entonces a

ij

= 1.

2. Si A

(j)

es una columna de A que tiene un pivote, entonces el resto de las componentes

de A

(j)

son iguales a 0 (cero), esto es, si i 1, . . . , m es tal que a

ij

= 1 y a

is

= 0

para cada 1 s < j, entonces a

kj

= 0 para cada k 1, . . . , m con k ,= i.

Escalonada Reducida por Filas (ERF) si es escalonada y reducida por las simultanea-

mente.

Ejemplo 1.12.

Matrices y Sistemas de Ecuaciones Lineales 23

1. Para cualesquiera m, n Z

+

, I

n

y 0

/

mn

son matrices escalonadas reducidas por las.

2. E =

_

_

2 1 3 8 3

0 5 1 6 4

0 0 0 8 7

0 0 0 0 0

_

_

es escalonada pero no es reducida por las.

3. R =

_

_

1 0 0 7

0 0 0 0

0 0 1 9

0 0 0 6

0 1 0 1

_

_

es reducida por las pero no es escalonada.

4. F =

_

_

1 0 5 0 8

0 1 3 0 1

0 0 0 1 2

0 0 0 0 0

0 0 0 0 0

_

_

es escalonada reducida por las.

Ejercicio 1.4. Sea A M

mn

(R). Pruebe que:

1. Si A es una matriz escalonada, entonces la cantidad de las no nulas de A es, a lo sumo,

el mnimo entre m y n.

2. Si A es una matriz RF, entonces la cantidad de pivotes de A es, a lo sumo, el mnimo entre

m y n.

Ejercicio 1.5. Pruebe que si A M

nn

(R) es una matriz escalonada, entonces A es triangular

superior.

Denici on 1.13. Sean A, B M

mn

(R). Diremos que B es equivalente por las a A si

existen OEF f

1

, f

2

, . . . , f

r

: F

m

(R) F

m

(R) tales que B = (f

1

f

2

f

r

)(A)

Ejemplo 1.13. Consideremos las matrices A y B del ejemplo 1.11. Entonces B es equivalente

por las a A (por que?).

Teorema 1.9. Sean A, B, C M

mn

(R). Tenemos que

Matrices y Sistemas de Ecuaciones Lineales 24

1. A es equivalente por las a A.

2. Si B es equivalente por las a A, entonces A es equivalente por las a B.

3. Si C es equivalente por las a B y B es equivalente por las a A, entonces C es equivalente

por las a A.

Demostraci on. Ejercicio!

Observaci on 1.16. La parte 2 del teorema 1.9, nos permite decir A y B son equivalentes por

las en lugar de B es equivalente por las a A o A es equivalente por las a B.

Teorema 1.10. Toda matriz A M

mn

(R) es equivalente por las a

1. Una matriz escalonada.

2. Una matriz reducida por las.

3. Una unica matriz escalonada reducida por las, la cual llamaremos la forma escalonada

reducida por las (FERF) de A.

Demostraci on. Ver apendice D

Observaci on 1.17. A M

nn

(R) es equivalente por las a I

n

si y solo si I

n

es la FERF de A.

El siguiente ejemplo ilustra el procedimiento a seguir para hallar la FERF de una matriz.

Ejemplo 1.14. Hallar la FERF de

A =

_

_

6 1 15 2 13

1 0 2 1 3

0 3 9 0 9

7 1 11 3 10

_

_

Soluci on.

A =

_

_

6 1 15 2 13

1 0 2 1 3

0 3 9 0 9

7 1 11 3 10

_

_

F

1

F

2

_

1 0 2 1 3

6 1 15 2 13

0 3 9 0 9

7 1 11 3 10

_

_

Matrices y Sistemas de Ecuaciones Lineales 25

F

1

F

1

_

1 0 2 1 3

6 1 15 2 13

0 3 9 0 9

7 1 11 3 10

_

_

F

2

F

2

6F

1

F

4

F

4

7F

1

_

_

1 0 2 1 3

0 1 3 4 5

0 3 9 0 9

0 1 3 4 11

_

_

F

2

F

2

_

1 0 2 1 3

0 1 3 4 5

0 3 9 0 9

0 1 3 4 11

_

_

F

3

F

3

+ 3F

2

F

4

F

4

F

2

_

_

1 0 2 1 3

0 1 3 4 5

0 0 0 12 24

0 0 0 8 16

_

_

F

3

1

12

F

3

_

1 0 2 1 3

0 1 3 4 5

0 0 0 1 2

0 0 0 8 16

_

_

F

1

F

1

F

3

F

2

F

2

4F

3

F

4

F

4

+ 8F

3

_

_

1 0 2 0 1

0 1 3 0 3

0 0 0 1 2

0 0 0 0 0

_

_

As que la FERF de A es

C =

_

_

1 0 2 0 1

0 1 3 0 3

0 0 0 1 2

0 0 0 0 0

_

_

Denici on 1.14. Una matriz E M

nn

(R) es llamada matriz elemental si existe una OEF

f : F

n

(R) F

n

(R) tal que E = f(I

n

), es decir, E se obtiene de I

n

por medio de una unica OEF.

Ejemplo 1.15.

1. E

1

=

_

_

1 0 0 0

0 1 0 0

5 0 1 0

0 0 0 1

_

_

es elemental, pues

I

4

=

_

_

1 0 0 0

0 1 0 0

0 0 1 0

0 0 0 1

_

_

F

3

F

3

5F

1

_

1 0 0 0

0 1 0 0

5 0 1 0

0 0 0 1

_

_

= E

1

Matrices y Sistemas de Ecuaciones Lineales 26

2. E

2

=

_

_

1 0 0

0 4 0

0 0 1

_

_

es elemental, ya que

I

3

=

_

_

1 0 0

0 1 0

0 0 1

_

_

F

2

4F

2

_

1 0 0

0 4 0

0 0 1

_

_

= E

2

3. E

3

=

_

_

1 0 0 0 0

0 0 0 0 1

0 0 1 0 0

0 0 0 1 0

0 1 0 0 0

_

_

es elemental, dado que

I

5

=

_

_

1 0 0 0 0

0 1 0 0 0

0 0 1 0 0

0 0 0 1 0

0 0 0 0 1

_

_

F

2

F

5

_

1 0 0 0 0

0 0 0 0 1

0 0 1 0 0

0 0 0 1 0

0 1 0 0 0

_

_

= E

3

Teorema 1.11. Sean A M

mn

(R), B M

np

(R) y f : F

m

(R) F

m

(R) una OEF. Entonces

1. f(AB) = f(A)B.

2. (f(A))

(j)

= f

_

A

(j)

_

para cada j 1, . . . , n de donde

f(A) =

_

f

_

A

(1)

_

f

_

A

(2)

_

f

_

A

(n)

_

es decir, la la j-esima de f(A) es igual a f aplicada a la j-esima la de A.

Demostraci on. Ver apendice D.

Como una consecuencia directa de este teorema tenemos el siguiente resultado.

Corolario 1.12. Si A M

mn

(R), B M

np

(R) y f, f

1

, f

2

, . . . , f

r

: F

m

(R) F

m

(R) son OEF,

entonces

Matrices y Sistemas de Ecuaciones Lineales 27

1. f(A) = f(I

m

)A.

2. (f

1

f

2

f

r

)(AB) = (f

1

f

2

f

r

)(A)B.

3. ((f

1

f

2

f

r

)(A))

(j)

= (f

1

f

2

f

r

)

_

A

(j)

_

para cada j 1, . . . , m.

Demostraci on. Ejercicio!

Otra consecuencia del mismo teorema, en conjuncion con el corolario anterior, es la siguiente.

Corolario 1.13. Sean A, B M

mn

(R) dos matrices equivalentes por las. Entonces existen

matrices elementales E

1

, E

2

, . . . , E

r

M

mm

(R) tales que B = E

1

E

2

E

r

A

Demostraci on. Ejercicio!

1.3. Sistemas de Ecuaciones Lineales

La presente seccion esta muy relacionada con las OEF y las matrices, y es quizas, junto con la

seccion anterior, la mas importante del presente captulo.

Denici on 1.15. Un sistema de ecuaciones lineales con m ecuaciones y n incognitas es

un conjunto de ecuaciones de la forma

_

_

a

11

x

1

+ a

12

x

2

+ + a

1n

x

n

= b

1

a

21

x

1

+ a

22

x

2

+ + a

2n

x

n

= b

2

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

a

m1

x

1

+ a

m2

x

2

+ + a

mn

x

n

= b

m

(1.4)

donde x

1

, x

2

, . . . , x

n

son las incognitas del sistema 1.4 y toman valores en R; a

ij

R son

n umeros jos para cada i 1, . . . , m y cada j 1, . . . , n y los llamaremos coecientes del

sistema 1.4 y b

1

, b

2

, . . . , b

m

R son jos y son los terminos independientes del sistema 1.4.

Si b

1

= b

2

= = b

m

= 0, diremos que el sistema 1.4 es homogeneo, en caso contrario

diremos que es no homogeneo.

Cuando m = n, se dice que el sistema 1.4 es un sistema cuadrado.

Matrices y Sistemas de Ecuaciones Lineales 28

Si hacemos

A = (a

ij

)

mn

=

_

_

a

11

a

12

a

1n

a

21

a

22

a

2n

.

.

.

.

.

.

.

.

.

a

m1

a

m2

a

mn

_

_

; b =

_

_

b

1

b

2

.

.

.

b

m

_

_

y x =

_

_

x

1

x

2

.

.

.

x

n

_

_

,

el sistema 1.4 puede escribirse como la ecuacion matricial Ax = b (verifquelo!), que llamare-

mos representacion matricial del sistema 1.4. La matriz A es llamada matriz de coe-

cientes o matriz del sistema 1.4, la matriz

[A[b] =

_

_

a

11

a

12

a

1n

b

1

a

21

a

22

a

2n

b

2

.

.

.

.

.

.

.

.

.

.

.

.

a

m1

a

m2

a

mn

b

m

_

_

es llamada matriz ampliada del sistema 1.4, x se conoce con el nombre de matriz incognita

o matriz de incognitas y b es conocida como matriz de terminos independientes.

El sistema

_

_

a

11

x

1

+ a

12

x

2

+ + a

1n

x

n

= 0

a

21

x

1

+ a

22

x

2

+ + a

2n

x

n

= 0

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

a

m1

x

1

+ a

m2

x

2

+ + a

mn

x

n

= 0

(1.5)

es llamado sistema homogeneo asociado al sistema 1.4.

Diremos que c

1

, c

2

, . . . , c

n

es una solucion del sistema 1.4 si al sustituir x

1

= c

1

, x

2

=

c

2

, . . . , x

n

= c

n

en 1.4, las igualdades son satisfechas.

Se dice que el sistema 1.4 es

Inconsistente si no tiene solucion alguna.

Consistente si tiene al menos una solucion, cuando tiene una unica solucion, se dice que

es consistente determinado, si tiene mas de una solucion, se dice que es consistente

indeterminado.

Observaci on 1.18. En general, no haremos diferencia al referirnos al sistema y a su repre-

sentacion matricial.

Matrices y Sistemas de Ecuaciones Lineales 29

Observaci on 1.19. Todo sistema homogeneo Ax = 0

/

m1

es consistente, x = 0

/

n1

es solucion

de este, la cual es llamada solucion trivial.

Observaci on 1.20. Es claro si A M

mn

(R) y x =

_

_

x

1

x

2

.

.

.

x

n

_

_

M

n1

(R), entonces

Ax = x

1

A

(1)

+ x

2

A

(2)

+ + x

n

A

(n)

Ejemplo 1.16.

1.

_

3x

1

+2x

2

6x

3

= 0

x

1

+5x

2

7x

3

= 4

es un sistema de ecuaciones lineales de dos ecuaciones y tres incognitas, es no homogeneo,

su representacion matricial es

_

3 2 6

1 5 7

_

_

_

x

1

x

2

x

3

_

_

=

_

0

4

_

La matriz es y la matriz ampliada del sistema son, respectivamente

_

3 2 6

1 5 7

_

y

_

3 2 6 0

1 5 7 4

_

las matrices incognitas y de terminos independientes son, respectivamente

_

_

x

1

x

2

x

3

_

_

y

_

0

4

_

2.

_

_

6x 2y +9z = 1

5x +12y 3z = 2

x 6z = 6

es un sistema de ecuaciones lineales cuadrado con tres ecuaciones y tres incognitas, es no

homogeneo y su representacion matricial es

Matrices y Sistemas de Ecuaciones Lineales 30

_

_

6 2 9

5 12 3

1 0 6

_

_

_

_

x

y

z

_

_

=

_

_

1

2

6

_

_

El sistema homogeneo asociado a este sistema es

_

_

6x 2y +9z = 0

5x +12y 3z = 0

x 6z = 0

Una pregunta que surge de manera inmediata es como garantizar que un sistema de ecuaciones

lineales es consistente o inconsistente? y en caso de que sea consistente como resolver dicho

sistema? Haremos uso de las matrices y las OEF para responder ambas preguntas, pero antes

daremos las bases teoricas que nos permitan usar dichas herramientas.

Teorema 1.14. Sean Ax = b y Cx = d las representaciones matriciales de dos sistemas de

ecuaciones lineales con m ecuaciones y n incognitas. Supongamos que las matrices [A[b] y [C[d]

son equivalentes por las. Entonces ambos sistemas tienen exactamente las mismas soluciones o

ninguno tiene soluci on.

Demostraci on. Dado que las matrices [A[b] y [C[d] son equivalentes por las, entonces existen

OEF f

1

, f

2

, . . . , f

r

: F

m

(R) F

m

(R) tales que

(f

1

f

2

f

r

)([A[b]) = [C[d]

por la parte 3 del corolario 1.12

(f

1

f

2

f

r

)(A) = C y (f

1

f

2

f

r

)(b) = d

y por la parte 2 del mismo corolario, tenemos que

(f

1

f

2

f

r

)(Ax) = (f

1

f

2

f

r

)(A)x

As que, si Ax = b, entonces

Cx = (f

1

f

2

f

r

)(A)x = (f

1

f

2

f

r

)(Ax) = (f

1

f

2

f

r

)(b) = d

Matrices y Sistemas de Ecuaciones Lineales 31

Ademas, en virtud del ejercicio 1.3, f

1

, f

2

, . . . , f

r

son invertibles y f

1

1

, f

1

2

, . . . , f

1

r

son tambien

OEF sobre F

m

(R), luego, si Cx = d, entonces

Ax = (f

1

f

2

f

r

)

1

(C)x = (f

1

r

f

1

2

f

1

1

)(C)x

= (f

1

r

f

1

2

f

1

1

)(Cx) = (f

1

r

f

1

2

f

1

1

)(d) = (f

1

f

2

f

r

)

1

(d) = b

Por lo tanto Ax = b si y solo si Cx = d, en consecuencia, o ambos sistemas son inconsistentes o

ambos tienen la(s) misma(s) solucion(es).

Observaci on 1.21. Cuando la matriz del sistema es una matriz ERF, es facil decidir si el

sistema es o no consistente, y en caso de serlo, es sencillo hallar la(s) solucion(es) de este. La

idea es hallar la FERF de la matriz ampliada del sistema, y en virtud del teorema 1.14, resolver,

de manera sencilla, el sistema dado.

Corolario 1.15. Sean A, C M

mn

(R) y b, d M

m1

(R) tales que [C[d] es la FERF de [A[b].

El sistema Ax = b tiene solucion si y solo si el n umero de las no nulas de [C[d] es igual al

n umero de las no nulas de C.

Demostraci on. Ejercicio!

Ejemplo 1.17. Decidir cual de los siguientes sistemas son consistentes y cuales no, en caso de

serlo, mostrar su(s) soluci on(es).

1.

_

_

2x +y z = 1

2x y +5z = 5

y +3z = 2

2.

_

_

2x +y z = 2

x 2y +4z = 3

5x 4y +8z = 9

y +3z = 2

3.

_

_

x +y 2z +w = 1

4x +2y +2z = 2

2y 10z +3w = 3

Matrices y Sistemas de Ecuaciones Lineales 32

4.

_

_

x +y 2z +w = 1

4x +2y +2z = 2

2y 10z +4w = 3

Soluci on.

1. La matriz ampliada del sistema es

_

_

2 1 1 1

2 1 5 5

0 1 3 2

_

_

Hallemos su FERF

_

_

2 1 1 1

2 1 5 5

0 1 3 2

_

_

F

1

1

2

F

1

_

1

1

2

1

2

1

2

2 1 5 5

0 1 3 2

_

_

F

2

F

2

2F

1

_

1

1

2

1

2

1

2

0 2 6 4

0 1 3 2

_

_

F

1

1

2

F

1

_

1

1

2

1

2

1

2

0 1 3 2

0 1 3 2

_

_

F

1

F

1

1

2

F

2

F

3

F

3

+ F

2

_

_

1 0 1

3

2

0 1 3 2

0 0 0 0

_

_

La ultima la de esta ultima matriz equivale a la ecuacion 0 x + 0 y + 0 z = 0, que no

aporta nada a la solucion. As que el sistema dado es equivalente al sistema

_

x +z =

3

2

y 3z = 2

que a su vez equivale a

_

x = z +

3

2

y = 3z 2

Luego el sistema dado es consistente indeterminado. Haciendo z = , con R, obtenemos

x = +

3

2

; y = 3 2

En consecuencia la solucion del sistema dado viene dada por

x = +

3

2

; y = 3 2; z = ; con R

Matrices y Sistemas de Ecuaciones Lineales 33

o bien

_

_

x

y

z

_

_

=

_

_

+

3

2

3 2

_

=

_

_

1

3

1

_

_

+

_

_

3

2

2

0

_

_

; con R

2. En este caso la matriz del sistema es

_

_

2 1 1 2

1 2 4 3

5 4 8 9

0 1 3 2

_

_

Vamos a hallar su FERF

_

_

2 1 1 2

1 2 4 3

5 4 8 9

0 1 3 2

_

_

F

1

F

2

_

1 2 4 3

2 1 1 2

5 4 8 9

0 1 3 2

_

_

F

2

F

2

2F

1

F

3

F

3

5F

1

_

_

1 2 4 3

0 5 9 8

0 6 12 6

0 1 3 2

_

_

F

2

F

4

_

1 2 4 3

0 1 3 2

0 6 12 6

0 5 9 8

_

_

F

2

F

2

_

1 2 4 3

0 1 3 2

0 6 12 6

0 5 9 8

_

_

F

1

F

1

+ 2F

2

F

3

F

3

6F

2

F

4

F

4

5F

2

_

_

1 0 2 7

0 1 3 2

0 0 6 18

0 0 6 18

_

_

F

3

1

6

F

3

_

1 0 2 7

0 1 3 2

0 0 1 3

0 0 6 18

_

_

F

1

F

1

+ 2F

3

F

2

F

2

+ 3F

3

F

4

F

4

6F

3

_

_

1 0 0 1

0 1 0 7

0 0 1 3

0 0 0 0

_

_

Luego, el sistema dado es equivalente al sistema

_

_

x = 1

y = 7

z = 3

Matrices y Sistemas de Ecuaciones Lineales 34

Por lo tanto el sistema es consistente determinado y su solucion es

x = 1; y = 7; z = 3

o bien

_

_

x

y

z

_

_

=

_

_

1

7

3

_

_

3. Hallemos la FERF de la matriz ampliada del sistema que es

_

_

1 1 2 1 1

4 2 2 0 2

0 2 10 3 3

_

_

_

_

1 1 2 1 1

4 2 2 0 2

0 2 10 3 3

_

_

F

2

F

2

4F

1

_

1 1 2 1 1

0 2 10 4 6

0 2 10 3 3

_

_

F

2

1

2

F

2

_

1 1 2 1 1

0 1 5 2 3

0 2 10 3 3

_

_

F

1

F

1

F

2

F

3

F

3

2F

2

_

_

1 0 3 1 2

0 1 5 2 3

0 0 0 1 3

_

_

F

3

F

3

_

1 0 3 1 2

0 1 5 2 3

0 0 0 1 3

_

_

F

1

F

1

+ F

3

F

2

F

2

2F

3

_

_

1 0 3 0 1

0 1 5 0 3

0 0 0 1 3

_

_

En consecuencia el sistema dado es equivalente al sistema

_

_

x +3z = 1

y 5z = 3

w = 3

o equivalentemente

_

_

x = 3z + 1

y = 5z 3

w = 3

Matrices y Sistemas de Ecuaciones Lineales 35

Por lo tanto el sistema original es consistente indeterminado. Haciendo z = , con R,

tenemos que la solucion del sistema es

_

_

x

y

z

w

_

_

=

_

_

3 +1

5 3

3

_

_

=

_

_

3

5

1

0

_

_

+

_

_

1

3

0

3

_

_

; con R

4. Hallemos la FERF de la matriz

_

_

1 1 2 1 1

4 2 2 0 2

0 2 10 4 3

_

_

que es la matriz ampliada del sistema

_

_

1 1 2 1 1

4 2 2 0 2

0 2 10 4 3

_

_

F

2

F

2

4F

1

_

1 1 2 1 1

0 2 10 4 6

0 2 10 4 3

_

_

F

3

F

3

+ F

2

_

1 1 2 1 1

0 2 10 4 6

0 0 0 0 3

_

_

Sin necesidad de llegar a la FERF de la matriz, vemos que la ultima la de esta ultima

matriz equivale a la ecuacion

0 x + 0 y + 0 z + 0 w = 3

la cual es contradictoria, en consecuencia, el sistema original es inconsistente.

Teorema 1.16. El sistema homogeneo Ax = 0

/

m1

, con A M

mn

(R), tiene innitas soluciones

si m < n, esto es, si el sistema homogeneo Ax = 0

/

m1

tiene mas incognitas que ecuaciones,

entonces es consistente indeterminado.

Demostraci on. Ejercicio!

Matrices y Sistemas de Ecuaciones Lineales 36

Teorema 1.17. Sea A M

mn

(R). Supongamos que x

1

, x

2

M

n1

(R) son soluciones del

sistema homogeneo Ax = 0

/

m1

. Entonces, para cada R, se tiene que x

1

+ x

2

y x

1

son

tambien soluciones del sistema.

Demostraci on. Ejercicio!

Teorema 1.18. Sean A M

mn

(R) y b M

m1

(R). Supongamos que x

p

es una solucion del

sistema Ax = b. Entonces, para cada solucion x

g

del sistema Ax = b, existe una solucion x

h

de

Ax = 0

/

m1

tal que x

g

= x

h

+ x

p

.

Demostraci on. Dado que x

p

es solucion del sistema Ax = b, tenemos que Ax

p

= b.

Sea x

g

una solucion cualquiera de Ax = b. Entonces Ax

g

= b. Denamos x

h

= x

g

x

p

. As que

Ax

h

= A(x

g

x

p

) = Ax

g

Ax

p

= b b = 0

/

m1

es decir, x

p

es solucion del sistema homogeneo Ax = 0

/

m1

y ademas x

g

= x

h

+ x

p

.

Ejemplo 1.18. Para el sistema de la parte 1 del ejemplo 1.17 tenemos que

x

p

=

_

_

3

2

2

0

_

_

; x

h

=

_

_

1

3

1

_

_

; con R

Para el sistema de la parte 2 del mismo ejemplo, se tiene que

x

p

=

_

_

1

7

3

_

_

; x

h

=

_

_

0

0

0

_

_

Notese que en este caso x

g

= x

p

.

Finalmente, para el sistema de la parte 3 del ejemplo en cuestion

x

p

=

_

_

1

3

0

3

_

_

; x

h

=

_

_

3

5

1

0

_

_

; con R

Ejercicio 1.6. Sea A M

mn

(R). Pruebe que si el sistema Ax = b tiene solucion para cada

b M

m1

(R), entonces m n.

Matrices y Sistemas de Ecuaciones Lineales 37

1.4. Inversa de una Matriz Cuadrada

En la presente seccion, presentaremos un breve estudio sobre las matrices invertibles y

sus aplicaciones en la resolucion de los sistemas de ecuaciones, cabe destacar que se pueden

denir inversas laterales de matrices no cuadradas, sin embargo, solo estudiaremos el caso de

matrices cuadradas.

Denici on 1.16. sea A M

nn

(R). diremos que A es invertible si existe una matriz B

M

nn

(R) tal que

AB = I

n

= BA

Cualquier matriz B que satisfaga las igualdades anteriores es llamada inversa de A.

Ejemplo 1.19. Si A =

_

2 2

3 4

_

, entonces B =

_

2 1

3

2

1

_

es una inversa de A ya que

AB =

_

2 2

3 4

__

2 1

3

2

1

_

=

_

4 3 2 2

3 3 3 + 4

_

=

_

1 0

0 1

_

= I

2

AB =

_

2 1

3

2

1

__

2 2

3 4

_

=

_

4 3 4 + 4

3 3 3 + 4

_

=

_

1 0

0 1

_

= I

2

Teorema 1.19. Si A M

nn

(R) es invertible, entonces A tiene solo una inversa, es decir,

existe una unica matriz B M

nn

(R) tal que AB = I

n

= BA, tal matriz es denotada por A

1

.

Demostraci on. Supongamos que A M

nn

(R) es invertible y que B, C M

nn

(R) son inver-

sas de A. Entonces

AB = I

n

= BA (1.6)

AC = I

n

= CA (1.7)

Luego

C = CI

n

(por la parte 5 del teorema 1.6)

= C(AB) (por la ecuacion 1.6)

= (CA)B (por la parte 1 del teorema 1.6)

= I

n

B (por la ecuacion 1.7)

= B (por la parte 5 del teorema 1.6)

Matrices y Sistemas de Ecuaciones Lineales 38

Teorema 1.20. Sean A, B M

nn

(R) dos matrices invertibles y R con ,= 0. Entonces

1. A

1

es invertible y (A

1

)

1

= A (propiedad involutiva de la inversa)

2. AB es invertible y (AB)

1

= B

1

A

1

(inversa del producto matricial)

3. A es invertible y (A)

1

=

1

A

1