Académique Documents

Professionnel Documents

Culture Documents

Redes Neuronales111

Transféré par

Edith GoApCopyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Redes Neuronales111

Transféré par

Edith GoApDroits d'auteur :

Formats disponibles

Introduccin a la Computacin Neuronal El hombre se ha caracterizado siempre por su bsqueda constante de nuevas vas para mejorar sus condiciones

de vida. Estos esfuerzos le han servido para reducir el trabajo en aquellas operaciones en las que la fuerza juega un papel primordial. Los progresos obtenidos han permitido dirigir estos esfuerzos a otros campos, como por ejemplo, a la construccin de mquinas calculadoras que ayuden a resolver de forma automtica y rpida determinadas operaciones que resultan tediosas cuando se realizan a mano. Charles Babbage trat de construir una mquina capaz de resolver problemas matemticos. Posteriormente otros tantos intentaron construir mquinas similares, pero no fue hasta la Segunda Guerra Mundial, cuando ya se dispona de instrumentos electrnicos, que se empezaron a recoger los primeros frutos. En 1946 se construy la primera computadora electrnica, ENIAC. Desde entonces los desarrollos en este campo han tenido un auge espectacular. Estas mquinas permiten implementar fcilmente algoritmos para resolver multitud de problemas que antes resultaban engorrosos de resolver. Sin embargo, se observa una limitacin importante: qu ocurre cuando el problema que se quiere resolver no admite un tratamiento algortmico, como es el caso, por ejemplo, de la clasificacin de objetos por rasgos comunes? Este ejemplo demuestra que la construccin de nuevas mquinas ms verstiles requiere un enfoque del problema desde otro punto de vista. Los desarrollos actuales de los cientficos se dirigen al estudio de las capacidades humanas como una fuente de nuevas ideas para el diseo de las nuevas mquinas. As, la inteligencia artificial es un intento por descubrir y describir aspectos de la inteligencia humana que pueden ser simulados mediante mquinas. Esta disciplina se ha desarrollado fuertemente en los ltimos aos teniendo aplicacin en algunos campos como visin artificial, demostracin de teoremas, procesamiento de informacin expresada mediante lenguajes humanos... etc. Las redes neuronales son ms que otra forma de emular ciertas caractersticas propias de los humanos, como la capacidad de memorizar y de asociar hechos. Si se examinan con atencin aquellos problemas que no pueden expresarse a travs de un algoritmo, se observar que todos ellos tienen una caracterstica en comn: la experiencia. El hombre es capaz de resolver estas situaciones acudiendo a la experiencia acumulada. As, parece claro que una forma de aproximarse al problema consista en la construccin de sistemas que sean capaces de reproducir esta caracterstica humana. En definitiva, las redes neuronales no son ms que un modelo artificial y simplificado del cerebro humano, que es el ejemplo ms perfecto del que disponemos para un sistema que es capaz de adquirir conocimiento a travs de la experiencia. Una red neuronal es "un nuevo sistema para el tratamiento de la informacin, cuya unidad bsica de procesamiento est inspirada en la clula fundamental del sistema nervioso humano: la neurona". Todos los procesos del cuerpo humano se relacionan en alguna u otra forma con la (in)actividad de estas neuronas. Las mismas son un componente relativamente simple del ser humano, pero cuando millares de ellas se conectan en forma conjunta se hacen muy poderosas. Tambin, es bien conocido que los humanos son capaces de aprender. Aprendizaje significa que aquellos problemas que inicialmente no pueden resolverse, pueden ser resueltos despus de obtener ms informacin acerca del problema.

Por lo tanto, las Redes Neuronales:

Consisten de unidades de procesamiento que intercambian datos o informacin. Se utilizan para reconocer patrones, incluyendo imgenes, manuscritos y secuencias de tiempo, tendencias financieras. Tienen capacidad de aprender y mejorar su funcionamiento.

Una primera clasificacin de los modelos de redes neuronales podra ser, atendiendo a su similitud con la realidad biolgica: 1) El modelo de tipo biolgico. Este comprende las redes que tratan de simular los sistemas neuronales biolgicos, as como las funciones auditivas o algunas funciones bsicas de la visin. 2) El modelo dirigido a aplicacin. Este modelo no tiene por qu guardar similitud con los sistemas biolgicos. Su arquitectura est fuertemente ligada a las necesidades de las aplicaciones para la que es diseada. Historia de las Redes Neuronales Conseguir disear y construir mquinas capaces de realizar procesos con cierta inteligencia ha sido uno de los principales objetivos de los cientficos a lo largo de la historia. De los intentos realizados en este sentido se han llegado a definir las lneas fundamentales para la obtencin de mquinas inteligentes: En un principio los esfuerzos estuvieron dirigidos a la obtencin de autmatas, en el sentido de mquinas que realizaran, con ms o menos xito, alguna funcin tpica de los seres humanos. Hoy en da se contina estudiando en sta misma lnea, con resultados sorprendentes, existen maneras de realizar procesos similares a los inteligentes y que podemos encuadrar dentro de la llamada Inteligencia Artificial (IA). A pesar de disponer de herramientas y lenguajes de programacin diseados expresamente para el desarrollo de mquinas inteligentes, existe un enorme problema que limita los resultados que se pueden obtener: estas mquinas se implementan sobre computadoras basadas en la filosofa de Von Neumann, y que se apoyan en una descripcin secuencial del proceso de tratamiento de la informacin. Si bien el desarrollo de estas computadoras es espectacular, no deja de seguir la lnea antes expuesta: una mquina que es capaz de realizar tareas mecnicas de forma increblemente rpida, como por ejemplo clculo, ordenacin o control, pero incapaz de obtener resultados aceptables cuando se trata de tareas como reconocimiento de formas, voz, etc. La otra lnea de la investigacin ha tratado de aplicar principios fsicos que rigen en la naturaleza para obtener mquinas que realicen trabajos pesados en nuestro lugar. De igual manera se puede pensar respecto a la forma y capacidad de razonamiento humano; se puede intentar obtener mquinas con esta capacidad basadas en el mismo principio de funcionamiento. No se trata de construir mquinas que compitan con los seres humanos, sino que realicen ciertas tareas de rango intelectual con que ayudarle, principio bsico de la Inteligencia Artificial. Las primeras explicaciones tericas sobre el cerebro y el pensamiento ya fueron dadas ya por Platn (427-347 a.C.) y Aristteles (348-422 a.C.). Las mismas ideas tambin las mantuvo Descartes (1569-1650) y los filsofos empiristas del siglo XVIII.

La clase de las llamadas mquinas cibernticas, a la cual la computacin neuronal pertenece, tiene ms historia de la que se cree: Hern (100 a.C) construy un autmata hidrulico. 1936 - Alan Turing. Fue el primero en estudiar el cerebro como una forma de ver el mundo de la computacin. Sin embargo, los primeros tericos que concibieron los fundamentos de la computacin neuronal fueron Warren McCulloch, un neurofisilogo, y Walter Pitts, un matemtico, quienes, en 1943, lanzaron una teora acerca de la forma de trabajar de las neuronas (Un Clculo Lgico de la Inminente Idea de la Actividad Nerviosa - Boletn deMatemtica Biofsica 5: 115-133). Ellos modelaron una red neuronal simple mediante circuitos elctricos. 1949 - Donald Hebb. Escribi un importante libro: La organizacin del comportamiento, en el que se establece una conexin entre psicologa yfisiologa. Fue el primero en explicar los procesos del aprendizaje (que es el elemento bsico de la inteligencia humana) desde un punto de vista psicolgico, desarrollando una regla de como el aprendizaje ocurra. Aun hoy, este es el fundamento de la mayora de las funciones de aprendizaje que pueden hallarse en una red neuronal. Su idea fue que el aprendizaje ocurra cuando ciertos cambios en una neurona eran activados. Tambin intent encontrar semejanzas entre el aprendizaje y la actividad nerviosa. Los trabajos de Hebb formaron las bases de la Teora de las Redes Neuronales. 1950 - Karl Lashley. En sus series de ensayos, encontr que la informacin no era almacenada en forma centralizada en el cerebro sino que era distribuida encima de l. 1956 - Congreso de Dartmouth. Este Congreso frecuentemente se menciona para indicar el nacimiento de la inteligencia artificial. 1957 - Frank Rosenblatt. Comenz el desarrollo del Perceptrn. Esta es la red neuronal ms antigua; utilizndose hoy en da para aplicacin como reconocedor de patrones. Este modelo era capaz de generalizar, es decir, despus de haber aprendido una serie de patrones poda reconocer otros similares, aunque no se le hubiesen presentado anteriormente. Sin embargo, tena una serie de limitaciones, por ejemplo, su incapacidad para resolver el problema de la funcin OR-exclusiva y, en general, era incapaz de clasificar clases no separables linealmente. En 1959, escribi el libro Principios de Neurodinmica, en el que confirm que, bajo ciertas condiciones, el aprendizaje del Perceptrn converga hacia un estado finito (Teorema de Convergencia del Perceptrn). 1960 - Bernard Widrow/Marcial Hoff. Desarrollaron el modelo Adaline (ADAptative LINear Elements). Esta fue la primera red neuronal aplicada a un problema real (filtros adaptativos para eliminar ecos en las lneas telefnicas) que se ha utilizado comercialmente durante varias dcadas. 1961 - Karl Steinbeck: Die Lernmatrix. Red neuronal para simples realizaciones tcnicas (memoria asociativa). 1967 - Stephen Grossberg. A partir de sus conocimientos fisiolgicos, ha escrito numerosos libros y desarrollado modelo de redes neuronales. Realiz una red: Avalancha, que consista en elementos discretos con actividad que vara en el tiempo que satisface ecuaciones diferenciales continuas, para resolver actividades como reconocimiento continuo de habla y aprendizaje de los brazos de un robot. 1969 - Marvin Minsky/Seymour Papert. En este ao surgieron crticas que frenaron, hasta 1982, el crecimiento que estaban experimentando lasinvestigaciones sobre redes

neuronales. Minsky y Papera, del Instituto Tecnolgico de Massachussets (MIT), publicaron un libro Perceptrons. Probaron (matemticamente) que el Perceptrn no era capaz de resolver problemas relativamente fciles, tales como el aprendizaje de una funcin no-lineal. Esto demostr que el Perceptrn era muy dbil, dado que las funciones no-lineales son extensamente empleadas en computacin y en los problemas del mundo real. A pesar del libro, algunos investigadores continuaron su trabajo. Tal fue el caso de James Anderson, que desarroll un modelo lineal, llamado Asociador Lineal, que consista en unos elementos integradores lineales (neuronas) que sumaban sus entradas. Este modelo se basa en el principio de que las conexiones entre neuronas son reforzadas cada vez que son activadas. Anderson dise una potente extensin del Asociador Lineal, llamada Brain State in a Box (BSB). 1974 - Paul Werbos. Desarroll la idea bsica del algoritmo de aprendizaje de propagacin hacia atrs (backpropagation); cuyo significado qued definitivamente aclarado en 1985. 1977 - Stephen Grossberg. Teora de Resonancia Adaptada (TRA). La Teora de Resonancia Adaptada es una arquitectura de red que se diferencia de todas las dems previamente inventadas. La misma simula otras habilidades del cerebro: memoria a largo y corto plazo. 1977 - Teuvo Kohonen. Ingeniero electrnico de la Universidad de Helsinki, desarroll un modelo similar al de Anderson, pero independientemente. 1980 - Kunihiko Fukushima. Desarroll un modelo neuronal para el reconocimiento de patrones visuales.. 1985 - John Hopfield. Provoc el renacimiento de las redes neuronales con su libro: "Computacin neuronal de decisiones en problemas de optimizacin." 1986 - David Rumelhart/G. Hinton. Redescubrieron el algoritmo de aprendizaje de propagacin hacia atrs (backpropagation). A partir de 1986, el panorama fue alentador con respecto a las investigaciones y el desarrollo de las redes neuronales. En la actualidad, son numerosos los trabajos que se realizan y publican cada ao, las aplicaciones nuevas que surgen (sobretodo en el rea de control) y las empresas que lanzan al mercado productosnuevos, tanto hardware como software (sobre todo para simulacin). Actualmente, son numerosos los trabajos que se realizan y se publican, las aplicaciones nuevas que surgen y las empresas que lanzan al mercado productos nuevos, tanto hardware como software, sobre todo para simulacin. Definiciones de una red neuronal Existen numerosas formas de definir a las redes neuronales; desde las definiciones cortas y genricas hasta las que intentan explicar ms detalladamente qu son las redes neuronales. Por ejemplo: 1) Una nueva forma de computacin, inspirada en modelos biolgicos. 2) Un modelo matemtico compuesto por un gran nmero de elementos procesales organizados en niveles. 3) ...un sistema de computacin compuesto por un gran nmero de elementos simples, elementos de procesos muy interconectados, los cuales procesan informacin por medio de su estado dinmico como respuesta a entradas externas.

4) Redes neuronales artificiales son redes interconectadas masivamente en paralelo de elementos simples (usualmente adaptativos) y con organizacin jerrquica, las cuales intentan interactuar con los objetos del mundo real del mismo modo que lo hace el sistema nervioso biolgico. Ventajas que ofrecen las redes neuronales Debido a su constitucin y a sus fundamentos, las redes neuronales artificiales presentan un gran nmero de caractersticas semejantes a las del cerebro. Por ejemplo, son capaces de aprender de la experiencia, de generalizar de casos anteriores a nuevos casos, de abstraer caractersticas esenciales a partir de entradas que representan informacin irrelevante, etc. Esto hace que ofrezcan numerosas ventajas y que este tipo de tecnologa se est aplicando en mltiples reas. Entre las ventajas se incluyen: Aprendizaje Adaptativo: capacidad de aprender a realizar tareas basadas en un entrenamiento o en una experiencia inicial. Auto-organizacin: una red neuronal puede crear su propia organizacin o representacin de la informacin que recibe mediante una etapa de aprendizaje. Tolerancia a fallos: la destruccin parcial de una red conduce a una degradacin de su estructura; sin embargo, algunas capacidades de la red se pueden retener, incluso sufriendo un gran dao. Operacin en tiempo real: los cmputos neuronales pueden ser realizados en paralelo; para esto se disean y fabrican mquinas con hardware especial para obtener esta capacidad. Fcil insercin dentro de la tecnologa existente: se pueden obtener chips especializados para redes neuronales que mejoran su capacidad en ciertas tareas. Ello facilitar la integracin modular en los sistemas existentes. Aprendizaje adaptativo La capacidad de aprendizaje adaptativo es una de las caractersticas ms atractivas de redes neuronales. Esto es, aprenden a llevar a cabo ciertas tareas mediante un entrenamiento con ejemplos ilustrativos. Como las redes neuronales pueden aprender a diferenciar patrones mediante ejemplos y entrenamientos, no es necesario elaborar modelos a priori ni necesidad de especificar funciones de distribucin de probabilidad. Las redes neuronales son sistemas dinmicos autoadaptativos. Son adaptables debido a la capacidad de autoajuste de los elementos procesales (neuronas) que componen el sistema. Son dinmicos, pues son capaces de estar constantemente cambiando para adaptarse a las nuevas condiciones. En el proceso de aprendizaje, los enlaces ponderados de las neuronas se ajustan de manera que se obtengan ciertos resultados especficos. Una red neuronal no necesita un algoritmo para resolver un problema, ya que ella puede generar su propia distribucin de pesos en los enlaces mediante el aprendizaje. Tambin existen redes que continan aprendiendo a lo largo de su vida, despus de completado su perodo de entrenamiento. La funcin del diseador es nicamente la obtencin de la arquitectura apropiada. No es problema del diseador el cmo la red aprender a discriminar. Sin embargo, s es necesario que desarrolle un buen algoritmo de aprendizaje que le proporcione a la red la capacidad de discriminar, mediante un entrenamiento con patrones.

Auto-organizacin Las redes neuronales emplean su capacidad de aprendizaje adaptativo para autoorganizar la informacin que reciben durante el aprendizaje y/o la operacin. Mientras que el aprendizaje es la modificacin de cada elemento procesal, la autoorganizacin consiste en la modificacin de la red neuronal completa para llevar a cabo un objetivo especfico. Cuando las redes neuronales se usan para reconocer ciertas clases de patrones, ellas autoorganizan la informacin usada. Por ejemplo, la red llamada backpropagation, crear su propia representacin caracterstica, mediante la cual puede reconocer ciertos patrones. Esta autoorganizacin provoca la generalizacin: facultad de las redes neuronales de responder apropiadamente cuando se les presentan datos o situaciones a las que no haba sido expuesta anteriormente. El sistema puede generalizar la entrada para obtener una respuesta. Esta caracterstica es muy importante cuando se tiene que solucionar problemas en los cuales la informacin de entrada no es muy clara; adems permite que el sistema d una solucin, incluso cuando la informacin de entrada est especificada de forma incompleta. Tolerancia a fallos Las redes neuronales fueron los primeros mtodos computacionales con la capacidad inherente de tolerancia a fallos. Comparados con los sistemas computacionales tradicionales, los cuales pierden su funcionalidad cuando sufren un pequeo error de memoria, en las redes neuronales, si se produce un fallo en un nmero no muy grande de neuronas y aunque el comportamiento del sistema se ve influenciado, no sufre una cada repentina. Hay dos aspectos distintos respecto a la tolerancia a fallos: a) Las redes pueden aprender a reconocer patrones con ruido, distorsionados o incompletos. Esta es una tolerancia a fallos respecto a los datos. b) Las redes pueden seguir realizando su funcin (con cierta degradacin) aunque se destruya parte de la red. La razn por la que las redes neuronales son tolerantes a los fallos es que tienen su informacin distribuida en las conexiones entre neuronas, existiendo cierto grado de redundancia en este tipo de almacenamiento. La mayora de los ordenadores algortmicos y sistemas de recuperacin de datos almacenan cada pieza de informacin en un espacio nico, localizado y direccionable. En cambio, las redes neuronales almacenan informacin no localizada. Por lo tanto, la mayora de las interconexiones entre los nodos de la red tendrn sus valores en funcin de los estmulos recibidos, y se generar un patrn de salida que represente la informacin almacenada. Operacin en tiempo real Una de las mayores prioridades, casi en la totalidad de las reas de aplicacin, es la necesidad de realizar procesos con datos de forma muy rpida. Las redes neuronales se adaptan bien a esto debido a su implementacin paralela. Para que la mayora de las redes puedan operar en un entorno de tiempo real, la necesidad de cambio en los pesos de las conexiones o entrenamiento es mnimo. Fcil insercin dentro de la tecnologa existente

Una red individual puede ser entrenada para desarrollar una nica y bien definida tarea (tareas complejas, que hagan mltiples selecciones de patrones, requerirn sistemas de redes interconectadas). Con las herramientas computacionales existentes (no del tipo PC), una red puede ser rpidamente entrenada, comprobada, verificada y trasladada a una implementacin hardware de bajo coste. Por lo tanto, no se presentan dificultades para la insercin de redes neuronales en aplicaciones especficas, por ejemplo de control, dentro de los sistemas existentes. De esta manera, las redes neuronales se pueden utilizar para mejorar sistemas en forma incremental y cada paso puede ser evaluado antes de acometer un desarrollo ms amplio. Redes neuronales y computadoras digitales. Para entender el potencial de la computacin neuronal, sera necesario hacer una breve distincin entre sistemas de computacin neuronales y digitales: los sistemas neurolgicos no aplican principios de circuitos lgicos o digitales. Un sistema de computacin digital debe ser sncrono o asncrono. Si fuera asncrono, la duracin de los impulsos neuronales debera ser variable para mantener uno de los valores binarios por periodos de tiempo indefinido, lo cual no es el caso. Si el principio fuera sncrono, se necesitara un reloj global o maestro con el cual los pulsos estn sincronizados. ste tampoco es el caso. Las neuronas no pueden ser circuitos de umbral lgico, porque hay miles de entradas variables en la mayora de las neuronas y el umbral es variable con el tiempo, siendo afectado por la estimulacin, atenuacin, etc. La precisin y estabilidad de tales circuitos no es suficiente para definir ninguna funcin booleana. Los procesos colectivos que son importantes en computacin neuronal no pueden implementarse por computacin digital. Por todo ello, el cerebro debe ser un computador analgico. Ni las neuronas ni las sinapsis son elementos de memoria biestable. Todos los hechos fisiolgicos hablan a favor de las acciones de las neuronas como integradores analgicos, y la eficiencia de la sinapsis cambia de forma gradual, lo cual no es caracterstico de sistemas biestables. Los circuitos del cerebro no implementan computacin recursiva y por lo tanto no son algortmicos. Debido a los problemas de estabilidad, los circuitos neuronales no son suficientemente estables para definiciones recursivas de funciones como en computacin digital. Un algoritmo, por definicin, define una funcin recursiva. Fundamentos de las Redes Neuronales El modelo Biolgico Se estima que el cerebro humano contiene ms de cien mil millones de neuronas estudios sobre la anatoma del cerebro humano concluyen que hay ms de 1000 sinpsis a la entrada y a la salida de cada neurona. Es importante notar que aunque el tiempo de conmutacin de la neurona ( unos pocos milisegundos) es casi un milln de veces menor que en los actuales elementos de las computadoras, ellas tienen una conectividad miles de veces superior que las actuales supercomputadoras. Las neuronas y las conexiones entre ellas (sinpsis) constituyen la clave para el procesado de la informacin. Algunos elementos ha destacar de su estructura histolgica son:

Las dendritas, que son la va de entrada de las seales que se combinan en el cuerpo de la neurona. De alguna manera la neurona elabora una seal de salida a partir de ellas. El axn, que es el camino de salida de la seal generada por la neurona. Las sinapsis, que son las unidades funcionales y estructurales elementales que median entre las interacciones de las neuronas. En las terminaciones de las sinapsis se encuentran unas vesculas que contienen unas sustancias qumicas llamadas neurotransmisores, que ayudan a la propagacin de las seales electroqumicas de una neurona a otra. Para ver el grfico seleccione la opcin "Descargar" Lo que bsicamente ocurre en una neurona biolgica es lo siguiente: la neurona es estimulada o excitada a travs de sus entradas (inputs) y cuando se alcanza un cierto umbral, la neurona se dispara o activa, pasando una seal hacia el axn. Posteriores investigaciones condujeron al descubrimiento de que estos procesos son el resultado de eventos electroqumicos. Como ya se sabe, el pensamiento tiene lugar en el cerebro, que consta de billones de neuronas interconectadas. As, el secreto de la "inteligencia" -sin importar como se defina- se sita dentro de estas neuronas interconectadas y de su interaccin. La forma que dos neuronas interactan no est totalmente conocida, dependiendo adems de cada neurona. En general, una neurona enva su salida a otras por su axn. El axn lleva la informacin por medio de diferencias de potencial, u ondas de corriente, que depende del potencial de la neurona. Este proceso es a menudo modelado como una regla de propagacin representada por la funcin de red u(.). La neurona recoge las seales por su sinpsis sumando todas las influencias excitadoras e inhibidoras. Si las influencias excitadoras positivas dominan, entonces la neurona da una seal positiva y manda este mensaje a otras neuronas por sus sinpsis de salida. En este sentido la neurona puede ser modelada como una simple funcin escaln f(.). Como se muestra en la prxima figura, la neurona se activa si la fuerza combinada de la seal de entrada es superior a un cierto nivel, en el caso general el valor de activacin de la neurona viene dado por una funcin de activacin f(.). Para ver el grfico seleccione la opcin "Descargar" Otras definiciones de Redes Neuronales Una red neuronal es un procesador masivamente paralelo distribuido que es propenso por naturaleza a almacenar conocimiento experimental y hacerlo disponible para su uso. Este mecanismo se parece al cerebro en dos aspectos [SH1]: El conocimiento es adquirido por la red a travs de un proceso que se denomina aprendizaje. El conocimiento se almacena mediante la modificacin de la fuerza o peso sinptico de las distintas uniones entre neuronas. Una red neuronal es un modelo computacional con un conjunto de propiedades especficas, como son la habilidad de adaptarse o aprender, generalizar u organizar la informacin, todo ello basado en un procesamiento eminentemente paralelo. [BJAK] [PPVS] Elementos de una Red Neuronal Artificial

Las redes neuronales son modelos que intentan reproducir el comportamiento del cerebro. Los mismos constan de dispositivos elementales de proceso:las neuronas. A partir de ellas, se pueden generar representaciones especficas, de tal forma que un estado conjunto de ellas puede significar una letra, un nmero u otro objeto. Generalmente se pueden encontrar tres tipos de neuronas: Aquellas que reciben estmulos externos relacionados con el aparato sensorial, que tomarn la informacin de entrada. Dicha informacin se transmite a ciertos elementos internos que se ocupan de su procesamiento. Es en las sinapsis y neuronas correspondientes a este segundo nivel donde se genera cualquier tipo de representacin interna de informacin. Como no tienen relacin directa con la informacin de entrada ni con la salida, estos elementos se denominan unidades ocultas. Una vez finalizado el perodo de procesado, la informacin llega a las unidades de salida, cuya misin es dar la respuesta al sistema. A continuacin se puede ver en la siguiente figura, un esquema de una red neuronal:

La misma est constituida por neuronas interconectadas y arregladas en tres capas (esto ltimo puede variar). Los datos ingresan por medio de la "capa de entrada", pasan a travs de la "capa oculta" y salen por la "capa de salida". Cabe mencionar que la capa oculta puede estar constituida por varias capas. En la siguiente figura se compara una neurona biolgica con una neurona artificial. En la misma se pueden observar las similitudes entre ambas (tienen entradas, utilizan pesos y generan salidas).

La neurona artificial pretende mimetizar las caractersticas ms importantes de las neuronas biolgicas. Cada neurona i-sima est caracterizada en cualquier instante por un valor

numrico denominado valor o estado de activacin

; asociado a cada unidad, existe una

funcin de salida, , que transforma el estado actual de activacin en una seal de salida. Dicha seal es enviada a travs de los canales de comunicacin unidireccionales a otras unidades de la red; estos canales la seal se modifica de acuerdo con la sinpsis (el peso, ) asociada a cada uno de ellos segn determinada regla. Las seales moduladas que han llegado a la unidad j-sima se combinan entre ellas, generando as la entrada total .

Una funcin de activacin, F, determina el nuevo estado de activacin teniendo en cuenta la entrada total calculada y el anterior estado de activacin

de la neurona, .

La dinmica que rige la actualizacin de los estados de las unidades puede ser de dos tipos: asncrono y modo sncrono. En el primer caso, las neuronas evalan su estado continuamente segn les va llegando informacin, y lo hacen de forma independiente, En el segundo caso, la informacin llega de forma continua, pero los cambios se realizan simultneamente, como si existiera un reloj interno que decidiera cuando cambiar su estado. Los sistemas biolgicos quedan probablemente entre ambas posibilidades. Unidades de proceso: La neurona artificial Si se tienen N unidades (neuronas), podemos ordenarlas arbitrariamente y designar la j-sima unidad como . Su trabajo es simple y nico, y consiste en recibir las entradas de las clulas vecinas y calcular un valor de salida, el cual es enviado a todas las clulas restantes. En cualquier sistema que se est modelando, es til caracterizar tres tipos de unidades: entradas, salidas y ocultas. Las unidades de entrada reciben seales del entorno, stas pueden ser provenientes de censores o de otros sectores del sistema. Las unidades de salida envan la seal fuera del sistema; stas pueden controlar directamente potencias u otros sistemas. Las unidades ocultas son aquellas cuyas entradas y salidas se encuentran dentro del sistema; es decir no tienen contacto con el exterior. Se conoce como nivel o capa a un conjunto de neuronas cuyas entradas provienen de la misma fuente, y cuyas salidas se dirigen a un mismo destino. Estado de Activacin

Junto al conjunto de unidades, la representacin necesita los estados del sistema en un tiempo t. Esto se especifica en un vector de N nmeros reales A(t), que representa el estado de activacin del conjunto de unidades de procesamiento. Cada elemento del vector representa la activacin de una unidad en el tiempo t. La activacin de una unidad Ui en el tiempo t se designa por ; es decir:

El procesamiento que realiza la red se ve como la evolucin de un patrn de activacin en el conjunto de unidades que lo componen a travs del tiempo. Todas las neuronas que componen la red se hallan en cierto estado. Podemos decir que hay dos posibles estados, reposo y excitado, a los que denominaremos estados de activacin y a cada uno de los cuales se le asigna un valor. Los valores de activacin pueden ser continuos o discretos. Adems pueden ser limitados o ilimitados. Si son discretos, suelen tomar un conjunto pequeo de valores o bien valores binarios. En notacin binaria, un estado activo se indicara por un 1, y se caracteriza por la emisin de un impulso por parte de la neurona (potencial de accin), mientras que un estado pasivo se indicara por un 0. En otros modelos se considera un conjunto continuo de estados de activacin, en cuyo caso se asigna un valor entre [0,1] o en el intervalo [-1,1], generalmente siguiendo una funcin sigmoidal. Los criterios o reglas que siguen las neuronas para alcanzar tales estados dependen de dos factores: Dado que las propiedades macroscpicas de las redes neuronales no son producto de actuacin de elementos individuales, es necesario tener idea del mecanismo de interaccin entre las neuronas. El estado de activacin estar fuertemente influenciado por tales interacciones ya que el efecto que producir una neurona sobre otra ser proporcional a la fuerza, peso de la conexin entre ambas. La seal que enva cada una de las neuronas a sus vecinas depender de su propio estado de activacin. Funcin de salida o transferencia Asociada a cada unidad Ui (neurona) hay una funcin de salida estado actual de activacin en una seal de salida: . , que transforma el

En algunos modelos, esta salida es igual al nivel de activacin de la unidad, en cuyo caso la funcin es la funcin identidad, suele ser la misma para todas las unidades. . A menudo, es de tipo sigmoidal, y

Existen cuatro funciones de transferencia tpicas que determinan distintos tipos de neuronas:

Funcin escaln Funcin lineal y mixta Sigmoidal Funcin gaussiana

La funcin escaln nicamente se utiliza cuando las salidas de la red son binarias. La salida de una neurona se activa slo cuando el estado de activacin es mayor o igual a cierto valor umbral. La funcin lineal o identidad equivale a no aplicar funcin de salida. Las funciones mixta y sigmoidal son las ms apropiadas cuando queremos como salida informacin analgica. Neurona de funcin escaln La funcin escaln se asocia a neuronas binarias en las cuales cuando la suma de las entradas es mayor o igual que el umbral de la neurona, la activacin es 1, si es menor, la activacin es 0 ( 1). Las redes formadas por este tipo de neuronas son fciles de implementar en hardware, pero sus capacidades estn limitadas. Neurona de funcin lineal o mixta La funcin lineal o mixta corresponde a la funcin F(x) =x. En las neuronas con funcin mixta si la suma de las seales de entrada es menor que un lmite inferior, la activacin se define como 0 ( 1). Si dicha suma es mayor o igual que el lmite superior, entonces la activacin es 1. Si la suma de entrada est comprendida entre ambos lmites, la activacin se define como una funcin lineal de suma de las seales de entrada. Neurona de funcin continua (sigmoidal) Cualquier funcin definida simplemente en un intervalo de posibles valores de entrada, con un incremento monotnico y que tengan ambos limites superiores e inferiores (por ejemplo las funciones sigmoidal y arco tangente), podr realizar la funcin de activacin o transferencia de forma satisfactoria. Con la funcin sigmoidal, para la mayora de los valores del estmulo de entrada, el valor dado por la funcin es cercano a uno de los valores asintticos. Esto hace posible que en la mayora de los casos, el valor de salida est comprendido en la zona alta o baja del sigmoide. De hecho cuando la pendiente es elevada, esta funcin tiende a la funcin escaln. La importancia de sta funcin es que su derivada es siempre positiva y cercana a cero para los valores grandes positivos o negativos; adems toma su valor mximo cuando x es cero. Esto hace que se puedan utilizar las reglas de aprendizaje definidas para la funcin escaln, con la ventaja respecto a esta funcin, que la derivada est definida para todo el intervalo. La funcin escaln no poda definir la derivada en ele punto de transicin y esto no ayuda a los mtodos de aprendizaje en los cuales se usan derivadas. Funcin de transferencia gaussiana Los centros y anchura de estas funciones pueden ser adaptados, lo cual las hace ms adaptativas que las funciones sigmoidales. Conexiones entre neuronas Las conexiones que unen las neuronas que forman una RNA tienen asociado un peso que es el que hace que la red adquiera conocimiento. Consideremos como el valor de salida de una neurona i en un instante dado. Una neurona recibe un conjunto de seales que le dan informacin del estado de activacin de todas las neuronas con las que se encuentra conectada. Cada conexin (sinpsis) entre la neurona i y la j est ponderada por un peso . Normalmente, como simplificacin, se considera que el efecto de cada seal es aditivo, de tal

forma que la entrada neta que recibe una neurona , es la suma de cada seal individual por el valor de la sinapsis que conecta ambas neuronas:

Esta regla muestra el procedimiento a seguir para combinar los valores de entrada a una unidad con los pesos de las conexiones que llegan a esa unidad y es conocida como regla de propagacin. Funcin o regla de activacin As como es necesario una regla que combine las entradas de una neurona con los pesos de las conexiones, tambin se requiere una regla que combine las entradas con el estado actual de la neurona para producir un nuevo estado de activacin. Esta funcin F produce un nuevo estado de activacin en una neurona a partir del estado entradas con los pesos de las conexiones ( Dado el estado de activacin de activacin siguiente, activacin. ). , el estado que exista y la combinacin de las

de la unidad Ui y la entrada total que llega,

, se obtiene aplicando una funcin F, llamada funcin de

En la mayora de los casos la funcin F es la funcin identidad, por lo que el estado de activacin de la neurona en t+1 coincidir con el Net de la misma t. En este caso, el parmetro que se le pasa a la funcin de salida , de la neurona ser directamente el Net. Es estado de quedar

activacin anterior no se tiene en cuenta. Segn esto, la salida de una neurona segn la expresin:

Por tanto, y en lo sucesivo, consideraremos nicamente la funcin , que denominaremos de transferencia o de activacin. Adems, la misma no est centrada en el origen del eje que representa el valor de entrada neta sino que existe cierto desplazamiento debido a las caractersticas internas de la neurona y que no es igual en todas ellas. Este valor se denota como y representa el umbral de activacin de la neurona i.

La salida se obtiene en una neurona para las diferentes forma de la funcin Funcin de activacin escaln Si el conjunto de los estados de activacin es E ={0,1}, tenemos que:

sern:

Si el conjunto es E = {-1,1}, tendremos que:

Funcin de activacin lineal o identidad El conjunto de estados E puede contener cualquier nmero real; el estado de activacin coincide con la entrada total que ha llegado a la unidad.

Funcin de activacin lineal-mixta

Con esta funcin, el estado de activacin de la unidad est obligado a permanecer dentro de un intervalo de valores reales prefijados.

Funcin de activacin sigmoidal Es una funcin continua, por tanto el espacio de los estados de activacin es un intervalo del eje real.

Para simplificar la expresin de la salida de una neurona i, es habitual considerar la existencia de una neurona ficticia, con valor de salida unidad, asociada a la entrada de cada neurona i mediante una conexin con peso de valor quedar: .De esta forma la expresin de salida

Vous aimerez peut-être aussi

- Proceso SDocument4 pagesProceso SEdith GoApPas encore d'évaluation

- A VeriasDocument19 pagesA VeriasEdith GoApPas encore d'évaluation

- Medicina PreventivaDocument1 pageMedicina PreventivaLaura Angelica Hernandez GomezPas encore d'évaluation

- Rio de Temas Selectos de DerechoDocument1 pageRio de Temas Selectos de DerechoEdith GoApPas encore d'évaluation

- Disfunciones Del Cuerpo Calloso (Módulo 5)Document2 pagesDisfunciones Del Cuerpo Calloso (Módulo 5)lalyhcPas encore d'évaluation

- Ondas CerebralesDocument101 pagesOndas CerebralesAdolfo La Roche67% (6)

- Watermarked - Revista Internacional de Principios y Practicas Del Diseno Volumen 3 Numero 2 - Dec 06 2021 01 17 15Document78 pagesWatermarked - Revista Internacional de Principios y Practicas Del Diseno Volumen 3 Numero 2 - Dec 06 2021 01 17 15Tutto RengifoPas encore d'évaluation

- El Ajedrez Como Herramienta en La Lucha Contra El AlzheimerDocument2 pagesEl Ajedrez Como Herramienta en La Lucha Contra El AlzheimerSteeven MartínezPas encore d'évaluation

- Sistema Nervioso PruebaDocument6 pagesSistema Nervioso PruebaSandra Arce GuerreroPas encore d'évaluation

- Motivar para Aprender en El Aula - GilbertDocument7 pagesMotivar para Aprender en El Aula - GilbertGloria Cofre MolPas encore d'évaluation

- Características y Funciones de Las Áreas Cerebrales de BrodmmanDocument14 pagesCaracterísticas y Funciones de Las Áreas Cerebrales de BrodmmanEmilly PerezPas encore d'évaluation

- Mecanismo de Acción de La Insulina en El SNC. MEDICINA HUMANA UNSCHDocument11 pagesMecanismo de Acción de La Insulina en El SNC. MEDICINA HUMANA UNSCHEBER JOSSUE PALOMINO PALACIOSPas encore d'évaluation

- Cerebro y Violencia NeurocriminologiaDocument51 pagesCerebro y Violencia NeurocriminologiaAlvaro CruzPas encore d'évaluation

- MeningiomaDocument2 pagesMeningiomaLieseel DurdenPas encore d'évaluation

- Clase 15 CerebroDocument30 pagesClase 15 CerebromegalaughPas encore d'évaluation

- Trastornos Cognositivos No EspecificadosDocument19 pagesTrastornos Cognositivos No EspecificadosGloria PánucoPas encore d'évaluation

- Neuropsicologica Epilepsia AdultosDocument7 pagesNeuropsicologica Epilepsia AdultosBetzabé DinorinPas encore d'évaluation

- Carpetilla Semanas 1 y 2Document50 pagesCarpetilla Semanas 1 y 2Nicole Stephanie GonzalezPas encore d'évaluation

- Infografía PDFDocument1 pageInfografía PDFzuneo1990Pas encore d'évaluation

- Omnilife Es SaludDocument20 pagesOmnilife Es SaludCecinio Huaranga SilvaPas encore d'évaluation

- Breve Resumen Del Libro Los 7 Hábitos de Las Personas Altamente EfectivasDocument64 pagesBreve Resumen Del Libro Los 7 Hábitos de Las Personas Altamente EfectivasJesus Tizon67% (9)

- Primero Comprender, Después Ser ComprendidoDocument3 pagesPrimero Comprender, Después Ser ComprendidoAdelaida DelgadoPas encore d'évaluation

- ElectroDocument76 pagesElectroYadareli DothéPas encore d'évaluation

- Valoracion Proceso de Enfermería en El Paciente Pediatrico NeurologicoDocument63 pagesValoracion Proceso de Enfermería en El Paciente Pediatrico NeurologicoChristopher BarreraPas encore d'évaluation

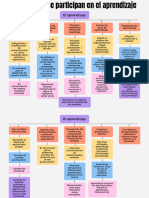

- Mapa Conceptual El AprendizajeDocument3 pagesMapa Conceptual El AprendizajeLudivina Lara EspinosaPas encore d'évaluation

- Visualización Creativa, Guía Practica - Denning y PhillipsDocument46 pagesVisualización Creativa, Guía Practica - Denning y PhillipsI.E.S.T.P. HIPOLITO UNANUEPas encore d'évaluation

- Perlmutter, D. - Tu-Dieta Mata Tu CerebroDocument41 pagesPerlmutter, D. - Tu-Dieta Mata Tu CerebroPolicena6944Pas encore d'évaluation

- TFG Marta Copete AndradeDocument65 pagesTFG Marta Copete AndradeAnafaby OcPas encore d'évaluation

- Psicopatologia Cuadro ComparativoDocument4 pagesPsicopatologia Cuadro ComparativokiomaraPas encore d'évaluation

- EncefalopatiaCronicanoevolutiva PDFDocument16 pagesEncefalopatiaCronicanoevolutiva PDFLujan FernandezPas encore d'évaluation

- El Sistema Nervioso Triptico PDFDocument3 pagesEl Sistema Nervioso Triptico PDFjh100% (1)

- Examen de Ciencias 1, Segundo Parcial, Segundo TrimestreDocument2 pagesExamen de Ciencias 1, Segundo Parcial, Segundo TrimestreGERMANPas encore d'évaluation

- Intereses de Los Alumnos de Educación Básica Preescolar en Ciudadanía e InterculturalidadDocument7 pagesIntereses de Los Alumnos de Educación Básica Preescolar en Ciudadanía e InterculturalidadPerla ArellanoPas encore d'évaluation

- Anatomía Morfofisiología 4Document2 pagesAnatomía Morfofisiología 4Luz Arianna Aparicio SalasPas encore d'évaluation