Académique Documents

Professionnel Documents

Culture Documents

9 Distribuciones Bidimensionales

Transféré par

2VelezTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

9 Distribuciones Bidimensionales

Transféré par

2VelezDroits d'auteur :

Formats disponibles

Introduccin

- La esperanza condicional es un concepto clave como se ver

al estudiar la asignatura de econometra.

- La esperanza condicional proporciona el valor esperado de

una variable cuando conocemos los valores que han tomado

las otras variables de las cuales depende.

- En la asignatura de Econometra lo que se har bsicamente es

modelizar esta esperanza condicional.

Esperanza condicional

Definicin: la esperanza de X condicional a que Y=y se

calcula como:

Es decir, es la esperanza de la distribucin condicional de

X a Y=y

Interpretacin: Valor esperado de X si se ha observado

que Y=y

y) Y | x p(X x

i

i i

= =

Ejemplo

En el ejemplo del tiempo meterelogico vamos a

calcular las probabilidades de X=x condicionales a cada

uno de los posibles valores de Y

X|Y=1 1 2 3

f

x/Y=1

(x) 0.78 0.06 0.16

X|Y=2 1 2 3

f

x/Y=2

0.25 0.5 0.25

X|Y=3 1 2 3

f

x/Y=3

0.25 0.125 0.625

Para cada

una de

estas

funciones

podemos

definir la

esperanza:

sern la

esperanza

condicional

Ejemplo (II)

Por tanto,

E(X|Y=1)=0.78+0.06*2+0.16*3=1.38

E(X|Y=2)=0.25+2*0.5+3*0.25=2

E(X|Y=3)=0.25+0.125*2+0.625*3=2.37

Ejemplo (III)

-Fjate que para cada valor de Y tenemos un

valor de la esperanza condicional de X.

-Por tanto, en definitiva, la esperanza

condicional de X no es ms que es una

FUNCIN de Y.

-Como Y es una variable aleatoria, cualquier

funcin de ella misma es tambin una variable

aleatoria.

-Esto significa que E(X|Y=y) es una variable

aleatoria!!

Ejemplo (y IV)

Vamos a analizar cul es la distribucin de esta

variable:

E(X|Y) 1.38 2 2.37

Prob. 0.64 0.2 0.16

Vale esta cantidad si Y=1

Por tanto, con una probabilidad igual a

la P(Y=1)=0.64

P(Y=2)

P(Y=3)

Ley de la esperanza iterada

-Como acabamos de ver, la E(X|Y) es una variable

aleatoria puesto que toma tantos valores como

valores tome la v.a. Y.

- Como cualquier v.a., tambin podemos calcular la

esperanza de esta nueva v.a. E(X|Y) que acabamos

de definir.

-Se calcula como siempre: como una media

ponderada de los valores de E(X|Y) ponderamos por

su probabilidad.

-La ley de la esperanza iterada nos da una igualdad

que se verifica siempre que hagamos este clculo.

Ley de la esperanza iterada

E

y

(E

x

(X|Y))=E(X)

Es decir, si calculo la esperanza de todas las esperanzas

condicionadas obtenemos la esperanza condicional.

Seguimos con el ejemplo anterior

En el ejemplo anterior tenamos

Si calculamos la esperanza de esta variable obtenemos:

E(E(X|Y))=1.38*0.64+2*0.2+2.37*0.16=1.66

E(X|Y) 1.38 2 2.37

Prob. 0.64 0.2 0.16

Por otra parte

Si calculamos la esperanza de esta variable obtenemos:

E(X)=1*0.59+2*0.16+3*0.25=1.66

Por tanto, efectivamente, E(X)=E(E(X|Y))

X 1 2 3

Prob. 0.59 0.16 0.25

Relaciones entre variables:

Covarianza y correlacin.

Independencia entre v.a.

Cuando construimos modelos econmicos,

bsicamente estamos relacionando variables

econmicas con argumentos del tipo: Un aumento en

la variable X est asociado a un aumento (descenso)

de la variable Y.

En este captulo vamos a aprender a determinar

1) Cuando dos variables estn asociadas o no (=son

independientes)

2) Qu tipo de relacin existe entre ellas (lineal o no)

3) La intensidad de la relacin lineal (calculando la

correlacin entre ellas).

Relaciones entre variables

Algunos ejemplos

Existe una relacin positiva entre el flujo de inmigrantes a

un pas y la renta per capita del pas de acogida.

Existe una relacin positiva entre la nota obtenida en

probabilidad y la de estadstica.

Existe una relacin negativa entre la tasa de fecundidad y la

tasa de participacin femenina.

No parece que exista ninguna relacin entre el volumen de

lluvias en Islandia y la nota del parcial de probabilidad.

Relaciones entre variables

Importante

En este tema no nos preocupamos de la causalidad

El objetivo ser:

detectar la posible relacin entre dos variables (sin

preocuparnos qu variable causa a la otra)

determinar (a travs de la covarianza) si las

variables estn relacionadas linealmente. En caso

afirmativo, determinar el sentido de la relacin

(positivo o negativo).

Determinar la fuerza de esta relacin (a travs de la

correlacin).

Relaciones entre variables

X

Y

X

Y

X

Y

Sin relacin

Relacin lineal

positiva

Relacin no-lineal

Relaciones entre variables

Las relaciones entre v.a. pueden ser de muy distinto

tipo: positivas o negativas (si cuando crece la una la

otra tambin lo hace y viceversa), lineales o no

lineales, etc.

Tambin puede ocurrir que no exista ninguna relacin

entre dos v.a.: cuando esto ocurre diremos que dos v.a.

son independientes.

Vamos a estudiar a continuacin cmo de lineal es la

relacin que existe entre dos variables: para ello

definimos la covarianza y la correlacin

Covarianza

Mide la relacin de tipo lineal entre dos v.a.

Definicin:

Interpretacin:

1. un valor positivo se interpreta como existencia de

relacin lineal positiva entre las v.a. X e Y

2. Un valor negativo, como existencia de relacin lineal

negativa entre las v.a. X e Y.

COV(X,Y)=E[(X-E(X))(Y-E(Y))

Covarianza (II)

3. Un valor igual a cero se interpreta como ausencia

de relacin lineal. Esto NO es igual a decir que las v.a.

Son independencientes.

X

Y

X

Y

Propiedades de la covarianza

1. COV(X,Y)=E(XY)-E(X)E(Y)

2. COV(X,Y)=0 SI Y SOLO SI E(XY)=E(X)E(Y)

3. VAR(X)=COV(X,X)

4. COV(K,X)=0 si K constante

5. COV(aX+b,cY+d)=acCOV(X,Y)

6. COV(X+Z,Y)=COV(X,Y)+COV(Z,Y)

7. VAR(X+Y)=VAR(X)+VAR(Y)+2COV(X,Y)

VAR(X-Y)=VAR(X)+VAR(Y)-2COV(X,Y)

El coeficiente de correlacin

La propiedad 5 que acabamos de ver es muy importante.

Imagina que X=beneficio (medido en millones de

euros) de la emp. X e Y=beneficio en millones de

euros de la emp. Y. Sabemos que COV(X,Y)=-1.8

Imagina que en lugar de expresarlo en millones de euros,

lo expresamos en euros, entonces:

COV(X*1000000,Y*1000000)=1000000000000*-1.8!!

Como vemos, la COV depende de las unidades en que

medimos las variables. Por tanto, NO podemos

utilizarla para medir la intensidad de la relacin lineal

El coeficiente de correlacin II

El coeficiente de correlacin estandariza la covarianza de

manera que no dependa de las unidades en que

estamos midiendo.

Definicin: CORR(X,Y)=(X,Y)=

Es fcil ver que esta medida ya no depende de las

unidades. En el ejemplo anterior:

y x

Y X

o o

) , cov(

) ( ) (

) , cov(

10 10

10 * 10

) 10 ( ) 10 (

) 10 , 10 cov(

) 10 , 10 (

6 * 2 6 * 2

6 6

6 6

6 6

6 6

Y V X V

Y X

Y V X V

Y X

Y X

=

=

El coeficiente de correlacin III

Propiedades del coeficiente de correlacin

No depende de las unidades

Siempre est entre 1 y 1.

Este resultado deriva de la conocida Desigualdad de

Schwartz. Para toda v.a Z y V,

Llamando: Z=X-E(X) y V=Y-E(Y) y tomando races

cuadradas:

) ( ) ( )] ( [

2 2 2

V E Z E ZV E s

y x y x

Y X o o o o s s ) , cov(

Command

Interpretacin

CORR(X,Y)=1. Existe una relacin lineal

exacta entre X e Yy la pendiente de la

recta es positiva:

0<CORR(X,Y)<1, relacin lineal + entre X

e Y, ms intensa cuanto ms cercana

a uno

CORR(X,Y)=0, ausencia de relacin lineal.

-1<CORR(X,Y)<0. relacin lineal (-) entre

X e Y, ms intensa cuanto ms

cercana a -uno

CORR(X,Y)=-1, Existe una relacin lineal

(-) exacta entre X e Y.

CORR(X,Y)=0, entonces

Hay ausencia de relacin LINEAL entre las variables. Diremos en este caso

que X e Y estn incorrelacionados. Esto puede ocurrir por dos motivos

a. Las variables No tienen ningn tipo de relacin, es decir son

INDEPENDIENTES

b. O de manera ms general, tienen algn tipo de relacin que no es lineal.

X

Y

X

Y

Ejemplo

El equipo X y el equipo Y se enfrentan en un campeonato.

Supn que la distribucin de probabilidad conjunta del

nmero de goles que obtienen es:

Y

0 1 2

0 .10 0.08 .04

X 1 .08 .30 .10

2 .07 .03 .20

existe alguna relacin lineal entre el nmero de goles

marcados por uno y otro equipo? En caso afirmativo, se

trata de una relacin estrecha?

Solucin

Calculamos la correlacin entre X e Y.

Para ello tenemos que calcular E(XY)-E(X)E(Y)

Calculamos E(XY). Para ello calculamos la funcin de

masa de prob. De la v.a. Z=XY

XY 0 1 2 4

0.37 0.30 0.13 0.20

P(X=2,Y=2)

P(X=1,Y=2)+P(X=1,Y=2)

P(X=1,Y=1)

Solucin (II)

E(XY)=0*0.37+1*0.30+2*0.13+4*0.20=1.36

E(X)=1.08

E(Y)=1.09

Por tanto,

COV(X,Y)=1.36-1.08*1.09=0.18

Existe una relacin lineal positiva entre los goles que marca

uno y otro equipo por partido.

Para cuantificar la fuerza de la relacin hay que calcular el

coeficiente de correlacin.

Solucin (y III)

V(X)=0.51, Desviacin tip: 0.71

V(Y)=0.58, Desviacin tip.: 0.76

Por tanto,

CORR(X,Y)=0.18/(0.71*0.76)=0.33

El coeficiente de correlacin est lejano de cero lo que

confirma que existe una relacin lineal positiva significativa

entre los goles marcados por X e Y. Por otra parte, este

valor tambin est lejano a 1 por lo que se puede deducir

que esta relacin lineal no es muy intensa.

Ejercicio

Sean X e Y dos v.a. Si E(X)=2, E(Y)=8,V(X)=4,

V(Y)=3 y COV(X,Y)=4 calcula:

1. V(X+Y)

2. COV(-3X,-2Y)

3. COV(X,5Y+6)

4. COV(X,3)

5. COV(Y,Y)

6. Si V(X)=0, X es una constante?

7. Si COV(X,Z)=0, Z o X han de ser

constantes?

Ejercicio propuesto

8. Si Z=log(X), entonces, crees que el

coeficiente de correlacin ser positivo,

negativo o cero?

9. Si Z=log(X), entonces corr(X,Y) puede ser

igual a 1 o 1?

10. Proporciona una transformacin de X, Z, tal

que CORR(X,Z)=1

11. Lo mismo pero CORR(X,Z)=-1

12. Lo mismo pero CORR(X,Z)=0

Ejercicio II

Una urna contiene 4 bolas con los nmeros 1, 2, 3 y

4. Se extraen 2 bolas sin reemplazamiento. Sea X

el valor mnimo e Y el valor mximo obtenido en

la extraccin.

1. Calcula la distribucin conjunta de (X, Y).

2. Calcula las distribuciones marginales y E(X)

3. Calcula la distribucin de X|Y=3 y su esperanza.

4. Calcula la cov entre X e Y

Este concepto hace referencia a la ausencia de relacin de

cualquier tipo, no slo de tipo lineal, entre dos v.a.

Recuerda que dos sucesos, A y B, son independientes si tener

informacin sobre uno de ellos no influye en el clculo de prob.

del otro, es decir:

O equivalentemente, A y B son independientes si y solo si

Independencia

P(A| B) = P(A )

P(AB) =P(B)P(A)

De una manera similar se puede definir el concepto de independencia entre v.a.

Sean X e Y dos v.a. (continuas o discretas). X e Y son independientes si y solo

si la distribucin de una ellas condicionada por la otra es igual a la marginal de

la primera,

Como en el caso de sucesos, esta definicin implica que X e Y son indep. si su

distribucin conjunta se puede calcular como el producto de las marginales, es

decir:

Independencia II

f

XY

(x, y) = f

X

(x) f

Y

(y)

f

X|Y

(x) = f

X

(x) f

Y|X

(y) = f

Y

(y)

Independencia e incorrelacin

Incorrelacin: ausencia de relacin lineal

Indepencia ausencia de cualquier tipo de

relacin, por tanto

Indepencia Incorrelacin

Ejemplo

Son X e Y indep? y U y V?

X\Y 1 2 3)

1 .50 .05 .04

2 .04 .10 .02

3 .10 .05 .10

U\V 1 2 3

1 .30 .10 .10

2 .18 .06 .06

3 .12 .04 .04

Ejercicio

Sean dos v.a. X e Y independientes tal que E(X)=3,

E(Y)=5, V(X)=1, V(Y)=7. Calcula

1. E(X|Y=1)

2. Corr(2X,3Y)

3. COV(2X,3Y-5X)

4. VAR(4X-3Y)

Distribuciones de probabilidad

bidimensionales o conjuntas

Si disponemos de dos variables aleatorias podemos

definir distribuciones bidimensionales de forma

semejante al caso unidimensional. Para el caso

discreto tendremos:

. y) x, Y P(X p(x, y) = = =

. 0 ) , ( , 1 ) , ( > =

y x p y x p

x y

Con:

37

Podemos encontrar la probabilidad marginal de

la variable aleatoria X sumando sobre todos los

posibles valores de la variable aleatoria Y:

y x p (x) p

y

X

= ) , (

Igualmente, podemos encontrar probabilidad

marginal de la variable aleatoria Y sumando

sobre todos los posibles valores de la variable

aleatoria Y:

y x p (y) p

x

Y

= ) , (

38

Y la funcin de probabilidad condicional de Y dado X = x es:

Funcin de probabilidad condicional

La funcin de probabilidad condicional de X dado Y = y es:

(y) p

p(x,y)

p(x|y)

Y

=

(x) p

p(x,y)

p(y|x)

X

=

39

Nota: El punto 2 lo veremos ms adelante.

45

La definicin para dos variables aleatorias continuas es

semejante: F(x,y) = P(X s x, Ys y).

La densidad de probabilidad f(x,y) se obtiene derivando la

funcin de probabilidad con respecto a sus argumentos:

} }

=

>

1 ) , (

, 0 ) , (

dxdy y x f

y x f

Por supuesto:

) , (

) , ( ) , (

2 2

y x f

x y

y x F

y x

y x F

=

c c

c

=

c c

c

46

}

= dx y x f y f

Y

) , ( ) (

}

= dy y x f x f

X

) , ( ) (

Las densidades de probabilidad marginales y las

probabilidades condicionales se definen de forma

semejante al caso bidimensional discreto sin ms que

sustituir sumatorios por integrales. As:

(y) f

f(x,y)

f(x|y)

Y

=

(x) f

f(x,y)

f(y|x)

X

=

47

(y) P (x) P P(x, y)

Y X

=

Distribuciones bidimensionales

e independencia

Los sucesos aleatorios {X = x} e {Y = y} son independientes

si:

Y entonces, dos variables aleatorias sern independientes

si la relacin anterior se cumple para todos los posibles

pares (x,y).

(y) p p(y|x) (x) p p(x|y)

Y X

= = y

Podremos entonces escribir:

48

El teorema de Bayes se expresa como:

(x) p

(y) p(x|y) p

p(y|x)

y p

(x) p(y|x) p

p(x|y)

X

Y

Y

X

=

=

) (

49

50

51

52

53

54

55

56

La covarianza mide la manera en que dos variables

aleatorias X e Y varan juntas. Por ejemplo, si cuando

una variable aleatoria X se acerca a su media,

entonces es de esperar que la variable Y est

cercana a la suya, la covarianza es positiva. Si es de

esperar que la variable Y est lejana a su media,

entonces la covarianza es negativa.

Covarianza

( ) ) )( ( ) , ( Cov v = Y X E Y X

( ) ( ) Y E X E = = v Con:

57

Se cumple que:

( ) v = Y X E Y X ) , ( Cov

Si X e Y son variables independientes, su covarianza

es cero. Observa que en este caso:

( ) ( ) ( ) 0 ) , cov( = = = = v v v v Y E X E Y X E Y X

Puesto que X e Y son variables independientes

Si la covarianza de X e Y es cero, no necesariamente

X e Y son variables independientes.

58

Nota: Aqu est el punto 2 que nos quedaba pendiente.

Propiedades de la covarianza

Si a y b son constantes:

( )

( )

( ) Y X ab bY aX

X Y Y X

X X X

, cov ) , cov(

, cov ) , cov(

var ) , cov(

=

=

=

60

( ) ( ) ) , ( Cov 2 Var Var ) ( Var

2 2

Y X ab Y b X a bY aX + + = +

Nota:

61

Resumen del formulario:

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

Transformacin de variables

aleatorias bidimensionales

Dada una variable bidimensional (X, Y), con funcin densidad

de probabilidad conjunta f(x, y) y una transformacin biunvoca:

U = u(X, Y), V = v(X, Y)

la funcin de densidad de probabilidad conjunta de la nueva

variable aleatoria bidimensional (U, V) ser:

g(u, v) = f(x(u,v), y(u,v)) |J|

con:

1

c

c

c

c

c

c

c

c

=

c

c

c

c

c

c

c

c

=

y

v

x

v

y

u

x

u

v

y

u

y

v

x

u

x

J

77

Ejemplo de transformacin bidimensional

Sean x,y dos nmeros aleatorios generados por distribuciones

normales tipificadas N(0,1). Si son independientes, su distribucin

sobre un plano ser:

)

`

+

=

|

|

.

|

\

|

|

|

.

|

\

|

=

2

) (

2

1

2

2

1

2

2

1

) , (

2 2 2 2

y x

Exp

y

Exp

x

Exp y x P

t

t t

x = 1 e

y

y = ln ( 1 x )

x = 1 e

y

y = ln ( 1 x )

x = 1 e

y

y = ln ( 1 x )

x = 1 e

y

y = ln ( 1 x )

Hagamos una transformacin a coordenadas polares (R,).

Con d = R

2

= x

2

+ y

2

:

) 2 / (

2

1

2

1

) , (

) , (

) , (

) , ( d Exp y x P

d

y x

d P =

c

c

=

t u

u

que es equivalente al producto de una distribucin exponencial de

vida media 2, y una distribucin uniforme definida en el intervalo

[0,2].

(Press et al., Numerical Recipes)

79

Transformacin de Box-Mller:

Cmo conseguir una distribucin normal bidimensional

a partir de una uniforme?

demuestra que nos llevan a dos nmeros aleatorios x,y

cuya probabilidad sigue una distribucin normal.

Puesto que las transformaciones dependen de funciones

trigonomtricas, no son muy eficientes para el clculo

computacional.

2

1

2

2

ln 2

u

u R

t u =

=

) sin(2 ln 2 sin

) cos(2 ln 2 cos

2 1

2 1

u u R y

u u R x

t u

t u

= =

= =

(Press et al., Numerical Recipes)

Sean dos nmeros aleatorios u

1

, u

2

derivados de una

distribucin uniforme. Se realizan las transformaciones:

86

x = 1 e

y

y = ln ( 1 x )

x = 1 e

y

y = ln ( 1 x )

x = 1 e

y

y = ln ( 1 x )

x = 1 e

y

y = ln ( 1 x )

Para hacer el algoritmo de Box-Mller

ms rpido se definen las variables:

v

1

=2u

1

1

v

2

=2u

2

1

Se generan nmeros hasta que

(v

1

,v

2

) se encuentre dentro del

crculo de radio R = 1.

2 / 1

2 / 1

ln 2

ln 2

|

.

|

\

|

=

|

.

|

\

|

=

d

d

y

d

d

x

2

1

v

v

2 / 1

2 2

2 / 1

1 1

) (

sin

) (

cos

2

2

2

1

2

2

2

1

v v

v v

v v

v v

+

= =

+

= =

R

R

u

u

v

1

v

2

R

(1,1)

(1,1) (1,1)

(1,1)

para d 1.

(Press et al., Numerical Recipes)

Estas transformaciones modificadas

son ms eficientes en el clculo.

87

88

89

Vous aimerez peut-être aussi

- Analisis de La CorrelacionDocument5 pagesAnalisis de La CorrelacionmiguelPas encore d'évaluation

- Distribuciones BidimensionalesDocument64 pagesDistribuciones BidimensionalesHugo Mejia GutierrezPas encore d'évaluation

- 9 Distribuciones BidimensionalesDocument64 pages9 Distribuciones Bidimensionaleslucia zegarraPas encore d'évaluation

- Clase 0 Econometria IntensivoDocument7 pagesClase 0 Econometria IntensivoGina RossiPas encore d'évaluation

- BidimensionalDocument10 pagesBidimensionalAmIn20122Pas encore d'évaluation

- Regresion Lineal MultipleDocument16 pagesRegresion Lineal MultipleKelvin GarciaPas encore d'évaluation

- Regresion y Correlacion Simple y Multiple 2014.Document37 pagesRegresion y Correlacion Simple y Multiple 2014.Luis NöolsPas encore d'évaluation

- Tema4 RegresionDocument12 pagesTema4 RegresionRUmanzor-89Pas encore d'évaluation

- Cap 1 Repaso Regresión Lineal SimpleDocument10 pagesCap 1 Repaso Regresión Lineal SimpleJean GutierrezPas encore d'évaluation

- 04 Econometria Supuestos MCRLDocument4 pages04 Econometria Supuestos MCRLCarolaine FariasPas encore d'évaluation

- Ejercicios Regresion Lineal SimpleDocument11 pagesEjercicios Regresion Lineal SimpleLesly Leonor Moctezuma VelezPas encore d'évaluation

- Unidad 10 Regresion y CorrelacionDocument23 pagesUnidad 10 Regresion y CorrelacionJuanIgnaciodelaIglesiaPas encore d'évaluation

- Documento de Lectura S 1a Coeficiente de Correlacion de PearsonDocument4 pagesDocumento de Lectura S 1a Coeficiente de Correlacion de PearsonYesenia AlbujaPas encore d'évaluation

- Regresion Lineal MultipleDocument16 pagesRegresion Lineal MultipleJorge SaldarriagaPas encore d'évaluation

- Evaluación VDocument12 pagesEvaluación VMedina AndreaPas encore d'évaluation

- Semana 7Document32 pagesSemana 7MISHELL CHANTALL AYLAS COTRINAPas encore d'évaluation

- Clase Teórica 7Document7 pagesClase Teórica 7Guadalupe GarciaPas encore d'évaluation

- Regresion Lineal Simple Estadística 1Document4 pagesRegresion Lineal Simple Estadística 1YOSHIKI HITOSHI SUN GUSHIKEN HUAMANIPas encore d'évaluation

- Guía de Estudio - Regresion Lineal - Parte 1Document11 pagesGuía de Estudio - Regresion Lineal - Parte 1Juan Pedro CabezaPas encore d'évaluation

- Covarianza y Correlacion PDFDocument7 pagesCovarianza y Correlacion PDFIgnacio Nicolas LunaPas encore d'évaluation

- CostosDocument7 pagesCostosWilians CruzPas encore d'évaluation

- Regresion Lineal SimpleDocument23 pagesRegresion Lineal SimpleAarón RivasPas encore d'évaluation

- Correlacion y Regresion Lineal Con EnlaceDocument15 pagesCorrelacion y Regresion Lineal Con EnlaceIrenePas encore d'évaluation

- Inferencial 1Document4 pagesInferencial 1Garcia Pinzon MoncerratPas encore d'évaluation

- Actividad 7 DiapositivasDocument10 pagesActividad 7 DiapositivasMayra Andreina MOLINA ALMEIDAPas encore d'évaluation

- ECONOMETRÍA1Document20 pagesECONOMETRÍA1DK NACHPas encore d'évaluation

- Ensayo 2 EconometriaDocument7 pagesEnsayo 2 EconometriaBRAYAN STIVEN CARVAJAL MONTOYAPas encore d'évaluation

- Guia de Ejercicios Prueba Global EconometriaDocument11 pagesGuia de Ejercicios Prueba Global EconometriaYari BugueñoPas encore d'évaluation

- Regresion LinealDocument23 pagesRegresion LinealEric ManuelPas encore d'évaluation

- Texto RegresiónDocument187 pagesTexto RegresiónWilmar GamboaPas encore d'évaluation

- Estadistica AplicadaDocument4 pagesEstadistica AplicadaAnjoPas encore d'évaluation

- 09-13-2019 221602 PM SESION 11Document12 pages09-13-2019 221602 PM SESION 11Hilber SifuentesPas encore d'évaluation

- UTN FRH PyE 2023 Guía 5 Enunciados y RespuestasDocument16 pagesUTN FRH PyE 2023 Guía 5 Enunciados y RespuestasCristian Brian ALMARAZ ROCHAPas encore d'évaluation

- Analisis de Datos BivariadosDocument8 pagesAnalisis de Datos Bivariadosdreic9 :pPas encore d'évaluation

- Sesion 9 Regresion y CorrelacionDocument17 pagesSesion 9 Regresion y CorrelacionRobert SiancasPas encore d'évaluation

- Tarea Regresion LinealDocument6 pagesTarea Regresion Linealtony_moctezumaPas encore d'évaluation

- 02 Estadística DescriptivaDocument40 pages02 Estadística DescriptivaAndrea GalendePas encore d'évaluation

- Estadística I: Tema 10 / Parte 2 Análisis de Regresión LinealDocument5 pagesEstadística I: Tema 10 / Parte 2 Análisis de Regresión LinealJuan Carlos Chavez MoranPas encore d'évaluation

- Tema 1 Regresión Lineal Simple y CorrelaciónDocument21 pagesTema 1 Regresión Lineal Simple y CorrelaciónEddy Tun CarballoPas encore d'évaluation

- Econometría I - Unidad 1Document8 pagesEconometría I - Unidad 1Adrian TejedaPas encore d'évaluation

- Estadistica InferencialDocument10 pagesEstadistica InferencialluisitoPas encore d'évaluation

- Análisis de Relación y CorrelaciónDocument22 pagesAnálisis de Relación y CorrelaciónLily Tantalean ToctoPas encore d'évaluation

- A.4 Regresion Lineal SimpleDocument38 pagesA.4 Regresion Lineal SimpleJessica SuastesPas encore d'évaluation

- CovarianzaDocument17 pagesCovarianzaDaniel Gomez Martinez0% (1)

- 2-Estadistica Desciptiva BivarianteDocument3 pages2-Estadistica Desciptiva BivarianteAnita Calderón OcañaPas encore d'évaluation

- Hoja 1 2021Document4 pagesHoja 1 2021Karolina GliwaPas encore d'évaluation

- 3 Ein9907 C6 LecturaobligatoriaDocument11 pages3 Ein9907 C6 LecturaobligatoriaFelipe SantiagoPas encore d'évaluation

- Estadistica Bidimensiona Martes 16 de FebreroDocument33 pagesEstadistica Bidimensiona Martes 16 de FebreroMesadesoporteIT SistemasPas encore d'évaluation

- Pauta EDocument6 pagesPauta EMarco Sandoval QuidelPas encore d'évaluation

- Ftema 15 Rlestimacion y ContrastesDocument10 pagesFtema 15 Rlestimacion y ContrastesMemo Ortiz (Angel Sin)Pas encore d'évaluation

- T6Document27 pagesT6Maria MedinaPas encore d'évaluation

- Razonamiento cuantitativo, 2ª edición: Notas de claseD'EverandRazonamiento cuantitativo, 2ª edición: Notas de claseÉvaluation : 5 sur 5 étoiles5/5 (1)

- Problemas resueltos de electromagnetismo. Volumen I: ElectrostáticaD'EverandProblemas resueltos de electromagnetismo. Volumen I: ElectrostáticaPas encore d'évaluation

- Algebra Lineal (Notas)Document146 pagesAlgebra Lineal (Notas)Orochimaru356Pas encore d'évaluation

- Reporte04 CBA 2020 1Document19 pagesReporte04 CBA 2020 1Aron Benito Pari MachacuayPas encore d'évaluation

- Andrie Marie AmpereDocument3 pagesAndrie Marie AmpereVeraly CoradoPas encore d'évaluation

- Cartografía, Atmósfera, RelievesDocument27 pagesCartografía, Atmósfera, RelievesJosé de la RosaPas encore d'évaluation

- Mat U3 2grado Sesion7Document9 pagesMat U3 2grado Sesion7kjirkasPas encore d'évaluation

- Cambios de Unidades Con Factores de Conversión 3 EsoDocument5 pagesCambios de Unidades Con Factores de Conversión 3 EsoAgripina1961Pas encore d'évaluation

- Mcu y McuvDocument8 pagesMcu y McuvJeff Huckleberry50% (2)

- CV ExampleDocument4 pagesCV ExampleJorge Luis Ortiz CcamaPas encore d'évaluation

- VectoresDocument18 pagesVectoresJorge SegoviaPas encore d'évaluation

- 8Document8 pages8Eduardo Salcedo FloresPas encore d'évaluation

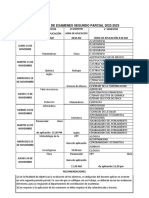

- Segundo Parcial 2022-2023Document1 pageSegundo Parcial 2022-2023Megan KeithPas encore d'évaluation

- 152 Ezine 152 PDFDocument385 pages152 Ezine 152 PDFAlfredo Juillet FrascaraPas encore d'évaluation

- Filaleteo - El Secreto Del Elixir de La InmortalidadDocument5 pagesFilaleteo - El Secreto Del Elixir de La InmortalidadVericuetoMental100% (3)

- EIA y Plan Manejo Ambiental Sismica 3D Bloque31Document468 pagesEIA y Plan Manejo Ambiental Sismica 3D Bloque31Ramon Diaz Tellez100% (3)

- Practicas Met ClimaDocument91 pagesPracticas Met ClimaSANDRA DEL AGUILA RIOSPas encore d'évaluation

- Universidad Nacional Del AltiplanoDocument43 pagesUniversidad Nacional Del Altiplanodersun04Pas encore d'évaluation

- Practica Catálisis ÁcidaDocument9 pagesPractica Catálisis Ácidacralex22Pas encore d'évaluation

- Exposicion de MatematicaDocument11 pagesExposicion de Matematicaevelyn patricia tejada llacasPas encore d'évaluation

- biomecanicaAlcalaEspaña PDFDocument10 pagesbiomecanicaAlcalaEspaña PDFrezavalasPas encore d'évaluation

- Análisis Combinatorio Ii 09.02.07Document5 pagesAnálisis Combinatorio Ii 09.02.07Edinsson R. Javier Villanueva67% (3)

- Taller Campo ElecDocument4 pagesTaller Campo ElecJose Manuel Molina CuaritePas encore d'évaluation

- ADN MATematicaDocument14 pagesADN MATematicaYaffa Barg KlocPas encore d'évaluation

- BombaDocument23 pagesBombaRenato CabreraPas encore d'évaluation

- Servicios Auxiliares en Las Industrias LacteasDocument7 pagesServicios Auxiliares en Las Industrias LacteasDavid Flores100% (1)

- Parcial Corte 1 - 03 2021Document2 pagesParcial Corte 1 - 03 2021Simon Daza JuradoPas encore d'évaluation

- Bases Mecánicas Del Movimiento (Modo de Compatibilidad)Document65 pagesBases Mecánicas Del Movimiento (Modo de Compatibilidad)Valeria Beatriz BarriaGonzalezPas encore d'évaluation

- Practicas Tiro ParabolicoDocument3 pagesPracticas Tiro ParabolicoFernanda GonzalezPas encore d'évaluation

- Centro de Gravedad MecanicaDocument2 pagesCentro de Gravedad MecanicaMariialex'z Wy VeguillaPas encore d'évaluation

- Practica IV. Energia MecanicaDocument2 pagesPractica IV. Energia MecanicaLeomar ReyesPas encore d'évaluation

- Cascarilla LadrilloDocument10 pagesCascarilla LadrilloMaria ElenaPas encore d'évaluation