Académique Documents

Professionnel Documents

Culture Documents

1 CoursOptimisationMath PDF

Transféré par

Abir Ay Ed0%(1)0% ont trouvé ce document utile (1 vote)

26 vues73 pagesTitre original

1_CoursOptimisationMath.pdf

Copyright

© © All Rights Reserved

Formats disponibles

PDF ou lisez en ligne sur Scribd

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

© All Rights Reserved

Formats disponibles

Téléchargez comme PDF ou lisez en ligne sur Scribd

0%(1)0% ont trouvé ce document utile (1 vote)

26 vues73 pages1 CoursOptimisationMath PDF

Transféré par

Abir Ay EdDroits d'auteur :

© All Rights Reserved

Formats disponibles

Téléchargez comme PDF ou lisez en ligne sur Scribd

Vous êtes sur la page 1sur 73

ensile

‘omer Se

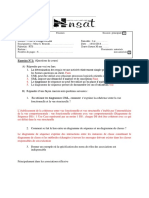

Ministére de I Education Nationale

Ecole nationale supérieure d'informatique

pour l'industrie et l'entreprise

ENSIIE, 1 square deta Résistance 91025 Evry cedex -Tel 01 69 36 73 50 Fax 01 6936 73 05

hupstonwwenstef - infoensie tr

Optimisation sans contraintes

Introduction......csseseeeee 2

1 Probleme, 2

2 infimum, minimum 22

3 Notations. : 3

Résultats généraux sur les extrema dune fonction... 4

1 Rappels A

2 Définitions des différents types 6

3 Conditions optimalité ........csseessseessnsereen 6

4 Points. selle. 7

5. Demarche por trouver ies extremums.. 27

Fonctions convexes. = 8

1 nsembles convexes. aa

2 Fonctions convexes.. 28

3 Minimisation d'une fonction convexe .. io

4. Application de la convexité. 10

‘Méthodes itératives pour Toptimisation sans contraintes.-...s..-2. 212

1 Méthode des coordonnées 12

2 ‘Méthode de plus forte pente (ou de Cauchy) 12

3 Méthodes. des directions conjuguées 4

4. ‘Méthode de Newton... :

5 Méthodes quasi-Newtoniennes..

(Optimisation sous contraintes

Projection, séparation,

1 Projection

2. Séparation.

ch Hyperplan d'appui, cdne normal

4 “Application des théoremes de séparation

Conditions d'optimalité sous contrainte.

Introduction.

Cone tangent

Conditions doptimalité ........

‘Caraciérisation du cBne tangent

Conditions doptimalité du Ler ordre (Kuhn et Tucker)

Conditions doptimalité du 28me ordre.

Résumé, =o

Dualité lagrangienne

1 Probiéme primal, probiéme dual

2. Relation entre primal et dual ....--..

3 Points selles

4 Relations entre optimums du dual et du primal et point selie

s. Relation entre points selles et conditions de Kuhn et Tucker

6 Résoluton du probleme dul

Méthodes primales..

ie Tatroduetion.

2 Méthode du gradient projet.

3. méthode du gradient rédui

Méthodes de pénalité et de barrire....

1 Introduction...

2 Méthode de’ pénalité,

3 Méthode de barriére.

Méthodes lagrangiennes.

1 Introduction...

2 Problémes avec contraintes dégalité

3 Problemes ave containtes degalté et dinggaité

4 Problémes quadratiques ae

OPTIMISATION SANS CONTRAINTES

Introduction

1. Problame

Soient f:D->R définie sur DCR" et XCD. On se pose le probleme: minimiser

f(x), x€X. Résoudre ce probléme consiste soit & montrer que min{ f(x): x € X} n'existe pas,

soit a trouver x" €X tel que f(x’ )=min{ f(x): xX} (Cestadire f(x")< f(x) VxeX),

x” est appelé solution du probléme tandis qu'un élément de X quelconque est appelé solution

réalisable ou admissible. f est appelée fonction objectif.

On définit les mémes notions pour maximiser. On peut remarquer qu'un probléme du type

maximiser peut se ramener A un probleme du type minimiser de la maniére suivant

-f puis prendre 'opposé du minimum (sil existe).

‘exemples:

- minimiser e* , x <0 n'a pas de solution.

- maximiser e* , x $0 admet x*=0 pour solution.

= minimiser x , x >0 n’a pas de solution.

- minimiser x , x>0 admet x*=0 pour solution.

Si X=D (on minimise f sur son ensemble de définition) le probleme est dit sans contraintes.

exemples:

- minimiser xf +x} ,(x,x2) € R*. Ici

= minimiser Log(x),x>0. Tei D=J0,+%>[

R

Si X#D le probléme est dit sous contraintes.

exemples:

- minimiser x} +3 sous la contrainte x +x) 21. lei X= {(x,,x2)€ Rs 4 +x) 21}

= minimiser Log(x) sous la contrainte x21. Iei X=[1,+f

2. infimum, minimum

Si le probléme a une solution x” alors inf{f(x): xe X)=min{ f(x): xe X}= f(x"). Par

contre, il se peut que I'infimum existe mais que le probléme n'ait pas de solution. Par exemple

inf {e* : x <0}=0 mais le probléme de minimisation correspondant n'a pas de solution, de méme

inf {x : x >0}=0 (cf. les exemples | et 3).

On dispose des théortmes suivants qui permettent d'affirmer Vexistence de minimum dans

certains cas précis.

Théoréme du maximum

Si f continue, si X compact alors min{ f(x): x€X)} et max{ f(x): x€ X} existent.

Corollaire (fonction coercive)

Si f continue et i = f(x) = +0, si X= R" alors min{ f(x): x € X} existe.

Ix

3. Notations

Dans la suite on adoptera les notations suivantes:

=r"

vxex

= B(x.) ={x)fx—x"| R, de classe C2 sur ouvert D, x" ,x € D tels que [x",x]c D, xe| *yx[tel que

FOD= FO) + VIC DOH) a) HR)

x Pty. OF

Oxy o Ox Ax} o) Ox OXy a

ot VF) Os

to PF). Pf)

Oy Ak, Axy Ox, OX,

Li Autre for

Pour tout xe B(x" ,r)0 (resp. <0) Vy #0 R”

~ indéfinie ssi Jy, z € R” tels que 4 (y)>0 et Q4(z) <0

exemple: A=(1, 7), Qq0)=y7 +4y3 -20v2 =(4-y2)? #39} est strictement positif

V(1,92) # (0,0). A et Q4 sont donc définies positives.

1.2.2.1, les valeurs propres

- A est semi-définie positive (resp. négative) ssi toutes ses valeurs propres sont 20 (resp. <0)

- A est définie positive (resp. négative) ssi toutes ses valeurs propres sont >0 (resp. <0)

- A est indéfinie ssi elle admet une valeur propre >0 et une valeur propre <0

ont Jes racines du polynéme caractéristique

exemple: les valeurs proptes de a-(1

det(A AN =(1-A)(4—A)=1 soit 2, = 583 ot Ay = 513. Ay et Ap sont strictement

positives et done A est définie positive.

1.2.2.2. les mineurs principaux

a) 412 An

a2 422 an a1,

Ia12 aq

Si A=

alors Ay = 411.4. = det(A) sont les mineurs

ee eee eee

principaux de A.

-A est définie positive ssi Ay >0 k ”

- A est définie négative ssi (~1)* Ay >0 k=

-si Ay >0 k=1,....n—1 et A, =0 alors A est semi-définie positive

-si (-1)F Ap 20k n—LetA, =0 alors A est semi-définie négative

~ si A, <0 et sim est pair alors A est indéfinie

exemple:

( 7 a) Ay =1,A7 =3.A est done définie positive

1.2.2.3. décomposition en carrés de formes linéairement indépendantes

Tl existe n réels a; etm formes linéaires 1; linéairement indépendantes tels que

2alv)= Saul)?

~A est semi-définie positive (resp. négative) ssi or; 2 0 Vi (resp. <0)

~ A est définie positive (resp. négative) ssi a; > 0 Vi (resp. <0)

- A est indéfinie ssi Jor; > 0, 3a; <0

La méthode de Gauss donne une expression de Q, en somme de carrés de formes indépendantes

2

Si aj #0, on a Qg(y)= (42) +q(y) od q(y) est une forme quadratique

0)

qui est bien linéaire.

Si ajy =ay9 =0 et ay #0, on a a 2 ($242)(£222)) «4639 ot g(y) est une

forme quadratique indépendante de y et de y2. Dans cette derniére expression on peut faire

iépendante de yj. On pose Jy (y

apparaitre la différence de deux carrés. et on a

Oi) , 840)? _ (20 (9) 7

ah ((B2+B2Y-(AO-BOP ea. on pose

+ 28D et vy 4) 00) qui sont bien linéaires et indépendantes

En utilisant ces formules on peut de proche en proche décomposer Q4 en une combinaison

linéaire de carrés de formes linéaires linéairement indépendantes.

exemple: a-(4, ra) 0400) = 9? +43 -2y192-

ay) =1#0 et la méthode de Gauss donne Q (y)= (91 ~y2) +3y3-

ayy = 4#0 et si on applique la méthode de Gauss en commencant par la variable yp on obtient

2 4 3y2

On0)=4(-v1 +492)? +397

La décomposition n'est done pas unique mais dans les deux cas on constate bien que les

coefficients «2; sont strictement positifs et que la forme est donc définie positive.

1

2. _Définitions des différents types d'extremum

f:DCR" > R, x" €D, on dit que f admet en x* un:

- minimum global sur D ssi f(x") $ f(x) xe D. Si l'inégalité est stricte pour x#x* on dit que

le minimum est strict.

= minimum local ssi 3B(x" ,€) tel que f(x") $ f(x) Vx € DO B(x" ,e). Si Vinégalité est stricte

pour x#x* on dit que le minimum est strict.

On définit de maniére analogue maximum global, global strict, local, local strict.

x* est dit point critique si Vf(x")=0.

remarque: x* minimum global => x* minimum local (de méme pour maximum)

La réciproque est vraic dans certains cas particuliers, par exemple f convexe (concave pour

maximum). Le cas des fonctions convexes sera étudié dans un chapitre ultérieur.

3. Conditions d'optimalité

Les conditions qui suivent sont établies pour des minima. Remarquant que tout x* maximum de f

est minimum de -f, on déduit facilement les conditions pour les maxima

3.1. conditions nécessaires d'optimalité

3.1.1. conditions du Jer ordre

f:DER" 5 R de classe C! sur D ouvert, si x” € D est un minimum local (a fortiori global) de

falors Vf(x")=0

3.1.2. conditions du 28me ordre

f:DER" > R de classe C2 sur D ouvert, si x” € D est un minimum local (a fortiori global) de

falors Hf(x") est semi-définie positive.

3.2. conditions suffisantes d'optimalité

3.2.1. optimalité locale

f:D CR" > R de classe C2 sur D ouvert, si x” € D est un point critique (Vf(x"

0) et si

Hf (x" ) est définie positive alors x* est un minimum local strict.

remarque: si on relache Ia condition Hf(x" ) définie positive A semi-définie positive alors x*

n'est pas forcément un minimum. Considérer par exemple f(x) =x? etx" =0

3

2, lobale

f:DCR" > R de classe C2 sur D ouvert, si x" €D est un point critique (Vf(x" )=0) et si

Vee D Hf (z) est semi-définie positive (resp. définie positive) alors x* est un minimum global

(resp. global strict)

temarque: la condition Vz. D Hf(z) est semi-définie positive est équivalente a f convexe sur

D. Le cas particulier des fonctions convexes sera abordé dans un chapitre ultérieur.

4. Points selle

f:DCR" = R de classe C2 sur D ouvert, si x” €D est un point critique (Wf(x" )=0) et si

Hf(x" ) est indéfini alors dy ,d> tels que f(x" + td) admet un minimum local strict en #=0 et

f(x" +14) admet un maximum local strict en t=0. On dit que x* est un point see

5. Démarche pour trouver les extremums

- recherche des points critiques

= pour chaque point critique x*,

- si Hf (x" ) est défini positif (resp. négatif) x* est un minimum (resp. maximum) local strict.

- si Hf(x" ) est indéfini x* n'est pas un extremum,

- si Hf(x" ) est semi-défini positif (resp. négatif) alors on ne peut pas conclure et il faut faire

une étude locale plus précise éventuellement avec un développement de Taylor & un ordre

supérieur.

exemples:

- f)=(x?=1),xeR

De Véquation f’(x) = 6x(x” -1y =0, on déduit les 3 points critiques 0, 1, -1

f"(0)=6>0 le hessien au point 0 est défini positif donc 0 est un minimum local.

77) = f"(-1)=0 les hessiens aux points 1 et -1 sont semi-définis positifs donc on ne peut pas

conclure. Une étude plus fine de f autour de ces points (voir le graphe) montre que ce ne sont

pas des minima.

‘On remarque que f est coercive donc elle posséde un minimum global qui ne peut étre que le

point 0.

= f(xi.x2)= xP -12ayx2 +823, (11,22) eR?

‘fadmet 2 points critiques (0,0) et (2,1).

Hf(0,0) est indéfini donc (0,0) n'est pas un extremum.

Hf (2,1) est défini positif donc (2,1) est un minimum local strict.

Par contre fn'admet pas de minimum global puisque lim f(x,,0)=

x=

remarque: la recherche des extremum globaux est plus difficile. L'obtention simple des minimas

globaux, par exemple, exige des conditions fortes sur f telles que convexité, coercivité.

(ot 2-1) #83

00843,

00043,

x*B-12*x*y48*y""3

1. Ensembles convexes

11. Définition

CER",C est dit convexe ssi Vx,yeC,VAE[0,1], (1-A)x+ AEC ie. [xy]EC , of

if.

bel (1-A)x+Ay:A €[0,1]}.

Par convention @ est convexe.

Remarque: Vx,y€C Vapplication f,y:[0,1]—> C définie par fyy(2) =x-+A(y—x) est continue

et par conséquent convexité est un cas particulier de connexité par arcs ol fy est affine.

1.2. Combinaison convexe

12.1

Soient un entier p21, x; € R"

Vélément de la forme YP. A;x; od DPA,

Définition

,2yesenPs ON appelle combinaison convexe de x1,2,.--5

| A; 20 i=

Exemple: tout point de [x,y] est une combinaison convexe de x et y (p=2 dans ce cas).

1.2.2. propriété

Soit Cc R", C est convexe ssi il est stable par combinaison convexe de ses éléments ie.

P Aix; €C, Vpzlentier, Vx; €C, VA; 20i=1,...,p tels que DPA; =1

in 4a ip i i q i

2. Fonctions convexes

2.1. Définition et propriétés

2 Définition

Soit f:CCR">R,C convexe, on dit que f est convexe ssi Vx,yeC,VA€[0,1],

S((l-A)x + Ay) (1-2) F(x) + (0).

On dit que fest strictement convexe ssi 'inégalité est stricte pour x#y et 4 <]0,1[.

On dit que fest concave (resp. strictement) ssi -f est convexe (resp. strictement).

Cette définition revient & changer le sens de linégalité dans la précédente définition.

exemple: la norme est une fonction convexe car |(1-A)x + Ay|<(1-A)lal|+ Ay] VA €[0,1]

2.1.2, Propriétés d'équivalence

Les 3 propriétés suivantes sont équivalentes:

- f convexe

+ SEL Aim) SDE Ailey) VA 20

déf

- Epif est convexe ot Epif eer) ECxR:f(x)Sa}

»p tels que DP,

2.1.3. Proposition

Si fest strictement convexe et si A; >0 i=1,, PA; =1 (Ai positifs strictement) alors on

a légalité f( Zhi Ain)=DP ;

2.1.4, Propriétés de stabilité

~ Si fi, fone» fic Sont des fonctions convexes définies sur un méme convexe C et si Of, , 2... 0%

sont des réels positifs alors on fi + Op fo +...t0rp fy est convexe. De plus si l'une des fj est

strictement convexe alors 0% f, + 12.fp +-..+ 0, fx est strictement convexe.

Ai f(x) ssi les xj sont égaux 2.42 (ie. x1=x2=...=xp).

= Si f:CCR" > R est convexe (resp. strictement convexe) et si g:f(C)c R— R est convexe

et croissante (resp. strictement croissante) alors ge f est convexe (resp. strictement convexe).

2

exemple: f(x) =el*l xe R” est convexe (décomposer en 3 fonctions).

2.2. Caractérisation des fonctions convexes différentiables

2.21 dre

téris

= f:CCR"R de classe Cl sur C ouvert et convexe, f est convexe ssi

F(y)2 f(x) + V(x) #(y—x) VaryeC. f est strictement convexe ssi l'inégalité est stricte

quand x4y.

Linterprétation géométrique de ce théoréme est qu'une fonction convexe est toujours au-dessus

de ses plans tangents.

- f:CCR"R de classe Cl sur C ouvert et convexe, f est convexe ssi

(¥f(y)- Vf(2)) #(y— x) 20 Wx, ye C. fest strictement convexe ssi l'inégalité est stricte quand

xey.

Dans le cas d'une fonction une variable, ce théoréme signifie que le gradient (la dérivée dans ce

cas) d'une fonction convexe est non décroissant.

2.2.2. Caractérisation au 28me ordre

f:C CR" >R de classe C2 sur C ouvert et convexe, f est convexe ssi Hf (x) est semi-défini

positif Vz eC.

exemple: f(x), ,23)=2x? + x3 +45 + 2x23 est convene.

remarque: si Hf(x) est défini positif Vx eC alors f est strictement convexe. Par contre la

réciproque est fausse. Considérer par exemple f(x)=x* (xe R). f est strictement convexe et

son hessien 12x? n'est pas défini positif en

9

3. Minimisation d'une fonction convexe

3.1. Propriété des minima locaux

Soit f:C R convexe, C convexe, alors tout minimum local de f est minimum global de f

sur C. Sif est strictement convexe et s'il existe un minimum local alors celui-ci est I'unique

minimum global de f sur C.

3.2. Conditions nécessaires et suffisantes d'optimalité

S:CCR" > R de classe C! sur C ouvert et convexe, x* € C est minimum global de f ssi x* est

un point critique (Vf(x")=0).

4. Application de la convexité.

4.1, L'inégalité arithmétique-géométrique (AG)

Soient x;,; 7 »m des réels positifs (strictement) tels que ))",6;=1 alors

7 ix; 2

=x,

?' (AG). Ily a égalité dans AG ssi xy = x2 =.

Exemple: n= 2, 5, = 8) =4, xyz S4x) +42) (x1 >0, x) >0)

écalité 7 i) on Véoalité é

Inégalité que l'on peut, dans ce cas, retrouver par: 0-<(4/x; xz)’ ob l'égalité est vérifiée ssi

xy =x

4.2. Programmation géométrique sans contraintes

défini

g:(R**)" — R est dit un posindme si g(x)=

réels quelconques.

exemple: g(x,x2) =a +272

¥

Un programme géométrique consiste en Ie probléme (noté PG) suivant:

minimiser un posinéme g(x) sous les contraintes x; >0 i=1,....7

Le dual d'un programme géométrique consiste en le probléme (noté DPG) suivant

A 5; >0 i=1,...,m 0)

maximiser v(5° =m (2 } sous les contraintes } 317" 6; =1 (2)

7 0455; = sn (3)

2.__ Relations entre un programme géométrique et son dual

théoréme de dualité:

Vx>0 et V5 vérifiant (1), (2), (3). g(x)2 (6).

10

théoréme:

uj (x

a(x*)

Si PG a une solution x* alors 6; = sm est une solution de DPG et

¥(5*)= (x4).

Exemples

x: 1

- minimiser x, +472 +— sous les contraintes xj > 0,2 >0

xP xy

6, -26) =0

5p 63 =0

Les contraintes du dual sont:

5, +5, +53 =1

61 > 0,62 >0,53 >0

dont l'unique solution est 67 -} 83

En utilisant a(x")=(9") =4 et les relations du type ui(x")= 5)e(x") i=1,2,3, on déduit

la solution x} =2, x

On pourrait retrouver cette solution en cherchant simplement les points critiques de la fonction &

minimiser mais il resterait & montrer que c'est bien un minimum global, ce qui est plus délicat

ni x

~ minimiser x, +27 sous les contraintes x, > 0,2 >0

aT

6-28) =0

5) =0

Les contraintes du dual sont:

6) +6 =1

61 > 0,8) >0

Le dual n'a pas de solution et donc le probléme n'a pas de solution (s'il en avait une, on saurait

caleuler une solution pour le dual).

u

X144*K2/ (x12) 41 /x2

x142*x2/(x1**2)

On considére dans ce chapitre le probleme: minimiser f(x), xR”

1. Méthode des coordonnées

1.1, méthode

On suppose ici fde classe C!

A chaque itération, on minimise f selon une variable, les autres étant maintenues fixées.

Soit un point initial x), on pose k=0, on fait:

1)

- choisir une coordonnée ou s'arréter. Soit i l'indice de Ia coordonnée choise.

= minimiser f(x(,....x).29,..4x) selon x,. Soit x7 Ja solution obtenue

- construire Ie point x49 =(20®,...27 x8 annx®).

~k=k+1

aller en 1.

Les fagons de choisit la coordonnée selon laquelle on minimise f,, sont multiples:

- choix circulaire: 1,2,....1,1,2,.

- aller-retour de 1 vers n puis de n vers 1

~ choix de la coordonnée correspondant & la composante du gradient V/(x") la plus grande (en

valeur absolue). C'est la méthode de Gauss-Southwell. Si la composante trouvée est de valeur

nulle, on s'arréte (on est en un point critique).

Liintérét des deux premieres méthodes est qu'elles dispensent de la connaissance du gradient au

point courant.

1.2. Propriétés de convergence dans le cas quadratique

Si f(x)= 3 *Axy—bex oA est symétrique, définie positive, soit x* unique minimum de f

(il existe, il est donné par x*= A~'b), soit E(x) = ge f(x) — f(x*). Si on applique la méthode

i) Ot Anas Amin sont

de Gauss-Southwell alors (a) sa(at|(1-

n-1

respectivement la plus grande et la plus petite valeur propre de A.

2. Méthode de plus forte pente (ou de Cauchy)

2.1. Rappels sur la dérivée directionnelle

Soit f numérique définie sur un voisinage V d'un point a, soit u un vecteur de norme 1, on

df f(atdu)- f(a)

appelle f’(aju)'= tim

la dérivée de f au point a dans la direction w .

430 a

Si fest différentiable en a alors f’(a;u)=Vf(a)*u

12

Dans ce cas supposons Vf(a)#0, alors le probléme, minimiser

, We(a)

f’(a;u) sous la contrainte Jul]=1, a pour solution u* =—

[vr]

Ce résultat montre que w*=-. re i est la direction de plus forte décroissance de f (en

partant du point a). Cest sur cette constatation que se fonde la méthode de plus forte pente.

2.2. méthode

On suppose maintenant f de classe C).

a partir d'un point x) on construit la suite de points s

(eH) = 0) = 1 y9(2) (20)

déf

ot 1 minimise 9, (t) = {x ~ 12 )) avec t>0

La suite s'arréte des que vex) 0

2.3. Quelques caractéristiques de 1a méthode

Les déplacements dans la méthode de plus forte pente sont orthogonaux c'est-a-dire pour tout

triplet de points consécutifs x), x*)), x(*2) on a (2 — xl) ) . beg — x(t)

La suite ( s(x )) est décroissante (strictement)

2.4. Propriétés de convergence

2.4.1, Convergence globa

Sifest coercive ie. | im f(x) =e, i existe une sous-suite de (x) convergente. De plus

bite

toute sous-suite de (x) convergente, converge vers un point critique de f

Si fest coercive et strictement convexe, alors la suite (x) converge vers l'unique minimum de

f.

2.4.2. Cas quadratique

Si f(x)= - *Ax—bex ol A est symétrique, définie positive, soit x* unique minimum de f

(il existe, il est donné par x*=A™b), soit E(x)=ge f(x)- f(x*) alors

3

Amax ~Amin A

(x!) <2(x Gms = Ain) ot Amaxs Amin Sont respectivement la plus grande et Ia

(max + Amin )

plus petite valeur propre de A.

Remarques:

Amax = Amin it és

= GRE mm <1 et on retrouve done le fait que la méthode converge vers x* (fest coercive

et strictement convexe), La méthode converge d'autant plus vite que Amar €t Amin Sont proches

Si Amin=Amax alors la méthode de plus forte pente trouve le mimimum de fen une itération i.e

x) 2x et cect vx),

~ La méthode de Cauchy converge plus vite que la méthode de Gauss-Southwell (voir méthode

des coordonnées) car on a les inégalités suivantes:

(esi) <(tey-(-) <(-) (5%)

3. Méthodes des directions conjuguées

3.1. méthode des directions conjuguées

3.1.1. Directions conjuguées

Définition: soit A une matrice symétrique, deux vecteurs non nuls d(0) et d(!) sont conjugués par

rapport 2 A ssi d e Ad =0

Si A est symétrique et définie positive, sid, d(D,..., d®)_ sont conjugués 2 & 2 par rapport 4A

alors d(), d(\),..., d@) forment une famille libre

3.1.2. méthode

La méthode s‘applique a la recherche du minimum de ax)= Fae art box ot A est

symétrique et définie positive

Soient d(0), d(1),..., d0"-1) conjugués 2 & 2 par rapport & A, & partir d'un point x) on construit

les n points x(®) suivants:

xD) 20 4 4®g® (K20,1,..n-1)

ot A minimise g(x + aa) (A quelconque)

q Gtant quadratique A) s'exprime simplement par:

a aM ea®

ao) =Vgcx)

Teags M8 Vac”)

4

directions conj

ged =0k n,i=0,...k-1 ot g =Vq(x) et x calculé par la méthode

des directions conjuguées.

(ny

On en déduit que g”) =0 et done que x minimise g(x).

3.2. méthode du gradient conjugué

Elle consti

it au fur et A mesure des directions conjuguées par rapport & A.

a partir d'un point x et de d =—g on fait:

xl) = 4g — =0,1,....0-1)

oe

pe "Dead

get) 2 gl) 4 pg

Le choix de AM) est tel que 4® minimise fx +d) (A quelconque)

Le choix de B™ est tel que d**) « Ad =0,

d®*0 et d® sont donc conjuguées. II s'avére que d**) et d® (i=0,...,k-1) sont aussi

conjuguées, Done Ia méthode donne loptimum en n itérations (d'aprés le théoréme des directions

conjuguées).

3.3. généralisation & une fonction quelconque

Ily a2 possibilités pour adapter Ja méthode des gradients conjugués a une fonction f quelconque:

- approximation quadratique od & chaque itération f est approximée par son développement au

second ordre.

~ la descente linéaire od & chaque itération l'on recherche effectivement fe minimum dans la

direction d® courante. Si de plus on utilise une expression de 6“ en fonction du gradient, la

méthode présente I'avantage de n'utiliser que les dérivées premiéres de f (elle évite le calcul

ef

F qui est déduite du

;

et

(ie)

coiiteux du Hessien en chaque point). Liexpression utilisée est B'

cas quadratique.

Pour assurer la convergence de la méthode, il est nécessaire de r

Ja direction de déplacement par lopposé du gradient courant (comme a T'nitialisation).

Is

méthode de l'approximation quadratique:

1) a partir d'un point x© et de d =-g, k=0, on fait:

P Pp

2)

We ® og

d® oHg(x® a

lH) 2 2) 4 gg

ty 8h ete(x® a

~~ g® + Hf(x® )a®

d&) =D 4 gg

si k+1=n alors x =x alleren 1, sinon k= k-+1 alleren 2

-g® og®

I Hx dh

ae minimise f(x + aa (A quelconque), I'expression de B® est remplacée par

Dans la méthode de descente linéaire, la ligne A) = est remplacée par

eon

br

pe

4. Méthode de Newton

On suppose maintenant f de classe C2.

‘A chaque itération de la méthode, on approxime f par son expression en fonction des 2 premiers

termes du développement de Taylor:

Sa (2)= fx y+ V7(x)(x—a®) Ax Jo {x J[x-2®)

et on recherche le point critique de cette approximation fy (x) qui sera le point suivant:

2D 2 ~ f(x y vex).

1

Si g(x) est définie positive et si ex }e0 alors —Hy(x“) vex) est une direction

suivant laquelle f décroit (direction de descente).

Ily a des variantes possibles de la méthode:

= xD =) A Hp(x®) We(x) on 2 (de signe quelconque) minimise f dans la

direction —Hg(x® y vex).

16

0 =) 3 (H7(x) +21) Y7(x) ot e® est choisi de sorte que

(r(x) +22) soit définie positive et on 220 minimise f dans Ia direction

-(Hr(2®) +21) v7(x®).

Liinconvénient majeur de la méthode de Newton et de ses variantes est le calcul du Hessien.

5. Méthodes quasi-Newtoniennes

5.1. équation de Ia sécante

On approxime I'inverse du Hessien par une matrice S“* qui vérifie I'équation

HD) _ 7) = gl) (v(x? )- v(x ) issue du développement de Taylor & ordre 1 de

Vf(x).

Les desiderata sont: $“*) symétrique (comme T'inverse du Hessien) et simple & mettre & jour.

Liidéal serait qu'elle soit définie positive pour fournir des directions de descente de f.

notations:

agg

- soient a et b 2 vecteurs colonne, on note a@b = ab* le produit tensoriel de a et b . Le résultat

est une matrice.

ae def

a®) "= yD _ © Je déplacement et y® = Vex) — V(x) la variation du

gradient.

5.2. correction de rang 1

On utilise Ja mise a jour suivante: S#t) = 5 + aa @ a

Pour satisfaire l'équation de la sécante, il suffit de prend

2 g® — sy ® of oe)

yt e(a® —sOyO

Le probléme de cette mise & jour est I'éventuelle division par 0. Cependant dans le cas ot fest

quadratique, si il n'y a pas de division par 0, inverse du hessien est atteint en 7 itérations.

7

méthode:

soit un point x, 5 = 7 (initialisation)

x) = x) — 4Msy7(x) on A (de signe quelconque) minimise f dans la direction

-s©v4(x)

(a® -sy®)

(a® -s®y®)

gh) — 5) NE -

+(a® = sy)

kek+1 et réitérer.

5.3. correction de rang 2

5.3.1. _ méthode DFP

(kel)

On utilise Ja mise a jour suivante: S' SY 4 a%a® @a® + pOLM @ pO

Pour satisfaire l’équation de la sécante, il suffit de prendre:

a® =d®, 5® =s®y® et g®

yO. sOyH

Ces formules présentent les propriétés suivantes:

si Ss est définie positive, si x n'est pas un point critique et si

249) 2H) _ 4@sV p(x) on A minimise F( -as®yp(x)), A>0 alors:

- les dénominateurs ne sont pas nuls

- SE) est définie positive

Dans le cas od fest quadratique (hessien constant A défini positif) les directions de déplacements

sont conjuguées 2 a2 par rapport 4 A et S =A7!, ceci WS“) définie positive. Ce qui entraine

que le minimum est trouvé en au plus n itérations.

méthode:

soit un point x), s =1 Gnitialisation)

® — 2s®yp(x) od A® (positif) minimise f dans la direction — SVs (x)

sD = Sy @® @d® _sOy® @sHyO

yO ed yO. sOO

k=k+1 et réitérer,

5.3.2, méthode BEGS

On peut, a la place d'approximer I’inverse du hessien, approximer le hessien. Les matrices

approximation doivent satisfaire l'équation de la sécante (cette fois inversée):

18

DED (xD — .O) = 94( 26) -y4(x) cos DENAH 258)

y®, @® jouent un role symétrique par rapport la méthode DEP. Done la formule de mise &

jour est:

Mey®© pWOg® @ pHa

yOod® Gg. poy

De) = p®

Si Ton prend I'inverse de chaque c6té en appliquant 2 fois Ia formule de Sherman-Morrison

(Ata@by =A! Aces on obtient la formule de mise a jour suivante, approximant

inverse du hessien:

st) g(t) ( 02s se ed® d® @sHy® +5@yH @q®

yO ed®

Cette formule est la base de la méthode BFGS.

Liexpérience montre que cette méthode est moins sensible aux imprécisions de calcul (lors de la

minimisation unidirectionnelle de f) que DEP. Les calculs approchés dans DFP, font que $+!)

n'est pas toujours définie positive,

19

OPTIMISATION SOUS CONTRAINTES

Projection, séparatiol

1. Projection

1.1. Définition

Soient CCR", xe R", x” eC

el que |x ~ x"| = inf {Ix yl:y €C}, x* est appelé projection de

x sur C.

x*, sil existe, est le point de C le plus proche de x. Par exemple, si x est dans C, x*

1.2, Projection sur un convexe

Soient Cc R", xR", x* eC, x* est projection de x sur C ssi ( * =x)e(x" )so Vee.

La caractérisation s‘interpréte en disant que les vecteurs (x~ x") et (y—x") forment un angle

obtus a, Rappetons que: (x-x")»(y—")=cos ax—x"|]y—x"]. Voir figure 1

x

Le

figure |

Dans le cas particulier d'un sous-espace L de R" (un sous-espace est convexe), en prenant

y=z+x" puis y=—z +x", on retrouve la caractérisation connue: (x° -x)ez=0 Vee L. Voir

Ja figure 2.

x

be

°

figure2

2.2. Unicité

La projection sur un convexe, si elle existe, est unique. Cela découle, directement de la

caractérisation.

1.2.3. Existence

La projection sur un fermé de R” existe. Pour le démontrer, on se raméne & un probléme de

minimisation sur un compact.

a

2. Séparation

2.1. Demi-espaces

Dans R” , soit un hyperplan H={x:pex=a} p40, on note Ht ={x:pex>a} et

:pex a> pexy

- H sépare fortement $1, S2 ssi Je >0,Vxy €S1,Vxq €Sp, perp 2a+e a2 pexy

2.3. Séparation d'un point et d'un convexe

2.3.1. conve: 1é

théoréme: x@C, C convexe, fermé, non vide, il existe H qui sépare fortement x et C ice.

Sp #0, a, pex>azpey WyeC (e=pex—a).

2.3.2. _convexe quelconque

théoreme: xC, C convexe, non vide, il existe H qui sépare largement x et C ie.

Sp #0, pexzpey VyeC (a=pex)

2.4. Séparation de deux convexes

‘Théordme: Soient C1 et C2 2 convexes de R", non vides, Cy C2 =@, alors il existe un

hyperplan qui sépare largement C1 et Co ie. p40, pox; 2 pexz Vx, €Cy,Vx2 €Cp

(prendre o: = inf {pe x1: xy €C)}).

Pour le démontrer, on se raméne a la séparation d'un point (en l'occurence 0) et d'un convexe (en

Toccurrence C2 - C1).

Corollaire: Soient C1 et C2 2 convexes de RM, non vides, Cy Cz =, alors il existe un

hyperplan qui sépare largement C1 et C2.

En effet, H7 ={x9: @2 pe xp} est fermé. Done, si @2 pexg Wx €Cp est vérifié c'est-d-dire

Cy CH™ alors Cy =Cy CH™ est vérifié et done a2 pe x7 Wx € Cp. Il suffit par conséquent

de séparer Cj et Cy (ce dernier étant convexe).

3. Hyperplan d'appui, céne normal

Rappel et notation: $< R" , on note aS la frontitre de $. On rappelle que aS = 5 -S.

Définition: Soit Sc R" et xe dS. Un hyperplan H={y:p*y=pex}, passant done par x, est

appelé hyperplan d'appui (en abrégé plan d'appui) de S en x ssi SCH* (i.e.

pey2 pex VyeS) ou bien SCH™ (ie. peyspex Wye).

Définition: Soient Sc R”, xe R". N(S,x) = {p: pe yS pox, Vy eS} est appelé céne normal

de Senx.

Verifier que c'est bien un cOne (ie. stable par multiplication par un scalaire positif).

Si xe alors N(S,x)={0}. Pour le voir prendre y—x= ep €>0 (¢ suffisamment petit) alors

2

lel" so.

Exemple: H = {z: pez= a} (p#0) un hyperplan et x © H, alors N(H,x)={Ap: 2 € R}.

Théoréme: Soit C convexe de R” et x € JC alors il existe un plan d'appui de C en x.

En effet {x} C= done il existe un hyperplan H qui sépare largement x et C (prendre

G.= {x}, Cy =C et appliquer le corollaire précédent sur la séparation de deux convexes).

4. Application des théorémes de séparation

4.1, théor’me de Farkas

coordonnées. Alors

Soit A une matrice m lignes, n colonnes et A’ sa transposée, ¢ un vecteu

un et un seul des deux systémes suivants a une solution:

systéme 1 (inconnues x): Ars0,cex>0,xeR”

systéme 2 (inconnues y): A'y=c, y20, ye R™

Si le syst#me 2 a une solution y , en multipliant scalairement y par Ax , on déduit que le syst@me

I ne peut pas avoir de solution.

Si le systéme 2 n'a pas de solution on sépare fortement C={z: z=

y, y2 0} convexe, fermé et le

point c. La normale p du plan de séparation H = {z: pe z= a} vérifie les conditions du syst8me 1

en raison de la spécificité de C.

Le théoréme de Farkas s'énonce au:

(Ax <0 = cex<0)e(3y20c=A'y)

Corollaire

Soit A une matrice m lignes, n colonnes, B une matrice I lignes, n colonnes, c un vecteur An

coordonnées. Alors un et un seul des deux systémes suivants a une solution:

syst8me 1 (inconnues x): Ax <0, Br=0,c#x>0,xeR"

systéme 2 (inconnues y, z): A‘y+B'z=c,y20,yeR",zeR'

2B

A

Il suffit d'appliquer le théoréme avec une matrice A remplacée par la matrice m+2/ lignes ( B ]

-B

dont la transposée est (A‘ BY - BY).

4.2. Théoréme de Gordan

Soit Aj une matrice m lignes, n colonnes, soit A? une matrice I lignes, n colonnes.

Soit le systéme 1 (inconnues x): Ayx <0, Agx=0,xER"

Soit le syst#me 2 (inconnues y, z): Afy+ Ajz=0, y20, yeR™,zER’, (yz) #(0,0)

Si le systéme 1 n'a pas de solution alors le systéme 2 a une solution,

Pour le montrer on sépare les 2 convexes C,={(i,up):m =Ayx, uy =Apx,xeR"} et

C= {(4,0): v1 <0}. La normale (pj, p2) # (0,0) du plan de séparation vérifie les conditions du

systéme 2 en raison de la spécificité de Cy et C2.

4.3. Sous-gradient

Définition

Soient f convexe définie sur un convexe C, ¥¢C. On dit que & est un sous-gradient de fen ¥

ssi f(x)> f() +E 0(x—%) We.

De manigre symétrique, on définit un sous-gradient pour une fonetion concave en inversant le

sens de l'inégalité précédente.

Exemple: si f convexe est de classe Cl et si FC, on a montré que

{()2 f)+ VP) (x—¥) Vee C. Done le gradient est un sous-gradient.

Dans la suite du paragraphe il est sous-entendu que fest convexe.

Théoréme

Soient f définie sur un convexe C, ¥€C. Tl existe un sous-gradient de f en Z.

Pour le montrer on remarque que Bpi(f) 2 (xy) CxR: S()S y} est convexe et que

(%,f(@)) € JEpi(f). On en déduit qu'il existe un plan d'appui de Epi(f) en (¥,f(%)) ie. il

existe (E,u)eR"XR tel que (x, f(¥))*(E,u)2(xy)*(E,u) V(x») € Bpi(f) soit encore

FeE+ fHmexeE+ yu V(xy)e Epi(f). La spécificité de Epi(f) et le fait que ¥ soit

intérieur 4.C impliquent que 42 <0. On déduit alors que -Lé un sous-gradient def en ¥.

Définition

Leensemble des sous-gradients de fen ¥ est appelé sous-différentiel de fen ¥ et noté f(z).

‘Théoréme

Sif est différentiable en ¥ €C, le sous-différentiel en ¥ comporte un seul élément a savoir le

gradient au point x.

24

1. Introduction

Soient f:D— R définie sur Dc R" et ScD (inclusion stricte). On considére le probleme (P)

minimiser f(x) x¢S.

S est le plus souvent décrit comme ensemble des points vérifiant un nombre fini dinégalités et

d'égalités appelées contraintes:

S={xeR": g)(x)S0i=1,....m, hy(x)=0 i=1, .P}

Suivant le cas f(x), g;(x), hj(x) seront de classe C! ou C2,

Pour le probléme (P), minimiser f(x) x €S, on dit que x* est:

- solution, ou encore minimum global, de (P) ssi f(x" )< f(x) Vx eS. Si l'inégalité est stricte

pour x#x* on dit que le minimum est strict.

= minimum local de (P) ssi 3B(x" ,e) tel que f(x" )< f(x) Wx 57 B(x" ,e). Si Vinégalité est

stricte pour x#x* on dit que le minimum est strict.

Un point x quelconque de S est appelé solution réalisable.

2. Céne tangent

Définition

Soient SCR", yER",xeS. On dit que y est tangent 4 S en x ssi il existe les suites

xp €S, Ay >0 telles que x, > x et Ay(x_ —x) > y.

On note 7(S,x) ensemble des y tangents aS en x

Propriétés: T(S,x) est un céne, contenant 0, fermé. De plus si x € S alors T(S,x) = R"

= {re R:x 20,1, 20}, x (3) @>0, xe

1

Exemple: . Ona r-( : Jerts.a) En effet

es

{+ Dhan = £s0,xg 5 VEEL xg 0 Ag (xe 2) 9Y

3. Conditions d'optimalité

3.1. Com

Si.x* est un minimum local de (P) alors Vy € T

jons_nécessaires

Exemple: soit (P) minimiser (x)= (x +1)? +(a) +1)°, xe S= {xe R*: x 20,x, 20}. Pour

-1

x=(§) a>0, y-(p Jets et Vf(x)*y=-2(a@+1)<0. Done x ne vérifie pas la

28

condition nécessaire. En effet, on voit sur la figure 1 que tout déplacement de x vers lorigine

améliore la valeur de la fonction objectif.

os

Les cerlesconcentigues sont es courbes de niveau def

ice (x,fe=c) oll es une constante

figure 1

Diaprés les propriétés du céne tangent, si x" €S alors 1(5,x") =R", Dans ce cas la condition

doptimalité devient vs(x")= 0. On retrouve la condition établie dans le cas sans contraintes. Le

point est intérieur donc les contraintes n’interviennent pas.

3.2. Conditions suffisantes

Si fet S sont convexes. Soit x" eS tel que V/(x")ey20 Wye 7(S,x") alors x” est un minimum

global de (P).

2

exemple (suite): T(S,0)={y: y; 20, y, 20} (cf. exemple paragraphe suivant). Vf(0) = () et

Vy €7(S,0) ¥f(0) *y=2(y, + ¥2)20, la condition d'optimalité est donc vérifiée. f et § étant

convexes, cette condition est suffisante et origine est minimum global. Ce résultat peut se

vérifier sur la figure 1.

Caractérisation du céne tangent

4.1. Introduction

On considére maintenant $= {x: g;(x) SO i=1,....m, hj (x soso Pf

Soit x eS, 1(x)={i: g(x) =0} les indices des contraintes d'inégalité saturées en x.

On définit F(x) = {y: Vgi(x)*y 0 ie I(x), Viy(x)ey=0i=1,....p}.

théoréme: T(S,x) ¢ F(x).

I! serait intéressant de savoir s'il est possible que T(S,x)= F(x) car dans ce cas on pourrait

exprimer la condition nécessaire d'optimalité en fonction des gradients de f(x), g;(x), lij(x).

définition: x € S, on dit que x est qualifié si T(S,x) = F(x)

4.2. Contraintes d'égalité

26

définition: V'espace tangent a Sen xe S est

E(S,x)={y: 3y:R— R" C! sur Fouvert contenant 0, (1) S, 7(0)= x, 7'(0)=

proposition: pour tout xe S, E(S,x)CT(S,x).

En effet, pour & suffisamment grand, les suites x, = 7(}), 4x =} répondent aux critéres voulus.

théoréme: x € S, si Vij(x) (i=1.....p) sont linéairement indépendants alors x est qualifié,

démonstration

On montre que F(x) c E(S,x). Soit y € F(x).

Pee) Poy

xy Ox,

Notation:

ak

FE) FEO)

On considare le systéme de p équations & p+1 inconnues (t,w): Hx $y +(H(n)'

(0,0) est une solution puisque h(x) =0.

La matrice jacobienne du systéme par rapport & w au point (0,0) est 2¢(x)(24(x))'.

Elle est inversible (conséquence des gradients linéairement indépendants): d'aprés le théoréme des

fonctions implicites, le systéme d'équations admet une solution (t, v(t) pour t dans un voisinage

ouvert de 0. En particulier w(0)=0.

w(t) est Cl et on obtient sa dérivée en 0 en dérivant le systtme par rapport a £

2(x)y + BCy(*C9)'w'O=0

Mais 22(x)y=0 par définition de y , ce qui implique w’(0) =0 (solution unique).

Finalement 7(¢) = x-+1y +(34(x))' w(z) est dans $ et C! pour ¢ dans un voisinage ouvert de 0,

(0) =x et 7’(0)=y.y satisfait les conditions requis

4.3. Contraintes d’égalité et d'inégalité

On considére S={x: g;(x) $0 i=1,...,m, hj(x)=0 i=1,...,p}.

On note F(x)={y: Vg; (x)*yS0 ie I(x), Vij(x)*y=0 i=1.....P}

On rappelle que I(x)={i: g;(x)=0} est l'ensemble des indices des contraintes d'inégalité

saturées en x.

On définit Fy (x)= {y: Vei (x) y <0 fe L(x), Vij (x)ey=0 i= 1... p}

Qualification de Cottle

théoréme: x€S, si Vhj(x) (i=

qualifié.

..p) sont linéairement indépendants et Fy (x)#@ alors x est

27

démonstration

Si on montre que Fo(x)0 telles que xz >x et

Aplxy-x) 9 y-

A partir dun certain rang les xj €5. En effet, ils vérifient:

= les contraintes g;(x) <0 i€ I(x) en raison de la définition de y (faire un développement de

Taylor a 'ordre 1 de g;)

- les contraintes g;(x) $0 i¢ I(x) car.x vérifie strictement ces contraintes.

y vérifie les conditions requises pour appartenir T(S, x)

4.4. Autres critéres de qualification

On propose ici des crittres qui impliquent le critére de qualification de Cottle mais qui sont de

vérification plus simple.

Qualification de Slater

théoréme: xe S, si

- gj (x) convexe i€ I(x)

= hy(x) affine i=1,..., p et si Vhj(x) (7

= Axo gi(xo) <0 ie M(x), hi(xo) =

alors x est qualifié.

On montre que x9

Qualification de V'indépendance linéaire

théoréme: x eS, si Vhj(x) (

x est qualifié,

On montre, a I'aide du théoréme de Gordan, que si Fy (x) =@ alors les gradients sont liés.

p) sont linéairement indépendants

P

x€ F(x)

sp) » Vgi(x)(ie I(x) sont linéairement indépendants alors

Exemple: cherchons le cOne tangent de S={xe R?: (x)=

Vorigine. L’origine sature les 2 contraintes d'inégalité et 1(0

x1 $0, g9(x)=-x2 SO} en

{1.2}

-1 0

Vai(0)=[ 5 -Ve2(0)=|_,] sont linéairement indépendants done

T(S,0)={y: Vey (0)* y $0, Vg, (0)eys0}={y: y, 20, 2 20}.

5. Conditions d'optimalité du ter ordre (Kuhn et Tucker)

On considére le probleme (P) minimiser f(x) xeS avec

S={xER": g(a) SO i=l. hy(x)=0 i= hep} Gah de classe Cl),

28

5.1. Conditions nécessaires

Théoréme:

Si x* est minimum local de (P) et six* est qualifié alors 3A; i€ I(x"

A, 20ieT(x")

Wh") + DA Ves (x) + EP

elt")

HiVh (x")

Pour le montrer on utilise la condition d'optimalité exprimée avec les vecteurs du céne tangent &

Senx* qui maintenant est caractérisé avec les gradients des contraintes. Le théoréme de Farkas

permet de conclure.

Remarque: x* appartenant & S et point critique (Vf(x")=0) et 2=p=0 vérifient ces

conditions. Mais ce n'est généralement pas I'unique solution.

On utilise souvent la formulation équivalente:

Si x* est minimum local de (P) et si x* est qualifié alors 34; i=1,...,m, 3m; i=1,....p ta.

A, 20 i=l.

(K.T.) Vx") + DR AvVai (2) + DE

Rig(x")=0 i=1,...

H;Vh;(x")=0

Ces demiéres conditions A;g;(x"

d'inégalité non saturées car g,(x")<0= A, =0 , et done de retrouver la formulation initiale.

=0 permettent d'annuler les A; associés aux contraintes

Sachant que Vi A;20,g;(x")o} les indices des inégalités saturées (par x*) dont le multiplicateur

de Lagrange associé est non nul (appelées contraintes non degénérées).

Puis on considére les ensembles de points x et de vecteurs y:

g(x) $0 ie M(x") \ I(x")

~ St(x")={ x: g(x) =0 ie I(x")

h(x) =0 i=].

Vg(x")eys0 fel") \ I(x")

. FY(x")=F(2*)a{y: Vgi(x")ey=0 ie I*(x*)}=ty: Vg(x )ey=0 ie I(x")

Vi(x")¢y=0 =P

Notons que x” S* (x"). Si x* vérifie la qualification de Vindépendance linéaire alors F*|

coincide avec 7(S*(x"),x") le cdne tangent & S*(x") en x*.

Théoréme

Si x* est un minimum local du probléme (P) et si x* qualifié alors JA,f1 tels que x", A,p

vérifient les conditions du ler ordre (K.T.) et tels que le hessien de la fonction de Lagrange en

x",A,f est semi-défini positif sur le céne tangent a S*(x") en x* ice.

yoHL(x',Aw)y20 Wy € 7(S*(x*),x").

remarque: si x* vérifie la qualification de l'indépendance linéaire alors 1(s*(x").x") =F*(x")

Cette formulation explicite du cOne tangent permet en pratique la vérification de la condition

nécessaire.

remarque: dans le cas d'un probleme comportant uniquement des contraintes d’inégalité, si

a(x") =@ alors 4=0 et la fonction de Lagrange coincide avec f. La condition devient Hf(x")

semi-défini positif (partout).

démonstration du théoréme

VyeT(S*(x"),x") , Ax, € S*(x")s0y > 0.x, 9 x", (x, 2") > y-

Sachant que les conditions du ler ordre (K.T.) impliquent 2, =0 Wie I(x"), les contraintes non

saturées par x* n'interviennent pas dans la fonction de Lagrange. Il en est de méme des inégalités

saturées d’indices i € I(x*) \ I*(x*) car dans ce cas aussi 4=0. On a:

31

L(x,,A,H)= L(x". 2,n) + VL(x"

+4 (xp — 2") 9 HL( x" A,u)(% 2"

+z —x'[Pe(m -2')

Les conditions du ler ordre impliquent VL(x", 2,1) =0

Pour & suffisamment grand, x, €S (car xz tendant vers x*, vérifie alors les contraintes non

saturées par x*) et donc f(x)-f(x")20 et par conséquent

Hla — x") H(x"Asn)(34 —x") +foxn 2" eae —2")20

On multiplie cette inégalité par a? et on passe a la limite (k > ©).

A,m)e (x =

ES) = Ux, Aw

= f(x) et x" eS, A, w vérifiant (KT) => E(x", Au) =

6.3. Conditions suffisantes

Pour x” €S, A, jt vérifiant les conditions nécessaires du ler ordre de Kuhn-Tucker, on

considére les ensembles:

- T*(x*) indices des inégalités saturées de multiplicateur de Lagrange non nul

- St(x*) et FY(x")

définis plus haut pour les conditions nécessaires (du 28me ordre).

Théoréme

Soit x” €S. Si x”,A, ul vérifient les conditions nécessaires du ler ordre (K.T.) et si le hessien

de la fonction de Lagrange en x",A,u est défini positif sur F*(x") c'est-a-dire

yeHL(x",2,u)y>0 Vye F*(x") (740) alors x* est un minimum local strict du probléme (P).

Remarque

Si x* vérifie la qualification de l'indépendance linéaire alors T(s*(x").x ) (x"). Dans ce

cas l'ensemble sur lequel la positivité du hessien de la fonction de Lagrange doit étre vérifiée est

Je méme dans les conditions nécessaires et dans les conditions suffisantes. Sinon l'ensemble des y

pour lequel le hessien doit étre défini positif s‘agrandit dans les conditions suffisantes car le céne

tangent 7(S*(x"),x") est inclu dans F*(x") mais Végalité n'est plus garantie.

démonstration du théortme

= Supposons que x* ne soit pas un minimim local strict: Vk 3x, (#x")e B(x", L) AS tel que

S(%,)$ f(x"). On construit ainsi une suite x, de S qui tend vers x" telle que f(x,)< f(x")

EI done [yy

existe une sous-suite qui converge. Pour simplifier les notations supposons que la suite y, elle

pour tout k, Posons yy = 6%, (xz—x") avec ay, La suite y, étant bornée il

méme converge vers un point y. Alors ye 7(S,x") (,, 0% remplissent les critéres voulus)..

- On a yeT(S,x")c F(x"), montrons que ye F*(x"). Pour cela il reste & montrer que

Vaj(x")ey=0 iel*(x") yeF(x’) et les conditions (K.T.) entrainent

W(x Jey=— LAVei(x")ey- LE meV x") LAVei(x")ey20.

ita) icles")

Par ailleurs f(x,)< f(x") pour tout k entraine que Vf(x")ey<0. Par conséquent

YAVe;(x")ey=0. La non-positivité de chacun des termes de la somme entraine

els")

ANgi(x" )*y=0 ie I(x’) et finalement Vg,(x")*y=0 i¢ I*(x').

- Montrons que le hessien de Ja fonction de Lagrange n'est pas défini positif sur F*(x")

U(xps Asm) = L(x" Asn) =S(eg) +2 9 ea) ~ F(x") <0

Les conditions du ler ordre impliquent V(x" ,A,12)=0.

Par conséquent:

L(xy,A,M)—L(x",A,m) = F(x, — x") ® HL(x",A,)(xp -x") + [4 2" e(e -x") 0

On multiplie cette inégalité par of et on passe A la limite (kee). On en déduit que

yeHL(x",A,u)y0 alors de méme

(-y)* HL(x",2,n)(-y)>0 et le vecteur -y est de l'autre c6té de I’hyperplan de normale

Vaj(x") c'est-a-dire Vg)(x") #(-y) 20.

Exemple: considérons le probléme minimiser —x,x, sous la contrainte }x7 +423 <1

Les conditions nécessaires du ler ordre sont:

A>0 (1)

{a )aG)-0

A(dx? +423 -1)=0 @)

ler cas :A =0. (2) implique x, =

2eme cas: A> 0. (3) entraine x? +x} =2 (4). (2) entraine x, = Axx, = Axy. On en déduit en

|, (1) impose l'unique solution 2 =1. On en déduit x, =x, qui avec (4)

x= Let x) -1.

Vérifions les conditions du second ordre.

Pour le point (3) la contrainte n'est pas saturée. Par conséquent le hessien de la fonction de

0

1

Lagrange en x, =x, =A=0 coincide avec le hessien de f et 111(0,0,0)=~{ ) doit étre

semi-défini positif sur R2. Ce n'est pas le cas done (3) nlest pas un minimum,

Pour le point (j), F*(i)={9: 91 +92 =0}. Le he

=1 de Ia fonction de

jen en x) =x,

Lagrange est HL(I,1,1)

2y,¥2 = 01-2)? =n?

33

Cotte quantité est positive ou nulle et s‘annule seulement pour y,=0. Done le hessien de la

fonction de Lagrange est défini positif sur F* (i) _ On aun minimum local strict,

Incidemment Ie point (i) vétifie la qualification de lindépendance linéaire donc le céne tangent &

la surface {x: xf +x} =2} ence point est {y: y, +y2 =0}.

Pour le point (i) les résultats sont identiques.

Diautre part ensemble § des solutions réalisables est compact. La fonction & minimiser étant

continue, le probléme admet une solution nécessairement parmi les minimum locaux {(t).-(i)}-

Les deux points donnant la méme valeur ce sont les deux solutions du probléme.

7. Résumi

On peut observer une certaine symétrie entre le role joué par f et ses dérivées dans le cas des

problémes sans contraintes et la fonction de Lagrange et ses dérivées dans le cas des problémes

sous contraintes. Les conditions d'optimalité (locale) sont résumées dans le tableau suivant.

[problemes sous contraintes

Conditions foptimalité [problemes sans contraintes

[fonction a considérer | f(x) L(x A [l)=

f(x) te g(x) + peoh(x

-A20

conditions nécessaires }_ yp(x" Unlat

(er ordre) Te We(x",An)=0

= Aeg(x')

conditions ncessares du Ter onde

conditions nécessaires

(28me ordre)

= f(x") se

fini posit

~ conditions néoessaires da Ter ord

~ HL(x" ,, 41) semi défini postit

sur le céne tangent a S* (x") enc

~ conditions nécessaires du ler onde

[conditions suffisantes

if

= f(x") défini po

= conditions nécessaires du ler ordre

~ HL(x" ,, 42) détini positit

sur le cOne tangent & S* (x" ) en x*

(si quali. de V'indépendance linéaire)

34.

Dualité_lagrangienne

14. Probléme primal, probléme dual

Probléme primal (P): minimiser f(x) sous les contraintes g(x) $0, h(x)=0, xe X¢R"

X est une partie quelconque de R”. Par exemple: R", un ensemble discret (nombres entiers

naturels pat exemple), ou encore un ensemble défini par des contraintes dinégalité ou d'égalité

autres que g et h.

A partir de (P) on définit un autre probléme: le probléme dual.

Probléme dual (D): maximiser @(u,v)=inf{ f(x) +ueg(x)+veh(x): xeX} sous les

contraintes u20

L(x, u,v) = f(x) +e g(x) +v h(x) est appelée fonction de Lagrange

(u,v) = inf L(x,u,y) est appelée fonction duale

xe

propriété: la fonction duale est concave.

Une conséquence trés importante est que tout maximum local du probléme dual (D) est maximum,

global de (D) c'est-a-dire solution de (D).

2. Relation entre primal et dual

Théoréme de dualité (faible)

Six est une solution réalisable de (P) et si (u,v) est une solution réalisable de (D) alors

f(x) 2 O(u,v)

Corollaire

Si x est une solution réalisable de (P) et si (u,v) est une solution réalisable de (D) telles que

f(x) = @(u,v) alors x est une solution (optimale) de (P) et (u,v) est une solution (optimale) de

(D)

3. Points selles

3.1, définition

Soient x” eX, u" 20.(x"u"

L(x" u,v) S L(x" u,v") SL (x,u",v") VreX, vu20

v") est un point see ssi:

35

jon des points selles

() Lo" ue" v")= inf Lou" v")

xeX

Soient x" €X, u" 20.(x".u",v") est un point selle ssi }2) g(x") $0, h(x")=0

3) u}gi(x")=0 i=1,...4m

Remarque: u" > 0 et 2) entrainent que 3) est 6quivalent au" * g(x"

3.3. théoréme de dualité (fort)

Si (x".u"v") est un point selle alors x* est une solution (optimale) de (P) et (u*,v*) est une

solution (optimale) de (D)

En effet x* est une solution réalisable de (P) en raison de la caractéristique 2). De plus les

caractéristiques 2), 3) et 1) permettent d’établir les égalités suivantes:

SOx )= f(x" tu" g(x" tv eho = L(x" u"v")= int Lou" v")=6(u",v")

rex

La conclusion découle du corollaire du théoréme de la dualité faible.

4. Relations entre optimums du dual et du primal et point selle

théoréme

Soit (i7,7) une solution (optimale) de (D). Si la fonction de Lagrange admet un point selle alors il

existe x* une solution (optimale) de (P) telle que (x", 17,7) soit un point sell.

corollaire

Soit (w,¥) une solution (optimale) de (D). Si la fonction de Lagrange admet un point selle et si

L(x,Z,¥) admet un minimum unique ¥ sur X alors ¥ est solution (optimale) de (P)..

Application: résolution de (P).

si on sait que la fonction de Lagrange admet un point selle

~ on résout (D). On obtient (72,7).

- on résout minimiser L(x,i,¥) x € X. Si ¥ est unique solution alors ¥ est solution de (P).

11 faut savoir que:

(P) a.une solution alors

sous les hypothases de convexité de l'ensemble des solutions réalisables de (P) (ie. les g;

convexes, les h affines, X convexe) et de convexité de f,

; pee . (= 3teX g(%)<0, A(Z)=0

~ plus sous les hypotheses de superonsistence suivants: | aur de h(X)

il existe un point selle.

36

5. Relation entre points selles et conditions de Kuhn et Tucker

On suppose ici X=R"

Si(x”,u",v") est un point selle alors il vérifie les conditions de Kuhn et Tucker.

En effet L(x,u",v") admet un minimum en x* et donc VL(x",u” ,v”)=0. Ce qui donne les

conditions de Kuhn et Tucker.

Réciproquement si x* est une solution réalisable de (P) et (x",u" v") vérifie les conditions de

Kuhn-Tucker et si la condition VL(x",u” ,v")=0 (x* point critique de L(x,u",v")) implique

que x* est un minimum global de L(x,u",v") alors 1a propriété caractéristique n°1 des points

selles est vérifiée. Les deux autres propriétés caractéristiques étant vérifiées on en déduit que

(x".u",v") est un point selle.

Cest par exemple le cas si f, g; telles que u; >0 sont convexes, fh, telles que vj #0 sont affines

car alors L(x,u",v") est convexe,

; +x221

Exemple: soit (P) minimiser (x1 ,x2)=2? +x} sous les contraintes {i 20/120

On met les contraintes sous la forme 4 g9 (1,9.

8324-2.

Tei X=R".

La fonction de Lagrange est L(x,u) = xp +x} +uj(—xj —x2 +1) +up(-m)+u3(-x2)

La fonction duale est 6(u) = inf {L(x,u): xe R"}

Explicitons la fonction duale, Pour cela cherchons un point critique de L(x,1) (u constant)

2x — uj —uy =0

fig 23 20°

2 yup _ yu

On en déduit: O(u) =-— ao

On remarque que 6(u) est bien concave (on vérifie que son hessien est défini négatif).

Le probléme dual (D) est: maximiser 6(u) sous les contraintes uj 20, up 20, uz 20

Résolvons le probléme dual. Pour cela rééerivons (D) en un probléme (D') de type minimiser:

2

wud te ss

minimiser “+2 4B 4 “02 4 “8

Eerivons les conditions de Kuhn et Tucker:

~uy sous les contraintes ~uy $0, - uy $0, —u3 $0

2,3)

2,3)

Ce syst&me admet une solution telle que (u,u2,u3) vérifie les contraintes de (D):

Ay =0, Az =A3 =4, my =I, up = uy =0.

37

Les hypotheses de qualification sont satisfaites puisque les conditions de l'indépendance linéaire

sont satisfait

Le probléme (D' ) vérifiant par ailleurs les conditions de convexité, les conditions de Kuhn-

‘Tucker sont suffisantes et le point (1,0,0) est minimum (global) done maximum (global) pour

(D).

int{Z(x,(1,0,0)): xe R" } est atteint par le point (x1,x2)=(},4). II est unique done cest Ia

solution de (P) (les hypotheses de convexité et de superconsistence étant vérifiées on sait que la

fonction de Lagrange admet un point selle).

Remarquons que 0(1,0,0)

conditions de Kuhn-Tucker de (P).

1, uy =1, uz =u3 =0 vérifient les

6. Résolution du probleme dual

6.1, Algorithme de sous-gradient

6

Sou: {de Ja fonction

ra

Notons: w=(H),B00=(f), X(w) = (2 X: f(x) +0 # B(x) = Ow).

Le théoréme suivant montre comment, une fois résolu le probléme de minimisation évaluant @ en

Ww , on peut obtenir simplement un sous-gradient de @ enw.

Théoréme: Vx € X(w), B(x) € 00(w).

Théoréme: Si 6(w) est différentiable en w alors J6(w) comporte un seul élément & savoir

Vo(w) le gradient en w.

On déduit des deux précédents théordmes que si 6(w) est différentiable en w et si X(w)#D alors

X(w) comporte un unique élément x et B(x) = VO(w).

Remarquons que 0(w) différentiable en w n'implique pas X(w)#Z. Considérer le probléme

minimiser e~ sous la contrainte 4x?+y?-x<0. La fonction duale est

a(u)= nf fe? a we eae a} =0 Wu20 (identiquement nulle) et X(u)=@ Vu20.

=

Théoréme: si @(w) est différentiable en w solution (optimale) du probléme dual et si

x X(w)#@ alors (x,w) est un point sell.

6.1.2. Maximisation de la fonction duale

On cherche ici A résoudre le probléme dual c'est-2-dire maximiser 1a fonction duale sous la

contrainte que certaines des variables doivent étre positives ou nulles. La simplicité de ces

contraintes fait que l'on peut adapter I'algorithme de plus forte pente utilisé dans le cas de

loptimisation sans contraintes. La différence est qu'on utilise un sous-gradient a la place du

gradient et que l'on interdit les déplacements qui rendraient négatives des variables astreintes &

&tre positives ou nulles.

38

Algorithme de sous-gradient (algorithme d'Uzawa)

On se donne une suite de nombres réels p“) > 0.

(0)

1) résoudre le probleme min f(x) +w © B(x): soit x une solution.

wD = P(w® + p(x) od PC) est la projection sur x-{(2) eR" y20,zé et

si w** = w® alors STOP

sinon k=k+1 et aller en 1)

La condition d'arrét w**) = w implique que (x,w®) est un point selle. Ceci se montre en

utilisant la caractérisation de la projection sur le cone convexe K

On remarque que les conditions caractéristiques 2) et 3) des points selles

g(x) <0, h(x) =0, u © g(x) =0 sont les conditions d'optimalité de la maximisation sur

K d'une fonction différentiable od le sous-gradient B(x) joue le role du gradient.

o

Les choix possibles de p sont:

- constant p =p Vk

- la série divergente p 0, Sp = +00

t

Théoréme

Dans le cas de la minimisation d'une fonction quadratique f(x)=4xeAx—bex (A définie

positive) sous des contraintes dinégalité affines Dr—d <0 (D de rang m) et X= R", dans le cas

du choix p® =p Vk, si pe ]o2m@| (Amin(A) est Ta plus petite valeur propre de A) alors fa

suite (x,w) converge vers (x",w") un point selle.

Exemple: appliquons V'algorithme d'Uzawa au dual du probléme minimiser f(x,x2)= x) +x}

0

ay x2 21

sous les contraintes if 2 Ory 20 oP Patant dew! = ( ‘) avec le pas constant p

Bi(%15%2)) (—m—%2 +1

On pose: g(x1,%2)=] gO.) |=} x

83(%1542), x2

itération 1

On minimise x? +x} —x—x (x),.x)€R”. La fonction étant convexe et soumise & aucune

contrainte, il suffit de chercher un point critique: x, =x, =4. Ce qui donne 6(0,1,1

itération 2

On mii

(0,

x, - $x) (a,x))€ R?. La solution est x,=x,=4. Ce qui donne

39

S

1 =

1

z

a

2

itération 3

On minimise x? +x} — $x, -

O(b44) =

u

. Ce qui donne

+e

eos

itération 4

On minimise x? +3 —

4(2,0,0)

2X) +3 (x,,22)€R?. La solution est x, =x, =}. Ce qui donne

mo)

1

+8(3.3) En projetant on obtient: a = (3)

0

=

3

8

itération 5

On minimise x? +x} —24-—x +1 (y,2,)€ R*. La solution est xy=2x,=4. Ce qui donne

6(1,0,0) = 4

web

ail

En projetant on obtient: u©) =| 0

0.

u® =u donc on arréte.

Vérifions que (x*,u*) = (4,4,1,0,0) est un point selle:

= les relations de complémentarités 3) sont vérifiées: u"

- la condition 2) (x* réalisable) est vérifiée: g(x”

- la condition 1) (x* minimise la fonction de Lagrange L(x,u") en w*) est vérifiée par définition

de x*.

On a mentionné a titre indicatif (elles n‘interviennent pas dans lalgorithme) les valeurs de la

fonction duale en chacun des points parcourus. On constate que la fonction duale augmente &

chaque itération.

On notera 'importance du choix de p. Par exemple si on prend p=2 pour le méme probléme, en

partant du méme point, I'algorithme cycle (c'est-a-dire repasse toujours par un méme point) sans

Jamais atteindre le point selle.

40

6.2. Méthode des plans sécants

Le probléme dual (D) peut s'éerire:

maximiser z

f(x) +ueg(x)+veh(x) pour toutxe X

sous les contraintes {2S F(#) tue a(x) + v9 h(x) pi

u20

En effet, pour u,v fixés, si z est maximum alors

aint {f(x)+ue g(x) +veh(x): xeX}=0(u,v). Done le probleme ci-dessus revient &

maximiser la fonction duale @(u, v) sous les conditions 120 soit au probléme dual.

Ce probléme est un probléme linéaire (en les variables z, u, v) qui comporte autant de contraintes

(en dehors des contraintes u20) qu’il y a d’éléments dans X (en particulier cardinal de X peut étre

infin).

C’est pourquoi 4 la place de (D), on résout une relaxation de (D) od seulement quelques

contraintes sont prises en compte. Si la solution obtenue vérifie toutes les contraintes c'est fini

sinon on rajoute une contrainte non vérifiée et on réitére.

algorithme:

soit X‘ contenant quelques éléments de X, k -0.

(1) on résout le probléme maitre:

maximiser z

e . (k)

pe ee g(x)+veh(x) pour tout x ¢ X'

u>

Soit 2“), u{*), v une solution. Pour tester si cette solution vérifie toutes les contraintes de (D),

on résout le sous-probleme: z* =min{ f(x)-+ul*) « g(x)+v!®) «A(x)}

xeX

siz!) <2*

alors STOP (on a résolu (D))

sinon

soit x") une solution du sous-probléme

x © x(k) {x} (on rajoute une contrainte au probléme maitre)

kOk+1 et aller en (1)

Exemple: appliquons I'algorithme des plans sécants au dual du probléme minimiser

si(a1 x2

(x x2) €X={(a1, 22): 11 20, x2 20}

£(x1,22)=2? +23 sous les contraintes {

Partons avec X'°) = {(0,0),(1, 1)}

itération k=0:

zs

Le probléme maitre est: maximiser z s.c. 4 z<$2—m

20

La solution est 2!) =1,u{9)

Le sous-probléme est: z° = mip{x? +a}-m—mti}=

x

La solution est x{° = xf?) =4. 2( >2* donc on rajoute au probléme maitre, la contrainte

engendrée par x{°) = xf) = ie. x ={(0,0),(1.1).(4,4)}.

4

itération k=1

zsuy

zs2-m

Le probleme maitre est: maximiser z.c. 4 <1

a

20

zl) =4,u{ =1 est une solution

probleme est: z” = min{x? + x3 -y - x2 + 1}=4

Le sous-probléme est: z minx? + x3 a-xtif=4

2 <2* done on arréte. L’optimum du dual vaut 4 et est atteint pour u

42

Méthodes _primales

1. Introduction

On va considérer ici deux méthodes. On les qualifie de primales car elles atteignent la solution du

probléme par déplacements successifs dans l'ensemble des solutions réalisables c'est-A-dire

Tespectant & chaque itération les contraintes du probléme primal. L'avantage d'avoir & chaque

itération une solution réalisable est que si on peut se contenter d'une solution sous-optimale on

peut interrompre l'algorithme avant terme. L'inconvénient est que dans le cas de contraintes

quelconques Ia mise en ocuvre est difficile. On se restreindra ici au cas ot l'ensemble des

solutions réalisables est un polyédre (contraintes linéaires). Les deux méthodes s‘étendent a des

problémes soumis & des contraintes quelconques mais sont alors de mise en oeuvre plus délicate.

Méthode du gradient projeté

2.1. notations, définitions

On considére le probleme: minimiser f(x) sous les _contraintes

ajexSb, (11), a,¢x=b, ('eJ) ot f:R" > R, de classe Cl, Het J finis. Les contraintes

inégalité sont non singuligres (Wi € I, x réalisable t.q. a; © x

Exemple: soit (P) minimiser f(x),x2) = x? + x2 sous les contraintes te Siaso

mx x9 S-1

On met les contraintes sous la forme 4x; <0

=x) <0

Ikération 1.

Partons de A) =(2). ¥¢(F))=(4). On projete (—") sur L={y: y =O}, on obtient d=(—*

F=(9). WA) = (4): On projet (G') sur L={y: yp =0}, on obtient d =(

; ~4a21|_, es

Déterminons le déplacement maximum: 3 ~ 4% 2 ni ae

eRe

} = a = (la toisiéme contrainte

n‘intervient pas par construction de d).

Le minimum de f(2- 40,0) sous la contrainte 0 < a < } est atteint en or =

Itération 2.

Nous obtenons le nonvean point A-(}). w(a)=(3)- On projate (2) sur

L={y nee

=Ve(A) dans la base (=).(2): On a: (?)=2(zi)+ 29), ce qui montre que la

contrainte —x, <0 nest pas active. On projéte (e) sur le nouveau L={y: yy +y2 =O}, on

.»2=0}={(9)}. on obtient a-(9). Cherchons les coordonnées de

-I

1

premiére contrainte n‘intervient pas par construction de d).

Le minimum de f(1- 0,2) sous la contrainte 0< or <1 est atteint en a = 4

1-020)

obtient a=( a

). Déterminons le déplacement maximum: }oasis oy =1 (la

Ttération 3.

a a or

Nous obtenons le nouveau point Pale w(A)=(1) On projéte (=) sur

2

L={y: 1 +92 =0}, on obtient a-(9). La coordonnée de — Vf (Py) dans la base @) est 1.

On arréte.

Les différents points parcourus sont représentés sur la figure 1.

3. méthode du gradient réduit

3.1. Notations, définitions

On considére le probleme: minimiser f(x) sous les contraintes Ax=b, x20 ot f:R" > R est

de classe Cl, A est une matrice m lignes, n colonnes de rang m 0.

Comme pour Ia programmation linéaire, il est plus commode d'utiliser 1a transposée du gradient

de f (vecteur ligne) que le gradient de f (vecteur colonne). On note

4s

aura reconnu la matrice jacobienne de f). De manire similaire aux notations précédentes on note

af _( of of of _( F F |i,

inom in

f peut s'exprimer en fonction de xy uniquement:

Slxp.xw)= S(Ag!b- Ag! Ayan xy) = F(x). Le gradient de 7 est appelé gradient réduit de f

ee ae -1 g

et sa transposée stexprime par 7 -& AglAn +30

:} +x}. On exprime x, en fonction de x,,x,, on obtient

Exemple (suite): soit f(x,,%2.%3,%4)

Fl x_.x4) = (Sap -17x4)? +23 et (z #) (52x) +170x, 170x, +578x,). On pourra

vérifier ce résultat avec la formule matricielle donnée ci-dessus.

3.2. prineipe de la méthode

Plutét que de considérer f , fonction de n variables, on considére f fonction de n-m variables.

Outre Ie fait que le nombre de variables est ainsi moins important, l'intérét est que ces n-m

variables sont soumises seulement aux contraintes relativement simples de non négativité.

On part d'un point x réalisable et on choisit une partition des variables (B,N) vérifiant les

critéres énoncés plus haut.

On va effectuer un déplacement dans la direction opposée au gradient réduit mais en prenant soin

de ne pas rendre négatives les variables indexées dans N et nulles. Notons

wagl aw +L la transposée du gradient réduit pris au point x . On définit Ja

direction d, se décomposant en dp et diy, de a maniére suivante:

0 sir;>Oetxj;=0

4 EF Goon Im? Gem

- dy 6tant défini, dp est déterminé via les contraintes d'égalité par dy =—Ap!Aydy

Si dy#0 le déplacement se fait jusqu'a atteindre le minimum de f dans la direction d mais en

respectant les contraintes de non négativité des variables. On obtient un nouveau point x’. Si une

de ses composantes dans B , disons s , s‘annule on construit une nouvelle partition des variables

BY = B-{s}+{r} N’=N+{s}—{r} oi r est choisi de sorte que Agr soit inversible et que x;

soit non nul puis on réitére. Cette opération, appelée changement de base, est nécessaire car sinon

on risque de faire du surplace, Ia nullité de x; blocant le déplacement suivant. Le fait de faire

passer s dans N permet de controler la variation de la coordonnée s qui ne peut étre que positive

‘ou nulle par construction de la direction de déplacement.

Si dy=0 les conditions de Kuhn-Tucker sont satisfaites et on arréte.

Théoréme

Si la méthode de gradient réduit construit une direction de déplacement nulle, ie. d_y=0, le point

courant x vérifie les conditions de Kuhn-Tucker.

démonstration:

Xx)+A-A=0

Les conditions de Kuhn-Tucker riven: #20

a

oF

peseald

Soient r=

Boag, Ap=0, Ay

conditions? Pour Ia premiére égalité un simple calcul le montre. La dew:

Leoaglay + Zoe). x4ud vertienvits ces

ion (A 20)

46

est vérifiée car dy=0=r20 d'aprés 1a définition de dy. La troisiéme condition

) ou (-r;=0) VjeN toujours par

O

(complémentarité) est vérifiée car dj = 0=9(rj >0 et x;

définition de dy.

3.3. algorithme

Soit x un point réalisable et une partition des variables (B,N) tq. Ag inversible

1) déterminer r= -Heoaylay + Ko

0 sirj >Oetx,

45 OF don" Gem. dp

Si dy#0 alors

% =max{o2 0: x+ 0d 20}

soit @% solution de minimiser f(x -+ ord) sous la contrainte 0< or< a

xextand

si dye B x, =0 alors on change de base:

soit re N tq. Ag inversible (B’ = B—{s}+{r}) et x, maximum.

Be B-{s}+{r}

NEN+{s}—{7}

aller en 1)

sinon FIN.

Remarque pratique:

au cours de lalgorithme, il faut effectuer le changement de base B’=B-{s}+{r}

N’=N-+{s}—{r} et il faut alors calculer Aj!. Ce calcul peut étre fait & moindre coat.

Ona lidentité Ag! =(45'Ay) Apt

‘Ap Glant obtenue & partir de Ay en remplagant Ia colonne Aj.) par Ia colonne A,,) , on a

a on 0 yn

P ott Ag'A, =| P

In

0

On peut done calculer Aj! en prémultipliant Aj! par une matrice simple a obtenir.

est appelé pivot de la colonne r.

[xy + 2aty +323 — xy =6

Exemple: reconsidérons le syst#me {i 33x, 42x, 45%

(1323)

Choisissons B= {1,3},N = {2,4}. Alors Ay (

a7

Effectuons le changement de base B’ = {2,3},N’ = {1,4}

Aggy = (7 5)8)=(8) p=520 et done A,

(iG

41,

Sous I'hypothése de non-dégénérescence, l'opération changement de base est toujours possible, En

effet xp +Ag!Ayxy =Aglb>0 et si on note pj le pivot de la colonne j (relatif & xs) on a:

seBtgq. x,=0= ) px; >0=5reNt.q. p,x, #0

jen

Exemple (suite): pour B={1,3} , on a (3) * 4ibyAen(2)= jus

wot (2)+(2 33 VBC? AND

ssit encore (2)+(5, £2)(2) (8)

x3 =0=9 x) — 6x4 =2

Les pivots des colonnes A2 et A4 (relatifs & x3) sont -1 et -6. S*ils étaient nuls on aurait

voit que la condition de non-dégénérescence n’est pas nécessaire puisqu'ici Ag!b a une

composante (celle associée & x1) nulle et pourtant on peut effectuer les changements de base B-

{1}+{2} et B-{1}+{4}, les pivots (5 et 17) étant non nuls.

=G 3) est inversible (45'Ay

1 3

Al

2

7 7 7 . 2

Exemple récapitulatif: soit (P) minimiser x? +.x3 sous les contraintes ie tm2l

x 20, x 20

_ aang? ay $29 23 =1

(P) revient a minimiser f(x,,x2,23)= x7 +7 sous les contraintes ‘a 20rx7 20,x3 20

2

Choisissons le point initial Ay = ( et B={3}, N={1,2}.

1

Itération 1.

On a xgs-Ituy+x7. On en déduit — f(x,x2)= f(a1,x2,-14+x1 +22),

z (t 2) (2x, 239) et

2) (-4 oft aa at

1 4 assy

Le minimum de f(2~40z,0,1-4a2) sous la contrainte 0< or} est atteint en a = 4

(4 0). La direction de déplacement est d

1

Le nouveau point est A, -(}

0.

base. Liindice 1 est I'indice dans NV associé a 1a coordonnée de Py Ia plus grande: on forme la

nouvelle décomposition B= {1} et N= {2,3}.

} Sa coordonnée 3 est nulle. Il faut effectuer un changement de

48

Itération 2.

On a Bl-xy +35 dtoa Flxg.x3) = fl—2 +3,%2,3),

a 2 a 2

Z(H E+ L)-(24 +2 2x) et r=(-2 2) ay =(6) et dg =-2 done la

2) (1 -2 rea

direction de déplacement est d=| 2 |.|0|+a) 2 20>

0) \o 0 ae)

Le minimum de f(1—2c.,20r,0) sous la contrainte 0< a <4 est atteint en a = 4

Le nouveau point est Py =

ONENE

Itération 3

Le gradient réduit en P2 est r=(0 1) et done dy =(0) On arréte,

‘Vérifions que les conditions de Kuhn-Tucker sont satisfaites:

ici A=(I 1-1)

soient = Xb 0,(az a3)=r=(0 1)

gf

£(4,4,0)+ua-2=06>(2x4 2x4 0)-(1 1 -1)-(0 0 1)=(0 0 0), done vérifié

On aura remarqué que l'on a une écriture “transposée" des équations de Kuhn-Tucker.

4.20 et les conditions de complémentarités 2 x4=0, 42 x4=0, 43 x0=0 sont vérifiées.

Remarque: en partant du méme point on obtient des cheminements différents selon le choix du B

. Par exemple si l'on choisit {I} et N={2,3}, on passe par les 3 points

Py

sans changer de base B.

Suna

=

Geoinon

49

Méthodes de pénalité et de barriére

1. Introduction

Le principe de ces méthodes est de transformer le probléme initial en un probléme sans

contraintes dont Ja résolution est a priori plus facile surtout dans le cas de contraintes non

linéaires.

2. Méthode de pénalité

2.1. Introduction

La méthode de pénalité est une méthode duale dans le sens od elle atteint la solution du probléme

par l'extérieur de l'ensemble des solutions réalisables. Dés que l'on atteint une solution réalisable

celle-ci se trouve étre une solution optimale. Cette méthode consiste a résoudre une suite de

problémes sans contraintes. L'inconvénient inhérent aux méthodes duales est que si l'on arréte

Talgorithme avant terme on ne dispose pas d'une solution réalisable.

2.2. Principe de la méthode

On considére le probléme (P): minimiser f(x) x€Sc R”

A pattir de (P) on construit le probléme sans contraintes (Py): minimiser f(x) +MP(x) xe R"

1) P continue

ot Le R* et P:R" > R vérifie 42) P(x)20 Vre R”

3) P(x)=0eoxeS

P(x) est une pénalité infligée a tout x qui n'est pas solution réalisable de (P).

exemple: pénalité de Courant-Beltrami

Si S={x: gi(x)SOi=1,....m hj(x)=0i=1,...,p} on peut prendre la pénalité

ft 2 2

P(x) = D(sh a)” +E (hi)? od gf (x) = max{0, /(2)}

il A

Intuitivement pour j1 "grand", toute solution (optimale) de (Py) a une pénalité nulle c'est-a-dire

est réalisable pour (P). Mais on ne sait pas a priori quelle valeur assigner & ut. C'est pourquoi,

pour chercher cette valeur, on se donne une suite (14;) (positif) strictement croissante et qui tend

vers I'infini (par exemple k).

La démarche des méthodes de pénalité est alors la suivante:

~ pour chaque k on résout le probléme sans contraintes (Py): f(x)+ MPC) x€ R”

- on obtient (xz) la suite des solutions des (Px).

Question: la suite (xg) converge-t-elle vers une solution de (P) ?

2.3. Convergence de la méthode

On se donne une suite (j1;) telle que J1j.41 > My >0 et qui tend vers l'infini.

50

On note:

= a(x Hy) = $00) + Mg PO)

- xz Ja solution de (Pj): minimiser g(x,11,) =

Hypothése: Vk (Ps) admet une solution x,

(x) + MpP(x) xe R™

Lemmel

(eH) Saxe Mast)

P(x)? Psa)

(xe) Fes)

Lemme2

Soit x* une solution de (P). f(x") > 4(xx-Hk)2 f(e) Vk

Théoreme