Académique Documents

Professionnel Documents

Culture Documents

Apprentissage Supervis E: Introduction Aux Arbres de D Ecision

Apprentissage Supervis E: Introduction Aux Arbres de D Ecision

Transféré par

Faical BitamTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Apprentissage Supervis E: Introduction Aux Arbres de D Ecision

Apprentissage Supervis E: Introduction Aux Arbres de D Ecision

Transféré par

Faical BitamDroits d'auteur :

Formats disponibles

Université Paris 7 - Denis Diderot Introduction à l’IA

M1 info Année 2009-2010, 1er semestre

TD n◦10

Apprentissage Supervisé : introduction aux Arbres de Décision

Exercice 1 Construction d’un arbre de décision

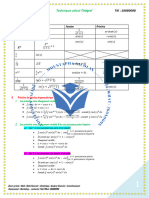

Nous supposerons qu’il n’y a que 2 classes + et - de sorte que l’entropie d’un ensemble puisse

être donnée par un tableau à 2 entrées, X et Y, X étant le nombre d’éléments de la classe + et

Y le nombre d’éléments de la classe -.

X Y 1 2 3 4 5

5 3.90 6.04 7.63 8.92 10.

4 3.61 5.51 6.90 8.

3 3.25 4.85 6.

2 2.75 4

1 2

Nous considérons l’ensemble E d’exemples suivant :

E1 E2 E3 E4 E5 E6 E7 E8 E9 E10

A a1 a1 a1 a2 a2 a2 a1 a2 a3 a3

B b1 b2 b2 b1 b2 b2 b1 b1 b1 b2

C c1 c2 c3 c1 c1 c1 c1 c2 c3 c2

D d2 d2 d1 d1 d1 d2 d1 d2 d1 d2

Classe + + - - - + + - + +

1. Construisez l’arbre de décision en utilisant les attributs ABCD dans cet ordre.

2. Construisez l’arbre de décision en utilisant les attributs DCBA dans cet ordre.

3. Construisez l’arbre de décision qui discrimine tous les exemples de E pour les classes + et

- en faisant appel à la méthode de construction employée pour l’algorithme ID3 (C4.5).

Justifiez le choix des attributs aux différents noeuds de l’arbre.

4. Construisez l’arbre de décision qui discrimine tous les exemples de E pour les classes + et

- en utilisant la mesure de Gini.

Remarque : La mesure de Gini telle qu’elle est utilisée dans l’algorithme CART cherche lors de

la segmentation le regroupement binaire qui maximise le gain.Ce n’est pas le cas ici.

Exercice 2 Construction d’un arbre de décision (2)

- Construisez l’arbre de décision qui discri-

Attribut Exemple E1 E2 E3 E4 E5 mine tous les exemples les classes + et - en

F1 a c a b c faisant appel à la méthode de construction

F2 c a a c c employée pour l’algorithme ID3 (C4.5).

F3 a c c a b

Classe + + - - -

Vous aimerez peut-être aussi

- Detection des collisions dans les jeux video 2D: avec C#5, WPF et Visual Studio 2013D'EverandDetection des collisions dans les jeux video 2D: avec C#5, WPF et Visual Studio 2013Pas encore d'évaluation

- Exam Graphe CorrigeDocument2 pagesExam Graphe CorrigeMarouane Boussellami0% (1)

- Brevet Maths 2021 Sujet Corrige Blanc Pour La Revision Du DNBDocument8 pagesBrevet Maths 2021 Sujet Corrige Blanc Pour La Revision Du DNBMehdi Elouahabi100% (1)

- Exercices Partier 1Document4 pagesExercices Partier 1abderrahim zouheirPas encore d'évaluation

- Programmation Orientée ObjetDocument6 pagesProgrammation Orientée ObjetOsama100% (2)

- TD 3 - Heritage Et PolymorphismeDocument1 pageTD 3 - Heritage Et PolymorphismeanassPas encore d'évaluation

- tp4 LoukamDocument10 pagestp4 LoukamAzzeddine benhenniPas encore d'évaluation

- Tdad 1920Document1 pageTdad 1920ilyes0% (1)

- TD3C 2022Document2 pagesTD3C 2022Ala AlaPas encore d'évaluation

- TP6 Héritage: Exercice 1Document2 pagesTP6 Héritage: Exercice 1Med Amine RihaniPas encore d'évaluation

- TD Num 2012 2013Document18 pagesTD Num 2012 2013idrissa dembelePas encore d'évaluation

- Série 01Document2 pagesSérie 01CHERNI ANISPas encore d'évaluation

- Devoir Maison N2 SDocument2 pagesDevoir Maison N2 Syassmina hajjiPas encore d'évaluation

- TD Conception Et Analyse de AlgorithmesDocument18 pagesTD Conception Et Analyse de Algorithmesfairahmal2024Pas encore d'évaluation

- Activité Numérique 2Document5 pagesActivité Numérique 2yazidi aminePas encore d'évaluation

- TD Architecture Ordinateur 2023 2024 EtudiantsDocument5 pagesTD Architecture Ordinateur 2023 2024 Etudiantswww.doukoureabdoulaye1100% (1)

- 2TI-Devoir de Synthèse N°1-Énoncé + CorrectionDocument13 pages2TI-Devoir de Synthèse N°1-Énoncé + CorrectionRim ElbraiekPas encore d'évaluation

- EXEMPLE TEST MATHEMATIQUES DU Septembre 2021Document1 pageEXEMPLE TEST MATHEMATIQUES DU Septembre 2021jedusablePas encore d'évaluation

- 2020TD1 8086Document1 page2020TD1 8086Lakhdar BekkariPas encore d'évaluation

- CC Avec Correction Module POO Univ Tlemcen Promo 2018-2019 (Tchi Drive)Document6 pagesCC Avec Correction Module POO Univ Tlemcen Promo 2018-2019 (Tchi Drive)Riadh MatmatPas encore d'évaluation

- 3eme RevisionDocument10 pages3eme RevisionAlioune Badara KANEPas encore d'évaluation

- TD 3 Optimisation de Code IntermédiaireDocument2 pagesTD 3 Optimisation de Code IntermédiaireMohamed SelmaniPas encore d'évaluation

- 02 Ctrle 07 12 2023Document2 pages02 Ctrle 07 12 20239n6ydsy4r2Pas encore d'évaluation

- TP Informatique (Matlab)Document17 pagesTP Informatique (Matlab)Hamza BouabdallahPas encore d'évaluation

- 21-NSIJ2ME2 Avec Santorin BisDocument14 pages21-NSIJ2ME2 Avec Santorin BisLETUDIANTPas encore d'évaluation

- TD Algebre Lineaire 2023-2024 GestionDocument5 pagesTD Algebre Lineaire 2023-2024 GestionATCHIPas encore d'évaluation

- MPSI Vacances Exos CorrectionDocument7 pagesMPSI Vacances Exos Correctionavr 1217Pas encore d'évaluation

- Poo td01Document18 pagesPoo td01yveseonePas encore d'évaluation

- M1 Ese Poo TP1Document2 pagesM1 Ese Poo TP1lange681Pas encore d'évaluation

- TIGps TPE-3 MATHS P-CDETIDocument4 pagesTIGps TPE-3 MATHS P-CDETIAH JINPas encore d'évaluation

- TD1 Algo 2019Document2 pagesTD1 Algo 2019HICHEM BEHIRIPas encore d'évaluation

- td4-2018 CompressedDocument1 pagetd4-2018 CompressedDally Morgan Ndong EllaPas encore d'évaluation

- Devoir de Contrôle N°1 - Math - 2ème Sciences (2021-2022) Mme Meddeb AydaDocument1 pageDevoir de Contrôle N°1 - Math - 2ème Sciences (2021-2022) Mme Meddeb AydaahmedPas encore d'évaluation

- Tutorat 2Document5 pagesTutorat 2Yassine BoutahirPas encore d'évaluation

- Examen 28 02 11 Avec Corrige StrictDocument9 pagesExamen 28 02 11 Avec Corrige Strictihsen gasmiPas encore d'évaluation

- 3eme Sujets Brevet Maths Calcul Litteral 2017 2019Document7 pages3eme Sujets Brevet Maths Calcul Litteral 2017 2019el fatihiPas encore d'évaluation

- QCM C++Document23 pagesQCM C++Mėc FråįsPas encore d'évaluation

- Devoir 3 ÉnoncéDocument4 pagesDevoir 3 Énoncéfelixhebert03Pas encore d'évaluation

- Examen RO 2017 V2Document2 pagesExamen RO 2017 V2Wiem MelkiPas encore d'évaluation

- Dokumen - Tips - TD Systemes 21Document2 pagesDokumen - Tips - TD Systemes 21Ķħ Älīl CħễħäŤäPas encore d'évaluation

- CorrigeInterro2012 13 PDFDocument3 pagesCorrigeInterro2012 13 PDFDew DewPas encore d'évaluation

- Fax A4 IndDocument40 pagesFax A4 IndGaetan MessanviPas encore d'évaluation

- Zprobat D 2016Document3 pagesZprobat D 2016Guillaume herve PohsiePas encore d'évaluation

- 612a282e9753adevoir Corrige 33 de Maths Niveau Terminale DDocument8 pages612a282e9753adevoir Corrige 33 de Maths Niveau Terminale Dlossenik947Pas encore d'évaluation

- Ro03 TDDocument38 pagesRo03 TDjomalikePas encore d'évaluation

- ENONCE DEV BILAN 2ndeDocument4 pagesENONCE DEV BILAN 2ndeilias.bouarbiPas encore d'évaluation

- TD2 Logique Combinatoirex PDFDocument9 pagesTD2 Logique Combinatoirex PDFsensaad50% (2)

- TP1 Poo 1Document2 pagesTP1 Poo 1BjoRn63Pas encore d'évaluation

- TP 3Document6 pagesTP 3Chardin DushimePas encore d'évaluation

- Chapitre 2Document8 pagesChapitre 2khawla kharbouchPas encore d'évaluation

- Probat D 2016Document3 pagesProbat D 2016mbilongoPas encore d'évaluation

- BAC BLANC Tle C&D MAI 2022 IPPBDocument3 pagesBAC BLANC Tle C&D MAI 2022 IPPBnguepongsadoPas encore d'évaluation

- Exos Complet 1 eDocument70 pagesExos Complet 1 ewiss.lrhaziPas encore d'évaluation

- Serie3 Arbre TD TGDocument3 pagesSerie3 Arbre TD TGmariam100% (1)

- 3eme BB 2 21-22Document3 pages3eme BB 2 21-22agatha christinaPas encore d'évaluation

- Calcul MathématiqueDocument3 pagesCalcul MathématiqueVo Quoc TruongPas encore d'évaluation

- TD Architecture Des Ordinateurs 2021-2022Document5 pagesTD Architecture Des Ordinateurs 2021-2022Ouattara larsonPas encore d'évaluation

- TD01 Les Classes Et Les ObjetsDocument6 pagesTD01 Les Classes Et Les ObjetsTim'sPas encore d'évaluation

- 2ème Devoir Surveillé Du 1er SemestreDocument3 pages2ème Devoir Surveillé Du 1er Semestrejo softPas encore d'évaluation

- TD TP4Document4 pagesTD TP4mohaamine2299Pas encore d'évaluation

- TP1 (Concept de Base)Document12 pagesTP1 (Concept de Base)Faical BitamPas encore d'évaluation

- TD 1Document2 pagesTD 1Faical BitamPas encore d'évaluation

- TP 2 (Packet Tracer) - Partie 1Document4 pagesTP 2 (Packet Tracer) - Partie 1Faical BitamPas encore d'évaluation

- TD 2Document2 pagesTD 2Faical BitamPas encore d'évaluation

- Tdadbayes 2021Document2 pagesTdadbayes 2021Faical BitamPas encore d'évaluation

- Chapitre 4. (Les Réseaux Adhoc)Document73 pagesChapitre 4. (Les Réseaux Adhoc)Faical BitamPas encore d'évaluation

- Chapitre 2 (Adressage & Routage Ip) Partie 2Document65 pagesChapitre 2 (Adressage & Routage Ip) Partie 2Faical BitamPas encore d'évaluation

- Examen Final v3 2017Document3 pagesExamen Final v3 2017Faical BitamPas encore d'évaluation

- Chapitre 3 (Introduction Aux Réseaux Sans Fil)Document41 pagesChapitre 3 (Introduction Aux Réseaux Sans Fil)Faical BitamPas encore d'évaluation

- Examen Final v1 2017 2018Document2 pagesExamen Final v1 2017 2018Faical BitamPas encore d'évaluation

- Examen Final v1 2016 2017Document3 pagesExamen Final v1 2016 2017Faical BitamPas encore d'évaluation

- Routage Classless Vlsm/CidrDocument24 pagesRoutage Classless Vlsm/CidrFaical BitamPas encore d'évaluation

- TdclassifDocument2 pagesTdclassifFaical BitamPas encore d'évaluation

- Tpbayes 2021Document1 pageTpbayes 2021Faical BitamPas encore d'évaluation

- 3series TD Crypto l3Document10 pages3series TD Crypto l3Faical BitamPas encore d'évaluation

- TP4 Heritage JavaDocument5 pagesTP4 Heritage JavaEya SalemPas encore d'évaluation

- Examen de Rattrapage Module LM Avec CorDocument3 pagesExamen de Rattrapage Module LM Avec CorNour MeniiPas encore d'évaluation

- GenericsDocument38 pagesGenericsNadia BoulifaPas encore d'évaluation

- TD2 GraphesDocument4 pagesTD2 GraphesAbdoulaye CoulibalyPas encore d'évaluation

- Main 5Document72 pagesMain 5Bougary TamegaPas encore d'évaluation

- 7 Chapitre3.2Document7 pages7 Chapitre3.2Achraf SahriPas encore d'évaluation

- FWB - Circulaire 7791 (8046 - 20201015 - 163851)Document5 pagesFWB - Circulaire 7791 (8046 - 20201015 - 163851)clarinvalPas encore d'évaluation

- Chapter 4-Protocole de Transmission Dinstructions SuperscalairesDocument17 pagesChapter 4-Protocole de Transmission Dinstructions SuperscalairesMohamed OuaddanePas encore d'évaluation

- Adaptfltr 2Document26 pagesAdaptfltr 2hayouni aymenPas encore d'évaluation

- Algo1 Apad 2012 s3 Serie2 - Algo F CorrigeDocument7 pagesAlgo1 Apad 2012 s3 Serie2 - Algo F CorrigeAziz BenamorPas encore d'évaluation

- Chap2 Pile Et FileDocument28 pagesChap2 Pile Et FileMariam SamakePas encore d'évaluation

- L1 Langage C 2020Document101 pagesL1 Langage C 2020Jean BaptistePas encore d'évaluation

- TdjavaDocument2 pagesTdjavaMoustafa AbdelazizPas encore d'évaluation

- PHP Chapitre2Document16 pagesPHP Chapitre2samiaPas encore d'évaluation

- TD II C CombinesDocument20 pagesTD II C CombinesSharon DonnayPas encore d'évaluation

- 2 OrdDocument41 pages2 Ordomar omarPas encore d'évaluation

- Syllabus Version1Document160 pagesSyllabus Version1WAilPas encore d'évaluation

- 1 - Presentation Du ModuleDocument7 pages1 - Presentation Du ModuleEspoir MAKAYA MBANZILAPas encore d'évaluation

- Delphi ServeurDocument13 pagesDelphi ServeurRazika RazouPas encore d'évaluation

- 2 Pascal ObjetDocument4 pages2 Pascal ObjetfatimaPas encore d'évaluation

- Chapitre 2Document20 pagesChapitre 2Doucson Seydou Fily MalléPas encore d'évaluation

- Commandes AixDocument35 pagesCommandes AixM BPas encore d'évaluation

- Thread Final 19-20Document79 pagesThread Final 19-20Nour AmelloukPas encore d'évaluation

- Note D'organisation Ramassage Des Livres 2023Document1 pageNote D'organisation Ramassage Des Livres 2023MorelPas encore d'évaluation

- Ch1-Automates Finis - Seance4Document12 pagesCh1-Automates Finis - Seance4Ali SaadPas encore d'évaluation

- Cours Calculs Dans RDocument4 pagesCours Calculs Dans Rletaief zeinebPas encore d'évaluation

- Exercices GSIDocument4 pagesExercices GSIla vie SimplePas encore d'évaluation

- Introduction À MPI - Message Passing InterfaceDocument71 pagesIntroduction À MPI - Message Passing Interfacebilel.bilalou28Pas encore d'évaluation

- Collection Validé Tél: 26080098: Technique CalculDocument7 pagesCollection Validé Tél: 26080098: Technique CalculMoustapha NicolasPas encore d'évaluation