Académique Documents

Professionnel Documents

Culture Documents

Complexité Asymptotique

Transféré par

LaenetGalumetteJosephJuniorPaul0 évaluation0% ont trouvé ce document utile (0 vote)

40 vues3 pagesTitre original

Complexité asymptotique

Copyright

© © All Rights Reserved

Formats disponibles

PDF, TXT ou lisez en ligne sur Scribd

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

© All Rights Reserved

Formats disponibles

Téléchargez comme PDF, TXT ou lisez en ligne sur Scribd

0 évaluation0% ont trouvé ce document utile (0 vote)

40 vues3 pagesComplexité Asymptotique

Transféré par

LaenetGalumetteJosephJuniorPaulDroits d'auteur :

© All Rights Reserved

Formats disponibles

Téléchargez comme PDF, TXT ou lisez en ligne sur Scribd

Vous êtes sur la page 1sur 3

Complexité asymptotique

Dans cette section, nous allons examiner un aspect extrêmement important

d'un algorithme, à savoir sa performance. Même si la vitesse des ordinateurs

augmente régulièrement, en fait, elle ne sera jamais assez grande. Les

utilisateurs veulent résoudre des problèmes de plus en plus complexes, et

pour un grand nombre d'algorithmes, doubler la vitesse de l'ordinateur

n'implique pas qu'on puisse résoudre un problème deux fois plus grand.

Il est donc important pour un informaticien de choisir l'algorithme le plus

rapide. Il y a là un problème difficile : la vitesse d'exécution d'un algorithme

dépend de l'ordinateur (du processeur, du type et de la quantité de mémoire,

de l'organisation et la taille du cache et éventuellement de la rapidité du

disque). Comment peut-on comparer des algorithmes du point de vue de la

performance si l'on ne connaît pas l'ordinateur sur lequel va tourner

l'algorithme ?

De plus, le temps d'exécution d'un algorithme dépend bien sûr de la taille du

problème à résoudre. Pour comparer deux algorithmes du point de vue de la

performance, il faudrait alors donner la taille du problème à résoudre. Le

résultat de cette comparaison peut varier selon la taille du problème.

Ces questions sont étudiées par une branche de l'informatique que nous

appelons la théorie de la complexité. Nous allons en particulier nous

intéresser au concept de complexité asymptotique.

L'idée de base est de ne pas mesurer directement le temps d'exécution d'un

algorithme, mais de compter le nombre d'opérations élémentaires (additions,

soustractions, comparaisons, etc.) requises par son exécution en fonction de

la taille du problème. Nous allons appeler cette fonction la fonction du

temps de l'algorithme. Pour un problème de taille , nous allons noter cette

fonction . Malheureusement, la fonction du temps ne permet pas

forcément de comparer la vitesse d'exécution de deux algorithmes. La raison

est qu'une opération élémentaire peut s'exécuter plus ou moins rapidement

selon l'ordinateur en question.

Pour contourner ces problèmes, les informaticiens ont inventé la notion

de complexité asymptotique. Avec la complexité asymptotique, on ne donne

pas la fonction du temps exacte, mais uniquement une approximation de

celle-ci. Cette approximation est donnée sous la forme d'une fonction bien

connue qui donne la forme générale de la fonction du temps.

Exemple : Prenons un algorithme dont la fonction du temps est .

La complexité asymptotique va donner l'approximation , i.e., on ne

s'occupe pas du facteur constant , mais on regarde uniquement la forme

générale de la fonction. Cette approximation permet de ne pas tenir compte

de la différence de vitesse entre différents ordinateurs.

La notation utilisée pour indiquer qu'il s'agit d'une approximation de la fonction

du temps est appelée la notation grand O , car elle utilise la lettre 'O'

majuscule. Donc, on dit qu'un algorithme avec a une complexité

asymptotique (ou simplement une complexité) (prononcer ``grand O

de cube).

La complexité asymptotique ne nous permet donc pas de comparer deux

algorithmes différents dont la forme de la fonction est la même. Une telle

comparaison ne serait d'ailleurs pas forcément utile, à cause des différences

entre les ordinateurs. Par contre, la complexité asymptotique permet de

comparer deux algorithmes dont la forme de la fonction du temps est

différente.

Exemple : pour trier un tableau de nombres par ordre croissant, il existe un

algorithme dont le nom est tri par insertion et dont la complexité est . Il

en existe un autre dont le nom est tri par tas et dont la complexité

est . Lequel est le plus rapide ? En général , ce qui

indique que le tri par tas est plus rapide que le tri par insertion (en général,

c'est le cas). Mais on ne peut pas être sûr. Il est tout à fait possible que pour

le tri par insertion et que pour le tri par tas .

Heureusement, cette situation n'arrive pratiquement jamais. Il est donc

raisonnable de conclure que le tri par tas est plus rapide que le tri par

insertion. Ceci est d'autant plus vrai que la taille du problème (la valeur de )

est grande. Dans le cas ci-dessus est supérieur à à partir

de environ. Autrement dit, si le tableau à trier a une taille supérieure

à (ce qui est souvent le cas), l'algorithme de complexité est

plus rapide, même si la constante est fois plus élevée.

Une grande partie de l'algorithmique est consacrée à trouver des algorithmes

efficaces du point de vue de la complexité asymptotique. De plus, on est

parfois capable de prouver que l'algorithme trouvé est le plus efficace

possible. Dans le cas du tri, par exemple, on peut prouver que si l'on n'utilise

que des comparaisons pour déterminer le plus grand de deux nombres, alors,

un algorithme ne peut pas avoir une complexité asymptotique inférieure

à . Un tel résultat est très important; en effet on ne perdra pas son

temps à rechercher un algorithme plus rapide qui n'existe pas.

Vous aimerez peut-être aussi

- 674 Fiche AmphibiensDocument4 pages674 Fiche AmphibiensLaenetGalumetteJosephJuniorPaulPas encore d'évaluation

- Degré MoyenDocument3 pagesDegré MoyenLaenetGalumetteJosephJuniorPaulPas encore d'évaluation

- Type AbstraitDocument4 pagesType AbstraitLaenetGalumetteJosephJuniorPaulPas encore d'évaluation

- Le Différence Entre Un Algorithme Et Un ProgrammeDocument2 pagesLe Différence Entre Un Algorithme Et Un ProgrammeLaenetGalumetteJosephJuniorPaulPas encore d'évaluation

- Les Bases D'informatiqueDocument374 pagesLes Bases D'informatiqueSami Ben El MamounPas encore d'évaluation

- Informatique GeneraleDocument114 pagesInformatique GeneraleLaenetGalumetteJosephJuniorPaul100% (4)

- Configuration Du Thomson Gateway TG585 v7Document5 pagesConfiguration Du Thomson Gateway TG585 v7LaenetGalumetteJosephJuniorPaulPas encore d'évaluation

- CV Saihi HosseinDocument1 pageCV Saihi HosseinNoureddineLaarejPas encore d'évaluation

- Fiche Guide - Déployer L'agent OCS INVENTORY Par GPODocument7 pagesFiche Guide - Déployer L'agent OCS INVENTORY Par GPOali azigPas encore d'évaluation

- PLC EXAM IV NIVEAU (Fin) Version FinaleDocument11 pagesPLC EXAM IV NIVEAU (Fin) Version FinaleScribdTranslationsPas encore d'évaluation

- Poly3 ASDDocument57 pagesPoly3 ASDRania AlibiPas encore d'évaluation

- Bousmah Flutter 2021Document15 pagesBousmah Flutter 2021lamiakarimPas encore d'évaluation

- Examen FinalDocument19 pagesExamen FinalBambaPas encore d'évaluation

- Hallou JugurthaDocument91 pagesHallou JugurthaLamiae ElguelouiPas encore d'évaluation

- TP N1 - & - 2 - AITC - Guide - KOF - 025 - EDocument19 pagesTP N1 - & - 2 - AITC - Guide - KOF - 025 - EBen Mekki HoucinePas encore d'évaluation

- Lisez MoiDocument4 pagesLisez MoiFajjeri HadilPas encore d'évaluation

- Conversion Binaire-Hexadécimal - Cours D'électroniqueDocument3 pagesConversion Binaire-Hexadécimal - Cours D'électroniqueCharles KouaméPas encore d'évaluation

- Lecon 1Document36 pagesLecon 1Alex Yvan SadiaPas encore d'évaluation

- NAAJI Dorian Rapport de Projet PDFDocument58 pagesNAAJI Dorian Rapport de Projet PDFyeoi ganamPas encore d'évaluation

- Compte Rendu PPPDocument15 pagesCompte Rendu PPPSalah Eddine25% (4)

- Comment Apporter Des Modifications Dans Un Document PDFDocument2 pagesComment Apporter Des Modifications Dans Un Document PDFKatie100% (1)

- VHDL ProcesseurDocument21 pagesVHDL ProcesseurchaoukiPas encore d'évaluation

- FormationSpringBoot 5 SpringBootDocument63 pagesFormationSpringBoot 5 SpringBoothounaine100% (1)

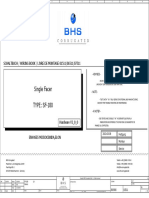

- Single Facer TYPE: SF-180: Schaltbuch / Wiring Book / Livre de Montage 01511/06511/07511Document95 pagesSingle Facer TYPE: SF-180: Schaltbuch / Wiring Book / Livre de Montage 01511/06511/07511Diego Armando Carrera palmaPas encore d'évaluation

- Chapitre 7 - Interface-Graphique-Sur-Python-Bac-Sciences - Prof - 2022Document3 pagesChapitre 7 - Interface-Graphique-Sur-Python-Bac-Sciences - Prof - 2022mahjoubi RabiePas encore d'évaluation

- Cours Réseau Informatique Master1 OkDocument58 pagesCours Réseau Informatique Master1 OkBARRYPas encore d'évaluation

- Agile Livre BlancDocument12 pagesAgile Livre BlancJean-Yves AtquetPas encore d'évaluation

- Guide TechniqueDocument140 pagesGuide TechniqueMiaBabilonPas encore d'évaluation

- 0657 Routage Et Reseaux IpDocument68 pages0657 Routage Et Reseaux Ipben yasPas encore d'évaluation

- Introduction Au Web CoursDocument26 pagesIntroduction Au Web Coursstanislas nabelewaPas encore d'évaluation

- Programme de Formation Développement WebDocument5 pagesProgramme de Formation Développement Webchristianmbuyal98Pas encore d'évaluation

- Bfotice 1Document52 pagesBfotice 1Burkina YABREPas encore d'évaluation

- Les Automatismes Industrielles (Api)Document10 pagesLes Automatismes Industrielles (Api)JospinPas encore d'évaluation

- BW410 16Document2 pagesBW410 16S&G SAPro AdvisoryPas encore d'évaluation

- Accès Et Fonctionnement Des Services Informatiques Offerts Aux Étudiants (Campus de Lévis)Document5 pagesAccès Et Fonctionnement Des Services Informatiques Offerts Aux Étudiants (Campus de Lévis)celia liaPas encore d'évaluation

- Lista Nueva 14 de Octubre-1Document43 pagesLista Nueva 14 de Octubre-1jimmy omarPas encore d'évaluation

- Rapport VANET2Document31 pagesRapport VANET2Sadia BoulhianPas encore d'évaluation