Académique Documents

Professionnel Documents

Culture Documents

Essaie de Correction Inf371

Transféré par

stive kevin Watat yondepTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Essaie de Correction Inf371

Transféré par

stive kevin Watat yondepDroits d'auteur :

Formats disponibles

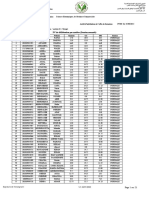

ESSAIE DE CORRECTION INF371

Partie 1 : Data Mining

Question de Cours

1) Definitions

Données Etiquetées : Ce sont des données de la forme (X, Y) ou X est un parametre observé

sur un individu (variables indépendante) et Y est une classe ou une valeur numérique

représentant la variable dépendante.

Fouille de données : Ensemble des méthodes, techniques et outils utilisés pour extraire de la

connaissance dans un ensemble de données de taille importante

Motif fréquent : C’est un ensemble d’item dont le support est supérieur au seuil de

fréquence fixé

Règle d’association : C’est une implication de la forme A=a => B=b qui se traduit par : Lorsque

A prend la valeur a B prend généralement la valeur b

2) Etapes de la fouille de données :

- Compréhension du domaine,

- Compréhension des données,

- Prétraitement des données,

- Modélisation et Evaluation et

- Deployement

3) Validation :

- Validation croisée d’ordre k : Ici on divise le dataset en k partie disjointes et pour i allant de

1 a k on considère à chaque fois la partie i comme testset et le reste comme trainset.

L’évaluation du modèle finale s’obtient en faisant la moyenne des performances des k

modèles.

- Holdout : Ici on divise le dataset en 2 parties (testset et trainset) avec une proportion p pour

le train set (généralement 0.7, 0.75, 0.8)

4) Precision = C’est la probabilité sachant que la prédiction la prédiction d’une classe est k

d’observé effectivement cette classe.

Rappel = C’est la probabilité sachant qu’une classe k est observé de prédire cette clas

Exercice 2

1) Commande R

df <- read.table(‘’file.txt’’, na.string=”?”, sep=”,”, dec=’’.’’)

2) On peut remplacer les Valeurs manquantes par une valeur par défaut (moyenne, medianne

pour les valeurs numériques ou le mode pour les valeurs catégorielles ou une valeur définie

par l’expert du domaine). On peut aussi utiliser la régression/classification pour remplacer les

valeurs manquantes.

3) Normaliser les données c’est les mettre dans une echelle de [0 ;1] ou [-1 ; 1].

#Normalisation Z-score

df$X1.scale <- scale(df$X1)

df$X2.scale <- scale(df$X2)

#Normalisation min-max

df$X1.scale <- scale(df$X1, center=min(df$X1), scale=(max(df$X1)-min(df$X1)))

df$X2.scale <- scale(df$X2, center=min(df$X2), scale=(max(df$X2)-min(df$X2)))

4) Discrétiser les données :

df$X1.discr <- cut(df$X1.scale, breaks=5)

df$X2.discr <- cut(df$X2.scale, breaks=5)

#regles d’association

library(arules)

df_matrix<- as.matric(df[,c(“df$X1.discr”, “df$X1.discr”, “Classe”)])

df_trans=as(df_matrix, ‘’transactions")

regles<-appriori(df_trans, ,parameter = list(supp=0.5,conf=0.8))

regles=sort(regles , by="lift")

Vous aimerez peut-être aussi

- SAD - Chap 2Document83 pagesSAD - Chap 2Gazdallah AmiraPas encore d'évaluation

- Chapitre 3Document40 pagesChapitre 3Dia Mouhamadou NabyPas encore d'évaluation

- Apprentissage SuperviseDocument16 pagesApprentissage SuperviseBaron DuvalPas encore d'évaluation

- Chapitre 5Document7 pagesChapitre 5MohamedLashabPas encore d'évaluation

- Progres2019 5Document44 pagesProgres2019 5SALMA CHLAIKHYPas encore d'évaluation

- DM Ch4Document29 pagesDM Ch4mohamedamin.benslimenPas encore d'évaluation

- Algo ClassificationDocument19 pagesAlgo ClassificationferyelPas encore d'évaluation

- Tps Data Mining (Matlab)Document14 pagesTps Data Mining (Matlab)Mohammed Amine Halbaba100% (10)

- Chap2 4 1Document53 pagesChap2 4 1Saif NairiPas encore d'évaluation

- Classification Supervise eDocument20 pagesClassification Supervise eSofiene GuedriPas encore d'évaluation

- Statistiques Descriptives À Une Ou Deux DimensionsDocument10 pagesStatistiques Descriptives À Une Ou Deux DimensionsJasmine BenhalimaPas encore d'évaluation

- Chapitre2 - Mukinga Kakonge Moise A CorrigerDocument15 pagesChapitre2 - Mukinga Kakonge Moise A CorrigerËmrÿs MösësPas encore d'évaluation

- CC Machine LearningDocument7 pagesCC Machine LearningNaomie JenniferPas encore d'évaluation

- FR Tanagra Scikit Learn Decision Tree 2Document24 pagesFR Tanagra Scikit Learn Decision Tree 2benn yassPas encore d'évaluation

- TP KNNDocument2 pagesTP KNNfatma.abidPas encore d'évaluation

- Chapitre 1Document29 pagesChapitre 1Ela RzigaPas encore d'évaluation

- Leçon6-Arbre de DecisionDocument25 pagesLeçon6-Arbre de DecisionOthmane Rais100% (1)

- FDD Et Arbres de Décision: Christelle Scharff IFI Juin 2004Document52 pagesFDD Et Arbres de Décision: Christelle Scharff IFI Juin 2004elarrouchiPas encore d'évaluation

- Arbre de DecisionDocument17 pagesArbre de DecisionÂßd ĕrăhmãńėPas encore d'évaluation

- BENMANSOUR KAOUTHAR CcsysidDocument9 pagesBENMANSOUR KAOUTHAR CcsysidkaoutharPas encore d'évaluation

- Cours SegmentationDocument43 pagesCours Segmentationhabitav2023Pas encore d'évaluation

- Encodage Et Normalisation Des DonnéesDocument3 pagesEncodage Et Normalisation Des DonnéesMedilyass ElhamdaouiPas encore d'évaluation

- Annals 1Document13 pagesAnnals 1Lina ThabetPas encore d'évaluation

- Support CoursDocument42 pagesSupport CoursLeila AmranePas encore d'évaluation

- Big Data Mining JJDocument91 pagesBig Data Mining JJNouradin Hassan DararPas encore d'évaluation

- MEthode Sous RDocument19 pagesMEthode Sous Rdaoud ounaissiPas encore d'évaluation

- Data Mining Description SP 2022Document20 pagesData Mining Description SP 2022ads asd100% (1)

- ALG08 Algorithme kNN2Document4 pagesALG08 Algorithme kNN2OrnetAndIcePas encore d'évaluation

- TP4 ClassificationSupervisée StudentDocument11 pagesTP4 ClassificationSupervisée Studentmohamed anouar hassinePas encore d'évaluation

- 01 Intro RegLin RegLogBinDocument47 pages01 Intro RegLin RegLogBinفركوس محمد العيدPas encore d'évaluation

- Chapitre 2Document16 pagesChapitre 2SARA STAMBOULIPas encore d'évaluation

- K Plus Proches Voisins / K-Nearest Neighbors /KNNDocument8 pagesK Plus Proches Voisins / K-Nearest Neighbors /KNNAbdallahi SidiPas encore d'évaluation

- TP RCP208 PMC RegressionDocument9 pagesTP RCP208 PMC RegressionDaly ZeddiniPas encore d'évaluation

- RFIA Cours3 PDFDocument36 pagesRFIA Cours3 PDFMINAPas encore d'évaluation

- Resume CoursDocument28 pagesResume Coursbr18Pas encore d'évaluation

- Feuille de Notes de StatistiquesDocument2 pagesFeuille de Notes de Statistiquesnaikhaalexis0904Pas encore d'évaluation

- Chapitre 1 Introduction Du StatistiqueDocument5 pagesChapitre 1 Introduction Du StatistiquePhương Linh NguyễnPas encore d'évaluation

- ResuméDocument30 pagesResuméLalla Sanae JazouliPas encore d'évaluation

- C3 ClusteringDocument29 pagesC3 ClusteringAmeni BoughanmiPas encore d'évaluation

- Chapitre 1Document11 pagesChapitre 1Ahmed NsirPas encore d'évaluation

- Cours de Statistic 1 Et 2Document6 pagesCours de Statistic 1 Et 2Bilal SaghirPas encore d'évaluation

- FDD Cours PDFDocument94 pagesFDD Cours PDFAnsoumane DaffPas encore d'évaluation

- KmeansDocument55 pagesKmeansAdam AmmourPas encore d'évaluation

- Chapitre 1 Statistique Descriptive PDFDocument6 pagesChapitre 1 Statistique Descriptive PDFÎlŸãş MïmøPas encore d'évaluation

- Partie 1: Statistiques Descriptives (Suite) : Ecole Mohammedia D'ingénieurs Année 2017-2018Document13 pagesPartie 1: Statistiques Descriptives (Suite) : Ecole Mohammedia D'ingénieurs Année 2017-2018Ahmed El MokademPas encore d'évaluation

- CM5 DecisionTreeDocument29 pagesCM5 DecisionTreerosecoco1248Pas encore d'évaluation

- Chap3-Recherche Par Le ContenuDocument117 pagesChap3-Recherche Par Le ContenuSahar MANAIIPas encore d'évaluation

- Cours AA 11 OctobreDocument39 pagesCours AA 11 OctobreOUSSEMA KACHTIPas encore d'évaluation

- Cours02 baseDataScientistDocument60 pagesCours02 baseDataScientistKlechPas encore d'évaluation

- Notions Sur Les: Support Vector MachinesDocument23 pagesNotions Sur Les: Support Vector MachinesmouradPas encore d'évaluation

- Analyse Et Collecte Des DonneesDocument60 pagesAnalyse Et Collecte Des DonneesSnoussi EzPas encore d'évaluation

- ProjectDocument15 pagesProjectSoufyane EL OUAHABIPas encore d'évaluation

- Cours - Data Science Intro+ACPDocument63 pagesCours - Data Science Intro+ACPsalma tn100% (1)

- K Plus Proches Voisions K-Nearest Neighbors KNN: Mme Hiba Lahmer 2020/2021Document14 pagesK Plus Proches Voisions K-Nearest Neighbors KNN: Mme Hiba Lahmer 2020/2021Houssayen BenouhibaPas encore d'évaluation

- Chapitre3 ClassificationDocument33 pagesChapitre3 ClassificationRa NimPas encore d'évaluation

- Analyse de Données - Chapitre5Document33 pagesAnalyse de Données - Chapitre5YoussefPas encore d'évaluation

- TPE DAS Groupe2Document21 pagesTPE DAS Groupe2DJELASSEM CYRILLEPas encore d'évaluation

- Analyse de Données CoursDocument18 pagesAnalyse de Données CoursSlimani El Alaoui MohamedPas encore d'évaluation

- Classification contextuelle des images: Comprendre les données visuelles pour une classification efficaceD'EverandClassification contextuelle des images: Comprendre les données visuelles pour une classification efficacePas encore d'évaluation

- 2-Prog Maths MP 2ème Année PDFDocument27 pages2-Prog Maths MP 2ème Année PDFZémzém YoocefPas encore d'évaluation

- Secg Lessons06-Regression LineaireDocument58 pagesSecg Lessons06-Regression LineaireAnonymous Wk05C1IlVPas encore d'évaluation

- Números ComplejosDocument22 pagesNúmeros ComplejosmichaelPas encore d'évaluation

- 12 - Espaces Vectoriels Normes Exercices Corriges Indispensables PDFDocument7 pages12 - Espaces Vectoriels Normes Exercices Corriges Indispensables PDFAdam GuissouPas encore d'évaluation

- Cours Sur Les Cartes de Controle - SPCDocument5 pagesCours Sur Les Cartes de Controle - SPCMeryem BelhassanePas encore d'évaluation

- Deliberation - SN - 2022 - 2023-4السنة الثالثة ادارة اعمالDocument12 pagesDeliberation - SN - 2022 - 2023-4السنة الثالثة ادارة اعمالDali InstaPas encore d'évaluation

- Problemes Au BAC S2 de 1999 À 2022 PDF Fonction (Mathématiques) Tangente (Géométrie)Document1 pageProblemes Au BAC S2 de 1999 À 2022 PDF Fonction (Mathématiques) Tangente (Géométrie)t7jdzxf4ttPas encore d'évaluation

- 821 2020 03 26 Seance SuiteDocument18 pages821 2020 03 26 Seance SuiteYousra Alaoui SossePas encore d'évaluation

- Révision 2020 2021 Analyse NumériqueDocument2 pagesRévision 2020 2021 Analyse NumériquececzczcPas encore d'évaluation

- 2014 Mines MP Maths2Document6 pages2014 Mines MP Maths2MI DOPas encore d'évaluation

- 2.1 Itération de Type Point Fixe, Cas Général: Cos XDocument12 pages2.1 Itération de Type Point Fixe, Cas Général: Cos Xloic.savorninPas encore d'évaluation

- Analyse Des Données Mouna BEN ALIDocument15 pagesAnalyse Des Données Mouna BEN ALISidiPas encore d'évaluation

- Cours AZIEZ RDM I.31 PDFDocument5 pagesCours AZIEZ RDM I.31 PDFLalia MimiPas encore d'évaluation

- Chapitre 1 Polynomes Et Fractions Rationnelles (1) PpintDocument60 pagesChapitre 1 Polynomes Et Fractions Rationnelles (1) PpintmohamedPas encore d'évaluation

- Méthodes de Monte Carlo Pour La FinanceDocument72 pagesMéthodes de Monte Carlo Pour La FinanceRajita EconomistePas encore d'évaluation

- Cours 1 Analyse NumeriqueDocument29 pagesCours 1 Analyse NumeriqueThouraya Haj HssanPas encore d'évaluation

- Fondamentaux de La Data ScienceDocument5 pagesFondamentaux de La Data SciencebitouPas encore d'évaluation

- Devoir Maison 4: Exercice 1: Autour Des Coefficients BinomiauxDocument14 pagesDevoir Maison 4: Exercice 1: Autour Des Coefficients BinomiauxOsée MagloirePas encore d'évaluation

- AfcDocument14 pagesAfcMandy100% (1)

- Fasicule TS1Document77 pagesFasicule TS1Mohamed Konate0% (1)

- DM 0708 CorrectionDocument4 pagesDM 0708 Correctionmax ManPas encore d'évaluation

- Optimisation - Corrigé - Série N°1Document7 pagesOptimisation - Corrigé - Série N°1Katia ChalalPas encore d'évaluation

- Limites Fonctions ExercicesDocument5 pagesLimites Fonctions ExercicesAngeauden DidoPas encore d'évaluation

- Adoption de La Norme Iso 9001 Par Les Entreprises Marocaine Du Secteur Textile HabillementDocument9 pagesAdoption de La Norme Iso 9001 Par Les Entreprises Marocaine Du Secteur Textile HabillementYounes El ManzPas encore d'évaluation

- Correction TD3Document5 pagesCorrection TD3Aymen GmarPas encore d'évaluation

- Cosd de Rufisque Anne Scolaire 2012Document2 pagesCosd de Rufisque Anne Scolaire 2012Samba Sall100% (1)

- Chapitre1 FCT Complexes - FinalDocument15 pagesChapitre1 FCT Complexes - FinalSilner DzPas encore d'évaluation

- CH IntimpDocument19 pagesCH IntimpHich EmPas encore d'évaluation

- Fonction de Reference - Correction PDFDocument4 pagesFonction de Reference - Correction PDFabdlkarimPas encore d'évaluation