Académique Documents

Professionnel Documents

Culture Documents

TD 1 Codage Et Compression

Transféré par

maissaTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

TD 1 Codage Et Compression

Transféré par

maissaDroits d'auteur :

Formats disponibles

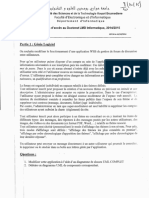

Université Mohamed Bachir El Ibrahimi de Bordj Bou Arréridj

Département d’électronique-Faculté S.T

Travaux Dirigés

Master I- Systèmes de Télécommunications

(2019-2020)

UE: Codage et Compression

Série 1: Codage et Compression

Responsable de l’UE: Prof. AIDEL Salih

I. Exercice 1.

Rappelez la définition de l'entropie d'une source discrète. Quel est son signe ?

Que représente l'entropie en terme d'information ?

II. Exercice 2:

On considère un fichier binaire formé de valeurs aléatoires. A quelles conditions

est-il possible (en théorie) de compresser l’information ?

III. Exercice 3:

Une source fournit des symboles de l’alphabet {A, G, C, T} de probabilités connues,

respectivement 0.44 ; 0.23 ; 0.19 ; 0.14 .

1. Y a-t-il pour coder ces symboles un code efficace ?

2. Quelles performances pourrait-on attendre d’un tel code ?

3. Pouvez-vous en proposer un ?

IV . Exercice 4:

Pour une source à trois symboles quelles sont les valeurs possibles de l’entropie

de la source ?

1. Même question pour une source à 4 symboles.

2. Peut-on citer des conditions sur les probabilités des 4 symboles pour qu’il existe

un code meilleur ?

3. que le code fixe de longueur 2 ?

4. Quelle est la condition pour qu'un code optimal coïncide avec l'entropie ?

V. Exercice 5:

Vérifiez que pour une source discrète de n symboles l’entropie est maximale si les

probabilités sont identiques.

1. Montrez que pour une source continue prenant ses valeurs dans l’intervalle [a, b]

l’entropie est maximale si la loi de probabilité est uniforme.

2. Y a-t-il une loi qui minimise la valeur de l’entropie ?

Vous aimerez peut-être aussi

- Interrogaation Codage Compression M1 2019Document1 pageInterrogaation Codage Compression M1 2019ranacheurfaPas encore d'évaluation

- TP 2Document2 pagesTP 2Naïm AbdelkerimPas encore d'évaluation

- TD 4 RSF RM 3g Umts 2021Document1 pageTD 4 RSF RM 3g Umts 2021manoplomiPas encore d'évaluation

- Corrige Sujet2 Theorie de InfoDocument4 pagesCorrige Sujet2 Theorie de InfoFopaPas encore d'évaluation

- EXAMEN Blanc Reseaux - Smi S5 29012021Document2 pagesEXAMEN Blanc Reseaux - Smi S5 29012021REDOUANE BOUGLIA100% (1)

- Test TP-Codage Et Compression-BoukenadilDocument1 pageTest TP-Codage Et Compression-Boukenadilredouan hamidatPas encore d'évaluation

- TD-6 RSF-RM - 5G Et Radio CognitiveDocument1 pageTD-6 RSF-RM - 5G Et Radio CognitiveYazid ZitouniPas encore d'évaluation

- TD 02Document2 pagesTD 02DO UAPas encore d'évaluation

- Fiche TD N°1Document1 pageFiche TD N°1Tiki RistoPas encore d'évaluation

- TP Cna 2022Document11 pagesTP Cna 2022imadPas encore d'évaluation

- TD-5-Téléphonie 4G-LTEDocument1 pageTD-5-Téléphonie 4G-LTEYazid ZitouniPas encore d'évaluation

- Reseau Sans Fil 1Document2 pagesReseau Sans Fil 1Franck kévin NyemeckPas encore d'évaluation

- Cours 03Document7 pagesCours 03sekPas encore d'évaluation

- Info Eval1 Terminale Ti 21 22Document2 pagesInfo Eval1 Terminale Ti 21 22jean christ nelson mboudouPas encore d'évaluation

- 01 Codes Correcteurs D'erreurs 4 Transparents Par PageDocument15 pages01 Codes Correcteurs D'erreurs 4 Transparents Par PagemeedstartPas encore d'évaluation

- Fiche-TD 1 2 3 4 5Document6 pagesFiche-TD 1 2 3 4 5BafadePas encore d'évaluation

- Série de TD 3: Module NS522 ELN3Document2 pagesSérie de TD 3: Module NS522 ELN3Adel-Hani MiloudiPas encore d'évaluation

- FGI - TD Theorie de L'info Et Du CodageDocument3 pagesFGI - TD Theorie de L'info Et Du CodagePatrick NdjikePas encore d'évaluation

- Examen Codage Compression M1 2019Document2 pagesExamen Codage Compression M1 2019ranacheurfaPas encore d'évaluation

- Corrigé Série TD1Document5 pagesCorrigé Série TD1yanisPas encore d'évaluation

- Généralités Sur Les Réseaux Informatiques - 2Document18 pagesGénéralités Sur Les Réseaux Informatiques - 2Awichoux TraorePas encore d'évaluation

- RIL (Eln) TD1Document1 pageRIL (Eln) TD1Menasria MissivaPas encore d'évaluation

- Traci Chap2 Part1Document15 pagesTraci Chap2 Part1DO UAPas encore d'évaluation

- Compte Rendu RésauxDocument13 pagesCompte Rendu RésauxAmal Hasmi0% (1)

- 01 Codes Correcteurs D'erreursDocument58 pages01 Codes Correcteurs D'erreursDatey Kodjo Benissan-messanPas encore d'évaluation

- Evalaluation de Fin Du Cours TELEINFORMATIQUE RIT1 USAGDocument1 pageEvalaluation de Fin Du Cours TELEINFORMATIQUE RIT1 USAGGodefroy Cheumani TcheumaniPas encore d'évaluation

- Série 01 RilDocument2 pagesSérie 01 RilRottina RossyPas encore d'évaluation

- Cours Et TD Codage Et Théorie de L'informationDocument42 pagesCours Et TD Codage Et Théorie de L'informationNinå Så100% (3)

- TD Liaison Des DonnéesDocument2 pagesTD Liaison Des DonnéesSarra SamaaliPas encore d'évaluation

- TD3 Protection Contre Erreurs FDocument1 pageTD3 Protection Contre Erreurs FAli KHALFAPas encore d'évaluation

- Examen SN - 2020 2021 - Smi5 Lp2iDocument2 pagesExamen SN - 2020 2021 - Smi5 Lp2iØssama AjbliPas encore d'évaluation

- TD1 Reseaux1Document4 pagesTD1 Reseaux1Ahmed La MiriPas encore d'évaluation

- Travaux Diriges N 1 2 3 Sam Au 2021 2022Document9 pagesTravaux Diriges N 1 2 3 Sam Au 2021 2022Kam ZegPas encore d'évaluation

- Codage 2 ATel 20Document3 pagesCodage 2 ATel 20Jesser DridiPas encore d'évaluation

- Liaison de DonnéesDocument12 pagesLiaison de DonnéesWissem FäễPas encore d'évaluation

- Solutions Travaux Diriges N 1 2 3 Sam Au 2021 2022Document18 pagesSolutions Travaux Diriges N 1 2 3 Sam Au 2021 2022Kam ZegPas encore d'évaluation

- Présentation Du Master Systèmes Des TélécommunicationsDocument1 pagePrésentation Du Master Systèmes Des TélécommunicationsIkram IkramPas encore d'évaluation

- Theorie D'informationDocument2 pagesTheorie D'informationLion DE AbderrazakPas encore d'évaluation

- TD RéseauDocument4 pagesTD Réseauharold ChoudjaPas encore d'évaluation

- td1 CrypDocument1 pagetd1 CrypBOUMAAZA FaridPas encore d'évaluation

- Exercice 0:: Universite de Thies Ufr Set Dpt. InformatiqueDocument6 pagesExercice 0:: Universite de Thies Ufr Set Dpt. InformatiqueAssane cisse NiassPas encore d'évaluation

- Corrigé-Type Sec Inf l3 CompressedDocument3 pagesCorrigé-Type Sec Inf l3 CompressedAbir ZahraouiPas encore d'évaluation

- TP 1 Atl Info 2Document7 pagesTP 1 Atl Info 2Molka ZayaniPas encore d'évaluation

- Eval Sq0 2018 CorrectionDocument1 pageEval Sq0 2018 CorrectionLuc Manureva SchuhmacherPas encore d'évaluation

- Codes de Blocs Lineaires PDFDocument12 pagesCodes de Blocs Lineaires PDFfidou1860Pas encore d'évaluation

- Info Genie Logiciel BD 2014Document3 pagesInfo Genie Logiciel BD 2014Laradj CHELLAMAPas encore d'évaluation

- TP N1 Charrad Oumayma Guedhami Hamdi Rjab Oumayma RT3 - 2Document14 pagesTP N1 Charrad Oumayma Guedhami Hamdi Rjab Oumayma RT3 - 2Hamdi GdhamiPas encore d'évaluation

- TP 1Document1 pageTP 1Naïm Abdelkerim100% (2)

- TP2 Langage de Programmation CDocument2 pagesTP2 Langage de Programmation CHamza BouzammitPas encore d'évaluation

- Predoc Teleinfo Hiver 2003Document13 pagesPredoc Teleinfo Hiver 2003ibara guelorPas encore d'évaluation

- Emd4 1Document1 pageEmd4 1indianaaris20Pas encore d'évaluation

- Reseau 2019 CorrigéDocument4 pagesReseau 2019 CorrigéDkfk HdjdPas encore d'évaluation

- TD1 Codage Et Compression 2017Document1 pageTD1 Codage Et Compression 2017Babi Ben100% (1)

- Introduction Et Chapitre I Télématique I G3 FASI UPCDocument12 pagesIntroduction Et Chapitre I Télématique I G3 FASI UPCSynthia KapengaPas encore d'évaluation

- Série 03-Télécommunications-FondamentalesDocument2 pagesSérie 03-Télécommunications-FondamentalesMohammed BenedinePas encore d'évaluation

- Controle 2Document2 pagesControle 2Lion DE AbderrazakPas encore d'évaluation

- Inbound 3607869966600314313Document5 pagesInbound 3607869966600314313Maroua SouidPas encore d'évaluation

- Chapitre 2 Codages EntropiquesDocument9 pagesChapitre 2 Codages EntropiquesBenmo AbdoPas encore d'évaluation

- Les Codes Correcteurs D'erreurs (CCE) : Introduction Aux CCE Application VHDL Du Code de HammingDocument74 pagesLes Codes Correcteurs D'erreurs (CCE) : Introduction Aux CCE Application VHDL Du Code de HammingsafaPas encore d'évaluation

- 6-Maintenance Et Suivi Du RéseauDocument43 pages6-Maintenance Et Suivi Du RéseauAbdou OuChPas encore d'évaluation

- Électricité: Objectif PédagogiqueDocument32 pagesÉlectricité: Objectif PédagogiqueAya MahdadPas encore d'évaluation

- 1-Installation Passive Du Réseau Série 02Document17 pages1-Installation Passive Du Réseau Série 02maissaPas encore d'évaluation

- 4-Installation Active Du Réseau Série 01Document12 pages4-Installation Active Du Réseau Série 01maissaPas encore d'évaluation

- Chapitre I SETDocument14 pagesChapitre I SETmaissaPas encore d'évaluation

- Chapitre I SETDocument14 pagesChapitre I SETmaissaPas encore d'évaluation

- FILTRESNUMERIQUES - CHP02 - Cours 02Document10 pagesFILTRESNUMERIQUES - CHP02 - Cours 02maissaPas encore d'évaluation

- Fiche TP Codage MasterI TLC RTSTDocument11 pagesFiche TP Codage MasterI TLC RTSTmaissaPas encore d'évaluation

- Chapitre I SETDocument14 pagesChapitre I SETmaissaPas encore d'évaluation

- Chap 1 - Codage Et Compression - M1Document24 pagesChap 1 - Codage Et Compression - M1maissaPas encore d'évaluation