Académique Documents

Professionnel Documents

Culture Documents

2021-2022 TALN CF Corrige

Transféré par

fatmazohra rezkellahTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

2021-2022 TALN CF Corrige

Transféré par

fatmazohra rezkellahDroits d'auteur :

Formats disponibles

École nationale Supérieure d'Informatique (ESI), Alger

2CSSID 2021/2022

Contrôle Final (CF)

Traitement automatique du langage naturel (TALN)

Lundi 20 juin 2022 - [9h, 10h30] - Partie 1

Documents non autorisés

Au delà de deux questions (pour tout l'examen), l'étudiant aura (-0.25) pour chaque question

Il faut répondre sur cette feuille (pages 1 et 2) et la rendre même si elle est vide

Au cas d'insuffisance des copies, recopier les réponses sur une feuille d'examen séparée de celle des

exercices

Nom + Prénom : NLP TALN

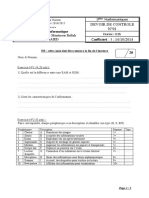

01. QCM (11pts : 30mn)

Pour chaque question, un choix erroné annule un autre correct. La note minimale par question est 0. La

politique peut varier selon la question.

1) Comparer entre les représentations d'un mot [3pts]. Ligne correcte (+0.5), (-0.25) pour chaque réponse

fausse par ligne, la note d'une ligne dans le cas où le nombre des choix corrects dépasse la moitié et n'atteint

pas la totalité des choix corrects est (0.25) sinon (0), la note minimale par ligne est (-0.5).

Lexicale Mot-Mot Word2Vec GloVe ELMo BERT

Représente la relation IS-A d'une manière explicite

☒ ☐ ☐ ☐ ☐ ☐

(directe)

Se base sur la co-occurrence des mots dans un

☐ ☒ ☒ ☒ ☒ ☒

corpus

Si oui (question passée), le contexte est fixe

☐ ☒ ☒ ☒ ☐ ☐

(nombre des mots avant et après)

Nécessite un réseau de neurones pour apprendre la

☐ ☐ ☒ ☒ ☒ ☒

représentation

Un mot peut avoir plusieurs représentations selon

☒ ☐ ☐ ☐ ☒ ☒

son sens (polysémie)

Prend en considération les variations

☒ ☐ ☐ ☐ ☒ ☒

morphologiques du mot

2) Etant donné les rôles sémantiques suivants :

Rôle Description

AGENT Le causeur volontaire d’un événement

EXPERIENCER L’expérimentateur d’un événement

FORCE Le causeur non volontaire d’un événement

THEME Le participant affecté directement par l’évènement

RESULT Le produit final d’un événement

CONTENT Une proposition ou le contenu d’un événement propositionnel

INSTRUMENT Un instrument utilisé dans l'événement

BENEFICIARY Le bénéficiaire d’un événement

Alger.ESI.2CSSID.TALN.CF page 1/5

Pour chaque syntagme nominal de la phrase "Le vent a cassé la fenêtre avec une pierre", sélectionner son rôle

sémantique [1.5pts]. (+0.5) pour un choix correct, (-0.5) pour un choix erroné.

SN \ Rôle AGENT EXPERIENCER FORCE THEME RESULT CONTENT INSTRUMENT BENEFICIARY

Le vent ◯ ◯ ⬤ ◯ ◯ ◯ ◯ ◯

la fenêtre ◯ ◯ ◯ ⬤ ◯ ◯ ◯ ◯

une pierre ◯ ◯ ◯ ◯ ◯ ◯ ⬤ ◯

3) Parmi les propositions suivantes (concernant les coréférences), choisir si elles sont toujours justes (OUI),

toujours fausses (NON) ou peuvent êtres correctes des fois (PEUT-ETRE) [2pts]. (+0.5) pour un choix correct,

(-0.5) pour un choix erroné.

Nomenclature : L'examen [référent] est …. Il [référence] …

OUI NON PEUT-ETRE

La référence suit le référent dans le texte. ◯ ◯ ⬤

Un syntagme en coréférence avec un autre est une référence et un

⬤ ◯ ◯

référent en même temps.

Avant d'appliquer la résolution de la coréférence, nous appliquons le

◯ ⬤ ◯

filtrage des mots vides sur le texte

La détection de coréférence utilise la détection de mention ⬤ ◯ ◯

4) Comparer les méthodes d'analyse de cohérence [2pts]. Ligne correcte (+0.5), (-0.25) pour chaque réponse

fausse par ligne, la note d'une ligne dans le cas où le nombre des choix corrects dépasse la moitié et n'atteint

pas la totalité des choix corrects est (0.25) sinon (0), la note minimale par ligne est (-0.5).

RST PDTB Centering theory Entity grid

Basée sur la structure du discours ☒ ☒ ☐ ☐

La cohérence est représentée d'une manière binaire ☐ ☒ ☒ ☐

La cohérence est estimée par la distribution des patterns ☐ ☐ ☐ ☒

La cohérence est une relation entre un noyau et un satellite ☒ ☐ ☐ ☐

5) Comparer entre les systèmes suivants : traduction automatique (MT), résumé automatique (AS),

questions-réponses (QA), système de dialogue (DS) et analyse de sentiments (SENT) [2.5pts]. Ligne correcte

(+0.5), (-0.25) pour chaque réponse fausse par ligne, la note d'une ligne dans le cas où le nombre des choix

corrects dépasse la moitié et n'atteint pas la totalité des choix corrects est (0.25) sinon (0), la note minimale

par ligne est (-0.5).

MT AS QA DS SENT

L'utilisateur peut introduire un seul mot et le résultat reste raisonnable ☒ ☐ ☐ ☒ ☒

Un système de recherche d'information peut être utilisé par ce système ☐ ☒ ☒ ☒ ☐

Ce système ne peut pas générer du texte ☐ ☐ ☐ ☐ ☒

Ce système n'utilise aucune étape de prétraitement ☐ ☐ ☐ ☐ ☐

Ce système est difficil à évaluer automatiquement ☐ ☐ ☐ ☒ ☐

Alger.ESI.2CSSID.TALN.CF page 2/5

École nationale Supérieure d'Informatique (ESI), Alger

2CSSID 2021/2022

Contrôle Final (CF)

Traitement automatique du langage naturel (TALN)

Lundi 20 juin 2022 - [9h, 10h30] - Partie 2

Documents non autorisés

Rappel : Au delà de deux questions (pour tout l'examen), l'étudiant aura (-0.25) pour chaque question

La réponse est sur la feuille d'examen ; Vous pouvez prendre cette feuille avec vous

Au cas d'une erreur dans le sujet, corriger la, justifier pourquoi c'est une erreur et continuer l'examen par

rapport votre corrigé.

02. Application (5.5pts : 40mn)

Voici les phrases et la grammaire vues en contrôle intermédiaire (CI) :

I fish small fish S → NP VP AJ → small | big

I swim like fish NP → AJ NM | NM | PN NM → fish | ducks

ducks swim VP → VB NP | VB PP VB → fish | like | swim

I like big fish PP → PR NP PN → I PR → like

A) Sémantique et représentation des mots

1. Etant donné les concepts [big, ducks, fish, I, like, small, swim], représenter les deux mots "fish" et

"swim" en utilisant une fenêtre 1-1 et calculer la similarité cosinus entre les deux [0.75pts]

fish : [1, 0, 0, 1, 1, 2, 0] (0.25pt) ducks : [0, 1, 0, 1, 1, 0, 0] (0.25pt)

cos(fish, ducks) = 2/(rac(7)*rac(3)) (0.25pt)

2. Peut-on calculer une similarité basée sur les relations IS-A de Wordnet entre ces deux mots ?

Non:Pourquoi/Oui:Comment ? [0.75pts]

Non (0.25pt) Puisque les catégories grammaticales des deux mots sont différentes fish/nom

swim/verbe (0.5pt)

B) Sémantique de la phrase

Nous avons le domaine suivant : Constants : I ; Prédicats : LIKE(x, y) ; BIG(x) ; FISH(x).

1. Écrire la dernière phrase en logique du premier ordre en se basant sur ce domaine. [0.5pt]

∀x FISH(x) ∧ BIG(x) ⇒ LIKE(I, x) (0.5pt)

2. Écrire les règles sémantiques qui génèrent cette phrase (sans prendre en compte les autres phrases ;

utiliser seulement les 8 règles grammaticales qui la composent). [2.5pts]

S → NP VP VP.sem(NP.sem) (0.25pt)

NP → PN NP.sem = PN.sem (0.25pt)

PN → I PN.sem = I (0.25pt)

VP → VB NP VP.sem = NP.sem(VB.sem(y)) (0.25pt)

Alger.ESI.2CSSID.TALN.CF page 3/5

NP → AJ NM NP.sem = NM.sem(AJ.sem(x) ∧) (0.5pt)

AJ → big AJ.sem = λx. BIG(x) (0.25pt)

NM → fish NM.sem = λQ.λP.λy. Q(x) FISH(x) ⇒ P(x) (0.5pt)

VB → like VB.sem = λy.λx. LIKE(y, x) (0.25pt)

Autres variantes peuvent être justes; l'essentiel est que le quantificateur est lié soit au nom, soit au syntagme

nominal (vu que les articles de quantification sont absents)

C) Cohérence

Supposons que les quatres phrases forment un paragraphe dans cet ordre.

1. En se basant sur "RST (Rhetorical Structure Theory)", est ce que ce texte est cohérent ? Pourquoi ?

[0.5pt]

Non (0.25) Puisqu'il n'y a aucune relation entre les phrases (causalité, contradiction, etc.) (0.25)

2. En se basant sur "Centering theory", est ce que ce texte est cohérent ? Pourquoi ? [0.5pt]

Oui (0.25) puisque le centre du discours ne change pas (l'interlocuteur) sauf pour une seule

phrase (0.25)

03. Discussion (3.5pts : 20mn)

Voici un système basé sur les réseaux de neurones récurrents (RNN). Le schéma est lu de droite à gauche.

1. C'est quoi la tâche traitée par ce système ? [0.5pt]

Auto-complétion (basée sur caractères)

2. Combien de cellules LSTM auront-nous besoin ? Pourquoi ? [0.5pt]

2 (0.25) une pour l'encodeur et l'autre pour le décodeur (0.25)

3. Nous voulons utiliser un modèle BERT dans cette tâche.

a. Devons-nous l'utiliser pour encoder, décoder ou les deux ? Pourquoi ? [0.5pt]

Encodeur (0.25) Puisque BERT est composé de la partie encodeur du transformer (0.25)

Alger.ESI.2CSSID.TALN.CF page 4/5

b. Comment ce modèle doit être entraîné ? (entrées, sorties, description des tâches) [1pt]

Entrée : chaque caractère est encodé oneHot + encodage de position dans le mot +

encodage du mot (1 ou 2) (0.25)

Sortie : l'encodage OneHot de chaque caractère et la classe (suivant/non suivant) (0.25)

Tâches :

1) Estimation des caractères masqués : on remplace des caractères aléatoirement

par un indicateur [MASK] et on essaye de les estimer (0.25)

2) Mot suivant : en entrée nous avons un indicateur [CLS] suivi par les caractères

du premier mot suivis par un indicateur [SEP] suivi par les caractères du

deuxième mot. On essaye d'estimer à la sortie équivalente à [CLS] si le mot2 peut

suivre le mot1 dans un texte. (0.25)

c. Comment devons-nous utiliser le modèle entraîné dans cette tâche ? [0.5pt]

Nous l'utilisons comme un encodeur :

La sortie [CLS] est utilisée comme contexte qui va être passé à la première instance du

décodeur LSTM afin de générer le premier caractère (0.25)

Les sorties des caractères du mot sont utilisées avec le mécanisme d'attention (0.25)

4. Par rapport à d'autres méthodes de la même tâche

a. Mentionner un avantage de ce système. [0.25pt]

Niveau caractère donc il peut apprendre les variations morphologiques comme la

conjugaison en se basant sur les propriétés du premier mot

b. Mentionner un inconvénient de ce système. [0.25pt]

Niveau caractère donc il doit avoir plus d'exemples afin d'apprendre

Alger.ESI.2CSSID.TALN.CF page 5/5

Vous aimerez peut-être aussi

- TD Synnex Belgium B.VDocument1 pageTD Synnex Belgium B.VGift MensahPas encore d'évaluation

- Analyse de DonnéesDocument41 pagesAnalyse de Donnéesrose0% (1)

- Grille Dévaluation Commentée DALF C2 PEDocument2 pagesGrille Dévaluation Commentée DALF C2 PEGuy Roland OsylPas encore d'évaluation

- Exercice Données de Panel SynthèseDocument24 pagesExercice Données de Panel SynthèsesmatiPas encore d'évaluation

- Exp 3 Devoir DS2 9Document4 pagesExp 3 Devoir DS2 9alyoutaPas encore d'évaluation

- Conception Et Realisation D Un Prototype PDFDocument126 pagesConception Et Realisation D Un Prototype PDFChouichi Ghada100% (1)

- 2021-2022 Taln CFDocument4 pages2021-2022 Taln CFfatmazohra rezkellahPas encore d'évaluation

- 2021-2022 Taln CiDocument4 pages2021-2022 Taln Cifatmazohra rezkellahPas encore d'évaluation

- 2021-2022 TALN MasterDocument4 pages2021-2022 TALN Masterfatmazohra rezkellahPas encore d'évaluation

- Chapitre3 Partie 01Document8 pagesChapitre3 Partie 01Hou DaPas encore d'évaluation

- Cours IA Polytech 3Document42 pagesCours IA Polytech 3Ahmed BouzoffaraPas encore d'évaluation

- Lisrel PlsDocument6 pagesLisrel PlsAymane Mohammed BenatiaPas encore d'évaluation

- Optimisation Par Algorithme Génétique Sous Contraintes: RechercheDocument23 pagesOptimisation Par Algorithme Génétique Sous Contraintes: RechercheChakib BenamarPas encore d'évaluation

- l2 Ecoif TP MosaicDocument8 pagesl2 Ecoif TP MosaicAMROUNI YasminaPas encore d'évaluation

- 2022-2023 TALN MasterDocument3 pages2022-2023 TALN Masterfatmazohra rezkellahPas encore d'évaluation

- Examen4 Génie Logiciel 2Document7 pagesExamen4 Génie Logiciel 2patinda Pascal KaborePas encore d'évaluation

- SD3 1 AcpDocument36 pagesSD3 1 AcpYassine AssamdiPas encore d'évaluation

- Ag PDFDocument11 pagesAg PDFsabrinaPas encore d'évaluation

- Evaluation Des Modèles de MLDocument32 pagesEvaluation Des Modèles de MLNora HabrichPas encore d'évaluation

- Support CoursDocument42 pagesSupport CoursLeila AmranePas encore d'évaluation

- Resume CoursDocument28 pagesResume Coursbr18Pas encore d'évaluation

- 2022-2023 TALN Master CorrigeDocument3 pages2022-2023 TALN Master Corrigefatmazohra rezkellahPas encore d'évaluation

- EXAM CorrigeDocument2 pagesEXAM CorrigeAbdel MugiwaraPas encore d'évaluation

- Les Algorithmes Génétiques Multiobjectifs: Chapitre IIIDocument20 pagesLes Algorithmes Génétiques Multiobjectifs: Chapitre IIIBoumaaza FaridPas encore d'évaluation

- Bs00resum Texte JavaDocument5 pagesBs00resum Texte JavaTarik El MahtouchiPas encore d'évaluation

- 06 Logistic 2Document27 pages06 Logistic 2Simozer CesarsimozerPas encore d'évaluation

- Ib2021-22 2 Alignement TPDocument10 pagesIb2021-22 2 Alignement TPwilfried AGBETOPas encore d'évaluation

- Chapitre3 Partie1 ASD 2022 2023Document9 pagesChapitre3 Partie1 ASD 2022 2023bouchaar douniaPas encore d'évaluation

- Minha Correcti InfoDocument14 pagesMinha Correcti InfoSolange Nababo brissorPas encore d'évaluation

- 2021-2022 TALN CI CorrigeDocument5 pages2021-2022 TALN CI Corrigefatmazohra rezkellahPas encore d'évaluation

- TP4 MLDocument10 pagesTP4 MLWalid LahsikiPas encore d'évaluation

- Chap 1Document40 pagesChap 1vy69m2rqj2Pas encore d'évaluation

- MetaheuristiquesDocument12 pagesMetaheuristiquesRedouane DrichiPas encore d'évaluation

- Chapitre 6Document24 pagesChapitre 6infcom100% (1)

- Cours Économetrie WWW - Economie Gestion - ComDocument63 pagesCours Économetrie WWW - Economie Gestion - ComRachid Ben El GhaziPas encore d'évaluation

- Cours 6 Contenue Les-Formes-NormalesDocument7 pagesCours 6 Contenue Les-Formes-Normalesradja djouambiPas encore d'évaluation

- MODELISATION BASE DE DONNES 18 - 19 (3 - Modèle Relationnel) 22 - 23Document21 pagesMODELISATION BASE DE DONNES 18 - 19 (3 - Modèle Relationnel) 22 - 23Mohamed TraorePas encore d'évaluation

- Cours Alignement BlastDocument48 pagesCours Alignement BlastlinePas encore d'évaluation

- Arbres de DécisionDocument23 pagesArbres de DécisionSmouni youssefPas encore d'évaluation

- CH3 Modèle RelationnelDocument31 pagesCH3 Modèle RelationnelRebeccaPas encore d'évaluation

- Matrice Multi CritèresDocument57 pagesMatrice Multi CritèresOthmane AouinatouPas encore d'évaluation

- Examen Corrigé 1Document4 pagesExamen Corrigé 1Roufaida TradPas encore d'évaluation

- Metric de Devaluation PerformanceDocument16 pagesMetric de Devaluation PerformancesowPas encore d'évaluation

- Modeles RI 1Document58 pagesModeles RI 1Rihab BEN LAMINEPas encore d'évaluation

- Multi Objective Optimization Using GADocument13 pagesMulti Objective Optimization Using GAIlyas FOxeérPas encore d'évaluation

- Ag PDFDocument34 pagesAg PDFMourad KattassPas encore d'évaluation

- Algorithm 3Document27 pagesAlgorithm 3GEEKGHAZIPas encore d'évaluation

- Adjectif Épithète Ou Attribut - Cours - Exercice Pour Apprendre Le Français - 1599422074738Document2 pagesAdjectif Épithète Ou Attribut - Cours - Exercice Pour Apprendre Le Français - 1599422074738Salif OuedraogoPas encore d'évaluation

- 930 SemantiqueDocument9 pages930 Semantiquedjamila boumahroukPas encore d'évaluation

- Grille Dévaluation Commentée DELF B2 PODocument2 pagesGrille Dévaluation Commentée DELF B2 POAndreeaFlorescuPas encore d'évaluation

- Extrait Du LivreDocument12 pagesExtrait Du LivreAssoum MabroukPas encore d'évaluation

- ADD EmpowerDocument3 pagesADD EmpowerMohamed MoudinePas encore d'évaluation

- 2Sc Seance4Document19 pages2Sc Seance4Bilel BOuchamiaPas encore d'évaluation

- 2 - Le Modèle Relationnel Et La NormalisationDocument12 pages2 - Le Modèle Relationnel Et La Normalisationhammouda.yaser47Pas encore d'évaluation

- 9 Reg - Multiple - Exogenes - Qualitatives PDFDocument12 pages9 Reg - Multiple - Exogenes - Qualitatives PDFezouinePas encore d'évaluation

- Logique Des PR Edicats: Rym Guibadj, Fabien TeytaudDocument66 pagesLogique Des PR Edicats: Rym Guibadj, Fabien Teytaudinformatiquehageryahoo.frPas encore d'évaluation

- Structure de Base de Données - Fiche de Cours - Numérique Et Sciences Informatiques - SchoolMouvDocument16 pagesStructure de Base de Données - Fiche de Cours - Numérique Et Sciences Informatiques - SchoolMouvwilfried AGBETOPas encore d'évaluation

- Introduction Aux Algorithmes GénétiquesDocument23 pagesIntroduction Aux Algorithmes Génétiquescome 10100% (1)

- Informatique Et Techniques Numériques en Economie: Session de Janvier 2007 CorrigéDocument7 pagesInformatique Et Techniques Numériques en Economie: Session de Janvier 2007 CorrigéEkwugha Olisaebuka aristidePas encore d'évaluation

- TD1 Inf221 2023-2024Document5 pagesTD1 Inf221 2023-2024LINKA MARSPas encore d'évaluation

- Les erreurs fréquentes en Mathématiques du cycle secondaire: Enquête statistique - TOME IID'EverandLes erreurs fréquentes en Mathématiques du cycle secondaire: Enquête statistique - TOME IIPas encore d'évaluation

- MemoireDocument11 pagesMemoireedi adjaroPas encore d'évaluation

- Projet Linux-1Document7 pagesProjet Linux-1Lamine DiengPas encore d'évaluation

- Manuel GoPro HERO 6Document53 pagesManuel GoPro HERO 6Arnaud BlanchardPas encore d'évaluation

- Routage 1Document24 pagesRoutage 1Hamid El BouabidiPas encore d'évaluation

- ACTIONS Sage X3Document2 pagesACTIONS Sage X3simon971130Pas encore d'évaluation

- CRG Exe 2Document3 pagesCRG Exe 2FadwaPas encore d'évaluation

- Les Fonctions de L'entreprise Rappel. Les Systemes D'information Et Les PGIDocument10 pagesLes Fonctions de L'entreprise Rappel. Les Systemes D'information Et Les PGIKidrissi Karim,idrissiPas encore d'évaluation

- L3 - API - Chapitre 2 Langage À Contacts 2020Document17 pagesL3 - API - Chapitre 2 Langage À Contacts 2020ayanokojiPas encore d'évaluation

- Ait Boulahcen Hamza RademDocument1 pageAit Boulahcen Hamza RademAIT BOULAHCENPas encore d'évaluation

- Les Outils de La RechercheDocument96 pagesLes Outils de La RechercheSahanePas encore d'évaluation

- Correction Partie2 TP3 (Lien Physique Et Lien Symbolique)Document3 pagesCorrection Partie2 TP3 (Lien Physique Et Lien Symbolique)Rahma Ben YounesPas encore d'évaluation

- Mestiri Mining Fall2015Document48 pagesMestiri Mining Fall2015Bassma KhilaPas encore d'évaluation

- CV ProfDocument1 pageCV Profforever273Pas encore d'évaluation

- DEC - Note Du Jury Du 23 Juin 2016Document16 pagesDEC - Note Du Jury Du 23 Juin 2016Anthony CiliaPas encore d'évaluation

- Article Technologie Et EnseignementDocument2 pagesArticle Technologie Et EnseignementJulia ClaptonPas encore d'évaluation

- OuiiiDocument1 pageOuiiiOussama MonirPas encore d'évaluation

- Toyota Corolla VersoDocument38 pagesToyota Corolla Versokains5467% (3)

- Cours Chap01Document77 pagesCours Chap01Alexis DartoutPas encore d'évaluation

- FR Acs800-01 HW K A4 ScreenDocument176 pagesFR Acs800-01 HW K A4 ScreenBounaji LotfallahPas encore d'évaluation

- Regulation l634cDocument56 pagesRegulation l634cCheval AlainPas encore d'évaluation

- TP9 SambaDocument2 pagesTP9 SambakassimiPas encore d'évaluation

- TP 04 Planification de Réseau 2G-GSM Et DCS 1800Document25 pagesTP 04 Planification de Réseau 2G-GSM Et DCS 1800BOUZANA ElaminePas encore d'évaluation

- Devoir de Contrôle N°1 Exemple 16 2014 2015Document3 pagesDevoir de Contrôle N°1 Exemple 16 2014 2015Anouer MachfarPas encore d'évaluation

- GuideTechnique LCPC SUIVIDIMDocument64 pagesGuideTechnique LCPC SUIVIDIMIroukoura AlexPas encore d'évaluation

- Baromètre Outsourcing 2005 FranceDocument28 pagesBaromètre Outsourcing 2005 FranceZakaria BendjedidPas encore d'évaluation

- SIGMA SD900 - French - Manuel de L'utilisateur PDFDocument90 pagesSIGMA SD900 - French - Manuel de L'utilisateur PDFfakhourimia souPas encore d'évaluation

- Amn 20220915161851.pdfamnDocument2 pagesAmn 20220915161851.pdfamnflorian delebecquePas encore d'évaluation