Académique Documents

Professionnel Documents

Culture Documents

Bigdata

Transféré par

asma.chaabouni345Titre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Bigdata

Transféré par

asma.chaabouni345Droits d'auteur :

Formats disponibles

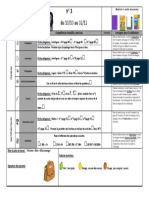

1) Donne la différence entre YARN et MapReduce.

- YARN (Yet Another Resource Negotiator) est un gestionnaire de ressources pour la gestion des

ressources dans un cluster Hadoop, tandis que MapReduce est un modèle de traitement de données

par lots pour le traitement de gros volumes de données. MapReduce s'appuie sur YARN pour la

gestion des ressources.

2) Donne la différence entre YARN et HDFS.

- YARN gère les ressources et l'exécution des applications dans un cluster Hadoop, tandis que HDFS

(Hadoop Distributed File System) est le système de fichiers distribué utilisé pour stocker les données

dans le cluster. Ils ont des rôles distincts dans l'écosystème Hadoop.

3) Est-ce que YARN peut exécuter 2 applications dans le même cluster ?

- Oui, YARN peut exécuter plusieurs applications simultanément dans le même cluster, en gérant les

ressources de manière équilibrée entre elles.

4) Pourquoi YARN utilise la notion de conteneur.

- YARN utilise des conteneurs pour encapsuler les ressources nécessaires à l'exécution d'une

application. Cela permet d'isoler les applications et de garantir une gestion efficace des ressources.

5) Est-ce que YARN contrôle le nombre de nœuds donnés à chaque application ?

- Oui, YARN contrôle la répartition des ressources (CPU, mémoire, etc.) entre les applications en

utilisant des conteneurs. Il veille à ce que chaque application reçoive les ressources allouées

conformément à sa configuration.

6) Donne le critère de RDD.

- RDD (Resilient Distributed Dataset) est une structure de données immuable et distribuée dans

Spark. Un critère essentiel des RDD est leur tolérance aux pannes, ce qui signifie qu'ils peuvent être

reconstruits en cas de défaillance d'un nœud.

7) Donne le schéma DGA.

- Je ne suis pas sûr de ce que vous entendez par "schéma DGA". Pourriez-vous fournir plus de

détails ou préciser votre question ?

8)

Y=['abc', 'ad', 'b'] y.map(e->e.split(' ')

- La syntaxe utilisée pour la fonction `map` semble incorrecte. En Python, vous devriez utiliser

`lambda` pour définir une fonction anonyme. La correction serait la suivante :

Résultat de `map` :

```

[['abc'], ['ad'], ['b']]

```

9)

`` y=[123456789] y.filter(e->e%2==0) ``

a) Donne le résultat de `filter` : Aucun élément ne satisfait la condition, donc la liste résultante sera

vide.

b) Le type de fonction `filter` est une fonction de filtrage ou de prédicat, qui accepte une fonction

lambda (ou une fonction définie par l'utilisateur) et renvoie les éléments de la liste qui satisfont la

condition spécifiée.

10)

a) Le rôle de ce code est de lire un fichier texte ('Shakespeare.txt') à l'aide de Spark, de le diviser en

mots, de compter le nombre d'occurrences de chaque mot, puis de sauvegarder les résultats dans un

fichier texte ('r2').

b) Les RDD utilisés dans ce code sont `rdd1`, `rdd2`, `rdd3`, et `rdd4`.

Vous aimerez peut-être aussi

- Cours1 2 Bigdata 1Document93 pagesCours1 2 Bigdata 1mohamed aziz madhounPas encore d'évaluation

- Résumé Big DataDocument6 pagesRésumé Big DataEl Moumne NihalPas encore d'évaluation

- Big Data: Marie NDIAYEDocument11 pagesBig Data: Marie NDIAYESerigne NdourPas encore d'évaluation

- Hadoop EcosystemDocument37 pagesHadoop Ecosystemhajar.filali4Pas encore d'évaluation

- SparkDocument28 pagesSparkhajar.filali4Pas encore d'évaluation

- CH 1Document53 pagesCH 1ya.latrechePas encore d'évaluation

- Hadoop 1Document61 pagesHadoop 1Mouhamed BouazziPas encore d'évaluation

- Apache SparkDocument16 pagesApache SparkMOHAMED ELRHAOUATPas encore d'évaluation

- Chapitre2 BigDataDocument35 pagesChapitre2 BigDataouma imaPas encore d'évaluation

- Cours SPARK REDUIT V Impression (3450) - 1Document138 pagesCours SPARK REDUIT V Impression (3450) - 1Mohamed ElamriPas encore d'évaluation

- Cours Intro Hadoop v27022014 Erraki HaddadDocument62 pagesCours Intro Hadoop v27022014 Erraki HaddadZohra CHANNOUFPas encore d'évaluation

- Control Big Data N°4-AU22-23Document3 pagesControl Big Data N°4-AU22-23Ferdaous HdioudPas encore d'évaluation

- Big Data: Marie NDIAYEDocument16 pagesBig Data: Marie NDIAYESerigne NdourPas encore d'évaluation

- Chapitre4 Archi Spark 4Document31 pagesChapitre4 Archi Spark 4safia fezai100% (1)

- CH 2 HadoopDocument56 pagesCH 2 HadoopRihane FarahPas encore d'évaluation

- Lab 3Document15 pagesLab 3Maryâm BôuchPas encore d'évaluation

- Cours SparkDocument63 pagesCours SparkZorzoPas encore d'évaluation

- résBigData 2Document11 pagesrésBigData 2Elleuch MariemPas encore d'évaluation

- TD 2Document3 pagesTD 222108Pas encore d'évaluation

- Ch2 (Part 1)Document27 pagesCh2 (Part 1)ya.latrechePas encore d'évaluation

- Chapitre 2 Hadoop-Part1Document26 pagesChapitre 2 Hadoop-Part1souhail nahed100% (1)

- Spark JiDocument37 pagesSpark JiFaten ClubistiaPas encore d'évaluation

- No SQ L Avec CassandraDocument7 pagesNo SQ L Avec CassandrayugaselvanPas encore d'évaluation

- ST Tutor5 R MapreduceDocument6 pagesST Tutor5 R MapreduceDaignon Max Nicolas ATINDOKPOPas encore d'évaluation

- Kien Thuc&Thanh PhanDocument7 pagesKien Thuc&Thanh PhanTú TrầnPas encore d'évaluation

- Application2 - Initiation Spark PDFDocument7 pagesApplication2 - Initiation Spark PDFAdministration IHETPas encore d'évaluation

- Présentation D'HADOOPDocument38 pagesPrésentation D'HADOOPFerdinand OwonaPas encore d'évaluation

- Big DataDocument6 pagesBig Datazaki workerPas encore d'évaluation

- Leçon5 SparkDocument18 pagesLeçon5 SparkMido proPas encore d'évaluation

- Cours Big Data Chap4Document17 pagesCours Big Data Chap4Ben YasserPas encore d'évaluation

- Chapitre 3 LEcosystème Hadoop VFDocument42 pagesChapitre 3 LEcosystème Hadoop VFBrahim Ben Saada100% (1)

- Examen Big DATADocument4 pagesExamen Big DATAzaki workerPas encore d'évaluation

- Chapitre 5 Big DataDocument6 pagesChapitre 5 Big DataSYRINE SDIRIPas encore d'évaluation

- chp2 HadoopmapreduceDocument58 pageschp2 HadoopmapreduceArnauldPas encore d'évaluation

- Tpe Yarn-1Document11 pagesTpe Yarn-1Taka fidèlePas encore d'évaluation

- Exam Final-Big DataDocument3 pagesExam Final-Big DataFerdaous Hdioud100% (3)

- BigChapitre 03 Partie02Document11 pagesBigChapitre 03 Partie02khliaissa46Pas encore d'évaluation

- Chapitre2 Hadoop MapReduceDocument28 pagesChapitre2 Hadoop MapReduceAmen MhamdiPas encore d'évaluation

- Resume Big DataDocument9 pagesResume Big DataKhaoula RAZZAKIPas encore d'évaluation

- Cours 02 Intro HadoopDocument30 pagesCours 02 Intro HadoopMichael Sniper WuPas encore d'évaluation

- ch4 MapreduceDocument16 pagesch4 MapreduceBedoui MehdiPas encore d'évaluation

- Fiche de TD INF 356Document21 pagesFiche de TD INF 356Sali Yaya FaraniPas encore d'évaluation

- Cours 5 Map ReduceDocument10 pagesCours 5 Map Reducejiji31zeboudjiPas encore d'évaluation

- Hadoop (Rihab Chaouch Et Alaa El GhoulDocument17 pagesHadoop (Rihab Chaouch Et Alaa El GhoulChaouch Mohamed Abd SalemPas encore d'évaluation

- Programmation Hadoop WordCountDocument18 pagesProgrammation Hadoop WordCountHammami MélekPas encore d'évaluation

- Examen BDADocument3 pagesExamen BDAMed Nour Elhak JouiniPas encore d'évaluation

- 2 Elfaddouli Bigdata Mapred 2022Document25 pages2 Elfaddouli Bigdata Mapred 2022abdou boulifPas encore d'évaluation

- Spark IntroductionDocument22 pagesSpark IntroductionBadiss JabouPas encore d'évaluation

- (Big Data) CHAP3 - MapReduceDocument29 pages(Big Data) CHAP3 - MapReduceMbarki Med OussemaPas encore d'évaluation

- Gschwend Matthieu 3 Presentation 012023Document18 pagesGschwend Matthieu 3 Presentation 012023Sayoba GansanePas encore d'évaluation

- Programmation HadoopDocument11 pagesProgrammation Hadoopشيبي محمد100% (1)

- Fondements Du Big Data TP1Document3 pagesFondements Du Big Data TP1Hanane NadiPas encore d'évaluation

- Chapitre 2 Final FRDocument94 pagesChapitre 2 Final FRÄya ĶhPas encore d'évaluation

- Partie Hadoop Et EcosystèmeDocument93 pagesPartie Hadoop Et EcosystèmeSafa 'Pas encore d'évaluation

- Big DataDocument3 pagesBig DataLamiae ElguelouiPas encore d'évaluation

- Cour 9Document7 pagesCour 9Ran IaPas encore d'évaluation

- (Big Data Analytics) CHAP2 - Scala SparkDocument42 pages(Big Data Analytics) CHAP2 - Scala SparkMbarki Med OussemaPas encore d'évaluation

- NoSQLziad (1) - 1Document34 pagesNoSQLziad (1) - 1Dimokrati HoussamPas encore d'évaluation

- 1 ELFADDOULI BigData HDFS 2022Document22 pages1 ELFADDOULI BigData HDFS 2022abdou boulifPas encore d'évaluation

- BUDAI Erika - Les SirenesDocument9 pagesBUDAI Erika - Les SirenesHélène RichardeauPas encore d'évaluation

- Grille Bfem TroisiemeDocument5 pagesGrille Bfem Troisiemepapeefi93Pas encore d'évaluation

- 08 Cours Travail Force Energie Mecanique MelissoDocument5 pages08 Cours Travail Force Energie Mecanique MelissoAZIAKOUPas encore d'évaluation

- Dossier Complet Belles Plantes Scolaires Textes Fiches PedagogiquesDocument59 pagesDossier Complet Belles Plantes Scolaires Textes Fiches Pedagogiquesjosdiakiese950Pas encore d'évaluation

- Cordiérite-Mullite 1 PDFDocument10 pagesCordiérite-Mullite 1 PDFkhalidPas encore d'évaluation

- Architecture J2 EEDocument27 pagesArchitecture J2 EEFaiçal YahiaPas encore d'évaluation

- DS1 4si2 2015-2016Document2 pagesDS1 4si2 2015-2016PROF PROFPas encore d'évaluation

- Plan de Travail 3Document1 pagePlan de Travail 3Fabienne GillardPas encore d'évaluation

- Integrer Un PDF Dans Un Site PDFDocument3 pagesIntegrer Un PDF Dans Un Site PDFlydiaberthomieuPas encore d'évaluation

- L'impact Du Choix Des FournisseursDocument9 pagesL'impact Du Choix Des FournisseursMamadou SYPas encore d'évaluation

- Le TANTRA Et Le Massage Tantrique.Document15 pagesLe TANTRA Et Le Massage Tantrique.Alexandra GalvezPas encore d'évaluation

- Les Lettres AdministrativesDocument7 pagesLes Lettres AdministrativesAyman LamzouriPas encore d'évaluation

- 37 Denombrements CorrigeDocument10 pages37 Denombrements CorrigeYassine BenabdellahPas encore d'évaluation

- Le Risque D'inondationDocument13 pagesLe Risque D'inondationcasaouis02Pas encore d'évaluation

- Examen Eoae 2 Bac Eco 2012 Session Rattrapage CorrigeDocument4 pagesExamen Eoae 2 Bac Eco 2012 Session Rattrapage CorrigeAhmed Hassan SkifaPas encore d'évaluation

- 11 Technique D'expression3Document17 pages11 Technique D'expression3Imene BrbPas encore d'évaluation

- 20 Pages Part 3 - Trajectoire Decarbonation Du MarocDocument20 pages20 Pages Part 3 - Trajectoire Decarbonation Du MarocIsmail LamriniPas encore d'évaluation

- Passerelle Primaire Admis 2023-2024Document6 pagesPasserelle Primaire Admis 2023-2024Chaymah ChoubouPas encore d'évaluation

- Compte-Rendu Diagnostic Et ExpertiseDocument23 pagesCompte-Rendu Diagnostic Et ExpertiseM'hamdi EzdiharPas encore d'évaluation

- E Vocabulaire GeometriqueDocument23 pagesE Vocabulaire Geometriqueadel kaisPas encore d'évaluation

- 10 29000-Rumelide 817008-1366091Document19 pages10 29000-Rumelide 817008-1366091gnouna12Pas encore d'évaluation

- Dossier Technique RéviséDocument10 pagesDossier Technique RéviséJalal Ke100% (2)

- COUR DE COMPTES TOGO AUDIT Thème 1Document42 pagesCOUR DE COMPTES TOGO AUDIT Thème 1Pascal SindiePas encore d'évaluation

- Ces Aliments Que L'on Peut Consommer Après La Date de Péremption - Santé MagazineDocument3 pagesCes Aliments Que L'on Peut Consommer Après La Date de Péremption - Santé MagazinekiamgoPas encore d'évaluation

- Art-Pie 1er Régiment d'Artillerie-à-Pied (Dunkerque, Calais, Boulogne)Document22 pagesArt-Pie 1er Régiment d'Artillerie-à-Pied (Dunkerque, Calais, Boulogne)DUCHAUSSOYPas encore d'évaluation

- 2008 Position de L'exiléDocument25 pages2008 Position de L'exilé1234Pas encore d'évaluation

- MONS Rue de Nimy (TEC) MONS Grands Prés (TEC) : Votre Trajet en Quelques ChiffresDocument1 pageMONS Rue de Nimy (TEC) MONS Grands Prés (TEC) : Votre Trajet en Quelques ChiffresPernelle DPas encore d'évaluation

- Dwnload Full Analog Circuit Design Discrete and Integrated 1st Edition Franco Solutions Manual PDFDocument36 pagesDwnload Full Analog Circuit Design Discrete and Integrated 1st Edition Franco Solutions Manual PDFlincolnrod80100% (16)

- Le Management de La Force de Vente Support 2Document73 pagesLe Management de La Force de Vente Support 2Soufiane Cherif100% (1)

- Du de La Des de de L ExercisesDocument2 pagesDu de La Des de de L Exercisesapi-262811896Pas encore d'évaluation

- Revue des incompris revue d'histoire des oubliettes: Le Réveil de l'Horloge de Célestin Louis Maxime Dubuisson aliéniste et poèteD'EverandRevue des incompris revue d'histoire des oubliettes: Le Réveil de l'Horloge de Célestin Louis Maxime Dubuisson aliéniste et poèteÉvaluation : 3 sur 5 étoiles3/5 (3)

- Guide Pour Les Débutants En Matière De Piratage Informatique: Comment Pirater Un Réseau Sans Fil, Sécurité De Base Et Test De Pénétration, Kali LinuxD'EverandGuide Pour Les Débutants En Matière De Piratage Informatique: Comment Pirater Un Réseau Sans Fil, Sécurité De Base Et Test De Pénétration, Kali LinuxÉvaluation : 1 sur 5 étoiles1/5 (1)

- Dark Python : Apprenez à créer vos outils de hacking.D'EverandDark Python : Apprenez à créer vos outils de hacking.Évaluation : 3 sur 5 étoiles3/5 (1)

- Apprendre Python rapidement: Le guide du débutant pour apprendre tout ce que vous devez savoir sur Python, même si vous êtes nouveau dans la programmationD'EverandApprendre Python rapidement: Le guide du débutant pour apprendre tout ce que vous devez savoir sur Python, même si vous êtes nouveau dans la programmationPas encore d'évaluation

- Le guide du hacker : le guide simplifié du débutant pour apprendre les bases du hacking avec Kali LinuxD'EverandLe guide du hacker : le guide simplifié du débutant pour apprendre les bases du hacking avec Kali LinuxÉvaluation : 5 sur 5 étoiles5/5 (2)

- Technologie automobile: Les Grands Articles d'UniversalisD'EverandTechnologie automobile: Les Grands Articles d'UniversalisPas encore d'évaluation

- Secrets du Marketing des Médias Sociaux 2021: Conseils et Stratégies Extrêmement Efficaces votre Facebook (Stimulez votre Engagement et Gagnez des Clients Fidèles)D'EverandSecrets du Marketing des Médias Sociaux 2021: Conseils et Stratégies Extrêmement Efficaces votre Facebook (Stimulez votre Engagement et Gagnez des Clients Fidèles)Évaluation : 4 sur 5 étoiles4/5 (2)

- Wi-Fi Hacking avec kali linux Guide étape par étape : apprenez à pénétrer les réseaux Wifi et les meilleures stratégies pour les sécuriserD'EverandWi-Fi Hacking avec kali linux Guide étape par étape : apprenez à pénétrer les réseaux Wifi et les meilleures stratégies pour les sécuriserPas encore d'évaluation

- Le trading en ligne facile à apprendre: Comment devenir un trader en ligne et apprendre à investir avec succèsD'EverandLe trading en ligne facile à apprendre: Comment devenir un trader en ligne et apprendre à investir avec succèsÉvaluation : 3.5 sur 5 étoiles3.5/5 (19)

- Python Offensif : Le guide du débutant pour apprendre les bases du langage Python et créer des outils de hacking.D'EverandPython Offensif : Le guide du débutant pour apprendre les bases du langage Python et créer des outils de hacking.Pas encore d'évaluation

- Python | Programmer pas à pas: Le guide du débutant pour une initiation simple & rapide à la programmationD'EverandPython | Programmer pas à pas: Le guide du débutant pour une initiation simple & rapide à la programmationPas encore d'évaluation

- Le Guide Rapide Du Cloud Computing Et De La CybersécuritéD'EverandLe Guide Rapide Du Cloud Computing Et De La CybersécuritéPas encore d'évaluation

- Wireshark pour les débutants : Le guide ultime du débutant pour apprendre les bases de l’analyse réseau avec Wireshark.D'EverandWireshark pour les débutants : Le guide ultime du débutant pour apprendre les bases de l’analyse réseau avec Wireshark.Pas encore d'évaluation

- L'analyse technique facile à apprendre: Comment construire et interpréter des graphiques d'analyse technique pour améliorer votre activité de trading en ligne.D'EverandL'analyse technique facile à apprendre: Comment construire et interpréter des graphiques d'analyse technique pour améliorer votre activité de trading en ligne.Évaluation : 3.5 sur 5 étoiles3.5/5 (6)

- Stratégie d'Investissement en Crypto-monnaie: Comment Devenir Riche Avec les Crypto-monnaiesD'EverandStratégie d'Investissement en Crypto-monnaie: Comment Devenir Riche Avec les Crypto-monnaiesÉvaluation : 3.5 sur 5 étoiles3.5/5 (11)

- Le money management facile à apprendre: Comment tirer profit des techniques et stratégies de gestion de l'argent pour améliorer l'activité de trading en ligneD'EverandLe money management facile à apprendre: Comment tirer profit des techniques et stratégies de gestion de l'argent pour améliorer l'activité de trading en ligneÉvaluation : 3 sur 5 étoiles3/5 (3)

- Conception & Modélisation CAO: Le guide ultime du débutantD'EverandConception & Modélisation CAO: Le guide ultime du débutantPas encore d'évaluation

- L'analyse fondamentale facile à apprendre: Le guide d'introduction aux techniques et stratégies d'analyse fondamentale pour anticiper les événements qui font bouger les marchésD'EverandL'analyse fondamentale facile à apprendre: Le guide d'introduction aux techniques et stratégies d'analyse fondamentale pour anticiper les événements qui font bouger les marchésÉvaluation : 3.5 sur 5 étoiles3.5/5 (4)

- Comment analyser les gens : Introduction à l’analyse du langage corporel et les types de personnalité.D'EverandComment analyser les gens : Introduction à l’analyse du langage corporel et les types de personnalité.Pas encore d'évaluation

- Dans l'esprit des grand investisseurs: Un voyage à la découverte de la psychologie utilisée par les plus grands investisseurs de tous les temps à travers des analyses opérationnellD'EverandDans l'esprit des grand investisseurs: Un voyage à la découverte de la psychologie utilisée par les plus grands investisseurs de tous les temps à travers des analyses opérationnellÉvaluation : 4.5 sur 5 étoiles4.5/5 (3)

- Le trading des bandes de bollinger facile à apprendre: Comment apprendre à utiliser les bandes de bollinger pour faire du commerce en ligne avec succèsD'EverandLe trading des bandes de bollinger facile à apprendre: Comment apprendre à utiliser les bandes de bollinger pour faire du commerce en ligne avec succèsÉvaluation : 5 sur 5 étoiles5/5 (1)

- NFT et Cryptoart: Le guide complet pour investir, créer et vendre avec succès des jetons non fongibles sur le marché de l'art numériqueD'EverandNFT et Cryptoart: Le guide complet pour investir, créer et vendre avec succès des jetons non fongibles sur le marché de l'art numériqueÉvaluation : 5 sur 5 étoiles5/5 (5)

- Le marketing d'affiliation en 4 étapes: Comment gagner de l'argent avec des affiliés en créant des systèmes commerciaux qui fonctionnentD'EverandLe marketing d'affiliation en 4 étapes: Comment gagner de l'argent avec des affiliés en créant des systèmes commerciaux qui fonctionnentPas encore d'évaluation