Académique Documents

Professionnel Documents

Culture Documents

Rapport Final

Transféré par

Yosra HouliCopyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Rapport Final

Transféré par

Yosra HouliDroits d'auteur :

Formats disponibles

CONSERVATOIRE NATIONAL DES ARTS ET METIERS CENTRE REGIONAL RHNE-ALPES CENTRE DENSEIGNEMENT DE GRENOBLE

UE ENG111 - Epreuve TEST Travail dEtude et de Synthse Technique en INFORMATIQUE

Les machines vecteurs support pour la classication en imagerie hyperspectrale : implmentation et mise en uvre.

Prsent par Ludovic Mercier le 11 fvrier 2010, Grenoble devant le jury : Prsident : M. Eric Gressier-Soudan Examinateurs : M. Jean-Pierre Giraudin Mme Vronique Panne M. Andr Plisson M. Eric Sellin M. Mathias Voisin-Fradin Tuteur : M. Mathieu Fauvel

Avant propos

Conventions typographiques

An de faciliter la lecture, le symbole accol un mot spcie une entre dans le glossaire situ la n de ce document.

Remerciements

Je remercie Mathieu Fauvel de lINRIA et Jocelyn Chanussot du Gipsa-lab pour avoir rpondu favorablement ma demande pour le suivi de cette preuve. Je souhaite remercier galement toute lquipe du Laboratoire de Plantologie avec laquelle je travaille et tout particulirement Sylvain Dout au sein du projet Vahin. Merci galement Frdric Schmidt pour les documents extraits de sa thse. Par ailleur un merci tout particulier Benot pour son amiti et le temps quil ma accorder pour la relecture de ce document. Enn je remercie du fond du cur ma petite Karen qui me soutient et mencourage depuis le jour de ma permire inscription au CNAM.

Sommaire

Table des gures Introduction Imagerie hyperspectrale . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Machine vecteurs support comme mthode de classication . . . . . . . . . . . . . . . 1 Apprentissage, classication et SVM 1.1 Notion dapprentissage . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1.2 Notion de classication . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1.3 Machines vecteurs support . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Fonctionnement des machines vecteurs support 2.1 Principe . . . . . . . . . . . . . . . . . . . . 2.2 Forme primale . . . . . . . . . . . . . . . . . 2.3 Forme duale . . . . . . . . . . . . . . . . . . 2.4 Astuce du noyau . . . . . . . . . . . . . . . 2.5 Marges souples . . . . . . . . . . . . . . . . 2.6 Bilan . . . . . . . . . . . . . . . . . . . . . . 2.7 Deux approches doptimisation . . . . . . . .

v 1 1 2 3 3 3 4

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

7 . 7 . 8 . 8 . 9 . 10 . 11 . 12 13 13 14 14 15 15 16 17 19 19 19 20 20 20 21 21 21

Slection des paramtres du modle 3.1 Mesure derreur en apprentissage . . . . . . . . . . . 3.2 Validation croise . . . . . . . . . . . . . . . . . . . 3.3 Grille de recherche . . . . . . . . . . . . . . . . . . 3.4 Approche biomimtique . . . . . . . . . . . . . . . 3.4.1 Algorithmes gntiques . . . . . . . . . . . 3.4.2 Optimisation des machines vecteurs support 3.4.3 Bilan . . . . . . . . . . . . . . . . . . . . . Mise en uvre 4.1 Projet Vahin . . . . . . . . 4.2 Bibliothque LIBSVM . . . 4.3 Volume et taille des donnes 4.4 Classication multi-classes . 4.4.1 Un contre tous . . . 4.4.2 Un contre un . . . . 4.4.3 Paralllisation . . . . 4.5 Choix des hyperparamtres .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

iii

4.5.1 4.5.2 Conclusion Glossaire Index Bibliographie

Fonction dvaluation SV . . . . . . . . . . . . . . . . . . . . . . . . . . 21 Multi-classes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22 23 25 26 27

Table des gures

1 1.1 1.2 1.3 1.4 2.1 2.2 2.3

Dcomposition dune image hyperspectrale. . . . . . . . . . . . . . . . . . . . . . Classication de spectres pour dterminer des types de surface : glace, H2 O, roche, CO2 par exemple. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Schma dun mlange granulaire auquel sera associ un mlange spectral. . . . . Exemples de spectres du givre sur la calotte polaire martienne diffrentes longitudes subsolaires (Ls ) [Appr, 2010]. . . . . . . . . . . . . . . . . . . . . . . . Exemple de classication binaire linaire et non-linaire dans R2 . . . . . . . . . . . . .

2 3 4 5 5

Hyperplan de sparation optimal avec marge souple dans un cas non linairement sparable. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8 La transformation linaire des donnes permet une sparation linaire dans un nouvel espace. Adapt de [Cornujols et al., 2002]. . . . . . . . . . . . . . . . . . . . 10 Exemple de classication binaire avec diffrents noyaux. Le choix du noyau inuence la rsolution. Source : AT&T Research Lab , laboratoire de recherche AT&T http://svm.dcs.rhbnc.ac.uk/. . . . . . . . . . . . . . . . . . . . 11 Exemple de grille de recherche des paramtres (,C) dun modle. La lgende reprsente la prcision obtenue (en pourcentage) sur un chantillon de test. . . . . . 14 Principe des oprateurs gntiques dans le cas dindividu cod sur 7 bits. . . . . . . 15 Codage de linformation dun chromosome pour une optimisation dun sparateur vaste marge. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16 Architecture parallle de classieur SVM binaire. . . . . . . . . . . . . . . . . . . 20

3.1 3.2 3.3 4.1

Introduction

Lobjectif de ce rapport est de prsenter les machines vecteurs support (SVM1 ) et les diffrentes approches doptimisation qui leur sont associes. Dans un premier chapitre, nous rappellons la notion dapprentissage et de classication et nous prsentons les SVM. Dans un second chapitre, nous dcrivons le fonctionnement des SVM et certaines approches doptimisation. Le troisime chapitre traitera des mthodes pour slectionner les paramtres optimaux. Enn, dans le dernier chapitre nous discuterons de leurs mises en uvre dans le cadre de limagerie hyperspectrale.

Imagerie hyperspectrale

Limagerie hyperspectrale est une technique permettant la reprsentation dune mme scne suivant de nombreuses bandes spectrales troites dans des gammes de longueurs dondes varies (visible, infrarouge, etc.). Cest une technologie en plein dveloppement qui permet daccder de nombreuses informations sur les proprits physiques des objets observs comparativement limagerie couleur classique. Limagerie hyperspectrale est utilise dans de multiples domaines comme la gologie, lcologie, lurbanisme, la foresterie, lagriculture, dans le domaine militaire ou encore en plantologie. Les donnes issues de la tldtection hyperspectrale sont agences en cube. Un cube est constitu de deux dimensions spatiales w et h et dune dimension spectrale . Le nombre de pixels dans la direction w, respectivement h, est not Nw , respectivement Nh . Le nombre de bandes spectrales ou spectels dans la direction est not N . Un exemple dimage hyperspectrale et le principe de sa composition sont prsents la gure 1. On notera quil existe une imagerie dite multi-spectrale qui se contente dune dizaine de canaux alors que limagerie hyperspectrale dpasse la centaine de canaux (N > 100). Les images hyperspectrales sont acquises par des spectro-imageurs associs des microscopes, des satellites (tudes de la surface terrestre) ou encore des sondes spatiales (tudes plantologiques de mars). Dans le domaine multi-spectral on trouvera par exemple, les satellites PLEIADES (CNES2 ) qui permettront lacquisition dimages multi-spectrales de 70 cm 250 cm de rsolution spatiale [CNES, 2009]. Chaque image aura un volume compris entre 1,8 et 3,6 Go pour seulement 5 canaux spectraux. Ce type dinstrument est dvelopp pour avoir un bon rendu spatial. Par comparaison dans le domaine hyperspectral nous avons comme exemple les images fournies par le spectro-imageur OMEGA3 (ESA4 ) [ESA, 2009]. Chaque image de rsolution spatiale comprise entre 350 m 4000 m. Leur taille varie de 50 100 Mo pour environ 100000 spectres

1 Support 2 Centre

Vector Machine , machine vecteurs support. National dEtude Spatiale. 3 Observatoire pour la Minralogie, lEau, les Glaces et lActivit. 4 European Space Agency , lagence spaciale europenne.

INTRODUCTION

F IG . 1 Dcomposition dune image hyperspectrale. composs eux mme de 184 spectels. Ces exemples montrent que la taille et la complexit des donnes gnres font apparatre de nouveaux ds mthodologiques pour lanalyse la fois mathmatique et informatique. Un des problmes rsoudre est dautomatiser lextraction dinformations pertinentes de ces images : dtection de zone dintrt, quantication des matriaux etc. De rcents travaux cits notamment dans [Bazi et Melgani, 2006] montrent que les mthodes de machine vecteurs support surpassent les mthodes statistiques classiques dans les problmatiques de classication en imagerie hyperspectrale. Elles se distinguent par une meilleure prcision de reconnaissance et une facult de gnralisation qui permet dobtenir une bonne classication des nouveaux exemples.

Machine vecteurs support comme mthode de classication

Les machines vecteurs support ou SVM, constituent une mthode de classication supervise particulirement bien adapte pour traiter des donnes de grande dimension. Par rapport aux techniques classiques dapprentissage, les SVM ne dpendent pas de la dimension de lespace de reprsentation des donnes. Grce lusage dune fonction noyau, elles permettent une classication non linaire comme nous le verrons au paragraphe 2.4 . L inconvnient des SVM est le choix empirique de la fonction noyau adapte au problme. Un deuxime inconvnient est le temps de calcul qui crot de faon cubique en fonction du nombre de donnes traiter. La complexit dun algorithme SVM est cubique par rapport au nombre de donnes et linaire par rapport au nombre de variables. Si le nombre de donnes dapprentissage est n la dimension des donnes classer est d, la complexit est alors en O(dn3 ) [Bousquet, 2001].

Chapitre

Apprentissage, classication et SVM

1.1 Notion dapprentissage

Lapprentissage cest lacquisition de connaissances et comptences permettant la synthse dinformation [Bisson, 2009]. Un algorithme dapprentissage va permettre de passer dun espace des exemples X un espace dit des hypothses H. Lalgorithme SVM va explorer lespace H pour obtenir le meilleur hyperplan sparateur (voir le paragraphe 1.3). Lapprentissage permet, partir dun ensemble de paramtres en entre, dobtenir un ensemble de rsultats en sortie. On va donc prparer un jeu de donnes apprendre constitu de couples paramtre/rsultat. Le but recherch est dapprendre une fonction permettant de prdire de nouveaux rsultats pour de nouvelles entres. Lapprentissage est dit supervis ou non supervis. Les SVM se situent dans le groupe des algorithmes dapprentissage superviss puisque que lon utilise une base dexemples pour obtenir la rgle de classication.

1.2

Notion de classication

La classication est une opration de structuration qui vise organiser un ensemble dobservation en groupes homognes et contrasts an de faciliter lanalyse des informations et deffectuer des prdictions [Bisson, 2009]. En imagerie hyperspectrale une classe est un ensemble de spectres ayant des caractristiques similaires ou communes. Sur la gure 1.1 nous prsentons une classication image de diffrents spectres. Dans le cadre de la tldtection des surfaces plantaires, les caractristiques communes sont :

Type de surface A Classification Type de surface B

F IG . 1.1 Classication de spectres pour dterminer des types de surface : glace, H2 O, roche, CO2 par exemple. 3

CHAPITRE 1. APPRENTISSAGE, CLASSIFICATION ET SVM

F IG . 1.2 Schma dun mlange granulaire auquel sera associ un mlange spectral. la prsence dun mme corps chimique, la mme reprsentation de surface, les mmes paramtres physiques au sein de la reprsentation de surface (granulomtrie, abondances, ...). La dnition dune classe se fait soit par lensemble des spectres considrs comme similaires, soit par un spectre de rfrence . Il est aussi ncessaire de dnir une notion de similitude. On notera que la similitude en apprentissage se base essentiellement sur la notion de distance [Bisson, 2009]. On utilisera alors la distance de Minkowski1 D p (Xi, X j ) = k Wk xik x jk p avec p > 0. Avec les dnitions prcdentes, la classication cherche minimiser la distance intraclasses (classe homogne) et par contre maximiser la distance inter-classes (classes contrastes). Concernant la classication dimages de surface, on peut travailler soit avec des spectres typiques de compos chimique pur, soit avec des spectres de mlange (ils seront appels spectres synthtiques). En effet un pixel correspond une surface de terrain htrogne comme le montre la gure 1.2. La surface du pixel varie de plusieurs dizaines de centimtre carr plusieurs centaines de mtre carr suivant la rsolution du spectro-imageur. La gure 1.3 montre des exemples de spectre de la surface de mars mesurs par le spectro imageur OMEGA. La complexit des surfaces plantaires va impliquer de nombreuses combinaisons de spectres synthtiques. Cette situation physique conduit des bases dapprentissage qui peuvent contenir plusieurs millions dindividus. Cet tat de fait va impacter le temps dapprentissage de part la complexit cubique de lalgorithme.

p

1

1.3

Machines vecteurs support

Les machines vecteurs support on t introduites en 1995 par Cortes et Vapnik [Cortes et Vapnik, 1995, Bottou et Chih-Jen, 2007]. Elles sont utilises dans de nombreux problmes dapprentissage : reconnaissance de forme, catgorisation de texte ou encore diagnostic mdical. Les SVM reposent sur deux notions : celle de marge maximale et celle de fonction noyau. Elles permettent de rsoudre des problmes de discrimination non linaire. Nous allons voir comment un problme de classication se ramne rsoudre un problme doptimisation quadratique. La marge est la distance entre la frontire de sparation et les chantillons les plus proches appels vecteurs support. Dans un problme linairement sparable les SVM trouvent une sparatrice qui maximise cette marge. Dans le cas dun problme non linaire on utilise une fonction noyau pour projeter les donnes dans un espace de plus grande dimension o elles seront linairement sparables (gure 1.4).

1 On

retrouve la distance euclidienne avec p = 2 et la pondration Wk = 1.

1.3. MACHINES VECTEURS SUPPORT

F IG . 1.3 Exemples de spectres du givre sur la calotte polaire martienne diffrentes longitudes subsolaires (Ls ) [Appr, 2010].

(a) Problme linaire avec diffrentes sparatrices.

(b) Problme non linaire.

F IG . 1.4 Exemple de classication binaire linaire et non-linaire dans R2 .

CHAPITRE 1. APPRENTISSAGE, CLASSIFICATION ET SVM

Chapitre

Fonctionnement des machines vecteurs support

2.1 Principe

Les machines vecteurs support forment une classe dalgorithmes dapprentissage superviss. Nous nous intressons une fonction note f qui a toute entre x fait correspondre une sortie y = f (x). Le but est dessayer dapprendre f partir dun ensemble de couple (xi , yi ). Dans ce problme les machines vecteurs support vont tre utilises pour classier une nouvelle observation x en se limitant deux classes y 1, 1. Nous allons donc construire une fonction f qui chaque valeur dentre dans un ensemble Rd va faire correspondre une valeur de sortie y {1, 1} :

f : Rd {1, 1}, f (x) = y. Dans le cas linaire, une fonction discriminante h est obtenu par combinaison linaire dun vecteur dentre x = (x1 , ..., xd ) et scrit : h(x) = w x + b. (2.1)

La classe est donne par le signe de h(x) : f (x) = sign(h(x)). Si h(x) 0 alors x est de classe 1 sinon x est de classe 1. La sparatrice est alors un hyperplan afne dquation : w x + b = 0. Si (xi , yi ) est un des p elements de la base dapprentissage not A p , on veut trouver le classieur h tel que : yi (w xi + b) 0, i [1, p]. (2.2) Dans le cas simple linairement sparable il existe de nombreux hyperplans sparateurs comme nous pouvons le voir sur la gure 1.4. Selon la thorie de Vapnick [Cortes et Vapnik, 1995, Vapnik, 1995] lhyperplan optimal (optimum de la distance inter-classe) est celui qui maximise la marge. Cette dernire tant dnie comme la distance entre un hyperplan et les points chantillons les plus proches. Ces points particuliers sont appels vecteurs support. La distance entre un point x quelconque et lhyperplan est donne par lquation 2.3. d(x) = |w x + b| . w (2.3)

Nous allons voir au paragraphe suivant que maximiser la marge va revenir minimiser w . 7

CHAPITRE 2. FONCTIONNEMENT DES MACHINES VECTEURS SUPPORT

F IG . 2.1 Hyperplan de sparation optimal avec marge souple dans un cas non linairement sparable.

2.2

Forme primale

Les paramtres w et b tant dnis un coefcient multiplicatif prs, on choisit de les normaliser pour que les chantillons les plus proches (xs ) vrient lgalit suivante : ys (w xs + b) = 1 donc quelque soit lchantillon xi on obtient : yi (w xi + b) 1. La distance entre lhyperplan et un point support est donc dnie par

2 w 1 w

(2.4) . La marge gom-

trique entre deux classes est gale . La forme primale (qui dpend seulement de w et b) des SVM est donc un problme de minimisation sous contrainte qui scrit :

1 min ( 2 w 2 ) (xi , yi ) A p , yi (w xi + b) 1.

(2.5)

2.3

Forme duale

La formulation primale peut tre transforme en formulation duale en utilisant les multiplicateurs de Lagrange. Lquation 2.5 scrit alors sous la forme suivante : 1 w L(w, b, ) = 2

p 2

i (yi (w xi + b) 1).

i=1

(2.6)

La formulation de Lagrange permet de trouver les extremums en annulant les drives partielles de la fonction L(w, b, ). Le lagrangien L doit tre minimis par rapport w et b et maximis par rapport . On rsout ce nouveau problme en calculant les drives partielles : 8

2.4. ASTUCE DU NOYAU

p L = w i yi xi = 0 w i=1 p L = i yi = 0. b i=1

(2.7)

(2.8)

En rinjectant les deux premires drives partielles 2.7 et 2.8 dans lquation 2.6 nous obtenons : L() =

p p p p p 1 p i yi j y j xi x j i yi j y j xi x j i yi b + i 2 i=1 j=1 i=1 j=1 i=1 i=1

on en extrait la formulation duale (dpendant des i ) suivante :

p

L() = i

i=1

1 i j yi y j xi x j . 2 i, j

(2.9)

On cherche donc maximiser L() sous les contraintes i 0 et i i yi = 0. A loptimal, , les conditions de Karush Kuhn Tucker (conditions KTT) sont satisfaites et permettent dcrire lgalit suivante : i [yi (w xi + b) 1] = 0, i [1, p]. (2.10)

Cela nous donne i = 0 ou (w xi + b) 1 = 0. Ces deux possibilits impliquent que seuls les i associs des exemples situs sur la marge peuvent tre non nuls. Autrement dit, ces exemples sur la marge constituent les vecteurs support, qui seuls contribuent dnir lhyperplan optimal. Cette maximisation est un problme de programmation quadratique de dimension gale au nombre dexemple. Lquation 2.7 nous donne la valeur optimale pour w not w : w = p i=1 i yi xi , avec i les coefcients de Lagrange optimaux. En utilisant lquation de lhyperplan 2.1 nous obtenons lhyperplan de marge maximale :

p

h(x) =

i=1

iyix xi + b.

(2.11)

2.4

Astuce du noyau

Le cas linairement sparable est peu intressant, car les problmes de classication sont souvent non linaires. Pour rsoudre ce point la mthode classique est de projeter les donnes dans un espace de dimension suprieur appel espace de redescription. Lide tant quen augmentant la dimensionnalit du problme on se retrouve dans le cas linaire vu prcdemment. Nous allons donc appliquer une transformation non linaire () aux vecteurs dentre xi tel que xi R et (xi ) R, (e > d). Ce changement va conduire passer dun produit scalaire dans lespace dorigine xi x j un produit scalaire (xi ) (x j ) dans lespace de redescription (voir la gure 2.2). Lastuce est dutiliser une fonction noyau note K qui vite le calcul explicite du produit scalaire dans lespace de redescription. Les fonctions noyaux doivent satisfaire le thorme de Mercer . Nous avons alors lgalit suivante : K(xi , x j ) = (xi ) (x j ). (2.12)

Il existe de nombreuses fonctions noyau prdinies, les deux les plus usites sont le noyau gaussien (quation 2.13) et le noyau polynomial (quation 2.14) : 9

CHAPITRE 2. FONCTIONNEMENT DES MACHINES VECTEURS SUPPORT

Espace de redescription F

Espace des exemples X

Espace de sortie

Redescription non linaire

Sparation linaire

F IG . 2.2 La transformation linaire des donnes permet une sparation linaire dans un nouvel espace. Adapt de [Cornujols et al., 2002].

K (xi , x j ) = e

xi x j

(2.13)

K,d,r (xi , x j ) = (xi x j + r)d .

(2.14)

Les noyaux gaussien sont des noyaux dits de type radial (fonction base radial abrg RBF [Bottou et Chih-Jen, 2007]), indiquant quils dpendent de la distance entre deux exemples. Lhyperplan sparateur se rcrit avec la fonction noyau sous la forme suivante :

p

h(x) = i yi K (x, xi ) + b.

i=1

2.5

Marges souples

Les machines vecteurs support sont efcaces quand le problme est sparable. Nous avons vu dans le paragraphe prcdent 2.4 que lutilisation dune mthode noyau permettait de traiter les cas non linaires mais cela nest pas utilisable dans le cas de donnes non sparables par exemple pour des donnes bruites. En effet, on peut avoir des lments classer du mauvais cot de lhyperplan comme le montre la gure 2.1. Cortes et Vapnik en 1995 ont donc introduit le concept de marge souple [Cortes et Vapnik, 1995]. Certains exemples dapprentissage peuvent violer la contrainte 2.4 que lon retouve dans lquation de la forme primale 2.5. On introduit par consquent des variables dites ressorts = (1 , ..., p ) qui permettent dassouplir la contrainte pour chaque exemple. Un paramtre supplmentaire de rgularisation C est ajout pour contrler la pnalit associe aux exemples. La nouvelle forme primale dcrite en 2.5 devient alors :

p 1 min ( 2 w 2 +C i=1 i ) (xi , yi ) A p , yi (w xi + b) 1 i .

(2.15)

De mme que pour la forme primale nous obtenons une nouvelle formulation duale qui est alors similaire celle dcrite dans la partie 2.3. Si on utilise en plus la fonction noyau K dans la formulation duale 2.9 en appliquant la mthode des multiplicateurs de Lagrange on cherche alors maximiser la nouvelle fonction L(). 10

2.6. BILAN

(a) noyau polynomial de degr 5

(b) noyau gaussien

F IG . 2.3 Exemple de classication binaire avec diffrents noyaux. Le choix du noyau inuence la rsolution. Source : AT&T Research Lab , laboratoire de recherche AT&T http://svm. dcs.rhbnc.ac.uk/.

p p 1 L(w, b, , ) = w2 +C i i [yi (w xi + b) 1 + i ]. 2 i=1 i=1

En appliquant la mme mthode qu au paragraphe 2.3 on obtient L() partir de lexpression du Lagrangien prcdent. 1 p L() = i i j yi y j K(xi , x j ) 2 i, j=1 i=1

p

(2.16)

(xi , yi ) A p , 0 i C et yi i = 0.

i

Le seul changement est la contrainte supplmentaire sur les coefcients i , qui se traduit par une borne suprieure C. La solution de lquation prcdente 2.16 est de la forme :

p

h(x) = i yi K(x, xi ) + b.

i=1

(2.17)

2.6

Bilan

Le calcul des i du Lagrangien vu prcdemment est obtenu par programmation quadratique. Cest un problme bien connu pour lequel il existe de nombreux algorithmes doptimisation. Ce type de problme a un optimum global unique, lment important car nous sommes srs de ne pas atteindre un optimum local. Il sensuit un seul qui maximise lquation 2.16. Une fois que lon a obtenu les coefcients , le coefcient b peut tre obtenu en utilisant nimporte quel vecteur xi avec lgalit 2.10. Des paragraphes prcdents on soulignera que la solution dpend uniquement dun nombre restreint dexemple de lensemble dapprentissage et non pas de la dimension d de lespace des exemples. La gure 2.3 montre deux exemples de classication binaire obtenus avec deux noyaux diffrents. On remarquera la faible proportion (17%) des points dits vecteurs support par rapport au nombre de points constituant lensemble des exemples dapprentissage. 11

CHAPITRE 2. FONCTIONNEMENT DES MACHINES VECTEURS SUPPORT

2.7

Deux approches doptimisation

Gnralement les algorithmes SVM ce concentrent sur la rsolution du problme duale. Nanmoins un article de O. Chapelle [Chapelle, 2007] prsente une optimisation de la forme primale1 grce un algorithme de type Newton. La complexit obtenue est du mme ordre que pour une optimisation de la forme duale (O(n3 )). Lquation 2.15 peut se rcrire comme un problme doptimisation sans contrainte : w

2 n

+C L(yi , w xi + b)

i=1

(2.18)

avec L(y,t) = max(0, 1 yt) p une fonction de perte . Cette quation 2.18 peut tre reformule sous une forme non dtaille ici, mais qui peut soptimiser par diffrentes techniques (gradient conjugu, mthode de Newton, ...). Lexprimentation compare sur les deux formulations primale et duale montre des temps de calcul infrieurs pour loptimisation primale (respectivement duale) quelque soit la taille de lensemble dentrainement si le problme est linaire (respectivement non linaire). Nanmoins si le problme un grand nombre dexemples apprendre une solution exacte nest pas envisageable. Loptimisation de la forme primale est alors meilleure car on minimise directement la quantit qui nous intresse. O. Chappel montre dune part un gain ditration de 30% pour atteindre la convergence et dautre part lutilisation possible de mthodes numriques plus simples (comme le gradient conjugu ). Cela rend loptimisation de la forme primale intressante. Nanmoins historiquement la forme duale est la plus employe, nous allons prsenter par la suite certaines mthodes doptimisation consacres cette dernire. Les rsultats de la formulation duale sont inuencs par le choix des hyperparamtres (C, ). Dans le chaptre suivant nous allons donc voir les mthodes de slection des hyperparamtres optimaux.

existe dautres rfrences antrieures concernant loptimisation de la forme primale, on se rferrera lintroduction des travaux de O. Chapelle.

1 Il

12

Chapitre

Slection des paramtres du modle

La rsolution de la mthode des machines vecteurs support implique la slection de plusieurs paramtres : le type de noyau, le ou les paramtres du noyau (,...) et le paramtre de rgularisation C. Plusieurs mthodes existent pour slectionner ces paramtres. Une technique classique consiste choisir une grille de recherche pour C et puis appliquer une mthode de slection en cherchant loptimum dun critre de qualit associ un couple (C, ). Au cours de ce chapitre nous allons considrer que nous travaillons avec un noyau gaussien. Nous avons donc un seul paramtre noyau slectionner.

3.1

Mesure derreur en apprentissage

En utilisant des algorithmes dapprentissage nous devons considrer deux critres : lerreur dapprentissage Ea et lerreur de gnralisation Eg [Bisson, 2009]. Lerreur dapprentissage correspond au taux de mauvais classement sur lensemble dapprentissage. Lerreur de gnralisation correspond au taux de mauvais classement sur lensemble de test. Pour comparer les modles dapprentissage il est intressant de calculer une table de contingence (table 3.1). A partir de celle-ci on peut alors obtenir diffrents critres tel que le taux de reconnaissance donn par la formule 3.1 [Bisson, 2009]. A+D . A + B +C + D Ou encore la prcision et le rappel du modle donn respectivement par 3.2 et 3.3. Trec = Tprec = A . A+B A . A +C classe relle classe + A vrai positifs C faux ngatifs classe B faux positifs D vrais ngatifs (3.1)

(3.2) (3.3)

Trappel =

classe prdite

classe + classe -

TAB . 3.1 table de contingence 13

CHAPITRE 3. SLECTION DES PARAMTRES DU MODLE

F IG . 3.1 Exemple de grille de recherche des paramtres (,C) dun modle. La lgende reprsente la prcision obtenue (en pourcentage) sur un chantillon de test.

3.2

Validation croise

La validation croise est une technique qui permet de tester un modle dapprentissage. La validation croise se dcline en plusieurs sous-mthodes. La plus rpandue est la mthode kFold avec typiquement k [4, 10]. Si lon a une base dapprentissage A p contenant p lments : A p = {x1 , ..., x p }la validation croise consiste appliquer les cinq tapes suivantes :

p 1. Dcouper lensemble des exemples en k sous-ensembles disjoints de taille k .

2. Apprendre sur les k 1 sous-ensembles. 3. Calculer lerreur sur la kime partie. 4. Ritrer le processus p fois. 5. Obtenir lerreur nale en calculant la moyenne des k erreurs prcdentes. La validation croise est simple mettre en uvre et utilise toutes les donnes. Elle permet dobtenir une estimation de lerreur de gnralisation. Cela permet dviter le surapprentissage [Hsu et al., 2009].

3.3

Grille de recherche

Comme nonc prcdemment, nous cherchons le meilleur couple (C, ). Nous allons donc par exemple utiliser des squences exponentielles [Hsu et al., 2009] : C = 25 , 24 , ...215 et = 215 , 214 , ..., 23 . En dterminant une heuristique sur la qualit des rsultats on pourrait viter une recherche exhaustive de toutes les combinaisons de paramtre. Une recherche exhaustive est quand mme envisageable car les paramtres sont indpendants et nous pouvons donc facilement parallliser la recherche. Nous pourrions nanmoins envisager une recherche par gradiant ou par faisceau. Cette dernire pourrait aussi tre facilement paralllise. La gure 3.1 montre un exemple de calcul exhaustif du taux de validation croise pour une grille de valeurs (C, ). Aprs une premire valuation on peut relancer la procdure en ranant la grille. Dans notre exemple (gure 3.1) nous pourrions relancer sur les intervalles [23 , 214 ] pour C et [214 , 27 ] pour . On pourra trouver dautres exemples dans le document [Hsu et al., 2009]. 14

3.4. APPROCHE BIOMIMTIQUE

(a) Croisement (mono-point)

(b) Mutation (dun seul bit)

F IG . 3.2 Principe des oprateurs gntiques dans le cas dindividu cod sur 7 bits. Une mthode de recherche exhaustive sur grille a t applique dans le cas hyperspectral par lquipe VAHINE1 . Le principal problme lors de la mise en uvre consiste trouver une fonction pour estimer les meilleurs rsultats.

3.4

Approche biomimtique

Sinspirant de principes issus de la biologie, les algorithmes biomimtiques comme les algorithmes gntiques (AG) ont t utiliss avec succs dans de nombreux domaines dapplication. Dans le cas du traitement dimages, les AG sont employs pour rsoudre des problmes de classication et de rduction de dimensionnalit. Dans le cadre de limagerie hyperspectrale, une approche propose [Bazi et Melgani, 2006] est dutiliser les AG pour deux choses : dune part slectionner les meilleures composantes discriminantes des individus classier (rduction de dimensionnalit) et dautre part estimer les meilleures valeurs pour les paramtres de rgularisation et les paramtres noyau.

3.4.1

Algorithmes gntiques

Les algorithmes gntiques ont t conus par J. Holland [Holland, 1975]. Ce sont des algorithmes doptimisation. On trouvera une prsentation dtaille de ces processus dans de nombreux ouvrages [Rennard, 2002]. Les AG reposent sur plusieurs hypothses : un codage homogne des informations, une utilisation dune population de modles et non un seul modle, une mesure dadaptation des modles lenvironnement, une reproduction des modles avec modication et change dinformations non dterministes. La recherche de la meilleure solution se fait donc par lvolution dune population dindividu qui sont sousmis deux mcanismes tirs de la gntique : la mutation et le croisement. Dune faon gnrale, les tapes dun algorithme gntique sont dcrites dans lalgorithme 1. Des variantes existent mais les points communs sont les hypothses prcdemment listes. Plusieurs remarques cette tape simposent : le codage des individus ou chromosomes se fait sous la forme dune chane de bits, le croisement produit deux descendants partir de deux parents partir dun point de coupure choisit alatoirement dans le chromosome des parents, la mutation produit un nouvel individu partir dun seul individu ; on opre un complment 1 de certain bit. Du point de vue algorithmique, les AG sont intressants comparativement dautres algorithmes tel que le recuit-simul car ils traitent et font voluer une population de solutions et non une seule

and analysis of multi-dimensional hyperspectral images in Astrophysics , visualisation et analyse dimage hyperspectrale en Astrophysique.

1 Visualization

15

CHAPITRE 3. SLECTION DES PARAMTRES DU MODLE Algorithme 1 Principe dun algorithme gntique. 1: dbut 2: gnration alatoire dune population de N individus 3: rpter 4: reproduction et donc production de M descendants par croisement et mutation de la population 5: valuation de chaque individu avec une fonction dadaptation au problme 6: remplacement de tout ou partie de la population par les N meilleurs individus parmi les N + M disponibles 7: jusqu convergence dun critre de qualit ou nombre maximal de gnration atteint 8: n

F IG . 3.3 Codage de linformation dun chromosome pour une optimisation dun sparateur vaste marge. solution. De plus les mcanismes dvolution 3.2 font que les individus de la population courante interragissent entre eux au lieu dvoluer chacun indpendamment.

3.4.2

Optimisation des machines vecteurs support

La construction de la population dindividu ou de chromosome est bas sur le codage des composantes pertinentes de chaque exemple et des paramtres du modle. Les exemples sont des spectres sous forme de vecteur xi d d composantes correspondant au nombre de spectels des images hyperspectrales traiter (d = N ). Si nous restons dans le cas de lutilisation dun noyau gaussien nous avons deux paramtres (C, ) pour notre modle SVM. Nous allons donc considrer une population de p chromosomes Cm tel que Cm d+2 . Le chromosome Cm est un vecteur de bits qui permet le codage de lutilisation ou non dune composante des xi et le codage du couple de paramtres (C, ) du noyau (voir la gure 3.3). Une fois le codage effectu, llment important est la fonction dvaluation de chaque chromosome. Les auteurs de [Bazi et Melgani, 2006] proposent deux fonctions dvaluation : R2W2 ( radius margin bound , marge radial de liaison ) et SV ( support vector count , nombre de vecteur support). Un rsultat trs intressant de cet article est la comparaison des mthodes SVM avec lutilisation de R2W2 ou de SV. Cette dernire a de nombreux points positifs : elle est moins complexe implmenter et a une prcision plus importante >80% (R2W2 <80%). SV a aussi une probabilit de fausse alarme infrieure R2W2 (0,1 au lieu de 0,4). On peut donc en conclure que 16

3.4. APPROCHE BIOMIMTIQUE la fonction SV est une bonne candidate pour ltape dvaluation. Il est noter que la fonction SV est aussi utilise par les auteurs de [Ghoggali et al., 2009] comme fonction dvaluation dans un contexte identique. Lalgorithme propos par [Bazi et Melgani, 2006] reprend les grandes tapes prsentes prcdemment en ajoutant une classication nale avec les caractristiques du chromosome ayant la meilleure fonction dvaluation. Cet algorithme effectue une classication binaire ce qui nest gnralement pas sufsant. Les auteurs proposent donc une amlioration multi-classes que nous ne dtaillerons pas ici.

3.4.3

Bilan

Lavantage de cette mthode est quelle permet une rduction de dimensionnalit sans connaissance priori sur le nombre de composantes slectionner. Elle permet en parallle de slectionner les paramtres optimaux du noyau. Les rsultats des comparatifs avec des mthodes SVM classiques sont meilleurs. On obtient entre 1 et 10% de prcision supplmentaire. Cette prcision se fait au dtriment du temps dapprentissage qui est en moyenne dix fois suprieur.

17

CHAPITRE 3. SLECTION DES PARAMTRES DU MODLE

18

Chapitre

Mise en uvre

Aprs avoir prsent le principe des machines vecteurs support nous allons voir sa mise en uvre dans le cas de limagerie hyperspectrale plantologique. Son usage est tudi dans le cadre du projet de recherche Vahin1 [INRIA et al., 2008]. Nous avons vu dans les chapitres prcdents quun programme dapprentissage par SVM se ramne la rsolution dun problme doptimisation quadratique. De nombreux outils sont disponibles pour limplmentation ou lutilisation dun algorithme SVM, on trouvera notamment des rfrences sur le site : kernel-machines.org http://www.kernel-machines.org. Aprs une introduction au projet Vahin nous dtaillerons succintement une implmentation de rfrence au paragraphe 4.2.

4.1

Projet Vahin

Le projet Vahin conanc par lANR2 et le CNES a pour but de dvelopper des modles mathmatiques, physiques, des algorithmes et des logiciels capables de travailler avec des donnes hyperspectrales. Ces donnes sont aussi bien dorigine spatiale3 , exprimentale ou simule4 . Le projet vise terme publier un logiciel libre danalyse et de traitement dimage hyperspectrale. Le projet Vahin travaille sur des donnes plantaires issues des spectro-imageurs OMEGA (Observatoire pour la Minralogie, lEau, les Glaces et lActivit) ou CRISM ( Compact Reconnaissance Imaging Spectrometer for Mars , spectro-imageur de reconnaissance compacte pour Mars.). En complment, de nombreuses donnes synthtiques sont aussi cres partir de code de simulation physique.

4.2

Bibliothque LIBSVM

Cest une des bibliothques les plus usites elle a t dveloppe par Chang et Lin [Chang et Lin, 2010]. Elle contient de nombreux modules de classication et supporte la classication multi-classes ainsi que la validation croise. Elle est dveloppe en C++ et Java. Des interfaces sont disponibles pour Python, MATLAB, Perl et Ruby. Elle permet lusage de diffrents noyaux : linaire, polynomial ... Cest cette bibliothque que lon retrouve dans des composants de plus haut niveau en traitement dimage tel que la bote outil OTB5 [CNES, 2010] du CNES.

and analysis of multi-dimensional hyperspectral images in Astrophysics , visualisation et analyse dimage hyperspectrale en Astrophysique. 2 Agence Nationale de la Recherche. 3 Les donnes sont acquises par des satellites ou des sondes spatiales. 4 Les simulations numriques fournissent aussi de nombreuses donnes hyperspectrales. 5 Orfeo Tool Box , bote outils Orfeo.

1 Visualization

19

CHAPITRE 4. MISE EN UVRE

SVM 1

SVM 2

Rgle de dcision

SVM M

F IG . 4.1 Architecture parallle de classieur SVM binaire. Pour la rsolution du problme dual, cette librairie utilise une mthode de dcomposition [Bottou et Chih-Jen, 2007]. Celle-ci ne cherche pas optimiser lensemble des coefcients mais optimiser un sous ensemble i , i B de coefcients chaque itration en laissant les autres coefcients j , j B inchangs. LIBSVM utilise une optimisation appele optimisation / squentielle minimale ou SMO. On retrouvera le dtail de lalgorithme dans larticle de L. Bottou et C-J. Lin [Bottou et Chih-Jen, 2007].

4.3

Volume et taille des donnes

Les donnes issues des spectro-imageurs et des simulations numriques reprsentent de grands volumes de donnes (plusieurs To). Chaque image hyperspectrale fait plusieurs dizaines de mgaoctets. Le nombre de bandes spectrales tant denviron 200, la taille dune matrice servant au calcul dune fonction noyau est de lordre de 3,2 Go pour une centaine dchantillon. Pour grer ce problme limplmentation de LIBSVM utilise un systme de cache pour une partie de la matrice noyau K. Celle-ci est dnie par : Ki, j = K(xi , x j ), i, j [1, p]. A tout moment seule une partie des coefcients Ki, j est mmorise. Les coefcients manquants sont calculs la demande et mmoriss. Les coefcients en mmoire qui nont pas t utiliss rcemment sont dsallous et en outre, un codage dit sparse des donnes est utilis. Celui-ci ignore les colonnes comportant la valeur 0 et permet de rduire lempreinte mmoire.

4.4

Classication multi-classes

Les machines vecteurs support vu prcdemment effectuent une classication binaire. Dans la plupart des contextes dont le projet Vahin nous cherchons rsoudre des problmes multi-classes. Plusieurs mthodes ont t dveloppes, elles se regroupent en deux approches : les approches parallles et hirarchiques. Ces dernires tant moins performantes, nous aborderons seulement les approches parallles [Melgani et Bruzzone, 2004].

4.4.1

Un contre tous

Cette approche utilise une architecture parallle de k machines vecteurs support, une pour chaque classe. Chaque machine vecteurs support rsout un problme deux classes : une classe i (i ) et toutes les autres i . Sur la gure de principe 4.1 nous avons M classieurs binaires avec dans cette premire approche M = k. La rgle de dcision nale est lapplication du principe winner take all . Pour chaque classieur un score va tre tabli et ltiquette attribue 20

4.5. CHOIX DES HYPERPARAMTRES lentre xi est celle associe au classieur qui obtient le meilleur score. Son principal inconvnient est deffectuer un apprentissage qui peut tre grandement dsquilibr. Ainsi pour un classieur i nous pouvons avoir un trs petit nombre dexemples de la classe i et un grand nombre de contre exemples.

4.4.2

Un contre un

Cette approche utilise k(k 1)/2 classieurs o chaque SVM est entrain pour dpartager deux classes i et j . On construit ainsi autant de classieurs que de couples de classe (i , j ), i = j possibles. Nous avons donc de nouveau larchitecture prsente la gure 4.1 mais avec M = k(k 1)/2. La rgle de dcision sobtient en utilisant la mthode du vote majoritaire. Chaque classieur va incrmenter le score Si (respectivement S j ) associ la classe i (respectivement j ). Ensuite le score Si (x) le plus lev va permettre dattribuer ltiquette i lentre x. Certaines implmentations ajoutent une pondration au vote de chaque classieur. Dans [Hsu et Lin, 2002] les auteurs montrent que la mthode un contre un a une meilleure prcision que la mthode un contre tous dans 60% des cas, mais dans toutes les comparaisons les taux de prcision reste proche 2%. Mme si la diffrence de prcision est faible un argument plus important en faveur de la stratgie un contre un est le temps ncssaire laprentissage. Cette dernire est de 2 6 fois plus rapide que la mthode un contre tous . Chaque classieur de la mthode un contre un est entran avec beaucoup moins de donnes que la mthode un contre tous . La stratgie un contre tous a certes beaucoup moins de classieurs entraner, mais d la complexit des SVM elle savre nettement moins rapide.

4.4.3

Paralllisation

Plusieurs approches de paralllisation dans le cas multi-classes ont t testes. Lapproche nave de distribuer les M classieurs sur M processeur est inefcace. Les temps de calcul entre chaque classieur ne seront pas identiques car ils ne disposeront pas, sauf hasard, du mme nombre dexemples dans leur jeu dapprentissage. Finalement les M 1 processeurs attendront le dernier. Une approche assez simple pour contourner cela est de dployer une architecture matre esclave telle que dcrite dans larticle [Plaza et al., 2009]. Cette approche consiste dsigner un processeur ou nud de calcul qui excutera une tche principale dite matre. Celle-ci va distribuer chaque tche dune liste constitue par lensemble des k(k 1)/2 paires de classe (i , j ). Le processus matre va assigner les k 1 premires tches un processeur (ou nud de calcul). Quand un processeur esclave aura ni son calcul le matre lui enverra la prochaine tche de la liste jusqu puisement de celle-ci. Cette approche permet davoir un taux doccupation des processeurs esclaves optimal. Dautres approches plus complexes sont galement abordes dans [Plaza et al., 2009].

4.5

Choix des hyperparamtres

Nous avons vu dans les chapitres prcdents diffrentes mthodes pour le choix des hyperparamtres. Nous revenons ici sur la fonction dvaluation utilise pour les algorithmes gntiques et laspect multi-classes.

4.5.1

Fonction dvaluation SV

La fonction dvaluation note SV est trs simple puisquil sagit du nombre de vecteurs support associ au modle courant. Ce nombre est normalis par le nombre total dexemples traits par lalgorithme. Lide mise en uvre par cette valuation est quun petit nombre de vecteurs 21

CONCLUSION support dnisse un systme dapprentissage ayant de trs bonne capacit de gnralisation. La rduction du nombre de vecteurs support correspond une simplication du modle par limination des points non pertinents ou redondants.

4.5.2

Multi-classes

La problmatique du choix des hyperparamtres dans le cas multi-classes peut tre facilement implmente avec la mthode des algorithmes gntiques vu au paragraphe 3.4.2. En effet sur un chromosome nous nallons plus coder un seul couple (C, ) mais M couples correspondants aux diffrents classieurs de la mthode un contre un . Il faudra juste veiller a ce que loprateur de croisement coupe les chromosomes entre deux couples dhyperparamtres.

22

Conclusion

Cette tude fut trs intressante pour ma part, mais assez difcile du fait de laspect mathmatique. Pour conclure je me focaliserai sur les lments marquants de mes lectures. Compte-tenu de la grande dimensionnalit en imagerie hyperspectrale, lutilisation dune mthode pour rduire le nombre de spectels utiles est pertinente. Un appart physique permet de justier cela. Les terrains tant inomognes du point de vue de leurs compositions, chaque pixel est un mlange de spectres. Pour distinguer les molcules de CO2 et de H2 O sur un spectre les physiciens utilisent leurs bandes dabsorption spcique (triplet de leau par exemple). Celles-ci se situent sur un nombre restreint de spectels. Intuitivement, si notre problme est de dtecter les molcules de CO2 et de H2 O, on peut supposer que lensemble des spectels peut tre rduit. Le problme est de xer le nombre minimal de spectels ncessaire la reconnaissance des corps chimiques recherchs. Soit on se base sur la connaissance physique spectroscopique, soit on dtermine numriquement le nombre optimum en effectuant une comparaison sur une base de tests. Le deuxime point concerne les algorithmes gntiques. Leur grand intrt est leur paralllisme implicite [Goldberg, 1994]. Par exemple, lalgorithme vu prcdemment optimise la fois lespace des composantes (rduction du nombre de spectels) et les hyperparamtres. Mais on pourrait envisager dans un premier temps doptimiser uniquement les hyperparamtres des classieurs multi-classes. Le point ngatif dans ltat actuel de la thorie des algorithmes gntiques est quil nexiste aucune garantie de dcouvrir la solution optimale. Une consquence indirecte est leur temps de calcul assez long pour atteindre un rsultat acceptable. Enn si la mise en uvre dun algorithme de SVM est en gnral peu coteuse en temps grce aux outils disponibles, il faut cependant noter que la recherche des meilleurs paramtres peut requrir des phases de test assez longues. An de diminuer le temps de traitement, la paralllisation me semble un point clef. Elle peut intervenir plusieurs endroits : le parcours dune grille de recherche, dans le cadre dun algorithme gntique et surtout au niveau de limplmentation multi-classes. Cette mise en uvre du paralllisme est aussi importante du fait de la disponibilit dsormait courante de machine quadri-cur voir octo-cur. De ces trois points ci-dessus, il serait intressant dans le cadre du projet Vahin de les exploiter pour implmenter un SVM multi-classes laide de la bibliothque OTB. Je conclue par le fait que les SVM peuvent galement sutiliser pour dautres tches que la classication comme des tches de rgression, cest--dire de prdiction dune variable continue en fonction dautres variables. Le champ dusage des SVM est donc vaste. En rsum les machines vecteur de support constituent une technique dapprentissage se dveloppant depuis plus de 10 ans mais bien loin davoir atteint leurs limites.

Glossaire

Classication : voir classication non-supervise ou classication supervise. Classication non-supervise : ne ncessitant pas dautres informations que les donnes brutes. Classication supervise : classication qui ncessite des connaissances pralables. Condition de Mercer : permet dobtenir sous certaines conditions que si K(x, y) est un noyau dni positif il existe un espace F et une fonction tel que K(x, y) = (x) (y). Distance : ressemblance entre deux objets au sens mathmatique. Fonction de perte : une fonction de perte mesure le cot associ une erreur de prvision, cest-dire la diffrence entre la valeur prdite et la vraie valeur dune variable. Il existe plusieurs formes de fonction de perte pour prendre en compte diffrentes caractristiques, telles limportance donne aux valeurs extrmes. Gradient conjugu : la mthode du gradient conjugu est une amlioration de la mthode doptimisation sans contrainte du gradient simple. Pixel : lment discret de la dimension spatiale. Similitude : ressemblance entre deux classes. En classication on utilise des indices de similarit, tel lindice Jaccard/Tanimoto qui utilise ou non les proportions de caractristique commune entre chaque classe [Bisson, 2009]. Spectel : lment discret de la dimension spectrale. Spectre : ux dnergie lectro-magntique dcompos en frquences. Spectre de rfrence : spectre reprsentatif dun type de terrain (caractris par la prsence dune espce chimique ou dun mlange particulier). Le spectre de rfrence est au centre (en terme de distance ) de sa classe. Triplet de leau : bandes dabsorption situes a 1.5 m, 2 m et 3 m permettant didentier la prsence de la molcule H2 O.

25

Index

valuation (fonction d), 16, 21 apprentissage, 3, 4, 13 biomimtique, 15 chromosome, 16 classe, 3, 4 classication, 2, 3 complexit, 2, 4 contingence (table de), 13 contrainte, 9 croisement, 15 dimensionnalit, 15, 17 distance, 4, 8 duale, 810, 12 erreur, 13 gntique (algorithme), 15, 23 gntique (oprateur), 15 grille, 14 hyperplan, 7, 9, 10 hyperspectrale, 1, 2, 19, 20, 23 imagerie, 1 Lagrange (multiplicateurs), 8, 10 machine vecteurs support, 1, 4, 7 marge, 4, 7, 10 multi-classe, 20, 22, 23 multi-spectrale, 1 mutation, 15 noyau, 9, 20 paralllisation, 21, 23 paramtre, 13, 17 plantologie, 1, 19 prcision, 13 primale, 8, 12

rgularisation, 10 ressort (variable), 10 similitude, 4 spectel, 1 spectre, 4 spectro-imageur, 1, 20 supervis, 2, 3 SVM, 1, 4 tldtection, 1, 3 validation (croise), 14 vecteurs support, 7, 9

26

Bibliographie

[Appr, 2010] A PPR, T. (2010). Spring evolution of mars northern seasonal condensates from omega/mars express. Icarus. [Bazi et Melgani, 2006] BAZI, Y. et M ELGANI, F. (2006). Toward an optimal svm classication system for hyperspectral remote sensing images. IEEE Transactions on geoscience and remote sensing, 44:33743385. [Bisson, 2009] B ISSON, G. (2009). Intelligence articielle. [Bottou et Chih-Jen, 2007] B OTTOU, L. et C HIH -J EN, L. (2007). Support Vector Machine Solvers, in Large Scale Kernel Machines. MIT Press. [Bousquet, 2001] B OUSQUET, O. (2001). Introduction aux support vector machines. [Chang et Lin, 2010] C HANG, C.-C. et L IN, C.-J. (2010). Library for support vector machines. National Taiwan University. URL http://www.csie.ntu.edu.tw/~cjlin/ libsvm/LIBSVM. [Chapelle, 2007] C HAPELLE, O. (2007). Training a support vector machine in the primal. Neural computation, 19(5):11551178. [CNES, 2009] CNES (2009). Systme dual dobservation optique de rsolution mtrique. URL http://smsc.cnes.fr/PLEIADES/Fr/. [CNES, 2010] CNES (2010). Orfeo toolbox (otb). PLEIADES/Fr/lien3_vm.htm. URL http://smsc.cnes.fr/

[Cornujols et al., 2002] C ORNUJOLS, A., M ICLET, L. et KODRATOFF, Y. (2002). Apprentissage articiel. Eyrolles. [Cortes et Vapnik, 1995] C ORTES, C. et VAPNIK, V. (1995). Support vector networks. Machine Learning, 20:273297. [ESA, 2009] ESA (2009). Mars express orbiter instruments. URL http://www.esa.int/ SPECIALS/Mars_Express/SEMUC75V9ED_0.html. [Ghoggali et al., 2009] G HOGGALI, N., M ELGANI, F. et BAZI, Y. (2009). A multiobjective genetic svm approach for classication problem with limited training samples. IEEE Transactions on geoscience and remote sensing, 47:17071718. [Goldberg, 1994] G OLDBERG, D. (1994). Algorithmes gntiques. Exploration, optimisation et apprentissage automatique. Addison-Wesley. [Holland, 1975] H OLLAND, J. (1975). Adaptation in Natural and Articial Systems. The University of Michigan Press. [Hsu et al., 2009] H SU, C.-W., C HANG, C.-C. et L IN, C.-J. (2009). A practical guide to support vector classication. Rapport technique, National Taiwan University. 27

[Hsu et Lin, 2002] H SU, C.-W. et L IN, C.-J. (2002). A comparison of methods for multiclass support vector machines. IEEE Transactions on neural networks, 13:415425. [INRIA et al., 2008] INRIA, LPG et G IPSA -L AB (2008). Vahine : Visualization and analysis of multi-dimensional hyperspectral images in astrophysics. URL http://mistis. inrialpes.fr/vahine. [Melgani et Bruzzone, 2004] M ELGANI, F. et B RUZZONE, L. (2004). Classication of hyperspectral remote sensing images with support vector machines. IEEE Transactions on geoscience and remote sensing, 42(8):17781790. [Plaza et al., 2009] P LAZA, A., B ENEDIKTSSON, J. A., B OARDMAN, J. W., B RAZILE, J., B RUZ ZONE , L., C AMPS -VALLS, G., C HANUSSOT, J., FAUVEL, M., G AMBA , P., G UALTIERI , A., M ARCONCINI, M., T ILTON, J. C. et T RIANNI, G. (2009). Recent advances in techniques for hyperspectral image processing. Remote sensing of environment, 113. [Rennard, 2002] R ENNARD, J.-P. (2002). Vie articielle. Vuibert informatique. [Vapnik, 1995] VAPNIK, V. (1995). The Nature of Statistical Learning Theory. Springer-Verlag.

C.N.A.M : Epreuve TEST en INFORMATIQUE - UE ENG111 Les machines vecteurs de support pour la classication en imagerie hyperspectrale : implmentation et mise en uvre. Ludovic Mercier Grenoble le 11 fvrier 2010

R SUM Les machines vecteurs support (SVM) dveloppes dans les annes 1990 ont t utilises dans de trs nombreux domaines. Avec le rcent dveloppement des capteurs spectromtriques de haute rsolution spatiale (quelques dizaines de centimtres par pixel) et spectrale (plusieurs centaines de bandes), les SVM peuvent savrer de prcieux outils pour le traitement des images hyperspectrales. Ce document a pour but de montrer le fonctionnement des SVM et leur usage comme classieur dans le cadre de limagerie hyperspectrale. Plusieurs techniques de slection des hyper-paramtres sont abordes. Nous dtaillons une technique particulire qui utilise les algorithmes gntiques. La mise en uvre sur des donnes relles passe par lusage de librairies type LIBSVM et par la possibilit de faire de la classication multiple. Un algorithme SVM ne pouvant sparer que deux classes, il est alors ncssaire de choisir une stratgie multi-classes adapte. Lutilisation de SVM multi-classes associes un algorithme gntique pour la classication dimage hyperspectrale pourrait tre alors envisage dans le cadre du projet de recherche VAHINE. M OTS CLEFS : Algorithme gntique (AG), apprentissage, classication, classication supervise, classication multi-classes, image hyperspectrale, machines vecteurs support (SVM), tldtection.

A BSTRACT Support vector machine (SVM) created in 90s is a popular tool for classication problems. Last hyperspectral remote sensors generate large dimensional data because of their very high spatial and spectral resolution. The support vector machine classier can help us to process these hyperspectral images. Therefore the goal of this document is to explain the mechanism of SVM and its use as classier. Several methods of model parameters selections are presented. We focus on one of them, the selection by genetic algorithm. The implementation of SVM typically uses LIBSVM solver to process real data. Our algorithms have to be able to operate in multi-class mode. As the SVMs were originally designed for binary classication, we have to select an efcient multiclass strategy. For VAHINE research project, we assume the usage of a SVM classier with integrated genetic algorithm for parameter model selection. K EY WORD : Classication, genetic algorithm (GA), hyperspectral image, multiclass classication, remote sensing, supervised classication, support vector machines (SVM).

Vous aimerez peut-être aussi

- These MadaniDocument146 pagesThese Madanimariawahiba100% (1)

- Support Vector Machine SVMDocument15 pagesSupport Vector Machine SVMVivo Vivoo VIPas encore d'évaluation

- Le droit de la régulation audiovisuelle et le numériqueD'EverandLe droit de la régulation audiovisuelle et le numériquePas encore d'évaluation

- La prise de décision en éthique clinique: Perspectives micro, méso et macroD'EverandLa prise de décision en éthique clinique: Perspectives micro, méso et macroPas encore d'évaluation

- Les joint ventures dans le commerce internationalD'EverandLes joint ventures dans le commerce internationalPas encore d'évaluation

- Commerce électronique Canada-Union européenneD'EverandCommerce électronique Canada-Union européenneÉvaluation : 5 sur 5 étoiles5/5 (1)

- Armes Autonomes: Comment l'intelligence artificielle va-t-elle s'emparer de la course aux armements ?D'EverandArmes Autonomes: Comment l'intelligence artificielle va-t-elle s'emparer de la course aux armements ?Pas encore d'évaluation

- L'Intelligence Artificielle (Ia) : Trinôme: - ADJLANE Hichem - SEGHIR Mohamed - Boucebha AkramDocument12 pagesL'Intelligence Artificielle (Ia) : Trinôme: - ADJLANE Hichem - SEGHIR Mohamed - Boucebha Akramlogicielo DzPas encore d'évaluation

- Confidentialité et prévention de la criminalité financière: Étude de droit comparéD'EverandConfidentialité et prévention de la criminalité financière: Étude de droit comparéPas encore d'évaluation

- La théorie des jeux: Thrillers judiciaires de Katerina Carter, #2D'EverandLa théorie des jeux: Thrillers judiciaires de Katerina Carter, #2Pas encore d'évaluation

- Le CHERCHEUR FACE AUX DEFIS METHODOLOGIQUES DE LA RECHERCHE: Freins et leviersD'EverandLe CHERCHEUR FACE AUX DEFIS METHODOLOGIQUES DE LA RECHERCHE: Freins et leviersPas encore d'évaluation

- L'intervention publique dans la spère économique: Fondements,principes et limitesD'EverandL'intervention publique dans la spère économique: Fondements,principes et limitesPas encore d'évaluation

- Le Créatorat: Un nouveau paradigme pour la vie en sociétéD'EverandLe Créatorat: Un nouveau paradigme pour la vie en sociétéPas encore d'évaluation

- L'arbitre et le juge étatique: Études de droit comparé à la mémoire de Giuseppe TarziaD'EverandL'arbitre et le juge étatique: Études de droit comparé à la mémoire de Giuseppe TarziaPas encore d'évaluation

- Fingerprint Fingervein FusionDocument91 pagesFingerprint Fingervein FusionKilo NovembrePas encore d'évaluation

- Actualités de la protection juridictionnelle dans et par l'Union européenneD'EverandActualités de la protection juridictionnelle dans et par l'Union européennePas encore d'évaluation

- L' ADMINISTRATION DES TERRITOIRES ET LES INSTRUMENTS DE L'ACTION PUBLIQUED'EverandL' ADMINISTRATION DES TERRITOIRES ET LES INSTRUMENTS DE L'ACTION PUBLIQUEPas encore d'évaluation

- Politiques climatiques de l'Union européenne et droits de l'HommeD'EverandPolitiques climatiques de l'Union européenne et droits de l'HommePas encore d'évaluation

- Alternatives: Les contre-récits pour combattre le discours de haineD'EverandAlternatives: Les contre-récits pour combattre le discours de hainePas encore d'évaluation

- L'expérience patient: La levée d'un tabou pour une meilleure prie en charge des patientsD'EverandL'expérience patient: La levée d'un tabou pour une meilleure prie en charge des patientsPas encore d'évaluation

- Les PRATIQUES TRANSFORMATRICES DES ESPACES SOCIONUMERIQUESD'EverandLes PRATIQUES TRANSFORMATRICES DES ESPACES SOCIONUMERIQUESPas encore d'évaluation

- Le Cyber-Harcèlement: Lorsque Le Harceleur S'Introduit Dans Votre Ordinateur.D'EverandLe Cyber-Harcèlement: Lorsque Le Harceleur S'Introduit Dans Votre Ordinateur.Pas encore d'évaluation

- Développer et interpréter une échelle de mesure: Applications du modèle de RaschD'EverandDévelopper et interpréter une échelle de mesure: Applications du modèle de RaschPas encore d'évaluation

- Le juge et l'algorithme : juges augmentés ou justice diminuée ?D'EverandLe juge et l'algorithme : juges augmentés ou justice diminuée ?Pas encore d'évaluation

- Réalité Augmentée: Est-il possible que la réalité augmentée réussisse là où la réalité virtuelle a échoué ?D'EverandRéalité Augmentée: Est-il possible que la réalité augmentée réussisse là où la réalité virtuelle a échoué ?Pas encore d'évaluation

- Traitement Cryogénique: Warfighter Lethality, vos médailles militaires sont-elles en danger ?D'EverandTraitement Cryogénique: Warfighter Lethality, vos médailles militaires sont-elles en danger ?Pas encore d'évaluation

- L'Administration et vous – un manuel: Principes de droit administratif concernant les relations entre l’Administration et les personnesD'EverandL'Administration et vous – un manuel: Principes de droit administratif concernant les relations entre l’Administration et les personnesPas encore d'évaluation

- L'application judiciaire du droit de l'Union européenne: Recueil d'étudesD'EverandL'application judiciaire du droit de l'Union européenne: Recueil d'étudesPas encore d'évaluation

- La Reconnaissance en Ligne de L'écriture Arabe ManuscriteDocument227 pagesLa Reconnaissance en Ligne de L'écriture Arabe ManuscritelukasesanePas encore d'évaluation

- Manuel de médecine légale: À l'usage des jurés, des avocats et des officiers de santéD'EverandManuel de médecine légale: À l'usage des jurés, des avocats et des officiers de santéPas encore d'évaluation

- L’innéité aujourd’hui: Connaissances scientifiques et problèmes philosophiquesD'EverandL’innéité aujourd’hui: Connaissances scientifiques et problèmes philosophiquesPas encore d'évaluation

- Veille stratégique et PME: Comparaison des politiques gouvernementales de soutienD'EverandVeille stratégique et PME: Comparaison des politiques gouvernementales de soutienPas encore d'évaluation

- Structure Multifonctionnelle: Les futurs systèmes de l'armée de l'air seront intégrés dans des cellules matérielles multifonctionnelles avec capteur intégré et composants de réseauD'EverandStructure Multifonctionnelle: Les futurs systèmes de l'armée de l'air seront intégrés dans des cellules matérielles multifonctionnelles avec capteur intégré et composants de réseauPas encore d'évaluation

- Ai Pour DebutantsDocument9 pagesAi Pour Debutantsdiavotchka 12Pas encore d'évaluation

- Prêt-à-penser et post-vérité: Le suicide numérique de la démocratieD'EverandPrêt-à-penser et post-vérité: Le suicide numérique de la démocratiePas encore d'évaluation

- Wiki SVMDocument10 pagesWiki SVMSiwar Ben GamraPas encore d'évaluation

- Les Bases de JAVADocument46 pagesLes Bases de JAVAHasnae MoumniPas encore d'évaluation

- Java DeveloppementDocument21 pagesJava DeveloppementIbrahim BousettaPas encore d'évaluation

- Rouidi Houssam Mémoire de Fin D'étudeDocument144 pagesRouidi Houssam Mémoire de Fin D'étudeHoussam RouidiPas encore d'évaluation

- Ad Hoc - Theorie Des Jeux V2.9Document69 pagesAd Hoc - Theorie Des Jeux V2.9Hakim HakimPas encore d'évaluation

- Ar Sem13 Profond PDFDocument48 pagesAr Sem13 Profond PDFMohamed AyedPas encore d'évaluation

- Modeles Mathematiques Et Metaheuristiques Pour LaDocument11 pagesModeles Mathematiques Et Metaheuristiques Pour Lajacques EDOHPas encore d'évaluation

- DécisionDocument12 pagesDécisionmassipssaPas encore d'évaluation

- Prediction Des Proprietes Des Materiaux Par Apprentissage.Document58 pagesPrediction Des Proprietes Des Materiaux Par Apprentissage.BOULAHLIB ALDJIAPas encore d'évaluation

- Theorie Des Jeux Poly ENPCDocument129 pagesTheorie Des Jeux Poly ENPCLhoucine EL Bourki100% (1)

- Pacte PME - RATP - Reconnaissance FacialeDocument7 pagesPacte PME - RATP - Reconnaissance FacialeJujusetePas encore d'évaluation

- Kruskal WallisDocument37 pagesKruskal WallisdaoPas encore d'évaluation

- Multimètre Multimètre Multimètre Multimètre: NoticeDocument12 pagesMultimètre Multimètre Multimètre Multimètre: NoticeNael Traore SoulePas encore d'évaluation

- Exam S1 SN 19-20-CorrectionDocument2 pagesExam S1 SN 19-20-CorrectionMohamed MezianiPas encore d'évaluation

- Cristianos Vayamos Adeste Fideles UnisonoDocument1 pageCristianos Vayamos Adeste Fideles UnisonoLuis RodriguezPas encore d'évaluation

- CCCCCCCCCCCCCCCCCCCCCDocument39 pagesCCCCCCCCCCCCCCCCCCCCCAmina ElkobriPas encore d'évaluation

- Pathologies Mentales À L'adolescence - JeammetDocument13 pagesPathologies Mentales À L'adolescence - JeammetdaphPas encore d'évaluation

- Capture D'écran . 2022-02-19 À 12.00.42Document10 pagesCapture D'écran . 2022-02-19 À 12.00.42Mahamat Seid FadoulPas encore d'évaluation

- Aurobindo Savitri en Francais PDFDocument352 pagesAurobindo Savitri en Francais PDFMichel Mangin0% (1)

- B Un CorrigéDocument14 pagesB Un CorrigéZizo chmiaPas encore d'évaluation

- SPECILISATIONDocument66 pagesSPECILISATIONIem MyrPas encore d'évaluation

- Conception Parasismique Des BatimentsDocument7 pagesConception Parasismique Des Batimentsmuahong123Pas encore d'évaluation

- Devoir 1 Classe de 1ere CDDocument2 pagesDevoir 1 Classe de 1ere CDdaniel feujioPas encore d'évaluation

- Genie CivilDocument96 pagesGenie Civilعبد الوهاب بوشنةPas encore d'évaluation

- EPS Et Citoyenneté Deouis 1925Document14 pagesEPS Et Citoyenneté Deouis 1925Annis VaranePas encore d'évaluation

- TD2 CapteurDocument3 pagesTD2 CapteurAbdellah El guernaouiPas encore d'évaluation

- 1 - Cours - UML - Yassine Rhazali - Partie - 2Document15 pages1 - Cours - UML - Yassine Rhazali - Partie - 2thegymlaboPas encore d'évaluation

- Vie Chaste - PureDocument10 pagesVie Chaste - PureStan InchaudPas encore d'évaluation

- Coefficients de Rigidité (XELIS) (2011)Document6 pagesCoefficients de Rigidité (XELIS) (2011)lilhaq930% (1)

- Chapitre 2 - Généralités Et Définitions de BaseDocument31 pagesChapitre 2 - Généralités Et Définitions de BaseTaki BenazzouzPas encore d'évaluation

- Généralités Sur Les ISTDocument9 pagesGénéralités Sur Les ISTpapinou sarrPas encore d'évaluation

- Mémoire Social CRMDocument114 pagesMémoire Social CRMyoucef lamariPas encore d'évaluation

- Cours StochastiqueDocument125 pagesCours StochastiqueAnass ChertiPas encore d'évaluation

- Comment Utiliser Access 2007 PDFDocument2 pagesComment Utiliser Access 2007 PDFLauraPas encore d'évaluation

- La Mise en Place D'une Plate F - KHADDAM ALLAH Asmae - 1343Document84 pagesLa Mise en Place D'une Plate F - KHADDAM ALLAH Asmae - 1343Mehdi BenPas encore d'évaluation

- Rapport de Stage Génie Civil - Étude D'un Mur de SoutènementDocument1 pageRapport de Stage Génie Civil - Étude D'un Mur de Soutènement4geniecivil50% (2)

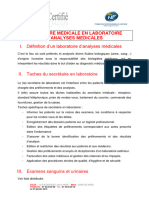

- Secretaire Medicale en Laboratoire D'Analyses MedicalesDocument5 pagesSecretaire Medicale en Laboratoire D'Analyses MedicalesRafik KhademPas encore d'évaluation

- Ddoc T 2015 0263 QademDocument360 pagesDdoc T 2015 0263 Qademoussama2015Pas encore d'évaluation

- 1-TDRs ASSISTANCE TECHNIQUE POUR L'AIDE À LA PROSPECTION D'ENTREPRISES ANETIDocument7 pages1-TDRs ASSISTANCE TECHNIQUE POUR L'AIDE À LA PROSPECTION D'ENTREPRISES ANETIAbdelhakim KhaldiPas encore d'évaluation

- Commerce International AFRIQUE ET MAROC Rapport FinalDocument20 pagesCommerce International AFRIQUE ET MAROC Rapport Finalzineb.boutaibPas encore d'évaluation

- COURS 9 LES ANTIBIOTIQUES COURS Snve 2Document69 pagesCOURS 9 LES ANTIBIOTIQUES COURS Snve 2Chawki MokademPas encore d'évaluation