Académique Documents

Professionnel Documents

Culture Documents

Usan - Physique, Information Statistique Et Complexité Algorithmique

Transféré par

Patrícia NettoCopyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Usan - Physique, Information Statistique Et Complexité Algorithmique

Transféré par

Patrícia NettoDroits d'auteur :

Formats disponibles

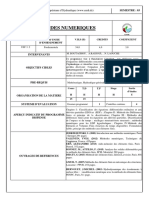

Philosophia Scienti

11-2 (2007)

Varia

................................................................................................................................................................................................................................................................................................

Pierre Uzan

Physique, information statistique et

complexit algorithmique

................................................................................................................................................................................................................................................................................................

Avertissement

Le contenu de ce site relve de la lgislation franaise sur la proprit intellectuelle et est la proprit exclusive de

l'diteur.

Les uvres figurant sur ce site peuvent tre consultes et reproduites sur un support papier ou numrique sous

rserve qu'elles soient strictement rserves un usage soit personnel, soit scientifique ou pdagogique excluant

toute exploitation commerciale. La reproduction devra obligatoirement mentionner l'diteur, le nom de la revue,

l'auteur et la rfrence du document.

Toute autre reproduction est interdite sauf accord pralable de l'diteur, en dehors des cas prvus par la lgislation

en vigueur en France.

Revues.org est un portail de revues en sciences humaines et sociales dvelopp par le Clo, Centre pour l'dition

lectronique ouverte (CNRS, EHESS, UP, UAPV).

................................................................................................................................................................................................................................................................................................

Rfrence lectronique

Pierre Uzan, Physique, information statistique et complexit algorithmique, Philosophia

Scienti [En ligne], 11-2|2007, mis en ligne le 27 juin 2011, consult le 14 juin 2015. URL: http://

philosophiascientiae.revues.org/347; DOI: 10.4000/philosophiascientiae.347

diteur : Universit Nancy 2

http://philosophiascientiae.revues.org

http://www.revues.org

Document accessible en ligne sur :

http://philosophiascientiae.revues.org/347

Document gnr automatiquement le 14 juin 2015. La pagination ne correspond pas la pagination de l'dition

papier.

Tous droits rservs

Physique, information statistique et complexit algorithmique

Pierre Uzan

Physique, information statistique et

complexit algorithmique

Pagination de ldition papier : p. 121-162

Introduction: Comment parler dinformation en physique?

1

Le concept dinformation se trouve au cur de la physique actuelle. En physique quantique, le

concept dinformation constitue le fondement mme de linterprtation minimale inconteste

de la notion de vecteur dtat comme outil prdictif contextuel. En effet, selon cette

interprtation qui a t explore en profondeur par M. Bitbol, linformation dont dispose

lobservateur sur une situation exprimentale et qui permet le calcul des prdictions est

encode dans le vecteur dtat (ou plus gnralement loprateur densit) reprsentatif de sa

prparation [Bitbol 1996].

En mcanique statistique, classique ou quantique, le concept dinformation sest introduit

lorsquon a cherch justifier la loi de croissance monotone de lentropie dun systme isol.

Certains physiciens ont mme t jusqu interprter lentropie thermodynamique en terme

de manque dinformation, comme une mesure de notre ignorance de ltat microscopique

du systme. Selon ce point de vue, qui a t introduit et dvelopp par Szillard, Shannon,

Brillouin [Szillard 1929] [Shannon et Weaver 1949] [Brillouin 1956] et dvelopp de faon

systmatique par Jaynes et, plus rcemment, par Balian [Jaynes 1957] [Balian 1982 ;

2005], le second principe de la thermodynamique ne modliserait que le processus de perte

dinformation corrlatif de lvolution dun systme vers son tat dquilibre.

Plus gnralement, les interprtations informationnelles de la physique, voire les tentatives de

reconstruction de la physique dun point de vue informationnel, ne cessent de se dvelopper

et savrent prometteuses, comme nous le montrent plusieurs travaux rcents traitant de

linformation quantique [Nielsen 1998] [Timpson 2004] [Grinbaum 2004].

Cependant, si la place du concept dinformation en physique semble pleinement acquise,

cest la manire dont ce concept est dfini et utilis qui pose problme. En effet, le concept

dinformation qui a t adopt en mcanique statistique depuis les travaux de Jaynes [Jaynes

1957] renvoie ce que connat ou ce que peut connatre lobservateur. Il sagit dun concept

dinformation-connaissance formul en terme dinformation (ou dentropie) statistique, ce

dernier concept tant issu de la thorie de la communication de Shannon et Weaver [Shannon

& Weaver 1949]. Le concept dinformation statistique a, il est vrai, permis de dvelopper

une interprtation cohrente de la thermodynamique en fournissant une justification de la

dfinition de lentropie thermodynamique introduite par Boltzmann et Gibbs en mcanique

statistique. Son succs semble dailleurs tre pleinement confirm par la fcondit du postulat

dentropie statistique maximale permettant de calculer les distributions dquilibre dun

systme thermodynamique. Ce principe stipule que parmi toutes les distributions statistiques

compatibles avec les donnes exprimentales, on doit reprsenter le macro-tat du systme par

celle qui correspond la plus grande valeur de lentropie statistiquecest--dire par celle

qui, tout en tant compatible avec les contraintes macroscopiques, nintroduit aucune autre

information-connaissance arbitraire [Jaynes 1957] [Balian 1982; 2005].

Mais, y regarder de prs, les succs de la mcanique statistique ne doivent rien cette

sur-interprtation subjectiviste de la notion dentropie thermodynamique. Par exemple,

de nombreuses prsentations de la mcanique statistique, comme celles de Reiff, de

Hakim ou de Cou-lon et Moreau [Reiff 1965] [Hakim 1996] [Coulon & Moreau 2000],

nous montrent que la dfinition statistique de lentropie thermodynamique dun systme

physique donne par Boltzmann, en terme de micro-tats accessibles, cest--dire compatibles

avec les contraintes macroscopiques, ne ncessite en rien dtre identifie un manque

dinformation-connaissance de ltat microscopique de ce systme. Cette dfinition ne

requiert a priori aucune interprtation subjectiviste des (densits de) probabilits quelle

Philosophia Scienti, 11-2 | 2007

Physique, information statistique et complexit algorithmique

utilise. Ces dernires peuvent toujours, aprs Boltzmann, tre penses comme des rapports

de nombre de configuration physiques compatibles avec les contraintes macroscopiques.

Corrlativement, la recherche des distributions dquilibre ne ncessite en rien de se rfrer

ce que lon connat (ou ce que lon pourrait connatre) ou pas de ltat microscopique

dun systme physique puisque celles-ci peuvent tre calcules partir dun dcompte des

configurations microscopiques physiques accessibles (voir, par exemple, [Coulon & Moreau

2000 2.3.2]). Par consquent, sil ny a, a priori, aucune raison pour identifier lentropie

thermodynamique dun systme physique avec un manque dinformation-connaissance de son

tat microscopique, cest bien lide suggre par Boltzmann selon laquelle elle constitue une

mesure de son organisation intrinsque (de son dsordre molculaire ) quil nous faut

privilgier. C est cette ide qui sera soutenue ici.

En outre, linterprtation subjectiviste de la notion dentropie thermodynamique semble

dboucher sur une impasse conceptuelle : la suppose quivalence entre entropie

thermodynamique et manque dinformation-connaissance, qui mne lide de convertibilit

entre nguentropie et information-connaissance, permet de soutenir celle dun cot entropique de lacquisition dinformation-connaissance [Szillard 1929] [Bril-louin 1956] [Costa

de Beauregard 1963]. Or, cette dernire ide, qui a t propose comme solution au clbre

paradoxe du dmon de Maxwell, est aujourdhui fortement remise en question. Ce dbat

crucial sera rapport brivement dans la sectionIII.1 partir des textes rassembls par Leff et

Rex [Leff & Rex 2003] et de ses dveloppements plus rcents dus Norton [Norton 2005],

Bennett [Bennett 2003] et Shenker [Shenker 2000].

Enfin, dun point de vue plus technique (sectionIII.2), lutilisation de la notion statistique

dinformation en physique quantique rencontre trs vite dimportantes limites. Il sagit dj de

sa rfrence problmatique une notion de mesure qui en fait une grandeur relative certaines

observables particulires. Mais surtout, par le fait que linformation statistique associe un

tat quantique nvalue que sa dviation par rapport la puret, elle est incapable de donner

un sens et, a fortiori, dvaluer linformation encode dans un tat pur alors quune telle

valuation savre tout fait essentielle pour le dveloppement des thories de linformation

quantique.

Cet article se propose donc, dans un premier temps, de mettre en vidence les limites de

lutilisation de la notion statistique dinformation en physique. Pour cela, nous commencerons

par analyser la faon dont sest introduit en physique le concept dinformation-connaissance

(section I), et, plus prcisment, celui dinformation statistique (section II), avant de

mettre en vidence ses limites dordre conceptuelle et technique (section III). Puis, dans

un deuxime temps, nous montrerons, partir de la section IV, comment la notion de

complexit algorithmique, introduite par Solomonoff, Kolmogorov et Chaitin [Solomonoff

1964] [Kolmogorov 1965] [Chaitin 1977], permet de surmonter ces limitations en proposant

une dfinition structurelle ou organisationnelle de l information . Une telle notion

dinformation est, en effet, dgage de tout subjectivisme excessif puisque quelle nvalue pas

la connaissance ou le manque de connaissance de lobservateur concernant ltat dun systme

physique mais, mme si cest une certaine prcision prs (comme cest en fait le cas pour

toute grandeur physique), son organisation intrinsque. Comme nous le prciserons dans les

sectionsV.2 et VI partir des recherches de Zurek et Caves [Zurek 1989] [Caves 1990], elle

permet de proposer une interprtation structurelle de la notion dentropie thermodynamique.

Enfin, elle peut tre utilise de faon satisfaisante pour valuer le contenu informationnel dun

tat quantique pur, ce que ne peut faire la notion statistique dinformationnotons que

lapplication de la thorie de la complexit algorithmique au domaine quantique, qui requiert

des prcisions conceptuelles et techniques supplmentaires, sera examine part, dans la

sectionVI, partir des recherches rcentes de Vitnyi, Berthiaume et al., Gcs, Mora et Briegel

[Vitnyi 2001] [Gcs 2001] [Berthiaume et al. 2000] [Mora and Briegel 2004].

Lintroduction de cette notion structurelle dinformation en physique permettrait donc

dasseoir sur des bases plus saines et plus fcondes la direction de recherche actuelle qui lie de

faon troite physique et information, tant dans le domaine de la physique statistique (classique

et quantique) que celui de la thorie de linformation quantique. Ces dveloppements

Philosophia Scienti, 11-2 | 2007

Physique, information statistique et complexit algorithmique

pourraient, selon nous, constituer les prmisses dune vritable thermodynamique de

linformation base sur le concept dinformation structurelle dont la mesure nous est donne

en terme de complexit algorithmique.

I. Le second principe de la thermodynamique et ses

interprtations dans le cadre de la mcanique statistique

10

11

12

La relation entre physique et information semble stre noue lorsqu on a essay dinterprter

le second principe de la thermodynamique dans le cadre de la mcanique statistique.

Le second principe de la thermodynamique a une origine purement phnomnologique

puisquil a t formul, au XIXe sicle, partir de lobservation du fonctionnement des

machines thermiques. Ses premiers noncs, relatifs au domaine spcifiquement thermique,

sont dus Clausius (la chaleur ne passe pas spontanment dun corps froid sur un corps

chaud), Thomson (un systme en contact avec une seule source de chaleur ne peut, au

cours dun cycle, que recevoir du travail et fournir de la chaleur) ou Carnot (si une machine

fournit du travail au cours dun cycle, elle change ncessairement de la chaleur avec deux

sources de tempratures diffrentes). Ces noncs sont quivalents et peuvent tre drives

dun nonc plus gnral1, de type axiomatique, qui stipule que:

Pour tout systme thermodynamique, ouvert ou ferm, il est possible de dfinir une fonction

dtat S, appele entropie 2, qui vrifie les proprits suivantes : S est une grandeur

extensive, et sa variation lors dune transformation quelconque sexprime sous la forme dune

somme de deux termes:

S=Se+Si,

13

14

15

16

o Se est un terme algbrique d aux changes de chaleur et de matire avec le milieu

extrieur. Pour un systme ferm recevant une quantit de chaleur Q la temprature T

constante, Se=Q /T, alors que Si rsulte des modifications internes du systme associes

des phnomnes irrversibles.

On postule alors que Si>0, en affirmant que lirrversibilit interne est source dentropie.

Par consquent, selon le second principe de la thermodynamique, lentropie dun systme

isol ne peut quaugmenter puisque dans ce cas Q=0 alors que Si>0. Ltat dquilibre

thermodynamique sera celui pour lequel S est maximale, compte tenu des contraintes imposes

au systme.

Malheureusement, la notion dentropie thermodynamique ne peut trouver dinterprtation dans

le cadre strict de la mcanique Hamiltonienne. En effet, Henri Poincar a montr quil nexiste

aucune fonction S(qj, pi, t) des coordonnes gnralises qj et pi du point reprsentatif de

ltat dun systme dans lespace des phases et du paramtre temps t qui puisse interprter

la notion dentropie thermodynamique. Plus exactement, lvolution thermodynamique dun

systme physique, caractrise par lexistence dune telle fonction monotone croissante (avec

t), est incompatible avec son volution mcanique qui est rgie par les quations de HamiltonJacobi3 [Poincar 1889]. Poincar a tabli ce rsultat partir des lois Hamiltoniennes et de

considrations tout fait gnrales sur les dveloppements en srie entire de lnergie E(qj,

pi, t) et de lhypothtique fonction entropie S(qj, pi, t) et sans utiliser lobjection de

rversibilit de Loschmidt qui traduit linvariance temporelle des lois de la mcanique.

On pourrait croire, comme il est souvent dit et crit un peu rapidement, que lirrversibilit

thermodynamique peut alors tre explique par la seule utilisation de la mcanique statistique

qui procde dune description probabiliste des systmes physiques de grande taille tablissant

un lien entre les grandeurs macroscopiques mesurables et les valeurs moyennes des proprits

de ses constituants microscopiques. Cependant, comme le rappellent les dveloppements

ci-dessous, si une interprtation satisfaisante des phnomnes thermodynamiques ncessite

effectivement, cause de la taille macroscopique des systmes physiques considrs,

lutilisation de la mcanique statistique, cest toujours par lintroduction dhypothses

posant au dpart de la dmonstration lasymtrie quil faut tablir et, en outre, au prix

dapproximations, que lirrversibilit trouve une justification.4

Philosophia Scienti, 11-2 | 2007

Physique, information statistique et complexit algorithmique

1.1. Lhypothse du chaos molculaire [Boltzmann 1867, 1872]

17

Historiquement, les premires tentatives pour tablir un pont entre mcanique statistique

et thermodynamique sont dues Boltzmann. Pour modliser lvolution dun systme N

particules, Boltzmann utilise des fonctions de rpartition rduites p(p, q, t), o p et q sont

les vecteurs quantit de mouvement et position des constituants du gaz, dans lespace

une particule o lensemble de N particules est reprsent par un nuage de N points 6

coordonnes (trois despace et trois de quantit de mouvement). Cest--dire que le nombre:

(p, q, t)d3pd3q,

18

est le nombre moyen de particules se trouvant, linstant t, dans le volume lmentaire d3q

centr autour du point q et qui possdent la quantit de mouvement p d3p prs.

Cest pour valuer le terme de collision (collisions supposes binaires) entre les molcules

dun gaz parfait, suppos isol et homogne, que Boltzmann a introduit l hypothse du

chaos molculaire. Cette hypothse, que Boltzmann justifie par lexistence de perturbations

extrieures (le systme ne serait donc pas vraiment isol), postule de faon vidente une

asymtrie temporelle [Boltzmann, in Brush 1966]:

(CM) Les molcules ne sont pas corrles avant dentrer en collisionalors quelles le sont juste

aprs.

19

Formellement, lhypothse (CM) implique lindpendance des nombres de molcules

susceptibles dentrer en collision dans un certain volume linstant t et se traduit par

la destruction rapide des relations de phase entre tats. Lvolution macroscopique est

alors modlise par un processus stochastique (description en termes de probabilits),

Markovien (les probabilits de transitions ne dpendent pas des tats microscopiques passs) et

stationnaire (par linvariance des quations de la mcanique par translation temporelle). Cest

g rce ltablissement de cette quation cintique approche que Boltzmann peut montrer

quune certaine fonctionnelle, appele H (et que nous nommons HBoitzmann pour la distinguer

de celle dfinie par Gibbs ci-aprs):

est monotone dcroissante jusqu ltat dquilibre thermodynamique, et donc que la

grandeur:

SBoltzmann=kBHBoltzmann,

o kB est la constante de Boltzmann, peut interprter la notion dentropie thermodynamique.

Notons que cette dernire fonctionnelle entropie scrit, selon la clbre formule due

Boltzmann,

SBoltzmann= kB ln ,

o est le nombre de configurations possibles ou dtats physiques accessibles, dans le

cas dun gaz parfait lquilibre (et sous lhypothse dquiprobabilit des tats accessibles).

I.2. Lhypothse des phases alatoires [Pauli 1928]

20

En physique quantique, von Neumann [von Neumann 1955] a dfini lentropie dun oprateur

densit D par:

SVN[D] =kBTrD ln D. (1)

21

Lentropie quantique SVN[D], qui peut tre vue comme une gnralisation de lentropie

dfinie par Gibbs en mcanique statistique classique (voir ci-aprs), reste constante si D

suit une volution Hamilto-nienne (quation de Liouville-von Neumann). Cest aussi grce

lutilisation dune approximation (ici, lhypothse des phases alatoires) que la question

de linterprtation mcanique de lirrversibilit thermodynamique a t rsolue par Pauli

dans le cadre quantique.

Philosophia Scienti, 11-2 | 2007

Physique, information statistique et complexit algorithmique

22

23

Lhypothse des phases alatoires propose par Pauli [Pauli 1928] peut tre considre

comme la rplique quantique de lhypothse du chaos molculaire de Boltzmann. Selon

cette hypothse, qui est justifie par lexistence de perturbations extrieures incontrlables

subies par le systme, les relations de phase entre ses micro-tats possibles sont rparties de

faon alatoire et sont alors trs rapidement dtruites, en des temps trs petits lchelle des

temps dvolution macroscopique. Cette hypothse permet de substituer loprateur densit

D exact , soumis lvolution Hamiltonienne (quation de Liouville-von Neumann),

un oprateur densit approch Ddiag pour lequel les termes non-diagonaux de la matrice

reprsentant D dans une certaine base (de relevance) sont gomms. Loprateur approch

vrifie alors une quation matresse Markovienne (lquation de Pauli) du mme genre que

celle obtenue par Boltzmann dans le cadre de la mcanique statistique classique.

Pour notre propos qui est de prciser le concept d information utilis en physique et

den dvoiler ses limites, un premier commentaire simpose cet endroit. Lvolution dun

systme vers son tat dquilibre thermodynamique, quil soit modlis par lquation de

Boltzmann ou celle de Pauli a t, aprs coup, dcrite en termes dinformation ou mme de

mmoire. Par exemple, le thorme H de Boltzmann sinterprterait comme un transfert

continu d information des fonctions de rpartitions une particule vers les corrlations

cres chacune des collisions [Balian 2005, 21]. Dans le mme esprit, nous pouvons lire

que lors de son volution vers son tat dquilibre, le systme macroscopique perd la

mmoire de ses tats microscopiques antrieurs au bout dun temps t trs court par rapport

lchelle de temps caractristique de son volution macroscopique [Diu et al. 1989, 597].

Cependant, quel est exactement le statut des notions d information et de mmoire

utilises par ces auteurs (et par bien dautres encore) pour dcrire lvolution spontane dun

systme vers son tat dquilibre thermodynamique? Sagit-il vraiment dune information

pouvant tre attribue de faon intrinsque au systme physiqueet de mme pour la notion

de mmoire, et, si oui, comment? Ou bien faut-il, comme cest gnralement le cas,

comprendre ces notions de faon subjective en faisant rfrence un observateur impersonnel

qui disposerait ou non de cette information-connaissance? Malheureusement, il semblerait

que ce soit la deuxime option qui ait t choisie par les physiciens jusqu trs rcemment. Le

concept dinformation renvoie, chez ces auteurs, une notion dobservateur susceptible

dacqurir ou non cette information et cest mme ce critre l qui dfinit la relevance

dune telle information-connaisance. Les observables relevantes sont, en effet, dfinies

comme celles qui peuvent tre mesures ou contrles par ce mme observateur alors que

lentropie relevante correspondante value le manque dinformation(-connaissance) sur

ltat microscopique du systme compte tenu du fait que ne peuvent tre observes ou

contrles que cet ensemble de variables macroscopiques relevantes [Balian 2005]5. En

outre, cette drive subjectiviste est amplifie dans les autres propositions rapportes ci-aprs,

qui sont tout aussi incontournables que les prcdentes, puisque celles-ci font explicitement

appel ce que connat ou ne connat pas lobservateur ou lexprimentateur du systme

physique considr.

I.3. Lhypothse du coarse-graining [Gibbs 1902]

24

Lentropie dfinie par Boltzmann, laide de la densit une particule, ne prenant pas

en compte les interactions entre les composants du fluide (sauf au moment des chocs),

elle ne convient donc que pour des gaz parfaits et non pas pour des fluides rels [Jaynes

1965]. Cest ce qui avait amen Gibbs considrer une dfinition plus gnrale de lentropie

thermodynamique utilisant la densit en phase (p(N), q(N), t) dans lespace des phases 6N

dimensions, o la fonction H est alors dfinie, pour un gaz N particules, par:

o p(N)=p1, , pN et q(N)=q1, , qN sont les coordonnes des N particules dans q(N),, alors que

d est llment de volume de autour du point de coordonnes (p(N), q(N)).

Notons que lentropie de Gibbs:

Philosophia Scienti, 11-2 | 2007

Physique, information statistique et complexit algorithmique

SGibbs=kBHGibbs (2)

25

est obtenu partir de lexpression quantique de lentropie (1) par passage la limite: lorsque

laction caractristique du systme trs grande devant h, la constante de Planck, les oprateurs

impulsion et position sont remplacs par des variables relles (coordonnes de point de ), les

observables deviennent des fonctions de ces variables et lopration trace se rduit bien une

intgrale de volume sur lespace des phases .

Comme ctait le cas pour lentropie de von Neumann, lors de lvolution Hamiltonienne

(classique) rgie par lquation de Liouville, lentropie SGibbs reste constante. Pour interprter

la croissance monotone de lentropie thermodynamique jusqu ltat dquilibre, Gibbs

a introduit lhypothse de dcoupage grossier de lespace des phases, dite de coarsegraining [Gibbs 1902, chapXII]:

(CG) Lespace est dcoup en petits lments de volume vj pour lesquels la prcision de nos

observations ne permet pas de distinguer entre deux de leurs points.

26

La distribution approche cg est donc obtenue par moyennage de la densit exacte sur

chacun des vj, si le point reprsentatif du systme se trouve dans vj. Cette densit coarsegrained approximative vrifie une quation cintique Markovienne qui traduit ici de faon

explicite le processus de perte progressive dinformation-connaissance de lexprimentateur

(ou de lobservateur) sur ltat microscopique du systme, perte dinformation qui est due

au caractre limit de la prcision de ses observations. Lentropie correspondante ScgGibb, qui

est, comme SGibbs, maximise par les distributions dquilibre micro-canoniques, canoniques et

grand-canoniques, est bien, en effet, une fonction non dcroissante du temps.

I.4. Lhypothse dimprvisibilit de lvolution

27

28

Signalons enfin, pour terminer cette brve revue, un procd dun autre type qui a t

utilis pour tablir un pont entre mcanique statistique et thermodynamique et qui repose

aussi de faon explicite sur le concept dinformation-connaissance. Ce procd est bas

sur lide que lirrversibilit thermodynamique traduirait notre manque de connaissance de

lvolution effectivement suivie par un systme physique et non sur lutilisation dune densit

en phase ou dun oprateur densit approximatif (relevant), comme dans les propositions

prcdentes. Cette incertitude ou absence de prvisibilit de lvolution fait appel ce que

lon pourrait appeler l hypothse de lHamiltonien mal connu qui permet dintroduire

un lment de stochasticit dans lvolution dynamique [Jaynes 1957] [Balian, 1982]. On

suppose, en effet, que plusieurs volutions sont possibles pour le systme physique considr,

volutions qui dpendent de la valeur du terme perturbatif Hj , pondr par la probabilit

pj, dans lHamiltonien Hj = H + Hj relatif lvolution j. Pour chacune des volutions

j, loprateur densit du systme est rgi par la loi dvolution Hamiltonienne et suit donc

une volution conservative, cest--dire que lentropie statistique SVN dfinie par lexpression

(1) ci-dessus reste constante, cest--dire que SVN [Dj (t)] = SVN [D(0)]. Cependant, par la

proprit de concavit de lentropie statistique [Balian 1982], loprateur densit rsultant de

cet ensemble dvolutions possibles, qui doit tre calcul t comme la moyenne pondre

par les probabilits pj des oprateurs Dj(t), suit une volution dissipative. Lhypothse de

lHamiltonien mal connu permet ainsi dtablir la croissance monotone de lentropie

quantique jusqu sa valeur maximale (dquilibre).

Dautre part, Prigogine et ses collaborateurs ont propos une modification des lois

Hamiltoniennes de faon y incorporer la sensibilit de certains systmes dit mlangeants

aux conditions initiales, systmes considrs alors comme tant intrinsquement instables

[Prigogine 1980]. Cependant, bien que cette proposition soit fonde sur la limitation de notre

connaissance des conditions initiales (mme si cest de faon plutt cache) et non sur celle de

lHamiltonien, elle revient en fait interprter lirrversibilit selon lide prsente ci-dessus

dimprvisibilit de lvolution due un manque dinformation-connaissance (ici, ce manque

dinformation concerne les conditions initiales et non lHamiltonien).

Philosophia Scienti, 11-2 | 2007

Physique, information statistique et complexit algorithmique

II. Lintroduction du concept dinformation statistique en

physique

29

30

31

32

33

Cest ici que lon a franchi un pas supplmentaire dcisif (et souvent accept sans discussion).

On ne sest pas seulement content dintroduire, de faon souvent implicite, des considrations

relatives l information dont nous disposons sur ltat microscopique dun systme

pour expliquer la croissance monotone de lentropie thermodynamique que ce soit en

utilisant lhypothse du chaos molculaire, un concept de coarse graining, en dfinissant

plus gnralement une densit dtat ou un oprateur densit relevant(e) , ou mme

en voquant un manque de prvisibilit de lvolution. Les dfinitions statistiques de

lentropie thermodynamique propose par Boltzmann, Gibbs et von Neumann, qui sont

pleinement justifie par la taille macroscopique des systmes considrs, ont t exploites

plus radicalement encore : par une interprtation sub-jectiviste du concept de probabilit

inhrent ces dfinitions, certains ont propos une pure et simple identification de la notion

dentropie thermodynamique avec celle d entropie statistique issue de la thorie de

la communication de Shannon et Weaver [Shannon & Weaver 1948] et applique au

contexte physique dont il est question. C est--dire quils ont propos lide selon laquelle

lentropie thermodynamique dun systme physique ne serait finalement quune mesure de

notre ignorance de son tat microscopique.

Prcisons ce point essentiel. Lentropie statistique, quil vaudrait mieux appeler manque

dinformation-connaissance pour la distinguer a priori des interprtations donnes par

Boltzmann, Gibbs ou von Neumann de lentropie thermodynamique dans le cadre de la

mcanique statistique, est dfinie de la faon suivante : pour un ensemble dvnements

possibles E={e1 ..., ej, ..., en} pouvant survenir avec des probabilits p1, ..., pj, ..., pn, lentropie

statistique Sstat(E) de lensemble E, qui value linformation manquante sur cet ensemble (ou

la quantit dinformation moyenne qui peut tre acquise lors de lobservation que lun de ces

vnements se ralise), est dfinie par:

o K est un facteur multiplicatif choisi selon lunit dinformation adopte.

En thorie de la communication, Sstat(E) sinterprte comme lincertitude sur lensemble de

tous les messages j qui peuvent tre reus. On choisit K=1 avec des logarithmes en base 2 de

faon dire que la quantit dinformation obtenue par un tirage pile ou face (quiprobable)

est de 1bit (ou binary digit), ce qui dfinit lunit dinformation. Avec ce choix, la quantit

dinformation associe un message de n caractres crit dans un langage binaire est de

nbits. En physique statistique, il suffit de choisir K=kB, la constante de Boltzmann, et des

logarithmes npriens pour tablir une parfaite identification formelle avec la dfinition de

lentropie propose par Gibbs en physique classique (expression (2)) ou von Neumann en

physique quantique (expression(1)).

En fait, une remarque importante simpose ici : afin dappliquer ce dernier concept

dinformation statistique au domaine de la physique quantique, il faut dfinir lensemble des

vnements de mesure qui sont susceptibles de nous informer sur ltat dun systme et non

sur un tat modifi (rduit) par ces mesures. Il ne faut donc sintresser qu des mesures

dobservables qui commutent avec loprateur densit D reprsentatif de cet tat6. Moyennant

ce choix, lobservation des diffrents rsultats possibles de la mesure dune telle observable

dcrit un ensemble dvnements (exclusifs) nous informant sur ltat microscopique du

systme et linformation statistique (3) associe cette distribution dvnements scrit alors

comme lentropie quantique (1) de ce mme tat (et donc comme sa limite classique (2)

introduite par Gibbs).

Cette analogie formelle entre entropie thermodynamique (classique ou quantique), dfinie dans

le cadre de la mcanique statistique, et entropie statistique, dfinie dans le cadre de la

thorie de la communication, a conduit trop rapidement une pure et simple identification

conceptuelle de la notion dentropie thermodynamique avec celle de manque dinformation-

Philosophia Scienti, 11-2 | 2007

Physique, information statistique et complexit algorithmique

34

35

connaissance. En effet, selon ce point de vue, lentropie thermodynamique dun systme

physique se rduiraient ntre quune valuation purement subjective de notre connaissance

de son tat microscopique. Et, par consquent, le second principe de la thermodynamique, au

lieu de rgir lvolution intrinsque dun systme physique, ne traduirait que lvolution de

notre connaissance des dtails fins de ce systme.

Les succs de la mcanique statistique ne sont plus dmontrer puis-qu elle permet

dinterprter la notion dentropie thermodynamique, de calculer les distributions dquilibre et,

plus gnralement, de retrouver la thermodynamique laide de rgles de correspondance

adquates [Balian 1982, chap. 5]. Cependant, lidentification de la dfinition statistique de

lentropie thermodynamique, donne par Boltzmann, Gibbs ou von Neumann (rappeles dans

la section I), l entropie statistique la Shannon, comme mesure de linformationconnaissance manquante, semble constituer une sur-interprtation qui nest pas ncessaire.

Cette drive subjectiviste est bien sr lie linterprtation subjective de la notion de

probabilit inhrente la description statistique des systmes physiques qui est faite en

mcanique statistique. En effet, en mcanique statistique (classique) les tats microscopiques

possibles dun systme physique forment un continuum dans lespace des phases qui lui

est associ, tandis que son tat macroscopique est dfini par la donne dune densit de

probabilit ), w(p(N), q(N), t) dans cet espace, densit partir de laquelle peuvent tre dfinies les

fonctions de distribution des particules7. Mais les probabilits de la mcanique statistique

mesurent tout dabord des rapports entre des nombres de configurations (ou de microtats)

physiques, et linterprtation de la dfinition statistique de lentropie thermodynamique en

terme dinformation manquante, cest--dire selon la formule de Shannon, ne simpose pas du

tout! Par exemple, la probabilit doccurrence dun micro-tat caractris par les valeurs

p0 et q0, d3p et d3q prs, est dfinie comme le rapport du nombre de microtats physiques

possibles satisfaisant ces conditions sur le nombre total de micro-tats accessibles, cest-dire compatibles avec les contraintes macroscopiques. Il serait, par consquent, beaucoup plus

pertinent (et aussi plus conforme lide des pres fondateurs de la mcanique statistique)

de relier la notion dentropie thermodynamique la structure ou lorganisation intrinsque

des systmes physiques considrs, et non notre manque de connaissance de leur micro-tat.

En outre, comme nous allons le voir dans la sectionsuivante, linterprtation subjectiviste de

la notion dentropie thermodynamique mne certaines confusions et trouve rapidement ses

limites.

Enfin, comme nous le montrerons aussi, lutilisation exclusive du concept statistique

dinformation rencontre trs vite dimportantes limitations en physique quantique. Par

exemple, elle ne peut servir dfinir le contenu informationnel dun tat quantique pur

et, en particulier, dun tat intriqu.

III. Critiques de lutilisation de la notion dinformation

statistique en physique

III. 1. Subjectivit de lentropie thermodynamique: une source de

confusion

36

Les interprtations de la notion dentropie thermodynamique en terme dinformation

statistique se rfrent une notion dobservateur puisquelles valuent son ignorance

des dtails fins du systme. Ce sont donc des mesures de linformation-connaissance

dont dispose (ou non) lobservateur sur le systme et non des grandeurs qui pourraient

tre associes de faon intrinsque ce dernier. Comment lentropie thermodynamique,

qui est dfinie en thermodynamique partir des paramtres physiques macroscopiques

intrinsques dun systme (volume, nergie, temprature, nombre de particules), pourraitelle, paradoxalement, se rduire ntre quune grandeur purement subjective dont la valeur

dpend de ce que sait ou ne sait pas lobservateur? Doit-on accepter lide selon laquelle

lvolution dun systme vers son tat dquilibre thermodynamique dpendrait de ce que lon

sait ou non de son tat microscopique?

Philosophia Scienti, 11-2 | 2007

Physique, information statistique et complexit algorithmique

37

38

39

40

Cette identification entre entropie thermodynamique et entropie statistique conduit,

en outre, certaines conclusions trs critiquables. Il sagit de lide, avance par Szilard,

Brillouin ou Costa de Beauregard, dun cot entropique de linformation , ide selon

laquelle toute acquisition dinformation se payerait par une augmentation dentropie

ce qui permettrait ainsi de rsoudre le paradoxe du dmon de Maxwell [Szillard 1929]

[Brillouin 1956] [Costa de Beauregard 1963]. Rappelons que le dmon de Maxwell est

un tre intelligent microscopique qui serait capable de mettre en dfaut le second principe

de la thermodynamique en diminuant lentropie dun systme isol grce linformation

quil acquiert sur ses composants microscopiques. Selon la version originale imagin par

Maxwell [Maxwell 1871], le systme est une enceinte contenant un gaz et spare en deux

compartiments C et D par une cloison munie dune porte microscopique. Le dmon ouvrirait

alors la porte aux molcules de D qui se dirigent vers C et la fermerait aux molcules

de C qui veulent schapper. Ce qui augmenterait lnergie interne du compartiment C

et diminuerait celle du compartiment D, entranant, par consquent, une diminution de

lentropie thermodynamique du systme8. Lintroduction dun cot entropique de lacquisition

dinformation permettrait alors, selon Szillard et Brillouin, de rsoudre ce paradoxe en

compensant la diminution dentropie du systme due au travail du dmon. Par exemple, ce

cot entropique se traduirait par le rchauffement du gaz conscutif lutilisation par le dmon

dune lampe-torche pour voir les molcules afin de dterminer leur direction et ainsi de

les rpartir dans les compartiments C ou D.

Mais cette dernire conclusion a tout dabord t remise en question par Landauer et Bennett:

selon ces auteurs, ce serait la destruction dinformation (permettant la r-initialisation de la

mmoire du dmon avant chaque nouveau cycle) qui a un cot thermodynamique et non son

acquisition qui peut tre, elle, rendue rversible. Plus prcisment, selon le principe de

Landauer, la destruction d1bit dinformation la temprature T causerait une dissipation

dnergie minimum de kBT ln 2, et donc une augmentation dentropie correspondante de

kBln2 [Landauer 1961] [Bennett 1988]. Car, selon Landauer, la destruction dtats logiques au

cours dun calcul (irrversibilit logique) saccompagne ncessairement dune augmentation

du nombre dtats physiques de lenvironnement afin de compenser la compression des

tats physiques correspondant aux tats logiques dtruits. A dfaut, toujours selon cet

auteur, ce calcul saccompagnerait dune diminution de lentropie thermodynamique qui

constitue (selon linterprtation statistique quen a donne Boltzmann) une mesure du nombre

dtats physiques accessibles. Or cette diminution est interdite par le second principe de la

thermodynamique.

Comme nous lavons signal dans lintroduction, les discussions passionnes autour du

paradoxe du dmon de Maxwell ont t rassembles dans le livre de Leff et Rex [Leff &

Rex 2003]. Notons simplement ici, pour illustrer lampleur de ce dbat, que le principe

de Landauer a incit certains auteurs, comme Zurek ou Li et Vitanyi [Zurek 1989] [Li &

Vitnyi 1993, section 8.4], proposer une notion alternative dentropie thermodynamique

qui prend explicitement en compte le contenu de la mmoire de lobservateur. En effet, ces

auteurs ont propos une notion d entropie physique (ou d entropie algorithmique

pour Li et Vita-nyi) comme la somme de lentropie statistique (dont la variation mesure

linformation-connaissance tire des observations) et de la place-mmoire ncessaire pour

encoder dans la mmoire du dmon les donnes acquises par ces mmes observations (cet

emplacement mmoire est valu en terme de complexit algorithmiquedont la dfinition

est donne la section suivante). Ces auteurs montent que cest partir de cette notion

dentropie physique (ou algorithmique) et non de la seule entropie statistique que doit

tre calcul le travail utile que le dmon peut extraire de ses observations (et, corrlativement,

laccroissement de la quantit de chaleur du systme global).

Cependant, plus rcemment, il semble que le principe de Landauer ait aussi t remis en

question. Norton a tout dabord remarqu que ce principe ne peut exorciser le dmon de

Maxwell que dans certains cas [Norton 2005]. Dans son article, Norton conoit par exemple

une machine cyberntique qui ferait le travail du dmon sans procder ncessairement

leffacement de sa mmoire. Ce qui a men Bennett proposer une version plus gnrale

Philosophia Scienti, 11-2 | 2007

10

Physique, information statistique et complexit algorithmique

41

42

43

du principe de Landauer, selon laquelle ce serait toute opration de fusion de chemins

computationels , se traduisant par une rduction dtats logiques au mme titre que

leffacement de la mmoire, qui aurait un cot entropique. [Bennett 2003]

Mais plus fondamentalement, Norton et Shenker doutent que le principe de Landauer ou sa

gnralisation puissent vraiment exorciser le dmon de Maxwell car les justifications qui sont

gnralement donnes ce principe qui associe la compression dtats logiques avec celle

dtats physiques utiliserait de faon illicite la notion densembles statistiques [Norton 2005]

[Shenker 2000]. Pour montrer ce point, Norton reprend lillustration que font Leff et Rex du

principe de Landauer9, o ils modlisent la mmoire du dmon comme une bote contenant

une seule molcule et place en contact avec un thermostat temprature T. Cette bote est

spare en deux compartiments par une cloison amovible et la position de cette dernire (dans

le compartiment de droite ou de gauche) dtermine alors ltat de la mmoire du dmon [Leff

& Rex 2003, 1].

Le calcul des entropies thermodynamiques de la bote (ou cellule mmoire) donn par Leff

et Rex assigne (a) la mme valeur dans le cas o la molcule peut se trouver indiffremment

dans le compartiment de droite ou celui de gauche et dans le cas o la cloison de sparation

entre les deux compartiments a t enleve puisque, selon ces auteurs, dans ce dernier cas la

molcule a toujours autant de chance de se trouver droite ou gauche (p.21)ce quil

faut comprendre comme nous ne savons pas plus dans le deuxime cas que dans le premier

o se trouve la molcule. En outre, (b) cette dernire valeur serait suprieure de kBln2

celle calcule dans le cas o la position de la molcule est dtermine, en particulier lorsque

la mmoire a t efface et r-initialise, cest--dire lorsque la molcule se trouve dans une

position dtermine (cest--dire connue), par exemple toujours gauche. Ce qui fait que la

compression dtats logiques, de la situation o la molcule peut se trouver indiffremment

droite ou gauche (o deux cases-mmoires sont ncessaires) la situation o elle se trouve

obligatoirement gauche (o une seule case-mmoire est ncessaire), se traduirait bien par

une rduction dentropie thermodynamique de la cellule-mmoire de kBln2 et donc par une

augmentation au moins gale kBln2 de lentropie de lenvironnement (ici, le rservoir la

temprature T), conformment au principe de Landauer.

Norton montre alors (section3.2) que ce calcul est tout simplement faux car (a)lenlvement

de la cloison donne en fait lieu une augmentation de lentropie thermodynamique de kBln2

puisque le volume accessible de lespace des phases est doubl lors de cette opration,

alors que (b)lentropie thermodynamique est la mme que lon sache ou non o se trouve

la molcule dans le cas o la bote est spare en deux compartiments, et en particulier

aprs effacement et r-initialisation de la mmoire, lorsque la molcule se retrouve dans

le compartiment de gauche. Norton prcise alors que (l)entropie thermodynamique est

une proprit de la cellule et de son tat physique; elle nest pas affecte par notre faon

dimaginer larrangement des cellules entre elles [Norton 2005, 20]. La raison de cette

erreur est, selon Norton, une utilisation illicite de la notion densembles canoniques chez Leff

et Rex. En effet, la collection de cellules-mmoire pour laquelle est dfinie la probabilit

doccurrence de la molcule dans lun ou lautre des deux compartiments est considre, par

Leff et Rex, comme un ensemble canonique au mme titre que lest, en mcanique statistique,

une collection de systme similaires placs dans le mme tat macroscopique et qui sont donc

caractriss par la mme fonction de distribution de lnergiece qui donne, en effet, un sens

physique lexpression de la probabilit canonique [Norton

p(x)=exp(E(x)/kBT)/Z,

o E(x) est lnergie du systme au point de coordonnes gnralises (dans lespace des

phases relatif au systme considr)

x=(x1, x2, , xn),

alors que Z est la fonction de partition canonique qui se dfinit aussi laide de lunique

fonction E(x). Or, dans lexemple de Leff et Rex repris par Norton, les cellules-mmoire ont

des fonctions nergie diffrentes selon la position de la molcule: si la molcule se trouve

Philosophia Scienti, 11-2 | 2007

11

Physique, information statistique et complexit algorithmique

44

45

46

droite, lnergie est finie dans la partie droite de lespace des phases relatif cette collection et

infinie gauche, de faon ce que sa probabilit de prsence sannule; et dans lautre cas cest

le contraire qui est vrai. La collection de cellules-mmoire constitu par un mme nombre de

cellules avec la molcule droite ou gauche ne peut donc dfinir un ensemble canonique au

sens de la mcanique statistique [Norton 2005, 18].

De faon plus directe, nous pouvons dire que la notion d entropie utilise chez les

dfenseurs du principe de Landauer, et en particulier dans lillustration donne par Leff et Rex,

mesure un manque dinformation-connaissance partir de probabilits subjectivescomme

nous pouvons le constater dans largumentation de Leff et Rex (points (a) et (b) ci-dessus).

Or, ces probabilits subjectives ne peuvent, en aucun cas, tre identifies aux probabilits

physiques de la mcanique statistique qui valuent, elles, des rapports entre nombres de

configurations physiques accessibles, ces dernires servant dfinir les ensembles statistiques

de la mcanique statistique. Comme le montre Norton, lutilisation densembles statistiques

est donc bien illicite dans ce cas.

Bien que le dbat sur le paradoxe du dmon de Maxwell ne soit peut-tre pas dfinitivement

clos aujourdhui, ce que lon peut affirmer est que sa rsolution, propose initialement par

Szillard puis reformule ensuite par Landauer et Bennett en termes de cot entropique de

leffacement de la mmoire, est srieusement remise en cause aujourdhui. L ide dune

quivalence, quelle soit directe ou non, entre nguentropie et information-connaissance

ne peut plus tre soutenue: soit sa justification est base sur des exemples particuliers qui

contiennent dj une tape thermodynamiquement irrversible [Norton 2005, sectionII.3], soit

elle utilise de faon illicite la notion densemble statistique, en identifiant implicitement les

probabilits introduites par Boltzmann ou Gibbs en mcanique statistique des probabilits

subjectives.

Cette remise en question des solutions proposes au paradoxe du dmon de Maxwell sur la base

dune suppose identification entre entropie thermodynamique et manque dinformationconnaissance semble donc confirmer les doutes formuls au dbut de cette section : il est

difficile de croire que lentropie thermodynamique, qui est dfinie partir des paramtres

physiques macroscopiques intrinsques dun systme (volume, nergie, nombre de particules,

temprature... ), pourrait se rduire ntre quune grandeur purement subjective dont la valeur

dpend de ce que sait ou ne sait pas lobservateur. Lide selon laquelle lvolution dun

systme vers son tat dquilibre thermodynamique dpendrait de ce que lon sait ou non de

son tat microscopique semblerait relever en fin de compte dune conception plutt nave de

notre relation au monde physique.

III. 2. Critiques plus techniques

47

III. 2. 1. La rfrence la notion de mesure est problmatique

Linformation statistique Sstat dfinie par lexpression(3) mesure linformation-connaissance

moyenne qui peut tre acquise lors de lobservation que lun des vnements de lensemble

E des vnements possibles se ralise. Cette notion fait donc rfrence une notion

d observation (ou de rception dun message dans le contexte de la thorie de

la communication o cette dfinition a t propose), sans laquelle sa dfinition naurait

dailleurs aucun sens. Ceci a une consquence fcheuse pour sa contrepartie formelle en

physique quantique, lentropie SVN dun oprateur (rappele dans la section I). En effet,

lentropie SVN dun oprateur densit D:

peut bien scrire sous la forme dune entropie statistique:

o les probabilits pj sont les valeurs propres de D:

48

Mais ce nest que dans le cas dobservables qui commutent avec D , du type:

Philosophia Scienti, 11-2 | 2007

12

Physique, information statistique et complexit algorithmique

49

que les probabilits dobtention des rsultats possibles bj sont gales aux pj . Ce nest, en effet,

que dans ce cas (mesure non perturbative) que la mesure de B va nous renseigner sur ltat D

et non un tat rduit. Par consquent, SVN[D] nvalue que lincertitude relative la mesure

dobservables qui commutent avec D et non lincertitude relative la mesure de nimporte

quelle observable.

Dailleurs, si lon considre la mesure (complte) dune observable B qui ne commute pas

avec D, le gain moyen dinformation serait paradoxalement plus grand que linformation

manquante SVN[D] avant la mesure! En effet, dans ce cas la mesure de B ne nous informe

pas sur ltat initial D du systme mais sur un tat tronqu (rduit) D'=jPjDPj, o les

Pj sont les projecteurs sur les sous-espaces associs aux rsultats possibles bj de la mesure de

B, et on montre que [Balian 1982, 105]:

SVN[D']>SVN[D].

50

51

Par consquent, lentropie SVN dun oprateur donne par von Neumann en physique quantique,

dont la dfinition se rfre, comme celle de Sstat, une notion dobservation ou de mesure, ne

peut, en outre, valuer que lincertitude relative la mesure des observables qui commutent

avec cet oprateur. Son utilisation nest donc justifie que relativement cette dernire classe

dobservable.

III. 2. 2. Quelle mesure pour linformation quantique?

Lentropie SVN dun oprateur densit, comme l entropie statistique Sstat est dfinie

ngativement , comme une incertitude (ou un manque dinformation ) lie une

distribution dvnements ou dtats possibles. Ce qui a pour consquence que lentropie Sstat

dfinie par:

SVN[D]=kBTrDlnD (1)

52

53

ne mesure que le degr de puret de D mais nest pas dfinie pour un tat pur: en fait, pour

un tat pur elle est prise nulle par convention ou par construction. Elle ne peut donc, en

aucun cas, tre utilis pour valuer le contenu informationnel dun tat pur.

Il serait bien sr possible de dfinir une notion dinformation statistique pour un systme

prpar dans un tat pur en considrant lensemble des mesures que lon pourrait effectuer

sur ce systme. Cette grandeur, appele par Pomeransky entropie informationnelle [Pomeransky 2004], value la quantit moyenne dinformation-connaissance que lon pourrait

obtenir en effectuant ces mesures. Mais, comme nous lavons remarqu ci-dessus, la rfrence

une notion de mesure nest pas satisfaisante puisqu une mesure ne fournit en gnral

quune information trs partielle dun tat quantique (celle de ltat rduit)10. Et le fait

de considrer un ensemble de mesures possibles ne permet pas plus de dfinir une grandeur

intrinsque cet tat purmais seulement une grandeur relative ces mesures.

En particulier, il faudrait pouvoir valuer le contenu informationnel dun tat intriqu

qui joue un rle fondamental dans les phnomnes typiquement quantiques (corrlations

EPR) et qui constitue une ressource essentielle pour la ralisation de diverses tches

spcifiquement quantiques, comme le codage superdense, la tlportation quantique, la

cryptographie quantique ou le calcul effectu par un ordinateur quantique [Nielsen 1998]

[Delahaye 2002] [Le Bellac 2005]. Une proposition a bien t faite par Everett (et confirme

par la suite) pour valuer une information de corrlation ou information mutuelle de

deux observables dfinies, respectivement, sur deux parties d un systme prpar dans un

tat pur [Everett 1973] [Schumacher 1990, 33-34]. Mais, comme son nom lindique, cette

information de corrlation value le degr de corrlation entre deux observables, en terme

de quantit moyenne dinformation-connaissance que peut apporter la mesure de lune des

deux observables sur la distribution des valeurs possible de lautre. Par consquent, comme

ctait le cas ci-dessus pour lentropie informationnelle de Pomeransky, linformation de

corrlation renvoie une notion de mesure (ou dobservable) et ne peut donc constituer une

Philosophia Scienti, 11-2 | 2007

13

Physique, information statistique et complexit algorithmique

54

valuation satisfaisante de linformation dintrication caractristique dun tat quantique pur.

Cette information dintrication qui est utilise comme ressource et qui est manipule dans

les diffrentes applications de la thorie de l information quantique devrait tre considre

comme une entit part entire, dfinie indpendamment des observables quil serait possible

ou non de mesurer sur un systme physique prpar dans cet tat.

Les critiques prcdentes suggrent donc quil faudrait dfinir une mesure individuelle de

linformation encode dans un tat quantique qui ne soit pas de nature statistique (pas

dutilisation des probabilits) et qui ne soit pas relative certaines variables relevantes que

lon pourrait mesurer ou contrler. Cest--dire une information structurelle qui caractrise

de faon intrinsque ltat d un systme physique individuel. Ce qui permettrait, par la

mme occasion, de surmonter les difficults conceptuelles (subjectivisme) dues lutilisation

exclusive dun concept dinformation-connaissance pour dfinir l entropie physique.

IV. La notion de complexit algorithmique [Solomonoff

1964] [Kolmogorov 1965] [Chaitin 1977] [Li & Vitnyi 1993]

IV. 1 Complexit algorithmique dune suite binaire

55

56

57

58

59

Si sest une suite de symboles d un langage binaire (ne contenant, par exemple, que 0 et 1),

la complexit algorithmique k(s) dune suite sest la longueur du plus petit programme autodlimit d ordinateur (machine de Turing universelle) capable de produire la suite s.11

La longueur dun programme est mesure en binary digits (bits classiques ). Par

ailleurs, le programme est dit auto-dlimit car il contient linformation relative sa

taille, ce qui permet larrt de la machine de Turing universelle lorsque le programme est lu.

Cette condition, qui permet une lecture (unique et) instantane dun programme, joue un

rle important dans la dmonstration de la double ingalit fondamentale liant la notion de

complexit algorithmique celle dinformation statistique qui sera introduite et utilise dans

les sectionssuivantes.

La complexit algorithmique dune suite est une mesure de son contenu incompressible

dinformation. Par exemple, la complexit algorithmique dune suite rgulire, comme

10101010101010101010, qui peut tre engendre par le programme simple crire 10 fois

10, est plus petite que la complexit algorithmique de la suite moins rgulire de mme

longueur 10011010001100000111. La notion de complexit algorithmique capture donc

la diffrence intuitive entre suite rgulire pouvant tre engendre par un programme court

et suite purement alatoire qui ne peut tre engendre que par elle-mme12.

Ce qui est essentiel pour notre propos est que la notion de complexit algorithmique ne fait

pas appel aux probabilits, contrairement celle dinformation statistique, et, en outre, ne se

rfre pas une quelconque notion de mesure ou dobservation. Elle nest pas une valuation

de linformation-connaissance qui pourrait tre obtenue par lobservation dun vnement

pris dans un ensemble dvnements possibles (ici, ce serait lobtention dune suite parmi un

ensemble de suites possibles). La complexit algorithmique value linformation structurelle

pouvant tre associe de faon intrinsque une suite binaire et donc nimporte quelle entit

pouvant tre dcrite laide dune suite binairecomme, par exemple, ltat dun systme

physique (voir ci-aprs les sectionsV et VI).

Notons enfin quil est possible de dfinir les notions de complexit algorithmique jointe

(mesurant la longueur du plus petit programme capable de dcrire la concatnation de deux

suites binaires), conditionnelle (mesurant la longueur du plus petit programme capable de

dcrire une suite partir dune autre) et mutuelle (mesurant le degr de corrlation entre deux

suites).

IV. 2. Relation fondamentale liant complexit algorithmique et

information statistique

60

La thorie de linformation algorithmique permet dtablir la double ingalit fondamentale

suivante liant lentropie statistique et la complexit algorithmique [Levin 1976] [Chaitin

1977] [Zurek 1989] [Caves 1990] [Li & Vitnyi 1993]:

Philosophia Scienti, 11-2 | 2007

14

Physique, information statistique et complexit algorithmique

61

62

o E est lensemble des suites Sj associes aux probabilits doccurrence pj, Sstat(E)=jpjlog2pj

est lentropie statistique de lensemble E, exprime en units naturelles dinformations

(voir la section II), < k (sj) >E = j pj k (sj) est la valeur moyenne sur E de la taille des

programmes les plus courts qui dcrivent les suites sj; k(E) est la taille du programme le plus

court qui dcrit lensemble des suites sj et leurs probabilits doccurrence pj,et 0(1) est une

constante caractrisant la machine de Turing universelle choisie pour valuer les valeurs de k.

En particulier, pour des ensembles E dont la description peut se faire de faon concise,

cest--dire laide de quelques bits dinformation, le terme k(E) est ngligeable devant Sstat(E)

et lingalit (4) se rduit alors lgalit suivante, la constante 0(1) prs:

Cependant, mme si cette dernire hypothse (k(E)<<Sstat(E)) nest pas ralise, ce qui est le

cas gnral, il est possible dtablir une quivalence entre entropie statistique conditionnelle

et complexit algorithmique conditionnelle. En fait, une telle formulation parat plus utile

en pratique puisquon value toujours des entropies statistique partir de la donne de

lensemble des vnements possibles et de leurs probabilits respectives doccurrence. On

value lentropie statistique conditionnelle Sstat(E/) qui mesure le manque dinformation

relatif la distribution E compte tenu de linformation pralable permettant dnumrer les

suites sj et leurs probabilits doccurrence pj. Par exemple, dans le domaine de la physique,

est constitu des donnes relatives la prparation du systme et aux lments thoriques

(mcanique statistique, par exemple) permettant lnumration des tats possibles avec leur

probabilit doccurrence. Corrlativement, il faudra considrer, au lieu de la complexit

algorithmique absolue k(sj), la complexit algorithmique conditionnelle k(sj /p) dfinie

comme la longueur du plus petit programme qui calcule la suite sj partir du programme

ppermettant le calcul de lensemble E des tats possibles compte tenu de linformation

pralable . Caves a ainsi reformul la double ingalit (4) en termes dentropie statistique

et de complexit algorithmique conditionnelles et a tabli lquivalence recherche (toujours

0(1) prs), qui est plus gnrale que la relation (4) puisque lhypothse k(E)<<Sstat(E) nest

pas requise [Caves 1990, 101]:

Cette dernire relation peut tre utilise pour interprter la notion dentropie thermodynamique

en terme de complexit algorithmique.

V. Thermodynamique et complexit algorithmique

63

64

Lquivalence (4) peut tre utilise sans problme en mcanique statistique classique. Les

suites sj peuvent tre considres comme des descriptions, dans un langage binaire, des

micro-tats j accessibles, cest--dire compatibles avec les contraintes macroscopiques,

auxquelles sont associes les probabilits pj. Les micro-tats classiques dsignent, en effet,

des configurations spatio-temporelles bien dfinies (contrairement au tats quantiques purs

dont le cas est tudi dans la sectionsuivante), par exemple par la donne des positions et

quantits de mouvements des constituants du systme. Par consquent, ils peuvent tre codes,

au mme titre que nimporte quelle srie de nombres rels, laide des suites binaires finies

sj si, comme cest le cas en pratique, un certain degr fini de prcision li, dune part, au

dcoupage de lespace des phases et, dautre part, lapproximation retenue pour les rels

encoder est fix.

Ce qui permet donc, de par lanalogie formelle entre entropie statistique et entropie

thermodynamique (voir la section II), une dfinition de lentropie thermodynamique dun

systme physique prpar dans le macro-tat correspondant la distribution E={sj,p j} en

terme de complexit algorithmique:

Philosophia Scienti, 11-2 | 2007

15

Physique, information statistique et complexit algorithmique

65

66

67

68

Comme application directe de ce rsultat, citons le calcul de lentropie dun gaz parfait

lquilibre effectu par Zurek [Zurek 1989]. Dans ce cas, < k(sj/pE/) >E est la longueur

moyenne du plus petit programme qui produit lune des suites sj (relative au micro-tat j)

partir du programme pE/ qui dcrit lensemble des suites sj et la distribution de probabilit

associe compte tenu de linformation pralable sur le systme (les paramtres dfinissant le

macro-tat du systme et la thorie physique qui permet lnumration des micro-tats j et

des probabilits associes). Or, si W est le nombre de ces micro-tats, la spcification de lun

deux parmi les W possibles requiert de donner son adresse dans cet ensemble, qui est un

nombre plus petit ou gal W. Dautre part, la longueur du plus petit programme qui produit

le nombre W est de lordre de log2 W (qui est approximativement le nombre de bits quil faut

utiliser pour sa reprsentation binaire, pour W suffisamment grand)13.

Par consquent, on calcule dans ce cas (toujours en units naturelle dinformation) que:

On retrouve donc la formule introduite par Boltzmann sans faire appel la notion

dinformation statistique dfinie par lexpression (3)! laide de cette valuation on retrouve

effectivement la formule de Sackur-Tetrode donnant lentropie dun gaz parfait (classique)

lquilibre en valuant le nombre de micro-tats possibles W compatibles avec les contraintes

macroscopiques [Zurek 1989, 4736].

Par consquent, dans la mesure o cela fait sens de parler de lensemble E des microtats (classiques) possibles compatibles avec la description macroscopique du systme, la

thermodynamique peut tre base sur la notion de complexit algorithmique qui ne mesure pas

notre manque dinformation sur ltat microscopique dun systme (ni sur son Hamiltonien

ou les conditions initiales) mais linformation structurelle moyenne de ses configurations

microscopiques possibles, mme si cest une certaine prcision prs. En fait, un tel ensemble

E de micro-tats peut bien sr tre dfini ltat dquilibre thermodynamique, comme dans

lapplication ci-dessus, mais aussi ds quune description locale de ltat macroscopique dun

systme physique peut tre donne, ce qui est possible lorsqu il peut tre dcoup en

sous-systmes ( lquilibre local et) en quilibre mutuel, sous-systmes pour lesquels il est

possible de dfinir des ensembles pondrs de micro-tats tels que E, par exemple laide de

la distribution de Maxwell-Boltzmann pour chacune des parties dun gaz parfait lquilibre

local. Mais, en fait, ces conditions ne sont, ni plus ni moins, celles qui doivent tre satisfaites si

on veut donner un sens la notion dentropie thermodynamique et donc au second principe

de la thermodynamique (voir sectionI, note2). La dfinition algorithmique(5) de lentropie

thermodynamique nintroduit donc aucune contrainte supplmentaire.

Linterprtation de la notion dentropie thermodynamique en terme de complexit

algorithmique permet donc une interprtation structurelle de la notion dentropie

thermodynamique qui saccorde mieux avec celle donne initialement par Boltzmann, en

terme de dsordre molculaire [Boltzmann 1876, in Brush 1966], quavec celle, plus

tardive, donne par Jaynes ou Balian, en terme de manque d information-connaissance. Il ny

a en fait plus de confusion possible entre entropie thermodynamique dun systme physique

et manque dinformation-connaissance de son tat microscopique puisque, par sa dfinition

algorithmique (5), lentropie thermodynamique value le degr dorganisation intrinsque de

ce systme (mme si cest moyennant une certaine prcision). En outre, le second principe de la

thermodynamique acquiert une interprtation structurelle: pour un systme isol, la croissance

monotone de la valeur moyenne <k(sj/pE/)>E de la complexit algorithmique conditionnelle

des micro-tats possibles jusqu ce que soit atteint ltat dquilibre thermodynamique signifie

que la description de ltat microscopique dun systme physique requiert de plus en plus

dinformation lorsque ce systme tend vers son tat dquilibre. Ce qui se traduit ici, en terme

de complexit algorithmique, par le caractre de plus en plus alatoire (et donc de moins en

moins compressible) des suites de symboles utilises pour encoder les tats microscopiques

Philosophia Scienti, 11-2 | 2007

16

Physique, information statistique et complexit algorithmique

accessibles. Cette ide saccorde aussi avec lintuition des fondateurs de la mcanique

statistique selon laquelle ltat dquilibre (macroscopique) est le plus dsordonn.

VI. Physique quantique et complexit algorithmique

69

70

71

72

73

Nous avions not dans la sectionIV que les micro-tats classiques dun systme physique

peuvent tre considrs comme des configurations spatiales instantanes de ce systme,

descriptibles en terme de suites binaires. Cependant, nous pouvons nous demander si les

tats quantiques peuvent vraiment tre considrs comme tels. Il y a en effet un sens prcis

considrer la description de ltat microscopique dun systme physique en physique classique,

par exemple (description purement mcanique) en se donnant la position et la quantit

de mouvement de chacune des particules qui le composent. Mais, comme nous le montre

labondante littrature sur le sujet (voir, en particulier, [dEspagnat 1994, 4.3 ou chap.11] et

[Bitbol 1996]), ltat quantique d un systme ne constitue pas la simple description

dune ralit spatio-temporelle pr-existante aux mesures que lon peut faire sur ce systme.

Il ne peut, malgr certaines propositions pour interprter la thorie quantique de faon raliste

[Bohm & Hiley 1993], tre considr comme une vritable description dun systme

physique au mme titre quun tat classique, cest--dire en terme de proprits dobjets qui

seraient dfinies chaque instant. Ltat quantique doit, avant tout, tre considr comme

une entit mathmatique encodant linformation relative un contexte exprimental ou

une prparation, information permettant le calcul des prdictions relativement ce contexte

(cest un outil prdictif contextuel selon les mots de Bitbol). La notion de complexit

algorithmique peut-elle alors sappliquer aux tats quantiques?

Il est en fait possible de rpondre positivement cette question. Nous allons donc chercher

prciser comment une complexit algorithmique quantique peut tre dfinie et que celle-ci

peut tre aussi utilise, comme dans le cas classique, pour dfinir lentropie thermodynamique.

Une premire classe de propositions pour dfinir une notion de complexit algorithmique pour

un qubit14 ou une suite de qubits se rfre au travail dun ordinateur quantique, cherchant ainsi

gnraliser le dfinition classique donne la sectionIV. Dans cet ordre dides, Vitnyi

[Vitnyi 2001] dfinit la complexit algorithmique du qubit |> comme la longueur, en bits

classiques, du plus petit programme d un ordinateur quantique susceptible de produire ou

de calculer exactement un qubit approch |> de |>, qui serait, lui, calculable, tout

en prenant en compte la fidlit du calcul, cest--dire son degr dapproximation qui peut tre

valu par la quantit |<|>|2 . De leur ct, Berthiaume, van Dam et Laplante [Berthiaume

et al. 2000] proposent de considrer comme mesure de la complexit algorithmique dune suite

donne de qubits (et donc, en particulier, dun seul qubit) la longueur, mesure en qubits15, de

la plus petite entre quantique (qui est aussi une suite de qubits) dun ordinateur quantique qui

produit ou calcule la suite de qubits donne initialement (ou le qubit unique donn),

et en prenant toujours en compte la fidlit16 du calcul. La diffrence essentielle entre ces

deux approches est que Vitnyi propose une mesure de la complexit algorithmique quantique

dun qubit en bits classiques, comme mesure de la longueur dun programme classique

fonctionnant sur un ordinateur quantique, alors que Berthiaume et al. en donnent une mesure

en termes de qubits, mesurant la longueur de lentre quantique dun tel ordinateur.

Cependant, ces propositions soulvent la question essentielle suivante : que veut dire

produire ou calculer un qubit? Dans le cas classique, calculer un mico-tat dun

systme physique revenait dcrire sa configuration spatio-temporelle, par exemple en termes

des positions et quantit de mouvement de ses constituants, cest--dire dcrire ce quil est

vraiment, indpendamment de toute autre considration comme nos moyens daccs la

connaissance de cet tat. Mais, comme nous lavons remarqu ci-dessus, un tat quantique

ne peut tre considr comme tel. Il est avant tout une entit abstraite qui encode l information

relative une prparation donne et qui permet de prdire les rsultats de mesure quil serait

possible dobtenir en mesurant telle ou telle observable.

La description dun tat quantique pur pourrait-elle alors dsigner, ainsi que le suggre

aussi Vitnyi [Vitnyi 2001, 3-4], celle de ses deux coefficients complexes dans une certaine

base? Ces derniers tant dfinis laide de quatre nombres rels, il faudrait donc considrer

Philosophia Scienti, 11-2 | 2007

17

Physique, information statistique et complexit algorithmique

74

75

76

la longueur du plus petit programme qui crit ces quatre nombres rels. Or, tous les nombres

rels ne sont pas calculables17. Par contre, on peut montrer que tout nombre algbrique, qui

est racine d un polynme coefficients entiers, est calculable (alors que les autres rels,

qui sont qualifis de transcendants, comme nou e, la base des log npriens, ne le sont pas

forcment). Par consquent, il y aurait un sens parler du plus petit programme qui calcule

ou produit un tat approch |> de |> dont tous les coefficients sont calculables (cest-dire quils sont constitus par des couples de rels calculables au sens prcis dfini ici, pour

des nombres).

Mais une telle proposition, qui est intressante dun point de vue purement algorithmique, nest

pas trs significative du point de vue de la physique. Il est difficile de croire que la complexit

numrique des coefficients utiliss pour crire le vecteur reprsentatif de ltat quantique

dun systme physique nous informerait sur la complexit physique des phnomnes qui

peuvent tre observs. Comme le montre lapplication de la thorie quantique des situations

paradigmatiques, telle les phnomnes dinterfrences ou les corrlations EPR, des tats

quantiques peuvent scrire laide de nombres entiers ou rationnels, cest--dire laide de

nombres algorithmiquement simples, et donner cependant lieu des phnomnes typiquement

quantiques rvlant une grande complexit physique, cest--dire en fait dune grande richesse

informationnelle . II est donc souhaitable de dfinir autrement que selon la conception

purement numrique mentionne ici la complexit algorithmique dun tat quantique.

Ces remarques nous mnent considrer une deuxime approche18 qui se base sur lide

expose au dbut de la sectionVI, plus proche de la ralit exprimentale, ide selon laquelle

un tat quantique doit, avant tout, tre considr comme une entit mathmatique dfinie

relativement un processus de prparation donn. Selon cette conception, Mora et Briegel

proposent de dfinir la complexit algorithmique d un tat quantique de la faon suivante

[Mora & Briegel 2005]:

Ces auteurs suggrent que la complexit dun tat quantique est lie la complexit

du processus de sa prparation qui peut tre dcrit classiquement , cest--dire par

lintermdiaire dun canal de communication classique qui nutilise que de linformation

classique. Ce processus exprimental peut tre idalis comme une suite finie de portes

logiques. Les portes logiques (quantiques) formalisent les oprations lmentaires partir

desquelles peut tre gnre toute prparation, prparation qui se traduit en fin de compte par

une manipulation de qubits. Par exemple, outre les portes logiques qui modifient la phase du

qubit dentre ou qui induisent une rotation, on utilise couramment lopration de Hadamard

qui agit sur lun des qubits d une base standard (|0>,|1>) et calcule, respectivement, une

superposition linaire poids gaux ou opposs de ces vecteurs de base:

ou la porte CNOT qui change les tats |0> et |1> du qubit cible |y> dun 2-qubit de

type |x,y>, o x et y peuvent prendre les valeurs 0 ou 1, mais seulement dans le cas o le

qubit contrle, |x> , est |1>:

[Nielsen 1998].

77

Une procdure de prparation donne pour un tat quantique utilise donc une suite finie

de portes logiques d une base B donne. Pour coder le circuit ainsi dfini, nomm CB,

il faut se donner un code qui va assigner chaque circuit possible une suite de bits qui est

diffrente de celle assign aux autres circuits. Mora et Briegel dfinissent alors la complexit

Philosophia Scienti, 11-2 | 2007

18

Physique, information statistique et complexit algorithmique

algorithmique (classique) d un tat quantique |> relativement la base B, au code

et au circuit CB par [Mora & Briegel 2005, 7]:

78

79

80

81

82

83

o (CB) est le code associ au circuit CB et kcl( (CB)) dsigne la longueur du plus petit

programme, en bits classiques, capable de gnrer (CB).

Puisqu il existe gnralement plusieurs procdures pour prparer un tat quantique donn,

la complexit algorithmique de |> relativement la base B et au code sera en fait dfinie

par la valeur minimale de la quantit dfinie par lexpression (6) sur tous les circuits possibles

CB:

Une remarque importante concernant la cohrence de cette dfinition : il est possible de

montrer une proprit dinvariance par changement de code, une constante additive prs.

Plus prcisment, pour deux codes et la diffrence de complexit dfinie ainsi est une

constante ne dpendant que de et [Mora & Briegel 2005, 7-8].

Enfin, la dfinition ci-dessus suppose, idalement, que ltat |> peut tre prpar exactement

partir dun circuit CB. Dans le cas gnral, les circuits utiliss permettent la prparation de

| > une certaine prcision . Par consquent, plus gnralement encore, la complexit

algorithmique de ltat quantique | > relativement la base B, au code et au paramtre

de prcision est dfinie par:

o CB(|>) est le circuit qui prpare |> avec la prcision .

La dpendance de la dfinition ci-dessus par rapport la base B pourrait faire croire que

le circuit le plus court servant prparer un tat quantique donn peut toujours tre rendu

aussi simple que lon veut en choisissant correctement la base B, ce qui ferait perdre cette

dfinition beaucoup de son intrt. En fait, comme le montrent Mora et Briegel, il nen est