Académique Documents

Professionnel Documents

Culture Documents

Adobe Scan Jan 16, 2023

Transféré par

Imane LOUKILICopyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Adobe Scan Jan 16, 2023

Transféré par

Imane LOUKILIDroits d'auteur :

Formats disponibles

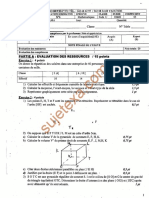

ENSET DE M OHAMMEDIA

GLSlD & IIBDCC - 3"111" annee

Examen final en Jngenierie decisio1melle - duree JH30

Exercice I : (7 points)

1. Quelles sont Jes principales faiblesses d'un perceptron ?

2. C'est quoi le role de la fonction d'activation dans un neurone ?

3. Pour le cas des arbres de decision, a quel moment peut-on parler de overfitting (surapprentissage) ? comment

peut on remedier ce probleme?

4. Decrire puis ecrire l'algorithme de K-means.

S. Donner un reseau de neurones d'apprentissage non supervise. Decrire le.

6. Est-ce qu'on peut parler de sur-apprentissage des modeles d'apprentissage non supervise? donner un exemple.

Exercice 2: (6 points)

On considere I' echantillon suivant :

No TO Tl T2 T3 Classe

1 1 () V N A

2 l l V I A

3 1 0 F 01 B I

4 2 I V N A

,:; ') I V n A

6 2 l F N A

7 2 0 F 0 B

8 2 0 V I A

9 1 0 F N B .

10 1 1 \l I B

1l ') 1 l:;' () A

12 2 I F I A

13 - · - ••I ·•·· - ..0 -V 0 B

1. Soit l'ensemble d'apprentissage constitue des exemples {l ,. ., 9 }. Construire l'arbre de

decision.

2. Classer Jes exemples de test

Exercice 3 : (7 points)

Soit le schema suivant qui represente un neurone :

l) En fonction des donnees montrees sur le schema, donner Jes expressions nume-riques qu'il faut puis

calculer la sortie correspondante

2) Calculer Loss trouvee dans la sortie sachant que le resultat attendu est )=O. 1

•

3) Eu se basant sur l'algvrithme de bacr(propagaiion

1 L • 1

et c,,airuuJ ' .

e, ecnre 1•'express1on

. ue...1 ac._n.u

owl

4) A partir de 3), ecrire )' expression numerique de ill.ass

owl

Les calculs et fonnules suivants peuv ent vous servir:

1 iJpredi ct ed == __ 1_ (l - _ _1_}' Los s ==

1 2

predicted= f(s) = 1 + e-s iJs 1 + e-s 1 + e-s 2 (desired - predicted)

Pro_fessem· Z. EN-NAJMA.1VJ Page J/2

ENSE T DE MOl-!A MMED IA

I

1,.''a211 e 1=2.7I

-j

Rappel de Chain rule:

c;

....,, on, a TII -- Flu

I(t / I ot " - ,!:1(A

'- &,Irrlv) alors

- 'I, dy dy du

- = -1"-

dx du dx

5) Queile est la difference entre un parametre et un hyperpa rametre

dans l'algori thme de gradient

descent

6) En se basant sur !es reponses des questions precedentes, ecrire l'algori

thme de gradient descent pour

trouver !es poids qui minimisent la fonction Loss

7) En deux itcrnti0ns de l'algorithmc, affi chcr pour chaque iteration la

valcur du nouvea u bias

T'r,,f; .1.<l'ur l [ \'- '\'.~ J,\ I.I '\ I

Vous aimerez peut-être aussi

- Annales de Mathématiques, Baccalauréat C et E, Cameroun, 2008 - 2018: Sujets et CorrigésD'EverandAnnales de Mathématiques, Baccalauréat C et E, Cameroun, 2008 - 2018: Sujets et CorrigésÉvaluation : 4.5 sur 5 étoiles4.5/5 (4)

- Guide de lIA Generative de Sousa Cardoso Cyril Parise Fanny Cyril de Sousa Cardoso Fanny PariseDocument295 pagesGuide de lIA Generative de Sousa Cardoso Cyril Parise Fanny Cyril de Sousa Cardoso Fanny Parisearnold BaziePas encore d'évaluation

- Rapport Pfe Ihab BendidiDocument67 pagesRapport Pfe Ihab Bendidisaid100% (2)

- L'intelligence Artificielle Dans Le Domaine Maritime - MARWANE AMMOUDocument29 pagesL'intelligence Artificielle Dans Le Domaine Maritime - MARWANE AMMOUschafferPas encore d'évaluation

- Formation AI Incubateur Msila 25-01-2021Document47 pagesFormation AI Incubateur Msila 25-01-2021Moun tariPas encore d'évaluation

- Intelligence ArtificielleDocument28 pagesIntelligence Artificielledrago_rossoPas encore d'évaluation

- TD - 2 PDFDocument13 pagesTD - 2 PDFMed Amine Talhaoui100% (1)

- Examen Matlab Avec CorrectionDocument2 pagesExamen Matlab Avec CorrectionSamiro TatbetPas encore d'évaluation

- Slide DL PDFDocument22 pagesSlide DL PDFHassan Ramchoun100% (1)

- Statistiques Appliquées - TD 2Document3 pagesStatistiques Appliquées - TD 2OverDoc100% (2)

- NOOB REROLL Light Novel 1 Ebook PDFDocument290 pagesNOOB REROLL Light Novel 1 Ebook PDFKolhaganPas encore d'évaluation

- Strategie Nationale D'intelligence Artificielle Et Des Megadonnees 2023 2027Document68 pagesStrategie Nationale D'intelligence Artificielle Et Des Megadonnees 2023 2027jesugo NOUNAGNONPas encore d'évaluation

- Notes de Cours Etape3 Solutionnaire Rencontre23 Pages17a22Document6 pagesNotes de Cours Etape3 Solutionnaire Rencontre23 Pages17a22Marie2345Pas encore d'évaluation

- Epst 1an Exam1 Analyse1Document7 pagesEpst 1an Exam1 Analyse1Thameur BEHIHPas encore d'évaluation

- Adobe Scan Jan 11, 2023Document3 pagesAdobe Scan Jan 11, 2023Imane LOUKILIPas encore d'évaluation

- Examen AnalyseDocument2 pagesExamen AnalyseMohand BADJOUPas encore d'évaluation

- 612bd31af1afasujet Corrige Et Bareme de Maths Bac A1 2021Document8 pages612bd31af1afasujet Corrige Et Bareme de Maths Bac A1 2021Boua DouhPas encore d'évaluation

- Solution Aut04Document9 pagesSolution Aut04mahdiPas encore d'évaluation

- 2017 Mathematiques1Document2 pages2017 Mathematiques1Katcha nanklan enock hiliPas encore d'évaluation

- Epreuve Bac 2023 Mathematiques Serie A-Abi Cameroun Cameroun-1Document2 pagesEpreuve Bac 2023 Mathematiques Serie A-Abi Cameroun Cameroun-1Germain NgankouPas encore d'évaluation

- TD2 LM270Document6 pagesTD2 LM270sechoirambulantPas encore d'évaluation

- CT CaoDocument6 pagesCT Caomiss khanPas encore d'évaluation

- Sujet IG-2006Document8 pagesSujet IG-2006Atou RamPas encore d'évaluation

- C°2-Composition-Lyccee-Valdiodio-Ndiaye-TS2.PDFDocument1 pageC°2-Composition-Lyccee-Valdiodio-Ndiaye-TS2.PDFPapabaldefall FallPas encore d'évaluation

- Adobe Scan Jan 06, 2024Document1 pageAdobe Scan Jan 06, 2024yasser.aitelPas encore d'évaluation

- Sujet Principal - BTS - BAT - 2017Document2 pagesSujet Principal - BTS - BAT - 2017Hasnae Ben khaldounPas encore d'évaluation

- Examen 2021 MoulisteDocument2 pagesExamen 2021 MoulisteYassine ElbiadPas encore d'évaluation

- Tle D Séq 3Document2 pagesTle D Séq 3JOEL LOICPas encore d'évaluation

- ElectroMagnétisme-Contrôle-n-1-avec-Correction-2004-2005 by RayDocument8 pagesElectroMagnétisme-Contrôle-n-1-avec-Correction-2004-2005 by RayMourad KattassPas encore d'évaluation

- Anciens de Sujets Du Semestre 6Document8 pagesAnciens de Sujets Du Semestre 6NSANGOUPas encore d'évaluation

- TD 2 PDFDocument13 pagesTD 2 PDFfayssal0% (1)

- BAC Mathematiques 2009 SDocument7 pagesBAC Mathematiques 2009 SswallakPas encore d'évaluation

- Emd GC L2 PDFDocument41 pagesEmd GC L2 PDFBreathe 4 footballPas encore d'évaluation

- TD2 3Document3 pagesTD2 3ALIOU DIALLOPas encore d'évaluation

- TP4 Regression MultipleDocument4 pagesTP4 Regression MultipleLeila BensoudariaPas encore d'évaluation

- No16 07 Mai 2022 Sujetexa - ComDocument2 pagesNo16 07 Mai 2022 Sujetexa - ComNgos JeanPas encore d'évaluation

- TD Intégral 3 2018Document2 pagesTD Intégral 3 2018ak penPas encore d'évaluation

- Exercices Supplémentaires - Analyse Complexe - 2AP2Document2 pagesExercices Supplémentaires - Analyse Complexe - 2AP2Achraf EnoualiPas encore d'évaluation

- Sujet Dexamen Maths 06 Et Le Corrige PDFDocument14 pagesSujet Dexamen Maths 06 Et Le Corrige PDFazzamPas encore d'évaluation

- Annale 38426 BTSGEOTOPO Mathematiques 2014Document9 pagesAnnale 38426 BTSGEOTOPO Mathematiques 2014Balogun Aboubakar WilfriedPas encore d'évaluation

- Enoncé Correction Bac Blanc 2023 Sfax1Document8 pagesEnoncé Correction Bac Blanc 2023 Sfax1fayzaPas encore d'évaluation

- Ds Maths 1Document2 pagesDs Maths 1[AE]Pas encore d'évaluation

- Exercices Sur Le Chapitre 9Document1 pageExercices Sur Le Chapitre 9Ayoub Zahraoui100% (1)

- Examen 2004Document2 pagesExamen 2004ouadazPas encore d'évaluation

- Econometrie Banque de Questions694Document4 pagesEconometrie Banque de Questions694peterlanga58Pas encore d'évaluation

- Analyse ComplexeDocument78 pagesAnalyse Complexehicham-essadikiPas encore d'évaluation

- Série1 CorrigéDocument11 pagesSérie1 CorrigéZahirPas encore d'évaluation

- CO1 2S 2019 Iapg WahabdiopDocument2 pagesCO1 2S 2019 Iapg WahabdiopMoussa DiopPas encore d'évaluation

- TD2 - Circuits Électriques Dans l'ARQSDocument4 pagesTD2 - Circuits Électriques Dans l'ARQSmarhieuPas encore d'évaluation

- OmpoDocument8 pagesOmpoAngus MakPas encore d'évaluation

- A5 SujetDocument1 pageA5 SujetFatima KanounPas encore d'évaluation

- TP Ondes Et VibrationsDocument8 pagesTP Ondes Et VibrationsNo1 Ad3Pas encore d'évaluation

- Chapitre: CalculDocument21 pagesChapitre: CalculKocouvi Agapi HouanouPas encore d'évaluation

- ph2 Exm1Document4 pagesph2 Exm1turufjgkg kbPas encore d'évaluation

- Examen 2021 SMDocument4 pagesExamen 2021 SMAlaa EddinnePas encore d'évaluation

- Mathématiques Série C 2021 - ÉnoncéDocument2 pagesMathématiques Série C 2021 - ÉnoncéRandriamandroso KevinPas encore d'évaluation

- TD Systeme Nerveux - Activites ReflexesDocument5 pagesTD Systeme Nerveux - Activites ReflexesGnandi BilantéPas encore d'évaluation

- Fiche 3Document2 pagesFiche 3Sbai SalahPas encore d'évaluation

- Act. 2/ Sem. 2: Analyse Et Fouille de Données - Jérôme BOSCHE - UPJV - FranceDocument2 pagesAct. 2/ Sem. 2: Analyse Et Fouille de Données - Jérôme BOSCHE - UPJV - FranceAntoine SodoPas encore d'évaluation

- Mathematiques: ConcoursDocument14 pagesMathematiques: ConcoursMaxime CoulibalyPas encore d'évaluation

- Examen Analyse Des DonnéesDocument2 pagesExamen Analyse Des DonnéesHassan ChamakhPas encore d'évaluation

- S1Td2 MEA 17 18Document2 pagesS1Td2 MEA 17 18El-amarty AbdelaliPas encore d'évaluation

- Angers2007 PDFDocument6 pagesAngers2007 PDFEMDCPas encore d'évaluation

- Devoir Controle 1 Physique Bac Technique 2018Document3 pagesDevoir Controle 1 Physique Bac Technique 2018Rafek JallouliPas encore d'évaluation

- Adobe Scan Jan 06, 2024Document1 pageAdobe Scan Jan 06, 2024yasser.aitelPas encore d'évaluation

- TD 3Document19 pagesTD 3Jean puantPas encore d'évaluation

- Série N°2 de MathsDocument2 pagesSérie N°2 de Mathsnada zadnanePas encore d'évaluation

- Intelligence Artificielle Et Conséquences Sur Les RHDocument3 pagesIntelligence Artificielle Et Conséquences Sur Les RHOphélie OihccanebPas encore d'évaluation

- Rapport Ahmed Imprimé Pour IssatsoDocument73 pagesRapport Ahmed Imprimé Pour Issatsoali hamdiPas encore d'évaluation

- Etude Open Source 2022Document39 pagesEtude Open Source 2022amaury.belarbiPas encore d'évaluation

- Chapitre II DiagbosticDocument5 pagesChapitre II DiagbosticAssala chellaliPas encore d'évaluation

- 01 FR Reconnaissance Des EmotionsDocument7 pages01 FR Reconnaissance Des EmotionsdidinePas encore d'évaluation

- ImInfo TD1 PDFDocument3 pagesImInfo TD1 PDFSalah MedPas encore d'évaluation

- INF1421 Corrige Module5 V3Document2 pagesINF1421 Corrige Module5 V3Sahar MANAIIPas encore d'évaluation

- 2513 SNG - Cours #2 (19 Sept 2022)Document56 pages2513 SNG - Cours #2 (19 Sept 2022)Brianna DreghornPas encore d'évaluation

- Revue Lamy Droit Civil - Novembre 2016 - Intelligence Artificielle PDFDocument1 pageRevue Lamy Droit Civil - Novembre 2016 - Intelligence Artificielle PDFGaëlle MARRAUD des GROTTESPas encore d'évaluation

- HugoAIAA-Guide Complet AIAADocument27 pagesHugoAIAA-Guide Complet AIAALoic ReyesPas encore d'évaluation

- Chapitre III-partie 1Document15 pagesChapitre III-partie 1Yosr LenglizPas encore d'évaluation

- Bouchet VincentDocument55 pagesBouchet VincentSow AbibalahiPas encore d'évaluation

- 9 CNIA - 2022 Leclercq MagnavalDocument7 pages9 CNIA - 2022 Leclercq Magnavalabdelhak AouadiPas encore d'évaluation

- Mag RH23Document230 pagesMag RH23gogolacoolPas encore d'évaluation

- Analyse ComportementaleDocument3 pagesAnalyse ComportementaleMALEK CHAABANE100% (1)

- Tournage GhlemDocument14 pagesTournage GhlemBilel BoulehmiPas encore d'évaluation

- Exercices en Apprentissage Supervis e Et Non Supervis e M2 SISE - Universit e Lyon 2 - 2018/2019Document6 pagesExercices en Apprentissage Supervis e Et Non Supervis e M2 SISE - Universit e Lyon 2 - 2018/2019Fatima ZahraPas encore d'évaluation

- I2d 221 0088Document11 pagesI2d 221 0088moran.daghariPas encore d'évaluation

- Comment Augmmenter Son Intelligence Pour Réussir en Milieu ScolaireDocument83 pagesComment Augmmenter Son Intelligence Pour Réussir en Milieu ScolaireAmadou benté DialloPas encore d'évaluation

- Système de Reconnaissance Automatique Des Plaques MinéralogiquesDocument8 pagesSystème de Reconnaissance Automatique Des Plaques Minéralogiquesamel smailiPas encore d'évaluation

- Ris 110 0141Document13 pagesRis 110 0141Lmh AlgerPas encore d'évaluation