0% ont trouvé ce document utile (0 vote)

390 vues9 pagesMathf 207 Seance 5 Corr

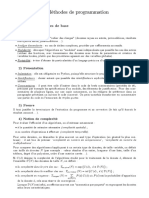

Ce document présente la résolution d'un exercice portant sur l'estimation ponctuelle. L'exercice consiste à estimer le paramètre θ d'une loi de densité donnée à partir d'un échantillon. Plusieurs estimateurs sont proposés et leur propriétés (biais, variance, efficacité) sont étudiées.

Transféré par

soulaimane lafhalCopyright

© © All Rights Reserved

Nous prenons très au sérieux les droits relatifs au contenu. Si vous pensez qu’il s’agit de votre contenu, signalez une atteinte au droit d’auteur ici.

Formats disponibles

Téléchargez aux formats PDF, TXT ou lisez en ligne sur Scribd

0% ont trouvé ce document utile (0 vote)

390 vues9 pagesMathf 207 Seance 5 Corr

Ce document présente la résolution d'un exercice portant sur l'estimation ponctuelle. L'exercice consiste à estimer le paramètre θ d'une loi de densité donnée à partir d'un échantillon. Plusieurs estimateurs sont proposés et leur propriétés (biais, variance, efficacité) sont étudiées.

Transféré par

soulaimane lafhalCopyright

© © All Rights Reserved

Nous prenons très au sérieux les droits relatifs au contenu. Si vous pensez qu’il s’agit de votre contenu, signalez une atteinte au droit d’auteur ici.

Formats disponibles

Téléchargez aux formats PDF, TXT ou lisez en ligne sur Scribd