Académique Documents

Professionnel Documents

Culture Documents

Scikit Learn 2

Scikit Learn 2

Transféré par

hermosillaTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Scikit Learn 2

Scikit Learn 2

Transféré par

hermosillaDroits d'auteur :

Formats disponibles

Cheat Sheet Sickit Learn

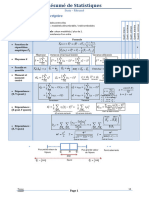

Apprentissage supervisé

Métriques pour la régression Métriques pour la classification

MSE : Différence quadratique Score R² : Coefficient de détermination Matrice de confusion :

moyenne entre les valeurs estimées

et la valeur vraie. n

i=1 (yi-yi)²

R² = 1 -

n

n

i=1 (yi-y)² Prédictions

1

MSE = (yi-yi)² 0 1

n i=1

model.score(X_test, y_test) VN FP

ConfusionMatrix =

0 VRAI NÉGATIF FAUX POSITIF

metrics.mean_squares_error(y_true, y_pred) FN VP

Réalité

RMSE : Mesure de la dispersion/

1 FAUX NÉGATIF VRAI POSITIF confusion_matrice=metrics.

variabilité de la qualité de la prédiction

confusion_matrix(y_true, y_pred)

MAE : Moyenne de toutes les erreurs

n

absolues. 1

RMSE = (yi-yi)²

n n i=1

1

MAE = yi-yi Metrics.mean_squared_error(y_true, y_pred)

Variables pour évaluer les modèles de Accuracy : La proportion d’observations

n i=1 classification : correctement classifiées.

mae_test =

Vrais Positifs VP : Observation classée

metrics.mean_absolute_error(y_true, y_pred)

VP + VN

positive par le modèle qui est effectivement Accuracy =

positive. n

Validation croisée et grille de recherche Vrais Négatifs VN : Observation classée (n : le nombre d’observations)

négative par le modèle et qui est effective- metrics.recall_score(y_true, y_pred,

pos_label='classe à signaler/

ment négative.

Validation croisée : Découpage du jeu de données en k parties tour à tour chacune des positive')

k parties est utilisée comme jeu de test, et le reste pour l’entraînement.

Faux Positifs FP : Observation classée

positive mais qui est en réalité négative Rappel : La proportion d’observations

- L’argument cv correspond au découpage de la base de données

réellement positives qui ont été

- L’argument scoring : métrique utilisée pour la validation

Faux Négatifs FN : Observation classée correctement classifiées positives par

négative et qui est en réalité négative le modèle

cross_validation=model_selection.cross_val_score

(logistic_regression,X,y,cv=10,scoring='accuracy')

Précision : La proportion de vrais positifs VP

Grille de recherche : parmi toutes les prédictions positives du

Rappel =

VP + FN

modèle

- Permet de tester plusieurs hyper paramètres : les paramètres sont croisés et un

metrics.recall_score(y_true, y_pred,

modèle est créé puis évalué pour chaque combinaison possible par validation croisée pos_label = 'classe à signaler/

- On indique les paramètres à faire varier grâce au dictionnaire VP

Précision = positive')

- On définit notre grille de recherche et on la fit VP + FP

- La méthode .best_params_ permet de retourner les paramètres avec le meilleur score

metrics.precision_score(y_true, y_pred, Classification report : Résumé de la

pos_label='classe à signaler/positive')

précision, du rappel, du score F1 pour

parametres = {'C':[0.1,1,10],'kernel':['rbf','linear','poly'],

'gamma':[0.001, 0.1, 0.5]} chaque classe.

metrics.f1_score(y_true, y_pred, pos_label

#clf notre modèle

F1 score : Quantifie l’équilibre entre ='classe à signaler/positive')

grid_clf=model_selection.GridSearchCV(estimator=clf, param_grid=pa- la précision et le rappel : critère fiable

rametres,scoring='accuracy') pour choisir le modèle le plus adapté à

grille=grid_clf.fit(X_train_scaled,y_train) notre problème.

grid_clf.best_params_

metrics.f1_score(y_true, y_pred, pos_label

='classe à signaler/positive')

Courbe ROC-AUC : Fonctions

roc_curve() qui permet de retourner

un tableau contenant les taux de faux

positifs (antispécificité), un tableau

de taux de vrais positifs (sensiblité)

et un tableau de seuil de classification

allant de 0 à 1

metrics.f1_score(y_true, y_pred, pos_label

='classe à signaler/positive')

Apprentissage non supervisé

Le coefficient de silhouette Le coefficient de Calinski-Harabasz

Coefficient de silhouette d’une observation :

Le coefficient de Calinski-Harabasz

bi - ai

Si = SS B N-k

max(a i ,b i ) S= X

SS W k-1

ai : distance moyenne de l’observation i aux autres observations du cluster

bi : distance minimale de l’observation i aux observations d’un autre cluster k : Nombre de clusters

Pour un cluster, le coefficient silhouette est égal à la moyenne des coeffi- N : Nombre total d’observations (points de

cients des objets du cluster. Il mesure la qualité du clustering. Il est compris données).

entre -1 (pire classification) et 1 (meilleure classification). SSW : Variance globale inter-clusters

from sklearn.metrics import silhouette_score

SSB : variance globale entre les clusters

silhouette_score(df, labels, metrics='sqeuclidean') Cet indice devrait être le plus grand

possible pour le nombre de clusters

optimal.

Vous aimerez peut-être aussi

- File Dans Ta Chambre (Caroline Goldman)Document172 pagesFile Dans Ta Chambre (Caroline Goldman)Rayane LaangryPas encore d'évaluation

- Mesures Et IncertitudesDocument4 pagesMesures Et IncertitudesmedwisePas encore d'évaluation

- CancersPaper 14 04399 v23229 2Document16 pagesCancersPaper 14 04399 v23229 2dani demoPas encore d'évaluation

- TP Ndeg1 Mesure Et IncertitudesDocument4 pagesTP Ndeg1 Mesure Et Incertitudesabde rahim haidraPas encore d'évaluation

- ElementsDocument1 pageElementsjpxPas encore d'évaluation

- Mesures Incertitudes PDFDocument7 pagesMesures Incertitudes PDFdhouhaPas encore d'évaluation

- StatistislidesbDocument27 pagesStatistislidesbyan muhalaPas encore d'évaluation

- Cours m1 Econometrie Appliquee Slide2Document34 pagesCours m1 Econometrie Appliquee Slide2ZOUHOUR21Pas encore d'évaluation

- CancersPaper 14 04399 v23229 2Document20 pagesCancersPaper 14 04399 v23229 2dani demoPas encore d'évaluation

- Asset-V1 MinesTelecom+04006+session10+type@asset+block@Télécom FBD S1 AlgèbrePartie1 V2Document15 pagesAsset-V1 MinesTelecom+04006+session10+type@asset+block@Télécom FBD S1 AlgèbrePartie1 V2Younouss KEITAPas encore d'évaluation

- Poly CH 1Document15 pagesPoly CH 1NangaPas encore d'évaluation

- Incertitudes TSDocument6 pagesIncertitudes TSIsmail ait talebPas encore d'évaluation

- Erreurs Et IncertitudesDocument5 pagesErreurs Et Incertitudesعبد الحكيم معيزيةPas encore d'évaluation

- Evaluation Des Modèles de MLDocument32 pagesEvaluation Des Modèles de MLNora HabrichPas encore d'évaluation

- COURS Plan D'experienceDocument19 pagesCOURS Plan D'experienceSafa RejebPas encore d'évaluation

- Cours 1 - Incertitude (1h30) PDFDocument60 pagesCours 1 - Incertitude (1h30) PDFAbdallah SobohPas encore d'évaluation

- Cours MasterDocument55 pagesCours MasterNaim ChPas encore d'évaluation

- Chapitre IDocument7 pagesChapitre Ichouroukbelkacemi236Pas encore d'évaluation

- Cours2 ADDDocument45 pagesCours2 ADDYassine MadaniPas encore d'évaluation

- ST M Explo AfdDocument6 pagesST M Explo AfdSouad BouabanaPas encore d'évaluation

- Polycopie de TP S3 ThermoDocument16 pagesPolycopie de TP S3 Thermoعمر عمري100% (3)

- Survol: Synthèse D'images Outils Mathématiques de BaseDocument7 pagesSurvol: Synthèse D'images Outils Mathématiques de BaseCyrille LamasséPas encore d'évaluation

- Cours Acp HandoutDocument10 pagesCours Acp HandoutMichelPas encore d'évaluation

- Anal-données-M1-CORRELATION ET REGRESSION LINEAIREDocument7 pagesAnal-données-M1-CORRELATION ET REGRESSION LINEAIREPatrice Kengne100% (1)

- Memento Prof MiDocument2 pagesMemento Prof MiLights'artsPas encore d'évaluation

- Labo FrottementDocument5 pagesLabo Frottementandyatt0068Pas encore d'évaluation

- Main MLDocument36 pagesMain MLflav legrand mongouoPas encore d'évaluation

- Cours Biostat Licence Et MasterDocument39 pagesCours Biostat Licence Et Masterfatmaamir878Pas encore d'évaluation

- Chap 3 RégressionDocument17 pagesChap 3 RégressionNadia BeraknaPas encore d'évaluation

- Cours-Resolution SEL-EnS - Info2!23!24 - Version 2Document83 pagesCours-Resolution SEL-EnS - Info2!23!24 - Version 2benjimktPas encore d'évaluation

- Regularized RegressionDocument41 pagesRegularized RegressionOmar BenPas encore d'évaluation

- 4 Chapitre III Statistique Descriptive BivariéeDocument12 pages4 Chapitre III Statistique Descriptive Bivariéehebrimaroua0Pas encore d'évaluation

- Chromatographie CalibrationDocument15 pagesChromatographie CalibrationKhalil OukebdanePas encore d'évaluation

- 1 Mathematiques-BaseDocument15 pages1 Mathematiques-BaseKristmi Gédéon BAMOGOPas encore d'évaluation

- Séance 8 IGF 13 JuinDocument31 pagesSéance 8 IGF 13 JuinSalah DahbiPas encore d'évaluation

- AM RadiobioDocument15 pagesAM Radiobiotiravi1249Pas encore d'évaluation

- TP2 Régression Linéaire MultipleDocument2 pagesTP2 Régression Linéaire Multiplemathieut157Pas encore d'évaluation

- Incertitude Et Logiciel GUM (MPRN)Document8 pagesIncertitude Et Logiciel GUM (MPRN)sofianesedkaouiPas encore d'évaluation

- Anova One Way (L3) Support de Cours Détaillé (Fevrier 2024)Document13 pagesAnova One Way (L3) Support de Cours Détaillé (Fevrier 2024)lynasamaPas encore d'évaluation

- Klubprepa 4790 PDFDocument2 pagesKlubprepa 4790 PDFdamino32Pas encore d'évaluation

- Stats - RésuméDocument8 pagesStats - Résuméyessminchaabouni5Pas encore d'évaluation

- 7 Tests 2016Document17 pages7 Tests 2016beday27725Pas encore d'évaluation

- Fiche Synthèse Sur La Régression Linéaire MultipleDocument1 pageFiche Synthèse Sur La Régression Linéaire MultipleAchrafOuinouPas encore d'évaluation

- Torseur Action MecaniqueDocument8 pagesTorseur Action MecaniqueMaha Karray100% (1)

- EJAYDocument24 pagesEJAYromuald calpasPas encore d'évaluation

- Chapitre2 - Statistique Descriptive À Une VariableDocument22 pagesChapitre2 - Statistique Descriptive À Une VariablebayePas encore d'évaluation

- Data ScienceDocument8 pagesData SciencemielledavPas encore d'évaluation

- Chapitre. Régression Linéaire Simple - 19-20 - Part01Document10 pagesChapitre. Régression Linéaire Simple - 19-20 - Part01Kamilia bouhraouaPas encore d'évaluation

- Chapitre. Régression Linéaire Simple - 19-20 - Part01 PDFDocument10 pagesChapitre. Régression Linéaire Simple - 19-20 - Part01 PDFKamilia bouhraouaPas encore d'évaluation

- S1 Modelisation RLDocument20 pagesS1 Modelisation RLAmine ChettatPas encore d'évaluation

- Cours Introduction À L'econométrieDocument95 pagesCours Introduction À L'econométriegondodiesamesperancePas encore d'évaluation

- Partie 1 - Chap 1 - de Mécanique Rationnelle-S1-TennougaL - CopieDocument20 pagesPartie 1 - Chap 1 - de Mécanique Rationnelle-S1-TennougaL - CopieRezig Ahmed KhodhirPas encore d'évaluation

- CHP0 - Partie 02Document9 pagesCHP0 - Partie 02refran daliaPas encore d'évaluation

- Formules Statistique UnivarieeDocument2 pagesFormules Statistique UnivarieeAce100% (1)

- Examenblanc PDFDocument7 pagesExamenblanc PDFabousalimPas encore d'évaluation

- Lois de Newton Resume de Cours 1 1Document3 pagesLois de Newton Resume de Cours 1 1motatata231Pas encore d'évaluation

- TP 1 Mesures Et IncertitudesDocument4 pagesTP 1 Mesures Et Incertitudesdalia aliasPas encore d'évaluation

- Complément Chapitre II - Calcul de La Médiane Et Les Quantiles - Cas Discret Et ContinuDocument43 pagesComplément Chapitre II - Calcul de La Médiane Et Les Quantiles - Cas Discret Et ContinuBlackstarr 547Pas encore d'évaluation

- Régression Linéaire Simple Et MultipleDocument13 pagesRégression Linéaire Simple Et MultipleOlivier TaonsaPas encore d'évaluation

- Français Première Année SecondaireDocument7 pagesFrançais Première Année SecondaireFrantzxo BonhommePas encore d'évaluation

- Prepa G2Document5 pagesPrepa G2bayilisamuel01Pas encore d'évaluation

- La Coordination Par Jean LoubatDocument13 pagesLa Coordination Par Jean LoubatdjelvrPas encore d'évaluation

- Republique Democratique Du CongoDocument1 pageRepublique Democratique Du CongoIsraël Ready Mabiala100% (1)

- Mettre en Place Un Outil de VeilleDocument6 pagesMettre en Place Un Outil de Veillehansi.pelikanPas encore d'évaluation

- Maarch Framework Tests ChargeDocument11 pagesMaarch Framework Tests ChargeicarobluePas encore d'évaluation

- 06 17 Rapport de Stage en Psychologie Maroiane HAOUIDEGDocument44 pages06 17 Rapport de Stage en Psychologie Maroiane HAOUIDEGultrazartrexPas encore d'évaluation

- DCICN Formation Introduction Aux Reseaux Data Center Cisco PDFDocument2 pagesDCICN Formation Introduction Aux Reseaux Data Center Cisco PDFCertyouFormationPas encore d'évaluation

- Cours-Systeme D Exploitation SeDocument50 pagesCours-Systeme D Exploitation SemahrazaekPas encore d'évaluation

- Formulaire M1 - 10-11Document6 pagesFormulaire M1 - 10-11blueskyedPas encore d'évaluation

- ViergeDocument1 pageViergeGode-junior YeyePas encore d'évaluation

- ENSEIGNEMENT - Une Crise Planétaire de L'éducation - Courrier InternationalDocument7 pagesENSEIGNEMENT - Une Crise Planétaire de L'éducation - Courrier InternationalAnonymous TPeTdS430% (1)

- 13 - Le Mental Du ChampionDocument5 pages13 - Le Mental Du Championalain kouassi100% (1)

- Autocad 2012 ProductDocument4 pagesAutocad 2012 ProductRobobatMaroc2012Pas encore d'évaluation

- Réglement Des Etudes Master 2020 - 2021 - VotéDocument10 pagesRéglement Des Etudes Master 2020 - 2021 - VotéYassine SaddikiPas encore d'évaluation

- LivreDocument71 pagesLivrecxxxPas encore d'évaluation

- Dev N°2 SBTFa CouDocument2 pagesDev N°2 SBTFa CouOumar TraoréPas encore d'évaluation

- Rapport D'activités 2015 - Fondation Pour La Mémoire de La ShoahDocument56 pagesRapport D'activités 2015 - Fondation Pour La Mémoire de La ShoahFondation pour la Mémoire de la Shoah100% (1)

- Autorité Nationale D'Assurance Qualité de L'Enseignement SupérieurDocument22 pagesAutorité Nationale D'Assurance Qualité de L'Enseignement SupérieurCOOPASIV TOGOPas encore d'évaluation

- Syllabus Cours Culture Entrepreneuriat - LP1Document2 pagesSyllabus Cours Culture Entrepreneuriat - LP1Yasmine SolenePas encore d'évaluation

- Programme Laboratoire - Physique - Cours (2017-01-D-72-fr-3)Document11 pagesProgramme Laboratoire - Physique - Cours (2017-01-D-72-fr-3)Barthélemy HoubenPas encore d'évaluation

- مصادر المعلومات الالكترونية المتاحة عن بعد في الاستشها... ال... تحليلية لعينة من مذكرات الماستر بقسم علوم التربية جامعة قسنطينة.Document8 pagesمصادر المعلومات الالكترونية المتاحة عن بعد في الاستشها... ال... تحليلية لعينة من مذكرات الماستر بقسم علوم التربية جامعة قسنطينة.Golden RosePas encore d'évaluation