Académique Documents

Professionnel Documents

Culture Documents

SVM Machine À Vecteurs Du Support

Transféré par

Miloud Bilal Zenazel0 évaluation0% ont trouvé ce document utile (0 vote)

53 vues37 pagesTitre original

SVM machine à vecteurs du support

Copyright

© © All Rights Reserved

Formats disponibles

PPT, PDF, TXT ou lisez en ligne sur Scribd

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

© All Rights Reserved

Formats disponibles

Téléchargez comme PPT, PDF, TXT ou lisez en ligne sur Scribd

0 évaluation0% ont trouvé ce document utile (0 vote)

53 vues37 pagesSVM Machine À Vecteurs Du Support

Transféré par

Miloud Bilal ZenazelDroits d'auteur :

© All Rights Reserved

Formats disponibles

Téléchargez comme PPT, PDF, TXT ou lisez en ligne sur Scribd

Vous êtes sur la page 1sur 37

SVM

machine à vecteurs de support

ou

séparateur à vaste marge

FOMANI - MOHAMADALLY Présentation BD Web

2006

Plan

• Introduction

• Principes de fonctionnement

• Les fondements mathématiques

• Domaines d’applications

• Les SVM dans Oracle

• Conclusion

FOMANI - MOHAMADALLY Présentation BD Web

2006

Introduction

• Méthode de classification binaire par

apprentissage

• Introduite par Vladimir Vapnik en 1995

• Repose sur l’existence d’un classificateur linéaire

• Apprentissage supervisé

FOMANI - MOHAMADALLY Présentation BD Web

2006

Principes de fonctionnement (1)

Pour deux classes d’exemples, on veut :

- Trouver un classificateur linéaire qui va séparer les données (Hyperplan)

- Maximiser la distance entre ces deux classes

FOMANI - MOHAMADALLY Présentation BD Web

2006

Principes de fonctionnement (2)

Hyperplan optimal : hyperplan dont la distance minimale aux exemples

d’apprentissage est maximale.

Cette distance est appelée « marge ».

FOMANI - MOHAMADALLY Présentation BD Web

2006

Principes de fonctionnement (3)

Pourquoi maximiser la marge?

FOMANI - MOHAMADALLY Présentation BD Web

2006

Principes de fonctionnement (4)

Classification d’un nouvel élément inconnu ?

On regarde sa position par rapport à l’hyperplan.

FOMANI - MOHAMADALLY Présentation BD Web

2006

Principes de fonctionnement (5)

Linéarité et non-linéarité ?

La majorité des problèmes réels sont non-linéaire

FOMANI - MOHAMADALLY Présentation BD Web

2006

Principes de fonctionnement (6)

Résolution d’un cas non linéaire ?

On change de dimension en utilisant une fonction noyau:

-Polynomial

-Gaussien

-Sigmoïde

-Laplacien

Le nouvel espace est appelé « espace de redescription »

FOMANI - MOHAMADALLY Présentation BD Web

2006

Principes de fonctionnement (7)

Illustration avec le cas XOR:

Le cas de XOR n’est pas linéairement séparable, si on place les points

dans un plan à deux dimension, on obtient la figure suivante

Coordonnées des points : (0,0) ; (0,1) ; (1,0) ; (1,1)

FOMANI - MOHAMADALLY Présentation BD Web

2006

Principes de fonctionnement (8)

Si on prend une fonction polynomiale (x , y) -> (x , y , x.y) qui fait

passer d'un espace de dimension 2 à un espace de dimension 3, on obtient

un problème en trois dimensions linéairement séparable :

(0,0) -> (0,0,0)

(0,1) -> (0,1,0)

(1,0) -> (1,0,0)

(1,1) -> (1,1,1)

FOMANI - MOHAMADALLY Présentation BD Web

2006

Les fondements mathématiques

FOMANI - MOHAMADALLY Présentation BD Web

2006

Problème d’apprentissage

• But: Observation (xi, yi) → déterminer la fonction f tq

f(x) = y de la façon la plus précise possible

Pb: Trouver le frontière de Trouver un compromis entre

décision optimale le sous-apprentissage et le

sur- apprentissage

FOMANI - MOHAMADALLY Présentation BD Web

2006

Classification à valeurs réelles

• But: Plutôt que de construire h : X → {-1, 1} on

construit f: X → R (nombres réels)

• La classe est donnée par h=signe(f).

• L'erreur se calcule avec

– P(h(X)!=Y ) = P(Yf(X) ≤0). Ceci donne une

certaine idée de la confiance dans la

classification. Idéalement, |Yf(X)| est

proportionnel à P(Y|X).

• Yf(X) représente la marge de f en (X,Y).

FOMANI - MOHAMADALLY Présentation BD Web

2006

Transformation des entrées

• On part du problème initial

• On transforme les entrées en vecteurs dans un espace F (feature

space) → Problème plus simple

• F finie ou non mais dispose d'un produit scalaire (espace de Hilbert)

• Choix de l’hyperplan optimal

FOMANI - MOHAMADALLY Présentation BD Web

2006

Maximisation de la marge

• Marge = distance du point le plus proche à l'hyperplan

• Linéaire → f(x) = w.x + b → hyperplan d’équation w.x + b = 0

• La distance d'un point au plan est donnée par d(x) = |w.x + b|/||w||

• Il faut donc minimiser ||w||

FOMANI - MOHAMADALLY Présentation BD Web

2006

Problème primal

• Un point (x; y) est bien classé si et seulement si

yf(x) > 0

• (w, b) est défini à un coefficient multiplicatif près

=> on choisi yf(x) > 1

• On en déduit le problème primal:

FOMANI - MOHAMADALLY Présentation BD Web

2006

Problème dual (1/2)

• Primal → Dual grâce aux multiplicateurs de

lagrange (cf théorème de lagrange)

• On obtient:

• Matrice hessienne (xi.xj)i,j

FOMANI - MOHAMADALLY Présentation BD Web

2006

Problème dual (2/2)

• (αi)i solutions =>

• αi = 0 vecteurs de support.

• La fonction de décision est donc

FOMANI - MOHAMADALLY Présentation BD Web

2006

La non linéarité (cas non séparable)

• Majorité des problèmes

• Primal linéaire → primal non linéaire

• Dual non linéaire:

FOMANI - MOHAMADALLY Présentation BD Web

2006

Fonctions noyau (1/3)

• Passage dans un espace intermédiaire de dimension

supérieure

• Exemple: passage en dimension 3

FOMANI - MOHAMADALLY Présentation BD Web

2006

Fonctions noyau (2/3)

• Dans le nouvel espace on doit résoudre:

• La fonction solution f est:

FOMANI - MOHAMADALLY Présentation BD Web

2006

Fonctions noyau (3/3)

• Le problème et la solution ne dépendent que de

Φ(x).Φ(x’)

• On choisi k: XxX → R tq k(x,x’) = Φ(x).Φ(x’)

• K est appelée la fonction noyau et est linéaire

• Pb: Choisir le bon noyau

FOMANI - MOHAMADALLY Présentation BD Web

2006

Condition de Mercer

• K symétrique est un noyau (k(xi,xj))i,j est une matrice définie

positive

• Dans ce cas il existe l’espace F et la fn Φ tq: k(x,x’)= Φ(x).Φ(x’)

• Problème:

– condition est très difficile à vérifier

– ne permet pas de savoir comment est Φ

– donne pas d'indication pour la construction de noyaux

• => En pratique, on combine des noyaux simples pour en obtenir de

plus complexes.

FOMANI - MOHAMADALLY Présentation BD Web

2006

Exemples de noyaux (1/2)

FOMANI - MOHAMADALLY Présentation BD Web

2006

Exemples de noyaux (2/2)

• 47 exemples (22 (5-, 4+) (3-, 4+) (5-, 4+)

+, 25 -) Ici fonction polynomiale de degré 2, 5, 8 et C = 10000

(10-, 11+) (8-, 6+) (4-, 5+)

Ici fonction Gaussienne de s = 2, 5, 10 et C = 10000

FOMANI - MOHAMADALLY Présentation BD Web

2006

Temps de calcul

• n = nombre de données d’apprentissage

• d = nombre d’entrées à prédire

• dn² ≤ complexité ≤ dn*n*n

• Taille de la matrice hessienne = n²

• =>SVM est adapté pour des problèmes de taille

moyenne (~10.000 à 100.000)

FOMANI - MOHAMADALLY Présentation BD Web

2006

Domaines d’applications (1)

• Catégorisation de textes

• Classification d’e-mails

• Classification de pages web

– Entrées : document (texte ou html)

• Approche « sac de mots »

• Document = vecteur de mots

– Sortie : catégorie (spam/non-spam)

FOMANI - MOHAMADALLY Présentation BD Web

2006

Domaines d’applications (2)

• Traitement d’images

• Reconnaissance de caractères manuscrits

• Reconnaissance de visages

– Entrées : image bidimensionnelle en couleur

ou en niveaux de gris

– Sortie : classe (chiffre / personne)

FOMANI - MOHAMADALLY Présentation BD Web

2006

Domaines d’applications (3)

• Diagnostic médical

• Évaluation du risque de cancer

• Évaluation du risque d’accidents cardio-

vasculaires

– Entrées : état du patient (sexe, age, bilan

sanguin, …)

– Sortie :

• Classe : à risque ou non

FOMANI - MOHAMADALLY Présentation BD Web

2006

Les SVM dans Oracle (ODM)

FOMANI - MOHAMADALLY Présentation BD Web

2006

Oracle et SVM

• Oracle 10g implémente SVM

• Spécificités de SVM dans Oracle 10g

– Détection d’anomalies (Anomaly detection)

– L’apprentissage actif (Active learning)

– Echantillonage et choix du noyau

FOMANI - MOHAMADALLY Présentation BD Web

2006

Le package DBMS_DATA_MINING et svm

• DBMS_DATA_MINING package dédié au datamining pour des

applications Pl/sql.

• Quelques paramètres du package pour SVM

Nom Description

svms_kernel_function -svms_linear (pour noyau linéaire)

-svms_gaussian (pour noyau gaussien)

svms_kernel_cache_size Taille du cache

svms_complexity_factor Valeur du facteur de complexité

svms_epsilon Valeur du facteur epsilon pour

l’algorithme de régression

FOMANI - MOHAMADALLY Présentation BD Web

2006

Arbres de décision vs SVM dans oracle (1/2)

• Cancer du poumon dans le Wisconsin

– 645 patients (512 comme données entraînement et 133 comme

données à prédire)

– 2 classes: Benign (65%) et malignant (35%)

– Les résultats sont les suivants:

Algorithme de SVM utilisant un Algorithme d’arbre de

noyau gaussien décision

Précision de 99,3% Précision de 92,5%

FOMANI - MOHAMADALLY Présentation BD Web

2006

Arbres de décision vs SVM dans oracle (2/2)

• Base de données pour les spams

– 4601 tuples (3520 tuples pour l’apprentissage et 811 pour les tests

– 2 classes : spam (39%) et non-spam(61%)

– Les résultats sont les suivants:

Algorithme de SVM utilisant un noyau Algorithme d’arbre de

gaussien décision

Précision de 95,3% Précision de 92,5%

FOMANI - MOHAMADALLY Présentation BD Web

2006

Conclusion

• Méthode de classification intéressante

• Efficace

• Utilisée dans de nombreux domaines d’application

FOMANI - MOHAMADALLY Présentation BD Web

2006

Pour en savoir plus

Programmes, articles en ligne, tutorial sur:

- www.kernel-machines.org

- www.kernel-methods.net

- www.support-vector.net

FOMANI - MOHAMADALLY Présentation BD Web

2006

Vous aimerez peut-être aussi

- Optimisation LineaireDocument24 pagesOptimisation LineaireTarek ZeblahPas encore d'évaluation

- SVM PDFDocument42 pagesSVM PDFprimerosePas encore d'évaluation

- 17 BranchBoundDocument26 pages17 BranchBoundYounes YouPas encore d'évaluation

- HAKIMADocument45 pagesHAKIMAAnonymous Ftt2WIPas encore d'évaluation

- P.L. Resolution.Document64 pagesP.L. Resolution.Amine StiouniPas encore d'évaluation

- Exercices Corrigés Recherche OpérationnelleDocument21 pagesExercices Corrigés Recherche OpérationnelleAnouar Bh100% (1)

- 2 - Presentation LMS Virtual LabDocument17 pages2 - Presentation LMS Virtual LabJaffyPas encore d'évaluation

- Prof Merzak PDFDocument57 pagesProf Merzak PDFالابتسامة سرها الوسامة0% (1)

- Chapitre1 Circuits LogiquesDocument8 pagesChapitre1 Circuits LogiquesHayet SeninaPas encore d'évaluation

- Les Cahiers de Mathematiques AnalyseDocument322 pagesLes Cahiers de Mathematiques AnalyseBernadette YaoPas encore d'évaluation

- Programmation Linéaire en Nombres Entiers-Première - Partie PDFDocument13 pagesProgrammation Linéaire en Nombres Entiers-Première - Partie PDFMohamed SelmaniPas encore d'évaluation

- Polycope ActuelDocument139 pagesPolycope ActuelKarinaPas encore d'évaluation

- Les Systèmes DynamiquesDocument53 pagesLes Systèmes DynamiquesBou NajPas encore d'évaluation

- Chap 2Document9 pagesChap 2Fan SofMPas encore d'évaluation

- Recherche OpérationnelleDocument41 pagesRecherche Opérationnelleben haydarPas encore d'évaluation

- P.L. La Dualite 17 05 21Document23 pagesP.L. La Dualite 17 05 21Amine StiouniPas encore d'évaluation

- Cours R o Epcci 2021Document58 pagesCours R o Epcci 2021bessama84100% (2)

- CHAPITRE 3 Méthode de SimplexeDocument18 pagesCHAPITRE 3 Méthode de SimplexeMEDSMI MéthodologiesPas encore d'évaluation

- 2015 Version Courte PDFDocument170 pages2015 Version Courte PDFLontchi LudovicPas encore d'évaluation

- Chapitre 1Document38 pagesChapitre 1رضوان رضاPas encore d'évaluation

- Cours PLDocument17 pagesCours PLcruyft49 YoPas encore d'évaluation

- Chapitre II OptimisationDocument4 pagesChapitre II Optimisationbabasidi AbderazakPas encore d'évaluation

- Logique FloueDocument43 pagesLogique FloueMed Salah Soudani100% (1)

- Tutoriel 1Document31 pagesTutoriel 1Hanane NaciriPas encore d'évaluation

- Lecture 5Document20 pagesLecture 5saad rajawiPas encore d'évaluation

- Recherche OpérationnelleDocument26 pagesRecherche OpérationnelleMziou Hammadi50% (2)

- 1 FloubisDocument43 pages1 FloubisNaas DjeddaouiPas encore d'évaluation

- Cours Op Tim MultiDocument59 pagesCours Op Tim MultiSaturné AYIDEGNONPas encore d'évaluation

- CoursA.N1ere SeanceDocument9 pagesCoursA.N1ere SeanceTarek BlfPas encore d'évaluation

- Chapitre 2Document13 pagesChapitre 2youcef mokranePas encore d'évaluation

- Sat SMTDocument21 pagesSat SMTDavit HarutyunyanPas encore d'évaluation

- Chap 3Document68 pagesChap 3adamPas encore d'évaluation

- Cours de Programmation Linéaire Partie 2Document11 pagesCours de Programmation Linéaire Partie 2DefPas encore d'évaluation

- Logique Floue Applic PDFDocument11 pagesLogique Floue Applic PDFDhikrane NafaaPas encore d'évaluation

- 1 FloubisDocument43 pages1 FloubisNina OleinikPas encore d'évaluation

- Exercices Corrigés Recherche OpérationnelleDocument17 pagesExercices Corrigés Recherche OpérationnelleAbdelouadoud Samery0% (1)

- ch1-OR-Prog - Lineaire-Imbt (1) 2018Document72 pagesch1-OR-Prog - Lineaire-Imbt (1) 2018younes ould bouallalaPas encore d'évaluation

- Séance 2 - Problème de Voyageur de CommerceDocument44 pagesSéance 2 - Problème de Voyageur de CommerceetakiPas encore d'évaluation

- Tp1 FourierDocument1 pageTp1 FourierYves-rolandN'guessanPas encore d'évaluation

- Chap 0 Opt 23 24Document12 pagesChap 0 Opt 23 24Zakaria TabatiPas encore d'évaluation

- 1 FlouDocument80 pages1 FlouJacob BouzidPas encore d'évaluation

- 5 - Matlab-Optimisation - FinaleDocument13 pages5 - Matlab-Optimisation - FinaleAhmed AbatourabPas encore d'évaluation

- 3 Cours Ro Chapitre 3 Methode Simplexe Algeb - 231003 - 073206Document14 pages3 Cours Ro Chapitre 3 Methode Simplexe Algeb - 231003 - 073206Loubna KbPas encore d'évaluation

- Cours FSR v1Document73 pagesCours FSR v1belfathiPas encore d'évaluation

- Résultats Dexistence Et DunicitéDocument36 pagesRésultats Dexistence Et Dunicitéseyf el islam bencherkiPas encore d'évaluation

- Chapitre5 IlyasDocument40 pagesChapitre5 IlyasKhaoula BelfassiPas encore d'évaluation

- Voyageur de CommerceDocument97 pagesVoyageur de Commercejupitemma19Pas encore d'évaluation

- Inf 316Document37 pagesInf 316Roland JeanPas encore d'évaluation

- Recherche Opérationnelle PDFDocument69 pagesRecherche Opérationnelle PDFhidou2013Pas encore d'évaluation

- 1 Optimisation CoursDocument56 pages1 Optimisation CoursMohamed BenafghoulPas encore d'évaluation

- TFE Syst Dyn Ch1Document8 pagesTFE Syst Dyn Ch1Bou NajPas encore d'évaluation

- Cours Recherche OpérationnelDocument60 pagesCours Recherche OpérationnelMouad GuendouzPas encore d'évaluation

- Recherche Op Chap5 - S6 - Youb ManalDocument24 pagesRecherche Op Chap5 - S6 - Youb ManalSALAH EDDINEPas encore d'évaluation

- 08 AutoencoderDocument31 pages08 AutoencoderAl AlouiPas encore d'évaluation

- Géométrie computationnelle: Explorer les informations géométriques pour la vision par ordinateurD'EverandGéométrie computationnelle: Explorer les informations géométriques pour la vision par ordinateurPas encore d'évaluation

- Cours 02Document6 pagesCours 02Miloud Bilal ZenazelPas encore d'évaluation

- 2018 UstoDocument4 pages2018 UstoMiloud Bilal ZenazelPas encore d'évaluation

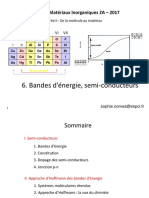

- Cours - Physique Des SemiconducteursDocument20 pagesCours - Physique Des SemiconducteursMiloud Bilal ZenazelPas encore d'évaluation

- 16F877 - Ch3 Instructions Du PIC16F877ADocument18 pages16F877 - Ch3 Instructions Du PIC16F877AMiloud Bilal ZenazelPas encore d'évaluation

- 16F877 - Ch4 Réalisation Dun Projet MPLABDocument17 pages16F877 - Ch4 Réalisation Dun Projet MPLABMiloud Bilal ZenazelPas encore d'évaluation

- Bandes D y Nergie Semi Conducteurs OnlineDocument41 pagesBandes D y Nergie Semi Conducteurs OnlineMiloud Bilal ZenazelPas encore d'évaluation

- 16F877 - Ch2 Registres InternesDocument19 pages16F877 - Ch2 Registres InternesMiloud Bilal ZenazelPas encore d'évaluation

- IB TIM Chap3 ImagesNumériquesDocument38 pagesIB TIM Chap3 ImagesNumériquesMiloud Bilal ZenazelPas encore d'évaluation

- 16F877 - Ch1 IntroductionDocument9 pages16F877 - Ch1 IntroductionMiloud Bilal ZenazelPas encore d'évaluation

- IB TIM Chap5 1 Pretraitements FiltrageDocument27 pagesIB TIM Chap5 1 Pretraitements FiltrageMiloud Bilal ZenazelPas encore d'évaluation

- IB TIM Chap2 CapteursImagesDocument21 pagesIB TIM Chap2 CapteursImagesMiloud Bilal ZenazelPas encore d'évaluation

- IB TIM Chap6 SegmentationDocument38 pagesIB TIM Chap6 SegmentationMiloud Bilal ZenazelPas encore d'évaluation

- IB TIM Chap4 Operations de Base ImageDocument46 pagesIB TIM Chap4 Operations de Base ImageMiloud Bilal ZenazelPas encore d'évaluation

- IB TIM Chap1 Introduction Au Traitement DimagesDocument48 pagesIB TIM Chap1 Introduction Au Traitement DimagesMiloud Bilal ZenazelPas encore d'évaluation

- Matériaux Intelligents 2020Document12 pagesMatériaux Intelligents 2020Miloud Bilal ZenazelPas encore d'évaluation

- La Diode Electrolumineuse Chapitre-01Document26 pagesLa Diode Electrolumineuse Chapitre-01Miloud Bilal ZenazelPas encore d'évaluation

- Photorécepteur À Effet de VolumeDocument10 pagesPhotorécepteur À Effet de VolumeMiloud Bilal ZenazelPas encore d'évaluation

- Enonce 19Document2 pagesEnonce 19yves1ndri100% (3)

- Thermodynamique II TD Corr 03Document8 pagesThermodynamique II TD Corr 03Djadouwa AKPAMADJIPas encore d'évaluation

- Chapitre 1.partie1.3èmeDocument24 pagesChapitre 1.partie1.3èmeSeif AyediPas encore d'évaluation

- Automatique 111Document17 pagesAutomatique 111laila AZZOUZIPas encore d'évaluation

- GraphesDocument68 pagesGraphesmulk omarPas encore d'évaluation

- Examens5 2022Document2 pagesExamens5 2022ragragmariemPas encore d'évaluation

- EnigmaDocument10 pagesEnigmaSami RouainiaPas encore d'évaluation

- Cours Programmation Avancée Chapitre 1.introductionDocument6 pagesCours Programmation Avancée Chapitre 1.introductionDO UAPas encore d'évaluation

- Chapitre 1Document9 pagesChapitre 1yasmine hmnPas encore d'évaluation

- 03 Cours DeepDocument73 pages03 Cours DeepKSDPas encore d'évaluation

- Series ChronologiquesDocument14 pagesSeries ChronologiquesMaria Amina100% (1)

- Cours EcqDocument33 pagesCours EcqDENOUPas encore d'évaluation

- James NeeDocument2 pagesJames NeeJames nee de SouzaPas encore d'évaluation

- Méthode Des Lieux de RacinesDocument8 pagesMéthode Des Lieux de RacinesMokhtaria CHELEFPas encore d'évaluation

- Cryptage PDFDocument122 pagesCryptage PDFAmor MrabetPas encore d'évaluation

- Beamer Diag 1Document71 pagesBeamer Diag 1Modeste AkaffouPas encore d'évaluation

- Corrige Exam Nov 2007Document11 pagesCorrige Exam Nov 2007Babi Ben100% (1)

- TP 08 - Tris (Suite)Document3 pagesTP 08 - Tris (Suite)moreiramario005Pas encore d'évaluation

- 3 - Commande Par Retour D - État. - ÉtudiantDocument10 pages3 - Commande Par Retour D - État. - Étudiantzakariaoo zakariaPas encore d'évaluation

- TD 1 Transformée de Laplace Et Fonction de Transfert - Sys AsservisDocument2 pagesTD 1 Transformée de Laplace Et Fonction de Transfert - Sys AsservisYasser YasserPas encore d'évaluation

- TD TDS MPDocument21 pagesTD TDS MPSteves DoumanPas encore d'évaluation

- Mii 00021Document50 pagesMii 00021Soufiane AssefriPas encore d'évaluation

- GLmbmy SW LFV FBaa Fe 140 Q ZW RF KT6 Rlpo PB YSkl FDDocument9 pagesGLmbmy SW LFV FBaa Fe 140 Q ZW RF KT6 Rlpo PB YSkl FDmedgmizaPas encore d'évaluation

- Détection D'Intrusions Réseaux en Utilisant Le Machine LearningDocument31 pagesDétection D'Intrusions Réseaux en Utilisant Le Machine Learningliticia nailiPas encore d'évaluation

- AnumII-Ch4 IntNumDocument68 pagesAnumII-Ch4 IntNumJean Jacques Atemengue ZamePas encore d'évaluation

- Cours Numpy FrankDocument9 pagesCours Numpy Frankabderrahim cheggourPas encore d'évaluation

- Lois Continues2Document43 pagesLois Continues2Mustapha ZianiPas encore d'évaluation

- ExemplesModeleLineaire AgroParisTechDocument124 pagesExemplesModeleLineaire AgroParisTechardjanisamirPas encore d'évaluation

- Solution TD Méthode MCS 2021 2022Document3 pagesSolution TD Méthode MCS 2021 2022Rosa BabePas encore d'évaluation

- CHP 3Document74 pagesCHP 3Hiba AmaraPas encore d'évaluation