Académique Documents

Professionnel Documents

Culture Documents

Processus de Poisson

Transféré par

Soumiya SkCopyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Processus de Poisson

Transféré par

Soumiya SkDroits d'auteur :

Formats disponibles

Processus de Poisson

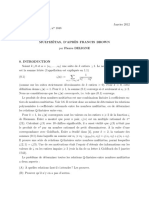

Leçons : 263, 264

Soit (Ω, F , P) un espace probabilisé.

Définition 1

Un processus de comptage est une suite de variables aléatoires réelles (N (t)) t¾0 telles que

1 N (0) = 0.

2 ∀t ¾ 0, N (t) ∈ N∗ .

3 t 7→ N (t) est croissante.

Du point de vue de la modélisation, ∀0 ¶ a ¶ b, N (b) − N (a) représente le nombre de

« tops » se produisant dans l’intervalle de temps [a, b[.

Définition 2

Un processus de Poisson de densité λ > 0 est un processus de comptage (N (t)) t¾0 tel

que :

1 Le processus est à accroissement indépendants : ∀t 0 ¶ t 1 < · · · < t k , les variables

aléatoires Nt k − Nt k−1 , . . . , Nt 1 − Nt 0 sont indépendantes.

2 Pour tout (s, t) ∈ R2+ , N (s + t) − N (s) suit la loi de Poisson de paramètre λt.

Les processus de Poisson sont souvent utilisés pour modéliser des files d’attente, chaque

top représentant l’appel d’un client au guichet.

Proposition 3

Un processus de Poisson est à accroissements stationnaires : soit N1 , . . . , Nk le nombre de

tops se produisant dans les intervalles I1 , . . . , I k ; alors si τ ¾ 0, et N10 , . . . , Nk0 est le nombre

de tops se produisant dans les intervalles translatés de τ I10 + τ, . . . , I k0 , (N10 , . . . , Nk0 ) et

(N1 , . . . , Nk ) ont la même loi.

Proposition 4

Un processus de Poisson est localement continu : lim+ P(N (t + h) − N (t) ¾ 1) = 0.

h→0

Le but du développement est d’étudier le temps d’attente entre deux tops :

Théorème 5

Soit Sn = inf {t ¾ 0, N (t) ¾ n} et Tk = Sk − Sk−1 pour k ¾ 1. Alors

1 (Tn )n est une suite de variables aléatoires i.i.d. de loi E (λ) .

2 Sn = T1 + · · · + Tn suit la loi Γ (n, λ) de densité

λ

(

e−λs (λs)n−1 si s ¾ 0

fSn (s) = (n − 1)! .

0 sinon

Démonstration. Soit n ∈ N∗ .

Gabriel LEPETIT 1 ENS Rennes - Université Rennes 1

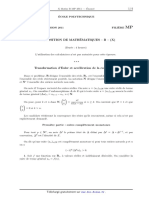

Étape 1 : Changement de variable : supposons que le vecteur aléatoire (S1 , . . . , Sn ) soit

à densité, de densité ϕ. Soit f : Rn → R continue bornée. Alors comme Sn ¾ . . . , ¾ S1 ,

par un changement de variable sk = t 1 + · · · + t k de jacobien 1 (la matrice jacobienne est

triangulaire), on a

E[ f (T1 , . . . , Tn )] = E[1Sn ¾···¾S1 f (S1 , . . . , Sn − Sn−1 )]

Z

= f (s1 , . . . , sn − sn−1 )ϕ(s1 , . . . , sn )ds1 . . . dsn

0¶s1 ¶···¶sn

Z

= f (t 1 , . . . , t n )ϕ(t 1 , . . . , t 1 + · · · + t n )dt 1 . . . dt n .

t 1 ,...,t n ¾0

Donc ψ : (t 1 , . . . , t n ) 7→ ϕ(t 1 , t 1 + t 2 , . . . , t 1 + · · · + t n ) est la densité de (T1 , . . . , Tn ).

Étape 2 : Calcul de la densité de (S1 , . . . , Sn ) :

Soit An l’évènement : S1 ∈ [s1 , s1 + h1 [, . . . , Sn ∈ [sn , sn + hn [ où 0 < s1 < s1 + h1 < s2 <

· · · < sn + hn . Alors An est la réunion des évènements :

• zéro top dans [0, s1 [ et exactement un top dans [s1 , s1 + h1 [

• zéro top dans [s1 + h1 , s2 [ et exactement un top dans [s2 , s2 + h2 [

.

• ..

• zéro top dans [sn−1 + hn−1 , sn [ et au moins un top dans [sn , sn + hn [.

Or, le processus étant à accroissements indépendants, les variables aléatoires « nombre

de tops » dans des intervalles disjoints sont indépendantes de sorte que

P(An ) = P(N (s1 ) = 0) × P(N (s1 + h1 ) − N (s1 ) = 1) × P(N (s2 ) − N (s1 + h1 ) = 0)×

P(N (s2 + h2 ) − N (s2 ) = 1) × · · · × P(N (sn ) − N (sn−1 + hn−1 ) = 0) × P(N (sn + hn ) − N (sn ) ¾ 1)

donc

P(An ) = e−λs1 e−λh1 (λh1 )e−λ(s2 −s1 −h1 ) e−λh2 (λh2 ) . . . e−λ(sn −sn−1 −hn−1 ) (1 − e−λhn )

= e−λsn λn−1 h1 . . . hn−1 (1 − e−λhn ).

Pour conclure, il suffit de remarquer que

Z s1 +h1 Z sn +hn

P(An ) = ... 10¶ξ1 ¶···¶ξn λn e−λξn dξ1 . . . dξn ,

ξ1 =s1 ξn =sn

ceci valant pour tous les pavés [s1 , s1 + h1 [× · · · × [sn + hn [, qui constituent une classe stable

par intersection engendrant B(Rn ) donc (S1 , . . . , Sn ) a pour densité 1ξ1 ¶···¶x n λn e−λξn .

Conclusion : selon la première étape, la densité de (T1 , . . . , Tn ) est

(t 1 , . . . , t n ) 7→ λn e−λt 1 . . . e−λt n 1R+n (t 1 , . . . , t n ).

En calculant les densités marginales, on constate immédiatement que f(T1 ,...,Tn ) (t 1 , . . . , t n ) =

f T1 (t 1 ) . . . f Tn (t n ) ; en d’autres termes, T1 , . . . , Tn sont indépendantes. La loi de Sn est donc

Γ (n, λ) en vertu du lemme ci-dessous.

Lemme 6

Si T1 , . . . , Tn sont n variables aléatoires i.i.d de loi E (λ), alors S = T1 + · · · + Tn suit la loi

Γ (n, λ)

Gabriel LEPETIT 2 ENS Rennes - Université Rennes 1

Démonstration. Calculons la transformée de Laplace d’une variable aléatoire V suivant la

loi Γ (n, λ), en rappelant que la transformée de Laplace caractérise la loi :

∞ ∞

λ λ

Z Z

L V (u) = E[e ] =

uS ux −λx

e e (λx) n−1

dx = e−x(λ−u) (λx)n−1 dx

Γ (n) 0

Γ (n) 0

bien définie pour λ − u > 0 donc en posant y = x(λ − u), on a

Z∞ n Z ∞

λ

n−1

λ λ λ

n

d 1

y y

L V (u) = e −y

= e y dy =

− y n−1

.

Γ (n) 0 λ−u λ − u Γ (n) λ − u 0

λ−u

Or, par le même changement de variable, si T ∼ E (λ),

+∞ ∞

λ λ

Z Z

L T (u) = e λe

ux −λx

dx = e− y d y =

0

λ−u 0

λ−u

donc comme la transformée de Laplace d’une somme de variable aléatoires indépendantes

est le produit de leurs transformées de Laplace, on a le résultat.

Remarque. • On peut aussi parler du paradoxe de l’inspection, ou paradoxe de l’auto-

bus, c’est dans le Foata–Fuchs juste après.

• Les deux premières propositions sont indépendantes du développement proprement

dit.

Références :

• Dominique FOATA et Aimé FUCHS (2004). Processus stochastiques : processus de Poisson,

chaînes de Markov et martingales. Dunod, pp. 28-31

• Dominique FOATA et Aimé FUCHS (2003). Calcul des probabilités. Dunod, p. 148 (pour

le lemme)

Gabriel LEPETIT 3 ENS Rennes - Université Rennes 1

Vous aimerez peut-être aussi

- Équations différentielles: Les Grands Articles d'UniversalisD'EverandÉquations différentielles: Les Grands Articles d'UniversalisPas encore d'évaluation

- Mat2720 H16Document6 pagesMat2720 H16Norbert PiechowiakPas encore d'évaluation

- Processus M2 PDFDocument186 pagesProcessus M2 PDFlangagecccPas encore d'évaluation

- Chaine Markov en Temps ContinuDocument26 pagesChaine Markov en Temps ContinuBouhdidaMahmoudPas encore d'évaluation

- Banque X-ÉNS 2020 MP Mathématiques B EaDocument3 pagesBanque X-ÉNS 2020 MP Mathématiques B EaMehdi BnmssdPas encore d'évaluation

- Multi ZetasDocument26 pagesMulti ZetasYAMNA HAMROUNIPas encore d'évaluation

- Corrigé Mine PC 2 2017 (Serie de Fonctions)Document6 pagesCorrigé Mine PC 2 2017 (Serie de Fonctions)bludzee SimonPas encore d'évaluation

- CH Mark ContDocument11 pagesCH Mark ContFatma BelabedPas encore d'évaluation

- CH Mark ContDocument11 pagesCH Mark ContdibekayaPas encore d'évaluation

- Ccenmp 101Document8 pagesCcenmp 101LAILA IDRISSIPas encore d'évaluation

- Theoreme Central LimiteDocument3 pagesTheoreme Central LimiteAkpo ArmandPas encore d'évaluation

- Concours Mines-Ponts: Théorème de Hardy-RamanujanDocument17 pagesConcours Mines-Ponts: Théorème de Hardy-RamanujanMax tekouPas encore d'évaluation

- Banque X-ÉNS 2020 MP Mathématiques B CBDocument7 pagesBanque X-ÉNS 2020 MP Mathématiques B CBMehdi BnmssdPas encore d'évaluation

- CCP 2011 MP m1 CorrigeDocument7 pagesCCP 2011 MP m1 CorrigeSara MarouchePas encore d'évaluation

- Théorème de La Limite CentraleDocument3 pagesThéorème de La Limite CentralemamoudoubalPas encore d'évaluation

- 15 Normes Matricielles CorrigeDocument6 pages15 Normes Matricielles Corrigeanon_752970773Pas encore d'évaluation

- Cha Ines de Markov ' A Temps Continu: 1 Lois ExponentiellesDocument8 pagesCha Ines de Markov ' A Temps Continu: 1 Lois ExponentiellesCyrille LamasséPas encore d'évaluation

- Exercices L12Document19 pagesExercices L12Alassane SowPas encore d'évaluation

- Chap2 TS 2021Document15 pagesChap2 TS 2021jouri sorayaPas encore d'évaluation

- 1 Holo 1 ExosDocument6 pages1 Holo 1 ExosReed DoloPas encore d'évaluation

- Exercices L10Document12 pagesExercices L10ZogoPas encore d'évaluation

- Cours - Analyse Asymptotique de Niveau 2Document6 pagesCours - Analyse Asymptotique de Niveau 26666666666666-545255Pas encore d'évaluation

- Daouia - Abdelkader@hotmail.f R: Corrigé de La Première Épreuve de Mathématique Mines PSI 2022Document9 pagesDaouia - Abdelkader@hotmail.f R: Corrigé de La Première Épreuve de Mathématique Mines PSI 2022Essayh WadiePas encore d'évaluation

- Chapitre 2 (Suites Dans Un EVN)Document51 pagesChapitre 2 (Suites Dans Un EVN)معاذ طويرPas encore d'évaluation

- La TRANSFORMeE en ZDocument13 pagesLa TRANSFORMeE en ZAyman LamzouriPas encore d'évaluation

- MathDocument8 pagesMathyousfi majdPas encore d'évaluation

- Exercices Maths Fermât CorrigésDocument3 pagesExercices Maths Fermât Corrigésmathis.menagerziza31Pas encore d'évaluation

- E3a PC 2003 Maths 1 CorrigeDocument6 pagesE3a PC 2003 Maths 1 CorrigeakramamairaPas encore d'évaluation

- Devoir de Mathématiques Numéro 6: Partie I - Quelques Résultats GénérauxDocument17 pagesDevoir de Mathématiques Numéro 6: Partie I - Quelques Résultats Générauxsalma Ait HamouPas encore d'évaluation

- Grégory Berhuy - Suites Et Séries de Fonctions (Lecture Notes) (2015)Document88 pagesGrégory Berhuy - Suites Et Séries de Fonctions (Lecture Notes) (2015)Chatiri AzizPas encore d'évaluation

- Concours Commun Mines-Ponts 2022: A. Fonctions L Et PDocument22 pagesConcours Commun Mines-Ponts 2022: A. Fonctions L Et Ploris emanuelliPas encore d'évaluation

- Joseph LaunayDocument24 pagesJoseph LaunayDouanguim LitisiaPas encore d'évaluation

- MP 10 Suites Et Séries de FonctionsDocument14 pagesMP 10 Suites Et Séries de Fonctionsdouhardflorian091Pas encore d'évaluation

- Concours Commun Mines-Ponts (CCMP) 2022 PC-PSI Mathématiques 1 CBDocument22 pagesConcours Commun Mines-Ponts (CCMP) 2022 PC-PSI Mathématiques 1 CBtomy.colinPas encore d'évaluation

- TLM1 Laplace PDFDocument12 pagesTLM1 Laplace PDFMuhammad DickPas encore d'évaluation

- 04 SeriesDocument14 pages04 SeriesProfchaari SciencesPas encore d'évaluation

- Partiel PMA1718Document2 pagesPartiel PMA1718martialmars363Pas encore d'évaluation

- Poly Processus Stochastiques FRDocument47 pagesPoly Processus Stochastiques FRsaidPas encore d'évaluation

- Ag001 A1Document5 pagesAg001 A1Baba HanafiPas encore d'évaluation

- Cecn 4Document60 pagesCecn 4Norbert DurandPas encore d'évaluation

- DS N°06 - CorrectionDocument13 pagesDS N°06 - CorrectionEdward AdounvoPas encore d'évaluation

- CCP 2006 MP M1 CorrigeDocument10 pagesCCP 2006 MP M1 CorrigeTahtouh LadebPas encore d'évaluation

- 19 NormesOperateurs CorrigeDocument5 pages19 NormesOperateurs CorrigeAyoub TemmaliPas encore d'évaluation

- TD 7Document6 pagesTD 7kukis14Pas encore d'évaluation

- Tts 1Document22 pagesTts 1sowPas encore d'évaluation

- Math 1 Mines MPCDocument10 pagesMath 1 Mines MPCSouleyPas encore d'évaluation

- Corrige Maths Ecricomes 2017Document9 pagesCorrige Maths Ecricomes 2017imanesabbar804Pas encore d'évaluation

- Formule de StirlingDocument7 pagesFormule de StirlingKamal ChaibPas encore d'évaluation

- X Ens MP 2020 Maths B Sujet PDFDocument6 pagesX Ens MP 2020 Maths B Sujet PDFSamad BnsPas encore d'évaluation

- FresnelDocument2 pagesFresnelramezPas encore d'évaluation

- Exercices L13Document17 pagesExercices L13Salman MohamedPas encore d'évaluation

- LM345 TD10 1Document5 pagesLM345 TD10 1GNANOU HABIBPas encore d'évaluation

- La Fonction Zêta de Riemann: Définitions FormellesDocument102 pagesLa Fonction Zêta de Riemann: Définitions FormelleskhaoulaPas encore d'évaluation

- DS3 1Document4 pagesDS3 1Yahya El GueddariPas encore d'évaluation

- Oralescp2006 ProbasDocument57 pagesOralescp2006 Probaskukis14Pas encore d'évaluation

- M2 Mathematique Analyse Fonctionnelle Sujet ExamDocument3 pagesM2 Mathematique Analyse Fonctionnelle Sujet Exammahuna911Pas encore d'évaluation

- MP Maths X 2 2011.enonceDocument4 pagesMP Maths X 2 2011.enoncepepafov154moneyzonPas encore d'évaluation

- Corrigé DS 20-21Document4 pagesCorrigé DS 20-21Imen MassoudiPas encore d'évaluation

- Transformée en Z - CoursDocument5 pagesTransformée en Z - CourssubulataPas encore d'évaluation

- Comp Il GammaDocument8 pagesComp Il GammaHasan RajawiPas encore d'évaluation

- dm09 PDFDocument3 pagesdm09 PDFSafae IssaouiPas encore d'évaluation

- Corr Ex2Document2 pagesCorr Ex2Sofien HaddadPas encore d'évaluation

- Concours National Marocain 2022-Maths I-Mp: ExerciceDocument4 pagesConcours National Marocain 2022-Maths I-Mp: Exerciceلا إلٰه إلّا اللهPas encore d'évaluation

- PL - RésolutionDocument19 pagesPL - RésolutionSoumiya SkPas encore d'évaluation

- Modèle de Régression LinéaireDocument16 pagesModèle de Régression LinéaireSoumiya SkPas encore d'évaluation

- Travail, Emploi, ChomageDocument14 pagesTravail, Emploi, ChomageSoumiya SkPas encore d'évaluation

- Structures de DonnéesDocument16 pagesStructures de DonnéesSoumiya SkPas encore d'évaluation

- M Ethodologie de Box Et JenkinsDocument6 pagesM Ethodologie de Box Et Jenkinssoufram1993Pas encore d'évaluation

- Cours Sugaux AleatoiresDocument92 pagesCours Sugaux Aleatoiresomar benaniPas encore d'évaluation

- 3-Stationnarité Et Processus Non StationnairesDocument31 pages3-Stationnarité Et Processus Non StationnairesOmayma TajddinePas encore d'évaluation

- Partie C RfaDocument19 pagesPartie C RfaMaha BadriPas encore d'évaluation

- Exercices Variogramme 2e-SerieDocument8 pagesExercices Variogramme 2e-SerieBensalma YanisPas encore d'évaluation

- PS - Cours 2Document11 pagesPS - Cours 2Badre MhiouahPas encore d'évaluation

- Poly Var - Estimation - Prévision - 2020Document22 pagesPoly Var - Estimation - Prévision - 2020Mansour laye ThiawPas encore d'évaluation

- Tsa R 6 17 PDFDocument12 pagesTsa R 6 17 PDFالشمس اشرقتPas encore d'évaluation

- Options Sur Taux LambertonDocument16 pagesOptions Sur Taux Lambertonyassine chnafyyassinePas encore d'évaluation

- 011 TD IndicationsDocument86 pages011 TD Indicationsfahdl magdoulPas encore d'évaluation

- 112 Lemmeito 4 X 4Document12 pages112 Lemmeito 4 X 4Fall WeuzfPas encore d'évaluation

- Université Du Québec MontréalDocument102 pagesUniversité Du Québec MontréalRadhia MohamedPas encore d'évaluation

- CH 1Document15 pagesCH 1thouraya hadj hassenPas encore d'évaluation

- Devoir2 (Solutions)Document7 pagesDevoir2 (Solutions)alfredPas encore d'évaluation

- TD Proc-Sta 19-20Document3 pagesTD Proc-Sta 19-20sibiri gregoire ouedraogoPas encore d'évaluation

- Correction EX1Document2 pagesCorrection EX1Sofien HaddadPas encore d'évaluation

- Estimation Modele Vecm Memoire TourismeDocument14 pagesEstimation Modele Vecm Memoire TourismePregoPas encore d'évaluation

- 6 Chapitre 2Document8 pages6 Chapitre 2yacinexmaafaPas encore d'évaluation

- LFDocument116 pagesLFMina OukachbiPas encore d'évaluation

- Cecn 4Document60 pagesCecn 4Norbert DurandPas encore d'évaluation

- Céline Lévy-Leduc - Cours Econométrie (Etude Des Séries Chronologiques)Document41 pagesCéline Lévy-Leduc - Cours Econométrie (Etude Des Séries Chronologiques)Abdelaziz El Idrissi100% (1)

- EnoncéDocument14 pagesEnoncéLouis OlivePas encore d'évaluation

- Cours FADocument10 pagesCours FAouichaouiabdenour23Pas encore d'évaluation

- Séries Non StationnairesDocument27 pagesSéries Non StationnairesAbba CissePas encore d'évaluation

- CALIBRATION AutoshearDocument7 pagesCALIBRATION AutoshearPete KemPas encore d'évaluation

- Statistique Appliquee CCAMDocument70 pagesStatistique Appliquee CCAMFliPas encore d'évaluation

- Brownien PDFDocument8 pagesBrownien PDFZozo Zozo DiagnePas encore d'évaluation