Académique Documents

Professionnel Documents

Culture Documents

Projet SPSS VF

Transféré par

EttalbiTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Projet SPSS VF

Transféré par

EttalbiDroits d'auteur :

Formats disponibles

Réalisé par : Ettalbi Houria

Introduction :

La rémunération d’une catégorie d’emplois présente le taux maximum de

salaire ou le maximum de l’échelle de salaire des emplois qui y sont regroupés.

Le même taux ou la même échelle de salaire ne signifie pas nécessairement le

même salaire versé. La Loi prévoit que le taux maximum de salaire ou le

maximum de l’échelle de salaire des emplois regroupés dans une catégorie doit

être le même.

On ne tient généralement pas compte des heures supplémentaires dans le

calcul de la rémunération. Il s’agit de la rémunération prévue pour l’emploi et

non du salaire versé à chacune des personnes occupant ces emplois. Les

salaires versés aux personnes dont les emplois sont regroupés dans une

catégorie peuvent varier, notamment en raison de règles de progression

connues du personnel basées, par exemple, sur les années de service au sein

de l’entreprise (ancienneté) ou sur le mérite.

Donc il est possible de regrouper au sein d’une même catégorie des emplois

qui n’ont pas le même salaire si cette différence s’explique par une logique de

progression. Si un emploi ne partage pas avec d'autres les caractéristiques

communes spécifiées, il constitue à lui seul une catégorie d'emplois.

De plus, il peut être pertinent de vérifier si la rémunération relative d'une

catégorie dans une entreprise a été établie lorsque la catégorie était à

prédominance féminine ou lorsqu'elle était à prédominance masculine.

Dans le cas où la rémunération aurait été déterminée alors que la catégorie

comptait surtout des femmes, il pourrait être possible qu'elle soit empreinte de

discrimination fondée sur le sexe.

Dans tous les cas, le choix de la prédominance sexuelle des catégories

d’emplois doit se faire dans l’esprit de la loi qui, rappelons-le, demeure la

correction des écarts salariaux entre les catégories d’emplois occupées par les

femmes et celles occupées par les hommes.

Donc le salaire dépend de plusieurs variables, mais comment on peut

expliquer cette variabilité ?

I- Analyse de la variance :

1- Définition ;

En statistique l’analyse de la variance (terme souvent abrégé par le terme

anglais ANOVA : analysis of variance) est un modèle statistique utilisé pour

comparer les moyennes d'échantillons.

Ce test s’applique lorsque l’on mesure une ou plusieurs variables explicatives

catégorielle (appelées alors facteurs de variabilité, leurs différentes modalités

étant parfois appelées « niveaux ») qui ont de l'influence sur la loi d'une

variable continue à expliquer. On parle d'analyse à un facteur lorsque l'analyse

porte sur un modèle décrit par un seul facteur de variabilité, d'analyse à deux

facteurs ou d'analyse multifactorielle sinon.

2- Le test de Fisher

La forme générale de l'analyse de variance repose sur le test de Fisher et donc

sur la normalité des distributions et l'indépendance des échantillons.

Normalité de la distribution : on suppose, sous l'hypothèse nulle, que les

échantillons sont issus d'une même population et suivent une loi

normale. Il est donc nécessaire de vérifier la normalité des distributions

et l'homoscédasticité (homogénéité des variances, par des tests

de Bartlett ou de Levene par exemple). Dans le cas contraire, on pourra

utiliser les variantes non paramétriques de l'analyse de variance (ANOVA

de Kruskal-Wallis ou ANOVA de Friedman).

Indépendance des échantillons : on suppose que chaque échantillon

analysé est indépendant des autres échantillons. En pratique, c'est la

problématique qui permet de supposer que les échantillons sont

indépendants. Un exemple fréquent d'échantillons dépendants est le cas

des mesures avec répétitions (chaque échantillon est analysé plusieurs

fois). Pour les échantillons dépendants, on utilisera l'analyse de variance

à mesures répétées ou l'ANOVA de Friedman pour les cas non

paramétriques.

3- Pourquoi choisir ANOVA ?

Pour simplifier les choses je vais considérer que ma recherche comporte

deux groupes (indépendants ou non) et que la variable dépendante est

quantitative.

De plus, ANOVA sert :

Pour comparer la variance de ces groupes (variable x) afin d'inférer

une relation entre X et Y. (dans notre exemple X représente : jobcateg

(Manager, Clerical, Custodial) et Y (le salaire).

Les tests statistiques comme l'analyse de variance permettent au

chercheur de rejeter ou non l'hypothèse nulle.

Donc de prendre une décision quant à la valeur de cette hypothèse

(est-elle vraie ou fausse ?).

Avant de procéder à une analyse de variance, il faut formuler vos

hypothèses statistiques (Ho et H1).

Et dans notre exemple :

Ho : il n'y a pas de différence entre les moyennes des trois groupes.

H1 : 'il existe une différence entre les moyennes des trois groupes.

II- ANOVA avec SPSS :

1- Qu’est ce que SPSS ?

IBM SPSS Statistics est le premier logiciel statistique au monde utilisé pour

résoudre les problèmes métier et les enjeux de la recherche au moyen

d'analyses, de tests d'hypothèses, de l'analyse géospatiale et de l'analyse

prédictive.

Les entreprises utilisent IBM SPSS Statistics pour comprendre les données,

analyser les tendances, réaliser des prévisions et définir des plans afin de

valider les hypothèses et de tirer des conclusions exactes.

2- Un outil complet :

IBM SPSS Statistics propose toutes les fonctions de base de statistiques, de

manipulation des données et de reporting.

Mais il permet également :

Pour l’analyse avancée :

« Advanced Statistics »: modèles linéaires généralisés (GLM) et mixtes

(GLMM), équations d’estimation généralisées (GEE), estimation de

composant de variance, analyse de la variance multivariée (MANOVA),

analyses de survie dont Kaplan-Meier, régression de Cox, analyses log-

linéaires.

« Regression » : aller au-delà de la régression linéaire : régression

logistique binaire et multinomial, régression non linéaire, (doubles)

moindres carrés.

« Custom Tables » : construire rapidement des tableaux d’analyse

simple, avec une interface purement graphique.

Pour les échantillons complexes :

« Missing Values » : méthodes statistiques pour estimer et remplacer

les données manquantes.

« Categories » : révéler les relations sous-jacentes entre variables

multivariées à l’aide de cartes factorielles sur les données catégorielles à

l’aide de nuage de points et de cartes factorielles

« Complex Samples » : créer des échantillons complexes et mettre en

œuvre des inférences statistiques plus robustes.

« Conjoint » : analyse conjointe, typiquement pour identifier les

caractéristiques d’un produit importantes pour le consommateur

« Exact Tests » : traiter les cas d’échantillons de faible taille ou

d’occurrences rares.

Pour l’analyse prévisionnelle :

« Forecasting » : Simulation et prévision pour les séries de données

temporelles à l’aide de modèles autorégressifs (ARMA/ARIMA) ou de

lissage.

« Decision Trees » : créer des arbres de décisions graphiquement et de

façon intuitive.

« Direct Marketing » : pour les responsables marketing sans expertise

approfondie en statistiques pour des analyses RFM, des classifications,

des profilages de prospects, des scores de propension, et des tests de

contrôle.

« Neural Networks » : mise en œuvre des réseaux de neurones de type

Multi-Layer Perceptron (MLP) et Radial Basis Function (RBF).

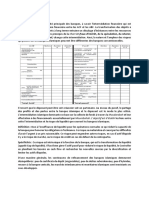

III- Le résultat du test ANOVA :

SPSS produit de nombreuses données pour le test ANOVA unidirectionnel.

Descriptifs :

Cela vaut la peine d’avoir un rapide coup d’œil aux statistiques descriptives

générées par SPSS.

Si vous regardez dans le tableau « Descriptifs », vous verrez que nos données

d’échantillon produisent une différence dans les scores moyens des 3 niveaux

de notre variable « jobcatg ».

Homogénéité des variances :

Une exigence pour le test ANOVA est que les variances de chaque groupe de

comparaison soient égales. Je l’ai testé en utilisant la statistique de Levene. Ce

que nous cherchons ici est une valeur de signification supérieure à 0.05.

Dans cet exemple, on a la valeur de signification de la statistique de Levene

basée sur une comparaison des médianes est de est de 0,00. Ce résultat n’est

pas significatif, ce qui signifie que l’exigence d’homogénéité de la variance a été

remplie et que le test ANOVA peut être considéré comme robuste.

Statistique F (résultat ANOVA).

Le tableau présente l'effet inter-groupes et l'effet intra-groupes. Il présente

également le total des deux effets pour la somme des carrés et les degrés de

liberté.

La colonne de la somme des carrés indique

pour la variabilité inter-groupes, la sommation de l'écart de chaque

moyenne de groupe par rapport à la moyenne totale au carré multiplié

par le nombre de sujets;

pour la variabilité intra-groupes, la variance (écart-type au carré) de

chaque groupe multipliée par le nombre de sujets de ce groupe moins

un.

Les degrés de libertés sont les mêmes que pour le test d'homogénéité des

variances.

La moyenne des carrés est calculée pour les deux effets en divisant la somme

des carrés par le degré de liberté associé.

La valeur de F est de 434 ,481. Cela signifie qu’il existe une différence

statiquement significative entre les moyennes des différents niveaux de la

variable « jobcatg ».

Vous aimerez peut-être aussi

- Physique QuantiqueDocument767 pagesPhysique Quantiquesam305100% (4)

- Rapport SPSSDocument44 pagesRapport SPSSBassma El GhalbzouriPas encore d'évaluation

- Traité de gestion de portefeuille, 5e édition actualisée: Titres à revenu fixe et produits structurés - Avec applications Excel (Visual Basic)D'EverandTraité de gestion de portefeuille, 5e édition actualisée: Titres à revenu fixe et produits structurés - Avec applications Excel (Visual Basic)Pas encore d'évaluation

- Marketing Approfondi Étude Du Cas Et Corrigé - Par Malika Saadi - Mef Reda Wakrim PDFDocument7 pagesMarketing Approfondi Étude Du Cas Et Corrigé - Par Malika Saadi - Mef Reda Wakrim PDFIdriss Darkouch80% (5)

- Cours ADDDocument105 pagesCours ADDrabab_elkhandari100% (1)

- AcpDocument13 pagesAcpRafikWaynePas encore d'évaluation

- Book Phystat PDFDocument89 pagesBook Phystat PDFWarda JoryPas encore d'évaluation

- Chapitre ACPDocument45 pagesChapitre ACPSalmaElPas encore d'évaluation

- ACP, SPSS InterpretaionDocument10 pagesACP, SPSS InterpretaionYoussef RhammaliPas encore d'évaluation

- LPSP1306 Exercices Danalyse de Donnees ADocument8 pagesLPSP1306 Exercices Danalyse de Donnees Aka100% (1)

- Partie REGRESSIONDocument110 pagesPartie REGRESSIONolli bhn100% (2)

- L'analyse des données de sondage avec SPSS: Un guide d'introductionD'EverandL'analyse des données de sondage avec SPSS: Un guide d'introductionPas encore d'évaluation

- Examen1 ADDocument2 pagesExamen1 ADaziz shahin100% (2)

- La Conduite D'une Mission D'audit de CertificationDocument53 pagesLa Conduite D'une Mission D'audit de CertificationEttalbiPas encore d'évaluation

- Analyse Des Correspondance Multiples: Pr. Trabelsi Mohamed Ali, Fsegt 1Document19 pagesAnalyse Des Correspondance Multiples: Pr. Trabelsi Mohamed Ali, Fsegt 1Yossra OuazPas encore d'évaluation

- Regression Lineaire SimpleDocument43 pagesRegression Lineaire SimpleSanaâ Merbouh100% (1)

- Afcm PDFDocument3 pagesAfcm PDFHamza Benzattat100% (1)

- Acp SPSSDocument18 pagesAcp SPSSSaad ZanifiPas encore d'évaluation

- Acp ExerciceDocument3 pagesAcp ExerciceYassine Amzil100% (1)

- Partie Pratique TPs Logiciel SPSS S6Document73 pagesPartie Pratique TPs Logiciel SPSS S6Simo BilalPas encore d'évaluation

- ADD CoursDocument15 pagesADD CoursRabir BabaPas encore d'évaluation

- FeuilleTage MicroéconomieDocument20 pagesFeuilleTage Microéconomiemohamed amid50% (2)

- Examen ANALYSE DES DONNEESDocument2 pagesExamen ANALYSE DES DONNEESezz100% (2)

- ACP, SPSS InterpretaionDocument8 pagesACP, SPSS InterpretaionmarocPas encore d'évaluation

- Présentation AFCDocument70 pagesPrésentation AFCNAAZIHPas encore d'évaluation

- Les Banques ParticipativesDocument17 pagesLes Banques ParticipativesEttalbi100% (1)

- Eviews 7Document95 pagesEviews 7Nanien Pana Issouf Coulibaly0% (1)

- Chapitre ACPDocument45 pagesChapitre ACPSana Yassine100% (3)

- Econométrie Master GIE DevoirDocument3 pagesEconométrie Master GIE Devoirlamia lebharPas encore d'évaluation

- Econométrie Pour La FinanceDocument78 pagesEconométrie Pour La FinanceHamza Afif75% (4)

- AfcDocument7 pagesAfcKarim KarimPas encore d'évaluation

- Vecm FinDocument25 pagesVecm FinEl Zakaria100% (1)

- Analyse de Données: Année Universitaire 2021-2022Document21 pagesAnalyse de Données: Année Universitaire 2021-2022Mouna RedissiPas encore d'évaluation

- Analyse en Composantes PrincipalesDocument18 pagesAnalyse en Composantes PrincipalesSalmaElPas encore d'évaluation

- Cours StataDocument24 pagesCours StataAbou DIENGPas encore d'évaluation

- Analyse Des Donnees-1Document12 pagesAnalyse Des Donnees-1Tbourida Maroc100% (1)

- S6 Econometrie ECO GEST 2016Document32 pagesS6 Econometrie ECO GEST 2016taki100% (1)

- Exposé Annova 1Document49 pagesExposé Annova 1OUISSAL EL HILALIPas encore d'évaluation

- TD Serie 4 - AFCDocument5 pagesTD Serie 4 - AFCelarbiPas encore d'évaluation

- TD 3 Analyse DD & Correction Exercice 2Document8 pagesTD 3 Analyse DD & Correction Exercice 2etudiant8Pas encore d'évaluation

- Présentation ADD - AFC Version RectifiéeDocument65 pagesPrésentation ADD - AFC Version RectifiéeelarbiPas encore d'évaluation

- Regression Linéaire Simple PDFDocument7 pagesRegression Linéaire Simple PDFsylPas encore d'évaluation

- StatistiqueDocument143 pagesStatistiqueImad Hakkache100% (1)

- Acp Sur SpssDocument4 pagesAcp Sur SpssYasmine Hammami100% (1)

- AfcDocument14 pagesAfcMandy100% (1)

- AFC CoursDocument6 pagesAFC CoursPptdPas encore d'évaluation

- Comment Calculer Un Coefficient de ContingenceDocument11 pagesComment Calculer Un Coefficient de ContingencerakolovaPas encore d'évaluation

- Analyse Des Données-Étude Da CasDocument28 pagesAnalyse Des Données-Étude Da CasImene AounePas encore d'évaluation

- Régression Linéaire SimpleDocument9 pagesRégression Linéaire SimpleIsmail AslPas encore d'évaluation

- Exercices Techniques de PrévisionDocument2 pagesExercices Techniques de PrévisionD IMPas encore d'évaluation

- Regression Multiple PDFDocument28 pagesRegression Multiple PDFAkrem ZouabiPas encore d'évaluation

- TD N°4 Modèle À Correction D'erreurDocument4 pagesTD N°4 Modèle À Correction D'erreurbabas100% (1)

- Cours Add Nssibah UaoDocument57 pagesCours Add Nssibah UaoSergeoPas encore d'évaluation

- Économétrie Pour Les NulsDocument10 pagesÉconométrie Pour Les NulsLEGHIMAPas encore d'évaluation

- Cas D - Application de L - ACP - Eaux MinéralesDocument8 pagesCas D - Application de L - ACP - Eaux MinéralesShop InPas encore d'évaluation

- Analyse Factorielle-1Document36 pagesAnalyse Factorielle-1amara abdelkarimePas encore d'évaluation

- Cours AFCDocument27 pagesCours AFCBenaissa LinaPas encore d'évaluation

- S6 Econométrie Multicolinearité 19 20 PDFDocument46 pagesS6 Econométrie Multicolinearité 19 20 PDFPPwmPas encore d'évaluation

- 6 Analyse DiscriminanteDocument18 pages6 Analyse DiscriminanteMohamed MoudinePas encore d'évaluation

- AfcDocument19 pagesAfcaqwaqwaqwPas encore d'évaluation

- Quali M1 PDFDocument110 pagesQuali M1 PDFLokmanePas encore d'évaluation

- Exercices - Sondages04-05Document31 pagesExercices - Sondages04-05fayssal33% (3)

- Analyse de Variance 2Document4 pagesAnalyse de Variance 2yasminePas encore d'évaluation

- Analyse de DonnéesDocument54 pagesAnalyse de DonnéesmajdiPas encore d'évaluation

- Cointegration de JohansenDocument27 pagesCointegration de JohansenABDESSAMAD EL YAHYAOUI100% (1)

- Rappels Analyse Exploratoire Multidimensionnelle STA201 Cle0a2813Document34 pagesRappels Analyse Exploratoire Multidimensionnelle STA201 Cle0a2813steerooPas encore d'évaluation

- Data Validation - CopieDocument70 pagesData Validation - CopieEttalbiPas encore d'évaluation

- 3eme Partie FIGR M3Document8 pages3eme Partie FIGR M3EttalbiPas encore d'évaluation

- 1ere Partie Gestions Des Risques M3Document7 pages1ere Partie Gestions Des Risques M3EttalbiPas encore d'évaluation

- FINANCEDocument4 pagesFINANCEEttalbiPas encore d'évaluation

- Cours ALM&Gestion ObligataireDocument30 pagesCours ALM&Gestion ObligataireEttalbi100% (1)

- Chap08 Cartes ShewhartDocument10 pagesChap08 Cartes ShewhartWerner Schrammel100% (1)

- Calcul Stochastiques Appliqué À La FinanceDocument95 pagesCalcul Stochastiques Appliqué À La FinanceAyoub BamoPas encore d'évaluation

- Diapo Le ChequeDocument74 pagesDiapo Le ChequeEttalbiPas encore d'évaluation

- Cours SC PDFDocument153 pagesCours SC PDFMohamed RdaitPas encore d'évaluation

- Poly Cours Series Temp m1 Im PDFDocument95 pagesPoly Cours Series Temp m1 Im PDFEttalbiPas encore d'évaluation

- Diapo Le ChequeDocument74 pagesDiapo Le ChequeEttalbiPas encore d'évaluation

- Calcul Stochastiques Appliqué À La FinanceDocument95 pagesCalcul Stochastiques Appliqué À La FinanceAyoub BamoPas encore d'évaluation

- Chap08 Cartes ShewhartDocument10 pagesChap08 Cartes ShewhartWerner Schrammel100% (1)

- Diapo Le-ChequeDocument74 pagesDiapo Le-ChequeEttalbi100% (1)

- As Jonas VAR VEC Stata EviewsDocument36 pagesAs Jonas VAR VEC Stata EviewsNathanaëla RazafindrakotoPas encore d'évaluation

- Série 1 - TD Économie - TCC - 2020Document2 pagesSérie 1 - TD Économie - TCC - 2020sararafik240Pas encore d'évaluation

- Chap 7 ModquantDocument21 pagesChap 7 ModquantSK BrookPas encore d'évaluation

- Principe D' Exclusion de PauliDocument2 pagesPrincipe D' Exclusion de PauliBernard SCHAEFFER100% (1)

- Chapitre 4Document9 pagesChapitre 4LkhaybPas encore d'évaluation

- Cours Reg LinDocument49 pagesCours Reg Lintest100% (1)

- Lois Du Mouvement de NewtonDocument10 pagesLois Du Mouvement de NewtonAndra LefterPas encore d'évaluation

- Oral 32 ProbasDocument3 pagesOral 32 ProbasfbdbhdPas encore d'évaluation

- SchrodingerDocument7 pagesSchrodingerFree FreePas encore d'évaluation

- Régression Logistique (Correction)Document16 pagesRégression Logistique (Correction)ëýá ràbâhPas encore d'évaluation

- TP3 Estimation CorrigeDocument14 pagesTP3 Estimation CorrigeElise fvPas encore d'évaluation

- TD Chap 1-2 3 ENCG Variable Alea Bin PoiDocument14 pagesTD Chap 1-2 3 ENCG Variable Alea Bin PoiAchraf BelmrharPas encore d'évaluation

- Cours 2 AtomistDocument11 pagesCours 2 AtomistSoufiane AharchiPas encore d'évaluation

- TD Proc-Sta 19-20Document3 pagesTD Proc-Sta 19-20sibiri gregoire ouedraogoPas encore d'évaluation

- SMF Ast 290 117-148Document33 pagesSMF Ast 290 117-148mostafaPas encore d'évaluation

- Chap5 Ato 2017Document15 pagesChap5 Ato 2017Roi AroufPas encore d'évaluation

- Chapitre II Quantification de Lénergie 2020 2021Document12 pagesChapitre II Quantification de Lénergie 2020 2021Younes Ahmed WassimPas encore d'évaluation

- Correction EX3Document2 pagesCorrection EX3Sofien HaddadPas encore d'évaluation

- Sig Aleatoire SlidesDocument4 pagesSig Aleatoire SlidesLEK GEFORCEPas encore d'évaluation

- Cours IIIDocument9 pagesCours IIIsmatiPas encore d'évaluation

- CosmologieDocument42 pagesCosmologieAhmed RabiiPas encore d'évaluation

- Poly6 TD MQ s5Document32 pagesPoly6 TD MQ s5BadrEddinPas encore d'évaluation