Académique Documents

Professionnel Documents

Culture Documents

Pour Tout Savoir Ou Presque Sur Le Coefficient Kap

Transféré par

AHMED AMINE BELDJERDTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Pour Tout Savoir Ou Presque Sur Le Coefficient Kap

Transféré par

AHMED AMINE BELDJERDDroits d'auteur :

Formats disponibles

See discussions, stats, and author profiles for this publication at: https://www.researchgate.

net/publication/237658832

POUR TOUT SAVOIR OU PRESQUE SUR LE COEFFICIENT KAPPA

Article · January 2002

CITATIONS READS

10 3,409

2 authors, including:

Remy Michel

Army Center for Epidemiology and Public Health

168 PUBLICATIONS 871 CITATIONS

SEE PROFILE

Some of the authors of this publication are also working on these related projects:

Food safety View project

All content following this page was uploaded by Remy Michel on 02 June 2014.

The user has requested enhancement of the downloaded file.

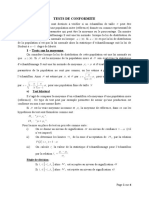

Technique

POUR TOUT SAVOIR OU PRESQUE SUR LE COEFFICIENT KAPPA...

I. BERGERI, R. MICHEL, J-P. BOUTIN

Med Trop 2002 ; 62 : 634-636

RESUME • Il est classique d’évaluer la qualité d’une méthode diagnostique au moyen de la sensibilité, de la spécificité et des

va l e u rs prédictives. Ceci nécessite toutefois d’avoir une méthode de référence. Comment faire lorsque cette condition n’est pas

remplie ? C’est tout le problème connu sous le nom de mesure de l’accord entre deux juges. Les auteurs présentent à partir

d’un exemple tiré de la pratique africaine, l’intérêt et le calcul du coefficient Kappa qui est l’outil le plus utilisé dans ces pro-

blèmes de concordance et de reproductibilité de mesures.

MOTS-CLES • Concordance, reproductibilité, qualitatif, accord, coefficient Kappa.

ABSTRACT • EVERYTHING (OR ALMOST) ABOUT THE KAPPA COEFFICIENT…

ABSTRACT • Sensitivity, specificity, and predictive value are the standard para m e t e rs used to eva l u ate the effi c a cy of diagnostic

tests. However all three parameters assume the existence of a gold standard test. Thus the problem arises as to what method

to use in the absence of a benchmark. The solution involves assessment of agreement between two raters. This article based

on an example drawn from an African setting describes the value and computation of the most widely used tool for assessing

agreement and reproducibility of measures, i.e., the kappa coefficient.

KEY WORDS • Agreement - Reproducibility - Qualitative - Kappa coefficient.

Une solution consiste ici à réaliser une séance de

S i nos jugements reflètent notre pensée, ils sont plus ra re-

ment en accord avec ceux d’autrui.

Cette variabilité inter-individuelle bénéfique pour

«concordance» entre les techniques pour estimer leur taux

d’accord par le coefficient Kappa et d’étudier leurs désac-

l’homme, est cependant pénalisante dans de nombreuses dis- cords pour y remédier.

ciplines scientifiques, où il est souvent nécessaire d’évaluer Plus généralement, le test statistique Kappa est utilisé

et d’améliorer l’accord entre des info rm ations appliquées au dans les études de reproductibilité.

même sujet.

Le test non para m é t rique Kappa de Cohen (1) permet

de chiffrer l’accord entre deux ou plusieurs observateurs ou DEFINITION DE L’ACCORD

techniques lorsque les jugements sont qualitatifs.

Pour illustrer nous prendrons un exemple tiré de la L’accord entre des jugements est défini comme la

revue Médecine Tropicale et relatif de la culture du sang péri- conformité de deux ou plusieurs informations qui se rap-

p h é rique comme moyen diagnostique de la leishmaniose vis- portent au même objet. Le taux d’accord ou de «concor-

cérale (la technique diagnostique habituelle étant jusqu’à pré- dance» est donc estimé par le coefficient Kappa proposé par

sent la culture de moelle osseuse) (2). Prenons le cas où ces Cohen (1).

deux techniques, tentant de poser un diagnostic chez le même Ici on souhaite évaluer le degré d’accord entre les dia-

patient, proposent des résultats divergents en mat i è rede leish- gnostics positifs et négatifs fournis par deux techniques A

maniose viscérale. Cette multiplication des avis n’ap p o rte pas (culture de sang périphérique) et B (culture de moelle

la sécurité attendue d’un parfait accord diagnostique pour le

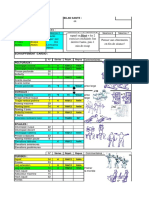

médecin traitant et le patient. Tableau I - Résultats de la recherche concomitante des leishmanies

dans le sang périphériques (A) et la moelle osseuse (B) chez 49

patients (d’après 2).

• Travail du Service de Médecine des collectivités (IB, Interne de pharma -

cie ; RM, Assistant des hôpitaux des armées ; JPB Professeur agrégé du

SSA), Institut de Médecine Tropicale du Service de Santé des Armées, Résultat de A

Marseille, France. Réponses + - Total

• C o rrespondance : I. BERGERI, S e rvice de Médecine des collectivités, Institut

Résultat + 19 10 29

de Médecine Tropicale du Service de Santé des Armées, Marseille, France

• Fax: +33 (0) 4 91 52 26 07 e-mail : medco.imtssa@wanadoo.fr • de B - 9 11 20

Total 28 21 49

• Article sollicité.

634 Médecine Tropicale • 2002 • 62 • 6

Pour tout savoir ou presque sur le coefficient Kappa...

osseuse) à la recherche de leishmanies sur les mêmes patients Suivant le classement de Landis et Koch (5) qui est

(2). L’étude porte sur 49 patients et les résultats sont présentés fréquemment utilisé en biologi e, le Kappa de notre exemple

dans le tableau I. aurait été considéré comme mauvais (Tableau II).

Tableau II - Degré d’accord et valeur de Kappa proposé par Landis

DÉFINITION DU COEFFICIENT KAPPA et Koch (5).

Accord Kappa

L’accord observé entre un ou plusieurs jugements

qualitatifs, résulte de la somme d’une composante «aléatoire» Excellent 0,81

(hasard) et d’une composante d’accord «véritable» (réel). Bon 0,80 - 0,61

Mais la part du hasard gêne notre appréciation. Pour contrô- Modéré 0,60 - 0,21

Mauvais 0,20 - 0,0

ler ce hasard, le coefficient Kappa (K) propose de chiffrer Très mauvais < 0,0

l’intensité ou la qualité de l’accord réel (3). C’est un indice

qui permet de « retirer » la portion de hasard ou de subjecti-

vité de l’accord entre les techniques.

Proportion d’accords observés - proportions d’accords dus au hasard Les limites de ce classement sont donc arbitraires et

K= peuvent varier selon l’étude réalisée ; par exemple en psy-

100 - proportions d’accords dus au hasard

chiatrie où la part d’incertitude est grande, un accord

Po - Pe

=

« modéré » dans l’échelle proposée ci-dessus pourrait être

1 - Pe considéré comme très satisfaisant, tel n’étant pas le cas devant

avec Po : la proportion d’accord observée ou concordance observée un résultat d’analyse biologique. Dans tous les cas, le clas-

Pe : la proportion d’accord aléatoire ou concordance aléatoire. sement dev ra être défini avec des ex p e rts avant la réalisat i o n

La présentation des résultats sous la forme d’un de l’étude.

t ableau de contingence montre que les deux techniques sont

en accord pour 30 patients avec 19 réponses positives concor-

dantes et 11 réponses négatives concordantes (Tableau I). SIGNIFICATION STATISTIQUE

La concordance observée Po est la proportion des

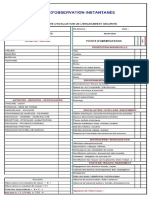

En général, on accompagne le calcul du coefficient K

individus classés dans les cases diagonales concordantes

de son degré de signifi c ation p afin de pouvoir interpréter le

( ) du tableau de contingence, soit :

résultat avec certitude (ce qui aurait dû être fait dans notre

Po = (19+11)/49 = 0,612 exemple).

Et la concordance aléatoire Pe est égale à la somme Pour tester l’hypothèse nulle H0 « indépendance des

des effectifs théoriques des 2 cases concordantes, divisée par jugements » (d’où K = 0) contre l’hypothèse alternative H1

la taille de l’échantillon (N= 49) : (K > 0), on utilise :

Pe = [(29*28)/49 + (20*21)/49] / 49 = 0,513 K

Z=

NB : Les effectifs théoriques se calculent ici comme ÷ (Var K)

dans un test du Chi carré de Pearson. qui, sous H0, suit ap p roximativement une loi normale centrée

D’où : réduite.

0,612 - 0,513 On remarq u e ra que la fo rmu l ation de H1 est toujours

K= = 0,20 unilatérale, en effet un K négatif signifi e rait que les observa-

1 - 0,513 teurs sont plus souvent en désaccord que sous l’effet du hasard,

ce qui n’est pas vraisembl able dans la pratique coura n t e.

On ne donnera pas ici le calcul de la va riance (Var K)

INTERPRETATION qui est assez complexe (1).

Dans notre exemple :

Selon les auteurs de l’article nous ayant servi 0,20

d’exemple (2), une valeur de 0,20 indique un bon accord entre Z= = 3,08

les deux techniques lorsqu’on a pris en compte (enlevé) le ÷ (0,0044)

hasard qui pouvait les mettre d’accord. L’interprétation de ce test est la suivante : si Z > 1,64,

En effet, le coefficient Kappa est un nombre réel, sans on rejette H0 pour un risque a = 5 % en unilatéral. Les deux

dimension, compris entre -1 et +1. L’ a c c o rd sera d’autant plus techniques de notre exemple concordent significativement

élevé que la valeur de Kappa est proche de +1 et l’accord plus que la chance seule ne pourrait l’expliquer (p<0,5 %).

maximal est atteint si K = 1. Lorsqu’il y a indépendance des La conclusion de Belhadj et Coll était donc valable (2). La

jugements, le coefficient Kappa est égal à zéro (Po = Pe), et culture du sang périphérique est bien dans le contexte tuni-

dans le cas d’un désaccord total entre les juges, le coefficient sien une méthode valide pour le diagnostic de la leishmaniose

Kappa prend la valeur -1. viscérale.

Médecine Tropicale • 2002 • 62 • 6 635

I. Bergeri et Collaborateurs

variance du coefficient Kappa et du Kappa lui-même, et ceci

USAGES EN PRATIQUE

entre deux ou plus de deux jugements, il est donc inutile d’al-

ler créer votre propre programme (6) ;

Dans la prat i q u e, le Kappa va servir pour déterm i n e r :

- La fiabilité d’un instrument de mesure. Est-ce que - le calcul du coefficient Kappa (entre deux jugements

le dosage d’un échantillon standard de référence de ch l o ro- seulement) est aussi disponible sur le logiciel EPI INFO 6.04

quine donne bien le résultat attendu avec un nouvel appareil ? fr qui est gratuit, dans le module EPITABLE. Le chemin

- L’ a c c o rdinter- o b s e rvat e u rs. Est-ce que deux bio- d’accès est le suivant :

logistes qui parcourent le frottis sanguin d’une même per- PROGRAMMES Æ EPITABLE Æ COMPARE Æ

sonne à la recherche de Plasmodium falciparum vont obte- PROPORTION Æ CONCORDANCE ENTRE OBSERVA-

nir le même résultat ? TEURS ;

- L’accord intra-observateur. Est-ce qu’un biologiste - sachez enfin que pour étudier la concordance entre

qui revoit le frottis de la même personne le lendemain va des réponses quantitatives, on peut utiliser le coefficient de

obtenir le même résultat que la veille ? détermination R2 qui est simplement le carré du classique

- N’opposez pas le coefficient Kappa avec la sensi- coefficient de corrélation « r » à condition qu’il y ait linéa-

bilité (Se), la spécificité (Sp), les valeurs prédictives (VPP, rité du lien entre les 2 jugements.

VPN) ! Ces dernières ne sont pas des indices « concurren- Vous savez maintenant « dompter » le hasard, à vous

tiels » du coefficient Kappa mais parfaitement complémen- de jouer, entrez vos données...

t a i res (4). Le K est utilisé essentiellement dans les études où

il n’y a pas de méthode de référence disponible.

POUR EN SAVOIR PLUS

CONCLUSION 1 - COHEN J - A coefficient of agreement for nominal scales. Educ Psychol

Meas 1960 ; 20 : 27-46.

2 - BELHADJ S, TOUMI NH, DAKHLIA H et Coll - La culture du sang

Le coefficient Kappa de Cohen permet d’estimer, en

péri p h é rique comme moyen diagnostique de la leishmaniose viscéra l e :

prenant en compte le hasard, l’accord entre des jugements a propos de 61 cas. Med Trop 2002 ; 62 : 155-157

qualitatifs appliqués aux mêmes objets, fournis par deux 3 - GRENIER A - Décision médicale. Collection Sciences et Médecine.

observat e u rs ou techniques, dans le but de déceler et de quan- Masson ed, Paris, 1993.

tifier les désaccords pour les corriger ou les interpréter. On 4 - LAPLANCHE A, COM-NOUGUE C, FLAMANT R - Méthodes

ajoutera que l’extension de la méthode à plusieurs observa- statistiques appliquées à la recherche clinique. Flammarion

teurs ou techniques est possible (1, 6). Médecine-Sciences ed, Paris, 1987.

Mais encore : 5 - LANDIS JR, KOCH GG - The measurement of observer agreement fo r

- de nombreux sites sur Internet proposent gratuite- categorical data. Biometrics 1977a ; 33 : 159-174.

ment des petits programmes télécharge ables de calculs de la 6 - http://perso.worldonline.fr/kappa.

Vient de paraître

636 Médecine Tropicale • 2002 • 62 • 6

View publication stats

Vous aimerez peut-être aussi

- Exercice Données de Panel SynthèseDocument24 pagesExercice Données de Panel SynthèsesmatiPas encore d'évaluation

- L'étude de la relation client: Le marketing scientifique à l'usage des managersD'EverandL'étude de la relation client: Le marketing scientifique à l'usage des managersPas encore d'évaluation

- Test (Psychologie) PDFDocument5 pagesTest (Psychologie) PDFfranck0% (1)

- L'interprétation Des Comptes Rendus D'examens de Biologie MédicaleDocument3 pagesL'interprétation Des Comptes Rendus D'examens de Biologie MédicaleBenmammarPas encore d'évaluation

- PDF - Vol 98-01-N01Document7 pagesPDF - Vol 98-01-N01Kone AzizPas encore d'évaluation

- Estadística 2Document5 pagesEstadística 2Ezequiel ZacañinoPas encore d'évaluation

- Excercices TDDocument6 pagesExcercices TDKaren DominiquePas encore d'évaluation

- GénétiqueDocument14 pagesGénétiqueSteph Christ VembePas encore d'évaluation

- 1 13 Parhsamètres Biologiques Valeurs Normales Et Unités de MesureDocument5 pages1 13 Parhsamètres Biologiques Valeurs Normales Et Unités de MesureducmikaaaaPas encore d'évaluation

- Chap 3Document35 pagesChap 3Fakhreddine Wiem100% (1)

- Chapitre III - Contrôle Et Critique Des DonnéesDocument10 pagesChapitre III - Contrôle Et Critique Des DonnéesSalem AmarouchiPas encore d'évaluation

- 01kdqsu3mlbr6o4ugldd98fqjq0823 OrgDocument7 pages01kdqsu3mlbr6o4ugldd98fqjq0823 OrgIssiaka Faissal CompaoréPas encore d'évaluation

- Guide TravauxGroupe Synthese Gallais 2Document10 pagesGuide TravauxGroupe Synthese Gallais 2emilyvilleneuve25Pas encore d'évaluation

- Chap6 2122Document4 pagesChap6 2122Berenger MabéléPas encore d'évaluation

- Détermination de La Taille D'échantillonDocument62 pagesDétermination de La Taille D'échantillonclauvis ngainangPas encore d'évaluation

- I-11-169-L'Évaluat Ion Thérapeutique Et Le Niveau de PreuveDocument7 pagesI-11-169-L'Évaluat Ion Thérapeutique Et Le Niveau de PreuveNemo LuPas encore d'évaluation

- P ValuesDocument18 pagesP ValuesXavier Herman MANANJARA ANDRIMAHAFALYPas encore d'évaluation

- Cpap ComplicationsDocument29 pagesCpap ComplicationsMeriame LaazizPas encore d'évaluation

- CHAPITRE 4 StatistiqueDocument8 pagesCHAPITRE 4 StatistiqueAbdallahi SidiPas encore d'évaluation

- 3-Test D'hypotèseDocument9 pages3-Test D'hypotèseAisSa KeRrøùùmPas encore d'évaluation

- Interpretation Desc Groupes Sanguins ABO Et Ses DifficultésDocument12 pagesInterpretation Desc Groupes Sanguins ABO Et Ses DifficultésAMJADPas encore d'évaluation

- Statistique enDocument59 pagesStatistique enWissem OuahabiPas encore d'évaluation

- ConsentementDocument9 pagesConsentementwassb1987Pas encore d'évaluation

- Chi 2Document17 pagesChi 2Lilou Ṧṹpeř MaboullPas encore d'évaluation

- MS16 4 Courtine Manon (1) (D) Version DiffusionDocument44 pagesMS16 4 Courtine Manon (1) (D) Version DiffusionOusmane DembelePas encore d'évaluation

- ADD TravailDocument20 pagesADD TravailHan..nae-61 chPas encore d'évaluation

- Questions EBPDocument5 pagesQuestions EBPBillel BenchihaPas encore d'évaluation

- Fleury2008 PDFDocument48 pagesFleury2008 PDFMohamed OmarPas encore d'évaluation

- Fichier Dmi Epp Kandelf11bbDocument3 pagesFichier Dmi Epp Kandelf11bbSAFAHo GamerPas encore d'évaluation

- TEST STAT m1BDocument15 pagesTEST STAT m1Bmonecole2018Pas encore d'évaluation

- Faut-Il Diminuer La Valeur de P À P 0,005 ?: Should We Reduce The Value of P To 0.005?Document2 pagesFaut-Il Diminuer La Valeur de P À P 0,005 ?: Should We Reduce The Value of P To 0.005?rezaPas encore d'évaluation

- RFE HemorragieDigestive2012Document16 pagesRFE HemorragieDigestive2012Kim SabrinePas encore d'évaluation

- TH2020PAYETCECILEDocument125 pagesTH2020PAYETCECILEbertyland GnangaissakaPas encore d'évaluation

- Khi 3Document7 pagesKhi 3Choudder MeriamPas encore d'évaluation

- Exercice TD1Document4 pagesExercice TD1rostandtchangouePas encore d'évaluation

- Mermet - Limite de QuantificationDocument64 pagesMermet - Limite de QuantificationLangelusyfairePas encore d'évaluation

- Statistiques Opus 5 PDFDocument9 pagesStatistiques Opus 5 PDFAissaPas encore d'évaluation

- Statistique S 2020Document27 pagesStatistique S 2020marielouisekouame187Pas encore d'évaluation

- 9-Dumontet Doc FDocument16 pages9-Dumontet Doc FbbdbdfPas encore d'évaluation

- Evaluation Statistiques Diagramme en Boite A Moustaches Premiere ProDocument4 pagesEvaluation Statistiques Diagramme en Boite A Moustaches Premiere Prondhbhqf7b5Pas encore d'évaluation

- 5 16 1 PBDocument5 pages5 16 1 PBOum BanatPas encore d'évaluation

- TD 2010Document14 pagesTD 2010ibrahimaPas encore d'évaluation

- These Sylvie ThellierDocument295 pagesThese Sylvie Thellierbouslimane idirPas encore d'évaluation

- FISE2 Estimation Part6 Detection Estimation BayésienneDocument25 pagesFISE2 Estimation Part6 Detection Estimation Bayésiennethomas vwPas encore d'évaluation

- Avantages de La Ddmarche: 8 0 Revue Frangaise Des Laboratoires. Novembre 2004. N ° 36'7Document2 pagesAvantages de La Ddmarche: 8 0 Revue Frangaise Des Laboratoires. Novembre 2004. N ° 36'7ndogyenoubaPas encore d'évaluation

- Qualif Et Valid ImpDocument124 pagesQualif Et Valid ImpAmal MastadiPas encore d'évaluation

- Frottis SanguinDocument10 pagesFrottis SanguinpepePas encore d'évaluation

- Tests StatistiquesDocument11 pagesTests Statistiqueschouchou vetovet100% (1)

- VialledDocument12 pagesVialledsaddoukPas encore d'évaluation

- Analyses Statitistiques Master Recherche 2020Document41 pagesAnalyses Statitistiques Master Recherche 2020FELICITE FODNE WAASOPas encore d'évaluation

- TP SVT (1) - 1Document16 pagesTP SVT (1) - 1TUTO A FONDPas encore d'évaluation

- Unlicensed-UE LCADocument18 pagesUnlicensed-UE LCAZaki MouazPas encore d'évaluation

- STAT1001-1 (AF Donneau 2021-2022) - Cours 4-8Document93 pagesSTAT1001-1 (AF Donneau 2021-2022) - Cours 4-8Camille SteenhoutPas encore d'évaluation

- Recommandation Antalgique Post Amygdalectomie 2014 TCDocument34 pagesRecommandation Antalgique Post Amygdalectomie 2014 TCbaptiste.lecart2Pas encore d'évaluation

- 08 Stats 2016 12Document9 pages08 Stats 2016 12Xavier Herman MANANJARA ANDRIMAHAFALYPas encore d'évaluation

- 2 Rfe Alr 2016Document14 pages2 Rfe Alr 2016RomanPas encore d'évaluation

- Ampliation ThoraciqueDocument7 pagesAmpliation ThoraciquehamidPas encore d'évaluation

- High-Sensitivity Cardiac Troponin Assays - Answers To Frequently Asked QuestionsDocument18 pagesHigh-Sensitivity Cardiac Troponin Assays - Answers To Frequently Asked QuestionsYuniati ValentinaPas encore d'évaluation

- Travaux Dirigés-Chapitre-5-Statistique1Document6 pagesTravaux Dirigés-Chapitre-5-Statistique1Manassé KakouPas encore d'évaluation

- Examen Stat Inf Corrig Juin 2017Document3 pagesExamen Stat Inf Corrig Juin 2017RaslenPas encore d'évaluation

- Pourquoi vacciner ?: La fin de la vaccination, documentée et argumentéeD'EverandPourquoi vacciner ?: La fin de la vaccination, documentée et argumentéePas encore d'évaluation

- Cat Rectorragie EnfantDocument25 pagesCat Rectorragie Enfantamédée junior wawaPas encore d'évaluation

- OujdaDocument14 pagesOujdaAnass OuraghniPas encore d'évaluation

- Devoir de Contrôle N°1 2016 2017 (MR Yahyaoui Abdellatif)Document3 pagesDevoir de Contrôle N°1 2016 2017 (MR Yahyaoui Abdellatif)sonilolaPas encore d'évaluation

- Fiche de Poste Chef EconomeDocument5 pagesFiche de Poste Chef EconomeAmine HachemiPas encore d'évaluation

- CC 2MHR Hygiene Des Locaux Et Des MaterielsDocument14 pagesCC 2MHR Hygiene Des Locaux Et Des MaterielscostaPas encore d'évaluation

- PTW Excavation FRDocument1 pagePTW Excavation FRATSI Hadjila100% (1)

- Nutrition 3 - Groupe Des AlimentsDocument4 pagesNutrition 3 - Groupe Des AlimentsŘīă WivgelrePas encore d'évaluation

- Adh 113 0127Document29 pagesAdh 113 0127ey74690Pas encore d'évaluation

- Volume Avance 3 SeancesDocument2 pagesVolume Avance 3 SeancesSehi LaurentPas encore d'évaluation

- III SanitaireDocument12 pagesIII SanitaireRaoul NoumbissiPas encore d'évaluation

- Capture D'écran . 2022-01-04 À 20.12.46Document48 pagesCapture D'écran . 2022-01-04 À 20.12.46ryd6w2fthjPas encore d'évaluation

- Kraepelin Emil - Introduction A La Psychiatrie CliniqueDocument454 pagesKraepelin Emil - Introduction A La Psychiatrie CliniquevanillesosoPas encore d'évaluation

- Ameliorer L Imag Du Corps Avec La Danse TherapieDocument3 pagesAmeliorer L Imag Du Corps Avec La Danse Therapiesoffia100% (1)

- Lavigne-Desnoyers Gabrielle 2016 MemoireDocument101 pagesLavigne-Desnoyers Gabrielle 2016 MemoireChristian Lauric N'guessanPas encore d'évaluation

- Dossier Pousse SeringueDocument20 pagesDossier Pousse SeringueKHAMSI ZINEBPas encore d'évaluation

- Pistolet de Massage Musculaire, Cotsoco Massage GuDocument2 pagesPistolet de Massage Musculaire, Cotsoco Massage GuorelcreppyPas encore d'évaluation

- Cote-d'Ivoire - Pser - Consolide - Et - ValideDocument48 pagesCote-d'Ivoire - Pser - Consolide - Et - ValideRémi DANHOUNDOPas encore d'évaluation

- Le Rôle Du Pharmacien D'officine Dans La Prévention Et La Prise en Charge Des Principales Pathologies Bucco-DentairesDocument206 pagesLe Rôle Du Pharmacien D'officine Dans La Prévention Et La Prise en Charge Des Principales Pathologies Bucco-DentairesWEMBE RAOULPas encore d'évaluation

- Anomalies Du Bilan de L'eau Et Du SodiumDocument20 pagesAnomalies Du Bilan de L'eau Et Du SodiumNJEBARIKANUYE EugènePas encore d'évaluation

- 60 Millions de Consommateurs Hors Série N°118 - Se Soigner Sans OrdonnanceDocument115 pages60 Millions de Consommateurs Hors Série N°118 - Se Soigner Sans OrdonnancejacquesPas encore d'évaluation

- Dimensionnement VentilationDocument20 pagesDimensionnement VentilationFRANCONPas encore d'évaluation

- Rapport de Stage SantéDocument12 pagesRapport de Stage SantéSos Pairs Educateur100% (1)

- Base D'exercices de Sante Publique Asio1 2022-2023Document19 pagesBase D'exercices de Sante Publique Asio1 2022-2023Adam MorokanPas encore d'évaluation

- Est 1140Document124 pagesEst 1140Alexandre SchaffhauserPas encore d'évaluation

- These76 09Document131 pagesThese76 09fati gsPas encore d'évaluation

- Sante Mag 28Document52 pagesSante Mag 28Nabil Bereksi ReguigPas encore d'évaluation

- Causerie Sécurité Au TravailDocument28 pagesCauserie Sécurité Au TravailJustemy ChrisPas encore d'évaluation

- Rapport SFE - BRCDocument29 pagesRapport SFE - BRCHajar El HamdaniPas encore d'évaluation

- Junior DonchiDocument3 pagesJunior DonchijnrmambouPas encore d'évaluation