Académique Documents

Professionnel Documents

Culture Documents

Tsi 11

Transféré par

Saida LaifaTitre original

Copyright

Formats disponibles

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

Formats disponibles

Tsi 11

Transféré par

Saida LaifaDroits d'auteur :

Formats disponibles

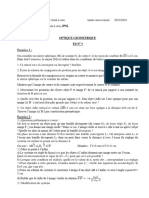

INP-ENSEEIHT 3IMA

Traitement et Synthèse de l’Image

Examen – 2 heures

L’épreuve comporte trois parties indépendantes. Les documents sont autorisés.

1 Exercice sur le cours de photographie (3 points)

En photographie, on dit généralement que « l’infini commence au-delà de 10 mètres ». On veut savoir si cette

affirmation est exacte du point de vue de la profondeur de champ. Si la mise au point est faite « à l’infini », alors

les points de l’espace objet dont l’image est nette ne sont pas limités à gauche, mais ils sont limités à droite par

un plan Π+ (notations du cours). On se demande si la distance de Π+ au centre optique est supérieure à 10m.

1. On utilise un objectif « standard », de distance focale f ′ = 50mm, réglé à l’ouverture N O = 5. La mise

au point est faite à l’infini. Calculer la taille t de la tache de flou correspondant à l’image d’un point objet

P situé sur l’axe optique à p = −10m. Il est conseillé de s’aider d’un schéma.

2. On suppose que le récepteur photosensible de l’appareil photographique est un capteur CCD de taille

24mm × 36mm constitué de 10 millions de pixels carrés. En supposant que les pixels couvrent entièrement

la surface du CCD, calculer leur côté a. L’image de P est-elle floue ? Conclusion ?

2 Problème sur la partie “vision par ordinateur” (9 points)

On souhaite estimer l’éclairage S d’une scène 3D, en utilisant un objet de géométrie et de couleurs connues,

à savoir un cube à faces colorées (cf. Figure ??). Ce problème comporte trois parties qui peuvent être traitées

indépendamment, bien qu’il soit conseillé de les traiter dans l’ordre indiqué.

2.1 Détection des sommets du cube et mise en correspondance 2D-3D

On dispose de deux photographies I et Iapp légèrement différentes d’un même cube dans lesquelles les images

de sept sommets du cube apparaissent (cf. Figure ??). Dans l’image droite Iapp (dite d’apprentissage) les

sommets ont été étiquetés avec les labels Ci , i ∈ 1..7. Dans l’image gauche I, légèrement différente, les mêmes

sommets apparaissent mais ne sont pas labelisés. On veut détecter et mettre en correspondance les sommets de

I avec ceux de Iapp . On utilise pour cela le TP TSI n˚2.

1. Le code Matlab de détection des points de Harris donne le résultat présenté dans la figure ??. Pourquoi

C5 n’est-il pas détecté ? Les sommets du cube ne sont pas les seuls points d’intérêt détectés. Pourquoi la

mise en correspondance utilisée dans le TP peut tout de même permettre d’apparier les sommets du cube

présents dans I et Iapp ?

2. Dans le code de détection des points de Harris, on utilise deux convolutions de l’image par les masques

directionnels de Prewitt. Rapellez pourquoi. Les deux images suivantes montrent les résultats de ces

convolutions. Indiquez le masque associé à l’image gauche (resp. droite). Compte tenu de ce résultat,

est-ce qu’une détection des sommets Ci dans l’image I via une détection de contours est envisageable ?

Comment opéreriez-vous ? (une réponse succincte suffit).

2.2 Calcul de la position du cube dans le repère de la caméra

On rappelle que la formation d’une photographie est décrite par l’équation de projection centrale

u ∼ PX,

TSI 1/3 2010-2011

INP-ENSEEIHT 3IMA

où P ∈ R3×4 désigne la matrice de projection, X ∈ R4 désigne le vecteur des coordonnées cartésiennes augmen-

tées d’un point dans le repère scène, et u ∈ R3 désigne le vecteur des coordonnées cartésiennes augmentées de

son image dans le repère 2D pixélique.

On associe à la scène un repère orthonormé (repère scène) tel que les huit coins du cube aient pour coordonnées

cartésiennes (±1, ±1, ±1). On désignera par Cj ∈ R4 , j ∈ {1..8} les vecteurs de ces coordonnées cartésiennes

augmentées et par ci ∈ R3 les vecteurs des coordonnées pixéliques augmentées de leurs images.

1. Formulez le problème de resection consistant à estimer P à partir des correspondances cj ↔ Cj , en

donnant, sous sa forme la plus adaptée au cas du cube, l’équation homogène linéaire en les éléments de P

décrivant la relation entre P, cj et Cj .

On rappelle que, pour toute paire de vecteurs m ∈ R3 , n ∈ R3 , on a l’égalité suivante :

m ∧ n = [m]∧ n

où

0 −m3 m2

[m]∧ = m3 0 −m1

−m2 m1 0

2. Donnez une définition à la notion de « points de fuite associés aux directions des arêtes ».

3. Que représentent les colonnes de P ?

4. Précisez de quelle connaissance (à savoir une matrice inconnue notée G) faudrait-il disposer, en plus de

P, pour calculer « directement », dans le repère scène, les normales des trois faces du cube visibles dans

l’image ? Détaillez le calcul de ces normales que l’on supposera unitaires.

5. Expliquez comment il serait possible d’estimer cette matrice G à partir de P ?

2.3 Calcul de la direction d’éclairage dans le repère de la caméra

On souhaite maintenant calculer la direction d’éclairage S dans le repère scène. On suppose qu’aucune face

du cube ne se trouve dans l’ombre.

1. Montrez que la couleur est uniforme sur chaque face du cube, si l’éclairage est supposé parfaitement

parallèle, si le matériau est supposé parfaitement lambertien et si on néglige le vignetage.

2. Montrez que l’estimation de S dans un repère 3D lié au cube n’est possible que si on connaˆles albédos

des différentes faces du cube dans les canaux R, V, B (rouge, vert et bleu).

3. En supposant que l’albédo dans le canal R est égal à 1pour toutes les faces, montrez que l’estimation de

S est très simple dans un repère 3D lié au cube, et donc dans le repère lié à la caméra.

4. Comparez cette “mire” de calibrage de l’éclairage avec celle qui a été utilisée en TP. En particulier, que

peut-on dire de la présence de taches brillantes dues à la “réflexion spéculaire” ?

3 Problème sur la partie “synthèse d’images” (8 points)

3.1 Questions (4 points)

Il est demandé de répondre à chaque question de manière claire et concise (10 lignes maximum par réponse) :

1. Comment modifier la transformation 3D vers 2D pour faire une projection orthogonale ? Qu’est-ce que

cela changerait au reste du rendu ?

2. Éclairage de Gouraud :

(a) Ce modèle d’éclairage simule une surface lisse : pourquoi ?

(b) Expliquez pourquoi une réflexion spéculaire ne peut pas arriver au milieu d’une face avec ce modèle

d’éclairage.

(c) Comment pourriez-vous modifier les données géométriques et le calcul de l’éclairage pour pouvoir

modéliser les arêtes vives (cf. Figure 2) ?

3. Expliquez le problème de la perspective quand on texture avec des coordonnées barycentriques calculées

sur l’image.

TSI 2/3 2010-2011

INP-ENSEEIHT 3IMA

3.2 Problème : “Environment Mapping” (4 points)

On dispose d’une image omnidirectionnelle d’une scène (l’“environnement”, représenté par exemple par une

photographie panoramique), et on souhaite faire le rendu d’objets en simulant leur immersion dans cette

scène à la position du point de vue de l’image d’environnement. On suppose qu’on dispose d’une fonction

getPixelAtAngle(image, theta, phi) qui prend en paramètres l’image et une direction depuis le centre de

la scène décrite par les angles theta et phi et renvoie la couleur du pixel de l’image omnidirectionnelle corres-

pondant à cette direction.

1. Décrivez un algorithme permettant de simuler la réflexion de l’environnement décrit par l’image omni-

directionnelle sur un objet considéré comme un miroir parfait. Distinguez en particulier les traitements

réalisés au niveau des sommets de ceux réalisés au niveau des pixels.

2. Quelles modifications apporter à cet algorithme pour des objets dont la surface est lambertienne ?

TSI 3/3 2010-2011

INP-ENSEEIHT 3IMA

Traitement et Synthèse de l’Image

Examen – 2h – Notes de cours autorisées

L’épreuve comporte trois exercices indépendants.

1 Exercice 1 : reconstruction 3D par stéréophotométrie (6 points)

En stéréophotométrie (cf. TP1), on peut considérer la surface d’un objet comme le graphe z = u(x, y) d’une

fonction u : R2 → R, qui à tout point image (x, y) associe une « profondeur » u(x, y), dans un repère 3D tel

que Oxy coïncide avec le plan image et Oz avec l’axe optique de l’appareil photographique. La normale unitaire

N(x, y) s’exprime alors en fonction du gradient ∇u(x, y) = [∂x u(x, y), ∂y u(x, y)]⊤ :

1

N(x, y) = p [−∂x u(x, y), −∂y u(x, y), 1]⊤ (1)

1 + k∇u(x, y)k2

On veut reconstruire le 3D d’un objet lambertien, d’albédo égal à 1, par stéréophotométrie. On dispose de n

images de cet objet vu sous n éclairages différents. La loi de Lambert donne l’expression du niveau de gris

Ik (x, y) au point image (x, y), sous l’éclairage Sk (cf. TP1) :

Ik (x, y) = max{S⊤

k N(x, y), 0} k ∈ [1, n] (2)

En l’absence d’ombre, le système (2) peut donc être réécrit sous forme matricielle :

I(x, y) = T N(x, y) (3)

Le vecteur I(x, y) = [I1 (x, y), . . . , In (x, y)]⊤ et la matrice T = [S1 , . . . , Sn ]⊤ sont supposés connus.

1. Précisez les dimensions de la matrice T. À quelle condition sur les vecteurs Sk , k ∈ [1, n], la pseudo-inverse

de T peut-elle permettre de résoudre le système (3) ? Que peut-on dire, en particulier, du cas où n = 2 ?

2. On suppose dorénavant que n = 2. En utilisant (1), réécrivez le système (3) sous la forme d’un système Σ

de deux équations aux dérivées partielles (EDP) en u(x, y).

3. On s’intéresse maintenant au cas où u(x, y) = √ (x + y )/2. On suppose que les n = 2 éclairages valent

2 2

S1 = [s, s, c] et S2 = [−s, −s, c] , où s = 2/2 sin α, c = cos α et α ∈ ]0, π/2[. Calculez la normale

⊤ ⊤

N(x, y), puis les niveaux de gris I1 (x, y) et I2 (x, y) des deux images (on suppose qu’il n’y a pas d’ombre).

4. Montrez que, dans ce cas, le système Σ implique les deux égalités suivantes :

(

k∇u(x, y)k2 = x2 + y 2

(4)

∂x u(x, y) + ∂y u(x, y) = x + y

5. Montrez que le système (4) a deux solutions en ∂x u(x, y) et ∂y u(x, y), et que ces deux solutions vérifient

la « condition d’intégrabilité » :

∂ ∂

(∂x u) = (∂y u) (5)

∂y ∂x

6. Terminez la résolution en calculant u(x, y). Que peut-on dire du nombre de solutions de la stéréophoto-

métrie lorsque n = 2 ?

TSI 1/3 2011-2012

INP-ENSEEIHT 3IMA

Résultat (1) Résultat (2) Appariement

Image gauche Image gauche Image gauche → image droite

Fig. 1 – Détection de points d’intérêt (pastilles blanches) et appariement (rectangles numérotés).

2 Exercice 2 : Détection et appariement de points d’intérêt (6 points)

Pour détecter des points d’intérêt, généralement, les opérateurs proposés s’appuient sur une détection des

contours (cf. TP2). Nous souhaitons travailler avec une paire d’images présentée dans la figure 1.

1. Quels types de contours peuvent être détectés dans cette image (appuyez vos propos en utilisant des

exemples) ? En utilisant le calcul de la dérivée première de cette image, comment peut-on détecter ces

types de contours ? (La réponse à ces 2 questions doit être succincte, elle ne doit pas dépasser 4/5 lignes).

2. Sachant qu’une fonction gaussienne à deux variables, d’écart type σ, en supposant une moyenne nulle en

x et en y, est donnée par :

1 − x2 +y2 2

g(x, y) = e 2σ , (6)

2πσ 2

exprimez les dérivées partielles secondes, notées gxx (x, y), gyy (x, y) et gxy (x, y).

3. Donnez les masques de taille 3 × 3 correspondants. Seule l’expression du masque en fonction de gxx , gyy

et gxy est souhaitée, en faisant apparaître les simplifications possibles.

4. En reprenant le même schéma que la fonction gaussmask (cf. TP2), complétez ce code (4 instructions

maximum) :

function [Lissage,DerivI,DerivJ,DerivII,DerivJJ,DerivIJ]=gaussmask2(TailleFenetre)

n=floor(TailleFenetre/2); Sigma=TailleFenetre/4; [J,I]=meshgrid(-n:n);

Lissage=exp(-(I.^2+J.^2)/(2*Sigma^2)); Lissage=Lissage/sum(sum(Lissage));

DerivI=-I.*exp(-(I.^2+J.^2)/(2*Sigma^2));

DerivI=DerivI/sum(sum(DerivI(1:n,:)));

DerivJ=DerivI’;

5. Le détecteur de Kitchen et Rosenfeld s’appuie sur l’expression suivante :

Ixx (x, y)Iy2 (x, y) − 2Ixy (x, y)Ix (x, y)Iy (x, y) + Iyy (x, y)Ix2 (x, y)

KR(x, y) = . (7)

Ix2 (x, y) + Iy2 (x, y)

function [XY,Res]=harris(Im,TailleFenetre,NbPoints,k) (cf. TP2) suit les étapes suivantes :

(a) Calcul des filtres utilisés pour le calcul de la réponse du détecteur ;

(b) Convolution de l’image originale pour obtenir les images des dérivées ;

(c) Calcul de la réponse du détecteur ;

(d) Suppression des non-maxima locaux ;

(e) Sélection des NbPoints en fonction des "NbPoints" réponses les plus fortes.

Que faut-il modifier dans le profil de la fonction et les étapes pour écrire la fonction rosenfeldKitchen

permettant la détection de points d’intérêt suivant Kitchen et Rosenfeld ?

6. Dans la figure 1 :

(a) À quels détecteurs correspondent les résultats (1) et (2) ?

(b) Pourquoi le nombre d’appariements est moins important que le nombre de points détectés au départ ?

(c) Quelle contrainte a priori peut on ajouter pour éviter l’erreur d’appariement sur le point 5 ?

TSI 2/3 2011-2012

INP-ENSEEIHT 3IMA

3 Exercice 3 : Recalage affine de deux images (3 points)

Comme le suggère l’exercice précédent, des appariements entre points d’intérêt peuvent être imprécis, peu

fiables. Ici on suppose que l’on dispose de deux images à recaler et de n couples de points d’intérêt appariés

(ui , vi )i=1...n . Chaque appariement est de plus doté d’une mesure de confiance wi ∈ [0, 1]. Plus la mesure de

confiance est forte et proche de 1, plus l’appariement est fiable et peut donc contribuer significativement au

recalage. Grâce à ces appariements, on veut opérer un recalage affine de nos deux images. On vous demande de

modéliser le problème d’estimation des 6 paramètres de la transformation affine (il faut donc n ≥ 3) avec prise

en compte des mesures de confiance qui pondèrent l’influence des n appariements. Le recalage affine utilisant des

points d’intérêt que nous avons discuté en cours est linéaire. Est-ce que votre modèle reste linéaire ? Avez-vous

toujours une solution analytique au problème ?

4 Exercice 4 : Synthèse d’images (5 points)

Question 1 (1 point)

Justifiez pourquoi l’algèbre linéaire de R3 n’est pas suffisante pour modéliser les transformations nécessaires

en synthèse d’images.

Question 2 (2 points)

Pour l’éclairage, vous avez implémenté une méthode appelée Gouraud (de son inventeur, un informaticien

français né en 1944) et vous avez vu en cours la méthode de Phong (informaticien vietnamien, 1942-1975).

Expliquez et comparez ces deux méthodes du point de vue algorithmique, mais aussi du point de vue des

résultats obtenus. Comparer aussi leur complexité en temps et en place.

Question 3 (2 points)

Le renderer implémenté en TP donne propose une gestion naïve des parties non visibles ou cachées. Dans

une scène complexe ayant énormément de primitives graphiques (polygones), on souhaite limiter le nombre de

primitives à traiter. Proposez et expliquez deux ou trois stratégies pour pouvoir limiter les calculs inutiles, en

particulier pour les primitives hors du champs de vue, ou occultées.

TSI 3/3 2011-2012

Vous aimerez peut-être aussi

- Suspension VTTDocument4 pagesSuspension VTTmasteratsii100% (1)

- TD Gisement Solaire PDFDocument6 pagesTD Gisement Solaire PDFMohamed Aly Sow100% (4)

- CNC Psi 2009 Physique 1 Epreuve PDFDocument12 pagesCNC Psi 2009 Physique 1 Epreuve PDFMohachmiPas encore d'évaluation

- Annales de Mathématiques, Baccalauréat C et E, Cameroun, 2008 - 2018: Sujets et CorrigésD'EverandAnnales de Mathématiques, Baccalauréat C et E, Cameroun, 2008 - 2018: Sujets et CorrigésÉvaluation : 4.5 sur 5 étoiles4.5/5 (4)

- M2 ESEM Vision ArtifDocument4 pagesM2 ESEM Vision ArtifMøŪn ĮrăPas encore d'évaluation

- TD 3 2023-2024Document3 pagesTD 3 2023-2024kebe.ibrahima4Pas encore d'évaluation

- SI ExosDocument5 pagesSI ExosCyrille LamasséPas encore d'évaluation

- Epreuve 3Document2 pagesEpreuve 3AmstrongPas encore d'évaluation

- Prepa Bac 2024 Recueil de Sujets Mathematiques Serie D-Ti CamerounDocument10 pagesPrepa Bac 2024 Recueil de Sujets Mathematiques Serie D-Ti CamerounChristine KatiaPas encore d'évaluation

- Sujet TD OptiqueDocument4 pagesSujet TD OptiqueTsantaniaina RAHERISONPas encore d'évaluation

- 9EXAM2005 WWW - CoursDocument4 pages9EXAM2005 WWW - CoursNou BouguetaiaPas encore d'évaluation

- Serie 2 TD Opt 2012Document6 pagesSerie 2 TD Opt 2012Yassine AfinissPas encore d'évaluation

- DM1 OptiqueDocument7 pagesDM1 OptiqueYahya El AmraniPas encore d'évaluation

- DS 2 Tsi-1Document4 pagesDS 2 Tsi-1Younes JaaidaniPas encore d'évaluation

- Null 4Document2 pagesNull 4LOUNDOU orthegaPas encore d'évaluation

- CRDS Dre S 1DDocument2 pagesCRDS Dre S 1DTB - Business en lignePas encore d'évaluation

- COUR DE TRAITEMENT DE SIGNAL Master 1Document51 pagesCOUR DE TRAITEMENT DE SIGNAL Master 1tagne simo rodriguePas encore d'évaluation

- Physique 1 CNC MP 2009 ÉnoncéDocument12 pagesPhysique 1 CNC MP 2009 Énoncéelhaffarisoumia123Pas encore d'évaluation

- CCP13physique1pc OffDocument12 pagesCCP13physique1pc OffEl BenPas encore d'évaluation

- Sujets Architecture 2023Document16 pagesSujets Architecture 2023chappazsachaPas encore d'évaluation

- Colle 5 ExercicesDocument7 pagesColle 5 ExercicesAdil JaouahirPas encore d'évaluation

- Exam 07Document6 pagesExam 07Ahmed LaibiPas encore d'évaluation

- Série ComplexeDocument5 pagesSérie ComplexeIyed GhabriPas encore d'évaluation

- Epreuve Maths 1ère D-TI Janv 2024Document2 pagesEpreuve Maths 1ère D-TI Janv 2024Ahmed SudaisPas encore d'évaluation

- Ti Semaine 2 ProjectionDocument5 pagesTi Semaine 2 ProjectionMohaman GonzaPas encore d'évaluation

- Cameroun 2018 Maths Serie D TIDocument2 pagesCameroun 2018 Maths Serie D TIemmanuel t magPas encore d'évaluation

- Série de TD N3Document2 pagesSérie de TD N3Ayoub AmazalPas encore d'évaluation

- ds1 OptiqueDocument4 pagesds1 OptiqueBennani GhaliPas encore d'évaluation

- Devoir de Ratrapage Mecanique Du PointDocument2 pagesDevoir de Ratrapage Mecanique Du PointPreparation TafemPas encore d'évaluation

- Seba 1995Document2 pagesSeba 1995Dado DjiguibaPas encore d'évaluation

- exam-TIN-13Mai2019 3IR M1 V2Document2 pagesexam-TIN-13Mai2019 3IR M1 V2Souhila MezianiPas encore d'évaluation

- Maths TD SeptDocument2 pagesMaths TD Septdelvanokenne9Pas encore d'évaluation

- Microscopie OptiqueDocument10 pagesMicroscopie OptiqueBacem KakaPas encore d'évaluation

- Ti Semaine 3 DiscretisationDocument11 pagesTi Semaine 3 DiscretisationMohaman GonzaPas encore d'évaluation

- Adm TG PDFDocument24 pagesAdm TG PDFjhdmssPas encore d'évaluation

- 28 SX2009NDocument4 pages28 SX2009NZakaria EzziyadiPas encore d'évaluation

- Se 4 TCsambo 21Document2 pagesSe 4 TCsambo 21Oussoumanou djadjel BoukarPas encore d'évaluation

- Matlab2009 ExamcorrecDocument15 pagesMatlab2009 ExamcorrecAbdel DaaPas encore d'évaluation

- TD N°4 - PHYSIQUES - Classe: 1 C - Mois: Janvier 2023: TD Sur Optique GeometriqueDocument10 pagesTD N°4 - PHYSIQUES - Classe: 1 C - Mois: Janvier 2023: TD Sur Optique GeometriquePauline DaissoPas encore d'évaluation

- Examen Traitement D'image: Exercice 1: Détection de Contour (30 Minutes)Document7 pagesExamen Traitement D'image: Exercice 1: Détection de Contour (30 Minutes)Leila AnedpPas encore d'évaluation

- Ennoncé CNC MP Physique 2009Document12 pagesEnnoncé CNC MP Physique 2009MarouanAkhabbilPas encore d'évaluation

- Correction BAC Math 2012Document98 pagesCorrection BAC Math 2012Marco InzaghiPas encore d'évaluation

- Centrale Supelec 2019 Informatique Commun Sujet 1Document10 pagesCentrale Supelec 2019 Informatique Commun Sujet 1Mokhtar El khrichiPas encore d'évaluation

- CC+Rattrapage (2018-2019)Document4 pagesCC+Rattrapage (2018-2019)khadija amlalPas encore d'évaluation

- DM OptiqueDocument3 pagesDM OptiqueFatima BelallamPas encore d'évaluation

- DS2021Document2 pagesDS2021medaymenhalleb3Pas encore d'évaluation

- 19 SX2014RDocument3 pages19 SX2014RZakaria EzziyadiPas encore d'évaluation

- TD1 Nombres Complexes GRM 1Document11 pagesTD1 Nombres Complexes GRM 1Alexis NguelewouPas encore d'évaluation

- Composition 2nd Semestre TS1 LAF 2015 WWW - Axloutoth.snDocument3 pagesComposition 2nd Semestre TS1 LAF 2015 WWW - Axloutoth.snASSANE NDIRPas encore d'évaluation

- Traitement Dimage Teledetection1Document25 pagesTraitement Dimage Teledetection1Faouzi BerrichiPas encore d'évaluation

- OPTIQUE Serie n2Document1 pageOPTIQUE Serie n2PLK 225Pas encore d'évaluation

- td1 Geoaffine PDFDocument3 pagestd1 Geoaffine PDFami_marPas encore d'évaluation

- 09 SX2018NDocument4 pages09 SX2018NZakaria EzziyadiPas encore d'évaluation

- 18 Se2014nDocument4 pages18 Se2014nZakaria EzziyadiPas encore d'évaluation

- Exam Vico 06Document2 pagesExam Vico 06HENRIETTEPas encore d'évaluation

- 10 SX2018RDocument4 pages10 SX2018RZakaria EzziyadiPas encore d'évaluation

- (DS) 2) Photomosaïque - CorrigéDocument7 pages(DS) 2) Photomosaïque - CorrigéMatthieu BoucheriePas encore d'évaluation

- Sequence 3 Physique PCDocument2 pagesSequence 3 Physique PCanita100% (2)

- Tle C Devoir Obligatoire 6Document2 pagesTle C Devoir Obligatoire 6Kobashi No SomaPas encore d'évaluation

- Maths Bac Blanc S TerminaleDocument4 pagesMaths Bac Blanc S Terminaleluxiole100% (6)

- Réalisation de La Commande Du Gradateur Triphasé Unidirectionnel À Base Du Microcontrôleur PIC16F876ADocument105 pagesRéalisation de La Commande Du Gradateur Triphasé Unidirectionnel À Base Du Microcontrôleur PIC16F876ALamyae AMMARIPas encore d'évaluation

- CHAPITRE 4 Synthèse Des Correcteurs NumériquesDocument6 pagesCHAPITRE 4 Synthèse Des Correcteurs NumériquesSaida LaifaPas encore d'évaluation

- HdaaaDocument53 pagesHdaaaZouhair IguerhzifenPas encore d'évaluation

- Examen Traitement D'image: Exercice 1: Détection de Contour (30 Minutes)Document7 pagesExamen Traitement D'image: Exercice 1: Détection de Contour (30 Minutes)Leila AnedpPas encore d'évaluation

- Cour TaiDocument65 pagesCour TaiSaida LaifaPas encore d'évaluation

- Examen Traitement D Images - 2017Document2 pagesExamen Traitement D Images - 2017Saida LaifaPas encore d'évaluation

- 0 Détection de ContoursDocument43 pages0 Détection de ContoursSaida LaifaPas encore d'évaluation

- Master Rannou PDFDocument95 pagesMaster Rannou PDFRabii MontaPas encore d'évaluation

- TP4Document2 pagesTP4Ayouta FrihannePas encore d'évaluation

- PHY108 Séance 4Document5 pagesPHY108 Séance 4Yao Mawohou AWILI100% (1)

- Conception Et Implementation D'un Systeme Expert D'aide Au Diagnostique D'un PC-convertiDocument81 pagesConception Et Implementation D'un Systeme Expert D'aide Au Diagnostique D'un PC-convertiThierry Nacoulma100% (1)

- 2 Connaissances Des Aéronefs KITCHENER Bia Caen (6) AMCADocument91 pages2 Connaissances Des Aéronefs KITCHENER Bia Caen (6) AMCAMohamed ElbaghdadiPas encore d'évaluation

- 2008 09 Antilles Exo3 Correction Titrage DemiEq PKa 4ptsDocument2 pages2008 09 Antilles Exo3 Correction Titrage DemiEq PKa 4ptsNedim MsmPas encore d'évaluation

- A5 User Manual V1.0 FRDocument12 pagesA5 User Manual V1.0 FRBENACHERINEPas encore d'évaluation

- Le BIOSDocument15 pagesLe BIOSZait NadimPas encore d'évaluation

- Soudage Et RoulementDocument1 pageSoudage Et RoulementHaytam ArouiPas encore d'évaluation

- Interro1 - RSD - CorrigéDocument4 pagesInterro1 - RSD - CorrigéÎnēs KblPas encore d'évaluation

- Séries 2 Solutions ÉlectrolytiquesDocument1 pageSéries 2 Solutions Électrolytiquessoso.saaan777Pas encore d'évaluation

- Corrigé - TP02 Java 2023Document9 pagesCorrigé - TP02 Java 2023Laila MoufakkerPas encore d'évaluation

- Extrait 42283210 PDFDocument116 pagesExtrait 42283210 PDFBousmaha YoucefPas encore d'évaluation

- Capital Food Services - 20220711-4607 - LimiV5Comp-V3Document4 pagesCapital Food Services - 20220711-4607 - LimiV5Comp-V3Erika MontezaPas encore d'évaluation

- Reseaux de Terrain (4) (Mode de Compatibilité)Document68 pagesReseaux de Terrain (4) (Mode de Compatibilité)med.chakib1990Pas encore d'évaluation

- 2014 v2 CorrigéDocument11 pages2014 v2 Corrigéchtioui aminePas encore d'évaluation

- 67NDocument10 pages67NdjebienPas encore d'évaluation

- Book 2 PDFDocument13 pagesBook 2 PDFIssam AliPas encore d'évaluation

- TD4 MathematiquesDocument2 pagesTD4 MathematiquesAli MaatouqPas encore d'évaluation

- Exercice N°1 (8 Points) : Lycée: Echebbi Tadhaman Devoir de SYNTHESE N°2 ProfsDocument3 pagesExercice N°1 (8 Points) : Lycée: Echebbi Tadhaman Devoir de SYNTHESE N°2 ProfsaliPas encore d'évaluation

- Moteur FuséeDocument8 pagesMoteur FuséeRou Màissà100% (1)

- Cours MSP Chapitre 5Document84 pagesCours MSP Chapitre 5Maram Sellami100% (1)

- TIPE Thèse 1Document223 pagesTIPE Thèse 1Mr MitePas encore d'évaluation

- Cours Math - Séries Statistiques Doubles - Bac Sciences (2009-2010) MR Abdelbasset Laataoui PDFDocument10 pagesCours Math - Séries Statistiques Doubles - Bac Sciences (2009-2010) MR Abdelbasset Laataoui PDFamelll84Pas encore d'évaluation

- Conducteurs Et Condensateurs Partie1Document38 pagesConducteurs Et Condensateurs Partie1Ismahane BenaliPas encore d'évaluation

- Dossier Complet Sur ParapsychologieDocument32 pagesDossier Complet Sur Parapsychologienicole_plante67% (3)

- 4 Jonction PNDocument24 pages4 Jonction PNSafa adPas encore d'évaluation

- l3 Topo11 01Document1 pagel3 Topo11 01Nesrine HomriPas encore d'évaluation