Académique Documents

Professionnel Documents

Culture Documents

Automatique COURS

Transféré par

Toto Le bo0 évaluation0% ont trouvé ce document utile (0 vote)

33 vues5 pagesCopyright

© © All Rights Reserved

Formats disponibles

PDF, TXT ou lisez en ligne sur Scribd

Partager ce document

Partager ou intégrer le document

Avez-vous trouvé ce document utile ?

Ce contenu est-il inapproprié ?

Signaler ce documentDroits d'auteur :

© All Rights Reserved

Formats disponibles

Téléchargez comme PDF, TXT ou lisez en ligne sur Scribd

0 évaluation0% ont trouvé ce document utile (0 vote)

33 vues5 pagesAutomatique COURS

Transféré par

Toto Le boDroits d'auteur :

© All Rights Reserved

Formats disponibles

Téléchargez comme PDF, TXT ou lisez en ligne sur Scribd

Vous êtes sur la page 1sur 5

L’automatique est une science qui traite de la modélisation, de l’analyse, de l’identification et de

la commande des systèmes dynamiques. Elle inclut la cybernétique au sens étymologique du

terme, et a pour fondements théoriques les mathématiques, la théorie du signal et l’informatique

théorique. L’automatique permet de commander un système en respectant un cahier des

charges (rapidité, précision, stabilité…).

Les professionnels en automatique se nomment automaticiens. Les objets que l’automatique

permet de concevoir pour procéder à l'automatisation d'un système (automates,

régulateurs, etc.) s'appellent les automatismes ou les organes de contrôle-commande d'un

système piloté.

Un exemple simple d'automatisme est celui du régulateur de vitesse d’une automobile : il permet

de maintenir le véhicule à une vitesse constante prédéterminée par le conducteur,

indépendamment des perturbations (pente de la route, résistance du vent, etc.). James Clerk

Maxwell, dans son article « On Governors »1 (1868), définissait ainsi le système de régulation

qu'il avait inventé : « A governor is a part of a machine by means of which the velocity of the

machine is kept nearly uniform, notwithstanding variations in the driving-power or the

resistance ». Cette définition est une excellente introduction à l'automatique.

Histoire de l'automatique[modifier | modifier le code]

Préhistoire de l'automatique[modifier | modifier le code]

On peut faire remonter les débuts de l’automatique à l’Antiquité. Par exemple, les Romains

régulaient le niveau d’eau des aqueducs grâce à un système de valves. Au XVIe siècle, Cornelis

Drebbel a conçu l'asservissement de température d'un four en combinant des effets thermiques

et mécaniques ; alchimiste, Drebbel espérait grâce à ce four (« l'athanor ») transformer le plomb

en or. Puis, au XVIIe siècle, Robert Hooke et Christian Huygens conçurent des régulateurs de

vitesse (pour les moulins à vent en ce qui concerne Huyghens). En 1769, James Watt a conçu

son fameux régulateur à boules pour la régulation de vitesse des machines à vapeur. Parmi

d’autres pionniers de l’automatique, il convient d’évoquer l’astronome Airy (vers 1840), James

Clerk Maxwell (son article On governors, déjà mentionné, est le premier article mathématique sur

la théorie du contrôle1), Ivan Alexeïevitch Vichnegradski (1876) ; et, bien entendu, les

mathématiciens Adolf Hurwitz et Edward Routh (auteurs du critère de stabilité qui porte leur nom,

datant de la fin du XIXe siècle), ainsi que les Français Liénard et Chipart, qui ont amélioré en

1914 le critère de Routh-Hurwitz. On peut citer aussi Alexandre Liapounov, qui a présenté en

1892 sa thèse fondamentale sur la stabilité des équations différentielles, ainsi que tous les

mathématiciens qui ont contribué à la théorie de la stabilité (voir l'histoire de la théorie de la

stabilité). Ces derniers travaux, qui mènent à une époque assez récente, sont néanmoins à

caractère essentiellement mathématique.

L'automatique fréquentielle[modifier | modifier le code]

L’histoire de l’automatique proprement dite commence avec les fameux chercheurs

des laboratoires Bell (fondés en 1925) : Harold Stephen Black et Nathaniel Nichols (en), qui

ont conçu leur célèbre diagramme, Harry Nyquist qui, le premier sans doute, a compris le

problème de stabilité que posent les systèmes bouclés2, enfin et surtout Hendrik Wade Bode. Ce

dernier est très connu par son diagramme, mais son œuvre maîtresse est son livre Network

Analysis and Feedback Amplifier Designer3, édité juste après la Seconde Guerre mondiale (et

réédité depuis), qui marque la maturité de l’automatique fréquentielle.

Les systèmes échantillonnés[modifier | modifier le code]

Il faut mentionner aussi les pionniers de l’automatique à temps discret : l’Américain Claude

Shannon, lui aussi chercheur aux laboratoires Bell, le Russe Yakov Zalmanovitch Tsypkin,

l'Américain Eliahu Jury (en) enfin, auteur du critère correspondant à celui de Routh-Hurwitz

mais pour les systèmes à temps discret. Une découverte fondamentale est le théorème de

l'échantillonnage, attribué par de nombreux auteurs à Nyquist et Shannon, mais auquel il faut

aussi associer, entre autres Edmund Taylor Whittaker et Vladimir Kotelnikov.

La commande optimale[modifier | modifier le code]

Dans les années 1950, d’autres approches de l’automatique se préparent : en Russie avec Lev

Pontriaguine et ses collaborateurs, aux États-Unis avec Richard Bellman. Pontriaguine conçoit

le principe du maximum pour la commande optimale. Il s’agit d’une extension du calcul des

variations, avec « variations fortes » qui permettent d’obtenir une condition de maximum à la

place de l’égalité d’Euler. Bellman invente la programmation dynamique, d’où il déduit l’équation

d’Hamilton-Jacobi-Bellman (en), généralisation de l’équation d’Hamilton-Jacobi du Calcul des

variations.

La représentation d'état[modifier | modifier le code]

Les découvertes qui viennent d’être évoquées jouent bien sûr un rôle essentiel dans la théorie

de la commande optimale, mais elles ont également conduit à la notion de représentation d’état.

C’est Rudolf Kalman qui, en 1960, a fait la théorie (presque) complète de ces systèmes dans le

cas linéaire. Il a notamment mis en évidence les notions fondamentales de commandabilité et

d’observabilité. La même année (son annus mirabilis), il faisait la théorie de la commande

optimale linéaire quadratique (par application des résultats de Pontriaguine et de Bellman) et sa

« version duale », le filtre de Kalman qui généralise le filtre de Wiener. Puis quelques

mathématiciens, dont Harold J. Kushner, développent la commande optimale stochastique4.

Applications de l'algèbre et de la géométrie

différentielle[modifier | modifier le code]

S’ouvre alors une nouvelle ère de l’automatique, avec des travaux de nature algébrique (pour les

systèmes linéaires) ou relevant de la géométrie différentielle (dans le cas des systèmes non

linéaires). Pour ce qui concerne les systèmes linéaires, un livre célèbre de Walter Murray

Wonham, dont la première édition date de 1974 (mais qui a été plusieurs fois réédité), marque

l’apogée de cette période5. Concernant les systèmes non linéaires, un livre d'Alberto

Isidori (en), dont la première édition date de 1985, puis plusieurs fois réédité et augmenté, a

eu une influence considérable6.

La robustesse[modifier | modifier le code]

Bien que la notion de robustesse ait été prise en compte dans des approches fréquentielles

traditionnelles, telles que la « théorie quantitative de la rétroaction » développée par Isaac

Horowitz dès 1963, c'est vers la fin des années 1970 que la problématique de la commande

robuste, qui était complètement occultée dans une approche uniquement algébrique, est

apparue comme incontournable. La commande optimale « linéaire quadratique » a des

propriétés de robustesse intrinsèques (marge de phase d'au moins 60°, etc.), du moins dans le

cas des systèmes monovariables, comme il résulte d'un article publié par Kalman dès 1964. La

question s'est donc posée de savoir si cette propriété se conserve en présence d'un observateur.

Or en 1978, John Doyle (en), un des pionniers de la théorie de la robustesse, a montré

qu’une commande linéaire quadratique gaussienne (LQG) (dont l'observateur est un filtre de

Kalman) peut n’avoir aucune propriété de robustesse. Le formalisme H-infini, établi par le

mathématicien Godfrey Harold Hardy dès le début du XXe siècle, mais introduit en 1981

par George Zames dans le domaine de l'automatique, s’est avéré utile pour formaliser les

problèmes de commande robuste7. Il a été rapidement associé à des techniques d’optimisation

convexe fondées sur des « inégalités matricielles linéaires » (LMI) qui ont pu conduire à des

méthodes de synthèse (parfois excessivement) complexes.

Applications de l'analyse algébrique et de l'algèbre

différentielle[modifier | modifier le code]

Enfin, depuis le début des années 1990 se développe une nouvelle approche de l’automatique

linéaire fondée sur la théorie des modules (plus précisément, des D-modules) et l’analyse

algébrique (branche des mathématiques fondée sur les idées d'Alexandre Grothendieck, puis

développée par Mikio Satō, Masaki Kashiwara et, pour ce qui concerne les systèmes d'équations

différentielles, Bernard Malgrange8). On peut évoquer ici l’approche « behaviorale » de Jan C.

Willems (en), ainsi que les travaux de Michel Fliess (qui a également appliqué aux systèmes

non linéaires des méthodes issues de l'algèbre différentielle9 et est à l'origine, avec trois autres

automaticiens, de la notion de « système plat »), d’Ulrich Oberst, ainsi que de leurs divers

collaborateurs et émules10.

Généralités, concepts[modifier | modifier le code]

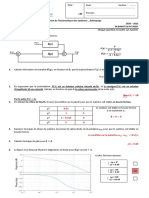

Consigne (en noir) et réponse (en bleu) d’un système asservi avec un régulateur PID (sans paramètres

optimaux)

On souhaite contrôler la température d’un four. La première tâche consiste à définir

le système « four ». Celui-ci possède une entrée (le courant fourni à la résistance de chauffage)

et une sortie (la température à l’intérieur du four). On modélise le système sous forme

d’équations, qui permettent d’exprimer les relations entre les entrées et les sorties du système,

sous la forme d’une équation différentielle ou d’une fonction de transfert. On détermine aussi les

conditions de stabilité du système (on ne veut pas que le four se mette à augmenter la

température sans s’arrêter).

Les personnes chargées de réguler ce système ont un cahier des charges à respecter :

• la stabilité (le régulateur ne doit pas rendre le système instable),

• la poursuite (la température du four doit atteindre la température en consigne, on

peut spécifier dans le cahier des charges si on a des contraintes de rapidité ou de

dépassement),

• le rejet des perturbations (on ouvre la porte du four, la température descend, la

température doit rejoindre la température voulue).

• Les coûts et délais de développement.

Après avoir déterminé la solution répondant le mieux aux besoins, on va synthétiser un nouveau

système, le « régulateur » ; celui-ci aura pour entrées la consigne (c’est-à-dire la température

souhaitée à l’intérieur du four) ainsi que la température réelle du four fourni par un capteur, et

pour sortie, la commande du four ; cette sortie est ainsi reliée à l’entrée du système four.

L’ensemble forme ce qu’on appelle un « système asservi ».

Le régulateur peut alors être réalisé sous forme analogique (circuit électronique) ou numérique

(microcontrôleur). Il existe également des régulateurs dans le commerce qui permettent ces

fonctions, où l’automaticien peut choisir la méthode de régulation, ou par exemple entrer les

coefficients dans le cadre d’un régulateur Proportionnel-Intégral-Dérivé.

Les systèmes[modifier | modifier le code]

Un système est une modélisation d’un procédé en fonctionnement. Il possède une ou plusieurs

entrées, et une ou plusieurs sorties. Les entrées du système sont appelées variables exogènes ;

elles rassemblent les perturbations et les variables manipulées, commandes ou grandeurs de

réglage. Elles sont souvent représentées de manière générique par la lettre u ou e. Elles sont

reliées au procédé en tant que tel par un actionneur.

Les sorties du système sont appelées variables contrôlées, mesures ou grandeurs réglées. Elles

sont souvent représentées de manière générique par la lettre y. Le procédé est relié à la sortie

du système par un capteur.

Dans le cas d’un système échantillonné, les entrées et sorties sont à temps discret, mais le

système en lui-même demeure à temps continu. Le système inclut donc un convertisseur

numérique-analogique en entrée, un convertisseur analogique-numérique en sortie et une

horloge permettant de fixer la fréquence d'échantillonnage.

Il existe une infinité d’exemples de systèmes : des systèmes mécaniques, des systèmes

électriques ou des procédés chimiques. La représentation du système ne pourra alors se faire

qu’avec de bonnes connaissances dans le domaine physique correspondant.

Différents systèmes[modifier | modifier le code]

Les systèmes peuvent être classés en plusieurs catégories.

Systèmes à temps continu, à temps discret[modifier | modifier le code]

• Systèmes à temps continus : ce sont les systèmes qui existent naturellement. Pour

ces systèmes, le temps décrit la droite réelle.

• Systèmes à temps discret : ce sont des systèmes pour lesquels le temps est

une variable discrète (on se ramène généralement au cas où décrit l’ensemble

des nombres entiers). Sauf exception, ces systèmes n’existent pas à l’état naturel (la

majorité des systèmes physiques naturels sont à temps continu), mais étant donné

que la plupart des contrôleurs utilisés en automatique sont calculés par des

processeurs numériques, il est parfois intéressant de modéliser le système

commandé comme un système à temps discret.

• Systèmes à événements discrets : systèmes dont le fonctionnement peut être

modélisé par des événements discrets. Généralement, ces systèmes sont modélisés

par des réseaux de Petri, des GRAFCET (qui en sont des cas particuliers très

répandus, notamment dans l'industrie) ou par les algèbres de dioïdes. Des exemples

sont les réseaux ferroviaires, ou le fonctionnement d’une chaîne de montage.

• Systèmes hybrides : systèmes dont la modélisation nécessite l’utilisation des

techniques liées aux systèmes continus et aux systèmes à évènements discrets, par

exemple : une boîte de vitesses de voiture.

Systèmes monovariables, systèmes multivariables[modifier | modifier le code]

Quatre possibilités existent :

• le système a une entrée et une sortie, c’est un système monovariable

ou SISO (Single Input Single Output) ;

• le système a plusieurs entrées et plusieurs sorties, c’est un système multivariable ou

MIMO (Multiple Input Multiple Output) ;

• le système a une entrée et plusieurs sorties, système SIMO ;

• le système a plusieurs entrées et une sortie, système MISO.

Néanmoins, ces deux derniers termes sont peu utilisés.

Système invariant (ou stationnaire)[modifier | modifier le code]

Ce sont des systèmes dont les paramètres du modèle mathématique ne varient pas au cours du

temps.

Systèmes linéaires ou non linéaires[modifier | modifier le code]

Article détaillé : Système linéaire.

On dit qu’un système est linéaire s'il est régi par un système d'équations différentielles linéaires.

En pratique, aucun système n’est linéaire, ne serait-ce que par les saturations (butées

physiques, par exemple) qu’il comporte ou encore par les phénomènes d’hystérésis. Toutefois,

un système non linéaire peut être considéré comme linéaire dans une certaine plage d’utilisation.

Il faut toujours garder à l’esprit que le système sur lequel on peut travailler n’est qu’un modèle

mathématique de la réalité, et que par conséquent il y a une perte d’information lors du passage

au modèle. Bien sûr, il incombe à l’ingénieur de juger la pertinence de son modèle vis-à-vis des

objectifs fixés.

Un système peut admettre une représentation linéaire et une autre représentation non linéaire.

Par exemple, un système pourra être linéaire en utilisant des coordonnées cartésiennes, et

deviendra non linéaire en coordonnées polaires.

Représentation des systèmes linéaires invariants[modifier | modifier

le code]

Les automaticiens ont l’habitude de représenter graphiquement un système asservi par

l’utilisation de schémas fonctionnels.

Équation différentielle et fonction de transfert[modifier | modifier le code]

Article détaillé : Fonction de transfert.

Un système physique se décrit généralement avec des équations différentielles (par exemple

le principe fondamental de la dynamique, caractéristique d’un condensateur ou d’une bobine…).

La transformation de Laplace permet alors de passer de l’équation différentielle temporelle à une

fonction de transfert, l'inverse n'étant exact que sous certaines hypothèses, car l'obtention d'une

fonction de transfert suppose qu'on travaille à conditions initiales nulles.

Pour un système à temps discret on utilise la transformation en Z.

Ces transformations permettent d’étudier le comportement entrée-sortie

Vous aimerez peut-être aussi

- 5 Eme Cours de Module DécouvertDocument6 pages5 Eme Cours de Module DécouvertAll AhmeDciaPas encore d'évaluation

- Cours Asservisement PTSI 2010 2011Document35 pagesCours Asservisement PTSI 2010 2011Dominique NassimePas encore d'évaluation

- Automatique 1 032348Document72 pagesAutomatique 1 032348Junior MASUDIPas encore d'évaluation

- P. APPELL - TRAITÉ DE MÉCANIQUE RATIONNELLE - Tome Premier STATIQUE-DYNAMIQUE DU POINT 1902 PDFDocument626 pagesP. APPELL - TRAITÉ DE MÉCANIQUE RATIONNELLE - Tome Premier STATIQUE-DYNAMIQUE DU POINT 1902 PDFferned_smith100% (1)

- Text To PDF 09092023 094022Document2 pagesText To PDF 09092023 094022Gloire SumbuPas encore d'évaluation

- Chapitre IDocument5 pagesChapitre IBil Halwa47Pas encore d'évaluation

- Kbiswas,+12506559 2001 9737564Document16 pagesKbiswas,+12506559 2001 9737564boukenkerol46Pas encore d'évaluation

- Dds NchitiDocument52 pagesDds NchitiWiam BalloukPas encore d'évaluation

- Cours de Mécanique Analytique Chapitre 2Document18 pagesCours de Mécanique Analytique Chapitre 2Karim MarmouriPas encore d'évaluation

- Commande AdaDocument5 pagesCommande Adaديني حياتيPas encore d'évaluation

- Systemes Asservis Lineaires ContinusDocument152 pagesSystemes Asservis Lineaires ContinusKhalil Jbeli100% (1)

- Mécanique AnalytiqueDocument17 pagesMécanique AnalytiqueChristophePas encore d'évaluation

- Véri Cation Par Automat TemporisésDocument31 pagesVéri Cation Par Automat TemporisésNacer NacerPas encore d'évaluation

- Chap1 Base de MecaniqueDocument12 pagesChap1 Base de MecaniqueassounaekrabenPas encore d'évaluation

- Cours Meca2 D - Automatique Ch1Document29 pagesCours Meca2 D - Automatique Ch1Ryem100% (1)

- Cours Physique3 VibrationDocument60 pagesCours Physique3 VibrationYoucef SI100% (3)

- Cours Automatique Linéaire V1Document53 pagesCours Automatique Linéaire V1bouchPas encore d'évaluation

- CH 02 Les Métiers de L'automatique Et de L'informatique IndustrielleDocument17 pagesCH 02 Les Métiers de L'automatique Et de L'informatique IndustrielleayoubchaiaunivPas encore d'évaluation

- Chapitre I Commande Des ProcedesDocument19 pagesChapitre I Commande Des ProcedesrezakPas encore d'évaluation

- Cours de Thermodynamique Et Conversion D'energie - L3 Mécanique ÉnergétiqueDocument133 pagesCours de Thermodynamique Et Conversion D'energie - L3 Mécanique ÉnergétiqueSen MarKh100% (4)

- Automatique CoursDocument5 pagesAutomatique CoursBabou ErrePas encore d'évaluation

- Cours Vibrations Chapitres1-8 VF CpressedDocument153 pagesCours Vibrations Chapitres1-8 VF CpressedMohamed CoulibalyPas encore d'évaluation

- Chapitre 01 PDFDocument11 pagesChapitre 01 PDFKotopediaPas encore d'évaluation

- Régulation Industrielle - EMIDocument129 pagesRégulation Industrielle - EMIAssia Benabid100% (1)

- Cours Master PDFDocument42 pagesCours Master PDFOD ELPas encore d'évaluation

- Algorithmique - WikipédiaDocument15 pagesAlgorithmique - WikipédiaBreton FLORA SOPHIEPas encore d'évaluation

- Economtrie Des Series TemporellesDocument60 pagesEconomtrie Des Series Temporellesabdelrh100% (1)

- 1 IntroductionDocument14 pages1 IntroductionSamy AmieziPas encore d'évaluation

- Resume Mecanique-Physique-MateriauxDocument2 pagesResume Mecanique-Physique-MateriauxPham Van DuongPas encore d'évaluation

- Cours Auto Ima1Document109 pagesCours Auto Ima1Ahmed HamdiPas encore d'évaluation

- Ch1 Introduction AutomatiqueDocument10 pagesCh1 Introduction AutomatiqueAïcha KomaraPas encore d'évaluation

- Cours Auto Ima1 Bouamama1 PDFDocument109 pagesCours Auto Ima1 Bouamama1 PDFAlfredho ShactarPas encore d'évaluation

- Biochimie StrucDocument146 pagesBiochimie Strucfrancoiseebene8Pas encore d'évaluation

- Régulation Des Systemes DynamiquesDocument134 pagesRégulation Des Systemes Dynamiquessamson100% (1)

- Résistance Des Matériaux - WikipédiaDocument18 pagesRésistance Des Matériaux - WikipédiaThe ShadowPas encore d'évaluation

- 1-Chapitre - 1 - Représentation - Des - Systèmes - Linéaires (1) - CopieDocument57 pages1-Chapitre - 1 - Représentation - Des - Systèmes - Linéaires (1) - CopieSamira EllouzatiPas encore d'évaluation

- Cours MasterDocument42 pagesCours MasterWilfriedPas encore d'évaluation

- Algorithmique - WikipédiaDocument22 pagesAlgorithmique - Wikipédiaclemenciantumba27Pas encore d'évaluation

- V 01Document402 pagesV 01Abdel DaaPas encore d'évaluation

- Cours Automatique 1A JMD 2016Document84 pagesCours Automatique 1A JMD 2016NourPas encore d'évaluation

- EvolRE B5 PDFDocument860 pagesEvolRE B5 PDFSandiPas encore d'évaluation

- Thomas GmürDocument17 pagesThomas Gmürsamir ghebouliPas encore d'évaluation

- 6-Regulation CorrectionDocument14 pages6-Regulation CorrectionAla Edine BeroualPas encore d'évaluation

- Cde Mode GlissementDocument21 pagesCde Mode GlissementilyPas encore d'évaluation

- Dynamique: Les Grands Articles d'UniversalisD'EverandDynamique: Les Grands Articles d'UniversalisPas encore d'évaluation

- Recherche OpérationnelleDocument3 pagesRecherche OpérationnelleYOUSRA EL AZHARIPas encore d'évaluation

- Thermodynamique PDFDocument114 pagesThermodynamique PDFعبد الحميد الجزائريPas encore d'évaluation

- MazoudiDocument16 pagesMazoudiz_12488109Pas encore d'évaluation

- Chapitre 1Document7 pagesChapitre 1GR GARMANIPas encore d'évaluation

- Cours D - Automatique MECA2 Ch1Document26 pagesCours D - Automatique MECA2 Ch1nesrine dhaouadi100% (1)

- Poly v5-2Document290 pagesPoly v5-2karim belaliaPas encore d'évaluation

- 1 Cours D'automatique RégulationDocument10 pages1 Cours D'automatique RégulationuserrPas encore d'évaluation

- Cours ThermodyDocument54 pagesCours ThermodyHraiech IbtissemPas encore d'évaluation

- Cours Asservissements PDFDocument67 pagesCours Asservissements PDFMohamed OubellaPas encore d'évaluation

- JTEA'08Document6 pagesJTEA'08Araouf GaaloulPas encore d'évaluation

- 1Document20 pages1samir ghebouliPas encore d'évaluation

- Histoire Des Ordinateurs - WikipédiaDocument26 pagesHistoire Des Ordinateurs - WikipédiaBaba Moustapha KabaPas encore d'évaluation

- Systemes Non Linéaires À Temps Discrets Et ContinusDocument13 pagesSystemes Non Linéaires À Temps Discrets Et ContinusPatrick Marcial Etata Mandjouk100% (1)

- Cours Automatique Et RégulationDocument150 pagesCours Automatique Et RégulationMed JDPas encore d'évaluation

- Automatique TD1Document9 pagesAutomatique TD1Toto Le boPas encore d'évaluation

- Cours 2Document5 pagesCours 2Toto Le boPas encore d'évaluation

- Exercice 1Document4 pagesExercice 1Toto Le boPas encore d'évaluation

- TD 2Document6 pagesTD 2Toto Le boPas encore d'évaluation

- TD1 Informatique IndustrielleDocument17 pagesTD1 Informatique IndustrielleToto Le boPas encore d'évaluation

- TP N°4 Initiation Au Logiciel Matlab Et SimulinkDocument12 pagesTP N°4 Initiation Au Logiciel Matlab Et SimulinkOussama EttahiriPas encore d'évaluation

- Boucle de Régulation....Document24 pagesBoucle de Régulation....Aya BessiriPas encore d'évaluation

- 11 G7 Chariot Eleve PDFDocument12 pages11 G7 Chariot Eleve PDFEdmond OuattaraPas encore d'évaluation

- PDF Volume1 Asservissements Lineaires ClassiquesDocument178 pagesPDF Volume1 Asservissements Lineaires ClassiquesRom-2 BotchackPas encore d'évaluation

- Synchrotact 4Document125 pagesSynchrotact 4YAO0% (1)

- Support de Cours SAE PDFDocument82 pagesSupport de Cours SAE PDFIbrahim El Khalil Yettar50% (2)

- 1 TD SemelleDocument1 page1 TD SemellebakhchPas encore d'évaluation

- Travaux Pratique RegulationDocument22 pagesTravaux Pratique RegulationAhmed LabidiPas encore d'évaluation

- Examen Rattrapage Corrigé 2021Document2 pagesExamen Rattrapage Corrigé 2021Adam EL AlamiPas encore d'évaluation

- Feuilletage 2535Document35 pagesFeuilletage 2535ghislain AlowakinnouPas encore d'évaluation

- Présentation de StageDocument16 pagesPrésentation de StageKabir OuchiPas encore d'évaluation

- Lettre de Motivation MulhouseDocument2 pagesLettre de Motivation Mulhouseiheb bouariche100% (1)

- Boite À Fusible Notice - Problèmes Eléctrique Ou Eléctronique - Forum Audi A3 8PDocument13 pagesBoite À Fusible Notice - Problèmes Eléctrique Ou Eléctronique - Forum Audi A3 8PAhmed OUADAHIPas encore d'évaluation

- Chapitre3 Méthodes de SynthèseDocument36 pagesChapitre3 Méthodes de SynthèseAYOUB RIADPas encore d'évaluation

- QCM AsservissementsDocument3 pagesQCM AsservissementsArmand Ess100% (5)

- Présentation Final2Document18 pagesPrésentation Final2Moh DoudouPas encore d'évaluation

- Elements Fondamentaux Du Systeme de ReguDocument35 pagesElements Fondamentaux Du Systeme de ReguCONDOR C8Pas encore d'évaluation

- Automatisme - L3-Eai-Elm - Exercices D'introduction Au GrafcetDocument4 pagesAutomatisme - L3-Eai-Elm - Exercices D'introduction Au GrafcetKing CyrusPas encore d'évaluation

- Initiation À MATLAB: 1. Généralités 1.1. Accès À MatlabDocument14 pagesInitiation À MATLAB: 1. Généralités 1.1. Accès À MatlabIguejdi LahcenPas encore d'évaluation

- Clicdvercrem Type RDocument2 pagesClicdvercrem Type Rcarlier stephanePas encore d'évaluation

- TD Automatique 1A 2016 JMDDocument20 pagesTD Automatique 1A 2016 JMDFaïssolath Achirou100% (1)

- Ahmed PDFDocument86 pagesAhmed PDFDjillali Serd0% (1)

- M19 Powerpoint - Cours - 1 (From Celyn-Pc)Document13 pagesM19 Powerpoint - Cours - 1 (From Celyn-Pc)2depic100% (2)

- P1632 - Brochure ASRiDocument9 pagesP1632 - Brochure ASRisaidouPas encore d'évaluation

- Adobe Scan 12 Dec 2020Document3 pagesAdobe Scan 12 Dec 2020Fleur D'espoirPas encore d'évaluation

- RevMP Sii AutomatiqueDocument30 pagesRevMP Sii AutomatiqueRebbag AnassPas encore d'évaluation

- Brochure Hitachi GAINABLE 10-2016Document6 pagesBrochure Hitachi GAINABLE 10-2016malikben100% (1)

- AssLin 02 ElemtsAnalyselSysLinContDocument13 pagesAssLin 02 ElemtsAnalyselSysLinContlacothPas encore d'évaluation

- CH 1 Introduction AutomatismeDocument40 pagesCH 1 Introduction AutomatismeImane AzatourPas encore d'évaluation

- TD 4Document2 pagesTD 4hdjs5Pas encore d'évaluation